无人机作战平台的智能目标识别方法  下载: 1041次

下载: 1041次

1 引言

在现代战争中,装备的智能化与信息化已经成为未来战争克敌制胜的关键。快速获取战场动态信息,掌握敌方作战意图,对于我方制定战场决策和抢先进行作战部署具有重大意义。现代战争对制信息权的要求不断提高,无人化装备因其可以突破人的生理和心理限制,以及具有快速、高机动性、成本较低、可深入敌后作战的特点而逐渐成为世界各国的重点发展方向[1]。

无人机在作战中的大量使用,离不开新技术的发展。人工智能技术的不断成熟,尤其是智能目标识别的出现,为无人机装上了“火眼金睛”,而智能目标识别的关键技术就是神经网络。传统的目标识别方法中,多尺度形变部件(DPM)算法的效果较为突出,获得了2007—2009年Pascal VOC(visual object class)目标识别冠军。随着基于卷积神经网络的目标识别算法(R-CNN)的出现[2],大多数致力于改进DPM的研究者纷纷转向深度学习研究领域[3]。近几年来,受益于计算机硬件性能的提升和机器学习理论的不断完善,基于卷积神经网络的目标识别方法得到了快速发展[4-5],先后出现了基于建议区域的R-CNN系列[6]和端到端的YOLO(You Only Look Once)系列方法。R-CNN系列虽然在识别精度上高于YOLO,但识别耗时太长,不适用于无人机作战平台;YOLO系列方法虽然在识别准确率上稍逊一筹,但可以实现实时识别[7]。本文结合当前在目标分类中具有领先地位的Inception网络模型,利用其在特征提取方面的独特优势对YOLOv3方法进行改进,提高网络的特征提取能力,进而提高训练模型的识别准确率。

2 无人机平台目标识别算法关键技术

无人机用于战场侦察时,主要采用视频摄像头作为战场信息的载入端,对敌方区域的人员与装备等信息进行实时采集[8]。在传统的无人机侦察技术中,通常将采集到的信息通过通信系统送入地面站的信息中心,在信息中心利用目标识别算法与数据库中已有的目标信息进行匹配,从而确认目标区域装备和人员信息,以节省人员消耗,提高作战效率[9]。这一过程中最关键的就是目标识别算法的准确性和实时性:若算法的稳健性太差,则会严重影响识别效果,无法发现敌方目标;若算法运行复杂度较高,则会导致识别缺乏实时性,从而失去快速掌握战场信息的主动权。因此,对于目标识别算法的选择和改进是实现无人机战场侦察打击能力的重点。基于卷积神经网络的目标识别算法使战场目标的智能化识别成为可能[2],通过智能目标识别,可以将地面站对信息的处理过程迁移到无人机平台上,从而真正实现无人化侦察预警。

3 目标识别算法

3.1 基于卷积神经网络的目标识别算法

近年来,基于卷积神经网络的目标识别算法发展迅速,根据目标识别的流程,主要可分为二阶段识别方法和单阶段识别方法[10]:1) 二阶段的识别方法,如R-CNN识别方法,首先通过卷积神经网络进行特征提取,然后将提取到的特征分别送入分类器进行分类和边界框回归网络进行目标定位,从而确定图像中目标的类别和位置信息[11-12];2) 单阶段识别方法,如YOLO算法,将特征提取和目标分类与位置回归作为整体进行训练,相较于二阶段识别方法,单阶段识别方法在速度上有绝对优势[13]。

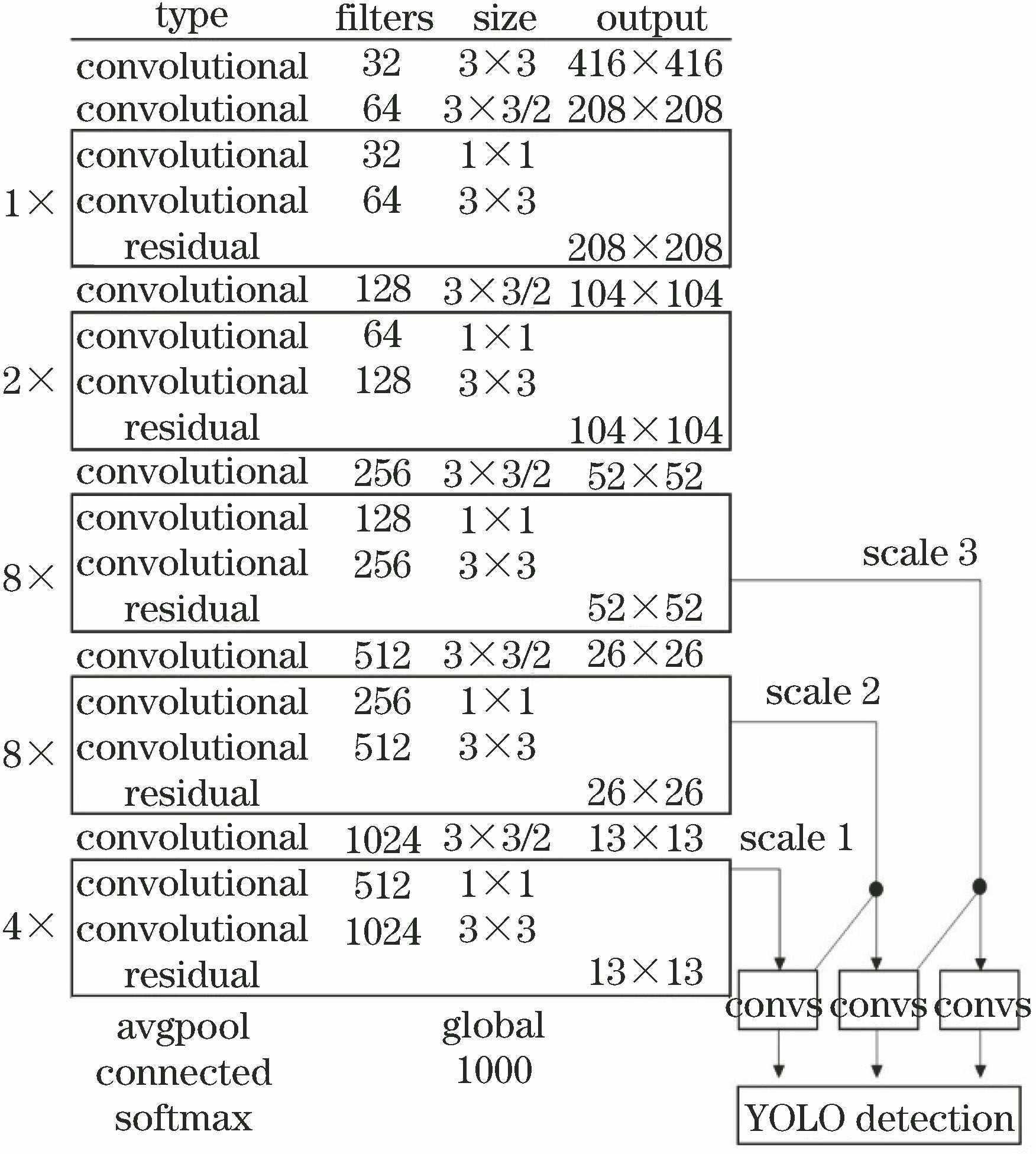

YOLOv3是Redmon等[14]提出的基于卷积神经网络的目标识别方法,该方法的特征提取网络共包含53个卷积层,因此也被称为darknet-53,如

3.2 改进的特征提取网络

尽管YOLOv3在目标识别算法中表现优异,但面对一些特征不明显的小目标时仍然缺乏判断力,容易出现错误识别和遗漏目标的问题。本文对YOLOv3的特征提取网络darknet-53进行改进,提高网络对图像特征的提取能力。

Inception-v4网络模型是目前分类网络中性能最好的模型之一,这主要得益于其使用的Inception模块可以对网络的横向进行拉伸,从而增强网络对上层信息的传递能力[16]。如

对特征提取网络的改进思路主要是将Inception模块融入darknet-53网络,提高网络的横向宽度,从而提高网络对图像特征的提取能力。

将得到的Inception-ResNet模块应用到darknet-53特征提取网络中,得到新的特征提取网络darknet-139,如

尽管新网络darknet-139看起来比darknet-53复杂很多,但网络复杂度并没有增加很多。

表 1. 网络计算复杂度比较

Table 1. Comparison of computational complexity of different networks

|

4 目标识别实验

4.1 目标识别实验

将新的特征提取网络darknet-139加载到YOLOv3目标识别算法中进行训练。实验设备配置如下:CPU,Intel(R) Xeon(R) E5-2683 v3,主频2.00 GHz;内存32 GB;显卡,英伟达Quadro K4200和英伟达Quadro M4000(双显卡);操作系统,Windows 10。实验采用的数据集由无人机采集与网络爬取结合的方式构建,共收集图片40024张,主要包含坦克、远火发射车、舰船、自行火炮、高射炮5类目标。将收集的图像按照1∶2∶7的比例进行划分,其中10%作为测试集,20%作为验证集,70%作为训练集,对训练集和验证集图像中的目标进行类别和位置标注后送入网络进行训练。

训练采用的学习率为0.0001,优化算法采用Momentum梯度下降算法,动量参数设为0.9,每次迭代的批量大小为64,学习率随迭代轮数更新的下降参数为0.0005。经过50000次迭代后网络最终收敛,收敛时的损失值为0.050830。

采用训练好的模型对包含远火发射车的图像进

行识别,将部分卷积的中间结果进行可视化,得到如

图 7. 部分中间卷积结果。(a)第1层;(b)第2层;(c)第3层;(d)第4层;(e)第5层;(f)第6层;(g)第7层;(h)第8层;(i)原图

Fig. 7. Partial intermediate convolution results. (a) Layer 1; (b) layer 2; (c) layer 3; (d) layer 4; (e) layer 5; (f) layer 6; (g) layer 7; (h) layer 8; (i) original graph

将训练好的网络权重加载到识别网络中进行测试,得到如

图 8. 目标识别效果。(a)(b)坦克目标识别;(c)(d)远程火箭炮识别;(e)~(h)高射炮识别;(i)舰船识别

Fig. 8. Target recognition effects. (a)(b) Tank target recognition; (c)(d) long-range rocket gun recognition; (e)-(h) antiaircraft gun recognition; (i) warship recognition

4.2 目标识别对比实验

为进一步了解新网络对图像特征的提取能力和目标识别准确率的提升效果,将新网络的训练模型与YOLOv3的训练模型进行对比测试。算法平均识别率表示为

式中:

表 2. 算法性能对比

Table 2. Performance comparison of algorithms

|

图 9. 模型识别效果比较。(a)(b) YOLOv3;(c)(d)新模型

Fig. 9. Comparison of model recognition effect. (a)(b) YOLOv3; (c)(d) proposed model

5 结论

首先对无人机作战平台在现代战争中的作用以及实现无人机对敌方目标智能识别的关键技术进行分析,阐明了目标识别算法在自动目标识别中的重要作用;然后以智能目标识别领域具有较高识别准确率和实时性的YOLOv3算法为基础,对卷积神经网络目标识别方法进行介绍,并将特征提取能力较强的Inception模块融入到YOLOv3算法中,提升了算法的识别准确率,取得了较好的识别效果。由于提高算法识别准确率时通常需要增加算法复杂度,这导致本文方法在识别速度上略有降低,而要提高识别速度通常又需要降低算法复杂度;因此,对算法的进一步改进将着重于减少网络的冗余设计,提高模型识别速度。另外,也可以通过提高硬件性能的方式提高算法执行效率。

将人工智能技术应用于各类作战平台可以大幅度提高无人化作战效率。例如,将人工智能用于声波分析可以从地表震动分析敌方地面**装备的型号和动向[18];在瞄准装具上增加智能瞄准可以更快速地锁定敌方单位,减少己方伤亡。随着人工智能技术的发展,智能导航、智能决策等更加先进的技术将大大提高现代战争的作战效率。

[1] 杜玉龙, 李建增, 张岩, 等. 无人机战场侦察中目标识别算法研究综述[J]. 飞航导弹, 2016( 7): 38- 41,53.

Du YL, Li JZ, ZhangY, et al. Overview of target recognition algorithms in UAV battlefield reconnaissance[J]. Aerodynamic Missile Journal, 2016( 7): 38- 41,53.

[2] 欧攀, 张正, 路奎, 等. 基于卷积神经网络的遥感图像目标检测研究[J]. 激光与光电子学进展, 2019, 56(5): 051002.

[3] 张慧, 王坤峰, 王飞跃. 深度学习在目标视觉检测中的应用进展与展望[J]. 自动化学报, 2017, 43(8): 1289-1305.

[4] 谷雨, 徐英. 面向SAR目标识别的深度卷积神经网络结构设计[J]. 中国图象图形学报, 2018, 23(6): 928-936.

[7] RedmonJ, FarhadiA. YOLO9000: better, faster, stronger[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6517- 6525.

[8] 孙皓泽, 常天庆, 王全东, 等. 一种基于分层多尺度卷积特征提取的坦克装甲目标图像检测方法[J]. 兵工学报, 2017, 38(9): 1681-1691.

[9] Lim TR, Guntoro AT. Car recognition using Gabor filter feature extraction[C]∥Asia-Pacific Conference on Circuits and Systems, 2002: 451- 455.

[10] 陈立里, 张正道, 彭力. 基于改进SSD的实时检测方法[J]. 激光与光电子学进展, 2019, 56(1): 011002.

[11] GirshickR. Fast R-CNN[C]∥IEEE International Conference on Computer Vision, 2015: 1440- 1448.

[13] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779- 788.

[14] RedmonJ, Farhadi A. Yolov3: an incremental improvement[J]. arXiv preprint arXiv: 1804. 02767, 2018.

[15] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770- 778.

[16] SzegedyC, IoffeS, VanhouckeV, et al. Inception-v4, inception-Resnet and the impact of residual connections on learning[C]∥AAAI Conference on Artificial Intelligence (AAAI-17), 2017: 4278- 4284.

[17] 魏湧明, 全吉成, 侯宇青阳. 基于YOLO v2的无人机航拍图像定位研究[J]. 激光与光电子学进展, 2017, 54(11): 111002.

Article Outline

吕攀飞, 王曙光. 无人机作战平台的智能目标识别方法[J]. 激光与光电子学进展, 2019, 56(7): 071001. Panfei Lü, Shuguang Wang. Intelligent Target Recognition Method of Unmanned Aerial Vehicle Combat Platform[J]. Laser & Optoelectronics Progress, 2019, 56(7): 071001.