基于改进的特征提取网络的目标检测算法  下载: 961次

下载: 961次

1 引言

随着人工智能时代的到来,目标检测已经成为人工智能及计算机视觉领域中的一个研究重点和难点,它的主要目标是识别出图像中感兴趣区域中的物体类别,并预测出物体的具体位置。目标检测在各个领域都有着非常重要的应用,如交通运输、人脸识别[1]、****[2]、医学诊断、视频监控等领域。

基于深度学习的目标检测算法主要可以分为2大类:一类是基于区域提名的算法,通过区域建议的方法生成一系列候选区域,对候选区域进行特征提取,然后进行分类和位置回归,经典的算法有R-CNN[3]、Fast R-CNN[4]、Faster R-CNN[5]等;另一类是端到端的算法,通过将输入图像划分成一系列的网格,对网格进行深度特征提取,最后完成目标的分类识别,该算法省去了生成候选框过程,将目标检测问题转化为回归问题,在保证一定精确度的前提下,能够有效提高检测速度,经典的算法有YOLO[6]、SSD[7]等。还有很多学者尝试着在此两类算法上进行创新,如在单次多检测框检测(SSD)基础上进行创新的有Faster-SSD算法[8],在改善感兴趣区域(ROI)分类效果上进行创新的有R-FCN算法[9],除此之外还有基于自适应卷积特征的目标跟踪算法[10]等。

虽然现阶段优秀的目标检测算法有很多,但还是存在识别准确率不高的问题。光照、天气等环境干扰因素,对输入图像特征提取不充分,以及去除多余重复框后确定目标位置时准确率不高,都会影响目标检测效果。本文提出一种基于改进的卷积神经网络(CNN)特征提取网络的目标检测算法,旨在提高目标检测精度。首先将训练集进行数据增强,并对数据增强技术作定量分析;其次设计一种只利用1×1、3×3、1×1卷积的双通道网络,用作目标检测算法Faster R-CNN的特征提取网络,对输入图像特征进行深层次利用;最后对非极大抑制(NMS)算法进行改进,使得预测阶段中含有目标的检测框能够因置信度的降低机制而更多地保留下来。

2 原理与方法

2.1 数据增强

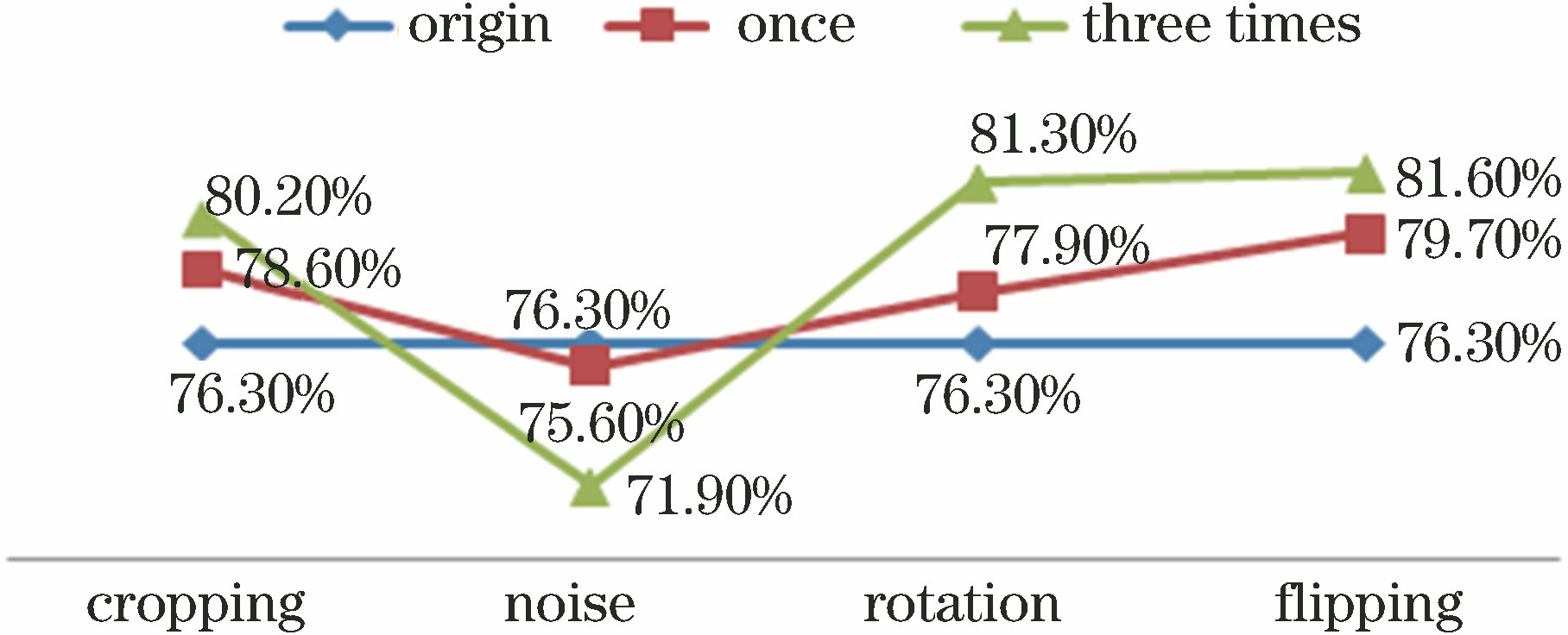

利用数据增强来提高目标检测效果是一个很重要的环节,如果增强方法选择不当,则会降低准确性和稳健性。所以针对翻转、裁剪、旋转、添加高斯噪声4种方法,在ImageNet数据集的子集上,采用AlexNet[11]对分类效果进行定量讨论。该子集共包含15类物体,每类物体有500张训练图片,输入图片大小为224×224×3。实验硬件设备是Ubuntu 16.04操作系统,语言版本是Python 2.7,使用Caffe平台。用这4种方法及其组合分别生成新的样本数量,数量是原始训练集的1倍和3倍,分别进行对比实验。

图 2. 翻转、裁剪、旋转方法组合效果对比图

Fig. 2. Comparison of combination effects of flipping, cropping, and rotating methods

由于添加高斯噪声并不能改善结果,于是对剩下3种方法的组合作进一步分析。

2.2 改进的特征提取网络

采取最新的网络内部链接拓扑结构,结合DensNet[12]和ResNet[13]的优点,设计一种双通道特征提取网络,如

该特征提取网络能够更好地提取图片的信息,提高特征的复用和传播,同时,还能够通过共享中间三个卷积,提高网络的计算效率,能在减少参数量上取得较大的优势,最终提高了模型的性能,降低目标检测的错误率,相对于其他检测方法具有较高的精度。

图 3. ResNet、DensNet、双通道网络单元结构节点表示图。(a) ResNet网络单元;(b) DensNe网络单元;(c)双通道网络单元

Fig. 3. Node representations of cell structures of ResNet, DensNet, and two-path networks. (a) ResNet network; (b) DensNet network; (c) two-path network

表 1. 特征提取网络结构

Table 1. Structure of feature extraction network

|

为突出特征网络在参数量上的优势,这里选择较复杂的100层网络、VGG-16网络、ResNet、DensNet进行参数量对比。超参数

表 2. 不同特征提取网络的复杂性比较

Table 2. Comparison of complexity of different feature extraction networks

|

2.3 改进的非极大值抑制算法

Faster R-CNN算法中建议窗口生成网络在计算过程中会得到2万多个带有置信值的预测框,这些预测框通过NMS的方法进行去冗余。但该算法仍然存在缺陷:如

图 4. 传统的NMS问题举例图。(a)马;(b)鸟

Fig. 4. Examples of traditional NMS problems. (a) Horses; (b) birds

针对该问题作进一步改进,将所有预测框按置信度分数排序,分数最高的预测框选作对比框,剩下的预测框与对比框的重叠面积大于交并比(IoU,

表 3. IoU阈值、β 参数、加权平均对平均值(AP)的影响(0.5、0.6、0.7代表不同的IoU阈值,w代表加权平均)

Table 3. Influences of IoU threshold, β parameter, and weighted average on AP (0.5, 0.6, and 0.7 represent different IoU thresholds; w represents weighted average)

|

除此之外,针对一个物体周围存在多个位置相近的预测框的情况,选择生成一个组合框,即对这几个相近预测框位置作加权平均,进一步改善预测框的位置。从

3 实现结果与分析

实验使用的环境配置为CPU Intel (R) Core (TM) i7-6700,GPU型号为NVIDIA GTX 1080Ti,操作系统是Ubuntu16.04,基于Caffe框架,python 2.7版本,MATLAB 2014b实现。本文采用端到端的联合训练法,占用显存小,并且训练速度快。采用随机梯度下降法和反向传播进行训练,动量设置为0.9,批次(batch size)设置为16,权重衰减(weight decay)设置为0.0005。由于使用数据增强导致数据集增多,因此训练次数也增加,设置为110万次。起初学习率(learning rate)设置为0.1,迭代65万次后学习率降为0.01,继续迭代至90万次,学习率降为0.001,直到训练结束,得到最终模型。

3.1 数据增强和改进的非极大值抑制的影响

表 4. 数据增强和改进的NMS机制对准确率的影响

Table 4. Influences of data augmentation and improved NMS mechanism on accuracy

|

3.2 训练时热身(warming up)技巧的影响

本实验采取热身技巧设置了学习率,在训练初始阶段,先以小学习率训练一定次数,然后再将学习率提升回来。对训练的前

表 5. 不同epoch对准确率的影响结果

Table 5. Influences of different epochs on accuracy

|

3.3 网络深度和网络增长率的影响

设计52层、100层和133层3种不同深度的特征提取网络,

图 5. 52层、100层、133层深度的特征提取网络参数量和Top-1错误率趋势图

Fig. 5. Trend of parameter quantity of feature extraction network with Top-1 error rate and 52, 100, and 133 layers

关于网络增长率

图 6. 网络增长率为12,18,24,48的特征提取网络的参数量和Top-1错误率趋势图

Fig. 6. Trend of parameter quantity of feature extraction network with Top-1 error rate and network growth rates of 12, 18, 24, and 48

3.4 检测精度和检测速度

表 6. 不同算法在VOC2007+VOC2012训练集下的测试结果

Table 6. Testing results of different algorithms under VOC2007+VOC2012 training sets

| |||||||||||||||||||||

4 结论

提出一种基于改进的特征提取网络的目标检测算法,将Faster R-CNN的特征提取网络替换成双通道网络;同时还对训练集进行了翻转、裁剪、旋转数据增强操作;在最后的预测部分改进了NMS算法,对所有IoU大于阈值的预测框的置信度分数进行降低,并对存在多个相近的预测框的位置进行加权平均以提高准确度。实验结果证明,本文算法的检测精度为79.1%,检测速度为2.1 frame/s,相比于其他主流算法,有效提高了检测精度,同时在two stage系列算法中具有一定的检测速度优势。由于two stage系列的目标检测算法检测速度较低,难以满足不同情境下的实时性要求,所以在未来算法改进中,希望能够在保证检测精度的基础上,提高检测速度,以满足实时性的要求。

[1] 何志超, 赵龙章, 陈闯. 用于人脸表情识别的多分辨率特征融合卷积神经网络[J]. 激光与光电子学进展, 2018, 55(7): 071503.

[2] 陈洋, 范荣双, 王竞雪, 等. 基于深度学习的资源三号卫星遥感影像云检测方法[J]. 光学学报, 2018, 38(1): 0128005.

[3] GirshickR, DonahueJ, DarrellT, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 580- 587.

[4] GirshickR. Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1440- 1448.

[5] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[6] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 779- 788.

[7] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9905: 21- 37.

[8] 陈立里, 张正道, 彭力. 基于改进SSD的实时检测方法[J]. 激光与光电子学进展, 2019, 56(1): 011002.

[9] Dai JF, LiY, He KM, et al. R-FCN: object detection via region-based fully convolutional networks[C]∥Proceedings of the 30th International Conference on Neural Information Processing Systems, December 5-10, 2016, Barcelona, Spain. New York: ACM, 2016: 379- 387.

[10] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[11] KrizhevskyA, SutskeverI, Hinton GE. ImageNet classification with deep convolutional neural networks[C]∥Proceedings of the 25th International Conference on Neural Information Processing Systems, December 3-6, 2012, Lake Tahoe, Nevada. New York: ACM, 2012: 1097- 1105.

[12] HuangG, Liu Z, van der Maaten L, et al. Densely connected convolutional networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 2261- 2269.

[13] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[14] NeubeckA, van GoolL. Efficient non-maximum suppression[C]∥18th International Conference on Pattern Recognition (ICPR'06), August 20-24, 2006, Hong Kong, China. New York: IEEE, 2006: 9210072.

Article Outline

乔婷, 苏寒松, 刘高华, 王萌. 基于改进的特征提取网络的目标检测算法[J]. 激光与光电子学进展, 2019, 56(23): 231008. Ting Qiao, Hansong Su, Gaohua Liu, Meng Wang. Object Detection Algorithm Based on Improved Feature Extraction Network[J]. Laser & Optoelectronics Progress, 2019, 56(23): 231008.