基于角点检测的可降解支架轮廓分割算法  下载: 828次

下载: 828次

1 引言

冠心病,作为一种最常见的心血管疾病,近几年成为全球头号死亡病因[1]。经皮冠状动脉介入术是目前治疗冠心病的主要方法[2]。随着冠脉介入治疗的发展,从球囊扩张(POBA)到金属支架(BMS)再到药物洗脱支架(DES),早期冠状动脉闭塞和再狭窄率有所下降[3], 然而有些术后风险是在DES置入3~6个月后才会变得明显[4],长期来看仍有发生晚期血栓的可能[5]。因为可降解支架(BVS)在提供暂时的径向支撑后可自动降解,故可显著降低晚期支架血栓发生的风险[6],并被认为是很有发展前景的支架。但是如果医生在支架植入过程中操作不当,就会导致支架和血管壁分离,引起支架贴壁不良,这可能会导致晚期支架血栓的发生,给患者的生命带来威胁。因此,在临床BVS支架植入术中,需要实时分析和评估支架贴壁情况。

血管内光学相干断层扫描技术(IVOCT)是近年来发展较快的一种最具发展前途的新型层析成像技术,其轴向分辨率可达5~15 μm,纵向分辨率达25 μm,探测深度约为2 mm,可对血管和BVS支架清晰成像,这为利用图像对BVS支架的贴壁情况进行自动分析提供了可能[7-8]。目前,支架贴壁情况主要依靠专家进行人工定性分析,人工定性分析具有主观性且不精确。与此同时,一个回拉中IVOCT 图像数目众多,每张IVOCT图像中包含数十个BVS支架,整个回拉中支架数量巨大,依靠专家进行定量分析耗时耗力。因此,自动、准确、快速地进行支架贴壁情况分析在临床中有很大的价值和需求。为了实现支架贴壁情况自动分析,需要准确分割出IVOCT图像中的BVS支架轮廓。

根据调研情况,目前关于可降解支架自动分析方面的研究较少。Wang等[9]提出了一种基于灰度和梯度特征来检测BVS支架的算法,该算法设置了大量的固定阈值,对于不同病人的IVOCT图像亮度和对比度存在较大差异的情况很难全部适应,且对于支架周围存在血液伪影或支架内部断裂情况的检测性能不佳。Lu等[10-11]提出一种将支架检测和支架分割分开进行的算法,第一阶段进行支架位置的检测,基于机器学习的方法检测支架所在的感兴趣区域,第二阶段利用DP算法进行支架轮廓分割。这种方法的泛化性较好,且利用机器学习的方法进行支架检测的准确率也较高,但使用DP算法进行轮廓分割时,要求遍历整个支架感兴趣区域来得到全局能量最小的轮廓,而支架轮廓周围的血液伪影和支架内部断裂都会影响到支架轮廓的分割效果,支架分割效果有待提升。

针对前人方法的局限性,本文利用支架具有四边形外观这一先验信息,提出了一种基于支架角点得到支架轮廓的分割算法。该算法可以避免分割结果受到如支架断裂、血液伪影和管腔轮廓等干扰信息的影响。首先,基于扩展的哈尔特征,利用改进的AdaBoost算法训练角点分类器;然后,使用该角点分类器检测得到候选角点,从候选角点中选出4个最优点作为支架角点;最后,基于4个角点得到分割轮廓,实现支架轮廓的自动分割。基于分割结果,可进行支架贴壁情况的自动分析。为客观公正地评估该算法的性能,将专家手动标记的角点位置与本文方法的角点检测结果进行比较,将使用DP算法进行轮廓分割的结果与本文方法的分割结果进行对比。实验结果证明,本文算法适用于分割复杂背景下的BVS支架,且其分割性能优于DP算法,具有很好的稳健性和泛化性。

2 本文算法

本文算法主要包含以下三个步骤:

1) 构建角点分类器。主要目的是基于机器学习方法训练用于检测支架角点的分类器。

2) 支架4个角点检测。利用步骤1)中训练得到的角点分类器,在支架感兴趣区域内检测得到候选角点,再进行后处理得到用于轮廓分割的4个角点,进而得到支架轮廓。

3) 贴壁情况分析。基于支架轮廓分割结果,实现支架贴壁情况的自动分析。

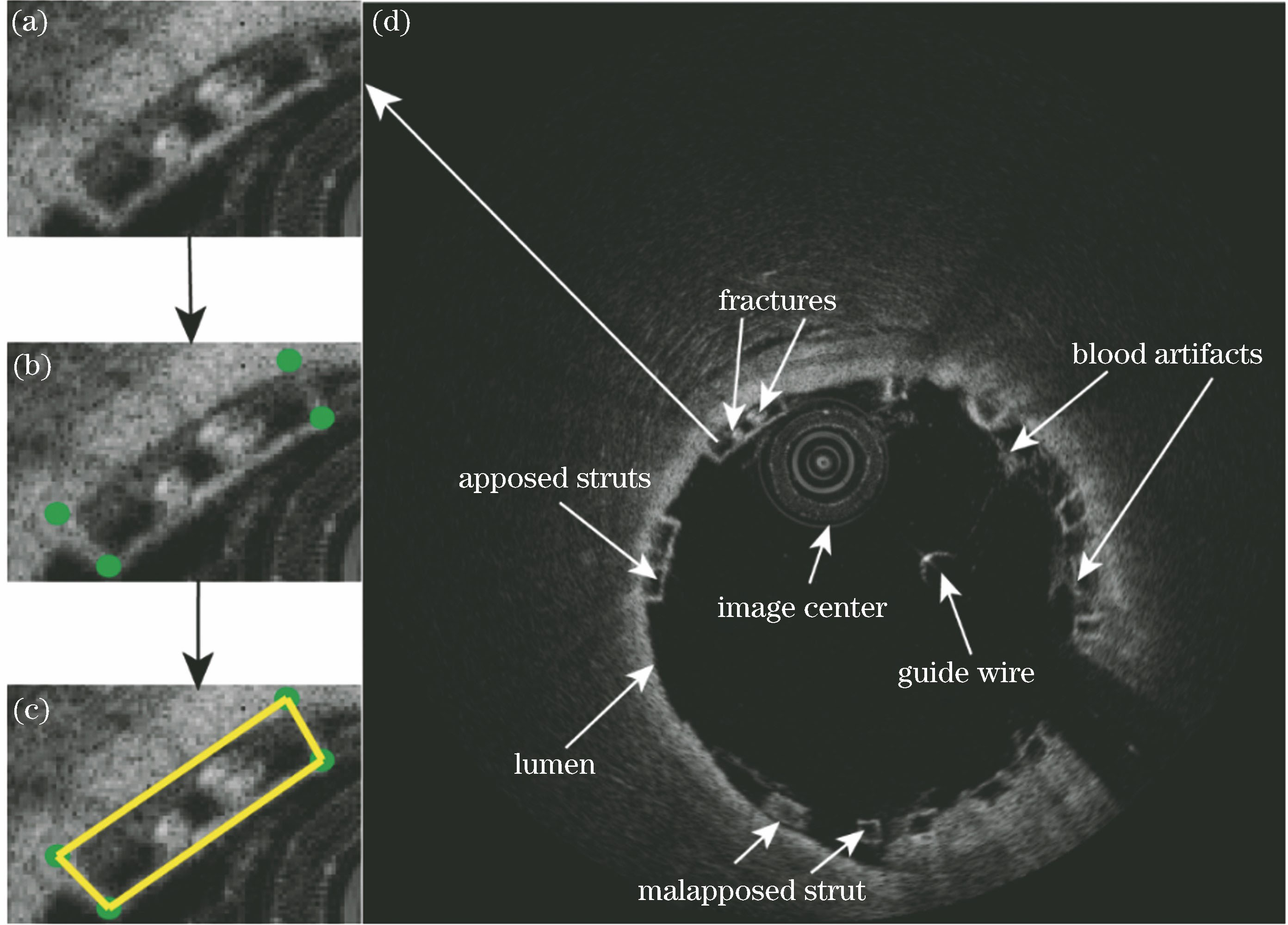

直角坐标系下植入支架的IVOCT图像如

图 1. 直角坐标系下支架植入后的IVOCT图像和支架轮廓可由专家标记的4个支架角点表示过程。(a)单个放大的支架;(b)专家在单个支架标记4个角点;(c)基于4个标记角点得到支架轮廓图;(d)直角坐标系下支架植入后的IVOCT图像

Fig. 1. IVOCT images after BVS stenting in Cartesian coordinate system and process where strut contour can be represented from four labeled corners by expert. (a) Single enlarged strut; (b) four corners labeled on single strut by expert; (c) strut contour obtained from four labeled corners; (d) IVOCT image after BVS stenting in Cartesian coordinate system

图 2. 基于不同转换中心得到的两种IVOCT极坐标图像。(a)以直角坐标下图像的图像中心为转换中心的IVOCT极坐标图像;(b)以直角坐标下图像的管腔轮廓中心为转换中心的IVOCT极坐标图像

Fig. 2. IVOCT images shown in polar coordinates based on two different transformed centers. (a) IVOCT image in polar coordinate system using center of image in Cartesian coordinate system as transformed center; (b) IVOCT image in polar coordinate system using lumen-contour center of image in Cartesian coordinate system as transformed center

2.1 构建角点分类器

考虑到Moravec等[12-14]常用的角点检测算法在复杂背景下进行角点检测时,算法精度和稳健性不佳,本文采用机器学习的方法训练得到角点分类器。在机器学习方法中进行样本训练时,样本特征和学习算法的选择至关重要。

2.1.1 训练样本

如

2.1.2 特征提取

选取正负训练样本后,需要提取训练样本特征。大量检测算子和描述子在文献[ 15-21]中提出, 其中局部二值模式(LBP)、方向梯度直方图(HOG)和Haar特征是三种应用广泛的特征。其中Haar特征最初由Viola等[20]应用于目标检测之人脸检测领域,人脸识别中使用了边缘、线性、中心和对角特征组成的特征模板。结合支架特征和角点检测的需求,选用Haar特征进行支架角点检测。

基于支架角点处的结构特征,将文献[

20]中提出的基本Haar特征模板扩展到

图 4. 基本哈尔特征模板及基于支架特征得到的扩展模板。(a)~(e)基本哈尔特征模板;(f)~(j)基于支架特征的扩展模板

Fig. 4. Basic prototypes with Haar-like features and extended prototypes combined with struts' features. (a)-(e) Basic prototypes with Haar-like features; (f)-(j) extended prototypes combined with struts' features

2.1.3 训练角点分类器

选定特征模板后,挑选出最具分辨力的Haar特征来进行支架角点和非角点的分类尤为重要。在此,应用Adaboost算法对训练样本进行学习,从而挑选出最具有分辨力的Haar特征构成角点分类器。本文方法中,角点分类器的训练主要包含2个阶段,即采用Adaboost算法分别训练强分类器和级联强分类器,以构成角点分类器。

采用Adaboost算法训练强分类器。Boosting是一族可将弱学习器提升为强学习器的算法,已成功应用于解决二分类问题。Adaboost算法作为Boosting族最著名的代表,最初由Freund等[22]提出,其基本思想是:通过组合不同的弱分类器来构建一个强分类器,从而极大提升分类器的分类性能。Adaboost 算法被Viola等[20]成功用于人脸检测领域,本文采用Adaboost算法对训练样本进行学习,从而挑选出最具有分辨能力的Haar特征构成分类器。Adaboost 算法步骤如下:

1) 输入训练数据集

2) 输入弱学习算法,其具体步骤为:

(1) 初始化训练数据的权值分布

(2) 设定强分类器训练时的迭代次数

a) 使用具有权值分布

b) 计算

式中:

c) 计算

d) 更新训练数据集的权重分布

式中:

(3) 构建基本分类器的线性组合

级联强分类器为角点分类器。基于上述得到的由

训练过程中,为保证下一级强分类器比上一级强分类器对难以判断的子窗口具有更强的分类能力,对前三级强分类器的训练负样本进行人工设定,在之后的每一级强分类器训练过程中,采用不同的负样本进行训练。具体来说就是将当前得到的强分类器进行级联,级联分类器在用于生成训练负样本的IVOCT图像上进行检测,将检测结果与专家标记的真实结果进行比对,将误报窗口作为下一级强分类器训练的负样本,而正样本保持不变。

在检测过程中,将成功通过所有级强分类器的子窗口判定为支架候选角点,为了衡量支架候选角点被判定为支架角点的可能性,当子窗口通过所有级强分类器时,为每个支架候选角点计算总得分

式中:

式中:

至此,训练得到角点分类器,角点分类器在支架感兴趣区域内自动检测得到候选角点及每个候选角点对应的分数

2.2 支架4个角点检测

如

2.2.1 支架候选角点检测

此部分是利用4个角点进行支架分割的基础,使用训练好的角点分类器在极坐标IVOCT图像中支架感兴趣区域进行检测,得到支架候选角点。首先,确定支架角点检测感兴趣区域,如

2.2.2 支架4个区域划分

在得到支架角点候选点位置后,从支架的所有候选角点中选择4个最优点作为支架角点,理想情况下具有最高分数的4个角点即可作为支架角点,但因为支架角点检测过程中容易受到血液伪影和支架内部断裂的影响,导致非角点位置检测出具有较高分值的角点候选点。为解决这一问题,考虑到以管腔轮廓中心为图像转换中心得到的极坐标IVOCT图像中,BVS支架形态较为规则且大部分都平行于管腔轮廓,在此,利用这一先验信息进行支架角点的选择。在极坐标IVOCT图像中,可以直观地看出代表支架的4个角点分别落在以支架中心为坐标中心的4个独立象限区域,相较于从所有支架候选点中选择4个点作为支架角点的方法,从4个区域的候选点中分别选择一个点作为支架角点的方法更加准确有效,因此将支架感兴趣区域划分为4部分,以选出最优候选角点作为支架角点。

理想情况下,极坐标IVOCT图像中,直接以支架中心为直角坐标中心,水平横轴,竖直纵轴,十字划分,即可将支架划分为包含4个角点的4个象限区域;但在实际情况下,如

图 5. 支架4个角点检测流程图。(a)~(d)使用十字划分方法得到支架的4个角点流程图;(e)~(h)使用支架角度划分方法得到4个角点流程图;(i)支架角度获取方法

Fig. 5. Flow charts of four corners detection of struts. (a)-(d) Flow chart of four corners detection by cross-division method; (e)-(h) flow chart of four corners detection by strut-angle-division method; (i) method of getting strut angle

如

2.2.3 支架角点选择

在得到如

对于每部分支架区域,假设有

并根据角点分类器得到的分数,将该部分具有最高分数的候选角点作为支架角点。然而,因为支架候选角点检测过程中容易受到支架内部断裂和周围血液伪影的影响,导致单纯依靠分类器分数来决定角点位置的结果不准确,在此,采用表达式

计算

式中:

2.3 贴壁情况计算

在得到所有支架的角点后,将支架角点从极坐标系转化到直角坐标系下,得到直角坐标下的支架分割结果。基于直角坐标下支架和管腔轮廓的分割结果计算BVS支架的贴壁情况。计算贴壁情况的方法同样使用文献[

10]中的方法,设血管壁轮廓中心为

3 实验

3.1 实验材料

实验中,所有的IVOCT图像都是通过FD-OCT系统(C7-XR system, St. Jude, St. Paul, Minnesota)获取的,所有支架均采用ABSORB 1.1 BVS支架(Abbott Vascular, Santa Clara, CA, USA),直角坐标系下图像大小为704 pixel×704 pixel,极坐标系下图像大小为352 pixel×720 pixel,系统的轴向成像分辨率为10 μm/pixel。实验中共使用16个回拉,包含4336张IVOCT图像,其中有1767张包含BVS支架的有效图像,BVS支架数目共计10561个,所有BVS支架由专家进行角点标记,作为真实值。在16个回拉中,4个回拉用作训练集,4个回拉用作验证集,其他8个回拉作为测试集。

3.2 参数设置

实验中,支架检测感兴趣区域的大小根据文献[

10]中得到的支架中心位置和半径确定。一般情况下,支架的厚度约为150 μm,长度为150~800 μm。根据支架的长度和宽度范围,将支架感兴趣区域的长度设定为支架半径的2.5倍,宽度设定为支架半径的1.5倍。根据支架宽度的大小,将训练样本的大小

3.3 评价标准

为了定量地评价角点检测性能,计算支架检测角点和专家标记真实角点之间的距离偏差(

式中:(

为了定量评估利用4个角点进行支架轮廓分割的性能,使用Dice系数(

式中:

3.4 结果分析

为了公平公正地比较本文算法和DP算法的分割结果,在相同的数据集上测试这两种算法。需要特别说明的是,两种方法在相同的支架检测感兴趣区域内进行轮廓分割,基于分割结果进行定性和定量评估。

3.4.1 定性结果

为了能直观显示支架贴壁情况,使用VTK进行支架3D可视化,血管内BVS支架3D重建模型横截面如

图 6. 支架分割结果对比图。(a)~(d)使用DP算法得到的支架分割结果;(e)~(h)使用本文中角点检测方法得到的支架分割结果

Fig. 6. Comparison of strut segmentation results. (a)-(d) Results of BVS strut segmentation using DP algorithm; (e)-(h) results of BVS strut segmentation using proposed algorithms

图 7. BVS支架3D重建模型图。(a)含有冠状动脉血管的BVS支架3D重建图;(b)去除冠状动脉血管的BVS支架3D重建图

Fig. 7. 3D reconstruction models of BVS struts. (a) 3D reconstruction model of BVS strut with coronary artery; (b) 3D reconstruction model of BVS strut without coronary artery

3.4.2 定量结果

本文算法和DP算法分别在8个回拉上进行测试,定量结果如

表 1. 支架检测与分割结果

Table 1. Results of strut detection and segmentation

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

4 结论

提出了一种基于角点检测进行IVOCT图像中BVS支架轮廓分割的算法。该算法利用了支架具有四边形外观的先验信息,由4个角点得到支架轮廓。首先,使用机器学习的方法,训练角点分类器;其次,检测支架候选角点,并后处理得到4个支架角点;最后得到支架轮廓,从而可以进行支架贴壁情况的自动分析。本文算法将BVS支架轮廓分割问题转化为支架角点检测问题,避免了DP算法在分割过程中受到血液伪影和支架断裂等问题的影响。实验结果显示,本文算法对BVS支架分割具有较高的准确性和较好的稳健性,且分割性能较DP算法有较大的提升。基于有效的支架分割结果,可以实现支架贴壁情况的自动分析。后续工作将围绕BVS支架三维重建展开,以在支架植入过程中给予医生临床上实时有效的指导。

[1] Forouzanfar M H, Afshin A, Alexander L T. et al. Global, regional, and national comparative risk assessment of 79 behavioural, environmental and occupational, and metabolic risks or clusters of risks, 1990-2015: a systematic analysis for the Global Burden of Disease Study 2015[J]. The Lancet, 2016, 388(10053): 1659-1724.

[4] Kotani J I, Awata M, Nanto S, et al. Incomplete neointimal coverage of sirolimus-eluting stents[J]. Journal of the American College of Cardiology, 2006, 47(10): 2108-2111.

[10] 鲁逸峰, 金琴花, 荆晶, 等. 基于机器学习的可降解支架检测与分割算法[J]. 光学学报, 2018, 38(2): 0215005.

[11] Lu YF, Cao YH, Jin QH, et al. Adaboost-based detection and segmentation of bioresorbable vascular scaffolds struts in IVOCT images[C]//2017 IEEE International Conference on Image Processing (ICIP), September 17-20, 2017, Beijing, China. New York: IEEE, 2017: 4432- 4436.

[12] Moravec HP. Obstacle avoidance and navigation in the real world by a seeing robot rover[R]. Stanford,USA: Stanford University, 1980.

[13] Harris CG, StephensM. A combined corner and edge detector[C]//Proceedings of 4th Alvey Vision Conference. [S.l.: s.n.], 1988, 15( 50): 10- 5244.

[16] LienhartR, Maydt J. An extended set of Haar-like features for rapid object detection[C]//Proceedings of International Conference on Image Processing, September 22-25, 2002, Rochester, NY, USA. New York: IEEE,2002, I: 900- 903.

[17] DalalN, TriggsB. Histograms of oriented gradients for human detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), June 20-25, 2005, San Diego, CA, USA. New York: IEEE, 2005: 886- 893.

姚林林, 金琴花, 荆晶, 陈韵岱, 曹一挥, 李嘉男, 朱锐. 基于角点检测的可降解支架轮廓分割算法[J]. 光学学报, 2019, 39(7): 0715001. Linlin Yao, Qinhua Jin, Jing Jing, Yundai Chen, Yihui Cao, Jianan Li, Rui Zhu. Corner Detection-Based Segmentation Algorithm of Bioresorbable Vascular Scaffold Strut Contours[J]. Acta Optica Sinica, 2019, 39(7): 0715001.