基于双通道空洞卷积神经网络的高光谱图像分类  下载: 1077次

下载: 1077次

1 引言

高光谱传感器可同时以数百个连续且细分的光谱波段对目标区域进行成像,并与光谱结合形成像素级高光谱图像。高光谱图像中包含大量的光谱信息和空间信息,所形成的三维数据块能够有效地反映许多在宽波段多光谱图像中无法探测到的地物信息[1],被广泛应用于矿产勘查[2]、化学成像[3]和环境科学等领域[4]。目前,高光谱图像分类在遥感图像处理领域中备受关注,然而,高光谱图像的已标记样本数据量十分有限,且图像自身维度较高,包含大量光谱信息,因此高光谱图像分类问题仍面临巨大挑战[5]。

近年来,许多监督机器学习方法已成功地应用在高光谱图像分类中[6],如支持向量机(SVM)和基于核的方法[7]、随机森林(RF)[8]和罗杰斯特回归(Rogerstein regression)[9]等。受休斯现象的影响,当图像维数过高时,传统的基于光谱信息的高光谱图像方法的分类精度会急剧下降[10]。在早期研究中,一些方法利用单一光谱信息对高光谱图像进行分类[11-12],然而相邻光谱间的相关性较高,在高光谱图像中常存在光谱冗余和噪声,因此仅利用图像的光谱特征很难获得良好的分类精度。

为了克服这一挑战,空间光谱联合特征的提取已成为研究热点[13]。Zhu等[14]强调了空间光谱测量对高光谱图像精确分类的重要性。近年来,卷积神经网络(CNN)在图像识别领域中展现出优秀性能,被广泛应用于提取高光谱图像的空间光谱特征[15-16]。Chen等[17]使用栈式自编码器学习高光谱图像的深层特征,再通过逻辑斯蒂回归对提取的深层特征进行分类。Li等[18]采用多尺度滤波器对高光谱图像的空间特征和光谱特征进行融合,再利用带有两个残差模块的9层全卷积网络对融合特征进行有效分类。Hang等[19]提出了一种基于门控循环单元(GRU)的级联循环神经网络模型用于高光谱图像分类,并在模型中集成了卷积层来学习光谱特征和空间特征。Niu等[20]利用语义分割领域中DeepLab方法提取高光谱图像的多尺度空间特征,将其与光谱特征进行融合并分类。然而,上述方法在特征提取过程中仍面临图像信息丢失的问题。

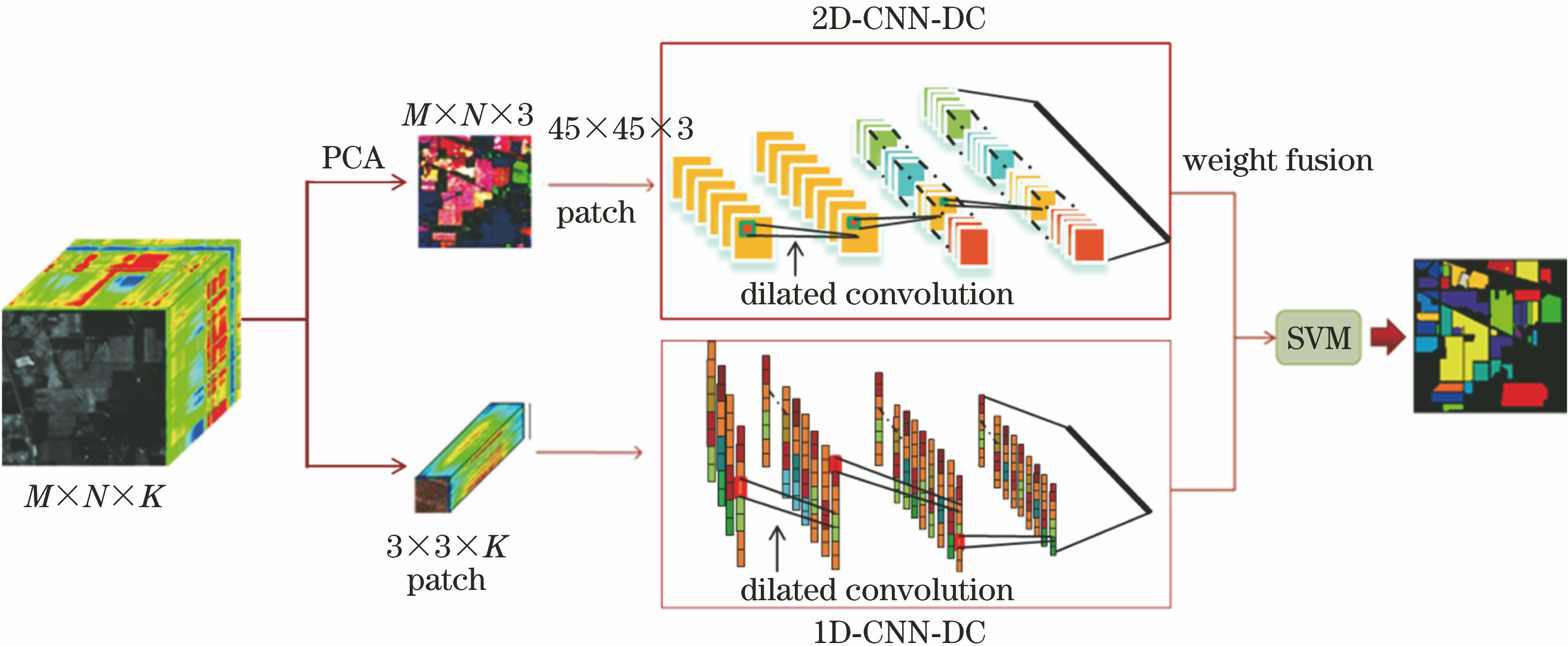

空洞卷积能在保持图像分辨率的同时,指数级地扩展滤波器的感受野,避免图像信息丢失,有效地提高分类精度[21]。基于此,本文提出了一种新的基于双通道空洞卷积神经网络(DCD-CNN)的高光谱图像分类框架,用于提取高光谱图像的空间特征和光谱特征:利用一维空洞卷积神经网络(1D-CNN-DC)提取光谱特征;利用主成分分析(PCA)降低高光谱图像的光谱维度后,利用二维空洞卷积神经网络(2D-CNN-DC)提取图像空间特征,再采用z-分数(z-score)方法对空间特征和光谱特征进行归一化处理,并采用加权融合方法对两种特征进行融合,最后将融合后的特征加入SVM进行分类。

比较两个公共高光谱图像数据集的分类性能,结果表明,所提框架优于传统方法和现有的基于深度学习的方法,特别是对于样本有限的小规模样本。

2 基本原理

2.1 基于1D-CNN-DC的光谱特征提取

将一些基于深度学习的方法应用于机器视觉领域的语义分割时,重复池化操作会降低图像的特征分辨率及精确度,在高光谱图像分类中同样面临这个问题。为此,引入空洞卷积来解决这一问题,其是在保持分辨率的情况下以指数方式扩展滤波器的感受野。在传统卷积运算中,滤波器以连续的方式对输入信号进行卷积,而在空洞卷积运算中,滤波器以跳跃的方式对输入信号进行处理。考虑一维空洞卷积的情形,对于给定的一维信号,其输入信号为x,则空洞卷积的输出定义为

式中:i为第i个像素;w(l)为一个长度为l的滤波器;r为卷积核对输入数据进行卷积时的空洞率,相当于在原始滤波器的两个相邻值间插入(r-1)个孔(即0值)生成新的滤波器,再将输入信号与滤波器进行卷积[22]。一维空洞卷积如

对于大小为M×N×K的高光谱图像,其包含M×N个像素,其中K为光谱通道数。对于每个可分类的像素,取邻域大小为3×3×K的3D数据块作为1D-CNN-DC的原始输入。为了满足1D-CNN-DC的输入要求,将每个数据块重新排列成长度为L的一维向量,再利用1D-CNN-DC从这些向量中提取高阶光谱特征。

图 2. 一维空洞卷积示意图。(a)标准卷积;(b)空洞卷积

Fig. 2. Schematic of 1D dilated convolution. (a) Standard convolution; (b) dilated convolution

2.2 基于2D-CNN-DC的空间特征提取

当2D-CNN-DC直接应用于高光谱图像时,由于网络参数多,高光谱图像的光谱维数过高,且标记数据少,容易出现过拟合现象。因此,利用PCA将原始高光谱数据的光谱维度降为3,再将图像分割成空间大小为45×45×3的数据块。将这些数据块作为输入数据,利用2D-CNN-DC提取高光谱图像的空间特征。

实验中的两个通道采用了相同结构和参数,共包含四个空洞卷积层和一个池化层。每个卷积层的r=2,步长为1,滤波器数量为64,滤波器大小分别为1-3-3-3,采用ReLU非线性函数作为卷积层的激活函数。卷积层后连接batch normation层,为了更加有效地防止过拟合,添加了dropout层,失活率设置为0.5。池化层采用常用的最大池化层(max pooling)。网络的具体结构如

2.3 特征融合

利用2.1节和2.2节的方法提取光谱特征和空间特征后,在特征融合阶段,使用z-score对两个特征进行归一化,再进行加权融合。假设S1是1D-CNN-DC提取的光谱特征,S2是2D-CNN_DC提取的空间特征,使用z-score函数逐行标准化S1和S2,表达式为

式中:xij为第i行中的一个元素值;μi和σi分别为第i行的均值和标准差。加权融合特征S可表示为

式中:f(S1)为归一化后的光谱特征;f(S2)为归一化后的空间特征;λ为平衡两个特征的权重因子。

将融合后的特征S放入SVM分类器中,得到最终分类结果。

3 实验及结果

3.1 数据集

实验性能评估采用两个常用的高光谱图像数据集:Indian Pines数据集和Pavia University数据集。Indian Pines数据集是由机载可见光/红外成像光谱仪(AVIRIS)于1992年采集,包含图像尺寸为145 pixel×145 pixel和200个可用于分类的有效光谱波段,其空间分辨率为20 m,共有16个真实地物类别,去除背景像素后,共包含10249个已标记样本,实验采用数据的10%作为训练集,90%作为测试集对所提框架进行分类性能评估。Pavia University数据集是由机载反射光学光谱成像仪(ROSIS)采集,包含图像尺寸为610 pixel×340 pixel和103个用于分类的有效光谱波段,其空间分辨率为1.3 m,真实地物由9个类别组成,共包含42776个已标记样本,选取数据的5%作为训练集,95%作为测试集进行实验。

3.2 参数分析

网络训练采用随机梯度下降(SGD)法对网络参数进行优化。实验将权重衰减(decay)、动量(momentum)和学习率(lr)分别设置为0.0005、0.6和0.04。每次训练共进行2000次迭代,批量大小设置为16。λ在0~1之间进行选择,不同λ值的两个数据集的总体精度(OA)变化如

从

3.3 结果分析

为了评价所提方法的性能,对SVM[9]、AEAP(Auto Extended Attribute Profiles)[23]、DCNN(Deep Convolution Neural Network)[24]和FEFCN-ELM(Feature Enhancement Fully CNN Extreme Learning Machine)[18]共4种高光谱图像分类方法进行比较。使用OA、平均精度(AA)和Kappa系数作为性能指标。

3.3.1 Indian Pines数据集的结果分析

表 1. 不同方法在Indian Pines数据集上的分类结果

Table 1. Classification results of different methods on Indian Pines datasetunit: %

|

从

所有方法的分类地物图如

图 5. 不同方法在Indian Pines数据集上的分类图。(a)真值图;(b) SVM;(c) AEAP;(d) DCNN; (e) FEFCN-ELM;(f)所提方法

Fig. 5. Classification maps of different methods on Indian Pines dataset. (a) Ground truth; (b) SVM; (c) AEAP; (d) DCNN; (e) FEFCN-ELM; (f) proposed method

3.3.2 Pavia University数据集的结果分析

所有方法的分类地物图如

表 2. 不同方法在Pavia University数据集上的分类结果

Table 2. Classification results of different methods on Pavia University datasetunit: %

|

图 6. 不同方法在Pavia University数据集上的分类图。(a)真值图;(b) SVM;(c) AEAP;(d) DCNN;(e) FEFCN-ELM;(f)所提方法

Fig. 6. Classification maps of different methods on Pavia University dataset. (a) Ground truth; (b) SVM; (c) AEAP; (d) DCNN; (e) FEFCN-ELM; (f) proposed method

4 结论

为了解决由于图像分辨率损失而造成图像分类精度下降的问题,提高高光谱图像分类的性能,引入了空洞卷积,并提出了一种新的基于DCD-CNN的深度学习分类框架。在两个公共数据集上进行实验,并与其他4种高光谱图像分类方法进行比较。实验结果表明,该框架具有最佳的分类精度。然而,在高光谱图像分类领域,仍有许多问题需进行进一步研究。例如,在实际问题中,会获得更多的未标记样本,而监督分类方法尚不能充分利用这些未标记的样本进行分类。未来研究中,将尝试使用半监督和无监督分类方法来解决这些问题。

[1] Bioucas-Dias J M, Plaza A, Camps-Valls G, et al. Hyperspectral remote sensing data analysis and future challenges[J]. IEEE Geoscience and Remote Sensing Magazine, 2013, 1(2): 6-36.

[2] van der Meer F. Analysis of spectral absorption features in hyperspectral imagery[J]. International Journal of Applied Earth Observation and Geoinformation, 2004, 5(1): 55-68.

[3] Gowen A, Odonnell C, Cullen P, et al. Hyperspectral imaging-an emerging process analytical tool for food quality and safety control[J]. Trends in Food Science & Technology, 2007, 18(12): 590-598.

[7] Camps-Valls G, Bruzzone L. Kernel-based methods for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(6): 1351-1362.

[8] Ham J, Chen Y C, Crawford M M, et al. Investigation of the random forest framework for classification of hyperspectral data[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(3): 492-501.

[9] Foody G M, Mathur A. A relative evaluation of multiclass image classification by support vector machines[J]. IEEE Transactions on Geoscience and Remote Sensing, 2004, 42(6): 1335-1343.

[10] Hughes G. On the mean accuracy of statistical pattern recognizers[J]. IEEE Transactions on Information Theory, 1968, 14(1): 55-63.

[11] Samaniego L, Bardossy A, Schulz K. Supervised classification of remotely sensed imagery using a modified K-NN technique[J]. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46(7): 2112-2125.

[12] Martínez-Usómartinez-uso A, Pla F, Sotoca J M, et al. Clustering-based hyperspectral band selection using information measures[J]. IEEE Transactions on Geoscience and Remote Sensing, 2007, 45(12): 4158-4171.

[13] Zhang L P, Zhang L F, Du B. Deep learning for remote sensing data: a technical tutorial on the state of the art[J]. IEEE Geoscience and Remote Sensing Magazine, 2016, 4(2): 22-40.

[14] Zhu X X, Tuia D, Mou L C, et al. Deep learning in remote sensing: a comprehensive review and list of resources[J]. IEEE Geoscience and Remote Sensing Magazine, 2017, 5(4): 8-36.

[15] Ouyang N, Zhu T, Lin L P. Convolutional neural network trained by joint loss for hyperspectral image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(3): 457-461.

[16] 毕晓君, 周泽宇. 基于双通道GAN的高光谱图像分类算法[J]. 光学学报, 2019, 39(10): 1028002.

[19] Hang R L, Liu Q S, Hong D F, et al. Cascaded recurrent neural networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(8): 5384-5394.

[20] Niu Z J, Liu W, Zhao J Y, et al. DeepLab-based spatial feature extraction for hyperspectral image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(2): 251-255.

[22] Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[24] Yue J, Zhao W Z, Mao S J, et al. Spectral-spatial classification of hyperspectral images using deep convolutional neural networks[J]. Remote Sensing Letters, 2015, 6(6): 468-477.

Article Outline

胡丽, 单锐, 王芳, 江国乾, 赵静一, 张智. 基于双通道空洞卷积神经网络的高光谱图像分类[J]. 激光与光电子学进展, 2020, 57(12): 122803. Li Hu, Rui Shan, Fang Wang, Guoqian Jiang, Jingyi Zhao, Zhi Zhang. Hyperspectral Image Classification Based on Dual-Channel Dilated Convolution Neural Network[J]. Laser & Optoelectronics Progress, 2020, 57(12): 122803.