基于YOLO v3的机场场面飞机检测方法  下载: 1829次

下载: 1829次

1 引言

场面飞机检测是智慧机场、远程塔台的重要组成部分,它能自动识别机场图像中的飞机,辅助塔台管制员保障飞行安全,在场面飞机冲突预警、防跑道侵入、远程指挥等方面具有重要的应用价值[1]。

场面飞机图像通常是由航站楼、塔台的摄像机采集。相比于轮廓完整、姿态单一的遥感飞机图像,场面飞机图像存在飞机相互遮挡,及拍摄距离远造成飞机较小等难以检测的问题,这使得基于滑动窗口的传统方法受到限制[2-4]。近些年,随着深度学习技术的快速发展,基于深度学习的方法广泛应用于目标检测领域。目前基于深度学习的方法主要分为两类:一是基于候选区域的方法,例如Fast-RCNN[5]、Faster-RCNN[6];二是基于回归的方法,例如You Only Look Once(YOLO)[7]、YOLO9000[8]、SSD[9]、YOLO v3[10-11]。其中,基于候选区域的方法具有很高的检测准确率,但是检测速度较慢,不适用于场面飞机检测,而基于回归的检测方法检测速度高,满足场面飞机检测实时性要求,且YOLO v3融合锚(Anchor)[12]、特征金字塔(FPN)[13]等策略,大大提高了检测准确率。

YOLO v3是目前最优秀的检测算法之一,国内外诸多研究者将其应用于飞机检测领域,并提出了不同的改进方案。李耀龙等[14]将Ting-YOLO[15]应用到机场飞机目标识别中,并提出一种简化的Ting-YOLO算法,提高了检测速度。Kharchenko等[16]将YOLO v3应用于无人机拍摄的地面小物体检测,该方法具有较高的检测能力、定位精度和实时处理速度。戴伟聪等[17]将YOLO v3应用于遥感图像中的飞机检测,并将密集相连模块用于骨干网络,实现了多尺度遥感图像中的飞机检测。上述文献将YOLO v3应用于飞机检测,并通过减少骨干网络层数、改变卷积层等方式对算法进行改进,但是在小目标及飞机相互遮挡的检测方面,效果并不理想。

针对上述问题,本文将YOLO v3算法应用于场面飞机检测,并提出两点改进:1)在骨干网络中,使用空洞卷积层[18]替换卷积层,保持较高分辨率和感受野,提高小目标检测的能力;2)在检测网络中,根据多个网格预测的候选框交并比(IOU)[19]的大小,线性衰减置信得分,保留被遮挡的飞机,解决飞机相互遮挡检测问题。本文使用自行组建并标注的场面飞机数据集Aeroplane,在此数据集上,对多种算法进行对比测试,实验结果表明,本文方法在小目标及相互遮挡的飞机检测方面取得良好的效果。

2 YOLOv3算法

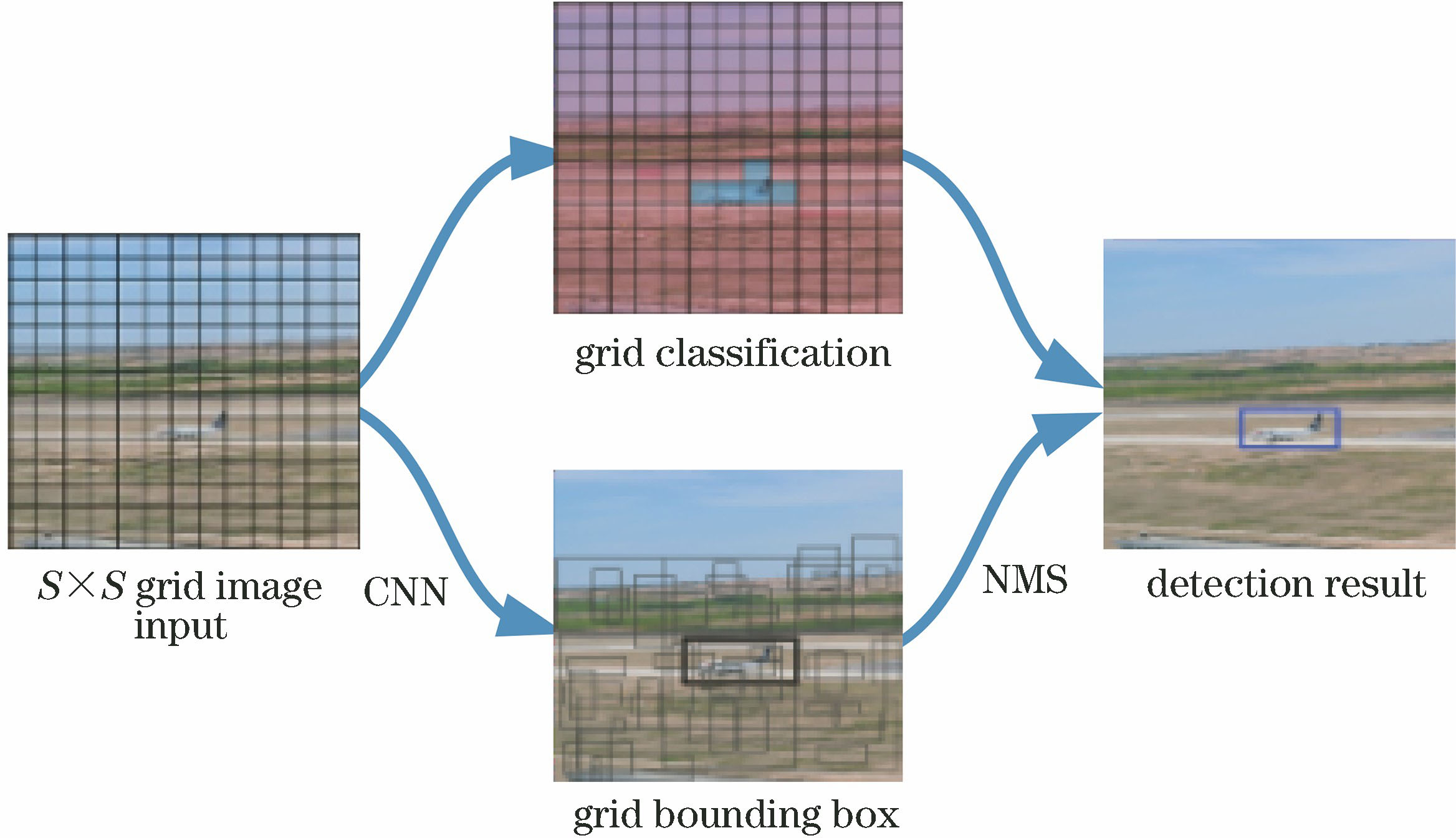

2016年,Redmon等[7]在YOLO v2[8]算法的基础上,融合ResNet[20-21]、FPN、二元交叉熵损失等方法,提出了YOLO v3算法。YOLO v3的网络结构分为骨干网络(Darknet-53)和检测网络。Darknet-53由52个卷积层和1个全连接层组成,构成了一个53层的卷积神经网络(CNN),并输出13×13、26×26及52×52三种尺度的特征,送入检测网络[16]。检测网络对三种尺度的特征回归,预测出多个预测框,并使用非极大抑制(NMS)算法,去除IOU较大与置信得分较低的预测框,保留置信得分较高的预测框为目标检测框[19]。

YOLO v3的检测流程,如

式中:如果预测框中存在检测物体,则

最后,使用NMS算法筛选出置信得分

式中,

YOLO v3中,Darknet-53使用步长为2,大小为3×3的卷积核进行降采样,感受野区域广,牺牲了空间分辨率,致使深层网络的小目标信息损失,缺乏细节信息。虽然YOLO v3采用FPN,将高层特征与浅层特征信息融合,提高了小目标的检测效果,但是步长较大的高层导致小目标的语义特征丢失严重,该特征融合方法对精确定位飞机和检测较小的场面飞机有不利的影响。NMS算法通过判断IOU值是否大于阈值的方式,删除多余的预测框,保留物体的检测框。该方式较好地筛选了预测框,但势必会删除遮挡飞机的预测框,影响相互遮挡飞机的检测[19]。

3 改进的YOLO v3模型

针对场面飞机存在的小目标与相互遮挡难以检测的问题,对YOLO v3的骨干网络Darknet-53和NMS算法提出两点改进:一是采用高分辨率、大感受野的骨干网络;二是采用线性衰减的NMS算法。

3.1 高分辨率、大感受野的骨干网络

对于小目标的检测,一方面需要高分辨率的特征图,才能检测较小区域的目标信息;另一方面需要较开阔的感受野或者更全局的信息,才能准确判断目标的位置和语义特征。为了改善场面图像中小目标的检测,结合空洞卷积和FPN结构,提出一种高分辨率、大感受野的骨干网络用于特征提取。

空洞卷积是通过改变卷积核的内部间隔来扩大卷积核的感受野。

图 2. 空洞卷积。(a) rrate=1;(b) rrate=2;(c) rrate=3

Fig. 2. Dilated convolutions. (a) rrate=1; (b) rrate=2; (c) rrate=3

改进后的YOLO v3的骨干网络及FPN结构,如

图 3. 改进后YOLO v3的骨干网络及FPN结构

Fig. 3. Backbone network and FPN architecture of the improved YOLO v3

图 4. 空洞卷积残差结构。(a)空洞卷积瓶颈层;(b)带1×1卷积结构的空洞卷积瓶颈层

Fig. 4. Structure of dilated convolution residuals. (a) Dilated convolution bottleneck; (b) dilated convolution bottleneck with 1×1 Conv projection

特征的分辨率将直接影响小目标的检测和整体性能指标,13×13的小目标语义特征丢失严重,52×52的高分辨率特征会造成较大的计算量和内存储存量,所以考虑到不降低骨干网络的整体性能,在网络改进的过程中选择计算量较为适中的分辨率26×26。最终,改进的YOLO v3能够在深层网络中保持较高分辨率和较大的特征图的感受野,增强了YOLO v3算法对小目标的感受野和检测能力。

3.2 线性衰减的NMS算法

如

式中,

优化后NMS算法处理流程图,如

改进后的骨干网络具有较高的分辨率,能够检测小目标所在区域的特征信息,且该网络具有更开阔的感受野,有助于从全局信息中定位场面图像中的小目标。改进后的NMS算法不再是简单的阈值比较法,而是一种通过采用IOU值线性衰减置信得分的方法,能避免误删遮挡目标的预测框,提升对遮挡目标的检测能力。

4 实验与结果分析

实验使用Darknet、TensorFlow[26]深度学习框架,在2块NVIDIA 1070 Ti显卡上完成训练及测试。

4.1 场面飞机数据集

目前,在机场及场面飞机检测的应用研究方面,缺乏公开的适合深度学习训练的数据集。本文构建场面飞机数据集Aeroplane,数据主要来源于宁夏银川市河东国际机场监控视频系统、PASCAL VOC2007与VOC2012[27]的飞机图像。

Aeroplane数据集包含了各种型号的单架客机、相互遮挡客机、小目标、其他目标(机场内的鸟、引导车、摆渡车、行人)等图像,共计10000张,如

场面飞机数据集

Airport scene aircraft data sets

4.2 网络训练

基于数据集Aeroplane进行训练,类别为2,输出特征图的数量为21,Anchor为10×13、16×30、33×23、30×61、62×45、59×119、116×90、156×198、373×326[26]。训练的批次为64,动量为0.9,衰减为0.0005,最大迭代次数为60000。开始训练时采用10-3的学习率,以达到稳定整个网路的效果,迭代20000次后调整为10-2,迭代30000次后调整为10-3,迭代30000次后调整为10-4。

在训练过程中,通过绘制损失(Loss)曲线能够直观地观察到训练的动态过程。

4.3 结果及分析

为验证本方法能够较好地检测小目标和相互遮挡的飞机,进而整体地提升场面飞机的检测效果,相关人员将在Aeroplane的测试集上进行3个对比实验。

1)小目标检测

从测试集中随机抽取尺寸为10 pixel×20 pixel、20 pixel×40 pixel、30 pixel×60 pixel、40 pixel×80 pixel、50 pixel×100 pixel、60 pixel×120 pixel的场面飞机图像,使用梯度直方图和支持向量机(HOG+SVM) [4]、Faster-RCNN[6]、SSD[9]、YOLO v3[10-11]和本文方法进行对比实验。

图 8. 不同方法检测多尺度小目标的结果

Fig. 8. Detecting results of multi-scale small targets by different methods

如

2)飞机相互遮挡检测

从测试集中随机抽取200张飞机遮挡图像,按照横向、纵向遮挡比例进行分组实验。不同遮挡比例的检测性能对比,如

图 9. 不同遮挡程度的飞机检测对比实验。(a)(b)遮挡比例接近于20%;(c)(d)遮挡比例接近于60%;(e)(f)有明显颜色特征、遮挡比例接近于60%;(g)(h)遮挡比例接近于80%

Fig. 9. Contrast experiments of aircraft detection with different occlusion proportions. (a)(b) Occlusion is close to 20%; (c)(d) occlusion is close to 60%; (e)(f) obvious color characteristics, occlusion is close to 60%; (g)(h) occlusion is close to 80%

3)不同检测方法的性能对比

表 2. 不同遮挡比例的检测性能对比

Table 2. Detection performance comparison of different overlapped proportions

|

5 结论

将YOLO v3应用到机场场面飞机检测领域,可以实现场面飞机的实时有效检测。针对小目标及遮挡飞机难以检测的问题,在YOLO v3模型的基础上,对骨干网络和NMS算法进行改进,在Aeroplane数据集上训练及进行对比测试。实验表明本文方法较大地改善了小目标、飞机遮挡的检测效果,将场面飞机检测准确率从72.3%提高到83.7%,速度达到26 frame·s-1,满足实时性检测要求。但本文算法在检测严重遮挡的飞机图像方面仍有不足,这也是后续的研究方向。

[1] 杨红雨, 杨波, 武喜萍, 等. 智能化空管技术研究与展望[J]. 工程科学与技术, 2018, 50(4): 12-21.

Yang H Y, Yang B, Wu X P, et al. Research and prospect of intellectualized air traffic management technology[J]. Advanced Engineering Sciences, 2018, 50(4): 12-21.

[2] Li[\s]{1}XB,[\s]{1}Wang[\s]{1}SJ,[\s]{1}Jiang[\s]{1}BT,[\s]{1}et[\s]{1}al.[\s]{1}Airplane[\s]{1}detection[\s]{1}using[\s]{1}convolutional[\s]{1}neural[\s]{1}networks[\s]{1}in[\s]{1}a[\s]{1}coarse-to-fine[\s]{1}manner[C]∥2017[\s]{1}IEEE[\s]{1}2nd[\s]{1}Information[\s]{1}Technology,[\s]{1}Networking,[\s]{1}Electronic[\s]{1}and[\s]{1}Automation[\s]{1}Control[\s]{1}Conference[\s]{1}(ITNEC),[\s]{1}December[\s]{1}15-17,[\s]{1}2017,[\s]{1}Chengdu,[\s]{1}China.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}235-[\s]{1}239.[\s]{1}

[3] 黄洁, 姜志国, 张浩鹏, 等. 基于卷积神经网络的遥感图像舰船目标检测[J]. 北京航空航天大学学报, 2017, 43(9): 1841-1848.

Huang J, Jiang Z G, Zhang H P, et al. Ship object detection in remote sensing images using convolutional neural networks[J]. Journal of Beijing University of Aeronautics and Astronautics, 2017, 43(9): 1841-1848.

[4] 姚远, 姜志国, 张浩鹏. 基于层次化分类器的遥感图像飞机目标检测[J]. 航天返回与遥感, 2014, 35(5): 88-94.

Yao Y, Jiang Z G, Zhang H P. Aircraft detection in remote sensing image based on hierarchical classifiers[J]. Spacecraft Recovery & Remote Sensing, 2014, 35(5): 88-94.

[5] GirshickR.[\s]{1}Fast[\s]{1}R-CNN[C]∥2015[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}December[\s]{1}7-13,[\s]{1}2015,[\s]{1}Santiago,[\s]{1}Chile.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}1440-[\s]{1}1448.[\s]{1}

[6] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[7] RedmonJ,[\s]{1}DivvalaS,[\s]{1}GirshickR,[\s]{1}et[\s]{1}al.[\s]{1}You[\s]{1}only[\s]{1}look[\s]{1}once:[\s]{1}unified,[\s]{1}real-time[\s]{1}object[\s]{1}detection[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}779-[\s]{1}788.[\s]{1}

[8] RedmonJ,[\s]{1}FarhadiA.[\s]{1}YOLO9000:[\s]{1}better,[\s]{1}faster,[\s]{1}stronger[C]∥2017[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}July[\s]{1}21-26,[\s]{1}2017,[\s]{1}Honolulu,[\s]{1}HI.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}7263-[\s]{1}7271.[\s]{1}

[9] LiuW,[\s]{1}AnguelovD,[\s]{1}ErhanD,[\s]{1}et[\s]{1}al.[\s]{1}SSD:[\s]{1}single[\s]{1}shot[\s]{1}multibox[\s]{1}detector[M][\s]{1}∥Leibe[\s]{1}B,[\s]{1}Matas[\s]{1}J,[\s]{1}Sebe[\s]{1}N,[\s]{1}et[\s]{1}al.[\s]{1}Computer[\s]{1}vision-ECCV[\s]{1}2016.[\s]{1}Lecture[\s]{1}notes[\s]{1}in[\s]{1}computer[\s]{1}science.[\s]{1}Cham:[\s]{1}Springer,[\s]{1}2016,[\s]{1}9905:[\s]{1}21-[\s]{1}37.[\s]{1}

[10] TumasP,[\s]{1}SerackisA.[\s]{1}Automated[\s]{1}image[\s]{1}annotation[\s]{1}based[\s]{1}on[\s]{1}YOLOv3[C]∥2018[\s]{1}IEEE[\s]{1}6th[\s]{1}Workshop[\s]{1}on[\s]{1}Advances[\s]{1}in[\s]{1}Information,[\s]{1}Electronic[\s]{1}and[\s]{1}Electrical[\s]{1}Engineering[\s]{1}(AIEEE),[\s]{1}November[\s]{1}8-10,[\s]{1}2018,[\s]{1}Vilnius,[\s]{1}Lithuania.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2018:[\s]{1}18356488.[\s]{1}

[11] Qu[\s]{1}HQ,[\s]{1}Yuan[\s]{1}TY,[\s]{1}Sheng[\s]{1}ZY,[\s]{1}et[\s]{1}al.[\s]{1}A[\s]{1}pedestrian[\s]{1}detection[\s]{1}method[\s]{1}based[\s]{1}on[\s]{1}YOLOv3[\s]{1}model[\s]{1}and[\s]{1}image[\s]{1}enhanced[\s]{1}by[\s]{1}retinex[C]∥2018[\s]{1}11th[\s]{1}International[\s]{1}Congress[\s]{1}on[\s]{1}Image[\s]{1}and[\s]{1}Signal[\s]{1}Processing,[\s]{1}BioMedical[\s]{1}Engineering[\s]{1}and[\s]{1}Informatics[\s]{1}(CISP-BMEI),[\s]{1}October[\s]{1}13-15,[\s]{1}2018,[\s]{1}Beijing,[\s]{1}China.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2018:[\s]{1}18439663.[\s]{1}

[12] 戴陈卡, 李毅. 基于Faster RCNN以及多部件结合的机场场面静态飞机检测[J]. 计算机应用, 2017, 37(s2): 85-88.

Dai C K, Li Y. Aeroplane detection in static aerodrome based on faster RCNN and multi-part model[J]. Journal of Computer Applications, 2017, 37(s2): 85-88.

[13] Lin[\s]{1}TY,[\s]{1}DollarP,[\s]{1}GirshickR,[\s]{1}et[\s]{1}al.[\s]{1}Feature[\s]{1}pyramid[\s]{1}networks[\s]{1}for[\s]{1}object[\s]{1}detection[C]∥2017[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}July[\s]{1}21-26,[\s]{1}2017,[\s]{1}Honolulu,[\s]{1}HI.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}936-[\s]{1}944.[\s]{1}

[14] 李耀龙, 张永科, 罗镇宝. 应用深度卷积神经网络的机场及机场内飞机目标识别技术[J]. 重庆理工大学学报(自然科学), 2018, 32(3): 210-216.

Li Y L, Zhang Y K, Luo Z B. Target recognition technology of airport and airport aircraft based on deep convolution neural network[J]. Journal of Chongqing Institute of Technology(Natural Science), 2018, 32(3): 210-216.

[15] MaJ,[\s]{1}ChenL,[\s]{1}Gao[\s]{1}ZY.[\s]{1}Hardware[\s]{1}implementation[\s]{1}and[\s]{1}optimization[\s]{1}of[\s]{1}tiny-YOLO[\s]{1}network[M][\s]{1}∥Zhai[\s]{1}G,[\s]{1}Zhou[\s]{1}J,[\s]{1}Yang[\s]{1}X.[\s]{1}Digital[\s]{1}TV[\s]{1}and[\s]{1}wireless[\s]{1}multimedia[\s]{1}communication.[\s]{1}IFTC[\s]{1}2017.[\s]{1}Communications[\s]{1}in[\s]{1}computer[\s]{1}and[\s]{1}information[\s]{1}science.[\s]{1}Singapore:[\s]{1}Springer,[\s]{1}2018,[\s]{1}815:[\s]{1}224-[\s]{1}234.[\s]{1}

[16] KharchenkoV,[\s]{1}ChyrkaI.[\s]{1}Detection[\s]{1}of[\s]{1}airplanes[\s]{1}on[\s]{1}the[\s]{1}ground[\s]{1}using[\s]{1}YOLO[\s]{1}neural[\s]{1}network[C]∥2018[\s]{1}IEEE[\s]{1}17th[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Mathematical[\s]{1}Methods[\s]{1}in[\s]{1}Electromagnetic[\s]{1}Theory[\s]{1}(MMET),[\s]{1}July[\s]{1}2-5,[\s]{1}2018,[\s]{1}Kiev,[\s]{1}Ukraine.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2018:[\s]{1}294-[\s]{1}297.[\s]{1}

[17] 戴伟聪, 金龙旭, 李国宁, 等. 遥感图像中飞机的改进YOLOv3实时检测算法[J]. 光电工程, 2018, 45(12): 81-89.

Dai W C, Jin L X, Li G N, et al. Real-time airplane detection algorithm in remote-sensing images based on improved YOLOv3[J]. Opto-Electronic Engineering, 2018, 45(12): 81-89.

[18] YuF,[\s]{1}KoltunV,[\s]{1}FunkhouserT.[\s]{1}Dilated[\s]{1}residual[\s]{1}networks[C]∥2017[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}July[\s]{1}21-26,[\s]{1}2017,[\s]{1}Honolulu,[\s]{1}HI.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}472-[\s]{1}480.[\s]{1}

[19] BodlaN,[\s]{1}SinghB,[\s]{1}ChellappaR,[\s]{1}et[\s]{1}al.[\s]{1}Soft-NMS:[\s]{1}improving[\s]{1}object[\s]{1}detection[\s]{1}with[\s]{1}one[\s]{1}line[\s]{1}of[\s]{1}code[C]∥2017[\s]{1}IEEE[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}(ICCV),[\s]{1}October[\s]{1}22-29,[\s]{1}2017,[\s]{1}Venice,[\s]{1}Italy.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2017:[\s]{1}5561-[\s]{1}5569.[\s]{1}

[20] Chen[\s]{1}ZX,[\s]{1}Xie[\s]{1}ZF,[\s]{1}Zhang[\s]{1}WB,[\s]{1}et[\s]{1}al.[\s]{1}ResNet[\s]{1}and[\s]{1}model[\s]{1}fusion[\s]{1}for[\s]{1}automatic[\s]{1}spoofing[\s]{1}detection[C]∥Interspeech[\s]{1}2017,[\s]{1}August[\s]{1}20-24,[\s]{1}2017,[\s]{1}Stockholm,[\s]{1}Sweden.[\s]{1}[S.l.:[\s]{1}s.n.],[\s]{1}2017:[\s]{1}102-[\s]{1}106.[\s]{1}

[21] He[\s]{1}KM,[\s]{1}Zhang[\s]{1}XY,[\s]{1}Ren[\s]{1}SQ,[\s]{1}et[\s]{1}al.[\s]{1}Deep[\s]{1}residual[\s]{1}learning[\s]{1}for[\s]{1}image[\s]{1}recognition[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}770-[\s]{1}778.[\s]{1}

[22] 魏湧明, 全吉成, 侯宇青阳. 基于YOLOv2的无人机航拍图像定位研究[J]. 激光与光电子学进展, 2017, 54(11): 111002.

[23] Li[\s]{1}ZM,[\s]{1}PengC,[\s]{1}YuG,[\s]{1}et[\s]{1}al.[\s]{1}DetNet:[\s]{1}a[\s]{1}backbone[\s]{1}network[\s]{1}for[\s]{1}object[\s]{1}detection[J/OL].[\s]{1}([\s]{1}2018-04-19)[2019-02-19].[\s]{1}https:∥arxiv.org/abs/1804.[\s]{1}06215.[\s]{1}

[24] 吴晨玥, 易本顺, 章云港, 等. 基于改进卷积神经网络的视网膜血管图像分割[J]. 光学学报, 2018, 38(11): 1111004.

[25] 华夏, 王新晴, 王东, 等. 基于改进SSD的交通大场景多目标检测[J]. 光学学报, 2018, 38(12): 1215003.

[26] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[27] 马永杰, 李雪燕, 宋晓凤. 基于改进深度卷积神经网络的交通标志识别[J]. 激光与光电子学进展, 2018, 55(12): 121009.

Article Outline

郭进祥, 刘立波, 徐峰, 郑斌. 基于YOLO v3的机场场面飞机检测方法[J]. 激光与光电子学进展, 2019, 56(19): 191003. Jinxiang Guo, Libo Liu, Feng Xu, Bin Zheng. Airport Scene Aircraft Detection Method Based on YOLO v3[J]. Laser & Optoelectronics Progress, 2019, 56(19): 191003.