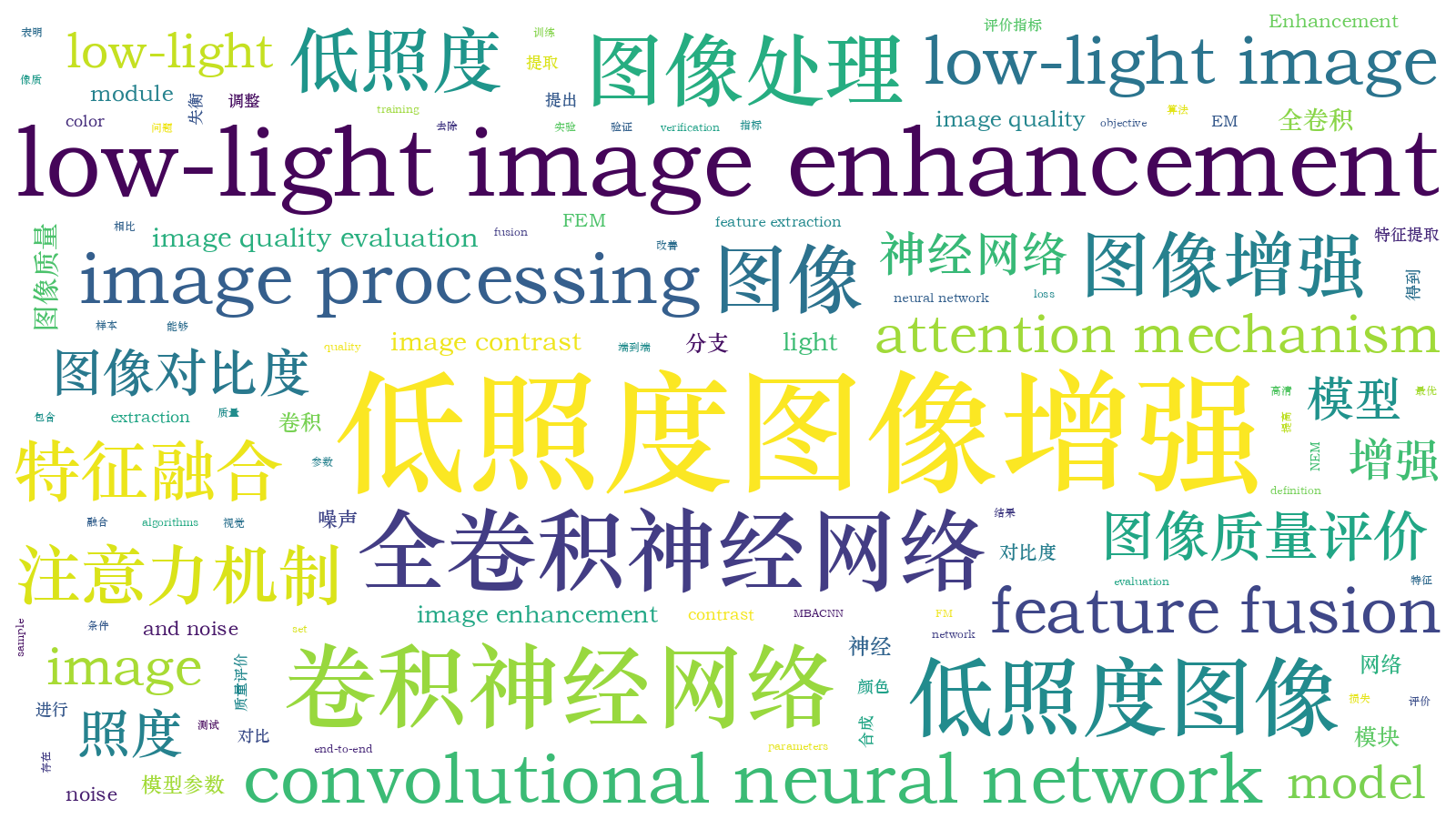

基于多分支全卷积神经网络的低照度图像增强  下载: 957次

下载: 957次

ing at the problems of low image contrast, color imbalance, and noise in low-light conditions, a low-light image enhancement model based on multi-branch all convolutional neural network (MBACNN) is proposed. The model is an end-to-end model, including feature extraction module (FEM), enhancement module (EM), fusion module (FM), and noise extraction module (NEM). By training the synthesized low-light and high-definition image sample, the model parameters are continuously adjusted according to the loss value of the verification set to obtain the optimal model, and then the synthetic low-light image and the real low-light image are tested. Experimental results show that compared with traditional image enhancement algorithms, the proposed model can effectively improve image contrast, adjust color imbalance, and remove noise. Both subjective visual and objective image quality evaluation indicators are further improved.

1 引言

在夜间、背光等低照度条件下,采集到的图像或者视频会呈现模糊的视觉效果,其对比度不高,有时会出现颜色失衡或者伪影,使得有效信息明显减少、感兴趣区域难以识别,给后续图像处理与分析(包括对象检测和识别、场景分析和近海视频监控等)带来困难[1]。而图像增强可以有效改善图像质量、丰富信息量、提高图像识别效果,具有十分重要的应用价值。

低照度图像增强的目的是提高亮度、去除噪声,实现图像清晰化。目前,国内外广泛使用的方法有4种:

1) 基于直方图均衡化(HE)的增强方法[2]。HE的中心思想是把原始图像的灰度直方图从比较集中的某个灰度区间变成全部灰度范围内的均匀分布。其中,对比度受限的直方图均衡化(CLAHE)方法可以有效提高图像的对比度[3]。这种方法处理速度快,但没有考虑图像频率以及细节信息,易出现色偏和过度增强。

2) 基于同态滤波的增强方法[4]。这种方法是基于照明-反射模型,通过改变照度和反射率对像元灰度值的影响,来达到揭示阴影区细节特征的目的。该方法的前提条件是假设光照均匀,所以该方法对于存在高光区和暗区的夜间图像增强效果较差。

3) 基于Retinex理论[5]的增强方法。这种方法具有压缩动态范围和颜色恒常等特点,是一种比较流行的低照度图像增强算法。根据Retinex理论,一幅图像可以表示为入射光和反射光的乘积,其中入射光直接决定图像像素所能达到的动态范围,反射光表示图像的内在属性。通过去除或者降低入射光的影响,尽量保留物体本质的反射属性,从而实现图像增强。这类方法的关键在于如何精确估计出入射光。其中最经典的有单尺度Retinex(SSR)算法[6]、多尺度Retinex(MSR)算法[7]和带颜色恢复的MSR(MSRCR)算法[8]。近年来,一些基于Retinex理论的新算法被提出。Zhang等[9]提出了扩展多尺度Retinex算法(LAB-MSR),在CIELAB色彩空间中的图像的三个通道上使用双边滤镜和三边滤镜的组合;Guo等[10]提出了LIME(Low-Light Image Enhancement via Illumination Map Estimation)算法,首先通过在R、G和B通道中寻找最大值来单独估计每个像素的光照,然后通过在初始光照图上添加一个结构来细化初始光照图,将其作为最终的光照图,这些方法在入射光估计方面存在误差。

4) 基于小波变换的方法。李庆忠等[11]利用离散小波变换(DWT)将图像的高、低频带分离,然后对低频分量进行照度估计与去除,并利用鲍威尔与模拟退火相结合的优化算法实现图像对比度的增强,但是未能克服小波变换自身的缺陷。

此外还有其他的一些增强方法,如Dong等[12]发现低照度图像经过翻转后与雾天图像具有一定的相似性,采用图像去雾的思想对图像进行增强,由于未考虑雾图中存在的白色区域所导致的暗通道理论失效的问题,增强后的图像往往不符合实际应用场景。深度学习特别是卷积神经网络在图像分类[13]、物体检测[14]和视频监控[15]等方面表现优异。文献[ 16-17]利用可训练的卷积神经网络对弱光照图像进行增强,得到了较好的效果,这说明使用深度学习进行图像增强是可行的。此外,卷积神经网络具有局部连接、权值共享和池化等特性,可以更好地提取图像的深层特征。

基于以上分析,本文提出一种基于多分支全卷积神经网络(MBACNN)的低照度图像增强算法。首先,基于清晰图像合成低照度图像库;然后使用本文所提模型进行训练,得到模型的最佳参数;最后使用各种类型的测试图像对模型性能进行测试。实验结果表明,所提方法可以明显增强图像的亮度和对比度、去除噪声和保持图像的色彩信息,在图像客观评价指标上都优于传统的方法,为低照度图像增强算法的研究提供了新思路。

2 基本理论

2.1 全卷积神经网络

全卷积神经网络(ACN)模型[18]使用步长为2的标准卷积层代替池化层。对于CNN某一层的输出特征图f,它可以表示为一个w×h×c的三维矩阵。其中w和h分别表示矩阵的宽和高,c表示特征图的通道数。全卷积操作过程可以描述为

式中:F=floor(k/2),其中floor(·)表示向下取整函数;ci,j,o(·)表示标准卷积层;f表示输入特征图;k表示卷积核的大小;θh,w,u,o表示卷积核的权重;σ(·)表示激活函数,典型的为ReLU激活函数;o∈

2.2 卷积块注意力模块

卷积块注意力模块(CBAM)[19]结构如

该模块包含两个子模块:通道注意力模块和空间注意力模块。其中,通道注意力模块中使用最大池化和平均池化对输入特征图在空间维度上进行压缩,得到两个不同的空间背景描述:

式中:AvgPool(F)表示平均池化;MaxPool(F)表示最大池化;MLP表示多层感知器函数;W0∈Rc×(c/r);W1∈Rc×(c/r)×c,r表示放缩因子。对

式中:f7×7表示使用7×7的过滤器进行卷积操作。

对于某一层的特征图F∈Rc×h×w,CBAM将会依次得到1维的通道注意图MC∈Rc×1×1和二维的空间注意图MS∈R1×h×w。计算过程可以描述为

式中:为element-wise乘法。首先将通道注意力图与输入的特征图相乘得到F',再计算F'的空间注意力图,并将两者相乘得到输出F″。

3 基于多分支全卷积神经网络的图像增强

由于低照度图像内容比较复杂,并且含有其他噪声,所以一个简单的网络很难实现高质量的图像增强。设计了一个多分支全卷积神经网络架构,将图像增强问题分解为与不同特征层相关的子问题分别进行求解,通过融合不同分支结果得到最终输出。模型的输入是低照度图像,输出是大小相同的增强后的图像,整个网络架构及数据处理流程如

3.1 增强算法流程

本文所提出的多分支全卷积神经网络架构包含4个子模块:特征提取模块(FEM)、增强模块(EM)、融合模块(FM)和噪声提取模块(NEM)。特征提取模块由5层全卷积神经网络构成。第一层的输入为低照度图像,输出既是下一层网络的输入,也是对应增强模块子网的输入。增强模块包括多个CBAM,详细信息见2.2节,其数目和特征提取模块中的层数相同。每一个CBAM的输入来自特征提取模块对应层的输出,其输出尺寸和特征提取模块中对应层的输出尺寸相同,为了使增强模块中每个CBAM的输出和原始低照度图像尺寸一样,在对应CBAM后添加了上采样[20]和反卷积[21]操作。融合模块利用Keras包中的concatenate函数将融合模块各个分支的输出叠加起来得到未去噪的图像,并采用1×1的卷积使其通道数和原始低照度图像保持一样。为了去除图像中的噪声,通过噪声提取模块从原始低照度图像中提取噪声,然后使用subtract操作去除图像中的噪声,再利用一次卷积操作调整图像的色彩平衡来获得最后的增强图像。

3.2 噪声提取模块

噪声提取模块(NEM)是一个对称的U型结构,如

3.3 损失函数

由于图像内容的复杂度较高,常用的误差度量标准如MSE、RMSE和MAE往往不能满足要求。其中,MSE的计算过程可以描述为

式中:yi表示样本的真实值;

式中:SSIM(X,Y)表示每个样本的结构相似性;μx和μy分别表示X和Y的平均值;

损失函数定义为

式中:N表示总的样本数;Xi和Yi分别表示第i个测试图像和对应的参考图像;SSIM(Xi,Yi)表示第i个测试图像的结构相似性。

4 实验结果分析

4.1 样本制作

由于获取大量真实世界的低光照图像比较困难,本研究基于COCO image dataset[24]进行合成,得到了大量的低光照图像。低光照图像与普通图像的区别在于最主要的两个特征:低亮度和存在噪声。对于低亮度特征,使用PIL(Python Image Library)数据包将每张普通图像的亮度降低70%;对于噪声,使用PIL数据包为每张普通图像添加高斯噪声。最后从COCO数据集中选取6787张图片用于训练集,340张图片用于验证集。

4.2 实验设置

本文实验是以Pycharm为实验平台,利用Keras和TensorFlow深度学习开源框架,CPU(Central Processing Unit)为Inter Core 15-9300,主频为2.40 GHz,内存为24 GB,GPU(Graphics Processing Unit)为NVIDIA GeForce RTX2060(6 GB)。

所有输入图像的尺寸为256×256×3,并把它们归一化为[0,1]。考虑到计算机性能,这里将批大小设为16,在有条件的情况下适当增加批大小可以提高增强效果。根据文献[ 21]的建议,卷积核的大小设置为3×3,并用PReLU[25]激活函数提高模型的泛化能力,为了减少训练时间和解决过拟合问题,在每一个全卷积层后都添加了Dropout[26]操作。此外,批归一化(BN)[27]操作可以加快模型的训练速度,减少网络中间数据分布的改变对神经网络参数训练的影响。在实验中,使用ADAM优化器[28],并采用Lookahead[29]优化策略,Lookahead策略通过提前观察另一个优化器生成的权重序列来选择搜索方向。它能够提升学习稳定性,不仅缩短了调参时间,还能提升收敛速度与效果。此外,还采用了学习率衰减策略,初始学习率为0.01,如果每经过5个epoch训练损失没有下降,学习率就缩小为上一次的10%,最低学习率为0.5×10-6,总计训练100个epoch。

4.3 实验分析

为了验证所提算法的有效性,将所提算法与现有的低照度图像增强算法进行了对比,分别对不含噪声的合成低照度图像、含噪声的合成低照度图像和真实低照度图像进行实验,从主观视觉和客观评价指标两方面进行对比。此外,还对模型的计算时间进行了对比,对比算法包括CLAHE[3]、SSR[6]、MSRCR[8]、文献[ 12]中的算法、文献[ 16]中的算法和文献[ 30]中的算法。

4.3.1 不含噪声的合成低照度图像实验

首先对不含噪声的合成低照度图像进行实验,从计算机视觉领域公开数据集LIVE1[31]中挑选27幅图像作为测试样本,部分实验结果如

图 4. 不含噪声的合成低照度图像的主观视觉对比。(a) Parrots图像;(b) building2图像;(c) buildings图像;(d) monarch图像

Fig. 4. Subjective visual comparison of synthetic low-light images without noise. (a) Image of parrots; (b) image of building2; (c) image of buildings; (d) image of monarch

表 1. 不含噪声的合成低照度图像的客观评价指标对比

Table 1. Comparison of objective evaluation indicators for synthetic low-light images without noise

|

在对不含噪声的合成低照度图像进行客观评价指标对比时,选取的评价指标包括峰值信噪比(PSNR)、均方误差(MSE)、平均绝对误差(MAE)、多尺度结构相似性(MS-SSIM)[32]、质量指数(Q)[33]和视觉信息保真度(VIF)[34]。其中,PSNR反映图像失真程度,其值越大表示失真程度越小。MSE和MAE表示增强后图像和真实图像之间的差距,其值越小表示增强后图像越接近原始图像。MS-SSIM可以反映图像失真程度,其值越大表示图像失真程度越小,最大为1。质量指数Q表示相对参考图像的好坏程度,其值越大越好。VIF是一种基于自然场景统计模型(NSS)、图像失真和人类视觉失真建模的图像质量评价方法,其值越大表示图像质量越好。

4.3.2 含噪声的合成低照度图像实验

为了验证所提算法对低照度图像的去噪能力,将4.3.1节的测试图像添加高斯噪声,然后再进行测试,部分实验结果如

表 2. 含噪声的合成低照度图像上的客观评价指标对比

Table 2. Comparison of objective evaluation indicators for synthetic low-light images with noise

|

图 5. 含噪声的合成低照度图像的主观视觉对比。(a) Parrots图像;(b) building2图像;(c) buildings图像;(d) monarch图像

Fig. 5. Subjective visual comparison of synthetic low-light images with noise. (a) Image of parrots; (b) image of building2; (c) image of buildings; (d) image of monarch

4.3.3 真实低照度图像实验

除了在上述合成低照度图像上有优势外,所提方法在真实低照度图像上也有很好的表现,从低照度图像数据库LIME[10]、DICM[35]和MEF[36]选取了12幅典型图像进行测试,部分实验结果如

图 6. 真实低照度图像的主观视觉对比。(a)(b)来自LIME数据库的图像;(c)(d)来自DICM数据库的图像;(e)来自MEF数据库的图像

Fig. 6. Subjective visual comparison of real low-light images. (a)(b) Images from LIME dataset; (c)(d) images from DICM dataset; (e) image from MEF dataset

表 3. 真实低照度图像的客观评价指标对比

Table 3. Comparison of objective evaluation indicators for real low-light images

|

对真实低照度图像进行客观评价时,由于没有对应的参考图像,故属于无参考图像质量评价。本文选用梯度结构相似度(NRSS)[37]、信息熵和自然图像质量评估(NIQE)[38]对增强图像进行客观评价。其中,NRSS是指通过低通滤波器构造参考图像,再通过计算原始图像与参考图像的结构相似度值来评价原始图像质量,它很好地结合了成像系统的数学模型和结构相似度评价方法的优势,其值越大说明图像质量越好。信息熵则表征图像信息量的大小,其值越大则图像信息量越丰富。NIQE则是基于简单且成功的空域自然场景统计模型(NSS)构建的质量感知统计特征集合,其值越小表示图像失真程度越小。

4.3.4 算法性能对比

为了测试模型的性能,对各个算法的处理时间进行了对比,

表 4. 算法处理时间对比

Table 4. Algorithm processing time comparison

|

5 结论

现有的低照度图像增强算法在提高图像亮度和对比度时容易出现颜色失衡现象,并且也忽略了一些噪声等附加因素。为了解决这些问题,提出了一种基于多分支全卷积神经网络的低照度图像增强算法,它包含4个模块,即FEM、EM、FM和NEM,从FEM不同层中提取丰富特征,并通过EM中不同子网对其进行增强,然后通过FM将增强结果融合在一起,再减去NEM提取到的噪声得到最后的增强图像。通过这种端到端的方式学习低照度图像和真实图像之间的映射关系。实验结果表明,所提算法能够有效地提高图像的对比度,解决颜色失衡问题;此外,所提算法还可以通过去除图像中的噪声,提高图像的清晰度,图像增强效果优于目前主流的低照度图像增强算法。但对于非低光区域,本文算法也会对其进行增强,导致出现曝光现象,下一步将继续优化模型,以解决非低光区域的曝光问题和提高模型的性能。

[1] YangJ, Jiang XW, Pan CH, et al. Enhancement of low light level images with coupled dictionary learning[C]∥2016 23rd International Conference on Pattern Recognition (ICPR), December 4-8, 2016, Cancun. New York: IEEE, 2016: 751- 756.

[2] Chang Y C, Chang C M. A simple histogram modification scheme for contrast enhancement[J]. IEEE Transactions on Consumer Electronics, 2010, 56(2): 737-742.

[3] 刘玉婷, 陈峥, 付占方, . 基于, 等. CLAHE 的红外图像增强算法[J]. 激光与红外, 2016, 46(10): 1290-1294.

Liu Y T, Chen Z, Fu Z F, et al. Infrared image enhancement algorithm based on CLAHE[J]. Laser & Infrared, 2016, 46(10): 1290-1294.

[4] 胡窦明, 赵海生, 李云川, 等. 一种基于同态滤波的红外图像增强新方法[J]. 红外技术, 2012, 34(4): 224-228.

[5] Land E H. The retinex theory of color vision[J]. Scientific American, 1977, 237(6): 108-128.

[6] Jobson D J, Rahman Z, Woodell G A. Properties and performance of a center/surround retinex[J]. IEEE Transactions on Image Processing, 1997, 6(3): 451-462.

[7] RahmanZ, Jobson DJ, Woodell GA. Multi-scale retinex for color image enhancement[C]∥Proceedings of 3rd IEEE International Conference on Image Processing, September 19-19, 1996, Lausanne, Switzerland. New York: IEEE, 1996: 1003- 1006.

[8] ParthasarathyS, SankaranP. An automated multi scale Retinex with color restoration for image enhancement[C]∥2012 National Conference on Communications(NCC). February 3-5, 2012, Kharagpur, India, New York: IEEE, 2012: 1- 5.

[9] Zhang S, Wang T, Dong J Y, et al. Underwater image enhancement via extended multi-scale Retinex[J]. Neurocomputing, 2017, 245: 1-9.

[10] Guo X J, Li Y, Ling H B. LIME: low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2017, 26(2): 982-993.

[11] 李庆忠, 刘清. 基于小波变换的低照度图像自适应增强算法[J]. 中国激光, 2015, 42(2): 0209001.

[12] DongX, WangG, PangY, et al. Fast efficient algorithm for enhancement of low lighting video[C]∥2011 IEEE International Conference on Multimedia and Expo, July 11-15, 2011, Barcelona, Spain. New York: IEEE, 2011: 1- 6.

[13] Khan S, Islam N, Jan Z, et al. A novel deep learning based framework for the detection and classification of breast cancer using transfer learning[J]. Pattern Recognition Letters, 2019, 125: 1-6.

[14] Lin G H, Zhang Y M, Xu G, et al. Smoke detection on video sequences using 3D convolutional neural networks[J]. Fire Technology, 2019, 55(5): 1827-1847.

[15] Muhammad K, Ahmad J, Mehmood I, et al. Convolutional neural networks based fire detection in surveillance videos[J]. IEEE Access, 2018, 6: 18174-18183.

[16] TaoL, ZhuC, XiangG, et al. LLCNN: a convolutional neural network for low-light image enhancement[C]∥IEEE Visual Communication and Image Processing(VCIP), December 10-13, 2017, New York: IEEE, 2017: 1- 4.

[17] 马红强, 马时平, 许悦雷, 等. 基于深度卷积神经网络的低照度图像增强[J]. 光学学报, 2019, 39(2): 0210004.

[18] Springenberg JT, DosovitskiyA, BroxT, et al. ( 2015-04-13)[2019-10-15]. https:∥arxiv.org/abs/1412. 6806.

[19] WooS, ParkJ, Lee JY, et al.CBAM: convolutional block attention module[M] ∥Computer Vision-ECCV 2018. Cham: Springer International Publishing, 2018: 3- 19.

[20] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3340.

[21] NohH, HongS, HanB. Learning deconvolution network for semantic segmentation[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1520- 1528.

[22] HuJ, ShenL, SunG. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT. New York: IEEE, 2018: 7132- 7141.

[23] Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[24] Lin TY, MaireM, BelongieS, et al.Microsoft COCO: common objects in context[M] ∥Computer Vision-ECCV 2014. Cham: Springer International Publishing, 2014: 740- 755.

[25] He KM, Zhang XY, Ren SQ, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1026- 1034.

[26] SrivastavaN, HintonG, KrizhevskyA, et al. ( 2014-11-28)[2019-10-15]. https:∥users.ics.aalto.fi/perellm1/thesis/summaries_html/node107.html.

[27] IoffeS, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[EB/OL]. ( 2015-02-11)[2019-10-15]. https:∥arxiv.org/abs/1502.03167v1.

[28] Kingma DP, Ba J. Adam: a method for stochastic optimization[EB/OL]. ( 2014-12-22)[2019-10-15]. https:∥arxiv.org/abs/1412. 6980.

[29] ZhangM, LucasJ, HintonG, et al., 1 stepback[EB/OL]. ( 2019-12-03)[2019-10-15]. https:∥arxiv.org/abs/1907. 08610.

[30] Ying ZQ, LiG, Gao W. A bio-inspired multi-exposure fusion framework for low-light image enhancement[EB/OL]. ( 2017-11-02)[2019-10-15]. https:∥arxiv.org/abs/1711. 00591.

[31] Sheikh H R, Sabir M F, Bovik A C. A statistical evaluation of recent full reference image quality assessment algorithms[J]. IEEE Transactions on Image Processing, 2006, 15(11): 3440-3451.

[32] WangZ, Simoncelli EP, Bovik AC. Multiscale structural similarity for image quality assessment[C]∥The Thirty-Seventh Asilomar Conference on Signals, Systems & Computers, November 9-12, 2003, Pacific Grove, CA, USA. New York: IEEE, 2003: 1398- 1402.

[33] FurhtB, MarquesO. Handbook of video databases: design and applications[M]. Boca Raton: CRC Press, Inc., 2003: 1041- 1078.

[34] Sheikh H R, Bovik A C. Image information and visual quality[J]. IEEE Transactions on Image Processing, 2006, 15(2): 430-444.

[35] LeeC, LeeC, Kim CS. Contrast enhancement based on layered difference representation[C]∥2012 19th IEEE International Conference on Image Processing, September 30-October 3, 2012, Orlando, FL, USA. New York: IEEE, 2012: 965- 968.

[36] Ma K D, Zeng K, Wang Z. Perceptual quality assessment for multi-exposure image fusion[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3345-3356.

[37] 谢小甫, 周进, 吴钦章. 一种针对图像模糊的无参考质量评价指标[J]. 计算机应用, 2010, 30(4): 921-924.

Xie X F, Zhou J, Wu Q Z. No-reference quality index for image blur[J]. Journal of Computer Applications, 2010, 30(4): 921-924.

[38] Mittal A, Soundararajan R, Bovik A C. Making a “completely blind” image quality analyzer[J]. IEEE Signal Processing Letters, 2012, 20(3): 209-212.

Article Outline

吴若有, 王德兴, 袁红春, 宫鹏, 陈冠奇, 王丹. 基于多分支全卷积神经网络的低照度图像增强[J]. 激光与光电子学进展, 2020, 57(14): 141021. Ruoyou Wu, Dexing Wang, Hongchun Yuan, Peng Gong, Guanqi Chen, Dan Wang. Low-Light Image Enhancement Based on Multi-Branch All Convolutional Neural Network[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141021.