基于残差块和注意力机制的细胞图像分割方法  下载: 1063次

下载: 1063次

1 引言

细胞是生物体结构和功能的基本单位,对细胞进行深入研究是揭开生命奥秘、改造生命及征服疾病的关键。采用计算机辅助技术实现细胞图像的自动分析对解决各种生物学问题具有重要意义[1-2]。在细胞图像分析中,细胞分割是最基础和最重要的领域之一,是对细胞图像进行识别、计数、测量等的基本前提。

在一些客观原因的影响下,当前的光学成像系统采集的相衬显微细胞图像存在亮度不均衡、细胞与背景对比度较低等问题,极大地增加了分割难度。Yin等[3-4]通过对相衬显微镜的成像原理进行分析得到了近似线性成像模型,然后基于此模型和细胞图像的特性,制定二次优化函数对图像进行复原,以剔除低亮度不均衡和低对比度的干扰,后续仅通过阈值处理即可完成高质量细胞分割。Yin等[5]通过分析相机成像时间与图像强度估算出相机响应函数,利用该响应函数获得高对比度且亮度均衡的细胞图像,然后进行阈值分割。上述方法通常需要将复杂的预处理操作与分割算法相结合才能获取较好的分割结果。

近年来,深度学习在自然图像分割上取得了较大进展,也被逐步应用于生物医学图像分割领域[6-8]。Shelhamer等[9]采用全卷积网络(FCN)来解决像素级细胞图像分割任务,该网络能对每个像素点进行分类,实现了端到端的训练,但是由于池化操作的信息损失,该网络在进行细粒度分割时效果较差。Ronneberger等[10]提出U-Net,该网络通过反卷积层和特征层的拼接弥补了信息损失,其结构简单、参数少、可塑性强,是细胞图像分割基础模型之一。但是该网络仍存在微弱边缘分割断裂的问题,且由于梯度消失的原因,可构建的网络深度有限。Quan等[11]将分割网络与残差网络相结合,并引入基于求和的特征层,通过构建更深的网络架构来实现更精准的细胞分割。近期,递归神经网络、注意力机制等也被用于图像分割中,以提高分割效果。Yi等[12]将SSD[13]和U-Net相结合对神经细胞进行实例分割,并在检测模块和分割模块中采用了注意力机制,以将模型重点放在与任务相关的特征上。Alom等[14]提出了一种基于U-Net的递归残差神经网络(R2U-Net),残差单元在训练深度网络时可以防止梯度消失,递归残差特征的累积可确保对网络进行分割时能有更好的特征表示。

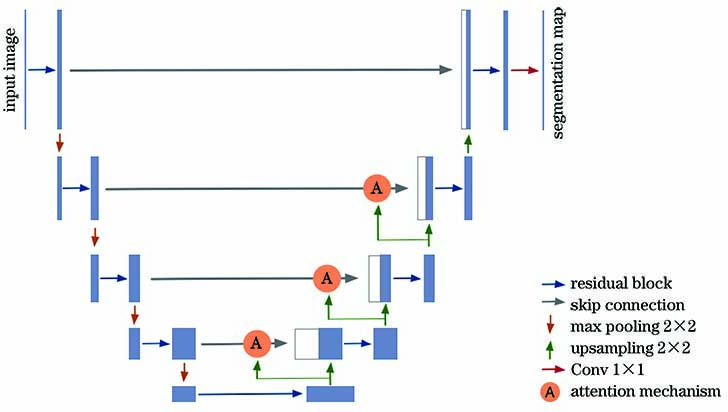

针对相衬显微镜采集的细胞图像存在亮度不均衡、细胞与背景对比度较低的问题,本文提出了一种基于深度学习的分割模型(attention Residual-UNet)。该模型以U-Net[10]为基本框架,结合了残差块[15]和注意力机制[16]。将残差块引入U-Net,缩短了深层抽象特征与浅层特征之间的路径,增强了特征的传播能力,从而能够提取出更多关于细胞的细节信息,同时解决了梯度消失的现象;通过注意力机制加强了细胞区域的权重,降低了图像亮度不一致、对比度低对模型的干扰,提升了模型的灵敏度和分割精度。

2 模型框架

2.1 整体模型框架简介

本模型以U-Net为基本框架,并对其进行了改进。其中编码器由残差块和池化层构成,残差块的使用增加了特征的重复利用率,使得模型能够提取到更多图像的细节信息,尤其是低对比度区域的信息。解码器由对称的残差块和上采样层构成。特征层连接中引入了注意力机制,使得模型专注于学习细胞特征,降低了图像亮度不一致、对比度低对模型的干扰,提高了模型的灵敏度和分割精度。最后通过1×1卷积层对细胞与背景进行分类。所提模型如

2.2 U-Net

U-Net[8]由1个编码器和1个解码器组成。其中编码器主要负责下采样的工作,用于获取丰富的上下文信息,主要对细胞和背景进行分类;解码器主要负责上采样的工作,用于实现细胞的精确定位。最后,通过特征层连接方法,结合细粒度层信息和粗粒度层信息,以获得更精确的上下文信息,从而得到更多的细胞细节信息。该设计使得U-Net可以利用较少的训练集进行训练,并得到较好的分割结果。但由于池化层和上采样层中产生了细节信息损失的现象,U-Net容易使微弱边缘处出现分割断裂,且在图像亮度发生变化时适应能力较差。

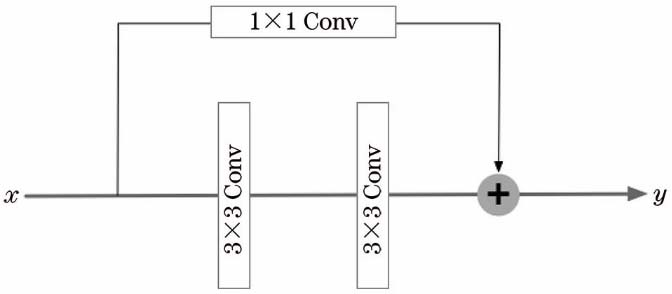

2.3 残差块

为了从图像中提取出更多的细节信息,缓解低对比度区域及微弱边缘处的欠分割问题,在U-Net中引入残差块[15]代替传统的卷积层,残差块的使用可以解决随着网络层数加深出现梯度消失的问题。残差块基础计算公式为

式中:x和y分别为网络的输入和输出;

由于(2)式梯度始终大于1,故随着网络层数的加深,梯度不会消失。通常情况下,f(x,Wl)与x的特征维度并不相同,故引入线性变换参数W完成维度匹配,计算公式为

残差块的网络结构如

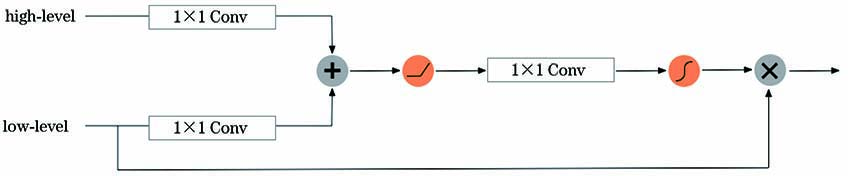

2.4 注意力机制

虽然残差块强化了特征的传播能力,有效地提取出更多的细胞细节信息,但是低层特征中缺少语义信息,亮度不均衡、对比度较低仍会对细胞的分割造成干扰,故引入注意力机制捕获高级语义信息,加重细胞区域的权重,增强模型对前景的学习能力,从而提高模型的灵敏度和分割精度。

注意力机制通过注意力权重0≪α≪1来识别细胞特征的显著性区域,注意力权重由包含丰富语义信息的高级特征图和包含全局上下文信息的低级特征图得到,计算公式为

式中:i为像素空间大小;

式中:c为通道尺寸。

注意力机制在训练过程中无需额外监督即可自动学习目标结构,同时在测试过程中会自动生成软区域,以加重细胞区域权重。如

3 实验

实验仿真的计算机硬件配置为Inter Core i7-6850K与Nvidia GeForce GTX1080Ti,使用以TensorFlow作为后端的Keras开源库训练和测试网络模型。

3.1 数据集

数据集来源于中国科学院生物化学与细胞生物学研究所,为肌肉干细胞分化过程中的细胞图像。数据采集所用显微镜为奥林巴斯ix73,为相差模式,放大倍数调整为10,分辨率为1600 pixel×1200 pixel,位深为16。该数据集包含17张原始图片,并对应有专家手动分割的真值图像,取其中7张为测试集。

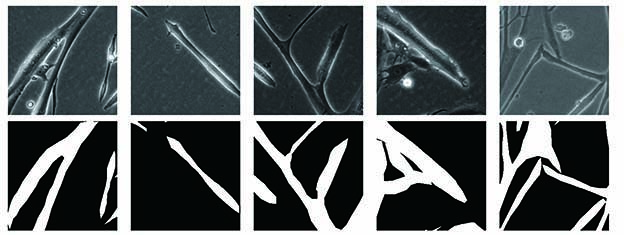

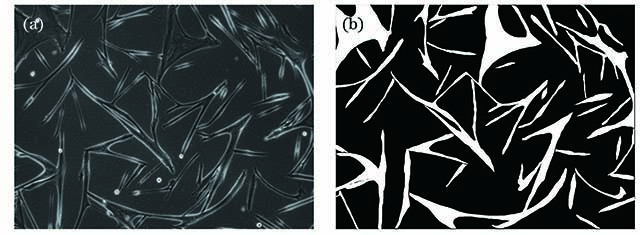

由于原始图像过大,直接使用会导致模型参数爆炸,故采用尺寸为256×256的滑动窗口将原始图像及对应真值图像裁剪为局部重叠的图像块,并对其进行归一化操作。为了增强模型的泛化能力,减少过拟合现象,分别对训练图像进行90°旋转、270°旋转、水平翻转、垂直翻转,将训练集扩充至原来的5倍,最终获得1900张256×256的训练图像。部分数据集及其真值图像如

图 4. 数据集展示。(a)训练集图像;(b)对应真值图像

Fig. 4. Display of dataset. (a) Training set image; (b) corresponding ground truth

3.2 训练细节

在二分类图像分割任务中,常采用的损失函数为像素级的二进制交叉熵损失函数。为了解决图像中正负类别不平衡的问题,引入Dice loss[17]。最终的损失函数形式为

式中:α=β=0.5,ε=10-3;pi为分割结果;yi为真值图像。

采用Adam算法[18]优化损失函数,初始学习率为0.001。批量大小设置为16,训练迭代100次。训练时,加入dropout层[19],丢弃概率设置为0.2,并引入早停机制,若10次迭代后loss仍不下降,则停止训练,防止模型过拟合。

3.3 评价指标

为了评估所提模型的分割效果,从主观评价和客观评价两方面对实验结果进行比较和分析。主观评价主要是从视觉效果上比较图像的整体分割及微弱边缘的分割情况。客观评价中,采用Pixel Accuracy[20]、Intersection over Union(IoU)[21]、Dice Score[22]作为评价指标,计算公式分别为

式中:NTP、NTN、NFP、NFN分别为细胞像素正确分类数目、背景像素正确分类数目、背景像素错误分类数目、细胞像素错误分类数目;X、Y分别为真实值和预测值。Pixel Accuracy为最简单的度量,表示分割正确的像素占总像素的比例;IoU为语义分割的标准度量,是真实值和预测值的交集与并集之比,其值为1时,表示两者完全相同;Dice Score为医学图像分割的重要度量,表示真实值与预测值的相似度,值越大,两者相似度越高。

3.4 不同分割模型的结果分析

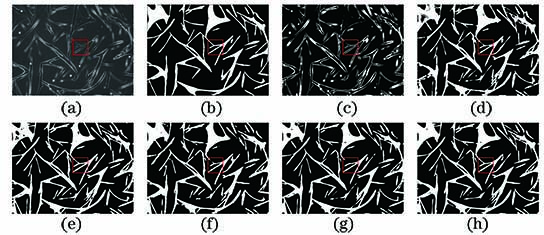

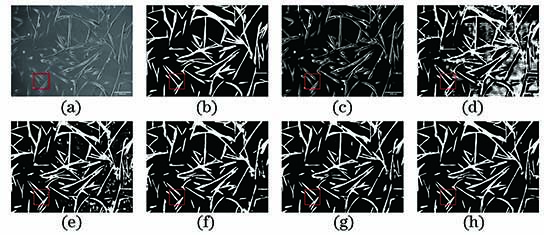

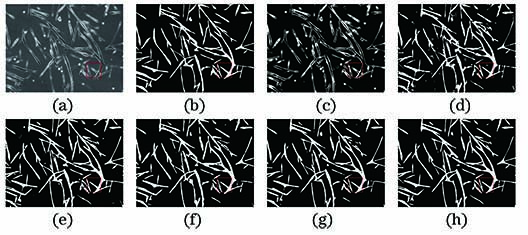

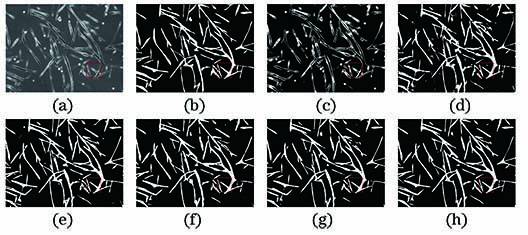

对阈值分割Otsu模型、FCN-8s模型[9]、SegNet模型[23]、U-Net模型[10]、R2U-Net模型[14]及所提模型进行对比,结果如

图 6. 第1组细胞分割结果。(a)原始图像;(b)真值图像;(c) Otsu模型;(d) FCN-8s模型;(e) U-Net模型;(f) SegNet模型;(g) R2U-Net模型;(h)所提模型

Fig. 6. Cell segmentation results of group 1. (a) Origin image; (b) ground truth; (c) Otsu model; (d) FCN-8s model; (e) U-Net model; (f) SegNet model; (g) R2U-Net model; (h) proposed model

图 7. 第2组细胞分割结果。(a)原始图像;(b)真值图像;(c) Otsu模型;(d) FCN-8s模型;(e) U-Net模型;(f) SegNet模型;(g) R2U-Net模型;(h)所提模型

Fig. 7. Cell segmentation results of group 2. (a) Origin image; (b) ground truth; (c) Otsu model; (d) FCN-8s model; (e) U-Net model; (f) SegNet model; (g) R2U-Net model; (h) proposed model

图 8. 第3组细胞分割结果。(a)原始图像;(b)真值图像;(c) Otsu模型;(d) FCN-8s模型;(e) U-Net模型;(f) SegNet模型;(g) R2U-Net模型;(h)所提模型

Fig. 8. Cell segmentation results of group 3. (a) Origin image; (b) ground truth; (c) Otsu model; (d) FCN-8s model; (e) U-Net model; (f) SegNet model; (g) R2U-Net model; (h) proposed model

图 9. 分割结果细节对比。(a)真值图像;(b) FCN-8s模型;(c) U-Net模型;(d) SegNet模型;(e) R2U-Net模型;(f)所提模型

Fig. 9. Detail comparison of segmentation results. (a) Ground truth; (b) FCN-8s model; (c) U-Net model; (d) SegNet model; (e) R2U-Net model; (f) proposed model

尽管通过视觉观察比较直接,但是其易受人主观因素的影响,故仍需对分割结果进行定量评价,结果如

表 1. 不同分割模型的定量分析

Table 1. Quantitative analysis of different segmentation models

|

3.5 各模块对整体模型的影响

为了验证各模块对整体模型的影响,对U-Net模型、添加残差块的优化模型、添加注意力机制的优化模型、所提模型进行对比实验,结果如

表 2. 各模块对整体模型的影响

Table 2. Influence of each module on whole model

|

4 结论

为了能够更准确地从相衬显微细胞图像中分割出细胞,本文提出了一种基于深度学习的attention Residual-UNet模型。该模型以U-Net为基本框架,首先,在U-Net中引入残差块,加强特征的传播,可以分割出更多的细节信息;然后利用注意力机制加强细胞区域的权重,以减缓图像亮度不均衡、对比度低对模型造成的干扰,提高模型的鲁棒性。实验结果表明,所提模型对细胞图像具有较高的分割精度,同时模型灵敏度也较高,但对于细胞内部亮度不均匀的区域仍会出现分割错误的现象。下一步将着重研究如何更高效地结合图像中的高级语义特征,减少像素错误分类的问题。

[1] HarderN, BodnarM, EilsR, et al. 3D segmentation and quantification of mouse embryonic stem cells in fluorescence microscopy images[C]∥2011 IEEE International Symposium on Biomedical Imaging: From Nano to Macro, March 30-April 2, 2011, Chicago, IL, USA. New York: IEEE, 2011: 216- 219.

[2] Faustino GM, GattassM, RehenS. Automatic embryonic stem cell detection and counting method in fluorescence microscopy images[C]∥2009 IEEE International Symposium on Biomedical Imaging: From Nano to Macro, June 28-July 1, 2009, Boston, MA, USA. New York: IEEE, 2012: 799- 802.

[4] Yin ZZ, LiK, KanadeT, et al. Understanding the optics to aid microscopy image segmentation[M] ∥Jiang T Z, Navab N, Pluim J P W, et al. Medical image computing and computer-assisted intervention-MICCAI 2010. Heidelberg: Springer, 2010: 209- 217.

[5] Yin ZZ, SuH, KerE, et al. Cell-sensitive microscopy imaging for cell image segmentation[M] ∥Golland P, Hata N, Barillot C, et al. Medical image computing and computer-assisted intervention-MICCAI 2014. Cham: Springer, 2014, 8673: 41- 48.

[6] 吴晨玥, 易本顺, 章云港, 等. 基于改进卷积神经网络的视网膜血管图像分割[J]. 光学学报, 2018, 38(11): 1111004.

[7] 郑婷月, 唐晨, 雷振坤. 基于全卷积神经网络的多尺度视网膜血管分割[J]. 光学学报, 2019, 39(2): 0211002.

[8] 褚晶辉, 李晓川, 张佳祺, 等. 一种基于级联卷积网络的三维脑肿瘤精细分割[J]. 激光与光电子学进展, 2019, 56(10): 101001.

[9] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 3431-3440.

[10] RonnebergerO, FischerP, BroxT. U-Net: convolutional networks for biomedical image segmentation[M] ∥Navab N, Hornegger J, Wells W M, et al. Medical image computing and computer-assisted intervention - MICCAI 2015. Cham: Springer, 2015, 9351: 234- 241.

[11] Quan TM, Hildebrand D GC, Jeong W K. FusionNet: a deep fully residual convolutional neural network for image segmentation in connectomics[EB/OL]. ( 2016-12-26)[2020-03-05]. https:∥arxiv.org/abs/1612. 05360.

[12] Yi J R, Wu P X, Jiang M L, et al. Attentive neural cell instance segmentation[J]. Medical Image Analysis, 2019, 55: 228-240.

[13] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Cham: Springer, 2016, 9905: 21- 37.

[14] Alom MZ, YakopcicC, Taha TM, et al. Nuclei segmentation with recurrent residual convolutional neural networks based U-Net (R2U-Net)[C]∥NAECON 2018 - IEEE National Aerospace and Electronics Conference, July 23-26, 2018, Dayton, OH. New York: IEEE, 2018: 228- 233.

[15] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[16] Chen LC, YangY, WangJ, et al. Attention to scale: scale-aware semantic image segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 3640- 3649.

[17] MilletariF, NavabN, Ahmadi SA. V-Net: fully convolutional neural networks for volumetric medical image segmentation[C]∥2016 Fourth International Conference on 3D Vision (3DV), October 25-28, 2016, Stanford, CA, USA. New York: IEEE, 2016: 770- 778.

[18] Kingma DP, Ba J. Adam: a method for stochastic optimization[EB/OL]. ( 2017-01-30)[ 2020-03-05]. https:∥arxiv.org/abs/1412. 6980.

[19] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. The Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[20] Garcia-Garcia A, Orts-Escolano S, Oprea S, et al. A survey on deep learning techniques for image and video semantic segmentation[J]. Applied Soft Computing, 2018, 70: 41-65.

[21] Levandowsky M, Winter D. Distance between sets[J]. Nature, 1971, 234(5323): 34-35.

[22] Dice L R. Measures of the amount of ecologic association between species[J]. Ecology, 1945, 26(3): 297-302.

[23] Badrinarayanan V, Kendall A, Cipolla R. SegNet: a deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.

Article Outline

张文秀, 朱振才, 张永合, 王新宇, 丁国鹏. 基于残差块和注意力机制的细胞图像分割方法[J]. 光学学报, 2020, 40(17): 1710001. Wenxiu Zhang, Zhencai Zhu, Yonghe Zhang, Xinyu Wang, Guopeng Ding. Cell Image Segmentation Method Based on Residual Block and Attention Mechanism[J]. Acta Optica Sinica, 2020, 40(17): 1710001.