基于卷积神经网络的雷达人体动作与身份多任务识别  下载: 1324次

下载: 1324次

1 引言

利用雷达进行人体动作识别与身份识别是近年来的研究热点,在灾难营救、医疗监控等领域都有广泛的应用前景 [1]。雷达具有高距离分辨率和强穿透力,能以非接触的方式对人体目标进行探测[2]。与其他传统人体行为探测方式[3-5]相比,雷达探测不仅不受环境条件限制,还可抑制杂波,更利于检测目标人体微小而复杂的行为变化。人体躯干及四肢的微弱动作会在雷达信号回波上引起微多普勒频移,这种现象可反映在雷达信号的可视化谱图上[6],谱图中的微多普勒特征可被用于人体的动作识别与身份识别。

基于雷达谱图的人体动作识别与身份识别任务已受到广泛关注。2009年,Kim等[7]分析了雷达时频图像特点,提取时变特征实现了人体动作分类。2015年,Ricci等[8]利用形状谱特征识别不同的人类身份。这些传统分类方法虽然取得了较好效果[9-11],但是需要人工提取判别特征,因此在其他任务上应用性不强。卷积神经网络(CNN)是识别领域中应用最广泛的深度学习模型,它可以自动学习图像特征完成识别。2016年,Kim等[12]率先将CNN应用于雷达人体动作识别。2018年,基于微多普勒雷达图像,Cao等[13]利用CNN实现了4个人的身份识别。同年,Chen等[14]在CNN浅层共享多基地雷达的各方向信息,提升了人体动作识别与步态识别的效果,但多基地雷达成本高,不利于实际应用。这些深度学习方法证明了CNN模型在雷达人体目标识别相关任务上的优越性[15-17]。但为了达到当前任务的最佳性能,其都是优化单一模型,易导致单任务上的过拟合。

多任务学习是一种归纳迁移机制,它通过学习多个任务上的共享知识来获得更好的泛化性能,可提升模型在多个任务上的有效性。文献[ 18]将自底向上的动态加宽网络用于实现多任务学习,但算法难以达到全局最优。文献[ 19]提出的深度关系网络通过对全连接层(FC)添加矩阵先验知识来学习任务间的关系,但在新任务上的应用性不强。多任务学习在自然语言处理[20]、实例分割[21]等领域都有广泛应用,雷达时频图像上的多任务识别方法仍有待研究。

本文提出了一种基于CNN的雷达人体动作与身份多任务识别方法。利用单基地雷达采集的人体回波信号,生成雷达时频图像数据集。构建多任务识别模型,通过对CNN特征的重校正和多尺度融合,进行两个相关识别任务的共享特征表示,最后分别在各自的特定任务层完成相关目标的识别。此外,在传统交叉熵损失函数基础上引入中心损失函数和均方误差损失函数,共同优化多任务模型参数。本文所提算法基于深度学习,采用雷达实测数据进行模型训练来完成识别任务,避免了对不同人体进行建模的复杂过程,更具有实际应用意义,其在雷达时频图像数据集上的识别结果验证了本方法的有效性。

2 雷达时频图像数据集构建

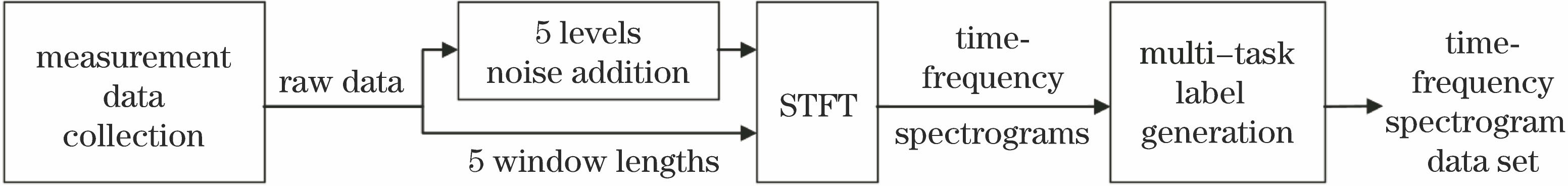

雷达时频图像数据集的构建流程如

2.1 数据采集

本文使用超带宽雷达模块PulsON 440进行人体行为的实测数据采集。雷达的工作频率为3.1 GHz到4.8 GHz,采样频率设置为16 GHz。采集实验在室内环境下进行。将两个定向天线的高度调整为1.2 m,用其发射雷达信号并接收人体回波信号。实验共有十五位被试者参与。在雷达的径向方向上对每位受试者的6种典型人体动作进行采集,所选取的动作分别为行走、拳击、地面爬行、潜行、前向立定跳、跑步。每种动作由每位被试者重复10~15次,每次采集时间为7 s左右。

2.2 雷达时频图像生成

对采集的雷达原始回波信号进行1024点的STFT可得到雷达时频图像。STFT将非平稳过程看作一系列短时平稳信号的叠加,先在时间维度上对信号进行加窗,再对窗内信号作傅立叶变换,得到信号的时变频谱,表达式为

式中:w(t)为窗函数;x(t)为雷达人体回波信号;t为时变信号的时间信息;τ为信号被截取的某个特定时间段。

为探究噪声对识别算法的影响,在雷达回波信号中加入均值为零的高斯白噪声得到0 dB、10 dB、20 dB、-10 dB、-20 dB这5种信噪比的有噪声信号,对有噪声信号采用长度为1.0 s的滑动窗口生成对应各噪声等级的5组时频图像;为探究STFT窗长对识别算法的影响,对无噪声信号分别采用长度为0.2,0.4,0.6,0.8,1.0 s的滑动窗口生成对应各窗长的5组时频图像。最后对生成的时频图像进行身份类别标定和动作类别标定。STFT慢时间窗口长度为1.0 s时,6种人体动作对应的无噪雷达时频图像如

图 2. 6种人体动作下的雷达时频谱图。(a)行走;(b)拳击;(c)地面爬行;(d)潜行;(e)前向立定跳;(f)跑步

Fig. 2. Radar time-frequency spectrograms of radar for six human activities. (a) Walking; (b) boxing; (c) crawling on the ground; (d) diving; (e) standing forward and jumping; (f) running

在生成的雷达时频谱图中,具有相同信噪比和相同STFT窗口长度的每种图像数量为180000张。在180000张的单种图像数据中,每个受试者的单个动作种类下含雷达时频图像2000张。每张图像对应一个身份类别标签和一个动作类别标签,尺寸为120 pixel×120 pixel。

3 基于CNN的雷达人体动作与身份多任务识别

3.1 基于注意机制的特征重校正结构

注意力机制的本质是将处理资源分配给更具价值的输入信息,并抑制无用信息以提高任务处理的效率与准确性。压缩激励(SE)模块[23]是一种基于特征通道的注意力加权操作,可以通过筛选特征信息来获取更有效的共享特征表示,从而提升多任务识别效果,其结构如

SE模块对维度为W×H×C的卷积层输出特征图进行全局池化(GAP),即通过全局平均将特征图每个通道上的二维特征表征为一个实数值,从而压缩各通道的特征图。所得输出特征的维度与特征图的通道数C相对应,每个通道上的输出值都具有全局的感受野,表示该通道的全局特征信息。

本结构还引入了源于循环神经网络的门激励机制[24],通过全连接层学习各通道之间的非互斥关系,并将激活函数作为门控,用于获取每个通道上的激励。SE模块利用一个全连接层将输入特征的维度降低为原来的1/16,使用一个修正线性单元(ReLU)激活后,利用第二个全连接层将特征升维至原始输入维度。两个全连接层构成的瓶颈结构使特征权重生成过程中的模型参数量减少,降低了计算复杂度,且增加了模型的非线性。采用sigmoid激活函数在网络的末端生成各通道权重,此权重值与可学习的模型参数相关,通过对卷积后的特征图进行乘法加权来自动完成特征重校正。

3.2 基于CNN的多任务识别模型

基于CNN的多任务识别模型由任务共享层与任务特定层构成,具体结构如

任务共享部分以传统的CNN结构为基础进行特征提取,含有五个卷积层,三个池化层。第一个卷积层使用96个11×11大小的卷积核;第二个卷积层使用256个5×5大小的卷积核;第三、四、五个卷积层分别使用384、384、256个3×3大小的卷积核。池化层都以3×3的窗口尺寸为基准进行最大池化操作。后四个卷积层分别与池化层和ReLU构成4个块(Block),由浅到深地提取微多普勒图像上不同层次的特征。保留最后一个卷积层的输出,在网络的前4个卷积层之后都加入SE模块,通过学习权重参数,对各层级的特征图进行重校正,提升相关特征的重要性,同时抑制不重要的特征。包含后四个卷积层的Block1~Block4分别放置于每个重校正结构之后,对校正后的特征图进行进一步抽象处理。

网络浅层所输出的底层特征具有雷达时频图像上的细节信息,如几何特征等,但缺少了上下文信息。网络深层输出的高层特征包含更抽象的语义信息,但丢失了较多空间位置信息。本文方法使用多尺度特征融合结构,保留多尺度特征图上的各通道全局信息,对 CNN模型生成的各尺度特征进行串行连接(concat),丰富了共享特征的层次。对Block1~Block4输出的四个尺度特征图分别进行全局池化操作,可以得到四个特征向量,特征向量表征了特征图各个通道上的全局信息,其维数与该尺度特征图的通道数相同。将四个尺度下的特征向量沿各自的通道维度进行串行连接。多尺度特征融合后的特征向量即为任务共享层输出的共享特征。

任务特定部分由每个任务上的三层全连接层构成。第一层全连接层输入1280维的特征向量,经过多次实验将输出维度设为96,第二层全连接层输入输出维度相同,第三层全连接层输入的特征向量维度为96,输出为相应任务类别上的识别结果。Dropout是一种随机失活操作。在深度学习网络的训练过程中,Dropout按照一定的概率将神经网络单元暂时从网络中丢弃。每两个全连接层中间添加ReLU和Dropout以增加非线性和防止过拟合。人体动作识别与身份识别都以多任务的共享特征为输入,在对应任务的特定层上获取识别结果。

3.3 多任务识别的联合损失函数

多任务识别的联合损失函数由交叉熵损失函数、中心损失函数、均方差损失函数构成。三种损失函数的联合监督扩大了样本在特征空间中的类间距离,减小了类内距离,均化了样本在识别上的错分概率,从而使多任务模型具有更强的识别能力。

交叉熵损失LE是分类问题中广泛使用的损失函数,表达式为

式中:m和n代表每个训练批次的样本数和样本类别数;xi为类别j下的样本i生成的特征矩阵;W、b为模型的参数矩阵和偏置项。交叉熵损失通过简单的计算结构衡量类分布之间的差异,可避免梯度弥散。在训练过程中,交叉熵损失函数仅注重于扩大样本的类间距离,但对相同类别下的样本分布没有进行约束,这种优化方式得到的样本分布可能存在类内间距大于类间间距的情况。为优化样本分布,在交叉熵损失函数的基础上加入中心损失函数与均方差损失函数,以进行联合优化。

中心损失函数[25]LC在单个识别任务的每个类别j上动态更新一个类中心cj,根据样本i与其类中心的距离计算中心损失函数,其表达式为

类分布在损失优化下的变化过程可表示为

式中:xij,cij表示矩阵xi和类中心cj的矩阵元。

最小化中心损失有利于类内样本的聚合,可以形成更紧凑的类分布。训练数据量较大时,无法直接获取类中心,因此先对类中心进行一个随机初始化。在计算每个类中心的更新量时,只考虑和中心类别相同的样本。以α作为类中心的学习效率,通过多次迭代对类中心进行更新。

均方差损失函数LM通常在回归问题中用于计算预测值与真实值间的距离。在识别任务中,可利用均方差损失函数来衡量模型的预测分布与真实分布之间的差异。在优化过程中,均方差损失函数与非样本所属类别的预测结果相关,可均化错分类别。将样本i的真实标签进行独热编码,得到的编码向量hi视为真实分布,维度等于识别任务中的类别数。向量仅在样本真实类别所对应的位上取1,其余位为0。模型在特定识别任务上对样本i的输出zi是各类别上的预测概率,视为预测分布。故均方差损失函数的表达式为

多任务识别下的联合损失函数生成过程如

4 分析与讨论

实验使用64位的Ubuntu14.04系统,处理器型号为Intel(R) Core(TM) i7-7700K CPU @4.20 GHz,内存8G,显卡型号为GeForce GTX 1080Ti,显存为11G。算法的实现基于python语言和Pytorch深度学习框架,优化器使用Adam梯度下降算法。

4.1 多任务识别与单任务识别分析

实验采用慢时间窗口长度为1.0 s的无噪雷达时频图像(180000张),其中每个受试者的单个动作种类包含2000张雷达时频图像。将180000张时频图像数据按照受试者类别和动作类别进行分层随机抽样,可得到4个数量相等的子集(45000张)。每个子集中,单个受试者的单个动作类别包含时频图像500张。每次取3个子集作为训练集(135000张),一个子集作为测试集(45000张),得到交叉验证集(cross validation)1~4。采用本文提出的模型结构和联合损失优化方法,进行人体动作(HA)与人体身份(HD)的多任务识别(MR)以及单任务识别(SR)。在单任务识别中,利用对应任务上的联合损失分别训练各任务的对应模型。训练中学习率为0.0001,迭代次数为20。经多次实验,设定λE、λM,λC为0.01,α为0.005。

实验结果表明,四折交叉验证上的多任务识别准确率均高于单任务独立识别的准确率。多任务下的总识别准确率平均值比单任务识别高出1.7%,证明了雷达人体动作识别任务与身份识别任务之间具有相互促进的作用,同时验证了本文方法的有效性。与单任务识别相比,多任务识别中的总任务识别和身份识别的准确率差异更小,即两个任务中被正确识别的样本重合度更高,这表明多任务信息的共享使模型学习到了更具泛化性的特征表示。

表 1. 多任务识别与单任务识别结果

Table 1. Results of multi-task and single-task recognitions

| ||||||||||||||||||||||||||||||||||||||||||||||||

图 6. 训练变化曲线。(a)损失变化曲线;(b)准确率变化曲线

Fig. 6. Loss and accuracy curves. (a) Loss curves; (b) accuracy curves

不同人体动作产生的雷达时频图像因具有一定的可视化差异易被识别,而不同受试者在相同动作下产生的时频图像差异是细粒度的,且待识别的身份种类多达15种,因此身份识别在难度上高于动作识别,动作识别任务在训练过程中具有更快的收敛速度和更高的准确率。

4.2 网络结构与联合损失对识别的影响分析

为证明网络结构各部分的有效性,首先在本文模型的基础上去除4个放置于卷积层后的SE模块,将得到的结构记为D-SE。然后,保留本文模型中的CNN特征提取部分,去掉多尺度特征融合结构,将任务特定部分的全连接层连接到Block4之后,此时任务特定层的输入仅为CNN最深层的特征,将此结构记为D-MS。最后,将去除4个SE模块后的D-MS结构记为D-MSSE。三个模型都采用联合损失优化,在交叉验证集4上的识别结果如

表 2. 不同网络结构下的识别结果

Table 2. Recognition results of different network structures

| |||||||||||||||||||

利用D-MS网络对前几个卷积层的输出进行特征校正,并将最高层的CNN特征用于特定的任务识别,识别效果与D-MSSE相比有一定改善。D-SE综合了多尺度特征图的各通道全局信息用于特定任务识别,但因为失去了SE模块对各通道特征的校正作用,各尺度上的通道全局信息缺乏准确性和一致性,所以特征融合后的识别结果有所下降。本文模型的识别效果高于此三种模型结构,证明了特征重校正结构和多尺度结构联合使用的必要性。两个结构共同利用了各通道特征的全局信息,在特征提取、校正和融合的联合作用下,能够提升识别效果。

本文模型以传统的交叉熵损失函数为基础,加入不同损失函数进行优化后的识别结果如

表 3. 不同损失优化下的识别结果

Table 3. Recognition results of different loss optimization

| |||||||||||||||||||

4.3 STFT窗长、噪声、训练数据量对识别的影响分析

在5种STFT窗长(L)的无噪声雷达时频图像数据集上分别进行动作、身份类别的分层随机抽样,按照3:1的数量比例将样本划分为训练集和测试集,采用本文方法进行识别。

表 4. 不同STFT窗长下的识别结果

Table 4. Recognition results under different STFT window lengths

| |||||||||||||||||||||||

在5种信噪比(NSR)的有噪声雷达时频图像数据集上分别进行动作、身份类别的分层随机抽样,按照3∶1的数量比例将样本划分为训练集和测试集,采用本文方法进行识别。

除此之外,本文还验证了数据量不足情况下的模型识别效果,从交叉验证集4的训练集中随机挑选数据,组成6种包含不同数据量的训练集。训练后的模型都在交叉验证集4的测试集上进行识别,实验结果如

表 5. 不同信噪比下的识别结果

Table 5. Recognition results under different NSR

| |||||||||||||||||||||||||||

表 6. 不同训练数据量下的识别结果

Table 6. Recognition results under different training data sizes

| |||||||||||||||||||||||||||||||

4.4 对比算法结果分析

本文采用PRGC算法[13]和MRN算法[18]在交叉验证集4上进行对比。PRGC算法使用多个雷达基站的时频图像共同训练浅层CNN以提升识别准确率;MRN算法主要通过在全连接层上进行信息迁移实现多任务学习。将本文提出的模型记为MCNN,

表 7. 对比算法结果

Table 7. Comparison of results of algorithms

| |||||||||||||||||||

PRGC算法未对模型的共享特征提取结构进行针对性改进,而MRN算法仅在全连接层上进行多任务的信息交互,在特征提取时仅使用了较为基础的CNN结构。本文方法关注于两个任务的潜在相关性,不仅改善了模型结构、加强了所提特征对各识别任务的有效性,还在优化方法上进一步约束了类分布以提高模型的泛化性能,从而综合地提升识别效果。本文提出的模型结构和联合损失的优化方法使网络能学习到雷达人体动作识别与身份识别任务上更具泛化性的共享特征表示,有效提升了识别的准确率。

5 结论

本文对雷达在人体动作识别与身份识别上的应用进行研究,针对相关任务间的信息共享问题和样本类分布的约束问题,提出一种基于CNN的多任务识别模型。在模型结构方面,利用特征重校正结构和多尺度特征融合结构提取共享特征,在特定任务层上进行多任务识别;在模型优化方面,提出基于多任务联合损失函数的优化方法,引入中心损失函数聚合类内样本,引入均方差损失函数促进类间样本分离,以获得更加紧致的类分布。实验结果表明,本文方法可有效提升模型的泛化性能,从而提高识别准确率,总识别准确率最高可达99.93%,优于任务独立识别结果以及其他算法的识别结果,且本文方法在不同的噪声量级、STFT窗长和训练数据量上都具有一定的稳定性。今后将针对小数据集上的识别方法,尝试多种模型结构与优化方法,进一步提高雷达人体动作与身份识别的效率与准确度。

[1] Fairchild D P, Narayanan R M. Classification of human motions using empirical mode decomposition of human micro-Doppler signatures[J]. IET Radar, Sonar & Navigation, 2014, 8(5): 425-434.

[2] 张翼, 朱玉鹏, 程永强, 等. 基于微多普勒特征的人体目标雷达回波信号分析[J]. 信号处理, 2009, 25(10): 1616-1623.

Zhang Y, Zhu Y P, Cheng Y Q, et al. Human target radar echo signal analysis based on micro-Doppler characteristic[J]. Signal Processing, 2009, 25(10): 1616-1623.

[3] 黄友文, 万超伦, 冯恒. 基于卷积神经网络与长短期记忆神经网络的多特征融合人体行为识别算法[J]. 激光与光电子学进展, 2019, 56(7): 071505.

[5] 徐海洋, 孔军, 蒋敏, 等. 基于时空方向主成分直方图的人体行为识别[J]. 激光与光电子学进展, 2018, 55(6): 061009.

[6] van Dorp P, Groen F C A. Feature-based human motion parameter estimation with radar[J]. IET Radar, Sonar & Navigation, 2008, 2(2): 135-145.

[7] Kim Y, Ling H. Human activity classification based on micro-Doppler signatures using a support vector machine[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(5): 1328-1337.

[8] Ricci R, Balleri A. Recognition of humans based on radar micro-Doppler shape spectrum features[J]. IET Radar, Sonar & Navigation, 2015, 9(9): 1216-1223.

[9] LiJ, Phung SL, Tivive F H C, et al. Automatic classification of human motions using Doppler radar[C]∥The 2012 International Joint Conference on Neural Networks (IJCNN), June 10-15, 2012, Brisbane, QLD, Australia. New York: IEEE, 2012: 12906230.

[11] Tahmoush D. Review of micro-Doppler signatures[J]. IET Radar, Sonar & Navigation, 2015, 9(9): 1140-1146.

[12] Kim Y, Moon T. Human detection and activity classification based on micro-Doppler signatures using deep convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(1): 8-12.

[13] Cao P B, Xia W J, Ye M, et al. Radar-ID: human identification based on radar micro-Doppler signatures using deep convolutional neural networks[J]. IET Radar, Sonar & Navigation, 2018, 12(7): 729-734.

[14] Chen Z X, Li G, Fioranelli F, et al. Personnel recognition and gait classification based on multistatic micro-Doppler signatures using deep convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 669-673.

[15] Seyfioglu M S, Ozbayoglu A M, Gurbuz S Z. Deep convolutional autoencoder for radar-based classification of similar aided and unaided human activities[J]. IEEE Transactions on Aerospace and Electronic Systems, 2018, 54(4): 1709-1723.

[16] Kim Y, Li Y. Human activity classification with transmission and reflection coefficients of on-body antennas through deep convolutional neural networks[J]. IEEE Transactions on Antennas and Propagation, 2017, 65(5): 2764-2768.

[17] KlarenbeekG, Harmanny R I A, Cifola L. Multi-target human gait classification using LSTM recurrent neural networks applied to micro-Doppler[C]∥2017 European Radar Conference (EURAD), October 11-13, 2017, Nuremberg, Germany. New York: IEEE, 2017: 167- 170.

[18] Lu YX, KumarA, Zhai SF, et al. Fully-adaptive feature sharing in multi-task networks with applications in person attribute classification[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1131- 1140.

[19] Long MS, Cao ZJ, Wang JM, et al. Learning multiple tasks with multilinear relationship networks[C]∥Advances in Neural Information Processing Systems 30 (NIPS 2017), December 4-9, 2017, Long Beach, CA, USA. Canada: NIPS, 2017: 1594- 1603.

[20] HashimotoK, Xiong CM, TsuruokaY, et al. ( 2017-07-24)[2019-06-09]. https:∥arxiv.org/abs/1611. 01587.

[21] KendallA, GalY, CipollaR. Multi-task learning using uncertainty to weigh losses for scene geometry and semantics[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 18-22, 2018, Salt Lake City, Utah. New York: IEEE, 2018: 7482- 7491.

[22] 刘燕平, 王冲, 夏海云. 时频分析在激光雷达中的应用进展[J]. 激光与光电子学进展, 2018, 55(12): 120005.

[23] Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 1.

[25] Wen YD, Zhang KP, Li ZF, et al. A discriminative feature learning approach for deep face recognition[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9911: 499- 515.

Article Outline

侯春萍, 蒋天丽, 郎玥, 杨阳. 基于卷积神经网络的雷达人体动作与身份多任务识别[J]. 激光与光电子学进展, 2020, 57(2): 021009. Hou Chunping, Jiang Tianli, Lang Yue, Yang Yang. Human Activity and IdentityMulti-Task Recognition Based on Convolutional Neural Network Using Doppler Radar[J]. Laser & Optoelectronics Progress, 2020, 57(2): 021009.