三维点云场景数据获取及其场景理解关键技术综述  下载: 2397次

下载: 2397次

1 引言

场景理解是在空间感知的基础上,对场景进行认知和推断的过程。然而,目前场景理解还没有严格统一的定义。根据目前国内外相关的研究,场景理解主要包含目标检测与识别、物体间的关系以及语义分割等科学内容[1-3]。场景理解是人工智能的前沿研究方向之一,在机器人、虚拟现实、自动驾驶和激光遥感测量等领域具有广泛的应用[4-7],例如,美国国家高速路安全管理局(NHSTA)定义的L5级自动驾驶、百度和高德等的三维(3D)语义地图以及现代战场环境下的单兵作战机器人等都需要高精度、高性能的环境感知和场景理解能力。

基于二维(2D)图像数据(如RGB图像、遥感图像)的场景理解已得到广泛的研究与应用。2D图像提供了物体的颜色、纹理及光谱等关键特征。然而,2D图像所复现的场景可能会存在光照不均匀、目标遮挡等现象,并且在生成过程中易受周围环境的影响。同时,2D图像不包含深度信息。因此,基于2D图像数据的场景理解稳健性差,且难以精确地提取目标轮廓、空间位置等关键信息。

基于3D建模数据(如点云、CAD模型等)的场景理解能够感知场景的3D空间信息。近年来,传感器的快速发展,使得3D数据的获取越来越容易。此外,随着计算机视觉、人工智能技术以及机器人技术的发展,关于各种空间物体的识别和理解的研究已经引起了越来越多的关注。目前,越来越多的学者针对3D场景理解的关键技术展开了大量研究[5,8-11]。近五年来,针对室内与室外环境的点云进行场景理解的方法逐年递增,为了对现有方法进行系统的研究与阐述,检索了近年来关于场景理解的相关文献,通过整理、阅读和研究发现,目前关于场景理解的综述文章都集中于2D图像的场景理解,还没有关于3D场景理解的相对完整、系统的综述,也缺乏图像和3D数据的对比研究。因此,本文主要针对3D场景理解的关键技术,采用图像和3D数据对比的方式,对3D场景数据的获取、现有3D场景理解数据集以及现有场景理解的方法展开论述,最后,对3D场景理解需解决的关键问题进行了展望。

2 点云场景数据获取

2.1 3D重建数据获取的传感器

常用于获取3D重建数据的传感器有普通摄像头、全景摄像机系统、深度相机和激光雷达等。相比较于摄像头获取的2D图像,3D点云可以提供更多的几何结构等空间信息,同时,3D点云获取设备(如Kinect、TOF、激光雷达)的快速发展,使得相关领域的研究人员能够更容易以越来越低的成本获得精度越来越高的3D点云数据。特别是利用激光扫描技术可以快速、高精度、简便地获取到空间信息数据。在复杂的现场环境及空间中,利用激光扫描技术可以直接得到各种大型、复杂、不规则、标准或非标准的实体或实景的3D数字几何信息。

2.2 3D数据重建方法

目前,常用的3D数据获取方法主要分为基于立体视觉、激光和视觉与激光联合重建的方法。基于立体视觉的3D重建方法进行3D重建本质上均是模仿人眼的“视差原理”,这种使用视觉方法进行3D重建的稳健性很差。虽然在比较理想的情况下,目前好的多目视觉方案精度可以达到厘米级别,但是当外界光线由强变弱时,或者物体表面纹理信息缺乏时,容易产生误匹配,精度会大打折扣。因此,基于立体视觉进行3D重建,其精度会随着周围环境的变化而受到影响,不但不具有良好的实时性反而具有相当大的局限性,限制了此方法在3D重建领域的广泛应用。而基于Kinect和TOF(Time of Flight)的3D重建,由于摄像头拍摄视野范围比较小,只能探测几米的范围,所以一般只能应用于室内场景。对于激光3D重建方法,虽然激光的探测距离相对较远,但是得到的只有场景的几何结构信息,缺乏场景的彩色信息,因此不利于后期基于场景的语义分割、场景理解等上层研究。

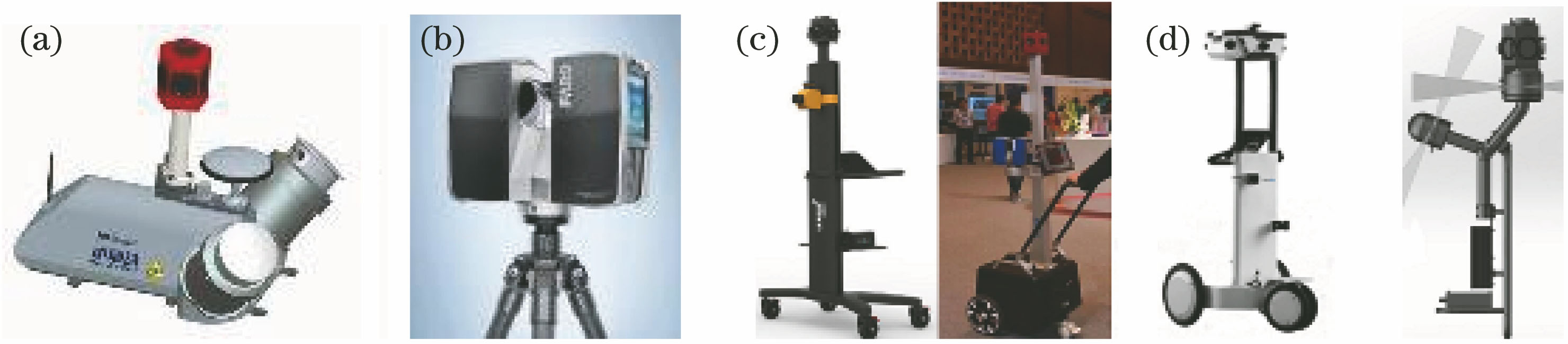

此外,基于合成孔径雷达(SAR)成像和高清影像可以生成地面场景的彩色点云数据,例如Seasat SAR、Almaz SAR、JERS-1 SAR等。这类数据虽然具有颜色信息且为大尺度场景,但是地面底部信息精度不高,会有一定的遮挡和信息缺失。然而,利用相机和激光点云的联合3D重建不但可以得到大尺度场景的几何结构信息和场景的彩色信息,而且能够适应地面上更多的环境场景,从而可以获得精度较高、信息丰富、场景多元化的3D重建效果。现有的联合重建方法中3D点云数据获取通常是如

图 1. 3D数据采集系统。(a)车载系统;(b)固定式扫描仪;(c)手推车式采集系统;(d)背负式采集系统

Fig. 1. Three-dimensional data acquisition systems. (a) Vehicle system; (b) fixed scanner; (c) trolley type acquisition system; (d) backpack type acquisition system

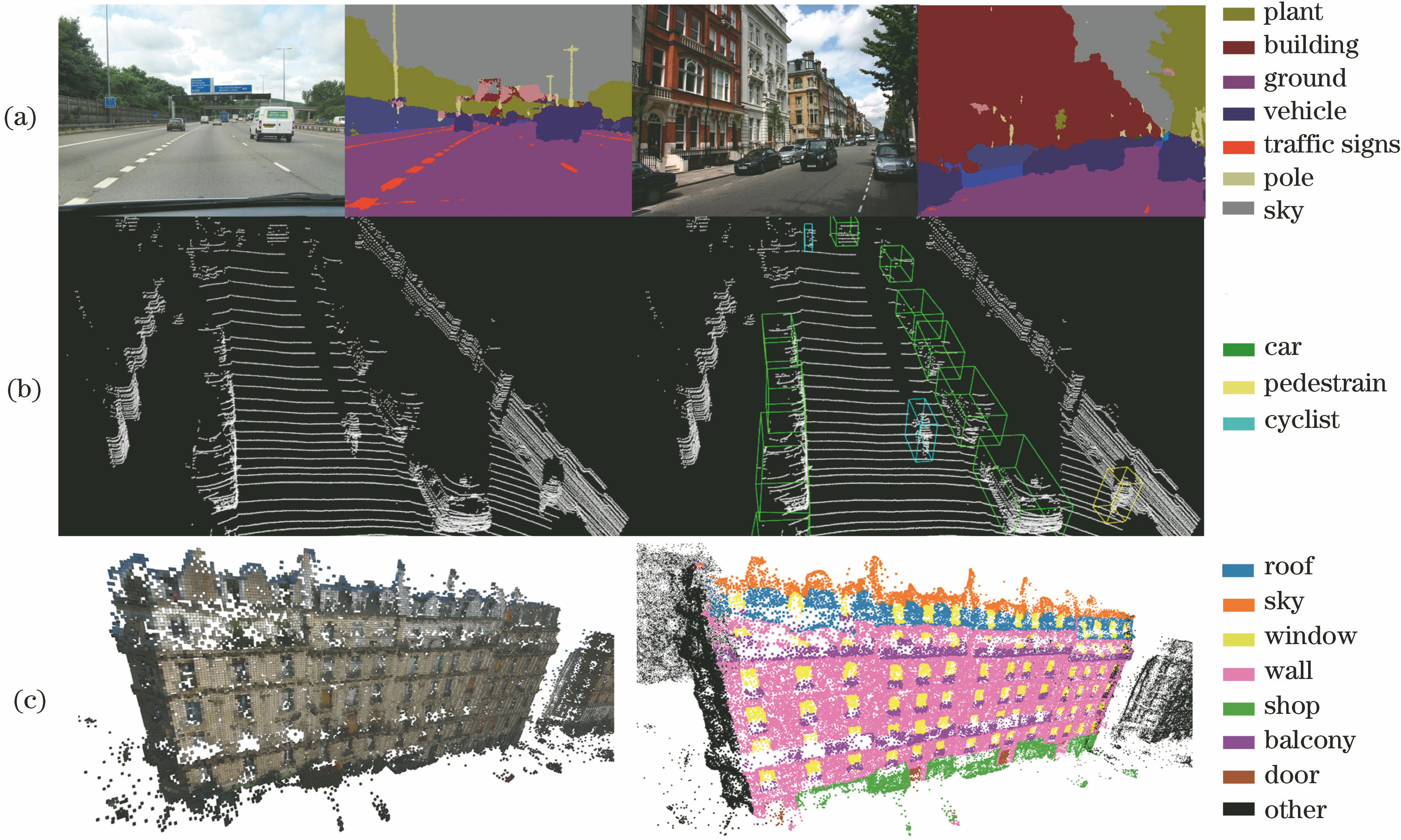

图 2. 场景理解示例。(a)图像语义分割;(b)点云目标检测;(c)点云语义分割

Fig. 2. Examples of scene understanding. (a) Semantic segmentation of image; (b) target detection of point cloud; (c) semantic segmentation of point cloud

3 3D场景数据类型对比及数据库

3.1 场景理解不同数据的对比

不同的数据类型进行场景理解时具有不同的效果。

为了更加明显地对比各种场景理解的数据,对现有的数据进行分类比较,

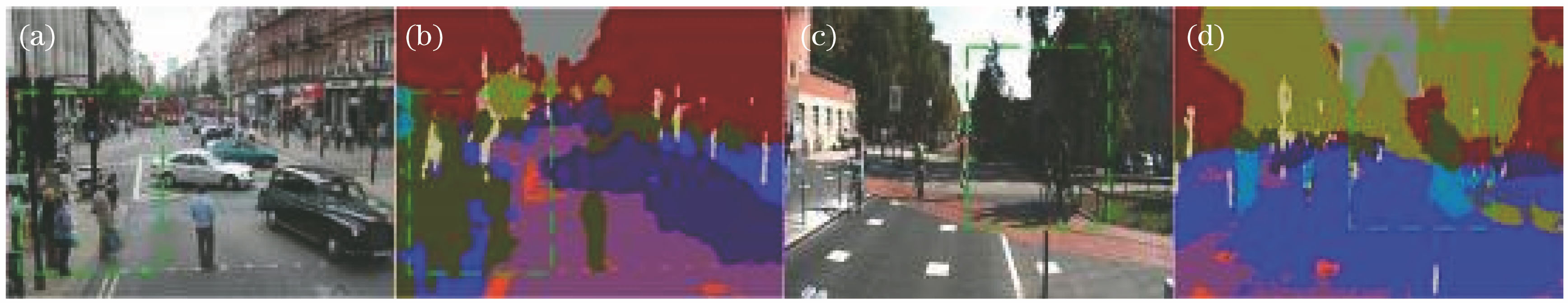

图 3. 2D图像受环境因素影响示例。(a)目标严重遮挡;(b) a图语义分割结果;(c)目标受光照影响;(d) c图语义分割结果

Fig. 3. Examples of 2D images affected by environmental factors. (a) Severe occlusion of target; (b) semantic segmentation of (a); (c) target affected by light; (d) semantic segmentation of (c)

表 1. 场景理解不同数据的优缺点对比

Table 1. Comparison of advantages and disadvantages of different data in scenario

|

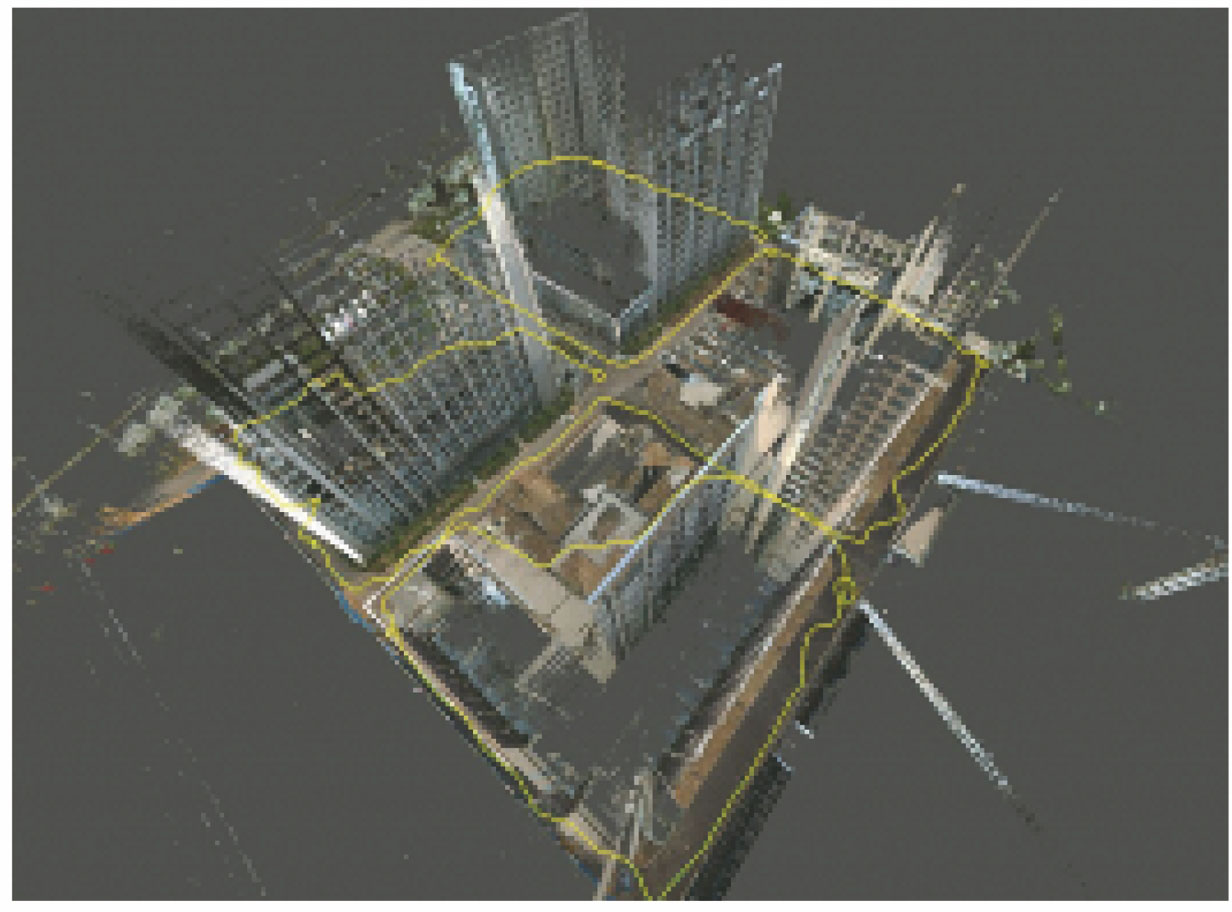

定义具有颜色信息的激光点云为彩色激光点云,该数据通过RGB图像和激光点云联合3D建模生成,不仅拥有RGB图像中的颜色信息,而且具备激光点云的空间结构特征,有利于目标物体多样、纹理复杂以及噪点多的室内外环境场景理解。

图 4. 3D彩色点云室外场景语义分割

Fig. 4. Semantic segmentation of semantic 3D color point cloud of outdoor scene

此外,相比于车载激光雷达、静态激光雷达以及航拍激光雷达,背负式激光雷达在复杂环境下的数据采集具有更多的优势。

图 6. 背负式全景影像移动轨迹(黄色线条)

Fig. 6. Trajectory (yellow lines) of collision-based panorama image

3.2 3D场景数据库

目前,3D点云公共数据库主要包含基于Kinect采集的数据库和基于激光点云的数据库。

基于Kinect采集的数据库,如NYUv2 dataset[10]和SUN RGB-D dataset[11]等。此类数据库面向室内场景居多,且数据精度及点云模型的完整性并不高。

基于激光点云的数据库,如Laser Registration Datasets[14];基于单站式的静态激光扫描的公共数据集Semantic 3D[8],航拍影像与激光扫描结合的点云数据库,如Aerial Inspection Datasets[7];其他车载激光点云数据,如德国Toposcan公司通过Lynx平台获取的Enschede数据、芬兰赫尔辛基大学通过ROAMER平台获取的Espoonlahti数据、Sydney Urban Object[15], ModelNet[16]等。此类数据库多数缺乏颜色信息或数据库表征场景单一或精度较低、场景完整度较差,在场景理解应用中效果较差。

内容丰富的彩色激光点云数据库,尤其是彩色激光点云数据库,能够准确复现3D场景的丰富信息,场景理解算法需要通过完整、有效的数据集进行验证,如

4 场景理解关键技术

3D场景理解是在空间认知的基础上,利用视觉分析、测绘测量等技术,挖掘场景数据中的特征与模式,形成对场景中物体的分割和识别,并对整个场景进行描述等的过程。基于3D点云的场景理解关键技术主要包括:点云的滤波、点云的特征提取、点云的分割、点云的分类、场景的语义分割与理解等内容。

4.1 点云的滤波

点云数据较复杂,目前的点云数据会存在数据缺失的现象,如扫描的模型被遮挡,造成部分点云数据的缺失;点云中通常含有噪声点及冗余信息;点云中存在旋转问题,如同一个物体,会存在不同的点云表达形式。

在点云的场景理解中,地面区域会对场景的分割等造成干扰,需要滤除地面区域,以便对地面以上感兴趣的信息进行有效的理解。点云滤波是点云处理的基本步骤,主要分为对点云中的噪声点进行滤波和对地面点进行滤波。对噪声点的滤波主要有直通滤波、半径滤波和统计滤波。如

表 2. 噪声点的滤波方法比较

Table 2. Comparison of noise filtering methods

|

目前,地面滤波的方式主要有基于高程的滤波方法、基于模型的滤波方法、基于区域生长的滤波方法、基于窗口移动的方法和基于三角网的滤波方法。如

表 3. 地面滤波方法比较

Table 3. Comparison of ground filter methods

|

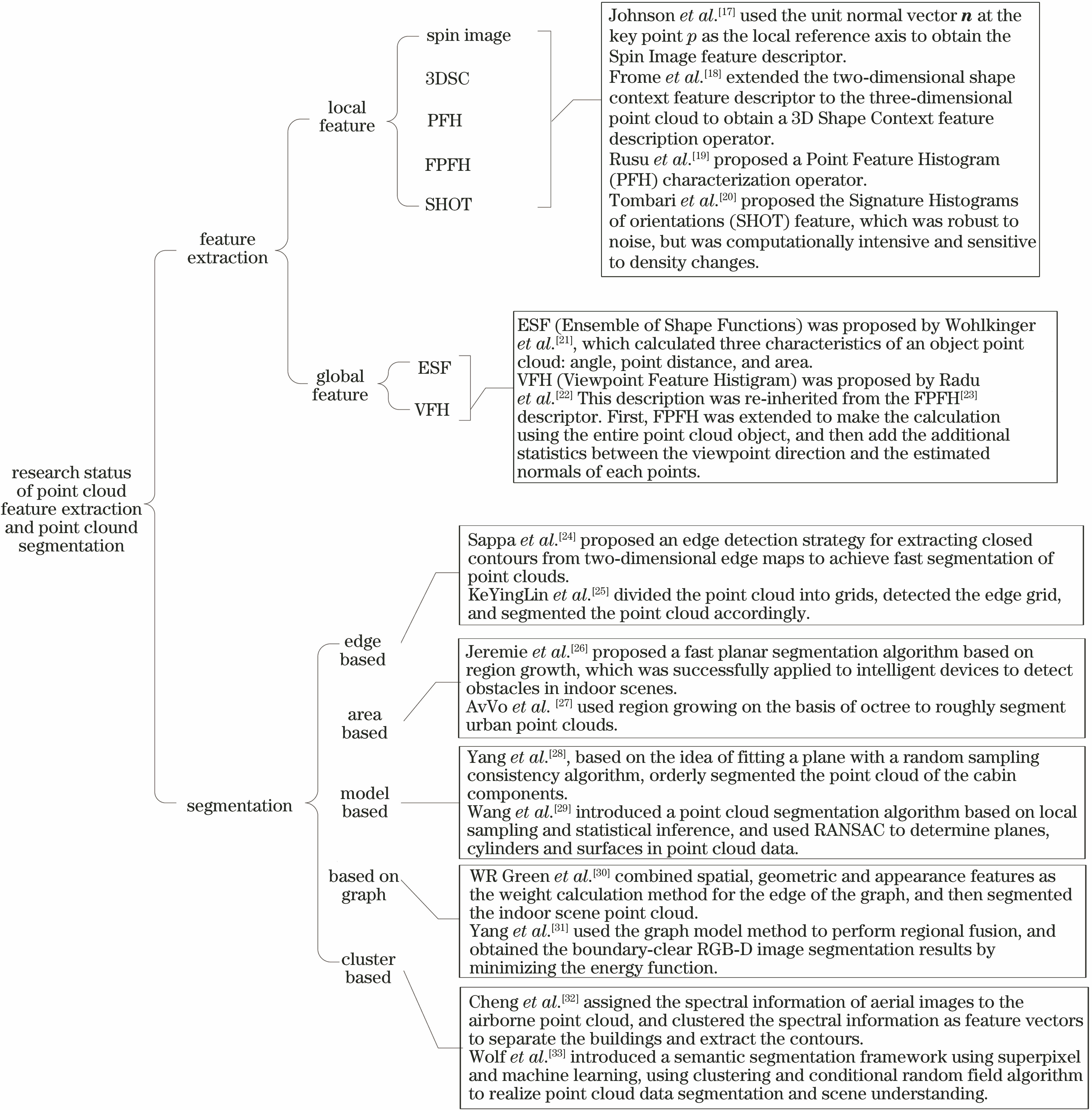

4.2 点云的特征提取与分割

点云的稳健特征提取与分割是室外场景理解的重要研究内容。稳健的特征是描述3D场景的基础表达。

4.3 3D点云的语义理解

语义分割是场景理解的基础和前提,即在语义分割基础上,结合其他信息,可以继续推理得到其他高层语义,如场景类别(街道、海边、城市或室内)、真实世界中的3D结构、场景中正在发生的事件等,进而实现场景的理解[17-18]。点云数据中的几何信息通常以原始无序的、密度分布不匀的3D空间点集的形式存在,数量从几千到上千万个不等,数据量较大[23]。面对着越来越庞大的3D点云数据,传统的人工手段解决海量3D数据语义解析的工作量较大,且效率低,而且计算机硬件的不断增强和软件技术的发展也使得处理3D数据的能力越来越强。尤其是机器学习和深度学习理论及其在多个领域的成功应用,为基于3D点云的语义分割与场景理解提供了重要的技术手段。

随着机器学习理论不断完善,基于点云的分类、识别等场景理解研究取得了较多的研究成果。国内外的研究者针对点云分类提出了大量算法,主要分为两大类,即基于点的分类和基于分割的分类。

图 8. 点云特征提取及点云分割研究现状

Fig. 8. Research status of point cloud feature extraction and point cloud segmentation

基于点的分类是直接对每一个3D点进行分类。如Hackel等[34]就是根据密度构建尺度金字塔,计算每个点共144维特征向量,并使用分类器训练来对室外场景点云直接分类。Weinmann等[35]首先选取尺度大小不同的最近邻,之后提取多种特征并使用分类器对大场景点云进行分类。但是,由于点的特征提取受到尺度的限制,因此对于环境多样化的室外场景,基于点的分类效果并不好。

基于分割的分类首先对点云数据进行分割,之后再判别每个分割块的类别。如Xiang等[36]根据法线信息对每个点构建邻接关系,并组成大的分割块,再利用支持向量机(SVM)判别来实现城市道路场景的点云分类。Aijazi等[37]将3D点体素化后合并成超体素,再根据设定的阈值对超体素进行划分进而完成点云分类。基于分割的分类相对计算速度较快,能提取更加丰富的特征信息。然而,该类算法对前期的初始化分割比较敏感。

这类基于机器学习的方法主要是通过大量样本训练有效的分类器,然而,有效的特征描述是这个分类模型的关键内容。用于点云描述的特征如4.2节所述,虽然目前提出了大量的特征描述方法,但是其表征能力有限,并不适用于所有的点云。目前点云分类常用的机器学习分类器主要有SVM[38],cascaded AdaBoost[39],random forest[40-41]等,但这些分类器的训练还是依赖于有效特征的选取。

表 4. 常用的点云特征描述方法及比较

Table 4. Common methods and comparison of point cloud feature descriptions

|

此外,室外场景彩色激光点云的数据量大、目标信息多样以及受环境干扰明显等特性增加了点云的分类难度。因此,面向室外场景彩色激光点云的分类仍需进行深入地研究。

计算能力的提高及张量数据理论的发展推动了深度学习在场景理解方面的广泛应用,对于点云理解的深度网络被不断地提出。目前,基于深度学习的点云理解,主要面临3个方面的挑战:1) 点云数据是分布在空间中的任意点(

目前,针对点云的深度学习网络主要分为3大类,即基于2D投影的深度学习网络、基于3D体素化的CNN和基于点云中单个点的网络模型。

1) 基于2D投影的深度学习网络

受深度学习在2D图像上取得较好的效果的启发,文献[ 42]和文献[ 43]将3D点云投影到2D图像后作为CNN的输入。常用的2D投影图像有基于虚拟相机的RGB图像、基于虚拟相机的深度图、基于传感器获取的距离图像和全景图像等映射图像。这些投影的方法通过利用2D图像中已经经过大量图像训练好的目标检测[43]与语义分割的网络模型作为预训练的模型进行微调,可以在2D图像上获取较好的检测与分类效果。常用的预训练模型主要有:VGG-16、Alexnet、Googlenet、FCN、U-NET等。

MVCNN[42]、Snapnet[44]和DeePr3SS[45]等方法采用多视角投影的方法进行点云的分类。目前,Snapnet和DeePr3SS的分类效果在Semantic 3D数据集的reduced-8上的Benchmark排名分别为第7和第9[46]。由此可知,这类方法还存在很多改进的空间。此外,这类方法容易造成3D结构信息的丢失,而且投影角度的选取和同一角度的投影对物体的表征能力也不同,对网络的泛化能力有一定的影响。

2) 基于3D体素化的CNN

为了保留更多的3D结构信息,研究人员在对2D CNN模型的基础上进行改进,通过对点云进行体素化等预处理操作,提出了基于3D CNN模型。最早的是由Maturana等[47]基于监督3D CNN和点云体素化提出的VoxNet网络模型;Gernot团队提出OctNet网络模型,通过非平衡八叉树和3D CNN,对点云进行了高分辨率体素表征,并且将表征后的结果在目标分类、点云标记等工作中进行了验证[48]。这类方法保留了大量的3D结构信息,但如文献[ 49]提出的基于3D CNN的大场景标注方法虽取得了不错的效果,但只考虑了单一的体素尺度。为了进一步提高体素的表征能力,相继地提出了多种多尺度体素的CNN方法,如Semantic 3D Net[8]、MS3_DVS[50]和MVSNet[51]。

体素化是这类方法的基础,目前体素化的方法通常有基于0-1表示是否有点的体素方法、基于体素网络密度的方法和基于网格点的方法[47]。现有的体素化的尺寸主要有11×11×11[51]、16×16×16[8]、20×20×20[49]和32×32×32[50]。此外,由于点云的数据量大,有研究人员采用降采样体素化的方法降低数据量[49],也有研究者通过体素化的方式将点云结构化,然后利用3D CNN、3D FCN等方法进行语义分割[52]。

基于3D体素化的CNN方法在Semantic 3D数据集上的Benchmark排名相对靠前。此外,这类方法通过网格化提供了点云结构,网格的转换解决了排列问题,同时也得到了数量不变的体素。然而3D CNN卷积时计算量非常大,通常会降低体素的分辨率,增加了量化的误差。此外,网络中仅利用了点云的结构信息,没有考虑到点云的颜色、强度等信息。

3) 基于点云中单个点的网络模型

为了充分利用点云的多模态信息,减少预处理过程中的计算复杂度,基于点云中单个点的网络模型逐渐被提出。如斯坦福大学Charles等[53]针对室内的点云场景提出了PointNet,对室内点云数据进行了分类、部分分割、语义分割3部分工作,而后,针对PointNet中局部特征信息进行了改进,推向多尺度,综合局部特征提出了PointNet++网络模型[53];Li等[54]在PointNet基础上进行改进,提出PointCNN,该方法通过对点云特性的分析,提出了一种基于点云中点学习到的X变换方法,然后将其用于同时加权与点关联的输入特征,并将它们重新排列成潜在隐含的规范顺序,之后再在元素上应用求积和求和运算。虽然所提算法能够对点云卷积处理的性能有所提高,但X变换方法还有较大的改进空间,尤其是在排序方面。

此外,最新的SO-net[55]的提出以及对PointNet改进提出的PointFlowNet[56]等网络模型均取得了较好的效果,但是对于大规模点云还具有一定的局限性,但这些网络为后续的大规模点云的语义分割提供了重要基础。

鉴于基于点的网络模型在点云分类上取得的较好效果,越来越多的研究对这类方法进行改进。由于原始的PointNet对于大规模点云具有局限性,有研究者预先对大规模点云进行分割或者分块处理,然后利用PointNet网络进行分类,如SPGraph[9],该方法在目前的Semantic 3D数据集的Semantic-8和reduced-8上的Benchmark均排名第一。

以上3类方法各有各的优缺点。此外,目前关于点云场景语义理解的方法大多是针对单体目标的识别、室内或者室外小场景的语义分割。针对室外大场景稠密激光点云的场景理解网络模型还有很多问题亟待解决。因此,对于室外复杂大场景的点云理解还有待进一步的研究。

5 结束语

面向真实场景的多通道高效表征和场景理解具有重要价值和现实意义。3D场景理解是真实3D地图、L5级自动驾驶以及机器智能等研究的关键。基于3D点云的语义分割与场景理解等智能感知方面因其数据丰富具有明显的优势,但是目前基于3D点云的场景理解效果还有众多内容有待去深入研究,尤其是针对彩色激光点云的场景理解。本文通过对现有3D点云数据获取及场景理解的关键技术进行分析总结,归纳出了以下仍需重点研究的几点:

1) 针对基于学习方法需要大量有标注的样本问题,海量3D数据,尤其是彩色激光点云数据,人工标注效率低,需要研究快速的、高精度的自动标注方法;此外,对于内容丰富的、有标签的室外点云场景理解数据集相对较少,构建一套作为Benchmark的数据库也十分重要。

2) 目前多数3D点云场景理解网络模型需要对点云进行大量预处理,如体素化等,增加了算法的复杂度。并且很多方法将3D信息投影到2D,再利用深度学习网络模型进行场景理解,丢失了部分3D信息。为了提高场景理解的效率,充分利用点云的3D信息,基于深度学习的端到端场景理解模型,即构建出由点到点标签的稳健性的网络模型是重要的研究方向。

3) 由于点云数据样本中各类目标的点数并不均衡,且室外大场景的点云较为复杂、差异大,例如街景场景中车辆、行人、建筑物等目标的个数不同,且各类目标中的点云的点数相差较大,从而导致在深度学习网络模型训练时存在样本不均衡问题,容易导致网络模型的识别结果偏向于样本较大的类别。因此,解决训练样本不均衡问题是重要的研究内容。

4) 目前获取的3D点云场景数据的精度和点云与颜色配准的效果还有待进一步提高。近年来,随着传感器的发展,3D点云数据获取装置的研究更注重其高精度、信息丰富性、高通过性、获取数据规模的广阔性以及装置的便携性等。

5) 目前基于3D点云数据的场景理解大多是对点云数据进行目标检测与语义分割,获取场景中的目标位置、种类和语义信息等内容,感知场景中感兴趣的内容,但对整个场景的理解还不够充分。除了端到端更加完善的目标检测、语义分割和场景分类的深度网络模型是关键的技术重点外,对场景中各个目标的拓扑关系、场景中目标的行为与分析等内容的理解也是场景理解需要突破的关键技术与发展方向。

[1] Kim BS, KohliP, SavareseS. 3D scene understanding by voxel-CRF[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 1425- 1432.

[2] Zhuang Y, He G J, Hu H S, et al. A novel outdoor scene-understanding framework for unmanned ground vehicles with 3D laser scanners[J]. Transactions of the Institute of Measurement and Control, 2015, 37(4): 435-445.

[3] 佟国峰, 杜宪策, 李勇, 等. 基于切片采样和质心距直方图特征的室外大场景三维点云分类[J]. 中国激光, 2018, 45(10): 1004001.

[4] 闫飞, 庄严, 王伟. 移动机器人基于多传感器信息融合的室外场景理解[J]. 控制理论与应用, 2011, 28(8): 1093-1098.

[5] IzadiS, KimD, HilligesO, et al. KinectFusion : real-time 3D reconstruction and interaction using a moving depth camera[C]∥Proceedings of the 24th Annual ACM Symposium on User Interface Software and Technology, October 16-19, 2011. Santa Barbara, California, USA. New York: ACM, 2011: 559- 568.

[6] 卢秀山, 俞家勇, 田茂义, 等. 车载激光点云与序列化全景影像融合方法[J]. 中国激光, 2018, 45(5): 0510004.

[7] BircherA, AlexisK, BurriM, et al. Structural inspection path planning via iterative viewpoint resampling with application to aerial robotics[C]∥IEEE International Conference on Robotics and Automation (ICRA), May 26-30, 2015, Seattle, WA, USA. New York: IEEE, 2015: 6423- 6430.

[9] LandrieuL, SimonovskyM. Large-scale point cloud semantic segmentation with superpoint graphs[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 19-21, 2018, Salt Lake City, Utah, USA. New York: IEEE, 2018: 4558- 4567.

[10] SilbermanN, HoiemD, KohliP, et al. Indoor segmentation and support inference from RGBD images[C]∥European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2012: 746- 760.

[11] Song SR, Lichtenberg SP, Xiao JX. SUN RGB-D: a RGB-D scene understanding benchmark suite[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 567- 576.

[12] 陈长军, 王刚, 关鸿亮. 基于激光扫描与全景影像的车载测量集成系统: CN202782968U[P].2013-03-13.

Chen CJ, WangG, Guan H L. Vehicle-mounted measure integrated system based on laser scanning and panorama images:CN202782968U[P]. 2013-03-13.

[13] Felix R. Method of generating panorama views on a mobile mapping system: EP20140156863[P].2015-09-02.

[15] Sydney urban objectsdataset[EB/OL] ( 2013-11-04)[2018-07-18] http:∥www. acfr.usyd.edu.au/papers/SydneyUrbanObjectsDataset.shtml.

[16] WuZ, SongS, KhoslaA, et al. 3D shapeNets: A deep representation for volumetric shapes[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1912- 1920.

[17] Johnson AE. Spin-images: a representation for 3-D surface matching[D]. Pennsylvania: Carnegie Mellon University, 1997.

[18] FromeA, HuberD, KolluriR, et al. Recognizing objects in range data using regional point descriptors[C]∥European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2004: 224- 237.

[19] Rusu RB, BlodowN, Marton ZC, et al. Aligning point cloud views using persistent feature histograms[C]∥IEEE/RSJ International Conference on Intelligent Robots and Systems, September 22-26, 2008, Nice, France. New York: IEEE, 2008: 3384- 3391.

[21] WohlkingerW, VinczeM. Ensemble of shape functions for 3D object classification[C]∥IEEE International Conference on Robotics and Biomimetics, December 7-11, 2011, Karon Beach, Phuket, Thailand. New York: IEEE, 2011: 2987- 2992.

[22] Rusu RB, BradskiG, ThibauxR, et al. Fast 3D recognition and pose using the viewpoint feature histogram[C]∥IEEE/RSJ International Conference on Intelligent Robots and Systems, October 18-22, 2010, Taipei, Taiwan, China. New York: IEEE, 2010: 2155- 2162.

[23] Rusu RB, BlodowN, BeetzM. Fast point feature histograms (FPFH) for 3D registration[C]∥IEEE International Conference on Robotics and Automation, May 12-17, 2009, Kobe, Japan, New York: IEEE, 2009: 3212- 3217.

[24] Sappa AD, DevyM. Fast range image segmentation by an edge detection strategy[C]∥Proceedings Third International Conference on 3-D Digital Imaging and Modeling, May 28-June 1, 2001, Quebec City, Quebec, Canada. New York: IEEE, 2001: 292- 299.

[25] 柯映林, 单东日. 基于边特征的点云数据区域分割[J]. 浙江大学学报(工学版), 2005, 39(3): 377-380.

[26] PaponJ, AbramovA, SchoelerM, et al. Voxel cloud connectivity segmentation-supervoxels for point clouds[C]∥IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2027- 2034.

[28] 杨泽鑫, 程效军, 李泉, 等. 平面舱壁类型的船舱点云分割方法[J]. 中国激光, 2017, 44(10): 1010006.

[29] Wang YM, Shi HB. A segmentation method for point cloud based on local sample and statistic inference[M] ∥Bian F L, Xie Y C. eds. Geo-Informatics in Resource Management and Sustainable Ecosystem. Berlin, Heidelberg: Springer, 2015: 274- 282.

[30] Green WR, GroblerH. Normal distribution transform graph-based point cloud segmentation[C]∥Pattern Recognition Association of South Africa and Robotics and Mechatronics International Conference, November 26-27, 2015, Port Elizabeth, South Africa. New York: IEEE, 2015: 54- 59.

[32] 程效军, 程小龙, 胡敏捷, 等. 融合航空影像和LIDAR点云的建筑物探测及轮廓提取[J]. 中国激光, 2016, 43(5): 0514002.

[33] WolfD, PranklJ, VinczeM. Fast semantic segmentation of 3D point clouds using a dense CRF with learned parameters[C]∥IEEE International Conference on Robotics and Automation (ICRA), May 26-30, 2015, Seattle, WA, USA. New York: IEEE, 2015: 4867- 4873.

[36] Xiang BB, YaoJ, Lu XH, et al. Segmentation-based classification for 3D urban point clouds[C]∥IEEE International Conference on Information and Automation (ICIA), August 1-3, 2016, Ningbo, China. New York: IEEE, 2016: 172- 177.

[37] Aijazi A K, Checchin P, Trassoudaine L. Segmentation based classification of 3D urban point clouds: a super-voxel based approach with evaluation[J]. Remote Sensing, 2013, 5(4): 1624-1650.

[39] Lodha SK, Fitzpatrick DM, Helmbold DP. Aerial lidar data classification using AdaBoost[C]∥Sixth International Conference on 3-D Digital Imaging and Modeling (3DIM 2007), August 21-23, 2007, Montreal, QC, Canada. New York: IEEE, 2007: 435- 442.

[41] NiemeyerJ, RottensteinerF, SoergelU. Classification of urban LiDAR data using conditional random field and random forests[C]∥Joint Urban Remote Sensing Event 2013, April 21-23, 2013, Sao Paulo, Brazil. New York: IEEE, 2013: 139- 142.

[42] SuH, MajiS, KalogerakisE, et al. Multi-view convolutional neural networks for 3D shape recognition[C]∥IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 945- 953.

[43] Qi CR, SuH, NießnerM, et al. Volumetric and multi-view CNNs for object classification on 3D data[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30,2016, Las Vegas, NV, USA. New York: IEEE, 2016: 5648- 5656.

[44] Boulch A. Guerry J, le Saux B, et al. SnapNet: 3D point cloud semantic labeling with 2D deep segmentation networks[J]. Computers & Graphics, 2018, 71: 189-198.

[45] Lawin FJ, DanelljanM, TostebergP, et al. Deep projective 3D semantic segmentation[C]∥International Conference on Computer Analysis of Images and Patterns. Cham: Springer, 2017: 95- 107.

[46] HackelT, SavinovN, LadickyL, et al. SEMANTIC3D.NET: a new large-scale point cloud classification benchmark[M/OL]. ISPRS annals of the photogrammetry, remotesensing and spatial informationsciences. 2017, IV-1-W1: 91-98. [2018-07-20]. http:∥www.semantic3d.net/view_results.php?chl=2.

[47] MaturanaD and SebastianS. VoxNet: a 3D convolutional neural network for real-time object recognition[C]∥IEEE/RSJ International Conference on Intelligent Robots and Systems, Congress Center Hamburg, September 28-October 2, 2015, Hamburg, Germany. New York: IEEE, 2015: 922- 928.

[48] RieglerG, Ulusoy AO, GeigerA. OctNet: learning deep 3D representations at high resolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017, 3: 6620- 6629.

[49] HuangJ, You SY. Point cloud labeling using 3D convolutional neural network[C]∥23rd International Conference on Pattern Recognition (ICPR), December 4-8, 2016, Cancun, Mexico. New York: IEEE, 2016: 2670- 2675.

[50] RoynardX, Deschaud JE, François G. Classification of point cloud scenes with multiscale voxel deep network[EB/OL]. ( 2018-04-10)[2018-07-18]. https:∥arxiv.org/abs/1804. 03583.

[52] TchapmiL, ChoyC, ArmeniI, et al. SEGCloud: semantic segmentation of 3D point clouds[C]∥International Conference on 3D Vision (3DV), October 10-12, 2017, Qingdao, China. New York: IEEE, 2017: 537- 547.

[53] Charles RQ, SuH, Mo KC, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 77- 85.

[54] Li YY, BuR, Sun MC, et al. PointCNN: convolution on χ-transformed points[EB/OL]. ( 2018-11-05)[2018-07-15]. https:∥arxiv.org/abs/1801. 07791

[55] LiJ, Chen BM, Lee GH. SO-net: self-organizing network for point cloud analysis[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 18-23, 2018. Salt Lake City, UT, USA. New York: IEEE, 2018: 9397- 9406.

[56] BehlA, PaschalidouD, DonnéS, et al. PointFlowNet: learning representations for 3D scene flow estimation from point clouds[EB/OL].( 2018-06-06)[2018-07-18]. https:∥arxiv.org/abs/1806. 02170.

李勇, 佟国峰, 杨景超, 张立强, 彭浩, 高华帅. 三维点云场景数据获取及其场景理解关键技术综述[J]. 激光与光电子学进展, 2019, 56(4): 040002. Yong Li, Guofeng Tong, Jingchao Yang, Liqiang Zhang, Hao Peng, Huashuai Gao. 3D Point Cloud Scene Data Acquisition and Its Key Technologies for Scene Understanding[J]. Laser & Optoelectronics Progress, 2019, 56(4): 040002.