自适应特征融合与抗遮挡的相关滤波跟踪算法  下载: 728次

下载: 728次

1 引言

视觉目标跟踪在计算机视觉领域中一直获得极大的关注度,由于实际跟踪问题受到各种因素的影响,如目标遮挡、快速移动、形变和光照变化等,因此解决这些影响具有很大挑战[1]。

近年来,基于相关滤波的跟踪算法在跟踪结果和处理速度上取得了优异的表现,因此得到广泛的关注和研究。2010年,Bolme等[2]提出了最小输出平方误差(MOSSE)算法,仅通过灰度特征便能实现不错的跟踪结果,更重要的是达到669 frame/s的处理速度。2012年,Henriques等[3]通过引入核矩阵提出了基于循环结构的核检测跟踪(CSK)算法,利用循环密集采样法对样本进行采样,解决相关滤波器中样本不足的问题。2015年,Henriques等[4]在核相关滤波器快速跟踪(KCF)算法中,提出了多通道特征模型,并采用方向梯度直方图(HOG)特征[5]代替灰度特征,同时利用循环矩阵傅里叶空间对角化简化计算过程。

为了解决目标跟踪中的尺度估计问题,Danelljan等[6]在KCF的基础上引入尺度估计,提出了判别式尺度空间跟踪(DSST)算法,并单独训练用于目标位置估计的滤波器和用于目标尺度估计的滤波器。在此之后,Danelljan等[7]提出了快速判别式尺度空间跟踪(fDSST)算法,通过主成分分析提取目标特征中的主要部分,将特征维度压缩至18维,既提高了DSST算法的运行速度,又提升了跟踪性能。何雪东等[8]通过三个不同大小的尺度因子来确定尺度的变化趋势,进而求解最优尺度。

为了解决循环密集采样法存在的边界效应问题,Danelljan等[9]提出了空间正则化相关滤波跟踪(SRDCF)算法。在其基础上,训练集优化的空间正则化相关滤波跟踪(SRDCFdecon)算法[10]是解决因跟踪过程中目标出现遮挡或偏离中心的跟踪结果,导致正样本集被背景图像污染的问题,将样本质量引入最小化问题中,以此动态调节训练样本权重,进一步提高跟踪器性能。Galoogahi等[11]提出了边界约束相关滤波器(CFLB)算法,在该算法中通过隐式的方式在滤波器的右方和下方进行零填充,使滤波器的尺度与用于训练的图像块的大尺度保持相同,以便直接进行互相关运算。但CFLB算法中这种非对称的填充方式,只能在一定程度上解决边界效应问题。Lukežic等[12]在基于通道和空间置信度的判别式相关滤波(CSR-DCF)算法中,通过提出的空间置信度计算每一帧图像的可靠性区域,使得滤波器能够作用于适合跟踪的图像区域,减少背景信息的干扰,并通过通道置信度评估方法可更准确地跟踪目标。

在特征改进方面,Danelljan等[13-14]通过引入Color Names(CN)特征提出了CN算法,运用主成分分析技术自适应将11维的颜色特征降至2维,提高了特征的光照不变性,也保证了运算速度,在彩色测试序列中得到较好的跟踪结果。在基于特征互补的目标跟踪Staple算法[15]中采用线性加权的方式,将HOG特征模型与颜色直方图模型的响应结果进行融合。虽然融合模型有效提高了算法的鲁棒性,但由于算法中使用了固定的权重比例,在许多实际问题中无法得到很好的跟踪结果。文献[ 16]通过分段函数自适应调节融合权重。文献[ 17]使用平均峰值相关能量(APCE)[18]指标衡量跟踪过程中响应结果的可靠性,并以此来自适应调节HOG模型与局部二值模式(LBP)特征模型的融合权重。

此外,针对目标遮挡问题,文献[ 19]采用经典的峰值旁瓣比(PSR)衡量目标跟踪置信度,当置信度较低时暂停更新模型,避免引入背景信息。文献[ 20]引入阶段式模型更新恢复机制以解决模型污染问题。文献[ 21]通过可靠性投票选择最好的跟踪结果来更新模型。

为了解决固定权重融合方式在特定环境下缺乏针对性的问题,本文在Staple算法的基础上,提出了一种自适应特征融合与通道加权的解决方案,同时引入通道置信度评估方法,提出了一种相关滤波跟踪算法。与此同时,在跟踪过程中,通过置信度指标判断目标遮挡情况,选择合适的模型更新策略来解决目标跟踪过程中出现的目标遮挡问题。在OTB测试数据集[22-23]上进行多组实验,验证所提算法的普适性和有效性。

2 自适应特征融合跟踪算法

2.1 标准相关滤波器

近几年,多通道相关滤波器在视觉跟踪领域中非常流行,以下将介绍这些滤波器的主要思想。给定一个通道数为N的图像特征f={fd}和与之对应的滤波模板h={hd},其中d的取值范围是{1,2,…,N}。第d个通道上的特征fd和与之对应的滤波器hd的大小均为W×H,W和H分别表示训练区域的宽和高。目标位置被估计为相关滤波响应g的最大值位置,即在图像中对应的位置。滤波响应的表达式为

式中:*为fd和hd的循环相关。通过最小化损失函数

求解最优相关滤波器h。式中:gGaussian为期望输出,通常是以目标位置为中心的二维高斯函数,gGaussian的大小为W×H;λ为正则化参数,可减轻过拟合现象;‖·‖2为L2范数的平方。通过在傅里叶域中求解ε(h)来提高计算效率。(2)式在傅里叶域中的向量形式为

式中:

式中:Ø为元素点除操作;E为(W×H)×1的大小、且元素值全为1的列向量;

每个通道上特征的表示能力不同,则不应该对其同等看待,为此引入通道权重w={wd},即通道置信度权重,用于衡量每个通道特征表示目标的能力。w在目标定位阶段,计算相关滤波响应时使用w,表达式为

式中:wd为第d个通道上特征的权重。

2.2 Staple算法

Staple算法将使用HOG特征的DSST[7]算法和颜色直方图特征的DAT(Distractor-Aware Tracker)[24]算法的两个响应结果通过固定的权重系数进行融合。HOG特征能较好地捕捉目标的局部形状信息,对运动模糊和光照变化具有良好的不变性。颜色直方图特征包含的空间信息较少,因此能够适应目标的形状变化,这也使得Staple算法具有这两者的优点。

在实际跟踪问题中,存在光照变化、形变和运动模糊等诸多因素,Staple算法中两个跟踪模型固定权重系数的融合方式无法较好地解决实际问题,因此提出一种自适应融合方案通过衡量两个模型在跟踪过程中的表现来决定融合权重的大小。由于跟踪过程中每个通道特征的表现情况不同,为此引入通道置信度来反映各个通道上的特征和滤波器表现的优劣。

2.3 通道置信度评估

目标跟踪过程一般分为训练阶段和检测阶段,为此设置了通道学习置信度wd, lea和通道检测置信度wd, det。定义第d个通道上特征的权重wd为wd, lea与wd, det的乘积,用于表示第d个通道上特征的重要程度,表达式为

1)通道学习置信度。通道学习置信度可反映当前位置的估计滤波器所能检测出目标的最大可能性,通道学习置信度越高,说明该通道的可靠性越高。wd, lea直接由当前通道的最大响应值确定,即wd, lea=ζ max(gd),gd为第d个通道上特征fd与hd的响应结果,计算公式为gd=fd*hd,ζ为归一化参数,保证各通道学习置信度总和为1,即

2)通道检测置信度。通道检测置信度可反映每个通道上的位置估计滤波器与候选区域的响应结果的可靠性。衡量标准为次峰值gd, max2(旁瓣峰强度)和主峰值gd, max之比,即ρ=gd, max2/gd, max,两者比值越小,说明响应图像越干净,跟踪效果越好,可靠性越高。

响应图像中响应值越大的位置为目标中心的可靠性越高,因此当多个与目标相似的对象出现时,响应图像中会出现多个响应峰,这种情况ρ值会增大。若ρ值越接近于1,跟踪结果的可靠性越低,但此时最大响应峰值可能已经确定了目标中心的位置。背景杂乱的情况,上述情况常常发生。为了防止对上述情况进行过于严重的惩罚,ρ的最大值被限制为0.5,即wd, det的最小值为0.5。检测置信度表达式为

2.4 自适应融合方案

所提算法使用HOG特征和颜色直方图特征用于跟踪过程中的目标描述。目前大多数算法均采用全局颜色特征与局部空间特征融合的方式来提高跟踪算法的鲁棒性。由于两种特征表达方式和含义不同,直接对特征进行融合,效果往往不佳,因此可对两个模型与目标候选区域的响应结果进行融合。

响应图像中响应值越大的位置为目标中心的概率越大,所以使用两个模型响应结果的最大值来衡量模型所占权重,求解步骤如下。

1)初始化颜色直方图模型和HOG特征模型的权重,分别为whist=0.3和wtemp=0.7。目标定位阶段,根据当前帧图像的颜色直方图模型和HOG特征模型的响应结果,即ghist和gtemp,求解当前帧图像颜色直方图模型的权重whist_new,求解公式为

2)更新阶段使用线性内插法,对第t帧模型的权重进行更新,表达式为

式中:ηhist为颜色直方图模型的学习率;wt-1, hist为第t-1帧颜色直方图模型的权重。

3) HOG特征强大的表现能力在许多跟踪算法中已得到检验,由于颜色直方图特征包含的信息有限,实验将其作为辅助模型使用。为了保证HOG特征模型的主要作用,对第t帧图像颜色直方图特征的权重wt, hist进行处理,当wt, hist大于0.4时,取wt, hist=0.4;当wt, hist小于或等于0.4时,保持不变,表达式为

计算最终HOG特征的权重wt, temp,表达式为

4)第t帧图像的最终响应融合结果为

2.5 模型的抗遮挡方案

2.5.1 遮挡检测机制

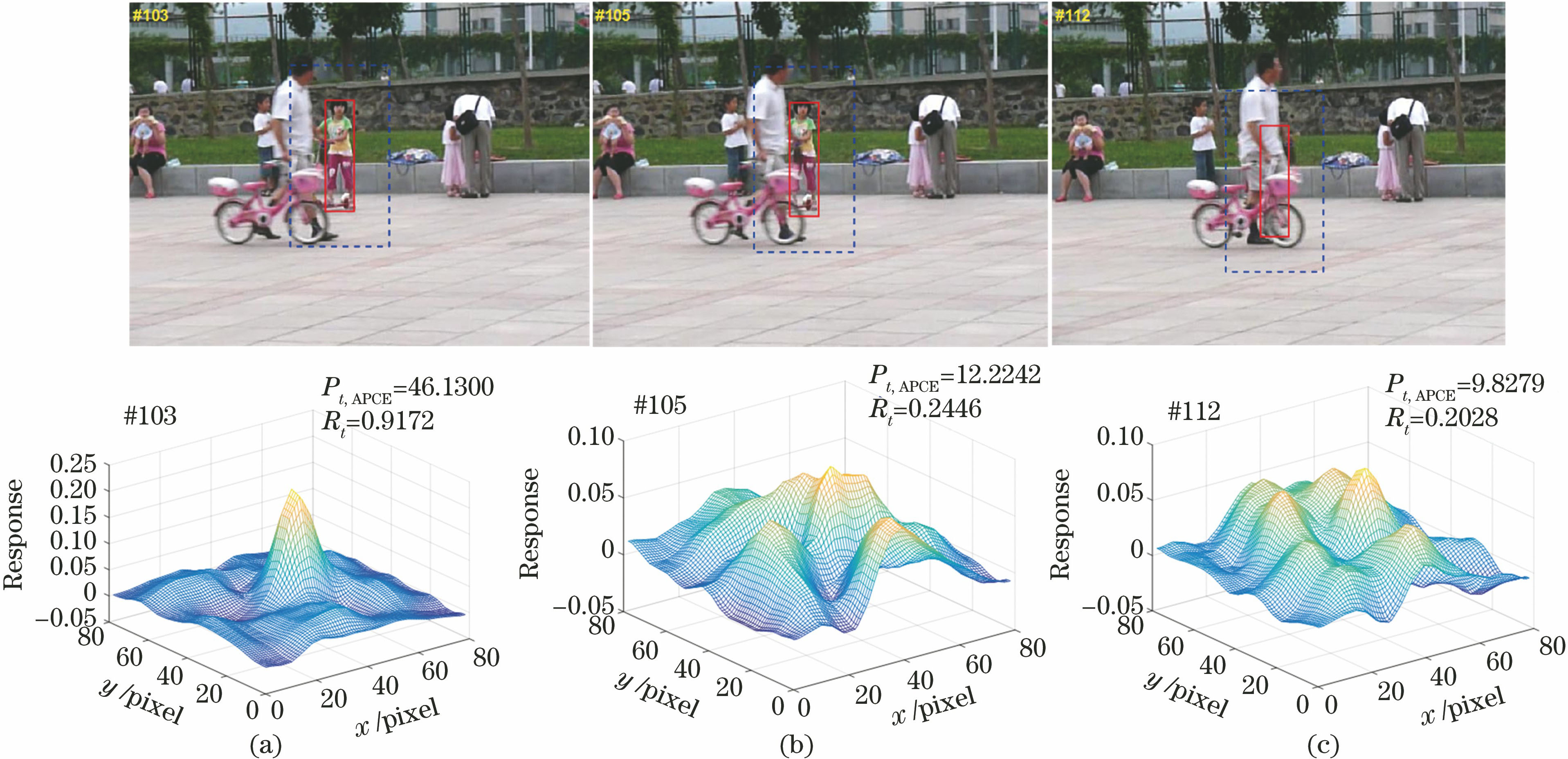

以往跟踪算法大多使用固定的学习率逐帧更新模型,当目标发生遮挡和背景变化时,使用非目标的背景信息更新模型会导致模型的鲁棒性变差。固定的学习率在模型更新时,无法根据跟踪结果实时作出调整,当跟踪结果的置信度较低时,采用过大的学习率会降低模型的判别能力;当跟踪结果的置信度较高时,应增大学习率来提高训练样本的利用率。同时,采用逐帧更新的方式会累积跟踪漂移所引入的误差,最终可能导致跟踪失败。针对上述问题,LMCF(Large Margin Object Tracking with Circulant Feature Maps)算法[18]采用多峰检测的方法来检测目标周围是否存在相似物,并判断目标是否被遮挡。此外,当目标发生姿态变化和旋转时,也会使得滤波响应出现多峰情况。仅通过响应峰值gmax来判断跟踪质量的好坏不可靠,因此通过平均峰值相关能量(APCE)进行具体的衡量,APCE可反映响应结果的波动程度,同时APCE值越大跟踪结果越稳定。当APCE值突然降低时,目标可能被遮挡或丢失。大小为M×N的检测区域内模型响应结果的APCE,可表示为

式中:gmin为响应结果的最小值;g(m,n)为在(m,n)处的响应结果。APCE仅使用当前帧的跟踪信息,未考虑连续帧图像中目标间的关系,当目标被遮挡时,连续帧图像中跟踪结果的APCE值会发生突变。仅根据APCE来判断跟踪过程中目标是否被遮挡的能力有限,因此在此基础上引入历史帧的APCE信息,来判断目标的遮挡情况,计算方法为

式中:Pi, APCE为第i帧响应结果的APCE值;Rt为第t帧跟踪结果的相对置信度。

Girl2视频序列中不同帧的跟踪置信度对比如

图 1. 不同遮挡情况下Girl2视频序列部分帧的跟踪置信度对比结果。(a)未被遮挡;(b)部分遮挡;(c)完全遮挡

Fig. 1. Comparison results of tracking confidence of partial frames of Girl2 video sequence under different occlusions. (a) Not occlusion; (b) slight occlusion; (c) severe occlusion

此外,鉴于均方误差(MSE)在其他图像领域中的杰出表现,将MSE引入模型更新方案中,利用MSE衡量两帧图像间的差异性。当目标被遮挡或快速移动时,MSE值会增大;当目标移动或形变不明显时,MSE值几乎不变。检测区域大小为M×N的当前帧图像It与前一帧图像It-1的MSE为

2.5.2 更新方案

目标跟踪过程中,置信度较低的跟踪结果会造成误差累计,导致模型判别能力变差。当目标出现时,依然可能出现跟踪漂移或失败的问题。针对目标遮挡问题,先对模型的ηtemp进行调整。由于相邻两帧图像的Mt, MSE可在一定程度上反映两帧中目标的变化程度,当目标几乎不变时,Mt, MSE值较小;当目标变化明显时,Mt, MSE值较大。因此作出以下调整,当Mt, MSE值小于最小更新阈值Tdown时,ηtemp=0.010;当Mt, MSE值大于最大更新阈值Tup时,ηtemp=0.025;除此之外,ηtemp=0.020。调整模型的学习率,即

所提算法通过跟踪Rt、gmax和Mt, MSE综合判断目标遮挡情况。当目标未发生遮挡时,采用线性插值的方法对模型进行正常更新,如(9)式,以适应目标的外观变化;当发生轻微遮挡时,以较低的学习率来更新模型,依然能够学习到目标的外观信息。并且采用轻微遮挡的目标作为样本来训练模型,能够增加训练样本的多样性;当发生严重遮挡时,停止更新模型以减少背景信息的引入,保证模型的判别能力。当目标再次出现时,未被背景信息污染的模型与检测区域的响应值变大,此时能够再次检测到目标,实现跟踪的恢复。更新策略如

表 1. 模型更新策略

Table 1. Model update strategy

|

2.6 算法框架

所提跟踪算法框架如

训练阶段:在第t帧图像Xt的目标估计位置pt处,提取固定窗口大小的图像块作为训练样本以提取HOG特征,加上同等大小余弦窗口以减少边缘效应。更新HOG特征跟踪模型ht,计算各个通道学习置信度,并与第t-1帧求得的通道检测置信度相乘得到当前帧的通道置信度w={wd};在pt处提取目标和背景的颜色直方图ρt(B),ρt(O),ρt={ρt(B),ρt(O)},更新颜色直方图特征跟踪模型βt。

跟踪阶段:在第t+1帧图像Xt+1的目标估计位置pt处,提取固定窗口大小的图像块,并进行循环移位后作为候选目标区域。提取候选目标区域的HOG特征并加上余弦窗,以减少边缘效应的影响。在各个通道上提取到的HOG特征与跟踪模型ht进行相关操作得到响应图,通过通道置信度w进行加权求和得到HOG特征响应图gt, temp。在目标估计位置pt处,提取目标和背景的颜色直方图ρt(B),ρt(O),用于计算颜色直方图模型响应图gt, hist;计算两个模型的融合权重,进行加权求和后得到最终响应图gt。根据各通道的响应结果,计算通道检测置信度。由最终响应峰值得到当前帧图像中目标估计位置pt+1,至此确定目标在第t+1帧的位置信息。

尺度估计:作为独立的相关滤波器,尺度滤波器的训练、预测过程与使用HOG特征的位置滤波器训练、预测过程基本相似。要注意的是尺度滤波器包含33个详细尺度,并从中预测目标的实际尺度。

3 实验及结果分析

实验使用MATLAB来实现目标跟踪算法,在2.8 GHz i7-7700HQ CPU和16 GB RAM配置的计算机上完成。实验保持传统Staple算法中部分参数不变,HOG特征的像素块大小(cell_size)为4 pixel×4 pixel,梯度方向个数为9,初始学习率ηtemp=0.020,滤波器输出标准差为0.0625。颜色直方图的组数bin为25,学习率ηhist=0.038。正则化参数λ=0.001,初始化融合因子为0.3。尺度估计中,尺度因子个数为33,步长为1.02,最大尺度为(32×16) pixel,尺度滤波器输出标准差为0.25,学习率ηscale=0.025。

为了测试所提算法的性能,设置4组实验:实验1测试固定融合权重系数对于跟踪结果的影响;实验2测试所提算法各部件间的性能;实验3是所提算法与当前主流跟踪算法在OTB-2013数据集和OTB-100数据集上的对比;实验4是所提算法在OTB数据集中具有代表性的视频序列上的具体跟踪结果。

3.1 实验测试数据集和评估方法介绍

实验采用OTB-2013[22]和OTB-100[23]两个数据集,其中OTB-2013由51个完全标注的视频序列组成,涉及11种不同的挑战因素,如形变(DEF)、快速运动(FM)、光照变化(IV)、尺度变化(SV)、遮挡(OCC)、运动模糊(MB)、平面外旋转(OPR)、平面内旋转(IPR)、背景混乱(BC)、超出视野(OV)和低分辨率(LR),OTB-100由100个属性更加复杂、跟踪难度更大的视频序列组成。OTB测试集有三种评估鲁棒性的方式,分别为:一次鲁棒性评估(OPE),即以第一帧中目标的真实位置作为初始位置,测试整个视频序列;时间鲁棒性评估(TRE)是选择视频序列的部分连续帧作为测试序列,以首帧中目标的真实位置作为初始位置;空间鲁棒性评估(SRE)通过对首帧中目标的真实位置进行移动、旋转或缩放,得到不同初始位置的跟踪目标,用来测量跟踪算法的鲁棒性,包括4个中心位置移位、4个角度旋转和4个尺度变化。

实验中采用平均中心定位误差(CLE),距离精度(DP)和重叠精度(OP)作为评价指标。

1) CLE是在K个测试序列图像上,计算目标跟踪区域的中心位置P'i与手工标注的目标真实区域的中心位置Pi,两者间的平均欧氏距离用来反映算法的跟踪准确度,表达式为

2) DP是CLE小于给定阈值的帧数占跟踪总帧数的百分比,一般取阈值为20 pixel。

3) OP定义为

式中:St为目标跟踪窗口区域;Sg为目标真实窗口区域。若OOP值小于阈值记为跟踪失败,反之跟踪成功。OP为跟踪成功的帧数占总帧数的百分比,取阈值为0.5。

3.2 不同融合权重对跟踪结果的影响

以Bird1、Bird2、Board和Coke测试序列为例,对不同融合权重的跟踪情况进行分析。

当whist=0时,此时颜色直方图特征不会对跟踪结果产生影响,融合特征模型的跟踪性能只与HOG特征有关;当whist=1时,此时只有颜色直方图特征决定融合特征模型的跟踪性能。从

从4个测试序列的实验结果可以看到,不同大小的whist对DP和OP影响较大,CLE在HOG特征模型比重变小时,基本呈现增大趋势。

图 3. 固定融合因子对于跟踪结果的影响。(a) Bird1的精度图;(b) Bird1的CLE图;(c) Bird2的精度图;(d) Bird2的CLE图;(e) Board的精度图;(f) Board的CLE图;(g) Coke的精度图;(h) Coke的CLE图

Fig. 3. Effect of fixed fusion factor on tracking. (a) Precision plot of Bird1; (b) CLE plot of Bird1; (c) precision plot of Bird2; (d) CLE plot of Bird2; (e) precision plot of Board; (f) CLE plot of Board; (g) precision plot of Coke; (h) CLE plot of Coke

图 4. Twinnings序列采用不同融合权重系数的跟踪结果。(a) whist=0时,第195 frame的跟踪结果;(b) whist=0时,第250 frame的跟踪结果;(c) whist=0.1时,第195 frame的跟踪结果;(d) whist=0.1时,第250 frame的跟踪结果;(e) whist=0.3时,第195 frame的跟踪结果;(f) whist=0.3时,第250 frame的跟踪结果

Fig. 4. Tracking results of Twinnings sequence with different fusion weights coefficients. (a) Tracking results of 195 frame with whist=0; (b) tracking results of 250 frame with whist=0; (c) tracking results of 195 frame with whist=0.1; (d) tracking results of 250 frame with whist=0.1; (e) tracking results of 195 frame with whist=0.3; (f) tracking results of 250 frame with whist=0.3

由于视频序列在不同帧图像中也存在光照变化、目标遮挡和形变等影响因素,所以对Twinnings序列具体帧的跟踪情况进行分析。

从whist值为0, 0.1和0.3的跟踪结果可以看到,在第195 fame融合模型的表现比单纯使用HOG特征模型更好;第250 frame,whist值为0.3时的跟踪结果比当whist值为0.1和0时更好。此时,被跟踪目标发生旋转,则目标的空间信息发生变化,而颜色直方图特征变化较小,故此时颜色直方图模型表现较好,增大whist值会使跟踪结果更稳定。从两种情况下的目标高斯响应图变化也可反映跟踪模型的鲁棒性变化。当whist=0.1时,目标高斯响应图呈现多峰情况,且主峰与次峰高度差较小;当whist=0.3时,目标高斯响应图中主峰明显,也说明此时跟踪结果更好。

从

3.3 所提算法各部件间的性能

为了证明各部件的性能,设置了4个跟踪算法的实验对象,包括原始Staple算法,在Staple算法的基础上引入通道置信度的改进算法Staple_CR,含自适应融合方案的Staple改进算法Staple_AM和含遮挡检测更新策略的Staple改进算法Staple_Update。其中包含的部件间参数保持一致,在OTB-2013数据集和OTB-100数据集上进行实验测试,结果如

表 2. 实验2中跟踪模型的设置及各模型在OTB上的OPE测试结果

Table 2. Setting of tracking model in experiment 2 and OPE test results of each model on OTB

| ||||||||||||||||||||||||||||||||||||||||||||

从

3.4 所提算法与当前主流算法的对比实验

实验3将所提算法与KCF[5]、DSST[6]、SRDCF[9]、Staple[15]、基于特征融合的尺度自适应核相关滤波跟踪(SAMF)[25]、基于分层卷积的视觉跟踪(CF2)[26]、背景感知相关滤波(BACF)[27]、基于连续卷积运算的视觉跟踪(CCOT)[28]和一种高效卷积运算的视觉跟踪(ECO-HC)[29]当前9种主流跟踪算法分别在OTB-2013和OTB-100测试集上进行测试,最终跟踪结果如

图 5. 实验3在OTB-2013数据集上的测试结果。(a) OPE精确度图;(b)成功率图

Fig. 5. Test results of experiment 3 on OTB-2013 dataset. (a) OPE precision plot; (b) success rate plot

图 6. 实验3在OTB-100上数据集的测试结果。(a) OPE精确度图;(b)成功率图

Fig. 6. Test results of experiment 3 on OTB-100 dataset. (a) OPE precision plot; (b) success rate plot

精确度图中横坐标为定位误差阈值,纵坐标为平均CLE在该阈值范围内的帧数占总帧数的百分比。成功率图中横坐标为重叠率阈值,纵坐标为在对应阈值下跟踪成功帧数占总帧数的百分比。这里绘制的成功率图有两种方式,一种是根据OP阈值对应的成功率直接绘制成功率图,另一种是通过第一种方式绘制出的成功率曲线的曲线下面积(AUC)绘制的成功率图。

从

表 3. 7种算法在OTB-2013数据集中11个具有挑战性的属性上的表现

Table 3. Performance of seven algorithms on 11 challenging attributes in OTB-2013 datasetunit: %

|

3.5 在OTB部分测试序列上跟踪结果的比较

表 4. 11种算法在OTB-2013和OTB-100测试集上的运行速度对比

Table 4. Comparison of running speed of 11 algorithms on OTB-2013 and OTB-100 test datasets

| ||||||||||||||||||||||||||||||||||||||

从

从

从

从

从

图 7. 所提算法与其他4种算法在不同视频序列上的跟踪结果对比。(a) Joggong-2;(b) Coke;(c) Matrix;(d) Football1;(e) Freeman4

Fig. 7. Comparison of tracking results of proposed algorithm with other 4 algorithms on different video sequences. (a) Joggong-2; (b) Coke; (c) Matrix; (d) Football1; (e) Freeman4

4 结论

在原始视觉目标跟踪Staple算法的基础上,对其作出三点改进,提出了新的自适应特征融合算法。先将通道置信度引入传统Staple算法中,根据每帧中学习所得模型与目标候选区域在各个通道上响应度的最大值,来确定通道的可靠性和该通道权重,提高了模型当面对不同复杂环境时的鲁棒性;再使用响应峰值确定HOG特征模型和颜色直方图特征模型与目标候选区域响应结果的融合权重,最大程度地利用特征中包含的信息,同时减少背景信息干扰;最后,使用模型历史帧跟踪结果的APCE信息及当前帧图像的MSE信息,来判断目标的遮挡情况,选择合适的模型更新策略,减少由于背景信息的引入引起误差累计问题。实验结果表明:与主流算法相比,所提算法在各种复杂情况下,可提高跟踪结果的成功率和准确率,同时在目标遮挡问题上表现较佳。后续工作将会结合空间约束滤波器来扩大搜索区域,进一步解决目标遮挡和快速移动的问题。

[1] 卢湖川, 李佩霞, 王栋. 目标跟踪算法综述[J]. 模式识别与人工智能, 2018, 31(1): 61-76.

Lu H C, Li P X, Wang D. Visual object tracking: a survey[J]. Pattern Recognition and Artificial Intelligence, 2018, 31(1): 61-76.

[2] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[3] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Heidelberg: Springer, 2012, 7575: 702- 715.

[4] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[5] O'Rourke S M. Herskowitz I, O'Shea E K. Yeast go the whole HOG for the hyperosmotic response[J]. Trends in Genetics, 2002, 18(8): 405-412.

[6] DanelljanM, HagerG, Khan FS, et al. Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Conference 2014, September 1-5, 2014, Jubilee Campus. Berlin: Springer, 2014: 1- 11.

[7] Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[8] 何雪东, 周盛宗. 快速尺度自适应核相关滤波目标跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121501.

[9] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 4310- 4318.

[10] DanelljanM, HägerG, Khan FS, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1430- 1438.

[11] Galoogahi HK, SimT, LuceyS. Correlation filters with limited boundaries[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 4630- 4638.

[12] LukežicA, VojírT, Zajc LC, et al. Discriminative correlation filter with channel and spatial reliability[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4847- 4856.

[13] van de Weijer J, Schmid C, Verbeek J, et al. Learning color names for real-world applications[J]. IEEE Transactions on Image Processing, 2009, 18(7): 1512-1523.

[14] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

[15] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[16] 董秋杰, 何雪东, 葛海燕, 等. 基于概率模型的自适应融合互补学习跟踪算法[J]. 激光与光电子学进展, 2019, 56(16): 161505.

[17] 刘晓悦, 王云明, 马伟宁. 融合FHOG和LBP特征的尺度自适应相关滤波跟踪算法[J]. 激光与光电子学进展, 2020, 57(4): 041512.

[18] Wang MM, LiuY, Huang ZY. Large margin object tracking with circulant feature maps[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4800- 4808.

[19] 成悦, 李建增, 褚丽娜, 等. 基于模型与尺度更新的相关滤波跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121015.

[20] 崔洲涓, 安军社, 崔天舒. 基于多层深度卷积特征的抗遮挡实时跟踪算法[J]. 光学学报, 2019, 39(7): 0715002.

[21] 尹宽, 李均利, 李丽, 等. 复杂情况下自适应特征更新目标跟踪算法[J]. 光学学报, 2019, 39(11): 1115002.

[22] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[23] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[24] PosseggerH, MauthnerT, BischofH. In defense of color-based model-free tracking[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 2113- 2120.

[25] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[M] ∥Agapito L, Bronstein M, Rother C. Computer vision - ECCV 2014 Workshops. Lecture notes in computer science. Cham: Springer, 2015, 8926: 254- 265.

[26] MaC, Huang JB, Yang XK, et al. Hierarchical convolutional features for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3074- 3082.

[27] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1144- 1152.

[28] DanelljanM, RobinsonA, Shahbaz KhanF, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9909: 472- 488.

[29] DanelljanM, BhatG, Khan FS, et al. ( 2017-04-10)[2019-10-20]. https:∥arxiv.org/abs/1611. 09224.

Article Outline

刘海峰, 孙成, 梁星亮. 自适应特征融合与抗遮挡的相关滤波跟踪算法[J]. 激光与光电子学进展, 2020, 57(14): 141014. Haifeng Liu, Cheng Sun, Xingliang Liang. Correlation-Filter Tracking Algorithm with Adaptive-Feature Fusion and Anti-Occlusion[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141014.