主动光场精确深度计算方法  下载: 995次

下载: 995次

1 引言

近年来,光场成像作为一种新颖的技术得到越来越多的关注[1-4]。常用的光场采集方式有单相机多自由度移动、相机阵列[5]、编码孔径[6]、内嵌掩模[7]、微透镜阵列[8]等。例如,通过在主透镜及探测器之间放置一个微透镜阵列,微透镜将主透镜会聚的光线进行成像或分散并传播到探测器上不同像素位置,因此可以追踪每条光线在探测器上的落点,探测包含光线的位置和方向信息的4维光场。相比于传统成像只记录光线的2维强度信息,4维光场数据通过计算成像技术进行后处理,可以实现多视点成像、数字重聚焦、全对焦成像、合成孔径等多种成像应用[9]。通过数字重聚焦技术解决特殊场合图像的失焦、背景目标过多等问题;通过合成孔径技术实现“透视”监视;在与显微技术融合后,还能实现多视角大景深显微成像。

4维光场数据中包含丰富的空间和角度信息,其中光线的角度信息与场景的深度信息具有高度耦合性。一方面,不同角度采样下的空间信息具有对应关系,另一方面,使用角度信息能够在不同深度下对光场数据进行剪切操作,使得光场成像具备深度成像、三维重构等功能。通常使用视差和焦点堆栈进行光场深度计算[10-15]。前者从光场多视点图像中提取场景的视差图;后者从光场重聚焦图像中提取场景聚焦或者失焦信息。然而,这些被动光场深度计算方法依赖于光场记录的辐射强度信息构建深度线索,容易受到物体表面反射率、环境光照、场景遮挡和探测噪声等因素的干扰。

本文提出一种新的主动光场深度成像方法,在光场成像中引入结构照明,结合了光场和结构光的优点。结构光应用于光学三维成像与测量,能够为不同视点下的目标场景提供便捷、快速和准确的辅助匹配信息,具有非接触、测量速度快、精度高和易于在计算机控制下实行自动化测量等优点[16-19]。在前期研究工作中,通过结合光场成像与结构照明,实现了基于相位映射的多视点深度以及三维测量[20-21],但尚未充分利用光场结构本身特有的深度线索进行计算和分析。在结构照明下,光场成像同时记录光线的方法信息和受场景深度调制的相位信息,本文使用相位编码信息替代强度信息,为构建光场深度线索提供强度不敏感的匹配特征,实现精确、稳健的光场深度计算。

2 原理

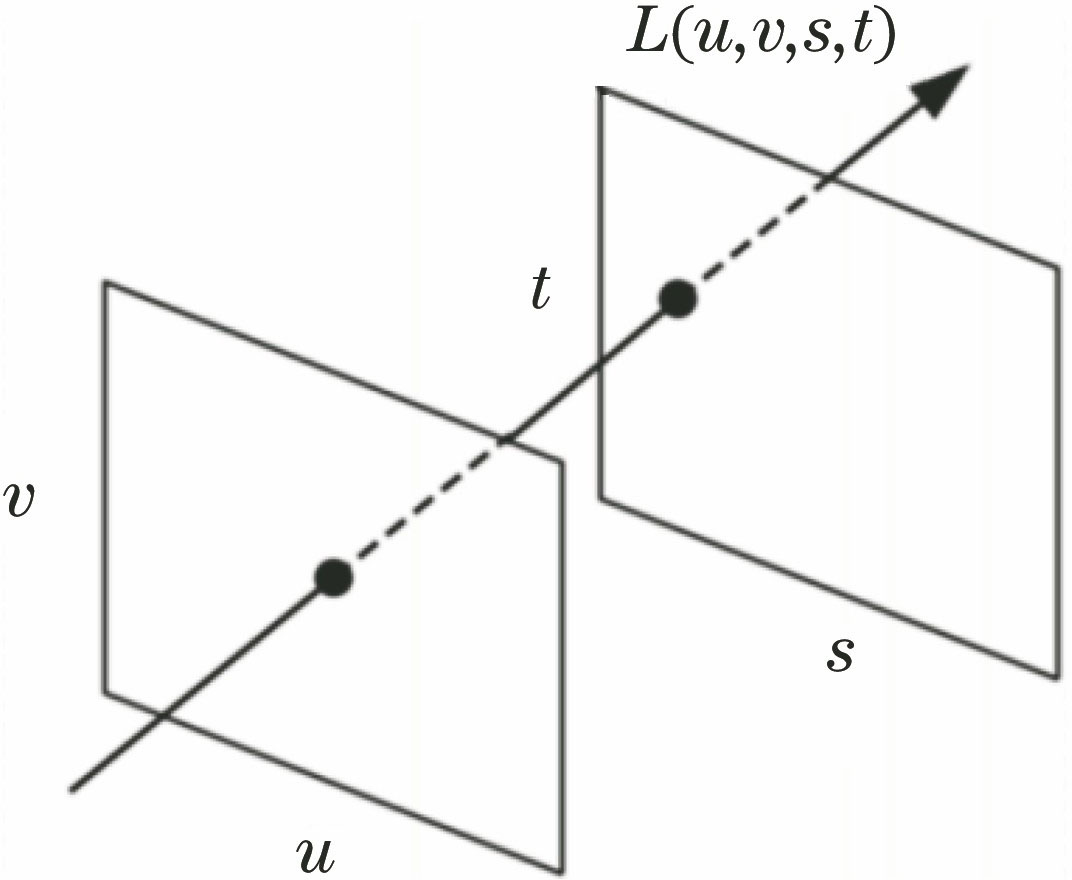

2.1 光场参数化

为了分析几何光学范畴内视觉信号的基本元素,即空间光线集合[22],Adelson等[23]提出了7维全光函数

2.2 光场图像处理

传统成像系统所采集到的图像为探测器上每个像素点对来自整个光瞳的光线进行积分,像素点

与传统成像不同,光场成像在2维探测器上同时记录光场的4维信息,即2维位置分布和2维传输方向。对4维光场数据进行后处理能够实现不同的成像效果,如数字重聚焦和多视点成像。

数字重聚焦是将采集的光场重新投影到新的像平面上进行积分,根据几何关系,4维光场投影到新焦面上的成像公式[24]为

式中:

光场成像范围取决于主透镜和微透镜阵列的大小,如果限定

式中:Δ

多视角成像能够反映场景在各个成像视角下的视差,而重聚焦成像能够反映场景在各个成像深度处的清晰或模糊状态。因此,光场的多视角成像和数字重聚焦从不同的维度反映了场景的深度信息。这是因为光场成像所记录的光线角度信息与场景深度信息具有高度耦合性,使得光场成像具备深度感知的功能。通过视差、模糊等反映场景深度变化的深度线索构造光场数据的能量函数

(4)式中能量函数的构造和优化依赖于光场记录的辐射强度信息,这类方法可以归类于被动光场深度计算方法。光场的辐射强度容易受到物体表面反射率、环境光照、场景遮挡和探测噪声等因素的干扰,进而影响被动光场深度计算的精确性和稳健性。

3 方法

提出一种主动光场深度计算方法。通过条纹结构光对场景进行相位编码,利用相位编码信息替代辐射强度信息,为构建光场深度线索提供强度不敏感的匹配特征。

式中:

式中:

调制相位

4 实验与分析

为验证所提出的主动光场深度计算方法的有效性,搭建了实验系统进行演示和分析。该系统由一个光场相机(Lytro 1.0)和一个投影仪(K132型,Acer公司,中国台湾,1280 pixel×800 pixel)组成。光场相机所记录的图像可以解码为四维光场数据,其空间分辨率为378 pixe×379 pixel,角度分辨率为11 pixel×11 pixel。

图 3. 实验场景。(a)均匀光照下的光场图像及其放大结构图;(b)结构光照下的光场图像及其放大结构图

Fig. 3. Experimental scenes. (a) Light field image and its amplified structure under uniform illumination; (b) light field image and its amplified structure under structured illumination

实验中,使用投影仪投射条纹结构光到物体表面,

图 4. 相位编码场。(a)相位编码场的图像及其放大结构图;(b) u=(2,2)T视角下的相位图;(c) u=(6,6)T视角下的相位图;(d)对应图4(b)、(c)中红色和蓝色标记线的相位分布曲线

Fig. 4. Phase-encoded field. (a) Phase-encoded field image and its amplified structure; (b) phase map from perspective of u=(2,2)T; (c) phase map from perspective of u=(6,6)T; (d) phase distribution curves corresponding to red and blue marker lines in Fig. 4(b) and Fig. 4(c)

为分析光场深度成像效果,本实验使用Tao等[12]的方法,分别通过均匀光照下光场的辐射强度和条纹结构光照明下相位编码场的相位信息构造光场能量函数,计算出场景深度,结果如

图 5. 光场深度计算。(a)被动方法;(b)主动方法;(c)对应图5(a)中深度图的三维效果图;(d)对应图5(b)中深度图的三维效果图

Fig. 5. Light field depth computation. (a) Passive method; (b) active method; (c) three-dimensional model maps corresponding to depth map in Fig. 5(a); (d) three-dimensional model maps corresponding to depth map in Fig. 5(b)

5 结论

通过结构光照明为场景提供相位编码信息,进一步为构建光场深度线索提供强度不敏感的匹配特征,由此精确计算场景深度。实验结果显示,对于颜色、纹理相似的场景,被动方法无法有效区分深度变化,而使用本文提出的主动方法能够有效计算出场景深度。因此,相比于被动方法,主动方法能够获得更高质量的深度效果,实现精确、稳健的光场深度计算。

[1] Levoy M, Hanrahan P. Light field rendering[J]. Computer Graphics, 1996: 31-42.

[2] Levoy M, Ng R, Adams A, et al. Light field microscopy[J]. ACM Transactions on Graphics, 2006, 25(3): 924-934.

[3] 夏朝阳, 田勇志, 梁二军, 等. 基于相机阵列的红外光场成像[J]. 光学学报, 2017, 37(9): 0911002.

[4] 王文锋, 张焱鑫, 陈瑜, 等. 基于光场深度序列的大视野图像拼接算法[J]. 光学学报, 2018, 38(9): 0915003.

[8] Ng R, Levoy M, Brédif M, et al. Light field photography with a handheld plenoptic camera[J]. Stanford Technical Report CSTR, 2005: 1-11.

[9] 张驰, 刘菲, 侯广琦, 等. 光场成像技术及其在计算机视觉中的应用[J]. 中国图象图形学报, 2016, 21(3): 263-281.

[11] WannerS, GoldlueckeB. Globally consistent depth labeling of 4D light fields[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA, 2012: 41- 48.

[12] Tao MW, HadapS, MalikJ, et al. Depth from combining defocus and correspondence using light-field cameras[C]∥2013 IEEE International Conference on Computer Vision (ICCV), December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 673- 680.

[13] Lin HT, ChenC, Kang SB, et al. Depth recovery from light field using focal stack symmetry[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3451- 3459.

[18] 彭翔, 殷永凯, 刘晓利, 等. 基于相位辅助的三维数字成像与测量[J]. 光学学报, 2011, 31(9): 0900120.

[19] 苏显渝, 张启灿, 陈文静. 结构光三维成像技术[J]. 中国激光, 2014, 41(2): 0209001.

[22] Gershun A. The light field[J]. Journal of Mathematics and Physics, 1939, 18: 51-151.

[23] Adelson EH, Bergen JR. The plenoptic function and the elements of early vision[M]. Landy M, Movshon J A. Computational models of visual processing. Cambridge, MA: MIT Press, 1991: 3- 20.

[24] Ng R. Fourier slice photography[J]. ACM Transactions on Graphics, 2005, 24(3): 735-744.

[25] 于晓洋, 吴海滨, 尹丽萍, 等. 格雷码与相移结合的结构光三维测量技术[J]. 仪器仪表学报, 2007, 28(12): 2152-2157.

陈智振, 蔡泽伟, 刘晓利, 彭翔. 主动光场精确深度计算方法[J]. 中国激光, 2019, 46(7): 0704005. Zhizhen Chen, Zewei Cai, Xiaoli Liu, Xiang Peng. Active Method for Accurate Light Field Depth Computation[J]. Chinese Journal of Lasers, 2019, 46(7): 0704005.