自适应上下文感知相关滤波跟踪  下载: 812次

下载: 812次

1 引言

目标跟踪作为当前计算机视觉领域中的研究热点之一[1-8],受到国内外学者的广泛研究,其结合了数学、人工智能、目标检测等众多领域的核心思想和先进技术,已在智能交通、车辆识别、医学图像等领域得到广泛应用。但目标跟踪存在诸多难点问题,如尺度变化、目标形变等,如何在复杂的场景下进行准确稳定的跟踪仍面临着巨大的挑战。

近年来,相关滤波算法因其优异的速度和良好的跟踪精度受到国内外研究人员的广泛关注。2010年Bolme等[9]首次将通信领域的相关滤波(CF)应用在目标跟踪中,提出了最小输出平方和误差(MOSSE)滤波跟踪算法,该算法在目标和检测区域做相关性,利用快速傅里叶变换将计算从时域转换到频域,降低了运算量,跟踪速度达到了600 frame/s以上,但该算法采用单通道的灰度特征导致跟踪效果较差。2012年Henriques等[10]在MOSSE算法的基础之上,通过循环密集采样的方法,提出核循环结构(CSK)算法,该算法充分涵盖了视频序列的整幅图像特征,提升了跟踪效果。2015年Henriques等[11]改进了CSK跟踪算法,提出了核相关滤波(KCF)算法,该算法采用多通道方向梯度直方图(HOG)特征替换单通道灰度特征,通过引入核函数将非线性问题转化为高维空间中的线性问题, 使得算法更加优化。2014年,Danelljan等[12]提出了判别型尺度空间跟踪(DSST)算法,该算法采用判别相关滤波器确定目标位置,利用尺度估计方法确定尺度信息,有效提高了尺度自适应性能。 2016年,Bertinetto等[13]提出staple算法,该算法融合了HOG特征和颜色直方图特征(CN),跟踪效果较好,但该算法在形变、遮挡等复杂场景下鲁棒性较差。

以上相关滤波算法中,训练集对初始目标进行一次采样后,其他样本通过初始样本循环移位获取,此时唯一准确正样本只有初始样本,当目标出现快速运动或快速变形时,会产生边界效应,导致跟踪效果较差,一些主流算法加入余弦窗来弱化边界效应的影响,但是余弦窗操作会过滤掉大部分的背景信息,从而进一步降低分类器的判别力。为了解决边界效应,2015年,Galoogahi等[14]提出有限边界的相关性过滤器(CFLB)最小化岭回归,该算法采用较大的训练和检测图像块,利用裁剪矩阵裁切出真实的小尺寸样本,提升真实样本的比例,有效解决了边界效应所带来的问题,跟踪效果较好。2015年,Danelljan等[15]提出了基于空间正则化的相关滤波(SRDCF)算法,扩大了样本搜索区域,同时加入空间正则化约束,但该算法记录了初始帧到当前帧的所有样本信息,计算复杂度较高,跟踪速度较慢,不适合用于实时跟踪。2017年,Mueller等[16]提出上下文感知相关滤波器跟踪(CACF)算法,该算法增加了更多的背景信息,在滤波器训练时,将目标作为正样本,目标上下左右方向各取一个背景块作为负样本,即在目标周围增加了背景约束信息,同时该算法是对相关滤波算法框架的改进,适应于所有的相关滤波算法,如DCF、SAMF,相比之前的算法,成功率和准确率都有了显著的提高。2018年,Li等[17]在SRDCF的基础上加入时间正则化,提出了时空正则化相关滤波器(STRCF)算法,既有效处理了边界效应,又提升了跟踪速度,相比SRDCF算法,具有更好的鲁棒性。

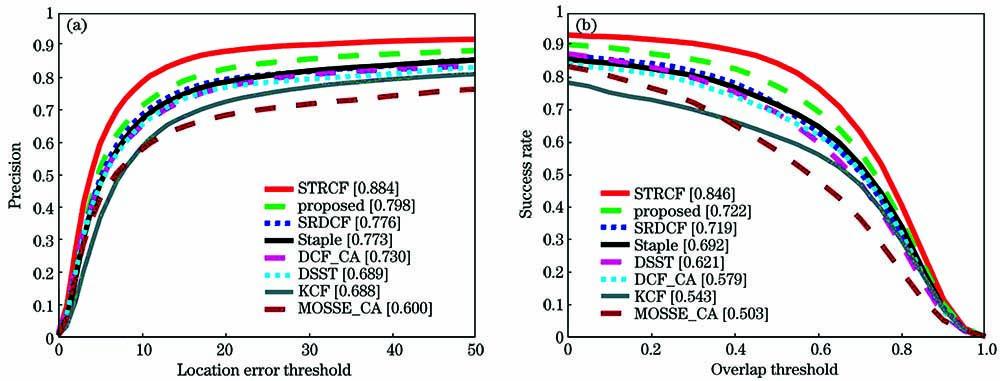

上下文感知相关滤波算法(CACF)虽然提取了更多的背景信息学习/训练滤波器,但该算法并没有考虑滤波器的时间一致性,当目标发生形变或快速运动等外观突变问题时,滤波器无法及时地适应连续两帧图像的目标和背景信息变化,即目标可能在连续帧中经历多次不可预测的变换,导致复杂场景下目标与背景信息相似时,容易出现目标漂移的问题。针对这一问题,本文提出了自适应上下文感知相关滤波跟踪算法。本文主要工作如下:1)提取目标周围背景信息来训练滤波器,增强滤波器对目标和背景的分辨能力,加入时间感知,保证连续两帧图像的滤波器尽可能一致;2)目标定位阶段,采用前一帧学习到的滤波器与当前帧做相关性计算,得到响应结果图,其响应结果图最大值对应的位置为当前帧目标的位置。模型更新阶段,采用平均峰值相关能量(APCE)对目标是否遮挡进行判别,当响应峰值和APCE都大于各自的历史平均值时,对目标模型进行更新,若有一个不满足,则不更新模型;3)在OTB100上评估本文算法,实验结果表明,与当前主流算法相比,本文算法具有更高的跟踪精确率和成功率,分别为0.798和0.722,均高于CACF框架的DCF_CA和MOSSE_CA算法。

2 上下文感知相关滤波算法原理

经典相关滤波器通过循环采样的方法对目标周围进行采样,利用岭回归训练滤波器,目标函数为

式中:ω表示学习到的相关滤波器;A0表示初始样本a0循环采样后的样本集;y表示回归目标,为二维高斯矢量图像;λ为正则化系数。由于(1)式为凸函数,有闭式解且为全局最优解,对其进行优化求解,可得

依据任何循环矩阵可以被傅里叶变换矩阵对角化的特性,对循环矩阵A0进行变换,可得

式中:P(a0)表示初始样本a0生成的循环矩阵A0;F是傅里叶变换矩阵;

式中:

上下文感知相关滤波器在此基础上,将初始样本作为唯一准确正样本,对应的循环矩阵为A0,采集初始样本上下左右四个方向背景块的信息作为负样本进行训练滤波器,所对应的循环矩阵为Ai,则(1)式转化为

(5)式以唯一准确正样本具有较高的响应值和负样本处响应值接近于零为约束条件训练滤波器,使(2)式中的目标回归为y,上下文背景块通过正则化系数λ2回归为0。利用(3)式对(5)式化简可得

3 本文算法

3.1 模型求解

上下文感知相关滤波算法利用前一帧的目标位置,通过与滤波器进行相关性计算得到当前帧图像的响应图,响应图中的最大值即为目标的当前帧位置,然后利用该目标位置更新模型,但是该算法并没有考虑滤波器的时间一致性,当目标发生形变或快速运动等外观突变问题时,滤波器无法及时地适应连续两帧图像的目标和背景信息变化,即目标可能在连续帧中经历多次不可预测的变换,导致复杂场景下目标与背景信息相似时,容易出现目标漂移的问题。本文算法引入时间感知项λ3

式中:λ1、λ2、λ3为正则化系数;Ai表示负样本循环采样后的样本集;ωt-1表示前一帧学习到的滤波器,下标t-1表示前一帧目标。将(7)式转换成矩阵形式,表示为

式中:B=

对(9)式进行傅里叶变换,可得

式中:

根据文献[18-20],将对循环矩阵的求逆问题转化为对特征值的求逆问题,则(9)式转换为

利用傅里叶变换矩阵F的性质[19]:FHF=FFH=I进行消元化简,可得

利用循环矩阵对角化性质[18-20]: Fdiag(x)FH=C

利用循环矩阵卷积性质:F

3.2 目标定位

在目标定位阶段,本文采用前一帧学习到的滤波器与当前帧进行相关性计算,得到响应结果图,响应结果图中的最大值即为目标的当前帧位置。

在模型更新阶段,采用文献[ 21]提出的APCE对模型进行遮挡判别是否更新,

式中:Lmax表示响应结果图中的峰值;Lmin表示响应结果图中的谷值;Lm,n表示目标在位置(m,n)的响应值。响应峰值Lmax越大表示跟踪结果越好,同时(16)式可以得到响应结果图的波动程度,当APCE值突然变小时,表示跟踪过程中出现目标遮挡或者目标丢失的情况,本文结合APCE值和Lmax的特点,当两者都以一定比例V1、V2大于各自的历史均值时才对模型进行更新,此时有效防止了目标漂移。

3.3 本文算法步骤

1) 初始帧目标定位。手动确定初始帧目标位置(Lx,Ly)和目标所在的背景区域。

2) 滤波器训练和更新滤波器模板。提取目标上下左右四个方向背景块信息作为负样本训练滤波器,采用(14)式得到当前帧与前一帧尽可能一致的滤波器。

3) 目标定位阶段。采用(15)式得到最大响应值Lmax,用于确定下一帧目标位置。

4) 模型更新阶段。对步骤3跟踪到的目标采用(16)式进行遮挡判别,是否进行模型更新。

5) 输出跟踪结果。继续执行步骤2,进行下一帧图像的滤波器训练与更新。

4 实验结果

4.1 实验环境及参数设置

本文采用MATLAB 2016a作为编程语言,实验平台配置Intel i7-8565UCPU和8 GB内存。操作系统为Windows 10。本文部分参数设置:正则化参数λ1=0.0001,λ2 =1,λ3 =10,搜索框大小为padding=4,学习率为η=0.015,V1、V2均为0.5,其他参数与文献[ 16]一致。

为了方便与当前主流算法进行实验对比,本文选取标准数据集OTB100[22]。数据集OTB100是常用的跟踪数据集,包含100组视频序列,具有11种不同的属性,如背景杂乱、平面内/外翻转等情况。本文算法采用一次性通过评价(OPE)分析算法性能,将跟踪精确率和成功率作为评价标准。

4.2 实验结果分析

为了验证本文算法的鲁棒性,选取近年来跟踪效果较好的跟踪算法进行对比,分别为KCF[8]、SRDCF[10]、DCF_CA[11]、MOSSE_CA[11]、DSST[12]、Staple[13]、STRCF[12]等。本节从算法定量比较和算法定性比较进行实验分析。

4.2.1 算法定量比较

从

图 1. 8种跟踪算法在OTB100上的成功率和精确率。(a)精确率;(b)成功率

Fig. 1. Success rate and precision for 8 tracking algorithms on OTB100.(a) Precision; (b) success rate

表 1. 8种跟踪算法在OTB100上的11种属性序列上的精确率得分

Table 1. Precision scores of 8 tracking algorithms on 11 attribute sequences on OTB100

|

表 2. 8种跟踪算法在OTB100上的11种属性序列上的成功率得分

Table 2. Success rate scores of 8 tracking algorithms on 11 attribute sequences on OTB100

|

在数据集OTB100上,从

4.2.2 与对比算法定性比较

图 2. 8种跟踪方法在部分序列的跟踪结果

Fig. 2. Tracking results of 8 tracking algorithms in partial sequences

1) 视频序列Bird2_1包含遮挡、平面内/外旋转、形变等视频属性。从初始帧到第10帧各跟踪算法均可准确跟踪到目标;到第53帧时,由于目标自身翻转导致其自身发生形变,此时KCF、DSST、SRDCF、DCF_CA、MOSSE_CA算法出现漂移;到第62帧时,STRCF算法包含了更多的背景信息,也出现轻度漂移现象;到第94帧时,由于目标再次翻转导致Staple算法误以为背景信息也是目标的一部分,从而包含这些背景信息,出现跟踪漂移。只有本文算法从初始帧到最后一帧能准确地跟踪到目标,也包含了更少的背景信息。

2) 视频序列skiing_1包含光照变化、尺度变化、形变等视频属性。从初始帧到第10帧,目标从刚开始启动滑雪动作到第一次翻转发生形变,KCF、MOSSE_CA、SRDCF、DSST算法陆续跟踪失败。从第10帧到第13帧,目标不停地进行平面内/外旋转动作,此时,DCF_CA算法漂移现象严重,只能跟踪到目标的一部分,却包含了更多的背景信息,STRCF算法跟踪失败,从第28帧开始,只有本文算法能跟踪到目标,其余算法均跟踪失败,这是因为本文算法加入了时间感知,保证了连续两帧图像学习到的滤波器尽可能一致,从而保证目标发生形变时,本文算法仍能准确跟踪到目标。

3) 视频序列couple_1包含尺度变化、形变、背景杂乱等视频属性。从初始帧到第41帧,由于目标的快速运动,DSST和KCF算法首先跟踪失败。从第41帧到第116帧,在目标快速运动出现尺度变化,同时有更多的背景信息干扰跟踪的情况下,只有STRCF、SRDCF和本文算法能跟踪到目标,其余算法跟踪失败,但前两者跟踪速度略慢于本文算法。

4) 视频序列DragonBaby_1包含遮挡、运动模糊、快速运动等视频属性。从初始帧到第10帧,在目标快速运动过程中,DSST算法首先跟踪失败,KCF算法发生中度漂移现象,不能准确且完全地跟踪到目标。从第10帧到第35帧,由于目标的转身导致被自身遮挡,SRDCF、MOSSE_CA算法发生漂移导致跟踪失败,Staple不能及时地适应目标外观变化,导致跟踪不如DCF_CA、STRCF和本文算法准确。从第35帧到第47帧,目标的快速运动导致出现运动模糊现象,Staple算法跟踪失败,STRCF算法包含了更多的背景信息。从初始帧到第113帧,由于目标持续地发生遮挡与快速运动等不利因素的干扰,本文算法引入APCE对模型进行遮挡判别,减少了模型更新次数,从而本文算法能准确跟踪到目标,其他算法出现跟踪漂移甚至跟踪失败的情况。

上述实验结果表明,

5 结论

针对上下文感知相关滤波算法没有考虑滤波器时间一致性,而导致跟踪性能不佳的问题,本文在原框架上加入时间感知,来保证连续两帧图像学习/训练到的滤波器尽可能一致,同时对于出现遮挡情况,引入了APCE进行判别,减少了模型更新次数,提高了跟踪速度,满足了目标跟踪实时需求。在数据集OTB100上进行大量对比实验,本文算法成功率和精确率分别为0.722和0.798,均优于当前主流算法,说明本文算法具有较好的准确率和鲁棒性。

[1] 刘万军, 孙虎, 姜文涛. 自适应特征选择的相关滤波跟踪算法[J]. 光学学报, 2019, 39(6): 0615004.

[2] 朱建章, 王栋, 卢湖川. 背景与时间感知的相关滤波实时视觉跟踪[J]. 中国图象图形学报, 2019, 24(4): 536-549.

[3] 刘波, 许廷发, 李相民, 等. 自适应上下文感知相关滤波跟踪[J]. 中国光学, 2019, 12(2): 265-273.

[4] 许敬祥, 伍雪冬, 杨开运. 基于高斯输出约束的上下文相关滤波跟踪[J]. 激光与光电子学进展, 2020, 57(4): 041508.

[5] 万欣, 张春辉, 张琳, 等. 加权全局上下文感知相关滤波视觉跟踪算法[J]. 计算机工程与应用, 2018, 54(16): 1-12, 67.

[6] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[7] 茅正冲, 陈海东. 基于核相关滤波的长期目标跟踪算法[J]. 激光与光电子学进展, 2019, 56(1): 010702.

[8] 廖秀峰, 侯志强, 余旺盛, 等. 基于核相关的尺度自适应视觉跟踪[J]. 光学学报, 2018, 38(7): 0715002.

[9] Bolme DS, Beveridge JR, Draper BA, et al.Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA.New York: IEEE Press, 2010: 2544- 2550.

[10] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Computer Vision-ECCV 2012. Berlin, Heidelberg: Springer Berlin Heidelberg, 2012: 702- 715.

[11] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[12] DanelljanM, HägerG, Shahbaz KhanF, et al. Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference 2014, Nottingham. British Machine Vision Association, 2014: 65.

[13] BertinettoL, ValmadreJ, GolodetzS, et al.Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE Press, 2016: 1401- 1409.

[14] Galoogahi HK, SimT, LuceyS. Correlation filters with limited boundaries[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA.New York: IEEE Press, 2015: 4630- 4638.

[15] DanelljanM, HägerG, Khan FS, et al.Learning spatially regularized correlation filters for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile.New York: IEEE Press, 2015: 4310- 4318.

[16] MuellerM, SmithN, GhanemB. Context-aware correlation filter tracking[C]∥ IEEE Conference on Computer Vision & Pattern Recognition. IEEE, 2017.

[17] LiF, TianC, Zuo WM, et al.Learning spatial-temporal regularized correlation filters for visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 4904- 4913.

[18] 陈瑞, 王二民. 几类特殊矩阵求逆矩阵的方法研究[J]. 枣庄学院学报, 2018, 35(2): 30-34.

[19] 孙青青, 王川龙. 循环矩阵填充的快速傅里叶变换算法[J]. 太原师范学院学报(自然科学版), 2019, 18(3): 1-7.

Sun Q Q, Wang C L. A median value modified singular value thresholding algorithm for toeplitz martix completion[J]. Journal of Taiyuan Normal University (Natural Science Edition), 2019, 18(3): 1-7.

[20] 贾中宁, 温俊海, 程敬之. 离散卷积与离散傅氏变换的矩阵关系[J]. 太原理工大学学报, 1999, 30(6): 3-5.

Jia Z N, Wen J H, Cheng J Z. Matrix relation of discretion convolution and discretion Fourier transformation[J]. Journal of Taiyuan University of Technology, 1999, 30(6): 3-5.

[21] Wang MM, LiuY, Huang ZY. Large margin object tracking with circulant feature maps[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 4800- 4808.

[22] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

姜文涛, 涂潮, 刘万军, 金岩. 自适应上下文感知相关滤波跟踪[J]. 激光与光电子学进展, 2020, 57(24): 241012. Jiang Wentao, Tu Chao, Liu Wanjun, Jin Yan. Adaptive Context-Aware Correlation Filter Tracking[J]. Laser & Optoelectronics Progress, 2020, 57(24): 241012.