基于优化YOLOv3的低空无人机检测识别方法  下载: 1393次

下载: 1393次

1 引言

随着现代电子通信技术及航空技术的飞速发展,民用无人机已迅速应用于社会生活的不同方面,在提供很大便利的同时,也对公共安全、个人隐私、**安全等构成了严重威胁。例如,媒体经常报道一些不法分子通过对低空小型无人机进行改装,即加装光电摄像设备进行非法拍摄活动,或者挂载危险物品(爆炸物等)来实施恐怖袭击[1]。有效的无人机检测技术对于应对无人机威胁问题非常重要。目前,常用的检测技术通常包括基于声波探测[2-3]、无线电探测[4]和雷达探测[5-6]等手段,但是这些技术手段通常需要昂贵的设备和严格的配置。基于机器视觉的技术具有成本低廉、易于配置的优点,因此,基于机器视觉的低空无人机检测技术具有良好的发展前景。

关于基于视觉的低空无人机检测识别任务:Rozantsev等[7]提出了一种基于回归的视频无人机检测方法,首先利用两个增强树回归器稳定运动,之后使用具有固定尺寸的立方体来检测无人机,当在飞行过程中无人机大小逐渐变化时,这种方法可以获得良好的检测性能,但无人机的实际飞行过程速度快、大小不一,导致该方法的实际表现较差;Martínez等[8]通过重建无人机的三维轨迹来检测装有固定摄像机的无人机,但由于摄像机的观测点固定,因此该方法对无人机的监视范围有限,对背景变化的无人机检测效果也较差。总的来看,基于视觉的无人机检测识别技术仍存在许多亟待解决的问题。

目前,深度学习技术已能模拟人脑建立学习分析的神经网络,利用人脑的机制实现数据分级特征的理解和表达,具有强大的视觉信息处理能力,在处理速度和处理性能上均能较好地满足当前图像视频大数据的要求。利用卷积神经网络构建的模型在目标检测识别领域已得到了十分广泛的应用,如Faster R-CNN[9]、R-FCN[10]、SSD[11]、YOLO[12]等方法。

无人机的检测识别需要一定的实时性。SSD与YOLO这2种方法在目标检测过程中都能达到实时检测。同时,文献[

13]表明,YOLOv3在标准数据集上的检测精度和速度都优于SSD方法。但原始的YOLOv3方法是针对常规目标数据集的检测方法,并不适用于对低空无人机的检测识别。针对无人机的实际检测情况,本文提出一种基于优化YOLOv3的低空无人机检测识别方法。该方法利用残差网络和多尺度预测相结合的优点,基于

2 YOLO方法的原理及优化

2.1 YOLO检测过程

因为低空无人机的类别不止一种,图像中包含多种类别的目标,所以需要对每个预测框的不同类别做出判断,具体的检测过程如下。

1) 将整个图片划分为

式中:

2) 利用卷积神经网络提取特征并进行预测。当网络中类别的个数为

3) 通过非极大值抑制(NMS)筛选预测的边框,去掉重复的边框,输出最终的预测结果。其中,损失函数的设计使用了

式中:

2.2 O-YOLOv3的网络结构

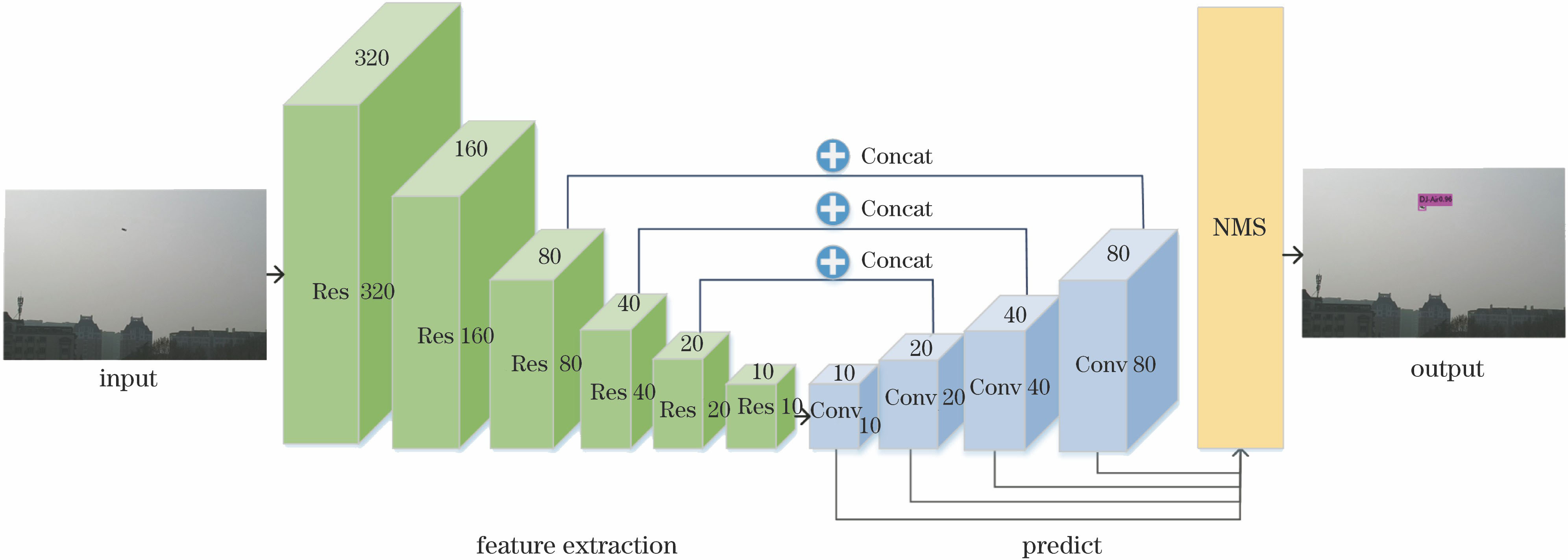

提出基于Optimized-YOLOv3(简称O-YOLOv3)的低空无人机检测识别方法,其实现框架如

图 1. 用于低空无人机的检测识别结构图

Fig. 1. Structural diagram of detection and recognition for low-altitude UAV

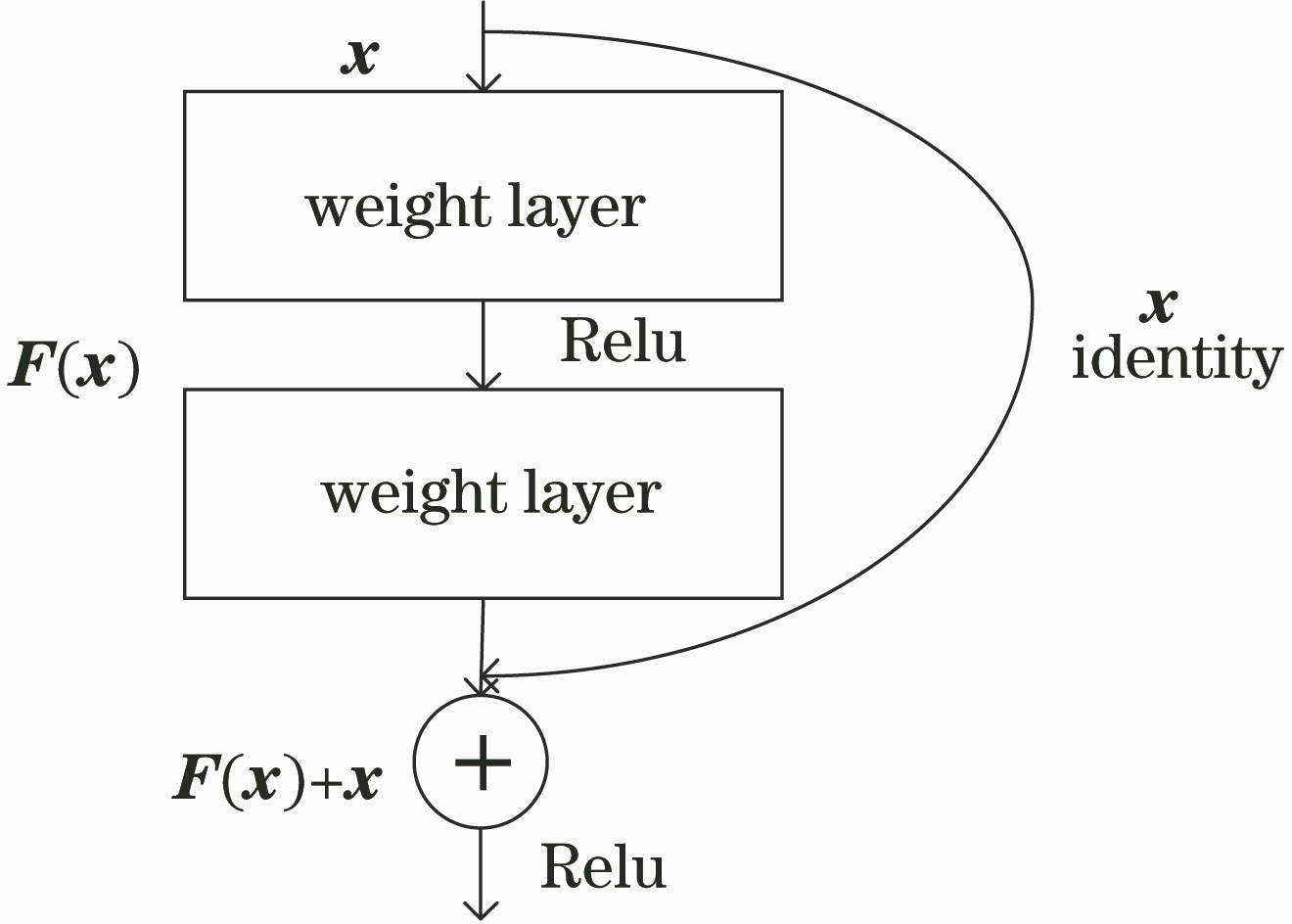

1) 利用深度残差网络提取无人机特征

O-YOLOv3根据残差网络的原理,构建了深度残差网络用于提取无人机的特征。残差网络是由一系列残差块组成,如

残差块的结构如

式中:

O-YOLOv3的网络结构如

表 1. 用于低空无人机检测识别的O-YOLO网络结构

Table 1. O-YOLO network structure for detection and recognition of low altitude UAV

|

2) 多尺度网络预测低空无人机O-YOLOv3网络在多个不同尺度的特征图上回归预测无人机的位置和类别。如

3 实验及结果与评价

3.1 数据集的准备

由于基于深度学习的低空无人机检测识别方法较少,而且也没有公开的数据集或是标准的数据集。为此,首先进行数据集的采集及构建。1) 数据采集。利用可见光探测器在不同时间、不同背景对3种型号民用无人机进行拍摄。无人机型号分别为大疆-精灵3(DJ-3)、大疆-御Pro(DJ-Pro)和大疆-御Air(DJ-Air)。为确保数据的多样性,拍摄过程中充分考虑了低空无人机的各种飞行姿态,包括盘旋、急速升降、平稳飞行等。最终共得到3524张可见光图像。2) 数据标注。采取人工标注方式。为确保数据的有效性,对于目标被遮挡面积大于等于50%的样本进行标注。最终,对3012张可见光图像中的低空无人机目标进行了边界框的标注,得到了具有标注信息的数据。按照4∶1的比例将其分成训练集和测试集。3) 图像增强。为提升方法的检测识别精度,采取目标检测领域中通用的图像增强方式对训练集进行增强处理,包括亮度、对比度的操作处理。4) 数据扩充。考虑到无人机飞行时的姿态不全是保持水平,还有倾斜等,故对训练集进行了翻转及±10°、±20°的旋转操作。如果旋转处理后图像中靠近边缘的目标出现残缺或完全丢失的情况,则放弃该样本数据。5) 数据集构建。通过对训练集的图像进行增强和扩充处理,分别获得3类数据集。如

表 2. 不同训练集的处理方式及样本数

Table 2. Processing methods and sample numbers for different train datasets

|

3.2 YOLO网络训练

针对原始YOLOv3网络及优化后的O-YOLOv3网络进行对比实验。实验环境如下:网络的训练为Darknet框架;服务器平台配置为Ubuntu 16.04操作系统,Intel(R) Xeon(R) CPU E5-2673 v3 @2.40 GHz,搭载GeForce GTX 1080Ti/PCIe/SSE2显卡,内存32 GB。

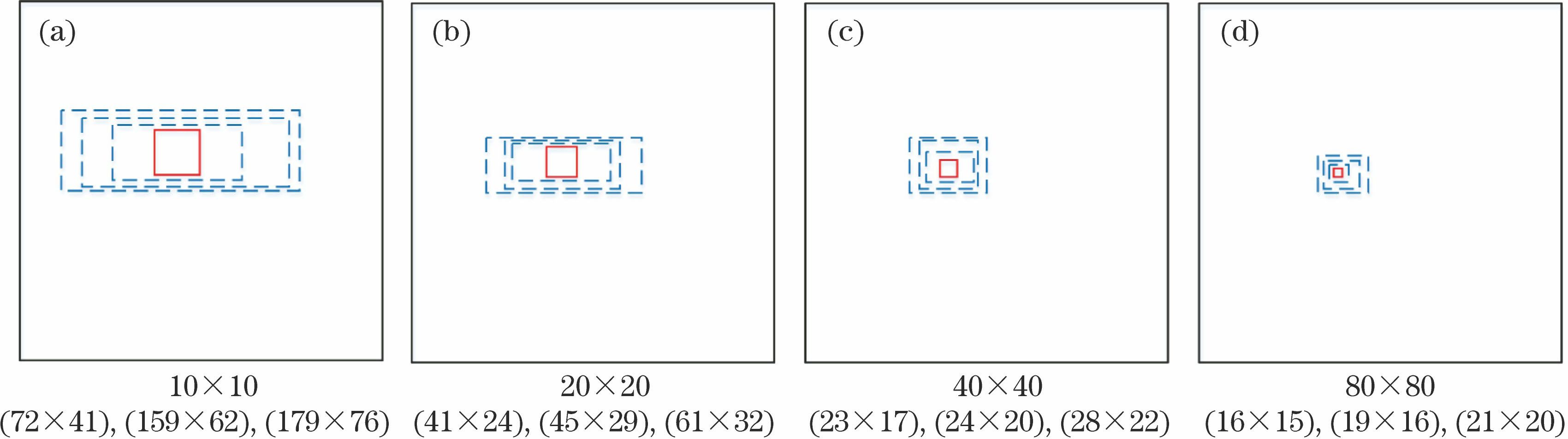

针对低空无人机的训练集,通过

图 3. 4种尺度的12个锚点示意图。在每一种尺度下,实线框为一个对应的方格,虚线框为对应的锚点框。(a) 10×10;(b) 20×20;(c) 40×40;(d) 80×80

Fig. 3. Diagrams of 12 anchors with 4 scales. At each scale, the solid box is a corresponding square, and the dotted boxes are the corresponding anchor boxes. (a) 10×10; (b) 20×20; (c) 40×40; (d) 80×80

在整个训练过程中,2个网络的训练参数相同,最大迭代次数为50000,动量和权重衰减分别为0.9和0.0005,批量大小设置为64,初始学习率为10-3,并在后两个阶段降低为10-4和10-5。相对应每个阶段的学习率,网络分别迭代25000、15000和10000次。

3.3 测试结果及评价

分别用UAV_A、UAV_B和UAV_C的训练集来训练2种检测识别网络,并与经原始及优化后的网络训练得到的模型进行比较,重点比对其对不同类型低空无人机的检测识别性能。

在对测试集进行检测时,将低空无人机目标测试集图像输入训练好的网络,进行目标的位置回归:当模型预测的目标边界框与手工标注的边界框交并集比(

表 3. 不同方法在不同测试集上的评价结果

Table 3. Evaluation results of different methods on different test datasets

| ||||||||||||||||||||||||||||||||||||||||||||||||||||

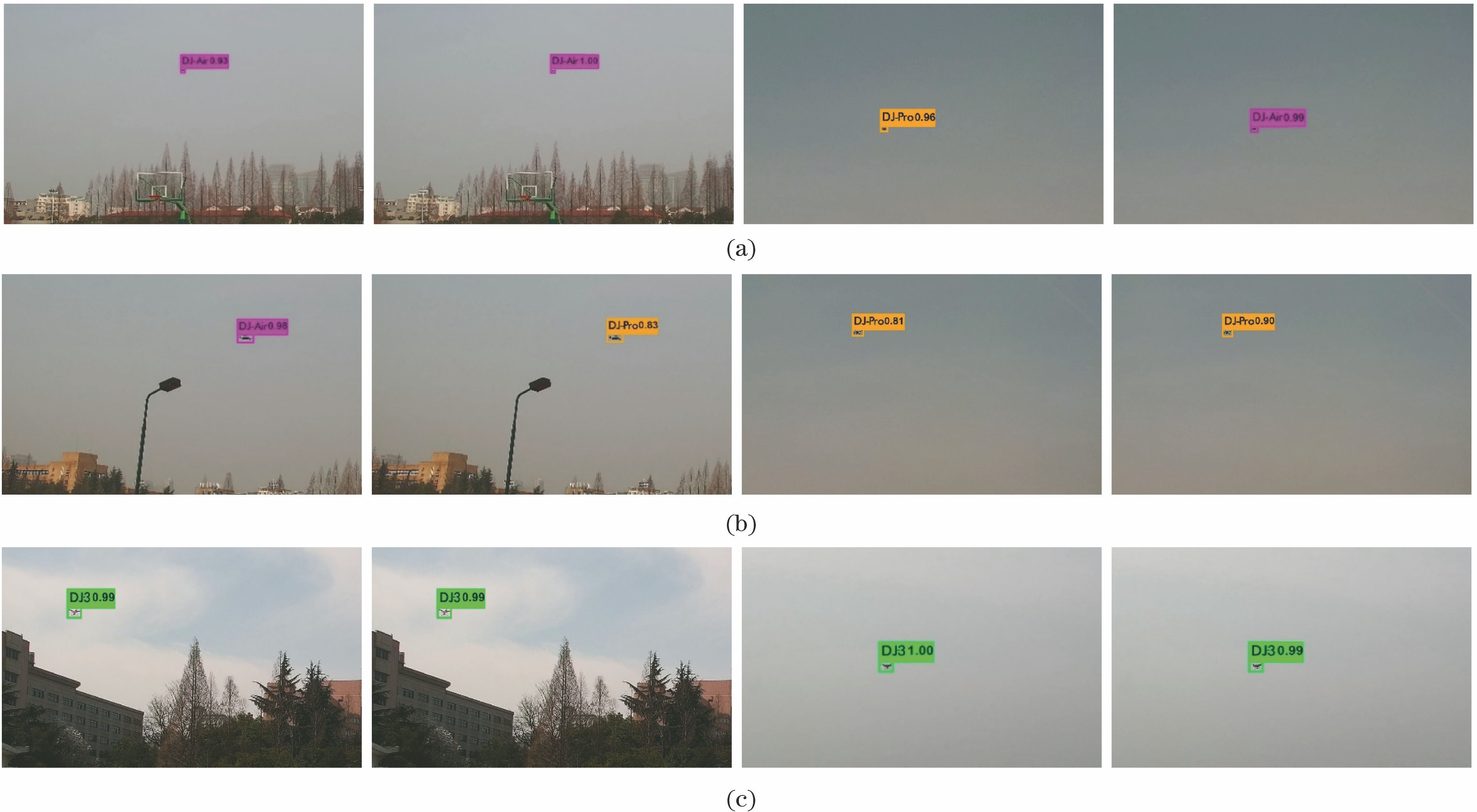

图 4. 测试集中部分检测结果对比图(第1列和第3列为YOLOv3方法,第2列和第4列为O-YOLOv3方法)。(a) DJ-Air;(b) DJ-Pro;(c) DJ-3

Fig. 4. Comparison of partial detection resultson test dataset (The first and third columns are the results of the YOLOv3 method, and the second and fourth columns are the results of the O-YOLOv3 method). (a) DJ-Air; (b) DJ-Pro; (c) DJ-3

1) 相同网络结构对应不同训练集的结果比较。由YOLOv3网络结构对应的结果可以看出,经过图像增强的训练集(UAV_B)对应的mAP值为71.24%,相较于原始训练集(UAV)提高了1.13%,而经过图像增强和扩充的训练集(UAV_C)对应的mAP值为73.86%,相较于原始训练集(UAV_A)提高了3.75%。对于O-YOLOv3网络结构,经过图像增强以及图像增强和扩充对应的mAP值分别提高了1.56%和4.32%。由此可见,图像增强与数据扩充对方法的检测性能有一定的提升。

2) 相同训练集对应不同网络结构的结果比较。从

3) 检测速度比较。YOLOv3的检测速度保持在30 s-1左右,而O-YOLOv3的检测速度约为26 s-1,说明在进行检测的同时两种方法都能够保持一定的实时性能,这在实际应用中有很大的作用。

由

4 结论

针对低空无人机目标存在的威胁,采用可见光探测技术,以YOLOv3网络为基础,通过深度残差网络及多尺度的预测来优化网络结构,提出O-YOLOv3网络。构建了低空无人机的数据集,并对两种方法进行比较评价。由实验分析可知,改进方法性能得到提高的原因有:1)通过具有针对性的图像增强与数据扩充操作,数据集的数量和多样性增多,提高了模型的泛化性能和检测精度;2)原始的网络结构与锚点值仅适用于常规目标,而优化后的网络结构与重新聚类得到的锚点值更适用于低空无人机目标,最终提高了模型的检测精度并且减少了误检;3)优化后的网络结构的网络层数较原始网络有所加深,这使得网络参数增加,也导致检测速度有所下降,但并不影响其实时检测的能力。

虽然优化后的方法相较于原始方法在性能上有了较大的提升,但仍存在一些不足:1)数据集的类别较为有限,如能获取更多类别的低空无人机数据,性能将会有更大的提升;2)采集的无人机图像均处于光照良好的可见光条件下,对于夜间或较为昏暗的光线条件下的无人机检测识别仍有待进一步的改进和验证。这将是未来深入研究的内容。

[1] 赵云雨,[\s]{1}常晋聃.[\s]{1}对低空无人机的探测与管控新技术综述[J].[\s]{1}电子对抗,[\s]{1}2016([\s]{1}4):[\s]{1}44-[\s]{1}49.[\s]{1}

Zhao[\s]{1}YY,[\s]{1}Chang[\s]{1}JD.[\s]{1}Detection[\s]{1}and[\s]{1}handling[\s]{1}of[\s]{1}drones[\s]{1}in[\s]{1}low[\s]{1}altitude[\s]{1}airspace[J].[\s]{1}Electronic[\s]{1}Warfare,[\s]{1}2016([\s]{1}4):[\s]{1}44-[\s]{1}49.[\s]{1}

[3] 汪庭霁,[\s]{1}黄伟宁,[\s]{1}范振雄,[\s]{1}等.[\s]{1}无人机侦测技术方法研究[J].[\s]{1}中国无线电,[\s]{1}2017([\s]{1}11):[\s]{1}57-[\s]{1}58.[\s]{1}

Wang[\s]{1}TJ,[\s]{1}Huang[\s]{1}WN,[\s]{1}Fan[\s]{1}ZX,[\s]{1}et[\s]{1}al.[\s]{1}Research[\s]{1}on[\s]{1}the[\s]{1}methods[\s]{1}of[\s]{1}UAV[\s]{1}detection[\s]{1}technology[J].[\s]{1}China[\s]{1}Radio,[\s]{1}2017([\s]{1}11):[\s]{1}57-[\s]{1}58.[\s]{1}

[4] NguyenP,[\s]{1}RavindranathaM,[\s]{1}NguyenA,[\s]{1}et[\s]{1}al.[\s]{1}Investigating[\s]{1}cost-effective[\s]{1}RF-based[\s]{1}detection[\s]{1}of[\s]{1}drones[C]∥Proceedings[\s]{1}of[\s]{1}the[\s]{1}2nd[\s]{1}Workshop[\s]{1}on[\s]{1}Micro[\s]{1}Aerial[\s]{1}Vehicle[\s]{1}Networks,[\s]{1}Systems,[\s]{1}and[\s]{1}Applications[\s]{1}for[\s]{1}Civilian[\s]{1}Use,[\s]{1}June[\s]{1}26-26,[\s]{1}2016,[\s]{1}Singapore.[\s]{1}New[\s]{1}York:[\s]{1}ACM,[\s]{1}2016:[\s]{1}17-[\s]{1}22.[\s]{1}

[5] 李琴, 黄卡玛. 低空小型无人机雷达探测距离仿真分析[J]. 无线电工程, 2018, 48(4): 303-307.

[6] KlareJ,[\s]{1}BiallawonsO,[\s]{1}Cerutti-MaoriD.[\s]{1}Detection[\s]{1}of[\s]{1}UAVs[\s]{1}using[\s]{1}the[\s]{1}MIMO[\s]{1}radar[\s]{1}MIRA-CLE[\s]{1}Ka[C]∥Proceedings[\s]{1}of[\s]{1}EUSAR[\s]{1}2016:[\s]{1}11th[\s]{1}European[\s]{1}Conference[\s]{1}on[\s]{1}Synthetic[\s]{1}Aperture[\s]{1}Radar,[\s]{1}June[\s]{1}6-9,[\s]{1}2016,[\s]{1}Hamburg,[\s]{1}Germany.[\s]{1}Germany:[\s]{1}VDE,[\s]{1}2016:[\s]{1}731-[\s]{1}734.[\s]{1}

[7] RozantsevA,[\s]{1}LepetitV,[\s]{1}FuaP.[\s]{1}Flying[\s]{1}objects[\s]{1}detection[\s]{1}from[\s]{1}a[\s]{1}single[\s]{1}moving[\s]{1}camera[C]∥2015[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}7-12,[\s]{1}2015,[\s]{1}Boston,[\s]{1}MA,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2015:[\s]{1}4128-[\s]{1}4136.[\s]{1}

[8] Martínez C, Mondragón I F. Olivares-Méndez M A, et al. On-board and ground visual pose estimation techniques for UAV control[J]. Journal of Intelligent & Robotic Systems, 2011, 61: 301-320.

[9] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[10] Dai[\s]{1}JF,[\s]{1}LiY,[\s]{1}He[\s]{1}KM,[\s]{1}et[\s]{1}al.[\s]{1}R-FCN:[\s]{1}object[\s]{1}detection[\s]{1}via[\s]{1}region-based[\s]{1}fully[\s]{1}convolutional[\s]{1}networks[C]∥Proceedings[\s]{1}of[\s]{1}the[\s]{1}30th[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Neural[\s]{1}Information[\s]{1}Processing[\s]{1}Systems,[\s]{1}December[\s]{1}5-10,[\s]{1}2016,[\s]{1}Barcelona,[\s]{1}Sapin.[\s]{1}New[\s]{1}York:[\s]{1}Curran[\s]{1}Associates[\s]{1}Inc.,[\s]{1}2016:[\s]{1}379-[\s]{1}387.[\s]{1}

[11] LiuW,[\s]{1}AnguelovD,[\s]{1}ErhanD,[\s]{1}et[\s]{1}al.[\s]{1}SSD:[\s]{1}single[\s]{1}shot[\s]{1}multibox[\s]{1}detector[M][\s]{1}∥Leibe[\s]{1}B,[\s]{1}Matas[\s]{1}J,[\s]{1}Sebe[\s]{1}N,[\s]{1}et[\s]{1}al.[\s]{1}Computer[\s]{1}vision-ECCV[\s]{1}2016.[\s]{1}Lecture[\s]{1}notes[\s]{1}in[\s]{1}computer[\s]{1}science.[\s]{1}Cham:[\s]{1}Springer,[\s]{1}2016,[\s]{1}9905:[\s]{1}21-[\s]{1}37.[\s]{1}

[12] RedmonJ,[\s]{1}DivvalaS,[\s]{1}GirshickR,[\s]{1}et[\s]{1}al.[\s]{1}You[\s]{1}only[\s]{1}look[\s]{1}once:[\s]{1}unified,[\s]{1}real-time[\s]{1}object[\s]{1}detection[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}779-[\s]{1}788.[\s]{1}

[13] RedmonJ,[\s]{1}Farhadi[\s]{1}A.[\s]{1}YOLOv3:[\s]{1}an[\s]{1}incremental[\s]{1}improvement[J/OL].[\s]{1}([\s]{1}2018-04-08)[2019-03-10].[\s]{1}https:∥arxiv.org/abs/1804.[\s]{1}02767.[\s]{1}

[14] He[\s]{1}KM,[\s]{1}Zhang[\s]{1}XY,[\s]{1}Ren[\s]{1}SQ,[\s]{1}et[\s]{1}al.[\s]{1}Deep[\s]{1}residual[\s]{1}learning[\s]{1}for[\s]{1}image[\s]{1}recognition[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}770-[\s]{1}778.[\s]{1}

[15] IoffeS,[\s]{1}SzegedyC.[\s]{1}Batch[\s]{1}normalization:[\s]{1}accelerating[\s]{1}deep[\s]{1}network[\s]{1}training[\s]{1}by[\s]{1}reducing[\s]{1}internal[\s]{1}covariate[\s]{1}shift[J/OL].[\s]{1}[2015-03-02][2019-03-10].https:∥arxiv.org/abs/1502.[\s]{1}03167.[\s]{1}

[16] 任之俊, 蔺素珍, 李大威, 等. 基于改进特征金字塔的Mask R-CNN目标检测方法[J]. 激光与光电子学进展, 2019, 56(4): 041502.

[17] 魏湧明, 全吉成, 侯宇青阳. 基于YOLO v2的无人机航拍图像定位研究[J]. 激光与光电子学进展, 2017, 54(11): 111002.

Article Outline

马旗, 朱斌, 张宏伟, 张杨, 姜雨辰. 基于优化YOLOv3的低空无人机检测识别方法[J]. 激光与光电子学进展, 2019, 56(20): 201006. Qi Ma, Bin Zhu, Hongwei Zhang, Yang Zhang, Yuchen Jiang. Low-Altitude UAV Detection and Recognition Method Based on Optimized YOLOv3[J]. Laser & Optoelectronics Progress, 2019, 56(20): 201006.