基于联合学习的多视角室内人员检测网络  下载: 1024次

下载: 1024次

1 引言

随着生活水平的不断提高,人们的安防意识也不断增强,视频监控设备也被广泛应用到生产和生活中,伴随计算机视觉技术的不断发展,智能视频监控应运而生。目标检测,尤其人体目标检测是智能视频监控领域中一项必不可少的研究课题,在自动驾驶、智能机器人、行为分析等方面应用广泛[1],尤其在一些特殊场所,如值班室、消防控制室、**哨所等,实时检测室内是否有人在岗对于保障人们的生命财产安全意义重大。

国内外有大量人体目标检测,尤其是行人检测的相关研究[2]。一般而言,人体目标检测框架主要包括特征提取和分类判别两个部分。特征提取部分可分为两大类。第一类是人工设计的传统特征,用来描述颜色、边缘、纹理、深度及梯度信息等,有时会添加运动信息、上下文信息等。最早的人工设计的传统特征以Dalal等[3]设计的方向梯度直方图(HOG)特征为代表,描述目标的边缘信息,可以适应目标的微小形变,成为后续研究的基础。之后有人将其与描述纹理信息的局部二值模式(LBP)特征[4-5]、尺度不变特征变换(SIFT)特征[6]、描述输入图像矩形特征的Haar-like特征[7]等相结合。之后人工设计的传统特征则主要以Dollar等[8]提出的ICF(Integral Channel Features)为代表,提出三种通道,即LUV颜色通道(L表示亮度,U和V是色度)、归一化梯度幅值通道和梯度直方图通道。后续一些方法也是基于这种思想,比如ACF(Aggregate Channel Features)[9]、Informed Haar特征[10]、LDCF(Locally Decorrelated Channel Features)特征[11]、Checkerboards特征[12]等。这类提取手工设计特征的方法主要依据行人外形,并不能很好地区分具有相似外形特征的背景目标。第二类是提取神经网络特征的方法[13-14]。此外,还有将两种特征结合的方法,如Cai等[15]将传统特征与深度网络特征相结合以提升检测性能。分类判别方法首先从HOG特征+支持向量机(SVM)框架[3]中的SVM开始,采用线性与非线性核函数(如线性SVM、直方图交叉核SVM[16]、latent SVM[17]等)进行分类。后来出现了一些利用统计概率思想的分类方法,如基于提升思想的Adaboost (Adaptive Boosting)方法等,这些方法对环境中的噪声等非目标因素较为敏感。随着相关技术的不断发展,出现了一些基于神经网络模型进行分类判别的方法,如ChnFtrs[8]、JointDeep[18] 等方法将多个模块进行集成,以实现最终的分类判别。

随着深度学习的不断发展,研究人员开始转向利用神经网络实现目标检测方法的研究,这种方法大致可以分为两大类:一类是以R-CNN(Regions with CNN features)[19]为代表的两阶段网络模型,如Fast R-CNN[20]、Faster R-CNN[21-22]等;另一类是单阶段模型,以YOLO(You Only Look Once)系列[23]、SSD(Single Shot MultiBox Detector)[24]等为典型代表。这些网络模型最初都是针对二分类或多分类问题提出的,将这些网络模型用于人的检测效果并不理想,而且,其中大部分方法都是用于室外开阔环境中处于直立状态的行人检测[25],图像采集范围广、距离远,人体目标比较完整,且基本处于站姿或走动状态,呈现正面或背面视角。室内人体目标检测的情形则与之不同:采集图像的范围小,距离近,目标存在一定倾角,大部分时候仅部分人体躯干可见,基本上呈现的都是坐姿,少量为站姿,且存在正面、背面、侧面等多种视角,多种姿态变化以及不同程度的变形与遮挡,受到复杂背景等因素的干扰等。为此,研究人员提出了一些方法来解决这些问题。

针对多变外形、多姿态的问题,主要以可变形部件模型(DPM)方法[17]为代表,在整体模型的基础上集成了部件模型并考虑其变形因素,在一定程度上提升了检测性能;还有一些方法对部件的旋转、大小变化、形状等进行建模以应对更复杂的变形问题[26],但基本上都是利用传统特征。针对遮挡问题,一些方法对遮挡进行推理,以部件图像块的检测分数为基础估计部件可见性[4,27];还有一些方法利用其他手段,如进行图像分割处理或提取深度信息等辅助判断[26],有时也加入运动信息、上下文信息、帧间信息等,但都未考虑与模型其他部分之间的联系。

除了检测性能之外,检测速度也是一个重要考虑因素,主要体现在图像区域预选取阶段。最早的方法是对图像进行密集式的滑动窗口遍历搜索[28],然后提取特征进行检测,计算复杂、耗时长,对分类器性能要求高。后来,区域建议的方法陆续出现,将目标转向重点关注区域,大大降低了计算成本,提升了分类、检测等后续阶段的效率。一般可以将其分为两类:一类基于区域分组的思想,以Selective Search[28]为代表;一类以窗口得分为基准,以Edge Boxes[29]为代表,后者的速度更快。之后,很多网络模型开始采用这种区域建议的思想,如DBN-Mut模型使用DPM进行区域建议[30];JointDeep[18]、SDN(Switchable Deep Network)[31]采用HOG+CSS(Color Self-Similarity)特征结合线性SVM的方法进行区域建议;还有不少网络模型使用ICF特征检测算子进行区域建议[32];Faster R-CNN[21]则基于一个网络模型实现区域建议。研究表明,除了提升算法效率之外,区域建议对检测性能也有一定的提升作用[33]。

基于以上研究基础,针对监控条件下的室内人体目标检测,本文提出了一种基于联合学习思想的多视角室内人员检测网络模型(MVNN)。该模型包括两大部分,即运用区域建议和多视角模型的预处理部分和多模块联合学习的检测网络部分。其中,区域建议部分可对输入图像进行预处理,排除大量的非目标区域;多视角模型有效提升了对多视角人体目标的召回率,提升网络的整体检测性能;多模块联合学习的检测网络可实现特征提取、可变形处理,并可对可见性进行估计,得到最终的分类结果。实验结果表明,所提出的算法模型比其他算法模型具有更高的准确率,尤其在处理变形与遮挡情况和多视角人体检测方面的性能更优。

2 基本原理

2.1 区域建议网络

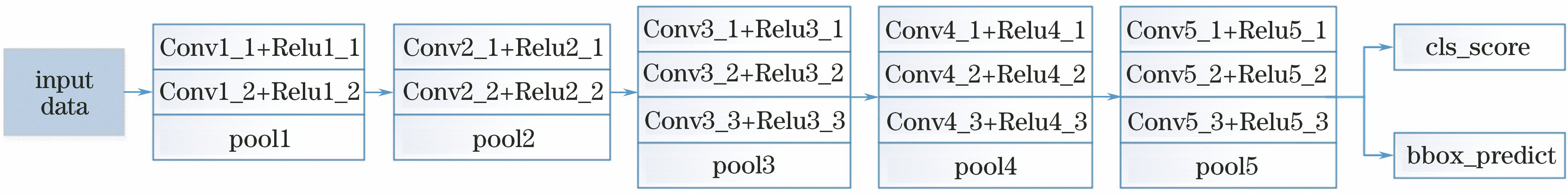

分析采集的视频片段,主要对人体上半身进行标注。借鉴Faster R-CNN[21]模型中的区域建议网络部分,网络结构(基于VGG模型)示意如

该网络通过提取图像CNN特征预提取有较大概率存在目标对象的图像块。实验结果表明,与原算法[18]中预处理阶段的HOG+CSS特征结合SVM的算法模型相比,使用该区域建议网络进行预提取具有更高的召回率。通常采用非最大值抑制(NMS)方法对区域建议结果进行进一步处理。依据IoU(Intersection Over Union)指标,可用交并比

式中:

2.2 多视角模型

设计了三视角(包括正面、背面、侧面三种视角)模型。由于监控摄像头的安装位置固定,目标会存在一定倾角,同时呈现出多种姿态,尤其是侧面视角,且每种视角又存在不同程度的变形,多视角模型比单视角模型更适合这种应用环境,部分样本如

图 2. 多视角样本。(a)正面;(b)侧面;(c)背面

Fig. 2. Multi-view samples. (a) Frontal view; (b) profile view; (c) back view

这些多视角样本分为三类,包括正面、侧面、背面三种视角的人体目标。

2.3 联合学习网络模型

联合学习网络主要包括特征提取、可变形处理、可见性估计、分类判定模块,网络模型框架如

区域建议网络和多视角模型部分主要是对大量的原始图像数据做预处理,提取最可能包含人体目标的候选框,减少后面网络层的计算量,且保证了较高的召回率。MVNN数据输入层的作用是将区域建议图像块做进一步处理,经过特征提取,添加适合本应用的可变形处理层,以应对遮挡及多视角、多姿态的情况,提升检测率和召回率。

在该基础模型上进行调整,使之适合本应用环境,主体网络结构及参数设置如

2.3.1 图像特征提取模块

将区域建议图像块作为输入,提取其颜色通道特征和边缘信息,最终以三通道图像的形式实现对图像信息的多层次表达。具体来说,第一通道是原图的Y通道;第二通道是由四个图像块拼接而成,包括U通道、V通道、Y通道和全零图像块;第三通道是计算前面的U、V、Y三通道图像块边缘信息并选择其最大值。三个通道都归一化到零均值-单位方差的分布,然后综合三通道信息描述图像,

图 5. 输入层三通道示意图。(a)样本1;(b)样本2

Fig. 5. Three channels of input layer. (a) Sample 1; (b) sample 2

2.3.2 目标可变形处理模块

室内环境中,由于监控摄像头安装位置固定,目标人员在监控视野中存在一定倾角,而且人的状态不定,呈现出多种视角,如背面、正面和侧面视角等,有时也会出现一些复杂情形,如人突然起身走动、弯腰捡物品、伸展双臂等,不同于通常的坐姿状态,这些情形给检测造成困难。为此,设计一种与之适应的DPM,可以在一定程度上提高检测率。

部件模型源于DPM[17]的思想,主要是将原图像目标看成两个层次,即整体层次和分部件层次,综合两层次得到最终结果,包括检测分数及位置信息。

如

式中:

式中:

式中:

式中:

结合文献[

18]中的部件模型,共设计了15种部件滤波器,参数设置如

表 1. 所提算法中部件滤波器参数

Table 1. Parameters of part filters in proposed algorithm

|

使用4个变量来定义部件滤波器的对应位置,即起始行、结束行、起始列和结束列。每列代表一种部件滤波器,假设目标整体尺寸大小是9×5,因此行的范围是1~9 ,列的范围是1~5。这15种部件滤波器分为3个层次,第1~4,5~8,9~15种部件分别为第1,2,3层次。高层次部件是由低层次的对应部件组成,如第5个部件由部件1和部件2组成,滤波器参数设置和研究目标相关。

2.3.3 可见性估计及分类模块

图像中会存在遮挡情况,如桌椅、植物、设备的遮挡,目标间的遮挡等,借鉴文献[

18],在DPM基础上估计可见性,可改善由遮挡导致的信息丢失问题,提高对遮挡目标的检测率。计算该图像区域块的检测分数,估计可见性,给出最终的分类结果,基于可变形层输出的部件分数

式中:

式中:

式中:

所提模型中采用了二分类中常用的交叉熵对数损失函数,计算方法为

式中:

根据随机梯度下降(SGD)准则进行网络训练,输入为前面得到的部件检测分数,将SGD训练过程中的参数计算分解为

式中:☉代表(

3 实验部分

实验平台是基于64位的Ubuntu14.04操作系统和NVIDIA TITAN Xp GPU,采用的软件有Matlab2014b、Python2.7,采用的深度学习框架为tensorflow及相关深度学习库。

3.1 性能评价指标

二分类问题中,通常采用查准率(

式中:

式中:

人体目标检测领域,根据Dollar等[34]提出的工具箱,通常用FPPI-MR(False Positives Per Image-Miss Rate)衡量人体目标检测算法的检测性能,把测试图片中包含人体目标的窗口切割出来,然后从不包含人体目标的测试集采样非人样本,将窗口作为测试集来评估算法的性能。相关分析表明[34],相比FPPW(False Positives Per Window),FPPI指标更合理。具体而言,给定一定数目的包含或不包含人体目标的样本图像,

为了验证所提算法模型对室内人员目标的检测性能,将其与其他相关算法模型进行了对比,选择

3.2 数据集建立

人体目标检测研究领域中,INRIA、Caltech、PASCAL VOC等数据集在相关研究中使用较多,其中,PASCAL VOC的图像标注方式及质量都较合理,常被用在一些比赛及课题研究中[35]。针对室内人员检测任务,目前尚没有公开相关专用数据集,因此,按照PASCAL VOC数据集的格式标准建立了一个监控环境下的室内人员检测数据集(IHDD),数据采集自某企业值班室和工作室,对应的每种场所都在不同角落安装了摄像头,人的上半身基本可完整呈现在监控视野中。对一个月内的监控视频进行截取并采集图像,涉及白天和夜晚时段、不同性别和年龄段的人员以及正面、背面、侧面多种视角,大部分人员是坐姿及其变形状态,也有少量直立或倾斜站立的姿态。共采集了14665个图像样本,其中包含8799个训练样本,2933个验证样本,以及2933个测试样本,一共标注了17854个人体目标,数据集构成如

3.3 训练网络模型

所提网络模型包括两个部分。第一部分是区域建议网络,其训练方法和文献[

21]一致,使用了VGG-16在ImageNet上的预训练模型。训练参数为:动量为0.9,权重衰减为0.0005,两阶段学习率分别为0.001和0.0001。第二部分是联合学习的多视角检测网络,网络训练参数设置如

根据学习率和模型误差间的变化关系,设定两阶段学习率分别为0.025和0.0125,并将epoch设定为250。模型选择了交叉熵损失函数,使用SGD的方式进行训练。

表 2. 室内人员检测数据集

Table 2. Indoor human detection dataset

|

表 3. 第二阶段网络模型参数设置

Table 3. Parameter setting of second-stage network model

|

3.4 MVNN的切片分析

为了验证所提算法模型的有效性,下面对几个主要部分的作用单独进行研究。

3.4.1 区域建议网络

所提模型构建了区域建议网络,为说明此部分作用,与文献[

18]中HOG+CSS+SVM的预处理算法模型进行了对比。由于对应源码不容易获得,此处采用具有类似检测思想的HOG特征结合Adaboost方法的模型替代该方法,测试结果如

图 7. 输入数据的区域建议结果比较。(a)HOG特征结合Adaboost方法;(b)所提区域建议算法

Fig. 7. Comparison results of region proposal for input data. (a) HOG+Adaboost algorithm; (b) Proposed region proposal algorithm

出现上述现象的原因主要是算法特征类型不同,文献[ 18]利用的是传统HOG特征,仅提取边缘信息,对目标的表达能力有限,当出现其他特征类似的目标时容易误检,而所提算法利用深度网络特征,对目标的特征表达更充分,不易出现误检,也更易检测出同类的新测试样例。文献[ 18]算法的特征表达能力有限,当应对变形较大或存在遮挡的新样例时易出现漏检。

分析以上测试结果发现,所提的区域建议模型具有更高的召回率和更低的误检率,尤其在处理遮挡和多视角情形的时候检测效果更好。

3.4.2 多视角模型

视频监控下的人体目标往往不能显示出完整外形,且大部分都存在一定倾角与形变,并呈现多种视角。为此,设计了多视角模型,部分检测结果如

图 8. 多视角模型测试结果。(a)不同视角下测试样本的检测结果;(b)单视角模型和多视角模型的检测效果对比

Fig. 8. Testing result of multi-view model. (a) Testing result of multiple views; (b) Comparison results of single-view model and multi-view model

总的来说,针对监控环境下的室内人员检测,多视角模型比单视角模型具有更高的检测率和召回率,不易产生误检。

3.4.3 可变形处理和可见性估计

使用可变形处理可在一定程度上应对目标形变,并通过估计可见性应对遮挡,文献[

18]中已说明了其对提高模型性能的重要作用。部分测试如

4 分析与讨论

所提算法的最终定量统计结果如

图 10. 所提算法在IHDD上的测试结果。(a) RFPPI-RMR曲线;(b) P-R曲线

Fig. 10. Testing result of proposed algorithm on IHDD. (a) RFPPI-RMR curve; (b) P-R curve

为了进一步验证所提算法的有效性,将其与现有人体目标检测经典算法模型(包括文献[

3]、文献[

21]和文献[

18]中的算法模型)进行对比,相关测试结果统计如

表 4. 不同算法在数据集上的定量比较

Table 4. Quantitative comparison of different algorithms on dataset

|

可以看出,对于监控环境下的室内人体目标检测,所提算法的召回率与检测率更高。分析原因如下:1)文献[ 3]的方法是在遍历图像的基础上提取人工设计的特征,在一定程度上表达了目标的边缘等信息,但是对于其他方面的信息(如颜色通道信息、纹理信息等)表达还不够充分,而且其他物体的边缘信息也可能和人体目标很相似,容易造成误检,通过网络学习提取的CNN特征则具有更丰富的表达能力,可以提取出目标的更多代表性信息,更能做出可靠性判断。2)文献[ 21]的方法是采用两阶段的网络模型,通过第一阶段的区域预提取保证了较高的召回率,第二阶段在此基础上进行更精确地判断,但其针对的是通常情况下的目标分类与检测问题,没有考虑监控环境下室内人体目标的多视角、多形态、存在变形及遮挡的情形,因而检测性能并不理想。3)文献[ 18]基于基准网络模型,采用联合学习的方法处理目标的变形与遮挡问题,在第一阶段中采用传统目标检测方法进行区域预提取。这种方法速度快,但准确率和召回率并不高。类似地,该模型针对的是处于开阔环境中处于水平视角的行人,并不适合所提算法模型的研究环境,尤其是监控环境下室内人体目标存在一定倾角、呈现多视角、多形态、信息不完整的复杂情形。

综上所述,针对监控环境下室内人体目标检测任务,所提算法模型能够合理处理不同光照(如白天和黑夜)、多种形态、多视角、存在一定遮挡的情形,检测效果更好。

5 结论

针对现有室内人员检测算法在处理多视角、存在多种变形和遮挡等方面的不足,结合监控条件下室内人员检测任务的特点,搭建了一个联合学习的MVNN,集成了区域建议、多视角模型、特征提取、可变形处理、可见性估计和判别分类等部分。在自建的IHDD上进行训练和测试,结果表明,相比于传统的人员检测算法和利用经典网络模型检测的方法,所提算法通过使用区域建议网络模型显著提高了目标召回率,而多视角模型和DPM的设计则使得算法在处理多视角、存在一定变形与遮挡的情形时仍有较高的检测率和较低的误检率,可以为后续相关研究提供参考。

由于实际监控条件和室内环境的不确定性,所提算法在一些复杂环境下的人员检测性能还有提升空间,综合考虑经济条件和应用需求,以后可在更多相关场所中架设摄像头,增加样本的数量并提高样本质量,不断提升所提算法在多视角、存在变形与遮挡等复杂环境下的检测性能。

[2] BenensonR, OmranM, HosangJ, et al. Ten years of pedestrian detection, what have we learned?[C]. European Conference on Computer Vision, 2015: 613- 627.

[3] DalalN, TriggsB. Histograms of oriented gradients for human detection[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2005: 886- 893.

[4] Wang XY, Han TX, Yan SC. An HOG-LBP human detector with partial occlusion handling[C]. IEEE 12th International Conference on Computer Vision, 2009: 32- 39.

[5] Zhang JG, Huang KQ, Yu YN, et al. Boosted local structured HOG-LBP for object localization[C]. IEEE International Conference on Computer Vision and Pattern Recognition, 2011: 1393- 1400.

[7] LienhartR, MaydtJ. An extended set of Haar-like features for rapid object detection[C]. International Conference on Image Processing, 2002: 900- 903

[8] Dollar P, Tu Z W, Perona P, et al. Integral channel features[J]. Proceedings of the British Machine Vision Conference, 2009, 91.

[10] Zhang SS, BauckhageC, Cremers AB. Informed haar-like features improve pedestrian detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2014: 947- 954.

[12] Zhang SS, BenensonR, SchieleB. Filtered channel features for pedestrian detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1751- 1760.

[13] SermanetP, KavukcuogluK, ChintalaS, et al. Pedestrian detection with unsupervised multi-stage feature learning[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2013: 3626- 3633.

[14] HosangJ, OmranM, BenensonR, et al. Taking a deeper look at pedestrians[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 4073- 4082.

[15] Cai ZW, SaberianM, VasconcelosN. Learning complexity-aware cascades for deep pedestrian detection[C]. IEEE International Conference on Computer Vision, 2015: 3361- 3369.

[16] MajiS, Berg AC, MalikJ. Classification using intersection kernel support vector machines is efficient[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2008: 4587630.

[17] Felzenszwalb P F, Girshick R B. McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[18] Ouyang WL, Wang XG. Joint deep learning for pedestrian detection[C]. IEEE International Conference on Computer Vision, 2013: 2056- 2063.

[19] GirshickR, DonahueJ, DarrellT, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580- 587.

[20] GirshickR. Fast R-CNN[C]. IEEE International Conference on Computer Vision, 2015: 1440- 1448.

[22] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[23] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779- 788.

[24] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]. European Conference on Computer Vision, 2016: 21- 37.

[25] 刘辉, 彭力, 闻继伟. 基于改进全卷积网络的多尺度感知行人检测算法[J]. 激光与光电子学进展, 2018, 55(9): 091504.

[26] EnzweilerM, EigenstetterA, SchieleB, et al. Multi-cue pedestrian classification with partial occlusion handling[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2010: 990- 997.

[27] Ouyang WL, Wang XG. A discriminative deep model for pedestrian detection with occlusion handling[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2012: 3258- 3265.

[29] Lawrence ZitnickC, DollárP. Edge boxes: locating object proposals from edges[C]. European Conference on Computer Vision, 2014: 391- 405.

[30] Ouyang WL, Wang XG. Single-pedestrian detection aided by multi-pedestrian detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2013: 3198- 3205.

[31] LuoP, Tian YL, Wang XG, et al. Switchable deep network for pedestrian detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2014: 899- 906.

[34] DollarP, WojekC, SchieleB, et al. Pedestrian detection: A benchmark[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2009: 304- 311.

Article Outline

王霞, 张为. 基于联合学习的多视角室内人员检测网络[J]. 光学学报, 2019, 39(2): 0210002. Xia Wang, Wei Zhang. Multi-View Indoor Human Detection Neural Network Based on Joint Learning[J]. Acta Optica Sinica, 2019, 39(2): 0210002.