基于图像质量和注意力的宫腔镜视频关键帧提取  下载: 947次

下载: 947次

1 引言

在医院或诊所里,妇科医生每天要为大量的病人做宫腔镜视频检查,相应的视频被保存在数据库中,用于病例对比、病史追踪、医学研究等。这些视频都是连续的、未经编辑的帧序列,其中只有少部分帧有助于诊断病情,所以宫腔镜视频中存在着大量的冗余数据。专家在查阅这些视频资料时,为避免错过关键信息,只能依次浏览所有图像帧,这一过程非常浪费时间,降低了医生的工作效率[1]。为此,相关的研究主要致力于从宫腔镜视频中提取关键帧(摘要),以供快速浏览和检索。具体实现时,采用的技术主要有K-means聚类[2]、最小生成树[3]、支持向量机[4]、稀疏重构[5-7]等。此外,文献[

8-10]中对多个低级特征(如颜色直方图、颜色矩、惯性矩、边缘等)进行加权融合,用于筛选关键帧。但这些方法都没有使用高级的语义特征,而且都是用于提取普通视频摘要的方法,所以用于宫腔镜视频提取时效果不佳。近年来,Ejaz等[11-13]开始使用视觉注意力模型来解决这一问题。其中文献[

11]中在评估注意力值时使用了运动显著性、多尺度颜色对比度和纹理显著性。运动显著性属于动态注意力,它反映了镜头的运动量,从而间接地反映了医生对当前帧的感兴趣程度。文献[

12]中在Ejaz等的基础上增加了曲率特征,以强调方向不变性。随后,Muhammad等[13]又在此基础上做出改进:1) 使用COC(color opponent color)颜色空间,更符合人类视觉系统[13];2) 使用积分图像,减少了重复计算。总之,基于注意力模型的方法融合了高级语义信息,因而更符合人类视觉感知,实验效果也较好。但是文献[

11-13]都是将注意力曲线等分为

2 基本原理

2.1 视觉注意力评估

医生在给患者做宫腔镜检查时,并不是以恒定速度移动摄像设备,其中大部分时间都是用于搜索感兴趣区域,一旦找到相关区域,就会以缓慢的速度移动镜头,甚至保持相对静止,以仔细观察该病理区域,这一区域的视觉注意力值较高。相反,当医生遇到非兴趣区域时,快速移动宫腔镜,相应的注意力值较低。这就是宫腔镜视频中隐含的视觉注意力模型。因此,可以由镜头内物体的位移量来估计镜头位移量(运动显著性),进而计算注意力值。本文的处理思路是从相邻帧中寻找匹配的特征点,然后根据匹配点的位置变化来求取物体的位移量。

本文采用了文献[ 15]中提出的SURF特征,这是一种局部图像特征,它对缩放、旋转、平移等具有较好的稳健性[16]。但是实验发现,直接对宫腔镜视频中的帧提取SURF特征时,无法获取足够多的稳定的特征点。文献[ 17]中指出,SURF特征点容易集中在图像中纹理特征丰富的区域,据此,先对原始帧求取对应的LBP(local binary patterns)图像,然后在此基础上提取SURF特征点。其中,LBP是一种纹理特征,具有较高的区分性、较低的计算量[18-19]。文献[ 20]中先对原图求取LBP图,然后从中提取SURF特征点,用于服装分类;而文献[ 21]中首先提取图像的颜色不变量边缘特征[22]和 CS-LBP(central symmetry-local binary patterns)[23]纹理特征形成融合特征灰度图,并从该图中提取SURF特征点。

对于某一宫腔镜视频,设其采样后共有l帧,记为

1) 分别求取

2) 从

3) 使用RANSAC(random sample consensus)[24]算法求取

4) 计算镜头位移量(运动显著性):

按照步骤1)~2)依次计算各帧的运动显著性,得到集合{

并依次求各帧的注意力值:

2.2 基于离散余弦变换(DCT)系数的图像锐利度评估

文献[ 26]的研究发现:对于散焦图像,其归一化DCT系数趋于低频加强;对于聚焦准确的图像,其归一化DCT系数趋于均匀分布,所以可以通过评估图像DCT系数分布的均匀程度,来计算图像的锐利度[26-27]。图像的DCT系数越趋于均匀分布,则其锐利度越高,而衡量一个分布的均匀程度可以使用熵的方法。贝叶斯熵[28]的定义为

式中:

式中:

图像

3 基于图像质量和注意力的关键帧提取

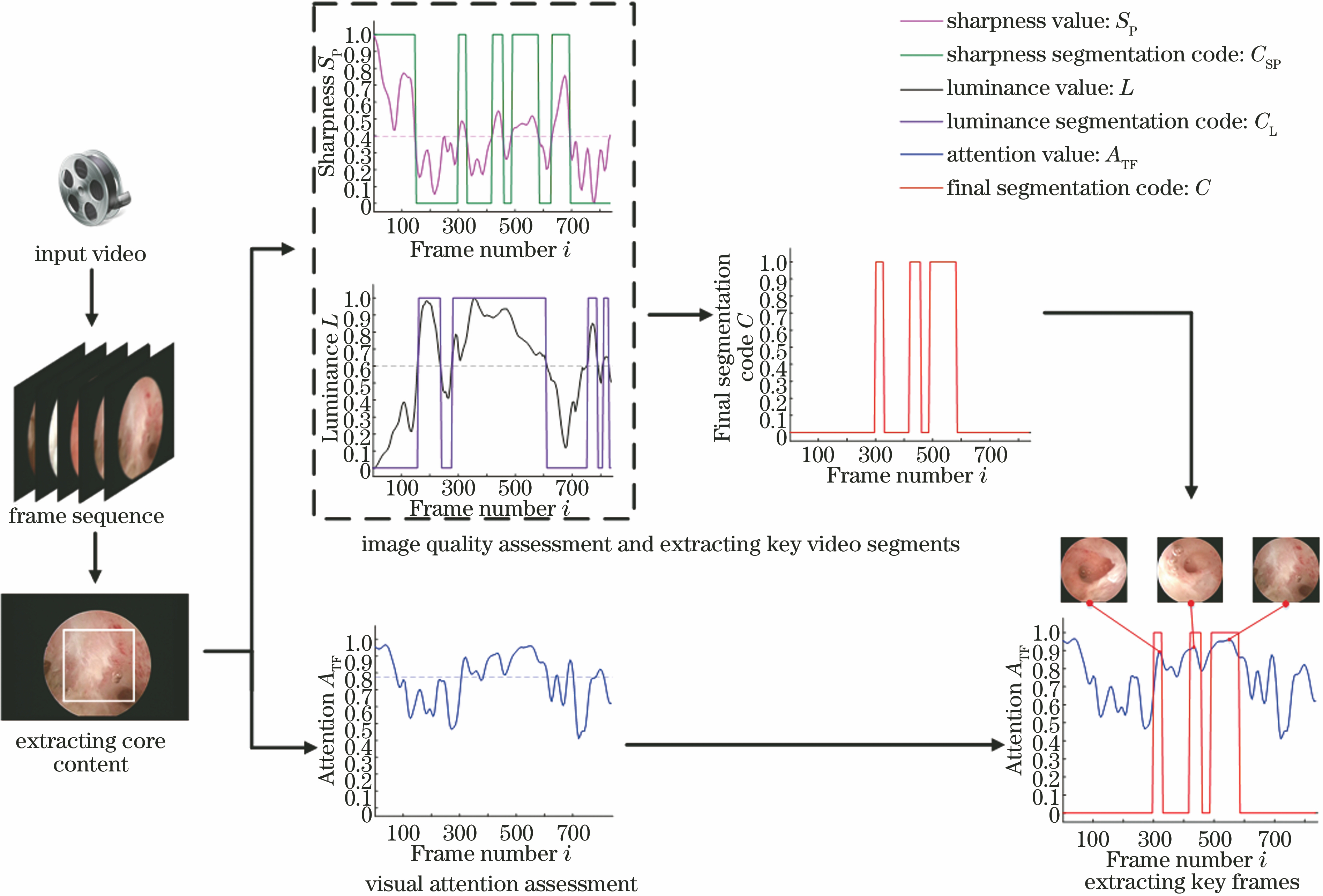

所提方法的整体框架如

3.1 粗筛选

对于给定的某一视频(采样后,共有

两种图像质量评分标准各有侧重,二者互为补充。因此,本文约定对于视频中某个片段,只有当所有图像质量指标都达标时,才能成为关键视频段。相应地,本文将两种图像质量的编码序列进行与操作,即

式中:符号“&”表示“与操作”;

而那些长度太短的关键视频段,可以被视为噪声、干扰。因此,对长度低于

通过图像质量评估、提取关键视频段,去除大部分图像质量较差的无意义帧,缩小了筛选关键帧的范围,这一部分被视为关键帧的粗筛选。

3.2 提取关键帧

对于给定的宫腔镜视频,按照3.1节的算法,可以将其分为数个关键片段、无意义片段(二者相间分布)。其物理意义是,每一个关键视频段都对应于一个观察目标(或一个观察区域),而无意义视频段则是其间的过渡片段。

但是,关键视频段内的帧并非都是关键帧。所以需要使用视觉注意力做进一步的筛选。当宫腔镜移动到感兴趣的病理区域时,医生会缓慢地移动镜头,甚至保持相对静止,以仔细观察相应的目标(此时注意力值较高)。根据这一理论基础,本文在各关键视频段中选择注意力值最高的帧作为关键帧(如

4 实验及分析

4.1 实验设置

实验环境为Intel i5-3230M 处理器,12 GB内存,采用Matlab R2016a 编程。实验所用数据集包含了30个宫腔镜视频,其视频长度从0.5 min到2 min不等,帧速为25 frame/s,帧尺寸为768 pixel×576 pixel 。另外,由两名妇科专家负责标记出关键视频片段(ground truth),这一点与文献[

13]一致。最终,专家标注出的片段共有48个,即

此外,由于所用的视频数据都是实际的宫腔镜检查视频,情况比较复杂,在视频首尾都各有一个无意义片段(准备开始阶段、准备结束阶段),时长均约为6 s,这属于该数据集本身的特性。所以在实验中,对所有方法都增加如下步骤:遍历所有选出的关键帧,若相应的帧被包括在首尾无意义片段内,则予以去除。

4.2 评价机制

对于某宫腔镜视频,假设专家标出

在以上约定下计算召回率、精确率和

4.3 实验结果及分析

表 1. 各方法的实验结果对比

Table 1. Comparison of experimental resultsby each method

|

由

文献[

11,13]都是将视频等分为

以视频4为例,专家标记出了一个关键片段。

图 3. 视频4的图像质量曲线及其相应的视频分段结果

Fig. 3. Image quality curve of video 4 and corresponding video segmentation results

图 4. 视频4的最终分段结果及所提方法选择出的关键帧

Fig. 4. Final segmentation results of video 4 and key frames selected by proposed method

图 5. 各个方法在视频8中提取的关键帧的对比

Fig. 5. Comparison of key frames extractedfrom video 8 by each method

5 结论

通过图像质量评估获得相应的质量曲线,并以此进行自适应的视频分段,选出关键片段,从而实现关键帧的粗筛选,这一过程滤除了大部分无意义帧,有效地提高了精确率。此外,取相邻的两帧,求得其LBP图像,然后从中提取SURF特征点,并根据匹配特征点的像素位置计算运动量,进而评估当前帧的注意力值。在评估视觉注意力时,与Lucas Kanade光流法相比,所提方法的计算速度更快,且其精确率、

[4] ChenJ, Zou YX, WangY. Wireless capsule endoscopy video summarization: A learning approach based on Siamese neural network and support vector machine[C]∥International Conference on Pattern Recognition, December 4-8, 2016, Cancún Center, Cancún, México. New York: IEEE, 2016: 1303- 1308.

[7] Ma MY, MetS, HonJ, et al. Nonlinear kernel sparse dictionary selection for video summarization[C]∥IEEE International Conference on Multimedia and Expo, July 10-14, 2017, Hong Kong, China. New York: IEEE, 2017: 637- 642.

[14] Lucas BD, KanadeT. An iterative image registration technique with an application to stereo vision[C]∥International Joint Conference on Artificial Intelligence, August 24-28, 1981, Vancouver, British Columbia. [S. l. : s. n.], 1981: 674- 679.

[15] BayH, Tuytelaars T, van Gool L. SURF: Speeded up robust features[C]∥European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2006: 404- 417.

[16] 王民, 李泽洋, 王纯, 等. 基于压缩感知与SURF特征的手语关键帧提取算法[J]. 激光与光电子学进展, 2018, 55(5): 051013.

[17] 韩天庆, 赵银娣, 刘善磊, 等. 空间约束的无人机影像SURF特征点匹配[J]. 中国图象图形学报, 2013, 18(6): 669-676.

[19] 杨恢先, 陈永, 张翡, 等. 基于改进梯度局部二值模式的人脸识别[J]. 激光与光电子学进展, 2018, 55(6): 061004.

[20] SurakarinW, ChongstitvatanaP. Classification of clothing with weighted SURF and local binary patterns[C]∥International Computer Science and Engineering Conference, Nov. 23-26, 2015, Chiang Mai, Thailand. New York: IEEE, 2015: 1- 4.

[21] 罗天健, 刘秉瀚. 融合特征的快速SURF配准算法[J]. 中国图象图形学报, 2015, 20(1): 95-103.

[22] Geusebroek J M, van den Boomgaard R, Smeulders A W M, et al. . Color invariance[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(12): 1338-1350.

[23] HeikkiläM, PietikäinenM, SchmidC. Description of interest regions with center-symmetric local binary patterns[M]. Computer Vision, Graphics and Image Processing. Berlin, Heidelberg: Springer, 2006: 58- 69.

[25] 靳京京, 卢文龙, 郭小庭, 等. 基于SURF和RANSAC算法的同步相移干涉图位置配准方法[J]. 光学学报, 2017, 37(10): 1012002.

[27] 王志明. 无参考图像质量评价综述[J]. 自动化学报, 2015, 41(6): 1062-1079.

[28] . C-[J]. Devijver P A. On a new class of bounds on Bayes risk in multihypothesis pattern recognition. IEEE Transactions on Computers, 1974, 23(1): 70-80.

Article Outline

苗强强. 基于图像质量和注意力的宫腔镜视频关键帧提取[J]. 激光与光电子学进展, 2019, 56(6): 061004. Qiangqiang Miao. Key Frame Extraction of Hysteroscopy Videos Based on Image Quality and Attention[J]. Laser & Optoelectronics Progress, 2019, 56(6): 061004.

![文献[13]中的方法对视频4的处理结果](/richHtml/lop/2019/56/6/061004/img_2.jpg)