基于相位辅助系统的三维纹理映射和成像  下载: 798次

下载: 798次

1 引言

随着计算机图形学、计算机视觉技术以及计算机硬件技术的飞速发展,人们对目标物体的结构和形状的了解需求越来越迫切,故三维成像技术吸引了越来越多学者的关注[ 1 - 4 ]。三维建模技术可模拟沉浸式逼真三维模型或场景,具有自由的交互性,已成为人们认识客观世界的重要途径和工具。

传统的建模软件如 AutoCAD、Unigraphics(UG)、Pro/Engineer等,在建立三维模型时,不能实现对复杂结构物体或自由曲面物体的精确建模,或对复杂物体的建模不能满足工业精度需求。光学三维数字化技术的出现和发展给这一难题提供了有效的解决方案[ 5 - 6 ],该技术具有扫描速度快、精度高、主动性强、操控性和交互性优良等特点[ 7 ]。

仅对目标物体几何造型的重建(如工业产品的外形、尺寸),限制了其在虚拟现实、增强现实、影视娱乐、以及文物保护等领域的应用。因此,目标物体的表面纹理属性(如色彩、材质)的构建尤为重要。构建复杂物体的表面纹理属性时,需要把采集到的纹理照片映射到目标三维模型表面,以得到不同视角的纹理面片。纹理映射实质上是建立二维参数域和三维空间曲面的映射函数,使得三维空间曲面上任意一点在二维参数域中有对应的纹理坐标,设三维点

由于存在遮挡,单视角的纹理映射通常难以覆盖整个物体,通常需要采集不同视角拍摄的纹理照片,并映射到目标物体表面,从而得到纹理面片。由于目标物体的成像受到光照、拍摄角度、物体表面非完全漫反射、深度匹配、重建误差以及累积误差等因素的影响,纹理面片上通常会产生明显的人工痕迹或者纹理接缝,降低重建模型的真实性[ 8 - 11 ]。Seitz等[ 12 ]根据拍摄视角与目标物体之间的位姿关系和三角形面片的可见性与拍摄视场的对应关系来确定边缘三角形,并通过对边缘三角形的操作实现物体表面区域纹理的色彩过渡。该方法中对边缘三角面片区域的选择是纹理融合成功的关键。Rocchini等[ 13 ]采用纹理图与几何模型捆绑的方式进行纹理融合,并通过区域生长和迭代寻找邻近的三维点,使目标纹理尽可能来自同一区域,以保证区域纹理的连续性。当区域纹理色彩差异较大时,该方法不能实现纹理的平滑过渡。Beauchesne等[ 14 ]和Bannai等[ 15 ]利用重光照和外推法进行纹理融合,但该方法无法保证所得到的纹理色彩是全局最优的融合色彩。Callieri等[ 16 ]和Liu等[ 17 ]根据相机拍摄物体的姿态特性,分别定义了纹理权重函数和均值权重进行物体表面色彩的融合,实现色彩的自然过渡。此外,Gal等[ 10 , 18 - 19 ]则用镶嵌方法进行纹理融合,利用图像分割的方法对目标表面进行划分,确定各区域对应的纹理,然后通过边缘纹理的操作实现纹理融合。复杂结构拓扑物体的纹理融合是一个难题,加上深度像匹配误差以及重建模型物体误差的累积等外界因素,因此高质量的纹理重建工作十分具有挑战性。

本文提出一种基于结构光扫描系统的高保真三维模型纹理重建实现方法。该方法利用结构光扫描系统投影目标物体进行数据采集,将采集到的局部坐标数据匹配到同一世界坐标系下,建立目标物体的深度数据模型;然后将采集的实拍纹理照片映射到重建的深度数据模型上,并对深度数据表面的纹理信息进行处理,恢复目标模型表面的纹理属性。与文献[ 3 ]的方法相似,本文方法通过建立在目标模型表面的能量优化目标函数,利用优化策略对目标函数进行优化求解。此外,本文方法通过对纹理图与几何模型的配准以及局部缺失纹理的优化,增强了重建模型的纹理细节,提高了重建模型的逼真度。

2 系统成像原理

2.1 数据采集

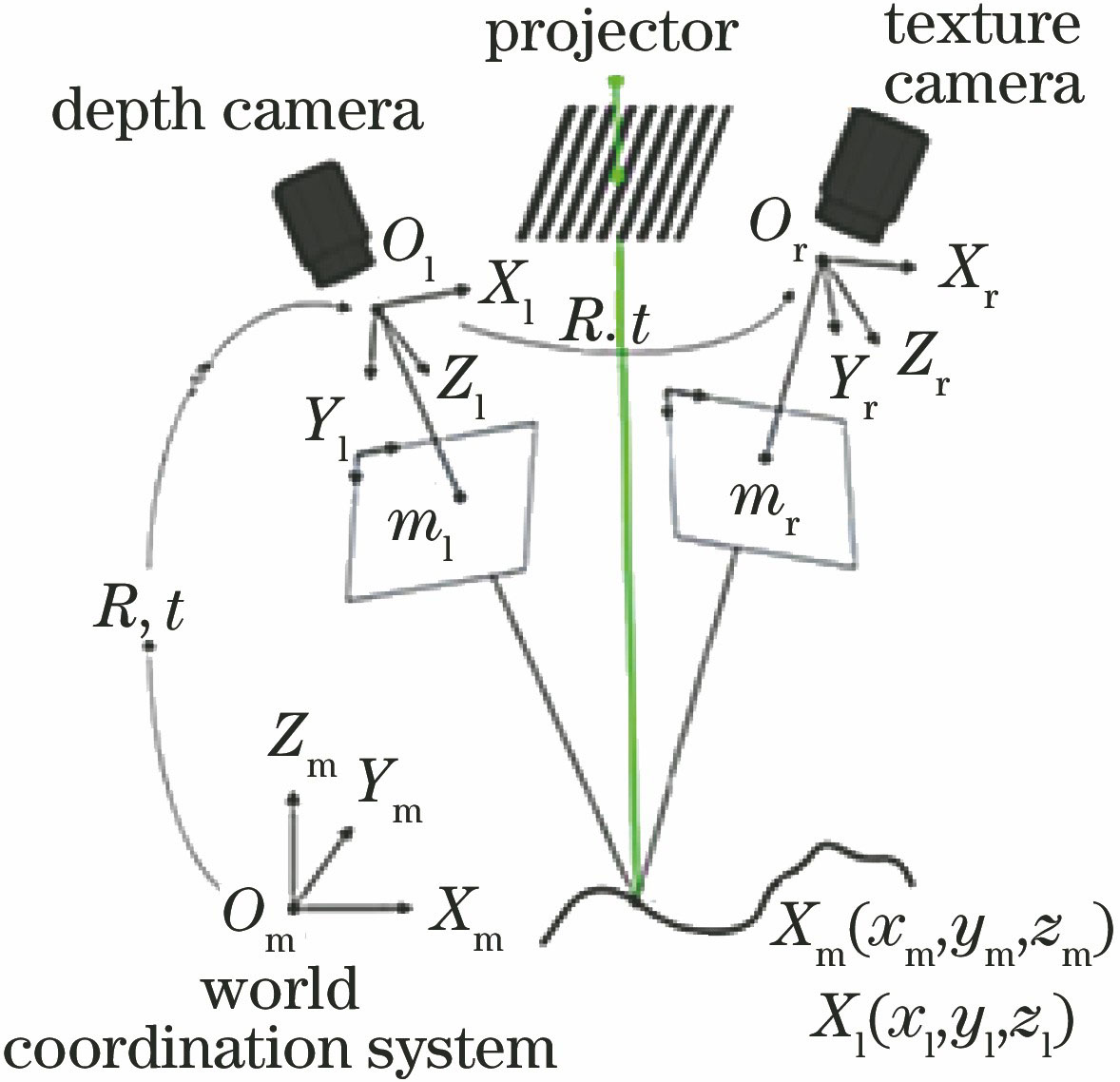

系统结构如

在数据采集前,需要对系统的参数进行标定,确定采集系统的参数(相机的主点、焦距、畸变系数等)。利用文献[ 22 ]的方法对系统参数进行标定,该方法利用测量空间体内对平面标靶的几次摆动实现相机参数的测量,同时对系统的相机畸变系数和系统误差进行估计,并通过优化参数,保证系统采集数据的精度(系统标定误差可达到0.02 pixel)。然后采用文献[ 23 ]的方法围绕目标物体进行数据采集,从而得到不同局部坐标系下的目标物体数据。

2.2 数据的预处理与几何建模

由于受相机畸变、误差、噪声,以及环境等因素的影响,采集的数据通常会产生散乱点数据、少量孤立的点云数据等,这些数据在所采集的数据中所占的比例较小,但对结果的影响较大。因此,在数据处理之前,需要对采集的原始数据进行数据预处理:1) 设定测量范围,对背景数据、遮挡等不在测量范围内的数据进行清理;2) 对孤立的点云数据进行检测,设定距离阈值(通常设为系统误差的

假设采集的深度像坐标为

式中:

图 2. 不同坐标系下深度数据及其匹配结果。 (a)局部坐标;(b)世界坐标;(c)利用重叠区域进行深度数据匹配的结果

Fig. 2. Depth data at different coordinates and the matching result. (a) Local coordinate; (b) world coordinate; (c) matching result using the overlapping areas

采用与文献[ 23 ]方法类似的缝合法对采集的数据进行融合。与文献[ 23 ]方法不同的是,本实验在融合过程中首先对采集的数据进行数据预处理,包含对孤立点云的检测与删除、点云数据的三角网格化,并利用三角网格中点、面以及特征曲线的约束关系对重叠区域的冗余数据进行约束,以保证数据融合后曲率的连续性。

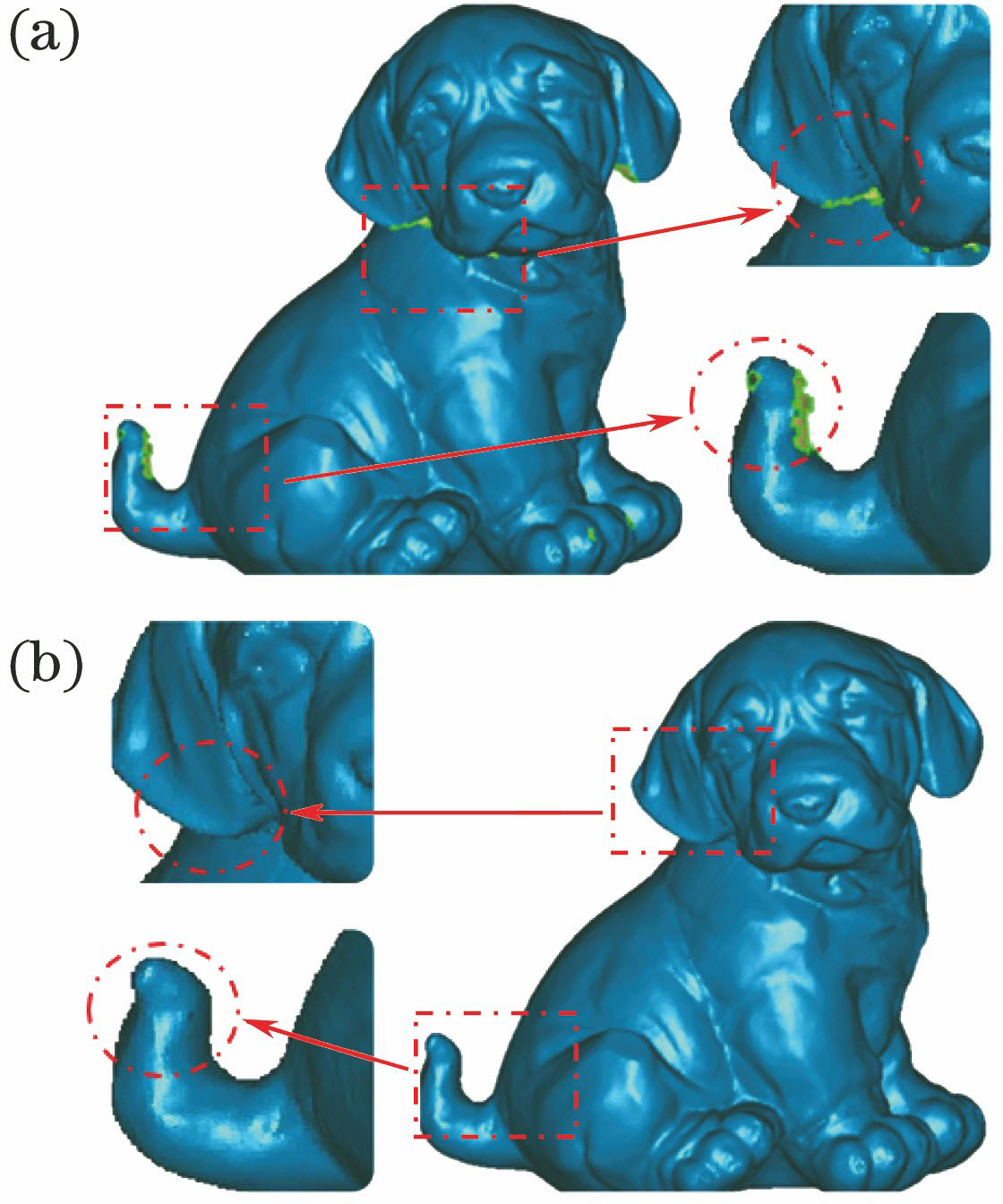

由于采集的数据受周围环境噪声、采集设置的误差、曲面的遮挡等因素的影响,目标物体获取过程中存在数据缺失等问题,缺失的数据会给目标物体网格重建带来困难,使目标网格产生几何错误或拓扑结构错误,从而影响目标模型的精度和最终结果。因此,本文方法对采集的缺漏数据进行修复,首先对孔洞周围的特征点进行检测,并形成特征曲线,然后根据孔洞周围的曲率、拓扑结构等信息重建得到的特征曲线,将原来的缺失孔洞分成若干个子洞,并利用三次样条拟合完成孔洞的修补。由于在孔洞修复过程中提取孔洞周围的特征数据,并在修复过程中加入了曲率等约束条件,该修复算法能够很好地将孔洞周围的特征结构传递到缺失的区域,较好地实现了孔洞的修补(

图 3. 数据融合结果。(a)缺失的深度数据及局部放大效果图;(b)数据融合及局部放大效果图

Fig. 3. Results of data fusion. (a) Local missing data and local renderings; (b) result of data fusion and local renderings

对局部坐标采集的数据

式中:

2.3 纹理关联映射

假定目标物体几何模型为

假设空间三维点为

式中:

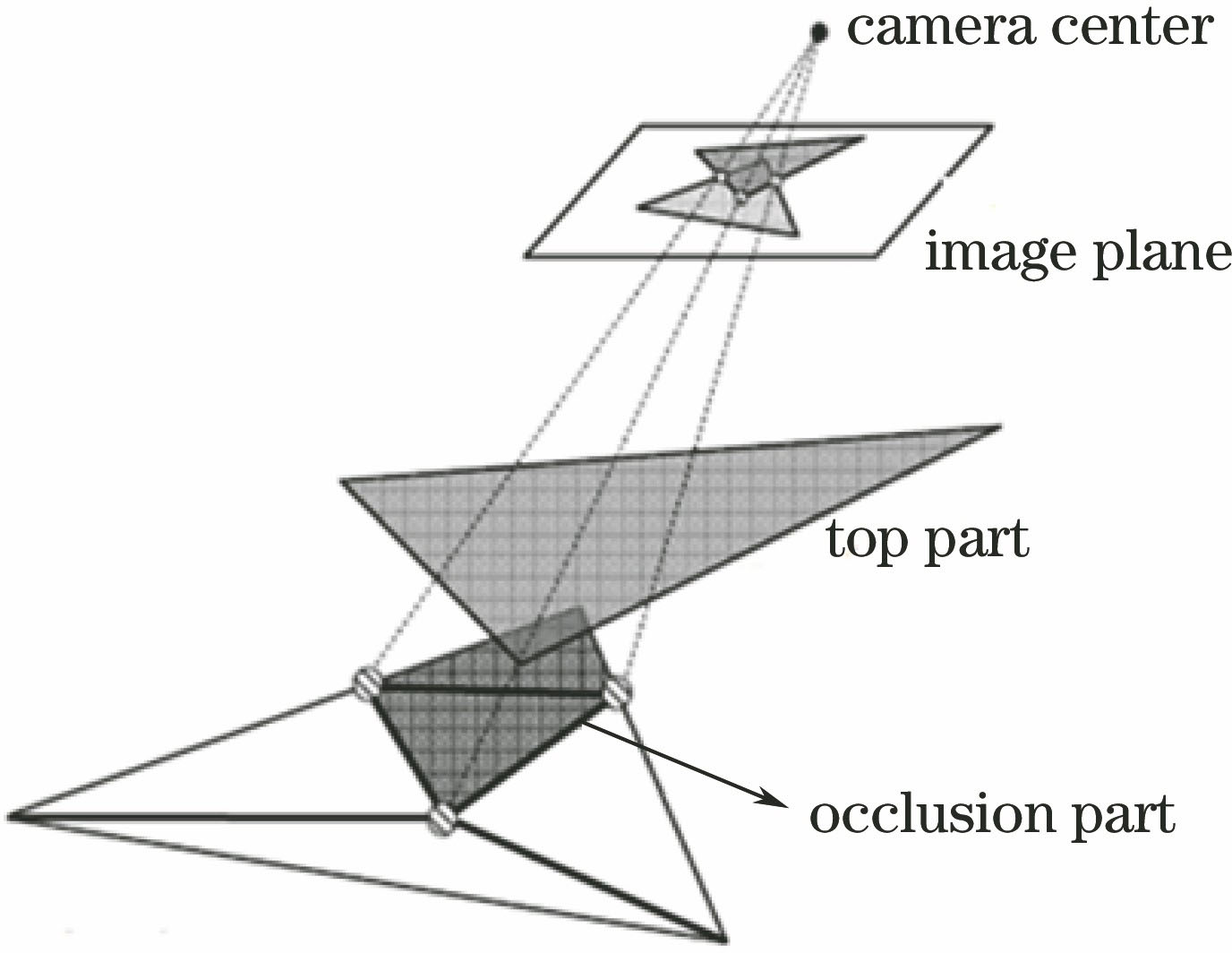

在纹理映射投影变换前,需对目标物体进行遮挡判断,确定投影到纹理坐标的深度数据未被遮挡,否则纹理映射就会出错(把纹理映射到遮挡部分,如

图 4. 根据目标物体与相机的姿态确定物体遮挡区域

Fig. 4. Occlusion area of object according to the object and camera position

值得注意的是,在对结构复杂的曲面目标物体进行纹理映射时,必须先进行遮挡判断,否则就会把采集到的纹理照片映射到被遮挡的部分(

3 纹理融合处理

3.1 纹理优化

目标物体的几何模型为

式中:

3.2 残余纹理的处理

将能量优化标识的目标纹理照片映射到几何模型表面,从而保证了最优的几何模型表面纹理。然而,为了尽可能逼真地还原物体的真实纹理信息,还需对映射到模型表面的纹理进行进一步处理。假设

确定面片

假设确定面片

首先,通过几何模型表面的纹理优化,对目标模型表面的纹理相关性进行优化,减少目标区域间的纹理差异;然后,通过对边缘纹理的融合处理,对区域残余的纹理进行了有效融合,实现了目标表面纹理的平滑过渡。

3.3 缺失纹理的处理

对于拓扑结构或形貌复杂的目标物体,采集的纹理图片通常难以完全覆盖目标物体,或者存在局部纹理的缺失,这就需要根据目标纹理周围的色彩对缺失纹理进行修复,如文献[ 25 ]根据周围的纹理对目标表面纹理进行泊松融合。

泊松融合是根据最小化源图像和目标图像的梯度场差异来实现纹理融合,假设函数

式中:

与文献[

25

]不同的是,本实验在三维网格曲面上进行纹理修复,拓展了其应用范围,其算法的复杂性和计算量都增大。在实验中,将纹理缺失区域划定为待求解融合区域,周围的纹理色彩目标源区域的图像融合是以目标源区域的纹理为指导,将目标源区域的纹理平滑扩散到融合区域,使融合后的图像能无缝地融合到目标场景中,并且色调和光彩与目标源图像一致。在实验中需要求解待融合区域和目标源区域的梯度场,计算融合图像的梯度场,并计算融合图像的散度;然后根据融合图像的散度并结合边缘约束条件建立方程,求解方程得到融合区域的纹理。

图 5. 缺失纹理的修复。(a)修复前;(b)修复后

Fig. 5. Repair of the missing texture. (a) Before repair; (b) after repair

3.4 细节优化

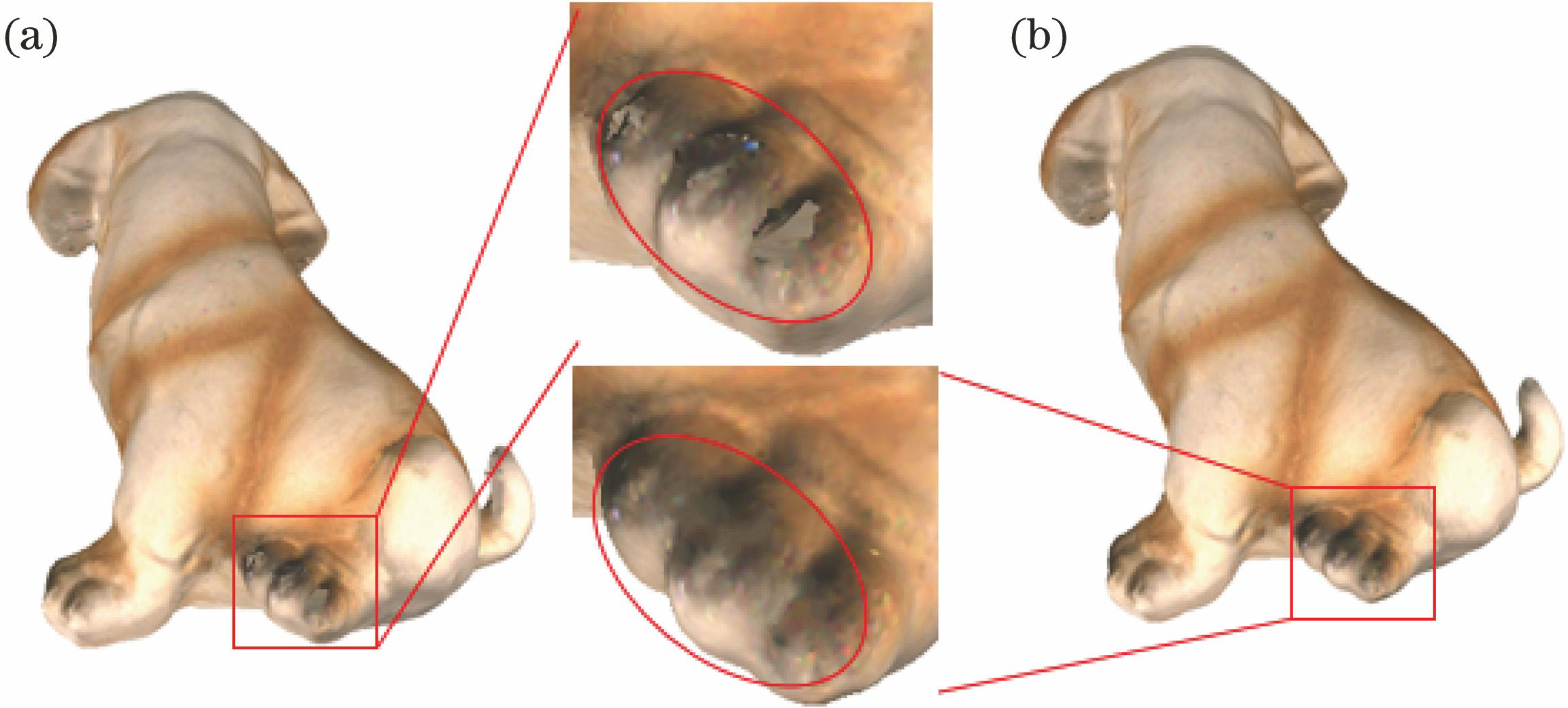

建模过程受到噪声、投影设备的非线性响应,以及重建过程中产生的误差累积的影响,最终会模糊重建模型的纹理细节,严重时会有纹理错位现象产生(

光束平差算法对误差进行优化求解,通过对空间三维点坐标的投影和图像对应点之间的误差优化得到采集系统的相关参数(相机的焦距、位置、投影参数矩阵)。假设

式中:‖·‖表示图像点的欧氏距离。如果空间点

由于场景中特征点较多,该问题的求解通常是一个高维的非线性优化过程。在算法实际应用中,采用LM算法[ 26 ],设置一个误差容忍度进行全局优化。

4 实验及结果分析

扫描系统为本课题组研制的扫描系统,系统由2个CCD相机(DH-HV1303UM,大恒(集团)有限公司,中国; DH-HV3103UC,大恒(集团)有限公司,中国),分辨率均为1280 pixel×1024 pixel,1个投影仪(Optoma SL1,Optoma,中国),分辨率为1280 pixel×800 pixel,以及本课题组研发的扫描软件系统组成(

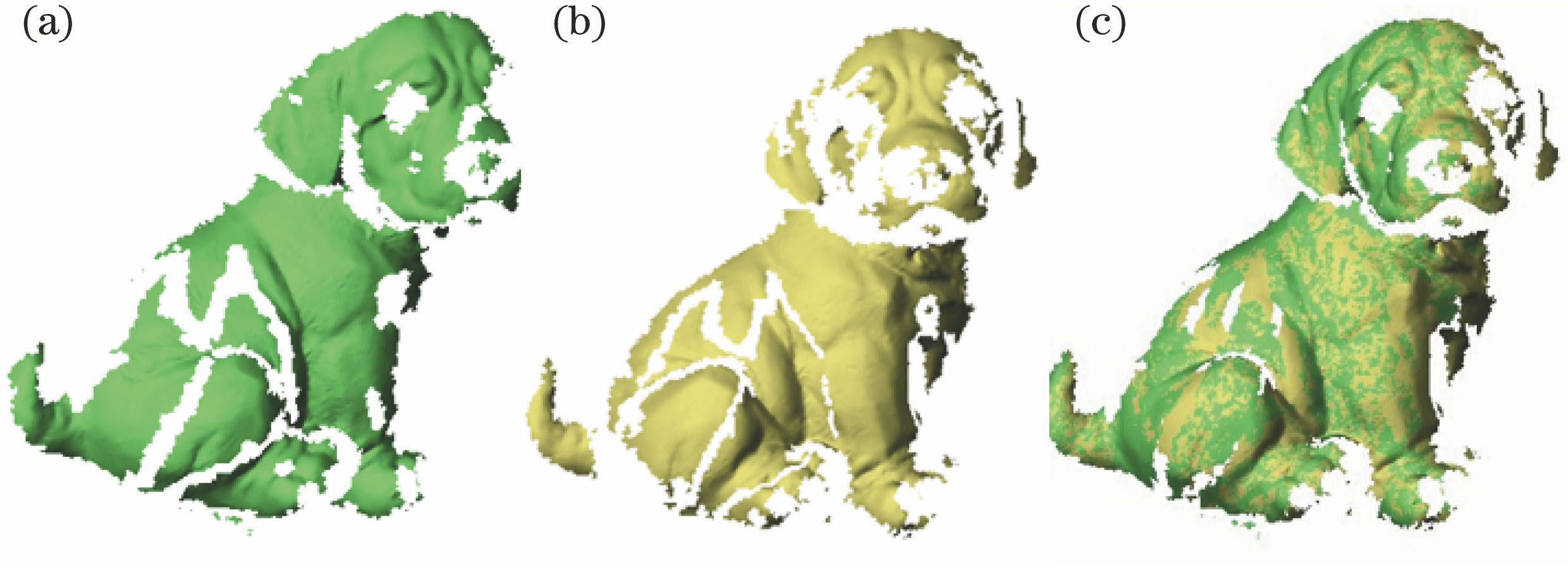

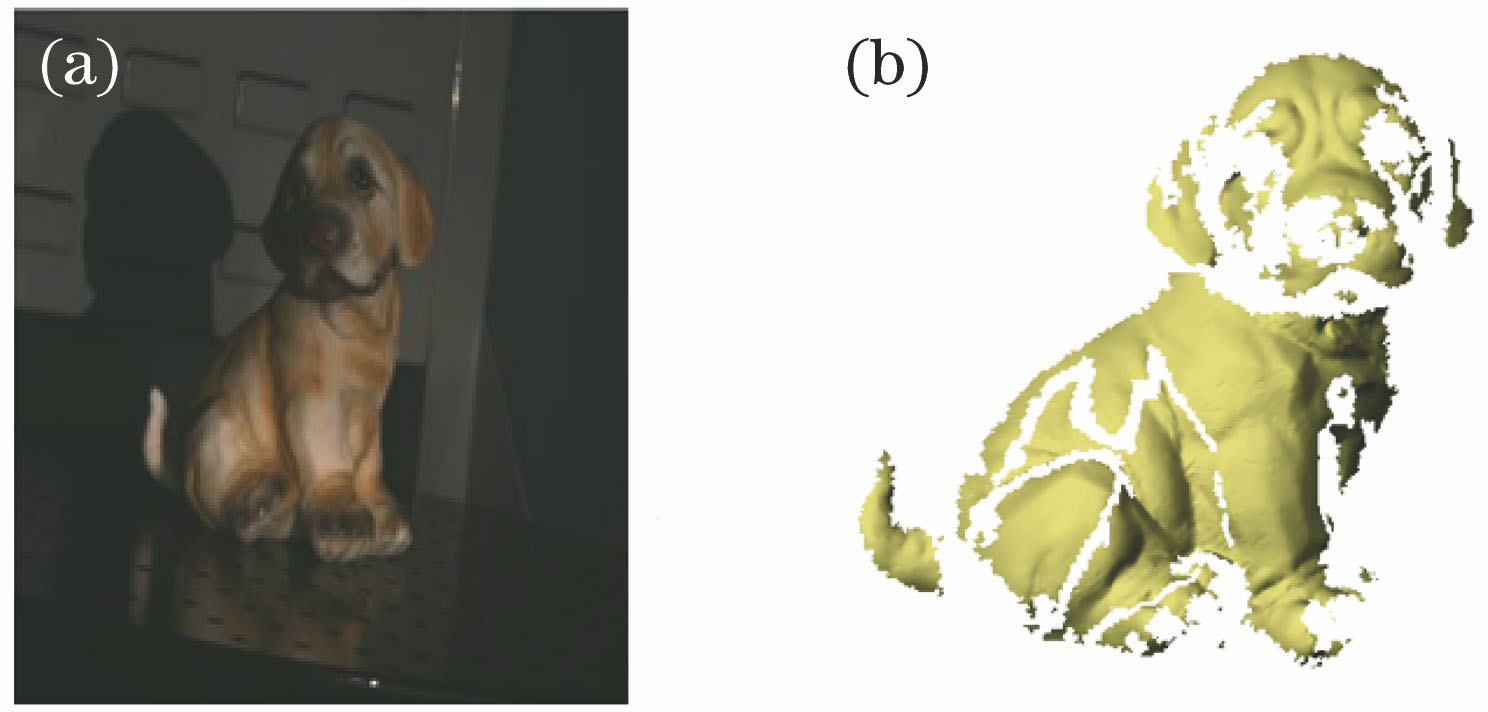

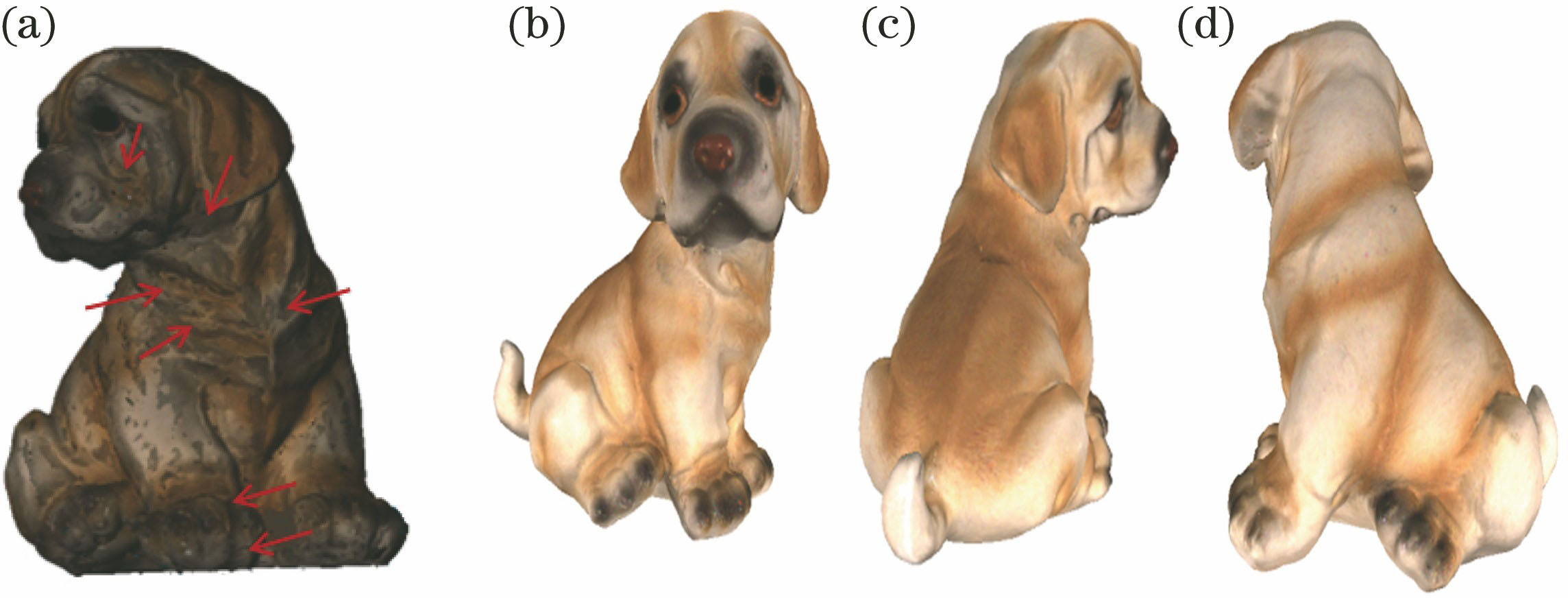

实验对小狗进行相位恢复和纹理重建,小狗呈蹲立状态,尺寸约为15 cm×15 cm×20 cm。将小狗放置在水平旋转平台上,旋转平台,从8个方向围绕目标物体进行数据采集,物体单面采集模型数据的数量为6000~10000(

图 7. 实验采集的数据。(a)局部坐标系下采集的纹理图像;(b)与对应的三维深度数据

Fig. 7. Collection data. (a) Texture image of local coordinate; (b) the corresponding depth data

采集的深度像模型经过数据融合和简化数据处理,消除重叠区域的冗余数据,建立完整的目标物体,融合后小狗模型的三角形面片数为3600,顶点数为1600。对建立的几何模型进行纹理映射,需要确定目标模型与纹理照片的对应关系,即同一表面区域的纹理可能来源于不同视角采集的纹理照片,因此采用纹理优化映射,建立能量优化函数,实现目标表面纹理映射的最优化,然后通过对残余纹理的融合和缺失纹理的修复,实现纹理融合(

本实验还选取了一个花瓶进行纹理重建(

图 8. 实验结果。(a)融合处理前;(b)前视图的融合结果;(c)后视图的融合结果;(d)侧视图的融合结果

Fig. 8. Experimental results. (a) Before fusion treatment; (b) result from front view; (c) result from back view; (d) result from side view

图 9. 花瓶纹理重建结果。(a)目标物体的纹理照片;(b)不同视角下目标物体的纹理照片;(c)目标物体网格模型;(d)融合得到的真实感三维模型

Fig. 9. Experimental results. (a) Texture image of vase and its texture details; (b) texture images from different perspectives; (c) mesh model of vase; (d) texture model of reconstruction after fusion

该套装置的扫描视场为300 mm×300 mm×150 mm,配置的计算机硬件设备为Intel Core(TM) i7-4500u CPU 1.8 GHz, 2.4 GHz 32位Windows操作系统。系统重建的参数如

表 1. 算法运行效率

Table 1. Algorithm efficiency

|

5 结论

利用实拍的纹理照片对目标纹理进行三维重建,建立纹理映射优化函数,实现目标物体表面纹理映射的优化,并对目标物体模型进行了逼真的三维纹理重建。本文算法根据拍摄纹理照片的相关性进行纹理映射,从而在最大程度上保证纹理重建的质量。此外,还对模型局部纹理细节进行了优化,对局部缺失的纹理进行了拟合,保证了重建三维模型纹理的真实性。对表面纹理色彩丰富,特别是目标物体表面具有丰富纹理细节的目标物体进行纹理重建(如物体表面的人物细节特征)时,需要保证纹理照片与几何模型的匹配精度,才能得到细节完美的逼真三维模型。否则在目标物体的局部区域会有纹理错位或鬼影现象产生,从而影响模型的真实感。

本实验未对物体表面光反射函数进行重建,如何快速地建立物体表面的光反射属性,获得物体表面的双向反射分布函数,从而更准确地建立合适的光照模型,实现物体表面的纹理融合,这是下一步需要进行研究和解决的问题。此外,对于拓扑结构简单的对称目标物体的三维重建,如何避免深度像匹配算法的局部收敛也是需要考虑的问题。

[1] 肖杨, 胡少兴, 肖深, 等. 从三维激光点云中快速统计树木信息的方法[J]. 中国激光, 2018, 45(5): 0510007.

[2] Andrade B T. Bellon O R P, Silva L, et al . Digital preservation of Brazilian indigenous artworks: Generating high quality textures for 3D models[J]. Journal of Cultural Heritage, 2012, 13(1): 28-39.

[3] ShuJ , LiuY , LiJ , et al . Rich and seamless texture mapping to 3D mesh models[C]∥Chinese Conference on Image and Graphics Technologies. Singapore: Springer , 2016 : 69 - 76 .

[4] Salvi J, Matabosch C, Fofi D, et al. A review of recent range image registration methods with accuracy evaluation[J]. Image and Vision Computing, 2007, 25(5): 578-596.

[5] Karaszewski M, Sitnik R, Bunsch E. On-line, collision-free positioning of a scanner during fully automated three-dimensional measurement of cultural heritage objects[J]. Robotics and Autonomous Systems, 2012, 60(9): 1205-1219.

[6] Goldlucke B, Aubry M, Kolev K, et al. A super-resolution framework for high-accuracy multiview reconstruction[J]. International Journal of Computer Vision, 2013, 106(2): 172-191.

[7] Zhang S. Recent progresses on real-time 3D shape measurement using digital fringe projection techniques[J]. Optics and Lasers in Engineering, 2010, 48(2): 149-158.

[8] Bernardini F, Rushmeier H, Martin I M, et al. Building a digital model of Michelangelo's Florentine Pieta[J]. IEEE Computer Graphics and Applications, 2002, 22(1): 59-67.

[9] Remondino F. Heritage recording and 3D modeling with photogrammetry and 3D scanning[J]. Remote Sensing, 2011, 3(6): 1104-1138.

[10] Gal R, Wexler Y, Ofek E, et al. Seamless montage for texturing models[J]. Computer Graphics Forum, 2010, 29(2): 479-486.

[11] DellepianeM , ScopignoR . Teaching 3D acquisition for cultural heritage: a theory and practice approach[C]. Proceedings of Eurographics Conference , 2012 : 25 - 32 .

[12] Seitz SM , CurlessB , DiebelJ , et al . A comparison and evaluation of multi-view stereo reconstruction algorithms[C]∥ IEEE Computer Society Conference on Computer Vision and Pattern Recognition , 2006 : 519 - 528 .

[13] Rocchini C, Cignoni P, Montani C, et al. Acquiring, stitching and blending diffuse appearance attributes on 3D models[J]. The Visual Computer, 2002, 18(3): 186-204.

[14] BeauchesneE , Sbastien R. Automatic relighting of overlapping textures of a 3D model[C]∥IEEE Computer Society Conference on Computer Vision and PatternRecognition , 2003 : II-166 .

[15] Bannai N, Fisher R B, Agathos A. Multiple color texture map fusion for 3D models[J]. Pattern Recognition Letters, 2007, 28(6): 748-758.

[16] Callieri M, Cignoni P, Corsini M, et al. Masked photo blending: mapping dense photographic data set on high-resolution sampled 3D models[J]. Computers & Graphics, 2008, 32(4): 464-473.

[17] Liu X M, Peng X, Yin Y K, et al. Generation of photorealistic 3D image using optical digitizer[J]. Applied Optics, 2012, 51(9): 1304-1311.

[18] LempitskyV , IvanovD . Seamless mosaicing of image-based texture maps[C]∥IEEE Conference on Computer Vision and Pattern Recognition , 2007 .

[19] Romanoni A, Fiorenti D, Matteucci M. Mesh-based 3D textured urban mapping[J]. IEEE/RSJ International Conference on Intelligent Robots and Systems, 2017: 3460-3466.

[20] 彭翔, 殷永凯, 刘晓利, 等. 基于相位辅助的三维数字成像与测量[J]. 光学学报, 2011, 31(9): 0900120.

[21] Zhang S, Yau S T. High-resolution, real-time 3D absolute coordinate measurement based on a phase-shifting method[J]. Optics Express, 2006, 14(7): 2644-2649.

[22] Zhang Z. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334.

[23] ZhangZ , PengX , ZhangD . Transformation image into graphics [M]. Boston: Springer , 2004 : 111 - 129 .

[24] Besl P J. McKay N D. A method for registration of 3-D shapes[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1992, 14(2): 239-256.

[25] Perez P, Gangnet M, Blake A. Poisson image editing[J]. ACM Transactions on Graphics, 2003, 22(3): 313-318.

[26] Umeyama S. Least-squares estimation of transformation parameters between two point patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1991, 13(4): 376-380.

Article Outline

刘星明, 王辉静, 唐琪, 管明祥, 蔡铁. 基于相位辅助系统的三维纹理映射和成像[J]. 激光与光电子学进展, 2018, 55(12): 121506. Xingming Liu, Huijing Wang, Qi Tang, Mingxiang Guan, Tie Cai. Three-Dimensional Texture Mapping and Imaging Based on Phase-Assisted System[J]. Laser & Optoelectronics Progress, 2018, 55(12): 121506.