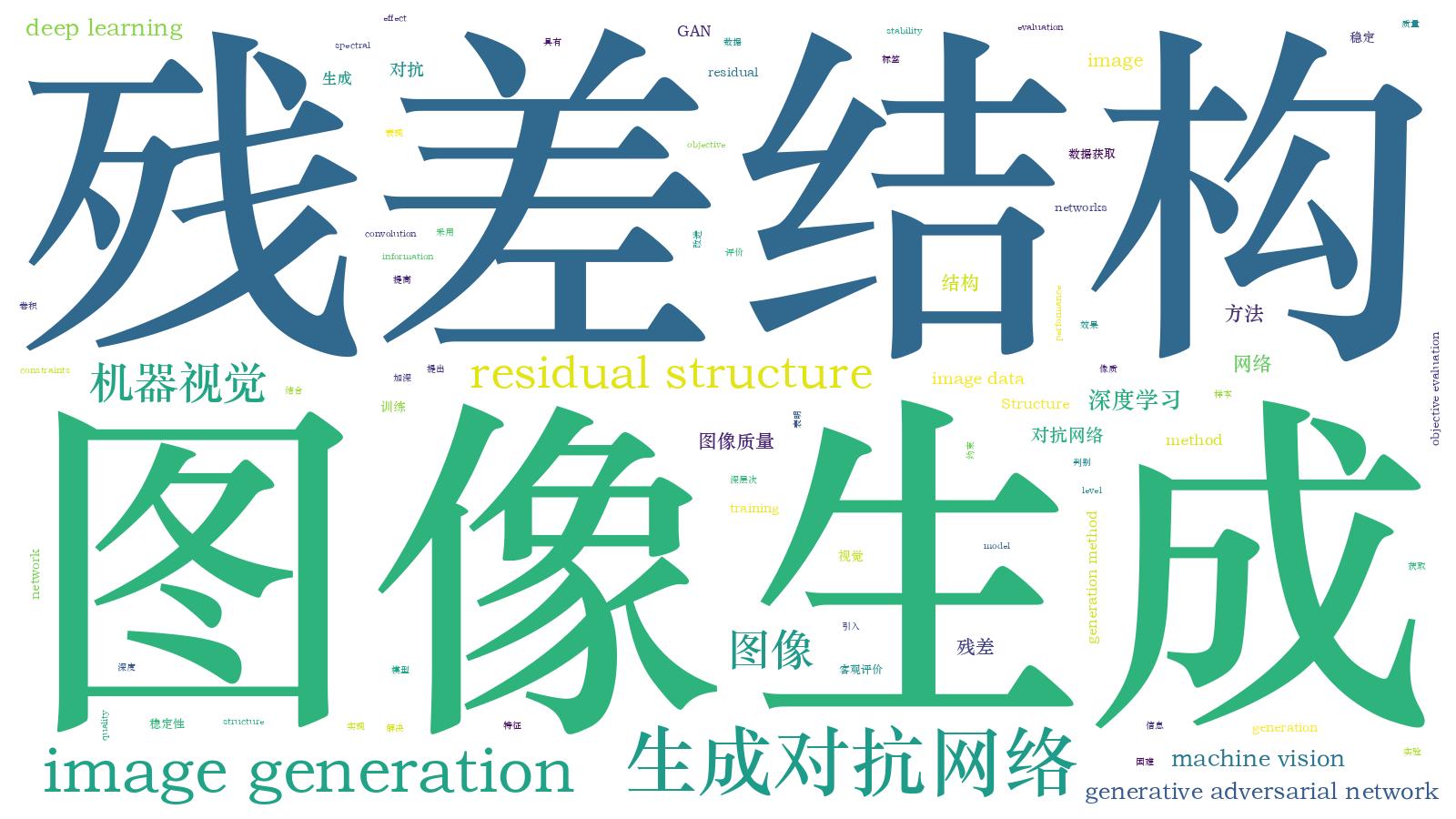

基于残差结构的对抗式网络图像生成方法  下载: 1080次

下载: 1080次

1 引言

在人工智能领域中,大规模的标注图像数据是研究深度学习的前提[1],但受限于环境、人力及物力等因素,对图像数据的获取很困难[2-4]。2014年,Goodfellow等[5]提出的生成对抗网络(GAN)具有能生成新图像样本的能力,该网络的出现对图像数据的获取起到了极大的促进作用,但GAN在训练时难以收敛,模型易崩溃,从而导致生成的图像样本的质量不高,或者无法生成图像[6-10]。2015年,Radford等[11]在GAN中引入卷积神经网络(CNN),从而提出了深度卷积生成对抗网络(DCGAN),并在生成器模型、判别器模型中加入批归一化(BN)层[12],这在一定程度上缓解了GAN的训练不稳定性,但生成的图像质量仍然有待提升。

本文在DCGAN的基础上进行改进,提出了一种基于残差结构的对抗式网络图像数据生成方法。该方法结合残差结构能加深网络深度、获取图像深层语义信息,将其应用在生成器与判别器模型中,通过连接层对训练图像和标签信息进行拼接,从而实现了同步训练,增强了网络对真实图像特征的获取能力;同时,为了增强GAN训练的稳定性,将判别器模型中的BN层替换成谱约束(SN)层,将判别器模型的梯度限制在固定范围内,从而避免了训练过程中生成器与判别器模型更新不均衡导致模型崩溃的问题。实验在SVHN、Cifar-10及CelebA数据集上进行,结果表明,相比于改进前的DCGAN,所提方法训练网络时更加稳定,且生成的图像具有较好的视觉效果及更高的初始分数(IS),生成的图像质量得到了提升。

2 生成对抗网络原理

GAN的思想起源于博弈论,即网络中生成器模型与判别器模型之间的极大极小博弈。其中生成器模型是将输入的服从某一分布的噪声伪装成服从真实图像样本分布的新样本;判别器模型类似于二分类器,用于判断输入图像样本是来自真实图像样本还是生成图像样本,若判定为“真实”,则给出高概率分布,如“1”,反之,则给出低概率分布“0”[13-15]。GAN的目标函数表示为

式中:D为判别器模型,G为生成器模型;z为输入的随机噪声;x为真实样本数据;Pdata(x)为真实样本数据集;Pz(z)为生成器模型生成的样本数据。

3 基于残差结构的生成对抗网络

针对DCGAN训练不稳定、图像质量不高的问题,提出一种基于残差结构的GAN,该网络根据深度神经网络对图像特征的提取能力,将训练图像与图像标签信息同时输入到网络中,通过引入残差结构增强生成器、判别器对真实图像深层特征的提取能力。GAN不稳定的主要原因是生成器与判别器在训练过程中梯度下降不对称,即判别器模型的判别能力优于生成器模型,因此将判别器模型中的BN层替换为谱约束层,以防止判别器收敛过快,使生成器得到充分训练。

残差单元(RBU)是深度残差网络的基本组成部分[16-19],包含BN层、修正线性单元激活函数(ReLU)、卷积层、恒等映射,其结构如

3.1 生成器模型(G-Net)

生成器模型用于捕捉真实样本的分布,使输入的噪声能够通过微步反卷积的方式伪装成真实样本。在DCGAN上进行改进,将生成器模型中反卷积层替换成卷积核大小为3×3、步长为1的残差结构,并在每个残差单元中增加上采样层,以实现每层图像的放大。每个线性卷积层上都使用BN,激活函数使用ReLU,结构如

3.2 判别器模型(D-Net)

判别器模型用于获取输入图像来自真实样本的概率,判别器模型的优劣同样影响到生成图像的质量,若判别器不能正确分辨图像的真实性,则可能导致网络无法生成图像或生成图像单一。如

4 实验与分析

4.1 实验环境及数据集

为了验证所提方法对图像样本生成的有效性,实验采用64位Ubuntu 14.04LTS操作系统、Intel Core i7-4790CPU 3.60 GHz x 8核心处理器、GeForce GTX 1080/Pcle/SSE2图形处理器及Pytorch深度学习框架。实验数据集选用小规模数据集SVHN、Cifar-10、CelebA。其中,SVHN数据集是由大小为32×32的100000张真实场景中的街道门牌0~9数字图片构成,73257张为训练集;Cifar-10数据集由60000张大小为32×32的彩色自然图像构成,其中50000张为训练集,总共分为汽车、马、船、狗等10个类别;CelebA数据集由202599张人脸图片构成,实验中将其标准化到64×64的大小并从中随机抽取60000张作为训练集。

4.2 图像生成

实验中生成器模型、判别器模型的初始权重服从N(0,0.02)的高斯分布,优化方法采用Adam,学习率为0.0002,Beta为0.99,损失函数为BCEloss。SVHN、Cifar-10数据集的批处理数量设为128,CelebA数据集的批处理数量设为64。采用各个数据集的训练集对模型进行训练,先固定生成器模型,更新判别器模型参数,再固定判别器模型,更新生成器模型参数,依次循环,相互迭代。

图 7. SVHN数据集在不同迭代次数下的生成图像

Fig. 7. Generated images of SVHN dataset under different epochs

图 8. Cifar-10数据集在不同迭代次数下的生成图像

Fig. 8. Generated images of Cifar-10 dataset under different epochs

图 9. CelebA数据集在不同迭代次数下的生成图像

Fig. 9. Generated images of CelebA dataset under different epochs

4.3 客观评价

为了更好地评估所提方法与DCGAN的图像质量,采用Salimans等[21]提出的评价生成图像语义的初始分数,该指标从单一图像质量和图像丰富性上进行衡量。如果网络生成的图像具有较好的质量与多样性,那么带有具体标签信息的图像则具有较低的熵,输出图像边缘分布则具有较高的熵,因此,IS越高,意味着生成图像的质量越高。对网络模型所生成的图像进行IS比较,结果如

表 1. 不同数据集的IS

Table 1. IS of different datasets

|

从

5 结论

提出一种基于残差结构的生成对抗网络图像生成方法。该方法在模型中引入残差结构以加深网络深度,提高网络对真实图像数据的深层特征提取能力,并通过谱约束限制判别器模型的梯度范围,提升了网络的稳定性。在各个数据集上的图像生成实验表明,所提方法在生成图像的视觉效果、客观评价(IS)上均高于DCGAN,网络也更为稳定,具有更优的图像生成能力。

[1] LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[2] Salamon J, Bello J P. Deep convolutional neural networks and data augmentation for environmental sound classification[J]. IEEE Signal Processing Letters, 2017, 24(3): 279-283.

[3] Wang K F, Zuo W M, Tan Y, et al. Generative adversarial networks: from generating data to creating intelligence[J]. Acta Automatica Sinica, 2018, 44(5): 769-774.

[4] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[5] Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al. Generative adversarial nets[C]∥Proceedings of the 27th International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Quebec. New York: Curran Associates, 2014, 2: 2672- 2680.

[6] 李航. 统计学习方法[M]. 北京: 清华大学出版社, 2012: 13- 15.

LiH. Statistical learning method[M]. Beijing: Tsinghua University Press, 2012: 13- 15.

[7] Zhu JY, ParkT, IsolaP, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice. New York: IEEE, 2017: 2223- 2232.

[8] ChenX, DuanY, HouthooftR, et al. InfoGAN: interpretable representation learning by information maximizing generative adversarial nets[C]∥Proceedings of the 30th International Conference on Neural Information Processing Systems, December 5-10, 2016, Barcelona, Spain. New York: Curran Associates, 2016: 2180- 2188.

[9] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15: 1929-1958.

[10] GulrajaniI, AhmedF, ArjovskyM, et al. ( 2017-12-25)[2020-01-01]. https:∥arxiv.org/abs/1704. 00028.

[11] RadfordA, MetzL, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks[EB/OL]. ( 2016-01-07)[2020-01-01]. https:∥arxiv.org/abs/1511. 06434.

[12] GirshickR. Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1440- 1448.

[13] ArjovskyM, ChintalaS, BottouL. Wasserstein generative adversarial networks[C]∥Proceedings of the 34th International Conference on Machine Learning, August 6-11, 2017, Sydney, NSW, Australia. New York: Curran Associates, 2017, 70: 214- 223.

[14] 王坤峰, 苟超, 段艳杰, 等. 生成式对抗网络GAN的研究进展与展望[J]. 自动化学报, 2017, 43(3): 321-332.

Wang K F, Gou C, Duan Y J, et al. Generative adversarial networks: the state of the art and beyond[J]. Acta Automatica Sinica, 2017, 43(3): 321-332.

[15] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[16] MiyatoT, KataokaT, KoyamaM, et al. ( 2018-02-16)[2020-01-01]. https:∥arxiv.org/abs/1802. 05957.

[17] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[18] CheT, Li YR, Jacob AP, et al. ( 2017-03-02)[2020-01-01]. https:∥arxiv.org/abs/1612. 02136.

[19] He KM, Zhang XY, Ren SQ, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1026- 1034.

[20] YoshidaY, Miyato T. Spectral norm regularization for improving the generalizability of deep learning[EB/OL]. ( 2017-05-31)[2020-01-01]. https:∥arxiv.org/abs/1705. 10941.

[21] SalimansT, GoodfellowI, ZarembaW, et al. ( 2016-01-10)[2020-01-01]. https:∥arxiv.org/abs/1606.03498v1.

Article Outline

颜贝, 张礼, 张建林, 徐智勇. 基于残差结构的对抗式网络图像生成方法[J]. 激光与光电子学进展, 2020, 57(18): 181504. Bei Yan, Li Zhang, Jianlin Zhang, Zhiyong Xu. Image Generation Method for Adversarial Network Based on Residual Structure[J]. Laser & Optoelectronics Progress, 2020, 57(18): 181504.