基于时空方向主成分直方图的人体行为识别  下载: 1077次

下载: 1077次

1 引言

在人体行为识别领域,基于深度传感器(如Kinect[1])的算法解决了传统方法中数据难以处理的问题,逐渐引起人们的关注。通过深度传感器获得的深度图可以准确地提取出比颜色信息更具有区分度的几何信息,而且,深度图序列不易受光照、纹理和亮度的影响。但是,深度图序列仍存在遮挡、速度变化、传感器噪声,以及摄像视角不同等问题,因此基于深度图序列的人体行为识别依然具有一定的挑战性。

基于深度图序列的人体行为识别的首要任务是设计一个良好的特征描述子,其次是选取恰当的分类器。在选取特征描述子方面,最初使用的特征描述子[2-4]主要是基于RGB图像的特征描述,但这种基于颜色信息的方法不能直接应用于深度序列中[5]。近年来,涌现出很多基于几何特征的行为识别方法[5-8]。Tang等[5]通过深度图序列中的法向量直方图进行行为识别,采用极坐标表示每张深度图,通过计算其空间导数,来获得二维直方图描述子。黄成挥[6]运用时空特征协方差矩阵表示视频中的人体行为,建立基于Log-Euclidean词袋模型和基于Stein核系数编码的人体行为识别方法;王军[7]把分解后的行为看作一个包,把各个动作看作包中的各个示例,结合多示例学习法与AnyBoost算法提出多示例行为学习算法,通过在多示例框架下对每一类行为进行学习,得到强分类器,用于未知行为包的识别;刘智等[8]根据深度图序列中的人体关节信息分别提取表示关节之间角度和相对位置的两个特征向量,然后使用LIBLINEAR-支持向量机(SVM)分类器分别对提取的两个特征向量进行分类识别,最后通过融合分类结果,得到最终的行为识别结果。在分类器方面,使用较多的是SVM[9]、神经网络[10-11]。张燕君等[9]将粒子群算法与最小二乘SVM相结合,应用于304钢板损伤识别研究中,使预测模型具有自诊断功能;刘峰等[10]将可见光、中波红外和长波红外三个波段的舰船目标特征进行融合识别,性能较单波识别方法有明显提升;毕立恒等[11]通过径向基函数神经网络建立模型,并采用多环量子算法确定各环量个体选择概率,实现径向基函数神经网络参数优化,从而提高植物叶片图像的识别率。

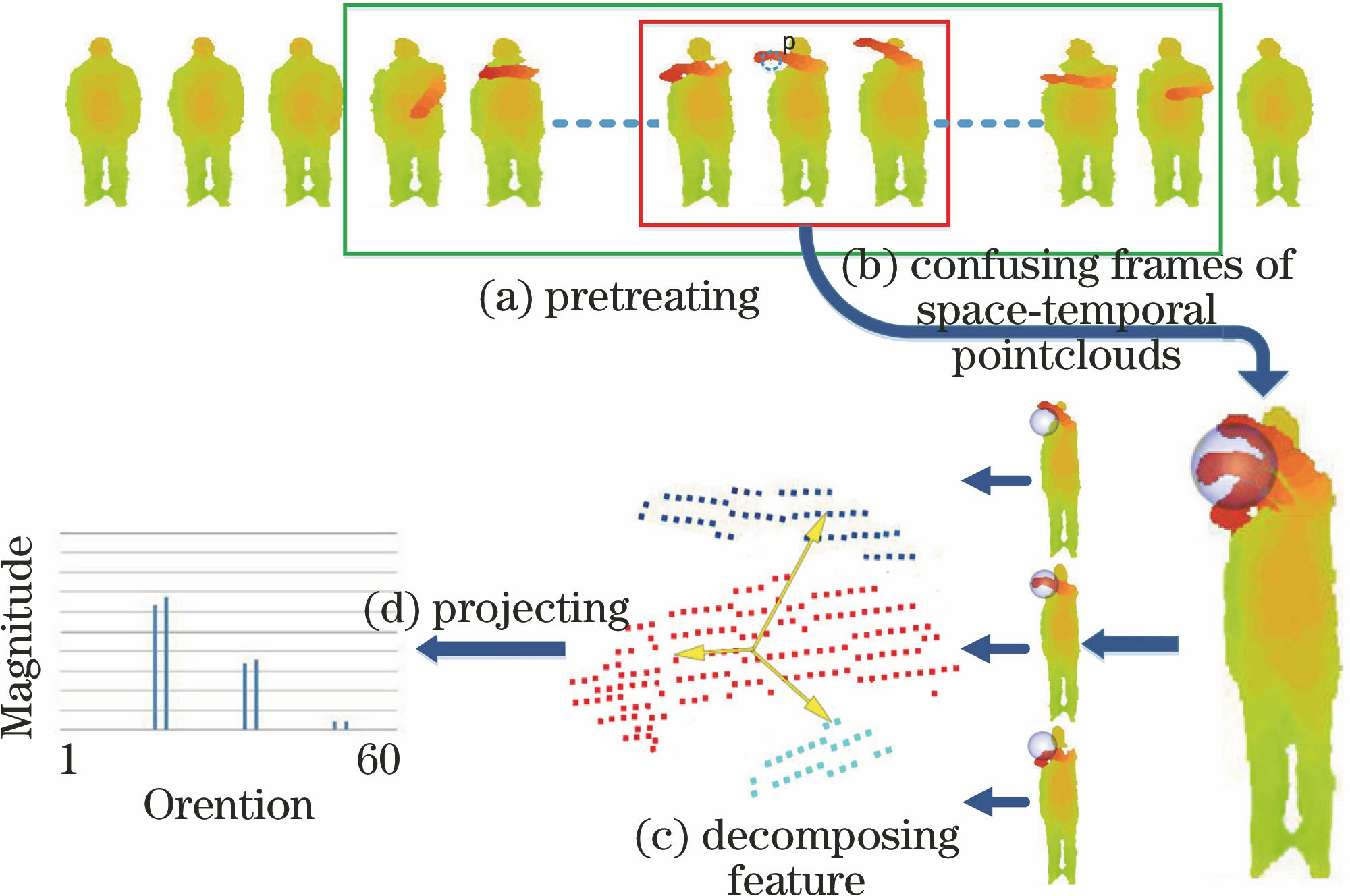

在上述方法的基础上,提出一种基于三维(3D)点云的时空方向主成分直方图(HSTOPC)的人体行为识别方法。首先,提出一种基于运动集中的时空区域提取方法,对获取得到的深度图序列转换为3D点云序列,在空间和时间维度上对视频序列进行限制,去除在时空中影响因子较小的序列和空间区域;其次,对获得的运动信息较为集中的3D点云序列求出符合条件的三维点序列中的点,对三维点序列中的点的散度矩阵求出其特征向量和特征值,将对应的特征向量映射到柏拉图立体中,从而获得每帧中符合条件的点的时空主成分;然后,通过多层时域重叠分割方法获得最终的3D点云的时空方向主成分直方图描述子;最后,采用SVM分类器在三个标准数据库进行训练和测试。

2 基本原理

提出的基于3D点云的时空方向主成分直方图的行为识别方法包括数据预处理、特征提取、多层时域重叠分割三个步骤。具体的操作步骤如

2.1 时空区域中的数据预处理方法

为了获得有效的特征描述子,首先对由深度视频序列转换的3D点云序列进行如下预处理。令

图 2. (a)高抛与(b)画圆动作的3D点云序列

Fig. 2. Action sequences of 3D point clouds of (a) high throw and (b) draw circle

2.1.1 LHW方法

针对已提取前景的点云序列采用LHW方法。在时间维上,先提取每帧图像的人体轮廓的最小外接矩形框,计算每帧最小外接矩形框的高度和宽度的比值

设置一个阈值

2.1.2 LEE方法

针对未提取前景的点云序列采用LEE方法。在时间维上,先计算每一帧的散度矩阵

式中

2.2 时空方向主成分特征提取

预处理之后的点云序列

式中

在点

假设是3D对称曲面,则

特征向量表示3D空间中相应点的最大变化方向,但存在方向歧义性问题。为了消除该歧义性,采用特征向量

将散度矩阵

对于一个以中心为原点的正二十面体,其方向向量归一化表示为

然后将每一个特征向量

若特征向量

量化后的向量表示为

式中1≤

最后按照特征值

2.3 多层时域重叠分割

为了获取相同维度的特征,对时空区域块中所有点的描述子

3 实验结果和讨论

为了验证本文算法的识别效果,分别采用MSR Action3D数据库[14]、ActionPairs3D数据库[15]和UWA3D数据库[12]进行测试。

为了便于性能比较,本文遵循文献[

12]中的实验设置(所有的实验使用固定的球半径

3.1 MSR Action3D数据库

MSR Action3D数据库[14]是由10个人完成20类动作的深度图序列构成,每个人的每类动作采集2~3次,深度图片的分辨率为320×240。虽然此数据库的背景经过预处理,但是20种动作中存在许多非常相似的行为,且类内差别大。

本文选择近几年比较典型的识别方法作为比较对象,实验中使用相同的实验设置[12]。测试1和测试2的识别精度对比如

表 1. MSR Action3D数据库的识别率比较

Table 1. Recognition rate comparison on MSR Action3D dataset

|

在主成分方向直方图(HOPC)方法基础上增加LHW方法,则识别率提高了2.13%,对应地,增加EIL方法,则识别率提高了1.4%。可以看出,图像预处理方法LHW和LEE均可以提高识别精度。这是由于加上了对时空区域的限制,可以提取更多的有效区域。HSTOPC+LHW方法使得识别率提高2.87%;HSTOPC+LEE方法使得识别率提高2.5%。以上比较结果表明,HSTOPC描述子可以很好地表示行为。这是由于多尺度时域重叠分割的计算和时间域的增强会提供更多可用于判别的信息。

表 2. 不同方法的实验结果比较

Table 2. Comparison of experimental results with different methods

|

3.2 ActionPairs3D数据库

ActionPairs3D数据库[15]是由10个人完成6对动作的深度序列构成,每个人每类动作重复3次采样。其中成对的动作具有高度相似的轮廓和运动。按照文献[

12]的实验设置,实验结果如

图 4. HOPCT+WHL算法在MSR Action3D数据集测试5/5实验结果的混淆矩阵

Fig. 4. Confusion matrix of the HOPCT+WHL algorithm by experiment setting of 5/5 on MSR action 3D dataset

表 3. ActionPairs3D数据库上的识别率比较

Table 3. Accuracy comparison on MSR Action3D dataset

|

3.3 UWA3D数据库

表 4. UWA3D数据库的识别率比较

Table 4. Accuracy Comparison with other description on UWA3D datasets

|

4 结论

通过分析已有的基于深度视频序列的人体行为识别方法,针对其中的预处理方法和特征提取方法展开研究,提出一种基于3D点云的时空方向主成分直方图方法用于行为识别。首先,将深度图序列转化为3D点云序列,通过LHW或者LEE方法对数据库进行预处理,旨在减少不重要及次要的时空区域。其次,为了突显所有时空体内的相对时间变化,在每个时空体中使用HSTOPC描述子来提高其相关性,即在每个时空体中,对每个时间层的矩阵使用矩阵连乘的方法提取时空特征。最后,除了预处理和HSTOPC特征描述子,简单的时空分割会导致分割处信息丢失,因此采用三层时域重叠分割方法。在三个公开行为数据库中进行行为识别实验,并与其他行为识别方法进行对比,结果表明,本文算法在不同的数据库中通用性较好,且识别精度有所提高。

[1] 董珂. 基于Kinect的人体行为识别研究[D]. 武汉: 武汉科技大学, 2015.

DongK. Human action recognition based on Kinect[D]. Wuhan: Wuhan University of Science and Technology, 2015.

[2] 蔡加欣, 冯国灿, 汤鑫, 等. 基于姿势字典学习的人体行为识别[J]. 光学学报, 2014, 34(12): 1215002.

[3] RahmaniH, MahmoodA, Huynh DQ, et al. Real time human action recognition using histograms of depth gradients and random decision forests[C]. 2014 IEEE Winter Conference on Application of Computer Vision, 2014: 626- 633.

[4] 蔡加欣, 冯国灿, 汤鑫, 等. 基于局部轮廓和随机森林的人体行为识别[J]. 光学学报, 2014, 34(10): 1015006.

[5] TangS, WangX, LvX, et al. Histogram of oriented normal vectors for object recognition with a depth sensor[C]. Asian Conference on Computer Vision, 2013: 525- 538.

[6] 黄成挥. 基于视频的人体行为识别算法研究[D]. 成都: 电子科技大学, 2016.

Huang CH. Human action recognition algorithm based on video[D]. Chengdu: University of Electronic Science and Technology of China, 2016.

[7] 王军. 基于多示例学习法的人体行为识别[J]. 信息技术, 2016( 7): 65- 70.

WangJ. Human action recognition based on sample learning method[J]. Information Technology, 2016( 7): 65- 70.

[8] 刘智, 董世都. 利用深度视频中的关节运动信息研究人体行为识别[J]. 计算机应用与软件, 2017, 34(2): 189-192.

Liu Z, Dong S D. Human action recognition based on the joint movement in the depth of video information[J]. Computer Applications and Software, 2017, 34(2): 189-192.

[9] 张燕君, 王会敏, 付兴虎, 等. 基于粒子群支持向量机的钢板损伤位置识别[J]. 中国激光, 2017, 44(10): 1006006.

[10] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

[11] 毕立恒, 刘云潺. 基于改进神经网络算法的植物叶片图像识别研究[J]. 激光与光电子学进展, 2017, 54(12): 121102.

[12] RahmaniH, MahmoodA, Du QH, et al. HOPC: histogram of oriented principal components of 3D pointclouds for action recognition[C]. European Conference on Computer Vision, 2014: 742- 757.

[13] 曹林. 人脸识别与人体动作识别技术及应用[M]. 北京: 电子工业出版社, 2015.

CaoL. Face recognition and human motion recognition technology and application[M]. Beijing: Electronic Industry Press, 2015.

[14] LiW, ZhangZ, LiuZ. Action recognition based on a bag of 3D points[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition-Workshops, 2010: 9- 14.

[15] JiX, ChengJ, FengW. Spatio-temporal cuboid pyramid for action recognition using depth motion sequences[C]. Eighth International Conference on Advanced Computational Intelligence, IEEE, 2016: 208- 213.

[17] WangC, WangY, Yuille AL. An Approach to Pose-Based Action Recognition[C]. Computer Vision and Pattern Recognition IEEE, 2013: 915- 922.

[19] KongY, SattarB, FuY. Hierarchical 3D kernel descriptors for action recognition using depth sequences[C]. IEEE International Conference on Automatic Face and Gesture Recognition, 2015: 1- 6.

[20] ChenC, JafariR, KehtarnavazN. Action Recognition from Depth Sequences Using Depth Motion Maps-based Local Binary Patterns[C]. IEEE Applications of Computer Vision, 2015: 1092- 1099.

[21] OreifejO, LiuZ. HON4D: Histogram of Oriented 4D Normals for Activity Recognition from Depth Sequences[C]. Computer Vision and Pattern Recognition, IEEE, 2013: 716- 723.

Article Outline

徐海洋, 孔军, 蒋敏, 昝宝锋. 基于时空方向主成分直方图的人体行为识别[J]. 激光与光电子学进展, 2018, 55(6): 061009. Haiyang Xu, Jun Kong, Min Jiang, Baofeng Zan. Action Recognition Based on Histogram of Spatio-Temporal Oriented Principal Components[J]. Laser & Optoelectronics Progress, 2018, 55(6): 061009.