基于区域辐射一致性的移动阴影检测  下载: 873次

下载: 873次

1 引言

运动目标检测一直是重要和富有挑战的任务,在许多场景有着重要的价值,如跟踪[1]、视频监控[2-4]和运动目标识别[5]。运动目标检测的一个实现方法是背景差分方法,该方法利用视频序列的每一帧与事先创建好的背景模型进行对比作差来得到运动目标。然而,在同一场景中存在的移动阴影容易使运动目标检测发生误检。同时,阴影也会导致目标合并、目标变形及目标丢失等现象的出现。当面对目标分类、目标跟踪、目标识别及目标计数等场合时,阴影会严重影响系统的稳健性[6]。因此,移动阴影检测具有重大的价值和意义。

阴影检测的关键在于定位阴影所对应的图像像素点或区域,在前景目标中消除阴影像素点,进而得到准确的运动目标。阴影的形状会随着光线的照射角度和目标形状的不同而变化。此外,阴影与目标通常会伴随在一起,并且有着相同的运动状态与表面形态[7]。因此,背景和阴影的颜色与纹理之间的相互作用是随机可变的,深度的阴影会导致区域纹理信息的丢失。为了解决上述问题,文献中提出许多基于像素和区域的阴影检测方法,它们的共同点是对提取特征进行分类[8-10]。这些特征描述符包括特定颜色空间的颜色和强度[11-12],阴影和前景目标边缘[13-14],以及纹理或区域的梯度[6,15-16]等。

为了克服基于单个像素的阴影检测造成的误差,对视频序列的每一帧采用基于图的分割方法[8-9]进行分割并得到超像素,可对每个超像素区域中的阴影进行分组和抑制。为了解决阴影表示问题,Russell等[10]引入了分块特征近似和稀疏表示技术,为了解决漏检问题,采取了后期形态学处理操作,使得检测结果更加完整。基于像素颜色的方法充分利用了不同颜色空间中阴影区域的颜色信息来提取多个特征[11-12]。基于半监督学习技术,文献[ 16]提出了一种新的自适应技术来解决移动阴影检测的静态设置工作模式问题,该技术具有自动适应场景条件变化的能力。

基于区域的阴影检测与抑制方法,利用区域纹理信息可以克服像素噪声问题。Amato等[5]利用阴影区域的局部颜色恒常性质,将图像分割成多个运动区域(超像素)。Wu等[13]提出了一种基于斑块的阴影边缘检测方法,创建了边缘分类器,通过训练阴影边缘和前景目标以获取阴影区域。Russell等[17] 利用像素几何方向,结合像素梯度幅度,获取新特征。Dai等[18]利用吸引子传播算法检测移动阴影区域,使用该算法时不必事先指定聚类数目且能很好地解决非欧空间问题。目前,大多数移动阴影检测算法都是基于前期运动目标检测算法的掩码结果,对其中的目标与阴影进行分离。因此,在阴影的检测结果中,目标部分仅仅是对前期目标部分的保留,而不能使目标掩码部分增长。这在一定程度上限制了阴影检测算法精度的提高[19]。

为此,本文采用基于图的分割方法对当前图像进行分割[20],可得到若干超像素区域,其目标超像素区域内所有像素点集合(PCC),主要分为阴影PCC和目标PCC。进而,提出一种基于掩码PCC种子的区域生长方法,将阴影PCC生长为完整的阴影区域。最后,通过融合生长后的目标PCC与前期运动目标检测算法得到的目标掩码中的真实目标区域,实现目标掩码反向增长,提升目标前景区域和阴影区域的检测精度。

2 区域辐射一致性及移动阴影检测

本研究所提算法需要对比PCC内坐标点映射到背景图像和当前图像中的每个像素点的强度, 对两个图像中的像素强度进行分析,二者分别为 PCC 元素对应于背景图像中的像素点( PB-PCC)和 PCC 元素对应于当前图像中的像素点( PC-PCC)。

2.1 阴影一致性属性证明

采用Lambert漫反射光照模型[21]对阴影区域进行描述, 表达式为

式中:

阴影区域光照辐射模型为

式中:

将(2)式代入(1)式,阴影区域的任意像素点

式中:

失去了主光源,像素点在当前图像中的反射光可表示为

式中:

式中,光线与表面法线的角度

因为

式中,

令

假定

这意味着,在阴影区域内部相邻像素点之间的反射光变化量近似相等,即都与主光源直接相关,而通常认为主光源是常量。与此相反,运动目标对应的像素点不符合这个规律,因为像素点的

(8)式是利用单光源模型推导出来的。当假设在(2)式中使用线性组合的多个光源时,结论也同样成立,这些假设符合大多数的场景要求,在模型中将

由(8)式可知,对于同一阴影区域内的像素点而言,在RGB颜色空间中,阴影区域对应的PB-PCC和PC-PCC中像素点之间的强度变化量近似一致,而这在真实的非阴影目标区域是不成立的。将这种规律称为“阴影区域辐射一致性属性”,简称一致性属性。

2.2 一致性属性与统计参数

基于阴影区域辐射一致性属性,在阴影区域内,由单个像素点扩展到PCC内全部元素。记cos[

建立阴影PCC内的像素点的数学模型。假设,当前图像中的每一个像素点强度出现的概率服从高斯分布[23],令

式中,(

假设某图像中的阴影PCC集合为{

式中,

则均值变化量为

对于不同的视频序列选取不同的阈值Δ

更进一步,对于阴影PCC而言,区域内的每一个像素点相对于背景图像强度近似减少

而在当前图像中,PC-PCC的方差为

将(13)式代入(16)式可得

即阴影PCC对应的PB-PCC和PC-PCC强度的方差矢量相同。这样,对于当前图像中的任意一个PCC而言,如果对应的PB-PCC和PC-PCC标准差相差不大,并且均值偏差没有超过上一个阈值条件,则这个PCC符合阴影PCC的特征。反之,则符合目标PCC的特征。这两个标准差的偏差阈值设置为Δ

2.3 基于统计参数的目标超像素区域PCC分类

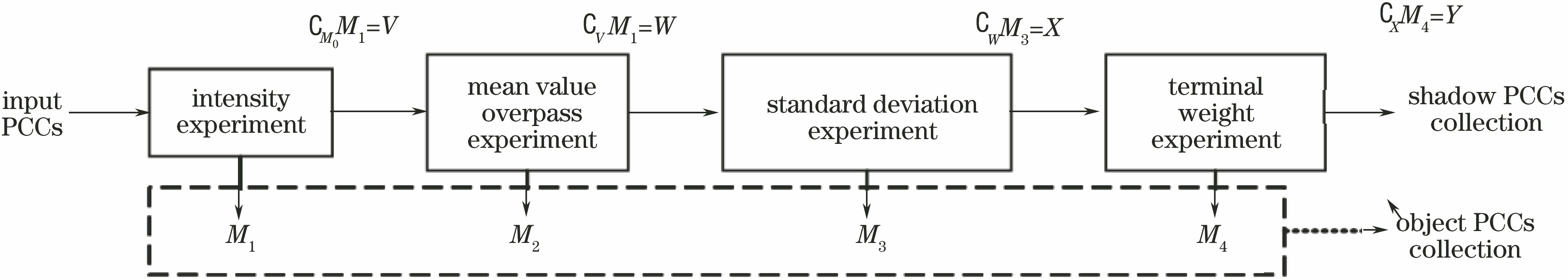

由前文可知,对区域轮廓内的PCC进行分类的重点在于对PCC对应的PB-PCC和PC-PCC中的信息对比。为此,利用阴影区域辐射一致性属性中所包含的4个指标(

1)

2)Δ

3)Δ

式中,Δ

实验中将

4)

通过以上分类过程,由于光照导致的亮度与标准差变化非常明显,运动目标的边缘侧PCC已经被正确地分类。但位于目标内部的阴影伪装区域未能被有效地识别出来。所以引入了PCC相对位置信息的衡量指标

在不同的视频序列将

3 阴影检测与目标掩码增长

3.1 完整阴影检测与目标掩码增长框架

由于超像素更有利于局部特征的提取与结构信息的表达,本研究采用基于图的分割方法,可得到当前图像若干超像素区域。利用所提算法进行阴影检测的前提是图像中的每一个像素点的强度值服从高斯分布[23]。采用Change Detection[24]数据集中BusStation序列的第1047帧作为实验对象进行阐述,完整移动阴影检测与目标掩码增长框架,如

步骤1 区域轮廓内的点集合的创建(

步骤2 区域轮廓内的点集合分类(

步骤3 阴影PCC区域生长(

步骤4 目标PCC区域生长与目标掩码融合(

3.2 完整阴影检测与目标掩码增长算法

在

图 3. 区域生长和ViBe目标掩码融合示意图

Fig. 3. Illustration of region growth and Vibe object mask fusion

区域生长是图像分割技术的一种,其基本思想是在一定条件下将具有相似性的像素合并到一个区域。该技术需要先选择区域生长的种子点,并在种子点的8邻域对符合生长条件的像素进行合并,新的像素又会作为新的种子继续生长。这里将ViBe掩码区域内的点作为生长的种子点,并对阴影PCC和目标PCC分别设置不同的生长条件。

阴影区域生长一共包含两个阶段。

阶段一为基于超像素的阴影PCC生长。这个阶段是将每一个阴影区域内的任意一个像素作为种子点,将

阶段二为基于超像素分割区域轮廓点的区域生长。这个阶段是将每一个阴影PCC边界的每一个点作为种子,将

目标PCC生长与阴影PCC生长的第一个阶段类似,不同之处在于第3)点为“没有生长到阴影区域附近邻域”,生长后的结果为

经过超像素阴影PCC的两次区域生长得到了完整的阴影区域,接着,对ViBe掩码与完整的阴影区域进行差运算得到ViBe目标掩码,对应

图 4. 区域生长与目标掩码融合结果。(b) Ground truth图像; (b)超像素分割图; (c)运动目标分割图; (d)分类后的PCC结果; (e)阴影PCC一阶段生长结果(绿色部分); (f)阴影PCC二阶段生长结果(红色部分); (g)目标PCC生长结果; (h)目标掩码融合结果

Fig. 4. (a) Result of region growth and mask fusion. (a) Ground truth image; (b) super-pixel segmentation image; (c) segmentation of moving object; (d) classified PCC result; (e) first stage of shadow PCC growth(green part); (f) second stage of shadow PCC growth(red part); (g) result of object PCC growth; (h) result of object mask fusion

4 实验结果与分析

4.1 参数分析

在2.3小节中,经过4个步骤对目标前景区域和阴影区域进行分类。方法中涉及到几个必须要依据场景的不同而需要设定的参数。

1) PCC亮度检测中的阈值:对应于

式中

2) PCC均值超越阈值Δ

3) PCC标准差偏差率阈值Δ

4) 边界点终点权重阈值

不同的视频序列中的目标形状和阴影形状等外部参数千变万化,导致不同场景中的数据分布有着明显的差异。因此,对每一个视频序列设置自定义的参数标准,这需要根据经验值进行测试,而一旦得到优化的参数范围,就会在该类型视频序列中有均衡的表现,

4.2 实验验证

1)定性实验:在公开数据集中选取6个视频序列,通过记录所提算法每一步处理的中间过程,定性说明所提算法在阴影检测方面的有效性,详细结果如

2)定量实验:定量评估实验基于Prati等[25]介绍的用于评估投影检测算法性能的两个度量标准:阴影检测率

式中,

需要注意的是,本研究进行阴影检测的基础是前期已经检测到了ViBe掩码区域。将该掩码区域和ground truth求与之后的结果作为本研究统计阴影检测与目标掩码增长性能指标的ground truth。这样做的目的在于突出阴影检测算法在ViBe中的检测精度。如果ViBe掩码检测率较低,在这个掩码的基础上进行阴影检测时,检测到的阴影像素点必然少,若以原始ground truth作为统计精确率的基础,必然会掩盖所提算法在ViBe中的检测率。反之,如果将ViBe掩码与ground truth求与之后的结果作为新的ground truth,并仅仅用于计算阴影检测率,会彰显出在所提方法在ViBe基础上的阴影检测精度。 所提算法仅仅统计包含在原始ground truth中的并且被ViBe检测到的部分的阴影检测率。

表 1. 5种算法的评价结果

Table 1. Appraisal results of five algorithms%

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

由

为了衡量所提方法在掩码增长中的表现,定义目标增长率

式中,

对比实验结果表明,在相同的测试序列下,所提方法的阴影检测率与阴影识别率最高。与此同时,由

表 2. 目标掩码增长率与精度

Table 2. Growth rate and accuracy of object mask

| |||||||||||||||||||||||

5 结论

为了解决移动阴影检测的难题,提出了一个新的阴影检测与目标掩码增长框架。提出的阴影区域辐射一致性属性及统计参数有助于准确区分真实运动目标区域与移动阴影区域。提出了在超像素内部和PCC边缘的掩码生长策略,使用该策略实现了完整阴影区域的检测和运动目标前景区域的增长,提升了阴影区域和目标区域的完整性。采用阴影检测率、阴影识别率和目标增长率等定量评价指标,将所提算法与4种阴影检测算法进行定量对比,验证了所提算法的移动阴影的检测精度较好,目标掩码增长的准确性较高。

所提方法的不足之处在于没有实现PCC分类中的参数自适应化,以及没有给出如何针对过小的PCC进行准确分类。后续研究将重点针对以上不足进行方法改进。

[1] 李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

李双双, 赵高鹏, 王建宇. 基于特征融合和尺度自适应的干扰感知目标跟踪[J]. 光学学报, 2017, 37(5): 0515005.

[2] 莫邵文, 邓新蒲, 王帅, 等. 基于改进视觉背景提取的运动目标检测算法[J]. 光学学报, 2016, 36(6): 0615001.

莫邵文, 邓新蒲, 王帅, 等. 基于改进视觉背景提取的运动目标检测算法[J]. 光学学报, 2016, 36(6): 0615001.

[3] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

[12] Chen CT, Su CY, Kao WC. An enhanced segmentation on vision-based shadow removal for vehicle detection[C]∥The 2010 International Conference on Green Circuits and Systems, June 21-23, 2010, Shanghai, China. New York: IEEE, 2010: 679- 682.

Chen CT, Su CY, Kao WC. An enhanced segmentation on vision-based shadow removal for vehicle detection[C]∥The 2010 International Conference on Green Circuits and Systems, June 21-23, 2010, Shanghai, China. New York: IEEE, 2010: 679- 682.

[13] WuQ, Zhang WD, Vijaya Kumar B V K. Strong shadow removal via patch-based shadow edge detection[C]∥2012 IEEE International Conference on Robotics and Automation, May 14-18, 2012, Saint Paul, MN, USA. New York: IEEE2012: 2177- 2182.

WuQ, Zhang WD, Vijaya Kumar B V K. Strong shadow removal via patch-based shadow edge detection[C]∥2012 IEEE International Conference on Robotics and Automation, May 14-18, 2012, Saint Paul, MN, USA. New York: IEEE2012: 2177- 2182.

[15] Huang JB, Chen CS. Moving cast shadow detection using physics-based features[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 2310- 2317.

Huang JB, Chen CS. Moving cast shadow detection using physics-based features[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 2310- 2317.

[17] RussellM, Zou JJ, FangG. A novel region-based method for moving shadow detection[C]∥2016 International Conference on Digital Image Computing: Techniques and Applications, November 30-December 2, 2016, Gold Coast, QLD, Australia. New York: IEEE, 2016: 1- 6.

RussellM, Zou JJ, FangG. A novel region-based method for moving shadow detection[C]∥2016 International Conference on Digital Image Computing: Techniques and Applications, November 30-December 2, 2016, Gold Coast, QLD, Australia. New York: IEEE, 2016: 1- 6.

[18] Dai J Y, Han D Y. Region-based moving shadow detection using affinity propagation[J]. International Journal of Signal Processing, Image Processing and Pattern Recognition, 2015, 8(3): 65-74.

Dai J Y, Han D Y. Region-based moving shadow detection using affinity propagation[J]. International Journal of Signal Processing, Image Processing and Pattern Recognition, 2015, 8(3): 65-74.

[21] AqelS, HmimidA, Sabri MA, et al. Road traffic: Vehicle detection and classification[C]∥2017 Intelligent Systems and Computer Vision (ISCV), April 17-19, 2017, Fez, Morocco. New York: IEEE, 2017: 1- 5.

AqelS, HmimidA, Sabri MA, et al. Road traffic: Vehicle detection and classification[C]∥2017 Intelligent Systems and Computer Vision (ISCV), April 17-19, 2017, Fez, Morocco. New York: IEEE, 2017: 1- 5.

[24] GoyetteN, Jodoin PM, PorikliF, et al. Changedetection. net: A new change detection benchmark dataset[C]∥2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 1- 8.

GoyetteN, Jodoin PM, PorikliF, et al. Changedetection. net: A new change detection benchmark dataset[C]∥2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 1- 8.

[29] SaninA, SandersonC, Lovell BC. Improved shadow removal for robust person tracking in surveillance scenarios[C]∥2010 20th International Conference on Pattern Recognition, August 23-26, 2010, Istanbul, Turkey. New York: IEEE, 2010: 141- 144.

SaninA, SandersonC, Lovell BC. Improved shadow removal for robust person tracking in surveillance scenarios[C]∥2010 20th International Conference on Pattern Recognition, August 23-26, 2010, Istanbul, Turkey. New York: IEEE, 2010: 141- 144.

Article Outline

陈海永, 郄丽忠, 刘坤. 基于区域辐射一致性的移动阴影检测[J]. 光学学报, 2019, 39(3): 0315003. Haiyong Chen, Lizhong Qie, Kun Liu. Moving Shadow Detection Based on Regional Radiation Consistency[J]. Acta Optica Sinica, 2019, 39(3): 0315003.