基于改进SSD的交通大场景多目标检测  下载: 1646次

下载: 1646次

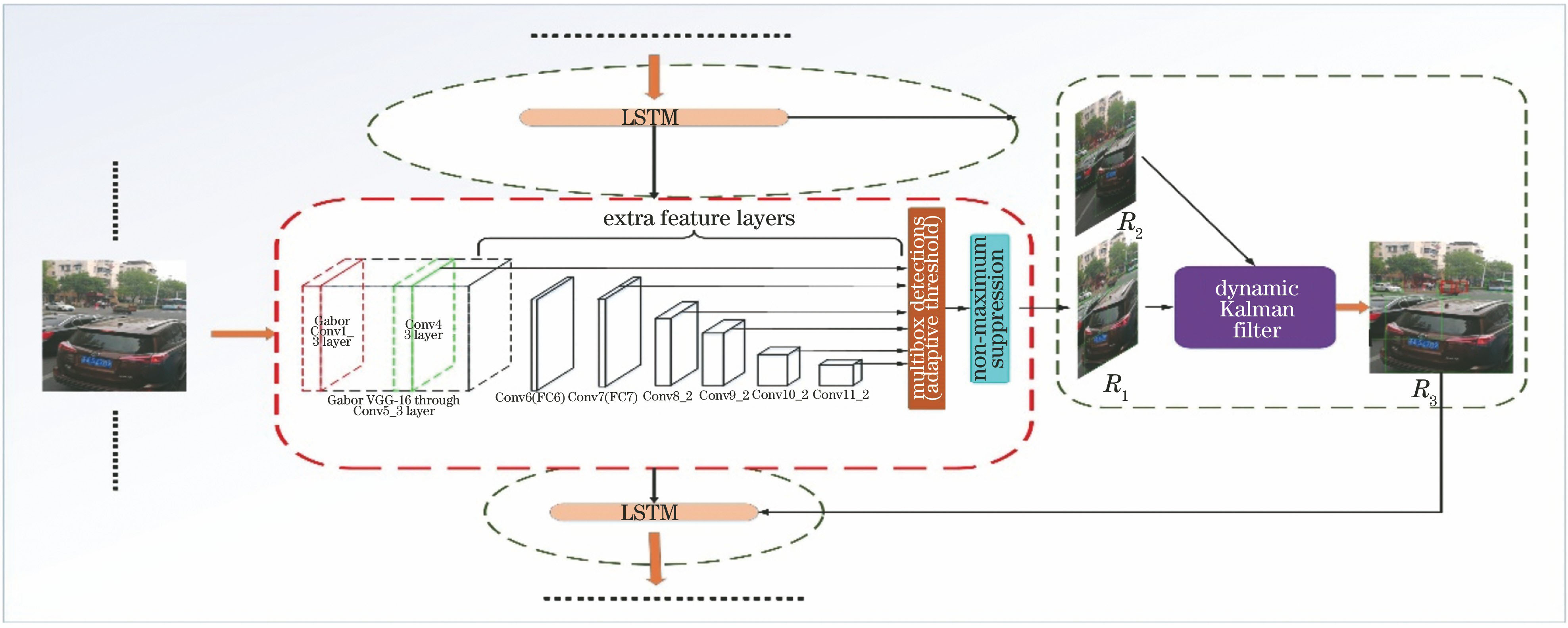

ing at the problem that the accuracy and real-time of multi-target detection in complex and large scenes are difficult to balance in the existing target detection algorithms, we imitate the human visual mechanism inspired by the convolution kernel shape of the deep neural network. The target detection framework——the single shot multi-box detection (SSD) based on deep learning is improved, and a multi-target detection framework adaptive perceive SSD is proposed, which is specially used for the multi-target detection in complex and large traffic scenes. A feature convolution kernel library composed of multi-form Gabor and color Gabor is designed. The optimal feature extraction convolution kernel group is trained and screened to replace the low-level convolution kernel group of the original network, and effectively improves the detection accuracy. A single image detection framework is combined with a convolution long-short-term memory network, and the temporal association of network frame-level information is realized by extracting the characteristic mapping between propagation frames with a bottleneck-long-term and short-term memory layer. And the calculation cost is reduced, and the tracking and identification of targets affected by the strong interference in the video are realized. An adaptive threshold strategy is added to reduce the rate of missing and false alarms. The experimental results show that compared with other target detection frameworks based on deep learning, the average accuracy of various target recognition is increased by 9%~16%, the average accuracy is increased by 14%~21%, the multi-target detection rate is increased by 21%~36%, and the detection frame rate reaches 32 frame·s -1, which achieves a balance between the accuracy and real-time performance of the algorithm and achieves better detection and recognition results.

1 引言

交通场景中的行人、车辆目标检测与识别是目标检测技术的重要分支,也是自动驾驶、机器人以及智能视频监控等研究领域的核心技术,具有重要的研究意义[1]。深度学习为基于深层人工神经网络的学习方法[2],在人工神经网络结构中,深度卷积网络具有强大的特征提取能力,广泛应用于图像分类,并在图像识别、图像分割、目标检测、场景分类等视觉任务中,取得了非常好的效果[3-5]。

单向多框检测器(SSD)是Liu等[6]提出的目标检测算法,也是主要检测框架之一,相比更快的区域卷积神经网络(Faster RCNN)[7]具有明显的速度优势,相比YOLO(You Only Look Once

综上,本文提出一种新的多目标检测框架自适应感知SSD,主要对传统SSD算法进行了以下改进:1)设计构造了由多形态、彩色Gabor构成的特征卷积核库,通过训练筛选得到最优特征提取卷积核组以替换原有特征提取网络用于区域基础特征提取的低级卷积核组,得到新的特征提取网络Gabor-VGGnet,大幅提高了检测精度;2)采用模糊阈值法调整自适应阈值策略降低漏警率和虚警率,在避免适应数据集的同时提高模型的决策能力;3)将单图像多目标检测框架与卷积长短期记忆网络(LSTM)相结合,形成交织循环卷积结构,实现了网络帧级信息的时序关联,极大降低了网络计算成本;4)利用LSTM的时序关联特性,结合动态卡尔曼滤波算法,实现对视频中受光照变化、大面积遮挡等强干扰影响目标的追踪识别。

2 本文模型

本文检测算法整体框架如

3 改进的特征提取网络Gabor-VGGnet

3.1 仿光感细胞的Gabor卷积核设计

训练深度卷积神经网络(CNN)的某一个卷积层实际上是在训练一系列的滤波器,让这些滤波器对特定的目标有高的敏感激活度,以达到深度CNN的识别、检测等目的。在训练开始之时,卷积层的滤波器是完全随机的,它们不会对任何特征激活即不能检测任何特征[10-11]。通过深度CNN可视化工具箱(yosinski/deep-visualization-toolbox)[12],对CNN模型进行可视化得到的各级特征卷积核示例如

图 2. CNN模型提取各级特征卷积核示例

Fig. 2. Example of CNN model extracting feature convolution kernels at various levels

人眼视网膜上主要光感受器为视杆细胞和视锥细胞。视锥细胞主司昼光觉,有色觉,光敏感性差,但视敏度高。视杆细胞对暗光敏感,光敏感度较高,视物无色觉[13-14]。Gabor小波与人类视觉系统中简单细胞的视觉刺激响应非常相似[15]。通过对比分析发现,深度CNN通过训练获取的提取基础特征的卷积核在形态上与Gabor的卷积核存在极大的相似度。用二维Gabor卷积核模拟视杆细胞功能,用彩色Gabor卷积核模拟视锥细胞功能。在空域,一个二维的Gabor滤波器是一个正弦平面波和高斯核函数的乘积,二维Gabor函数的数学表达式为

其中其实部与虚部分别为

式中:

为了让Gabor滤波器能够提取更加复杂、丰富的边缘和纹理特征信息,引入了参数

受深度CNN训练获得的彩色卷积核启发,以神经网络训练得到的彩色卷积核为参考,通过重构的方式构造了三维彩色Gabor滤波器,用于对彩色图像颜色特征的激活[17]。RGB空间使用红、绿、蓝三原色的亮度来定量表示颜色,是以R(红)、G(绿)、B(蓝)三色光互相叠加来实现混色的方式。模仿人眼的视觉机理,将一个二维的Gabor滤波器视为对三维颜色空间的一个颜色分量进行颜色特征检测的滤波器,依据需要提取的目标颜色特性,构造三个颜色分量的相互关系,分别得到其他两个颜色分量的Gabor滤波器,将这三个二维滤波器通过合成即可获得用于提取指定目标颜色特征的彩色Gabor滤波器,即

式中

在经典的感受野中,包含有红、绿、蓝、黄4个分量,拥有4种感受野[17]。为了模仿人眼视觉细胞对颜色的感知,以神经网络训练得到的彩色卷积核为参考,通过模仿重构的方式,总结出各颜色通道之间的数学关系为

约束条件为彩色Gabor敏感的目标颜色,例如R&G表示目标主色为红色和绿色,Y代表黄色。部分彩色Gabor效果如

3.2 智能优化最优Gabor卷积核组筛选

在实验中用SSD512模型结合训练数据集中的部分车辆目标数据集训练并测试了几种不同卷积核个数变化对目标识别率的影响,分析实验结果,为了保证尽可能高的检测精度,选取卷积层深度依次为128、256、384、384、384。人的视网膜中,视锥细胞数量约为600~800万,视杆细胞总数达1亿以上,两者的比例近似为10∶1,由此本文设计第一层Gabor卷积核组中二维Gabor卷积核数量为110,彩色Gabor卷积核数量为18。用KITTI数据集中的车辆目标数据集训练并测试了几种不同卷积核尺寸变化对识别率的影响,通过实验总结,发现二维Gabor滤波器卷积核取3×3大小,彩色Gabor滤波器卷积核取5×5,并往网络的Inception结构中加入1×1的卷积核进行降维时,组合的滤波器组能够获得更佳的目标特征敏感。为了能够有效提高算法整体的检测精度,构造合理的Gabor特征提取卷积核组提取具有区分度的多特征具有重要意义。最优Gabor卷积核组的筛选流程如

图 5. 最优Gabor卷积核组的训练流程

Fig. 5. Training process for optimal Gabor convolution kernel group

首先由(1)式和(4)式,通过变换参数的方式构造一个包含多种形态的二维Gabor库,由(6)式和(7)式可以构造一个同等规模的彩色Gabor库,再构造分别只单独含有“人”、“骑行者”、“车辆”的小规模测试图像集(三个目标各20张,共60张)。从两个Gabor库中各随机不重复抽取卷积核,组成卷积核组,每个卷积核组对测试集的图像逐张进行卷积,通过非极大值抑制获得对应的特征映射,将特征映射经过池化转换为特征向量,输入通过小样本数据训练好的传统SSD检测框架中全连接层即Softmax分类器,可获得测试图像目标的检测置信度,将测试集全部置信度的均值作为该卷积核组特征提取有效性的评价分数,取最高评价分数对应的卷积核组作为最佳卷积核组。

Gabor库的规模,依据实际需求的卷积核组中卷积核的个数来合理确定。为了避免因为组合过多造成的数据爆炸,以及数据库规模太小造成的特征提取不全面,在进行卷积核抽选时,将二维Gabor卷积核每10个随机组成一组,将彩色Gabor卷积核每18个随机组成一组,以组为单位进行组合,构造的Gabor库规模为180个卷积核。

4 置信度自适应阈值判定

在 SSD用 Softmax 为候选区域进行分类的最后阶段,候选区域会得到属于各个类别的置信度(即属于各个类别的概率),当属于某类的置信度高于设定阈值时则将此候选区域判为该类目标,若同一候选区域有多个类别置信度高于阈值则取最高者。针对 SSD检测固定置信度阈值不够灵活的缺陷,采用模糊自适应阈值法调整自适应阈值策略降低漏警率和虚警率。

模糊程度是由模糊率函数来确定的,当模糊率最低的时候,这时候分割效果最好。其中模糊率与隶属函数相关,模糊数学的基本思想是隶属度的思想[18]。检测一张图像默认得到

式中

此时

5 基于时间感知特征映射的视频目标检测

人类的思想具有连贯性,但传统的神经网络无法做到,然而递归神经网络(RNN)较好地解决了这个问题。LSTM是一种特殊的RNN,可以解决长期依赖的问题。

研究了在保证运行速度和低运算资源消耗的前提下,通过增加时间感知来构建视频检测模型的策略,在最终检测结果和特征空间中添加时间感知机制,通过递归网络体系结构将每个帧的特征映射调整到先前帧的相应特征映射上来利用特征级的连续性。提出了一种将卷积LSTM结合到单图像检测框架中的方法,将其作为跨时间传播帧级信息的手段,网络结构如

图 6. 基于时间感知特征映射的移动视频目标检测框架

Fig. 6. Mobile video target detection framework based on time-aware feature mapping

网络当中的某层Conv LSTM接收了上一帧对应位置的Conv LSTM传递的特征映射和当前帧前一层卷积层传递的特征映射后对检测结果进行预测,并把特征映射继续传递给下一层卷积层和下一帧对应位置的Conv LSTM,Conv LSTM的输出将在以后的所有计算中替换之前的特征映射,继续执行检测任务。然而,LSTM的简单集成会导致较大的运算量,妨碍网络实时运行。为了解决这个问题,引入了一个Bottleneck-LSTM[19],利用它具有深度可分离卷积和Bottleneck设计原则的特性,以降低计算成本。

视频数据可以视为多帧图像组成的序列,

式中

将单帧图像目标检测器定义为函数

式中○表示哈达玛乘积。同样将任意一层LSTM卷积层定义为函数,即

式中

由于需要在单个前向通道中计算多个门,所以LSTM对计算资源要求较高,这极大地影响了网络的整体效率。为了解决这个问题,首先,调整LSTM的维度,扩展文献[

19]中定义的通道宽度乘子

同时采用Bottleneck-LSTM提高传统LSTM的运算效率,即

式中:

训练有素的CNN无法应对大面积遮挡等强干扰造成目标图像信息严重缺失。对此本文从之前的检测结果中获取有用的先验信息来合理预测少量候选区域,增加目标被检测的几率。因此选择卡尔曼滤波[20]作为前一帧和当前帧之间传递目标信息的工具,结合目标检测任务设计卡尔曼滤波模型。

系统的测量方程为

6 实验分析与讨论

6.1 实验的条件与数据集

本文实验使用 DELL Precision R7910(AWR7910)图形工作站,处理器为Intel Xeon E5-2603 v2(1.8 GHz/10M),采用NVIDIA Quadro K620 GPU加速运算。SSD基于深度学习框架Caffe运行。本文在YFCC100M收集的交通场景数据集(WD)和KITTI数据集上进行了实验。选用KITTI数据集中第一个图片集 Download left color images of object data set和标注文件 Download training labels of object data set,实验数据集设置三个类别分别为Car、Cyclist、Pedestrian。 YFCC100M 数据集包含大约1亿张图片以及摘要、标题和标签。为了更好地展示本文方法的效果,通过搜索关键词“行人”、“道路”和“车辆”从YFCC100M数据集收集了1000幅分辨率较高的测试图像。对于该数据集,使用至少16 pixel宽度和小于50%遮挡对所有目标进行注释。图像在较长的一侧被重新缩放到2000 pixel,以适合GPU内存。

6.2 实验的参数设置

对SSD 系列中的SSD512进行改进。为了优化调参过程以及快速选取自适应池化纠正误差项的最佳值,制作了小样本数据集(200张图像),大幅节约了时间成本,提高了调参选值效率。在不使用自适应阈值时,阈值设置为 0.7;将所有实验中经过非极大抑制留下的候选区域数量设置为100(默认设置为300)。其他设置保持默认不变,后续所有实验都在以上设置基础上进行。对于LSTM,通道宽度乘子

6.3 评价指标

假设图像目标

1)建立目标和假设结果间的最优一一对应关系。采用欧氏距离来计算真实目标和假设目标的空间位置对应关系。欧氏距离的阈值

2)依据真实目标和假设目标对应的目标所属类别

3)由步骤2)的统计结果,可以通过计算算法的虚警率、漏警率、检测率、误检率来衡量算法的检测效果,分别表示为

平均准确率(AP)是评价深度学习检测模型准确性最直观的标准,AP从召回率和准确率两个角度衡量检测算法的准确性,可以用来分析单个类别的检测效果。平均准确率均值(mAP)是各个类别AP的平均值,mAP越高表示模型在全部类别中检测的综合性能越高[1]。

6.4 各改进策略有效性验证

首先将各个策略与SSD512进行单独结合,并进行相应的对比实验,表明各个策略的作用。然后将所有策略与SSD512结合,对最终的改进算法进行整体测评。采用训练集训练原始SSD512,将此模型记为M0。在M0基础上加入新的特征提取网络Gabor-VGGnet策略,生成模型M1。在M0基础上加入自适应阈值策略,生成模型M2。在M0基础上加入基于时间感知特征映射和动态卡尔曼滤波的目标检测改进策略,生成模型M3。最后将M0与所有策略结合在一起,生成模型M4。使用两数据库测试集对M0、M1、M2、M3、M4进行测试和对比。

对比

表 1. 各模型识别和检测效果比较

Table 1. Comparison of model identification and detection effects

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

6.5 与其他算法对比实验

另外本文选取了Faster R-CNN、深度监督对象检测器300(DSOD300)检测框架[21]、 YOLO 系列检测框架中的YOLOv2 544[22]和SSD改进模型去卷积单镜头探测器(DSSD513)[23]作为深度学习对比算法,与M4对比在Web Dataset 和KITTI数据集上的检测效果。检测识别效果如

表 2. 不同算法检测和识别效果比较

Table 2. Comparison of detection and recognition with different algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

对比

综上可知, M4模型不仅在检测精度和识别精度上高于其他算法,而且检测速率达到了32 frame·s-1,验证了本文算法能够实现精度和实时性平衡,实现了既快又好,综合性能明显优于其他算法,具有较强的应用前景。

7 结论

针对现有基于大数据和深度学习的目标检测算法在复杂大场景下多目标检测的精度和实时性难以平衡的问题,改进了基于深度学习的目标检测框架 SSD,提出一种新的多目标检测框架——自适应感知SSD,将其专用于复杂大交通场景多目标检测。实验结果表明,改进后的自适应感知SSD在应对弱小目标、多目标、杂乱背景、光照变化、模糊、大面积遮挡等检测难度较大的情况时,均能获得较好的效果,为深度学习在特定目标检测的应用提供了实例和新的思路。但是算法的处理效率距离工程实际应用的需求仍然有差距,后期如何降低运算量、提高算法的实时性和针对低分辨率弱小目标的检测和识别将是主要的研究方向。

[1] 冯小雨, 梅卫, 胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报, 2018, 38(6): 0615004.

[2] 余凯, 贾磊, 陈雨强, 等. 深度学习的昨天、今天和明天[J]. 计算机研究与发展, 2013, 50(9): 1799-1804.

[3] 刘峰, 沈同圣, 马新星. 特征融合的卷积神经网络多波段舰船目标识别[J]. 光学学报, 2017, 37(10): 1015002.

[4] 辛鹏, 许悦雷, 唐红, 等. 全卷积网络多层特征融合的飞机快速检测[J]. 光学学报, 2018, 38(3): 0315003.

[5] 鲁逸峰, 金琴花, 荆晶, 等. 基于机器学习的可降解支架检测与分割算法[J]. 光学学报, 2018, 38(2): 0215005.

[6] LiuW, AnguelovD, ErhanD, et al. SSD: single shot multibox detector[C]//European Conference on Computer Vision, 2016: 21- 37.

[8] RedmonJ, DivvalaS, GirshickR, et al. You only look once: unified, real-time object detection[C]// IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779- 788.

[9] Lin TY, DollárP, GirshickR, et al. Feature pyramid networks for object detection[C]// IEEE Conference on Computer Vision and Pattern Recognition, 2017: 936- 944.

[10] 周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251.

[11] 常亮, 邓小明, 周明全, 等. 图像理解中的卷积神经网络[J]. 自动化学报, 2016, 42(9): 1300-1312.

[12] Zeiler MD, FergusR. Visualizing and understanding convolutional networks[C]//European Conference on Computer Vision, 2014: 818- 833.

[15] Jain AK, FarrokhniaF. Unsupervised texture segmentation using Gabor filters[C]// IEEE International Conference on Systems, Man, and Cybernetics Conference Proceedings, 1990: 14- 19.

[17] 刘中华, 殷俊, 金忠. 一种自适应的Gabor图像特征抽取和权重选择的人脸识别方法[J]. 光子学报, 2011, 40(4): 636-641.

[18] 陈果, 左洪福. 图像的自适应模糊阈值分割法[J]. 自动化学报, 2003, 29(5): 791-796.

Chen G, Zuo H F. The image adaptive thresholding by index of fuzziness[J]. Acta Automatica Sinica, 2003, 29(5): 791-796.

[19] LiuM, Zhu M. Mobile video object detection with temporally-aware feature maps[J]. arXiv preprint arXiv: 1711. 06368, 2017.

[20] 詹建平, 黄席樾, 沈志熙, 等. 基于均值漂移和卡尔曼滤波的目标跟踪方法[J]. 重庆理工大学学报(自然科学), 2010, 24(3): 76-80.

[21] Shen ZQ, LiuZ, Li JG, et al. DSOD: learning deeply supervised object detectors from scratch[C]// IEEE International Conference on Computer Vision, 2017: 1937- 1945.

[22] Zhang J M, Huang M T, Jin X K, et al. A real-time Chinese traffic sign detection algorithm based on modified YOLOv2[J]. Algorithms, 2017, 10(4): 1-13.

[23] Fu CY, LiuW, RangaA, et al. DSSD: deconvolutional single shot detector[J]. arXiv preprint arXiv: 1701. 06659, 2017.

Article Outline

华夏, 王新晴, 王东, 马昭烨, 邵发明. 基于改进SSD的交通大场景多目标检测[J]. 光学学报, 2018, 38(12): 1215003. Xia Hua, Xinqing Wang, Dong Wang, Zhaoye Ma, Faming Shao. Multi-Objective Detection of Traffic Scenes Based on Improved SSD[J]. Acta Optica Sinica, 2018, 38(12): 1215003.