基于相关滤波器的目标抗遮挡算法  下载: 1115次

下载: 1115次

1 引言

视频目标跟踪是机器视觉里一个最为基本也是最为广泛的研究方向。经过30多年的研究与发展,大量算法被提出,主要分为生成学习和鉴别学习两类,早期是以生成学习方法为主[1],如Lucas-Kanade算法[2]、Kalman滤波算法[3]和Mean-shift跟踪算法[4]等。由于生成学习方法对于物体形变与噪声的干扰处理能力不强,很难准确把握目标动态特征信息,通常会出现跟踪丢失的情况。

2009年,Babenko等[5]提出在线多例学习跟踪算法(MIL),同年,Kalal等[6]利用检测学习跟踪(TLD)算法对跟踪问题建立了结构化约束,Hare等[7]提出结构化输出模型(Struck),通过对没有标签信息的样本进行学习,利用支持向量机(SVM)进行跟踪。此后由于稀疏表示与低秩表示显著的性能优势,生成学习与鉴别学习跟踪方面的算法得到了广泛的发展[8]。

鉴于生成学习与鉴别学习跟踪方法的算法复杂度过大,优化降低复杂度一直是难以解决的问题,因而近年速度快,精度高,计算简单的相关滤波器受到了广泛关注,其起初的目标建立一个对目标高响应、对背景低响应的滤波器。2010年,Bolme等[9]提出了最小平方误差输出总和滤波器(MOSSE),自此相关滤波器的研究得到了大力的发展。2015年,Henruques等[10]提出的核相关滤波器更是将这一方法推上了巅峰。

但核相关滤波器(KCF)算法在抗遮挡性能方面存在明显的缺陷,目标被遮挡一直是机器视觉中重要的研究方向之一,在处理时存在诸多难点。近年来,国内外对于目标遮挡也有着多方面的研究,如Alahi等[11]提出的基于马尔可夫决策树的多目标跟踪,利用马尔可夫决策把目标分为跟踪、丢失、开始检测与结束4部分,并采用模板保留策略将目标模板保留以作下次跟踪数据。Danelljan等[12]对于相关滤波算法自适应多尺度的研究。Li等[13]在KCF的基础上将颜色(CN)特征和梯度直方图(HOG)特征串联,加入尺度估计,使得算法有一定的抗遮挡能力。Bertinetto等[14]在响应阶段将HOG特征和颜色特征结合,使得算法运算速度有了一定的提升。闫河等[15]提出融合HOG与局部二值化(LBP)特征来提升跟踪遮挡视频的准确率。包晓安等[16]利用尺度不变特征变换(SIFT)特征检测来重定位再次出现的目标。所述研究对于遮挡视频的处理都取得了一定的研究成果,本文针对KCF算法的遮挡缺陷采用前后向误差检测与特征检测来处理抗遮挡问题,对KCF抗遮挡性能有着一定的提升。

2 相关滤波及核相关滤波器

2.1 MOSSE相关滤波器

MOSSE相关滤波器由Bolme等[9]2010年提出,当时的视频检测普遍比较慢,还未达到在线检测,相关滤波器的问世及其高帧率迅速引起了广泛的关注,其后相关滤波的改进算法便相继问世。

相关滤波的核心思想是相关性,在信号中有着相应的理论基础,两个信号越相似相关性就越大,将其引用到图像处理也是如此,因此提出以滤波器求相关的形式来获取输出响应,进而获得最大响应处的位置也即所期望跟踪的目标中心位置,其时域公式为

式中

由于矩阵的卷积运算过于复杂,为了简化运算将计算从时域转化为频域的点乘积,即

模板的计算方法为

其中最为重要的是滤波模板的计算,虽然(3)式给出了计算,但显然视频识别不可能只训练一次,在这种情况下引入了平方差最小的概念,通过随机仿射变换生成多个样本求平方差误差的最小值,即

其闭式解为

虽然MOSSE通过时频域转换使得图像处理速度得到了质的飞跃,但在某些方面还是过于粗糙,首先是没有考虑尺度变化,另外稳健性不够强,对于复杂的视频比较容易跟丢。

2.2 KCF核滤波器

核循环跟踪(CSK)算法虽然改进了MOSSE中的问题,但真正将相关滤波算法发扬光大的还是引进了核化的KCF算法。

2.2.1 KCF算法

KCF算法的主要工作是训练分类器函数,即

式中

分类器的训练过程则是一个岭回归问题,即

式中

式中

式中

最终通过循环矩阵与傅里叶变换将时域矩阵运算化成频域的点积运算,即

根据实验比较得知,采用高斯核函数具有很好的效果,所以核函数计算公式为

式中

2.2.2 循环矩阵

在线性代数中,循环矩阵是一种特殊形式的Toeplit矩阵,如

以一阶矩阵为例,若存在矩阵

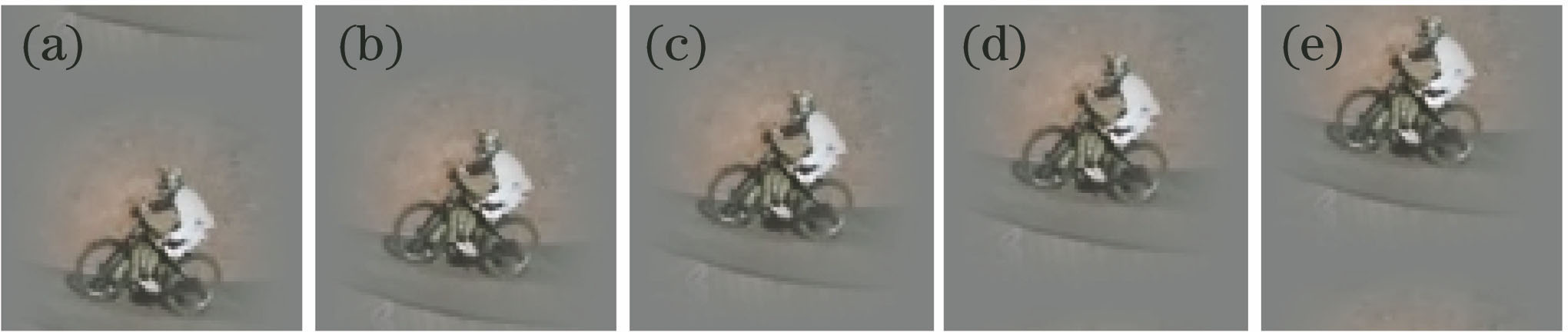

扩展到二维空间,循环矩阵可以起到增加样本数量提高训练精度的作用,同时在KCF算法中运用循环矩阵可以对运算进行进一步化简,提高运算速度。

图 1. 二维图像的循环位移。(a) +30;(b) +15;(c) 0;(d) -15;(e) -30

Fig. 1. Cyclic displacement of two dimensional images. (a) +30; (b) +15; (c) 0; (d) -15; (e) -30

图 2. 遮挡判断。(a)朝右走被遮挡;(b)朝左走被遮挡;(c)响应曲线

Fig. 2. Occlusion judgment. (a) Be blocked when go to the right; (b) be blocked when go to the left; (c) response curve

3 前后向误差检测

前后向误差检测[17-18]通过验证前后向跟踪轨迹是否一致来判断跟踪目标是否被遮挡。

假设图像序列

式中

实验发现,在跟踪过程中,当遮挡物体没有特征时,目标很可能停留在遮挡物某一位置或在较小的区域内跳动,这样也会出现后向确认轨迹和前向跟踪轨迹误差较小的情况。针对此种情况,需要先检查当前目标最佳匹配区域图像是否具有特征,可以通过检查其标准差大小来确定,若无特征,便可继续确认目标跟踪被遮挡。

图像标准差[19]计算为

式中

遮挡判断流程图如

4 实验结果及分析

对5组实验与数据收集对加入前后向差分抗遮挡的核相关滤波器进行了评价,分别为两组全遮挡视频,两组半遮挡视频以及一组无遮挡视频,实验结果与预期值出入不大,前后向差分检测能起到良好的抗遮挡效果,进一步提升核相关滤波器的跟踪精度。但是,算法仍然存在着缺陷与不足,希望在进一步的研究中加以改进。

4.1 抗遮挡实验结果

核相关滤波器设计之初是通过对目标模板的相关性检测来进行识别与跟踪,在模板迭代更新阶段作者采用了内部关联因子的更新方式,使得上一代的目标模板与新提取的模板以一定的权重结合生成新的模板用作下一次计算,这样能够很好地抑制噪声对跟踪的影响,对于短时间的干扰甚至是遮挡有着良好的抑制作用,但是这种模板更新方式对于较长时间的遮挡却没有良好的稳健性,如果无法快速消除干扰,随着更新的不断进行干扰会不断的累积下去,最终使得模板出现偏差,从而无法继续跟踪目标。前后向差分检测可以快速检测出遮挡发生点,并在此之前对模板进行保存处理[11],可以很好地保留跟踪目标的信息,直到目标重新出现才继续对其进行跟踪。

以数据集AVSS 2007中视频motinas_Room105为例,如

加入前后向差分检测能够对遮挡起到良好的判断和抑制作用,在目标消失后以预测的方式对其行为进行估计,并在目标再次出现后再次跟踪,并不会出现目标丢失的情况,如

图 5. KCF的遮挡实验。(a)遮挡前;(b)遮挡发生时;(c)脱离遮挡

Fig. 5. Occlusion experiment of KCF. (a) Before occlusion; (b) when occlusion occurs; (c) after occlusion

图 6. 抗遮挡实验。(a)遮挡;(c)目标出现后

Fig. 6. Anti-occlusion test. (a) Occlusion; (c) after the target appearing

前后向差分检测对于目标遮挡检测与判断具有显著的效果,显著改善核相关滤波器的抗遮挡性能。

4.2 抗遮挡性能对比

测试视频一共5组,包括motinas_Room105、自己拍摄的全遮挡视频Walking、采集于视频数据集的半遮挡视频David3和Suv,以及无遮挡视频Subway。如

由

表 1. 准确率以及帧数对比

Table 1. Comparison of accuracy and frame number

| ||||||||||||||||||||||||||||||||||

图 9. 对比实验。(a) Walking;(b) motinas_Room105;(c) Suv;(d) David3;(e) Subway

Fig. 9. Comparative experiment. (a) Walking; (b) motinas_Room105; (c) Suv; (d) David3; (e) Subway

4.3 欧氏距离阈值与标准差阈值

通过前后向检测的欧氏距离与特征标准差来进行遮挡判断,因而这两个阈值的设置会极大地影响程序的性能,另外每个视频由于光照、阴影、形变的影响,所设置的最佳阈值具有一定差异,但总体上不会超过一定的范围。以视频Rom_105为例,讨论不同的阈值对跟踪性能的影响。

从

当欧氏距离阈值为5~25或标准差大于1时,具有良好的跟踪效果。当设置值更低时,由于检测数据并非保持不变,因此遮挡前后会出现误判的情况,导致跟踪框无法准确地跟踪目标甚至丢失。Rom_105与Walking的具体分析见

表 2. 不同阈值设置结果对比

Table 2. Comparison of the results under different thresholds

|

4.4 其他算法准确度对比

采用自己拍摄的Walking与motinas_Room105这两个比较明显的遮挡视频来进行测试,其他视频由于遮挡效果并不明显,因此不采用。比较算法分别为原KCF算法、改进算法空间尺度检测跟踪器 (DSST)、staple算法以及具有一定抗遮挡性能的比例自适应多特征算法(SAMF)。两组视频的跟踪结果如

5 结论

从实验结果可以看出,加入前后向误差检测后,极大提升了核相关滤波器的抗遮挡性能,能够准确地检测到目标是否被遮挡、处于丢失状态。另外本文算法在长时遮挡方面具有一定的优势,大多数视频遮挡状态较短,如一棵树、一个电线杆以及行人重叠的现象,很多算法在短时遮挡方面有着极高的成功率;然而一旦出现长时遮挡,如一堵墙、一个方柱时,会出现表现不足的情况。针对长时遮挡的情况,视频遮挡帧数超过45帧,这一点与具有一定抗遮挡性能的SAMF算法对比效果明显。最后在遮挡消失状态下采用预测的方式进行跟踪,由于跟踪遮挡在大多数情况下的行动较为规律,在遮挡时采用预测跟踪的方式是可行的,因此采用了较为简单的线性预测,对于直线或大弧度曲线运动的物体有着较高的跟踪效率,对于稍微复杂的运动路线,如加入卡尔曼预测以及深度学习机制等都可以完善目标在遮挡发生时的运动路径,从而提高复杂情况下的跟踪精度。

但是实验也存在很多不足之处,在遮挡判断时涉及两个阈值设置,分别是欧氏距离阈值和特征检测的标准差阈值,由于每个视频的数据不同,这两个参数也不相同,而且设置偏差会极大地影响判断性能。其次在目标被遮挡的情况下,采用预测的方法判断,如果目标改变运动轨迹很容易丢失,在预测方式上也仅采用简单的线性预测,以后改进可以加入比较准确的预测方式。第三,对于视频帧数检测太慢,通过

[1] 吴小俊, 徐天阳, 须文波. 基于相关滤波的视频目标跟踪算法综述[J]. 指挥信息系统与技术, 2017, 8(3): 1-5.

[3] Nguyen H T. Smeulders A W M. Fast occluded object tracking by a robust appearance filter[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(8): 1099-1104.

[4] ComaniciuD, RameshV, MeerP. Real-time tracking of non-rigid objects using mean shift[C]∥Proceedings IEEE Conference on Computer Vision and Pattern Recognition, 2000: 142- 149.

[5] BabenkoB, Yang MH, BelongieS. Visual tracking with online Multiple Instance Learning[C]∥Computer Vision and Pattern Recognition, 2009: 983- 990.

[6] KalalZ, MatasJ, MikolajczykK. P-N learning: Bootstrapping binary classifiers by structural constraints[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 49- 56.

[7] HareS, SaffariA, Torr P H S. Struck: Structured output tracking with kernels[C]∥International Conference on Computer Vision, 2011: 263- 270.

[9] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[11] XiangY, AlahiA, SavareseS. Learning to track: online multi-object tracking by decision making[C]∥IEEE International Conference on Computer Vision (ICCV), 2015: 4705- 4713.

[12] DanelljanM, HägerG, Shahbaz KhanF, et al. Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference 2014, British Machine Vision Conference, 2014.

[13] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[M] ∥Cham: Springer International Publishing, 2015: 254- 265.

[14] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥IEEE Computer Vision and Pattern Recognition, 2016: 1401- 1409.

[15] 闫河, 张杨, 杨晓龙, 等. 一种抗遮挡核相关滤波目标跟踪算法[J]. 光电子·激光, 2018, 29(6): 647-652.

[16] 包晓安, 詹秀娟, 王强, 等. 基于KCF和SIFT特征的抗遮挡目标跟踪算法[J]. 计算机测量与控制, 2018, 26(5): 148-152.

[17] 吕高杰, 毛鑫, 胡银记, 等. 一种基于前后向误差比较的检测跟踪遮挡方法[J]. 红外技术, 2016, 38(4): 337-341, 347.

[18] KalalZ, MikolajczykK, MatasJ. Forward-backward error: automatic detection of tracking failures[C]∥20 th International Conference on Pattern Recognition , 2010: 23- 26.

[19] 万磊, 白洪亮, 戴军. 扩展的Otsu最优阈值图像分割的实现方法[J]. 哈尔滨工程大学学报, 2003, 24(3): 326-329.

Article Outline

王凯宇, 陈志国, 傅毅. 基于相关滤波器的目标抗遮挡算法[J]. 激光与光电子学进展, 2019, 56(3): 030401. Kaiyu Wang, Zhiguo Chen, Yi Fu. Target Anti-Occlusion Algorithm Based on Correlation Filter[J]. Laser & Optoelectronics Progress, 2019, 56(3): 030401.