基于词向量一致性融合的遥感场景零样本分类方法  下载: 956次

下载: 956次

1 引言

传统的遥感图像分类方法主要在“像素”和“对象”层面进行,针对的是空间分辨率不高的遥感图像分类任务,然而近年来随着遥感图像空间分辨率不断提升,这些方法越来越难以满足实际需要。场景分类作为高分辨率遥感图像快速分析与信息提取的重要手段,近10年来受到广泛关注[1-2]。这里的“场景”是指具有清晰类别语义的遥感图像块,以其作为遥感图像分类的基本单元,使场景分类能够适应大规模遥感图像快速分析的需要。然而,目前的场景分类方法属于监督分类,无法将识别能力灵活扩展到新类别场景,因此阻碍了遥感场景分类研究的进一步发展。为解决现有场景分类方法的迁移识别能力不足问题,Li等[3]提出了遥感图像零样本场景分类方法,即将场景分类与零样本学习方法结合,提高对新类别场景的迁移识别能力。

零样本分类(ZSC)是一种特殊的无监督分类方法,其基本原理是:以类别名称的语义词向量为桥梁,通过迁移由已知(seen)类别标注样本学习得到识别模型,获得对新的(unseen)类别的识别能力。由于ZSC方法能够在不标注unseen类样本情况下,获得对其的识别能力,因此近年来受到广泛关注[4-11]。为进行细粒度的ZSC,Xian等[4]在兼容函数学习过程中引入隐式变量模型,从而提出隐式嵌入方法(LatEm)。针对映射函数的泛化能力不足问题, Wang等[5]提出的关系知识迁移(RKT)方法通过语义映射方法还原unseen类别的流形结构。Zhang等[6]提出的联合隐式相似性嵌入(JLSE)方法将样本特征和对应的语义嵌入表示作为输入,通过建立两者之间的相似性度,实现对unseen类别样本的ZSC。Zhang等[7]提出的语义相似性嵌入(SSE)方法将源域或目标域数据视为训练类组合,并将其映射到同一语义空间中。Wang等[8]提出的双向隐式嵌入(BiDiLEL)方法利用流形保持原理,将图像特征和语义特征分别映射到第三方的公共空间。Li等[9]提出的双视觉语义映射(DMaP)方法利用语义空间流形和视觉语义映射迁移能力之间的关系,修正了语义词向量。为估计unseen样本特征分布特点以提升ZSC效果,Zhao等[10]提出利用直推式框架(MDP)。除语义词向量外,人工标注的类别属性向量也可用于ZSC研究中,如Lampert等[11]提出的基于类别属性向量表示的零样本分类方法,但是由于类别属性向量的标注成本较大且扩展性较弱,近年来用到ZSC的研究越来越少。语义词向量[12]是采用自然语言训练模型,在大规模文本语料集上,通过无监督学习得到的实体单词高维向量表示。在ZSC中,采用类别名称的语义词向量,提供类别间距离结构关系,来辅助推断图像特征空间unseen类别的原型表示。因此,语义词向量能否反映图像特征空间的类间距离结构关系,是ZSC方法的关键。现有ZSC方法针对均是某一领域内的细粒度类别的分类任务,然而,由于遥感场景类别涉及不同领域,词向量需要反映场景类别间的距离关系。单种语义词向量受训练语料、训练模型限制,难以满足多领域的遥感场景类别的情形。

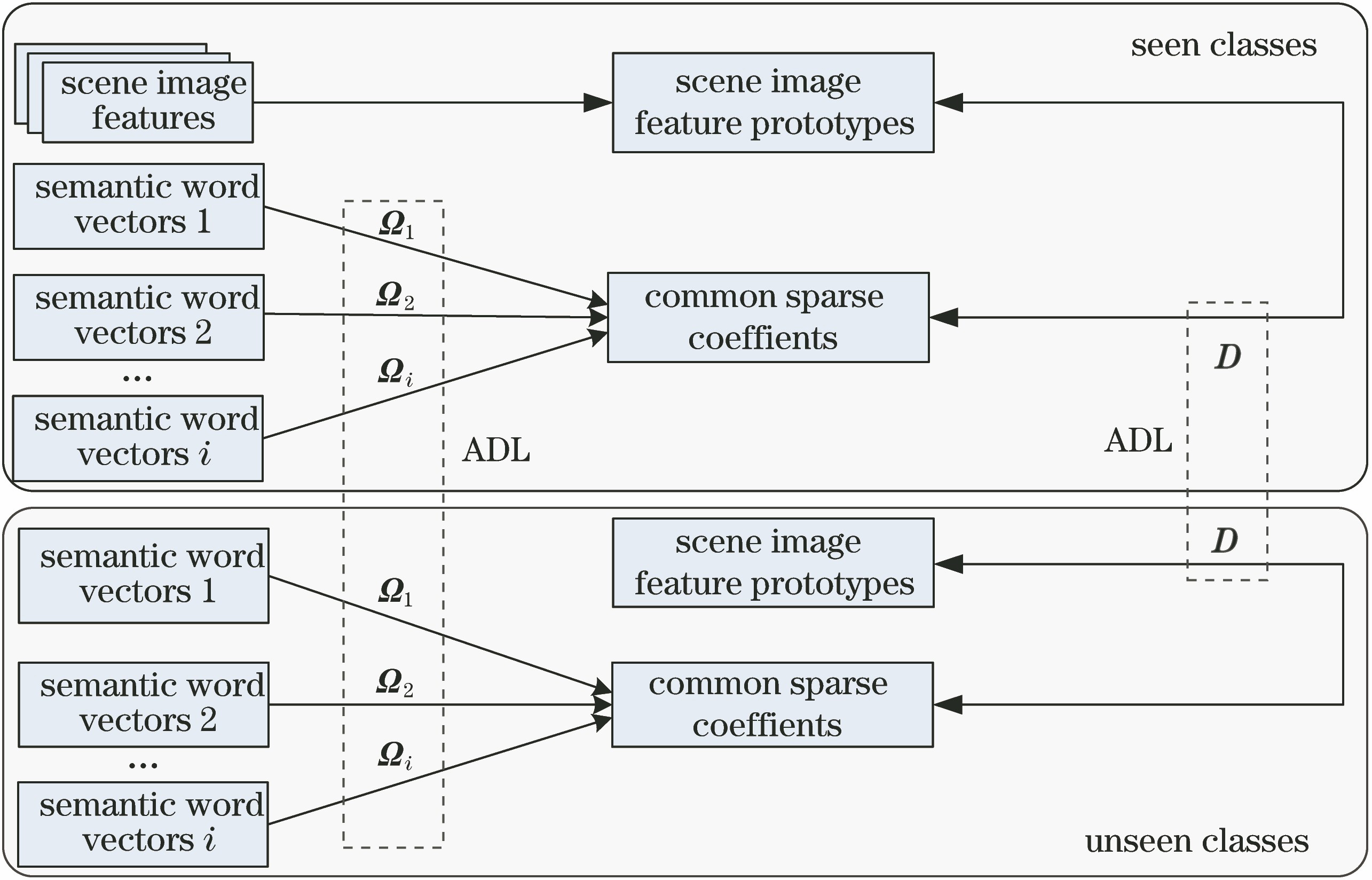

近几年,随着自然语言处理技术的进步,已能便捷获取不同训练模型(如Word2Vector[13]、Glove[14] 等)和不同训练语料(如Wikipedia、Common Crawl等)的语义词向量。这些语义词向量具有一定的一致性,通过融合可获得与图像特征空间场景类别距离结构更一致的语义词向量,从而提升遥感场景ZSC准确度。为利用不同语义词向量间的一致性,本文提出一种基于词向量一致性融合的遥感场景ZSC方法。首先,采用解析字典学习方法,获取各语义词向量的稀疏系数;其次,将各词向量的公共稀疏系数作为融合后的语义词向量表示;然后,再采用解析字典方法,将seen类图像特征原型表示嵌入到融合后的语义词向量空间,与其中的seen类融合语义词向量进行结构对齐,提升模型到unseen类的迁移效果;最后,在图像特征空间以学习得到的unseen类原型表示为中心,采用最近邻分类器对unseen类场景样本进行分类。

2 解析字典学习

字典学习方法分为两类,即合成性字典学习(SDL)和解析性字典学习(ADL)。SDL认为输入特征可以由字典和相应稀疏系数重建得到,而ADL则将字典应用到输入特征上,获得特征的稀疏系数。虽然SDL方法应用广泛,但其计算效率不高。而ADL通常具有闭式解,编码能力良好,计算效率较高[15-16]。ADL的基本公式为

式中:

3 方法

采用ADL方法获得各词向量的稀疏系数,并将公共的稀疏系数作为融合词向量表示,与图像特征空间类别原型结构对齐。首先,由于词向量中存在冗余信息,影响类间距离结构信息表达,需要对其进行稀疏编码处理,以减少冗余信息,突出类间距离结构信息。而解析字典学习方法具有优越的稀疏编码能力,因此本文采用解析字典学习方法,建立稀疏编码项,获取各语义词向量的稀疏系数。其次,为获取不同词向量的一致性,将各词向量的公共稀疏系数作为融合后的语义词向量表示。然后,融合后的词向量空间与场景图像特征空间来源不同,再加上遥感场景类别涉及不同领域(人类生产生活以及自然地貌),导致了两种空间中的场景类间距离存在较大差异,降低了对unseen类的迁移效果。因此需要对这种空间差异性进行建模,而ADL方法具有较强的稀疏编码能力,能够将场景图像特征嵌入到稀疏的融合后语义词向量空间,从而与其中的seen类场景图像特征对齐。最后,通过对seen和unseen类上的目标函数进行联合迭代计算,获得unseen类图像特征原型表示,进而采用最近邻分类器完成对unseen样本的分类。本文方法的整体框架如

3.1 基于解析字典学习的词向量融合方法

词向量融合的目标函数可表示为

式中:

(2)式对目标变量

1) 固定

此时的总体目标函数为

由于

这里记[

式中:

式中:超参数

2) 固定

此时的目标函数为

(7)式的求解步骤与(3)式相同。

3) 固定

此时关于

对

此时关于

同理,对

4) 固定

此时的总体目标函数为

对

5) 固定

此时的总体目标函数为

对

迭代循环结束后,在图像特征空间中,以学到的unseen类原型表示

3.2 本文方法步骤

本文基于词向量一致性融合的遥感场景ZSC方法的计算流程如

输入:seen类场景图像特征

输出:对

步骤1:初始化

步骤2:根据(3)式更新

步骤3:根据(7)式更新

步骤4:根据(8)和(9)式分别更新

步骤5:根据(10)式更新

步骤6:根据(11)式更新

步骤7:判断是否达到最大循环次数Iter

步骤8:在图像特征空间中,以

4 实验及结果分析

4.1 数据集及实验设置

实验采用3种遥感场景数据集:UC-Merced(UCM)数据集[18]、航空图像数据集(AID)[19]以及RSSCN7数据集[20]。其中,UCM和AID用于定量实验,RSSCN7用于定性实验,即作为seen样本,以测试遥感图像上unseen类场景的ZSC效果。UCM有21类场景,共2100张图像,图像大小为256 pixel×256 pixel,若干样本如

图 3. UCM数据集若干类的样本。(a)农田;(b)飞机;(c)棒球场;(d)密集住宅;(e)高速公路;(f)海港;(g)储罐;(h)网球场;(i)立交桥;(j)高尔夫球场

Fig. 3. Images of several classes from UCM dataset. (a) Agricultural; (b) airplane; (c) baseball diamond; (d) dense residential; (e) freeway; (f) harbor; (g) storage tanks; (h) tennis court; (i) overpass; (j) golf course

图 4. AID数据集若干类的样本。(a)机场;(b)贫瘠地;(c)海滩;(d)桥梁; (e)商业区;(f)运动场;(g)池塘;(h)火车站;(i)体育场;(j)立交桥

Fig. 4. Images of several classes from AID dataset. (a) Airport; (b) bare land; (c) beach; (d) bridge; (e) commercial; (f) playground; (g) pond; (h) railway station; (i) stadium; (j) viaduct

图 5. RSSCN7数据集类的样本。(a)草地;(b)河湖;(c)工厂;(d)场地;(e)森林;(f)居民区;(g)停车场

Fig. 5. Images of several classes from RSSCN7 dataset. (a) Grass; (b) river laker; (c) industrial; (d) field; (e) forest; (f) residential; (g) parking

实验采用卷积网络模型GoogLeNet[21]的全连接层输出作为场景图像特征。词向量融合分为不同训练模型、不同语料词向量融合。其中,不同训练模型的词向量融合实验,涉及2种训练模型:Glove(gl)和Word2Vec(wv)。这两种词向量均在Wikipedia语料上训练得到。不同语料词向量融合实验,采用2种训练语料:Wikipedia(Wiki)和Common Crawl(Crawl),均采用Glove模型训练。Iter_

4.2 定量实验结果及分析

在UCM和AID数据集上进行定量实验,并从结构对齐、超参数取值、融合效果以及与典型ZSC方法对比等4个方面,分别进行分析。

4.2.1 结构对齐效果分析

ZSC方法的本质是借助语义词向量提供的类间距离关系,将图像特征空间中类别原型,迁移至unseen类,获得unseen类的图像特征空间原型表示,最后利用该原型对unseen样本进行分类。而本文结构对齐项的实质作用就是降低两种空间类别间距离的不一致性。因此,这里定义语义词向量空间与图像特征空间的类别距离结构差异度为

式中:

图 6. 不同模型词向量融合的结构对齐效果

Fig. 6. Structure alignment performance of word vector fusion with different models

图 7. 不同语料词向量融合的结构对齐效果图

Fig. 7. Structure alignment performance of word vector fusion with different corpora

可以看出,相比未融合的单词向量及直接串接词向量,本文融合方法得到的词向量具有最小的

4.2.2 超参数取值分析

本文方法中的超参数

图 8. UCM和AID数据集上本文方法在不同α值上的OA值。(a) UCM上不同训练模型词向量融合;(b) UCM上不同训练语料词向量融合;(c) AID上不同训练模型词向量融合;(d) AID上不同训练语料词向量融合

Fig. 8. OA values of proposed method for different α on UCM and AID datasets. (a) Fusion of word vectors from different training models on UCM dataset; (b) fusion of word vectors from different training corpora on UCM dataset; (c) fusion of word vectors from different training models on AID dataset; (d) fusion of word vectors from different training corpora on AID dataset

4.2.3 词向量融合效果分析

表 1. 不同训练模型词向量和不同训练语料词向量融合前后的OA

Table 1. OA values of different training models and different training corpora before and after fusion of word vectors%

| |||||||||||||||||||||||||||||||

图 9. 不同训练模型词向量和不同训练语料词向量的各unseen类融合效果。(a) UCM上不同训练模型词向量融合;(b) UCM上不同训练语料词向量融合;(c) AID上不同训练模型词向量融合;(d) AID上不同训练语料词向量融合

Fig. 9. Fusion performance of different training models and different training corpora on unseen classes. (a) Fusion of word vectors from different training models on UCM dataset; (b) fusion of word vectors from different training corpora on UCM dataset; (c) fusion of word vectors from different training models on AID dataset; (d) fusion of word vectors from different training corpora on AID dataset

4.2.4 与典型ZSC方法比较

通过与6种典型ZSC方法进行对比,验证本文方法是否具有更优的ZSC效果。

表 2. 本文方法及对比方法OA值

Table 2. OA values of proposed method and relative methods%

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 10. 本文方法及对比方法的各unseen类S1+S2+S3词向量融合效果。 (a) UCM数据集; (b) AID数据集

Fig. 10. Fusion performance of S1+S2+S3 word vectors on unseen classes by proposed method and relative methods. (a) UCM dataset; (b) AID dataset

4.2.5 计算效率分析

为比较本文方法与其他ZSC方法的计算效率,测试各ZSC方法在AID数据集上对S1词向量上的计算耗时,结果如

表 3. 各ZSC算法在AID数据集上对S1词向量上的运算耗时

Table 3. Computing time of different ZSC algorithms on AID dataset with S1 word vector

|

4.3 定性实验结果及分析

为定性分析本文方法的实际遥感场景ZSC效果,以RSSCN7数据集作为seen类样本,对2幅高分辨率遥感图像I和II(空间分辨率均为0.3 m)进行ZSC分类。unseen类选择为ocean、airport和runway。S1+S2+S3得到的词向量,用于定性实验。步骤为:首先,用单类别支持向量机(SVM)判断遥感场景样本是否属于seen类;然后,对不属于seen类的样本,视为unseen类样本,采用本文方法进行ZSC。遥感图像I的尺寸为17920 pixel×10752 pixel,场景尺寸设定为256 pixel×256 pixel。本文及对比方法在遥感图像I上的ZSC效果,如

遥感图像II的尺寸为25344 pixel×29952 pixel,场景尺寸设定为256 pixel×256 pixel。本文及对比方法在遥感图像II上的ZSC效果,如

5 结论

针对遥感场景类别的语义词向量与图像特征原型的距离结构不一致问题,提出了面向遥感场景ZSC的词向量融合方法,通过定量和定性实验,验证了该方法在不同训练模型、不同训练语料词向量融合的有效性。该方法有以下特点:1)为利用不同词向量一致性,利用解析字典学习方法提取各词向量的公共稀疏编码系数,并作为融合后的词向量;2)为降低结构差异性,将遥感场景图像特征类原型嵌入到融合词向量空间中与其进行对齐。实验结果表明:与典型ZSC方法相比,本文方法在缩小距离结构差异、提升总体分类准确度方面都有更优表现,本文方法能够有效利用不同词向量的一致性,显著提升遥感场景ZSC效果。

[2] 刘大伟, 韩玲, 韩晓勇. 基于深度学习的高分辨率遥感影像分类研究[J]. 光学学报, 2016, 36(4): 0428001.

[4] Xian YQ, AkataZ, SharmaG, et al. Latent embeddings for zero-shot classification[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 69- 77.

[5] WangD, Li YN, Lin YT, et al. Relational knowledge transfer for zero-shot learning[C]∥Thirtieth AAAI Conference on Artificial Intelligence, February 12-17, 2016, Phoenix, Arizona, USA. California: AAAI, 2016: 2145- 2151.

[6] Zhang ZM, SaligramaV. Zero-shot learning via joint latent similarity embedding[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 6034- 6042.

[7] Zhang ZM, SaligramaV. Zero-shot learning via semantic similarity embedding[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile, USA. New York: IEEE, 2015: 4166- 4174.

[9] Li YN, Wang DH, Hu HH, et al. Zero-shot recognition using dual visual-semantic mapping paths[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 3279- 3287.

[10] ZhaoB, Wu BT, Wu TF, et al. Zero-shot learning posed as a missing data problem[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2616- 2622.

[12] SocherR, GanjooM, Manning CD, et al. Zero-shot learning through cross-modal transfer[C]∥26th International Conference on Neural Information Processing Systems, December 5-10, 2013, Lake Tahoe, Nevada. [S.l.: s.n.], 2013: 935- 943.

[13] MikolovT, ChenK, CorradoG, et al. Efficient estimation of word representations in vector space[J/OL]. ( 2013-09-07)[2019-03-01]. https:∥arxiv.org/abs/1301. 3781.

[14] PenningtonJ, SocherR, ManningC. Glove: global vectors for word representation[C]∥Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), 2014, Doha, Qatar. [S.l.: s.n.], 2014: 1532- 1543.

[18] YangY, NewsamS. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proceedings of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems-GIS'10, November 2-5, 2010, San Jose, California, USA. New York: IEEE, 2010: 270- 279.

[21] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. ( 2015-04-10)[2019-03-01]. https:∥arxiv.org/abs/1409. 1556.

Article Outline

吴晨, 于光, 张凤晶, 刘宇, 袁昱纬, 全吉成. 基于词向量一致性融合的遥感场景零样本分类方法[J]. 光学学报, 2019, 39(8): 0828002. Chen Wu, Guang Yu, Fengjing Zhang, Yu Liu, Yuwei Yuan, Jicheng Quan. Zero-Shot Classification Method for Remote-Sensing Scenes Based on Word Vector Consistent Fusion[J]. Acta Optica Sinica, 2019, 39(8): 0828002.