基于条件生成对抗网络的低照度遥感图像增强  下载: 996次

下载: 996次

1 引言

遥感图像在光照条件不足时会出现图像对比度低、色彩失真、饱和度低等现象,进而产生低照度遥感图像,对后续图像的处理产生消极影响。因此,对低照度遥感图像的亮度以及对比度的增强处理具有积极意义[1]。近年来,已有许多种图像增强方法相继被提出,直方图均衡化(HE)可使变换后图像灰度的概率密度呈均匀分布[2]。 Land于1965年提出Retinex算法,它是一种根据人眼的视觉特性以及不同的图像应用场合,模拟大脑视觉皮层成像的方法[3]。随后,出现了单尺度 Retinex算法(SSR)、多尺度 Retinex算法(MSR)和带色彩恢复的 MSR算法(MSRCR)[4]。但SSR不能同时满足动态范围压缩和色彩恒定性,MSR可能会出现色彩失真现象,MSRCR处理的低照度图像的细节并不明显[5]。Dong等[6]利用基于暗通道先验的去雾技术对取反后的低照度遥感图像进行处理,然后将得到的结果再次取反,但增强后的图像在亮度和细节方面仍有不足。

针对以上问题,本文提出一种在HSI色彩空间内利用条件生成对抗网络处理亮度分量以及改进的对数变换增强饱和度的方法,使处理后的图像具有更好的视觉效果。所提方法中增加了焦点损失函数[7],解决了样本不平衡的问题,使增强后的图像亮度与饱和度适中,细节清晰。

2 相关理论

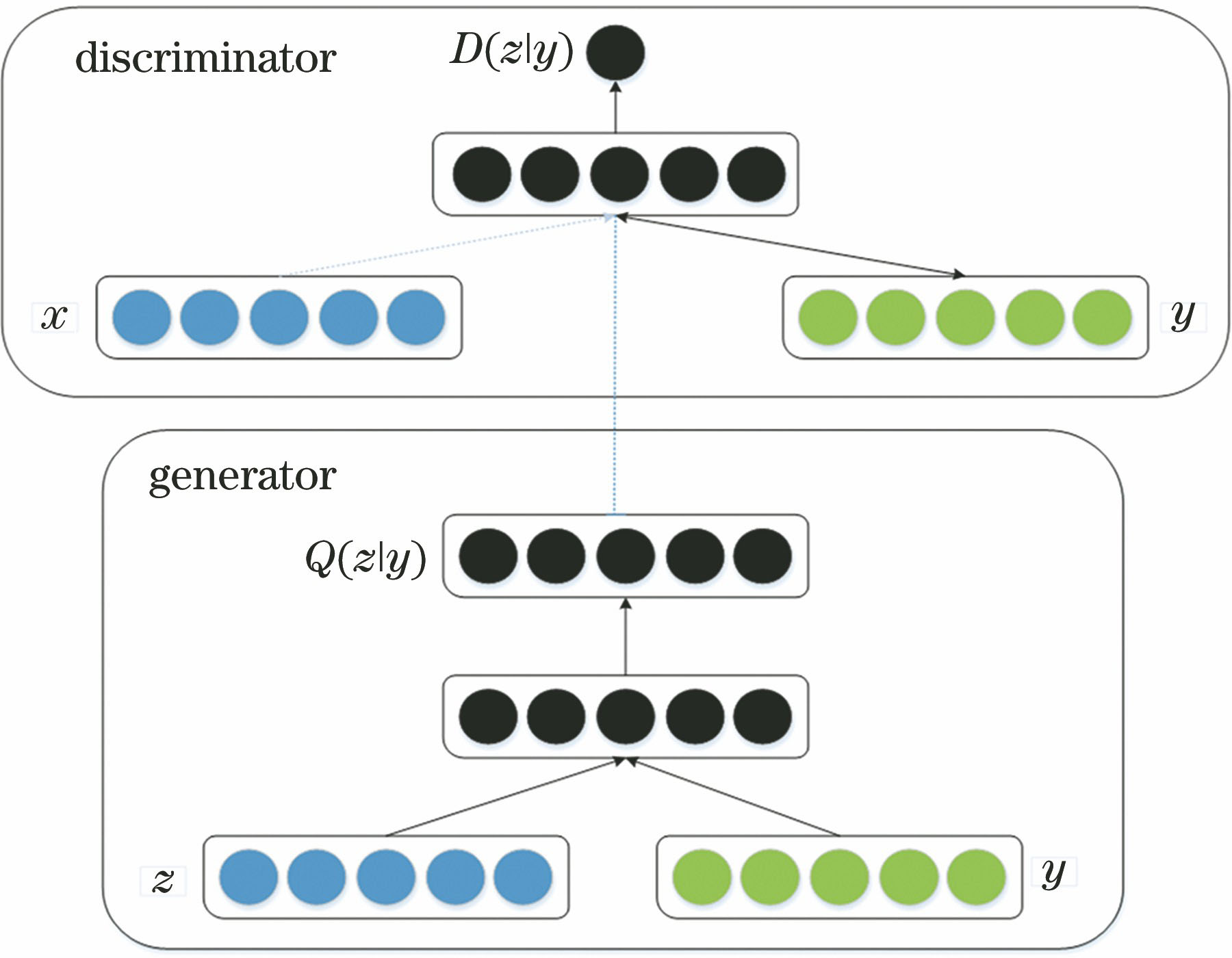

生成式对抗网络(GAN)是当前人工智能学界最为重要的研究热点之一[8]。条件生成对抗网(CGAN)[9]相较于原始GAN增加了条件信息[10],有条件地监督生成器Q生成数据,条件信息y作为生成器和判别器的输入,可以是任意信息,本研究中y为图像信息。同时输入噪声z和条件信息y后,生成器输出生成遥感图像。将真实数据x和条件信息y以及生成遥感图像同时输入到判别器D中,判别器输出判别概率,概率为[0,1]。CGAN的优化过程可以归结为二元极小极大值博弈过程,其目标函数V(D,Q)可表示为

式中:E(·)表示分布函数的期望值;Pdata(x)表示真实图像分布;P(z)表示低维的噪声分布[11]。CGAN模型如

3 本文方法

3.1 图像增强算法模型

针对当前已有算法的缺陷,本研究在HSI色彩空间内将条件生成对抗网络和改进的对数变换相结合来处理图像。首先,对低照度遥感图像实现从RGB到HSI的转换。通道拆分时,保持色调H不变,利用条件生成对抗网络和改进的对数变换分别增强亮度分量I和饱和度分量S。然后,将H与增强后的I'和S'进行通道合并,再转换到RGB空间,得到增强的遥感图像。本文算法流程如

3.2 色彩空间转换

采用几何推导法实现RGB和HSI的相互转换[12]。从RGB空间转到HSI空间的基本公式为

式中:θ=arccos

从HSI空间转换到RGB空间的基本公式如下:

当H∈

当H∈

当H∈

3.3 CGAN处理亮度分量

采用CGAN增强图像的亮度分量I,生成网络采用U-Net模型,设计了8个卷积层和8个反卷积层的结构,判别器中定义了5个卷积模块。在损失函数中引入焦点损失和L1-正则化损失函数,对合成的低照度遥感图像和正常光照的遥感图像进行训练和校正。

3.3.1 生成网络

本文方法以不丢失图像信息为前提对图像进行增强。为了更好地保留图像信息,生成器的设计采用了U-Net模型[13],U-Net模型是FCN结构的改进和延伸,包含提取图像特征的下采样过程和还原图像细节信息的上采样过程,即编码阶段和解码阶段。U-Net利用skip connection结构以及编码器与解码器的对称性使得裁剪以及拼接过程更加合理、直观。生成器结构如

在对低照度遥感图像进行亮度增强处理时,输入的低照度遥感图像和正常光照的遥感图像有很多相同的信息。U-Net模型使用skip connection结构来减轻网络压力。在生成网络左半部分进行下采样操作,提取低照度遥感图像的特征,展现环境信息;在右半部分进行上采样操作,逐步还原图像精度。所有的卷积层都使用batch normalization层与leaky ReLU激活层。每层卷积后的特征都进行批归一化与dropout操作[14],以加速收敛,避免过拟合。U-Net模型的skip connection结构包含了输入图像的很多信息,有助于还原下采样所带来的信息损失,因此,U-Net的skip connection操作是很有必要的。

3.3.2 判别网络

利用判别器鉴别生成器生成遥感图像与正常光照的遥感图像,尽量把生成器生成的图像和真实图像区分开,使生成器生成与真实图像尽可能相似的遥感图像,并判断图像的真假。判别器的所有卷积层都使用batch normalization层与leaky ReLU激活层,以达到加速收敛,控制过拟合的目的。 如果判别器的输出在(0.5,1)区间,则判别器判别图像为真;如果判别器的输出在(0,0.5)区间,则判别器判别图像为假;若输出值稳定在0.5,则说明生成器生成了判别器无法判别的图像。所设计的判别器最后一层使用 Sigmoid 激活函数,其结构如

3.3.3 损失函数

设{Ii,i=1,2,…,N}和{Ji,i=1,2,…,N}分别表示低照度遥感图像和相应的正常光照图像。CGAN利用原始目标函数进行训练,损失函数为

式中:D(·)表示判别网络;

式中:

样本中不同类别的样本量差异很大,会导致样本量少的分类所包含的特征过少,并很难从中提取规律,即使得到分类模型,也容易产生过度依赖与有限的数据样本导致的过拟合问题,当模型应用到新的数据上时,模型的准确性会很差,因此引入焦点损失函数来解决样本不平衡问题。函数定义为

式中:-ln pt表示交叉熵损失函数;ξ表示权重因子;γ为调制因子。本研究中γ=2,ξ=0.25。

通过修改标准的交叉熵损失函数,降低容易分类样本的权重,为交叉熵损失函数增加权重因子ξ,以避免梯度的更新方向由负样本主导。当Pt值很小时,调制因子接近于 1,焦点损失函数不受影响。随着Pt接近1,调制因子接近于0,则容易分类的样本损失函数权重降低,参数γ平滑地调整那些权重被降低的损失函数所占的比例。随着γ增加,其对调制因子的影响也会随之增加,实验中发现γ=2 时效果最佳。

最后,将对抗性损失、L1-正则化和基于内容的像素方式损失与焦点损失函数结合,规范所提出的生成对抗网络。损失函数的定义为

式中:a、b、c均表示权重[11]。根据(7)式对生成器进行修改,利用(12)式对判别器进行更新

3.4 饱和度分量处理

在H不变的前提下,使用改进的对数变换方法处理S。首先计算饱和度分量S,公式为

Sigmoid函数也称为S型生长曲线, 函数的输出映射在[0,1]区间,单调连续,并且在0.5处中心对称,越靠近x=0,其取值斜率越大。在对数变换中,使用对数函数处理后的图像容易造成图像信息的丢失,Sigmoid函数具有良好的性质,因此,采用自定义Sigmoid函数来代替对数函数。对数函数处理后的图像像素可能出现负值,导致像素超过显示范围,而Sigmoid函数仅考虑0的右边区域。本研究采用切合的Sigmoid函数代替对数函数,调整后的饱和度分量用S'表示,计算公式为

式中:k为曲线的陡峭程度;α为伸缩尺度,用来控制饱和度增强程度。多次实验表明,当k=1.5时,饱和度处理效果最佳,自定义Sigmoid函数与原Sigmoid函数曲线如

4 实验与分析

4.1 实验环境与参数设置

以PyCharm为仿真平台,CPU为Inter Core i7-8550,内存为8 GB。使用GPU并行加速,训练前利用正常光照图像合成1501幅低照度遥感图像,其中1050幅作为训练集,451幅作为测试集。模型epoch设置为200,batchsize设置为1,优化算法采用Adam(adaptive moment estimation),学习率为0.0002,采用Python语言,在Tensorflow深度学习框架下完成实验,训练所用时间约为11 h,测试时间约为4 min。

4.2 样本制作

在弱光照图像领域,目前还没有既包含低照度遥感图像又包含与之对应的正常光照遥感图像的数据集。因此,本研究利用正常光照的图像合成低照度图像[16]。

本研究选取UC Merced Land Use Dataset[17]遥感图像数据集,数据集中包含农田、建筑物、树丛和海滩等21类场景遥感图像,图像格式均为.jpg,分辨率为1英尺(0.3048 m),分别对256 pixel×256 pixel和380 pixel×380 pixel的图像进行处理。本文算法随机选取1501幅正常光照的遥感图像,然后将图像转换到HSI色彩空间,对亮度I通道图像作伽马变换,得到合成低照度遥感图像的I通道图像

4.3 实验结果对比

4.3.1 256 pixel×256 pixel图像的实验结果

首先对尺寸为256 pixel×256 pixel的图像进行处理,使用经典算法HE和MSR、MSRCR、Dong算法进行实验分析。在主观评价中,选取UC Merced Land Use Dataset数据集中6幅图像为例进行说明,如

从

4.3.2 380 pixel×380 pixel图像的实验结果

低照度遥感图像以及经过本文算法处理后的图像如

图 7. 不同算法对256 pixel×256 pixel图像主观视觉对比。(a)原始图像;(b) HE;(c) MSR;(d) MSRCR;(e) Dong;(f)本文算法

Fig. 7. Comparison of 256 pixel×256 pixel subjective visual images via different algorithms. (a) Original images; (b) HE; (c) MSR; (d) MSRCR; (e) Dong; (f) proposed algorithm

图 8. 380 pixel×380 pixel图像经本文算法处理后的结果

Fig. 8. Results of 380 pixel×380 pixel images processed by proposed algorithm

从

4.3.3 重要参数伸缩尺度对结果的影响

在算法的饱和度分量处理过程中,自定义的Sigmoid函数存在的伸缩尺度参数α可用来调节饱和度分量的处理变换程度,参数α的取值不同,所得到的实验结果也不尽相同。选取α=2.1、α=4和α=6,比较不同参数对实验产生的影响,结果如

饱和度是指色彩的鲜艳程度,也被称为色彩的纯度。从

4.4 图像质量客观评价

在客观评价中,选取峰值信噪比(PSNR)、均方误差(MSE)、结构相似度(SSIM)[18]、图像的对比度(CON)和饱和度(SAT)作为指标来说明算法性能的优劣,得到多幅图像的评价指标及其均值如

图 9. α取值不同的实验结果。(a)原始图像;(b) α=2.1;(c) α=4;(d) α=6

Fig. 9. Experimental results of different values of α. (a) Original images; (b) α=2.1; (c) α=4; (d) α=6

表 1. 不同算法的客观评价指标对比

Table 1. Comparison of objective evaluation indexes of different algorithms

|

PSNR反映图像的失真程度,本文算法的PSNR值最高,失真最少。 MSE反映增强后的图像与原图像之间的差距,其值越小说明增强后的图像亮度越接近原始图像,本文算法的MSE值最小,说明本文算法处理后的结果与原始遥感图像最接近。SSIM表示图像结构信息的完整性,其值可以作为对比原图像和处理后图像结构相似程度的指标,本文算法增强后的图像与原始遥感图像的结构最相似。对比度是图像亮暗的拉伸对比程度,表现了图像画质的清晰程度[19],本文算法处理后的图像对比程度最高,处理后的图像最清晰,视觉效果最好。饱和度是指图像色彩的鲜艳程度,一幅图像的饱和度越大,它的色彩越鲜明,视觉效果也就越好。因此,利用平均饱和度从颜色角度对图像的处理效果进行评价,由多幅图像求取并规范到[0,1]进行比较,由

5 结论

根据深度学习理论,利用一种在HSI色彩空间中利用改进的对数变换与条件生成对抗网络相结合的方法对低照度遥感图像进行增强。其中,采用条件生成对抗网络增强图像的亮度,利用改进的对数变换增强图像的饱和度,在损失函数中加入焦点损失函数来消除类别不平衡的现象。通过主观评价和客观评价的综合分析,所提算法在增强了低照度遥感图像的亮度和饱和度的同时,也避免了色彩失真现象,有效地对低照度遥感图像进行了增强。在下一步研究中,将尝试优化网络,使图像更加清晰。

[1] 杜泽星, 殷进勇, 杨建. 基于密集连接网络的遥感图像检测方法[J]. 激光与光电子学进展, 2019, 56(22): 222803.

[2] 朱会平, 魏峰远. 探讨图像增强中直方图均衡化的应用[J]. 测绘与空间地理信息, 2010, 33(1): 174-176.

Zhu H P, Wei F Y. Discussion on the application of histogram equalization in image enhancement[J]. Geomatics & Spatial Information Technology, 2010, 33(1): 174-176.

[3] 邵帅. 空间光学遥感影像的实时清晰度提升技术研究[D]. 北京: 中国科学院大学, 2019.

ShaoS. Research on image real time definition improvement for space optical remote sensing images[D]. Beijing: University of Chinese Academy of Sciences, 2019.

[4] 邵帅, 郭永飞, 刘辉, 等. HSI色彩空间下的低照度遥感图像增强[J]. 光学精密工程, 2018, 26(8): 2092-2099.

[5] 李垚峰, 何小海, 吴小强. 改进的带色彩恢复的多尺度Retinex雾天图像增强算法[J]. 计算机应用, 2014, 34(10): 2996-2999, 3023.

Li Y F, He X H, Wu X Q. Improved enhancement algorithm of fog image based on multi-scale Retinex with color restoration[J]. Journal of Computer Applications, 2014, 34(10): 2996-2999, 3023.

[6] Dong X, Wang G, Pang Y, et al. Fast efficient algorithm for enhancement of low lighting video[J]. Journal of Information and Computation Science, 2011, 10(7): 1-6.

[7] Lin TY, GoyalP, GirshickR, et al. Focal loss for dense object detection[C]∥2017 IEEE International Conference on Computer Vision, October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2980- 2988.

[8] 林懿伦, 戴星原, 李力, 等. 人工智能研究的新前线: 生成式对抗网络[J]. 自动化学报, 2018, 44(5): 775-792.

Lin Y L, Dai X Y, Li L, et al. The new frontier of AI research: generative adversarial networks[J]. Acta Automatica Sinica, 2018, 44(5): 775-792.

[9] MirzaM, OsinderoS. Conditional generative adversarial nets[EB/OL]. [2019-10-08].https: ∥arxiv.org/abs/1411. 1784.

[10] Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets[J]. Proceedings of the 27th International Conference on Neural Information Processing Systems, 2014, 2: 2672-2680.

[11] 梁毓明, 张路遥, 卢明建, 等. 基于条件生成对抗网络的图像去雾算法[J]. 光子学报, 2019, 48(5): 0510002.

[12] 龚文斌, 石章松, 韦华. 高分辨率遥感卫星图像不均匀云雾去除算法[J]. 激光与光电子学进展, 2020, 57(6): 061504.

[13] RonnebergerO, FischerP, BroxT. U-net: convolutional networks for biomedical image segmentation[M] ∥Lecture Notes in Computer Science. Cham: Springer International Publishing, 2015: 234- 241.

[14] 贾绪仲. 基于深度学习的图像去雾方法研究[D]. 株洲: 湖南工业大学, 2018.

Jia XZ. Image dehazing using deep learning[D]. Zhuzhou: Hunan University of Technology, 2018.

[15] Srivastava N, Hinton G E, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[16] 程宇, 邓德祥, 颜佳, 等. 基于卷积神经网络的弱光照图像增强算法[J]. 计算机应用, 2019, 39(4): 1162-1169.

Cheng Y, Deng D X, Yan J, et al. Weakly illuminated image enhancement algorithm based on convolutional neural network[J]. Journal of Computer Applications, 2019, 39(4): 1162-1169.

[17] YangY, NewsamS. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proceedings of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems, November 2-5, 2010, San Jose, California. New York,USA: ACM Press, 2010: 270- 279.

[18] 余婷. 基于SSIM的非局部全变分去噪方法研究[D]. 西安: 西安电子科技大学, 2014.

YuT. A study of nonlocal total variation for image denoising based on SSIM[D]. Xi'an:Xidian University, 2014.

[19] 苏金凤, 张贵仓, 汪凯. 结合鲁棒主成分分析和非下采样轮廓波变换的红外与可见光图像的压缩融合[J]. 激光与光电子学进展, 2020, 57(4): 041005.

Article Outline

彭晏飞, 杜婷婷, 高艺, 訾玲玲, 桑雨. 基于条件生成对抗网络的低照度遥感图像增强[J]. 激光与光电子学进展, 2020, 57(14): 141015. Yanfei Peng, Tingting Du, Yi Gao, Lingling Zi, Yu Sang. Low-Illumination Remote Sensing Image Enhancement Based on Conditional Generation Adversarial Network[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141015.