基于方向可靠性的互补跟踪算法  下载: 1012次

下载: 1012次

tracking based on correlation filter has become a research hotspot currently. The traditional tracking model trained from circular correlation is sensitive to the pixel arrangement of the target and is difficult to adapt object deformation, but it has good robustness of variety in color of illumination and similar color interference. However, the model based on spatial reliability can adapt to the deformation by establishing the spatial confidence map as the random field constraint of the correlation filter, but it has less robustness for the color change. In order to exert the superiorities of the two tracking methods, the concept of directional reliability is innovative presented and a set of the optimization strategies is proposed to achieve optimal translation estimation of the two tracking models in both the

1 引言

目标跟踪是计算机视觉中的一个基础性问题,在机器人、智能监控和自动化等领域有着重要的意义和广泛的应用。目标跟踪的基本问题是:在一个视频或图像序列中选择感兴趣的目标作为跟踪对象,并如何使计算机在后续的图像帧中,准确而持续地跟踪到该目标的位置。近年来这个问题引起了人们广泛的兴趣,相关的跟踪算法[1-20]发展速度很快,同时形成了一套标准的评价体系,主要分为目标跟踪基准数据集(OTB)[21-22]和视觉目标跟踪数据集(VOT)[23]。当前跟踪算法按照模型产生方式的不同主要分为生成式方法[15-20]和判别式方法[1-14]。生成式方法首先生成目标表观模型,然后在后续帧中搜索与目标模型最相似的区域。判别式方法以目标为正样本、以背景为负样本来训练分类器,并生成具有判别力的跟踪模板以在后续中查找最优区域。

近年,基于判别相关滤波器(DCF)的判别式方法逐渐发展成熟,并以其优异的表现成为当前的主流方法[1-12]。Bolme等[1]提出误差最小平方和滤波器并将相关滤波引入目标跟踪;在此基础上,Henriques等[2]引入循环移位和岭回归的模板训练方法,提出了含核的跟踪检测循环结构(CSK),奠定了当前相关滤波跟踪的主要框架,之后为了增强模型的判别力,引入了核函数,提出著名的核化相关滤波器(KCF)[3]。CSK和KCF算法极大地提升了原始算法的效率和准确性,使得基于相关滤波的目标跟踪方法在理论和实践中赶超传统的生成式和判别式方法,并成为当前研究的热点和主流。但是由于目标的形变、光照变化、运动模糊、相近背景干扰、尺度变化以及遮挡等问题,如何实现稳健的跟踪仍然富有挑战性。在此基础上,越来越多的学者开展了更加深入的研究。

针对目标尺寸在运动中发生变化的情形, Li等[4]在KCF的基础上,将相关滤波器与缩放的图像进行相关检测,由最大响应值同时得到目标的位置和大小,提出了基于特征融合的尺度自适应核相关滤波器跟踪器(SAMF);Danelljan等[5-6]则分别对位置和大小进行检测,先用传统方法找到目标的位置,再用所提出的多尺度相关滤波器检测目标的大小,提出了判别规模空间追踪器(DSST)算法[5];之后又加入主成分分析(PCA)算法对目标特征进行降维,实现了fDSST(fast-DSST,即DSST加速实现算法)[6]。为了解决循环移位存在的边界效应以及更好地突出目标,Galoogahi等[7]提出用零填充滤波器来进行学习;Possegger等[8]通过直方图统计建立前景和背景的颜色概率模型,用贝叶斯公式和阈值处理得到目标的颜色概率区域,提出了基于统计颜色特征的跟踪(DAT)算法。Danelljan等[9]引入空间正则化以惩罚目标边界外的滤波器值;Lukeži

上述方法多采用单一的跟踪模板进行目标跟踪,未考虑不同跟踪模板之间的互补性。Lukeži

为了实现最优的结合算法,自然存在如何充分发挥两个跟踪模板的互补优势的问题。Staple算法[11]将两种跟踪器的响应直接乘以常系数进行线性叠加,但是在实际跟踪过程中,由于两种跟踪器之间也存在一定的互补性,例如某些情况下,一个跟踪器的响应有偏差,另一个相对准确,而在其他某些情况下却相反。在缺少反馈信息的情况下,直接将两者叠加,则其中任何一个模板出现错误或偏差都会影响整体跟踪结果,无法充分发挥两种模板的互补优势。文献[

13]中提出一种跟踪置信度指标平均峰值相关能量(APEC) ,当跟踪置信度较高时才进行模板的更新。受此启发,将

2 相关滤波跟踪算法

主要介绍基于判别相关滤波器进行跟踪模板训练的基本方法及引入空间置信图作为约束而得到的基于空间可靠性的相关滤波跟踪的理论。

2.1 判别相关滤波器

判别DCF基本思想是:以当前帧的样本训练一个分类器,计算其与下一帧的样本卷积,以响应最大值点作为目标的跟踪位置。DCF的核心思想在于引入循环矩阵,可以获取到密集的训练样本,保证了分类器的可靠性;同时又使分类器求解过程中的空间卷积操作转换为频域点积,降低了算法的时间复杂度。分类器即跟踪模板

式中:

由文献[

2]求(1)式的岭回归解,即可得到当前训练的跟踪模板

式中:

计算

2.2 基于空间可靠性的相关滤波跟踪

当目标发生形变、旋转时,传统的基于特征的相关滤波由于采用循环矩阵进行密集采样,所得到的跟踪模板对于像素的排序犹为敏感,且易受背景的干扰,当目标发生形变时很容易丢失目标。借鉴图像分割的方法,将前景与背景区分开,可以在突出目标的同时减小背景的影响。考虑到跟踪实时性的需要,Lukeži

对跟踪区域内的像素计算上述概率可得空间置信图

式中:

由文献[

24]中的交替方向乘子法最小化(4)式,得

由

由此可以基于空间可靠性,即利用空间置信图进行约束,由第

3 基于方向可靠性的互补跟踪算法

3.1 互补跟踪模板

在多个跟踪测试序列上进行测试,实验结果验证了基于空间可靠性的相关滤波跟踪方法在目标发生形变、旋转时确实具有较好的稳健性,但当目标与环境的颜色相近或有颜色相近的物体干扰时,基于空间可靠性的跟踪方法中使用颜色统计的方法难以正确地将目标与背景区分开来,有时还会将背景中的相似物体错误地当成目标区域而将正确的目标排除在外,造成目标的漂移和丢失。而此时使用HOG特征的传统相关滤波跟踪具有相对较好的稳健性,且复杂度较低。利用(5)~(7)式训练得到基于空间可靠性的跟踪模板

3.2 基于方向可靠性的最优判别方法

既然有两种互补性较好的跟踪模板,为了尽可能地提高跟踪的稳健性和准确性,需要在每一帧以跟踪模板的最优位移结果进行跟踪,以实现两种跟踪模板的“强强结合”。然而事实上很难区分跟踪模板的优劣,此时对跟踪模板做出评价和判别的参考性指标至关重要。Bertinetto等[11]提出Staple,将模板特征方法[5]和统计特征方法[8]得到的跟踪模板直接以常系数线性相加得到互补的模板来进行跟踪,对两种模板缺乏判别及优先机制,当某一模板出现偏差或错误时,势必影响到整个算法。文献[

13]中提出相关滤波响应置信度指标,用于对单一跟踪模板置信度的评价,当响应置信度较高时才进行模板更新,然而该指标对于本文两种跟踪模板的评价并不具有良好的参考性。进一步来说,传统的单个相关滤波的位移跟踪是在跟踪模板与图像进行卷积之后,通过最大响应峰值点的偏移量分别定位横、纵方向,即

3.2.1 方向可靠性的提出

相关滤波跟踪中,由于岭回归的目标函数为高斯函数,因此理想的跟踪响应图是只有一个尖锐单峰且周围平滑的类高斯函数。实际情况下,由于环境中存在相似目标干扰,以及目标本身的形变、色变和遮挡等都会对响应图造成或小或大的波动,且干扰物的位置与响应图上的位置对应。对于目标跟踪来说,在目标跟踪未出现丢失的情况下,最需要关注的是横、纵方向上的响应波动,可以在一定程度上体现两个坐标定位的可靠性。因此,将响应峰值点(

式中:

3.2.2 最优模板判别和更新方法

为了判别上述3种情况,由(9)式及其在多个图像序列上进行实验论证的基础上,提出一套基于方向可靠性的最优判别的方法。通过两个跟踪模板的

若是,则认为两种模板跟踪的可靠性相近,一般情况下均跟踪到了目标,此时分别比较

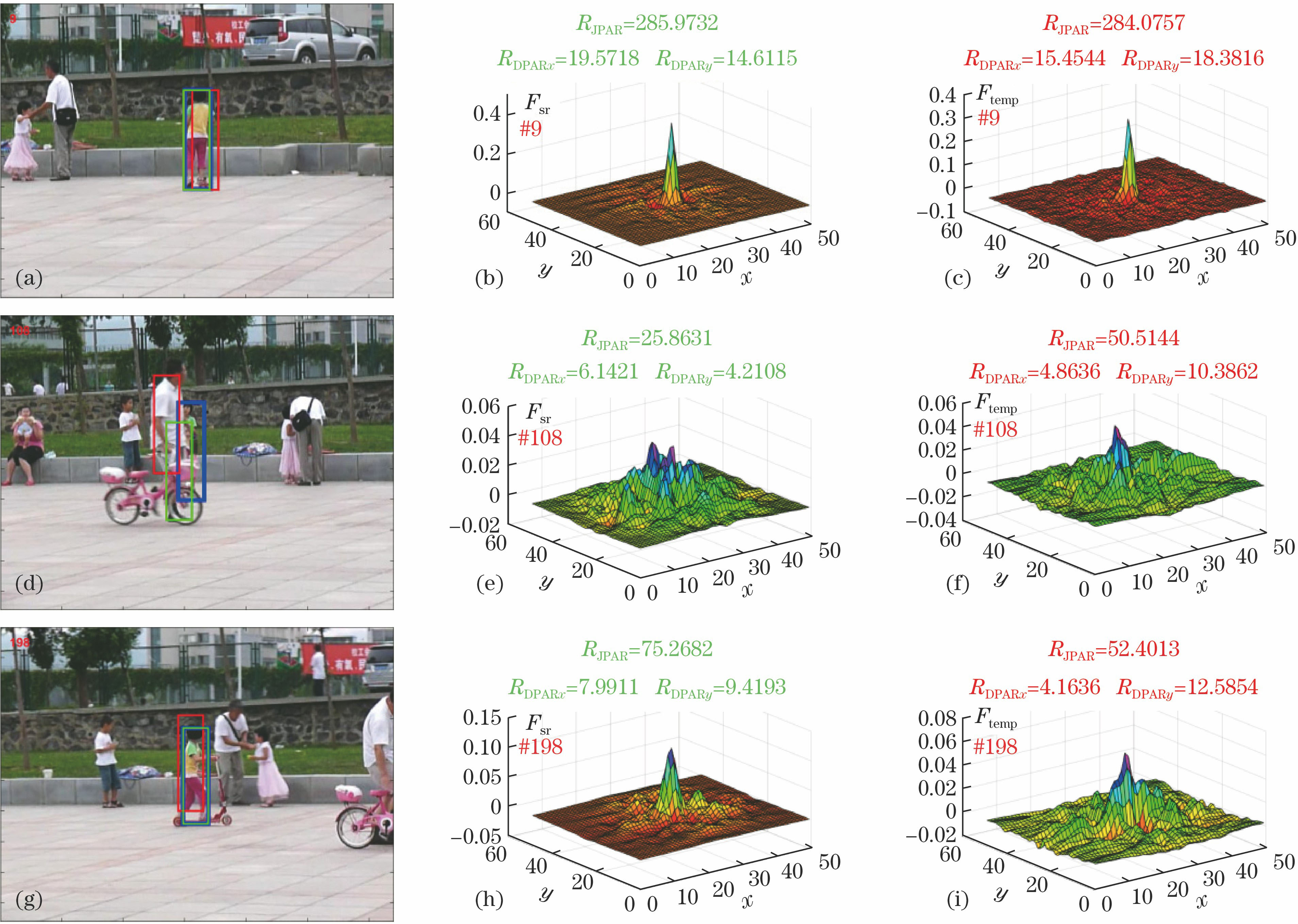

图 1. OTB测试集中Girl2序列的跟踪结果的典例示意图。(a)、(d)、(g)蓝色框为本文判优后的跟踪结果,绿色框为模板hsr的跟踪结果,红色框为模板htemp的跟踪结果; (b)、(e)、(h)模板hsr的响应图; (c)、(f)、(i)模板htemp的响应图

Fig. 1. Tracking results of sequence Girl2 from OTB test set. (a), (d), (g) Blue bounding boxes indicate the tracking results of proposed method with the optimization strategies, the green bounding boxes indicate the tracking results of hsr, and the red ones belong to the htemp; (b), (e), (h) corresponding to hsr; (c), (f), (i) corresponding to htemp

则认为其中一个模板相对于

3.3 互补跟踪算法的实现

所提出的互补跟踪算法基于相关滤波跟踪框架,主要分为位移估计和跟踪模板更新。本文算法的核心在于,在有机地结合两个跟踪模板的基础上实现最优的互补。框架中的算法采用文献[ 6]中的尺度估计方法,在位移估计之后进行,具有灵活性。为了使本文算法表达的更加清晰和完整,将各个步骤列出并归纳为算法1。

算法1 互补跟踪算法流程

输入:

图像帧

输出:

当前帧目标位置

位移及尺寸估计:

1) 采用(9)式计算

2) 采用3.2.2节方法分别估计

3) 以文献[

6]方法在当前位置

跟踪模板更新:

4) 由3.2.2节中的方法判断两种模板更新情况,确定其更新速率

5) if

采用(5)~(7)式计算new_

以速率

else end

循环进行以上步骤。

相关滤波的框架较为灵活且易于拓展,对于位移估计具有较高的效率和准确性。本文在传统的相关滤波跟踪的框架下加入了方向可靠性对两种跟踪模板进行综合分析,实现两种跟踪模板的最优互补。同时由方向可靠性来决定模板是否更新及更新的速率,在一定程度上抑制模型的漂移,特别是在目标发生遮挡时可以提高跟踪算法的稳健性。这对于其他相关滤波跟踪算法也有借鉴意义。

4 实验结果及分析

选取标准测试集OTB,主要考虑其具有客观性和权威性,以便与其他优秀的算法进行定性分析和定量对比。对OTB2013的50个跟踪图像序列以及OTB2015拓展后的100个跟踪图像序列全部进行测试,选取fDSST[6]、CSR-DCF[10]、空间正则化相关滤波跟踪(SRDCF)[9]、Staple[11]、自适应样本优化的判别跟踪(SRDCFdecon)[18]的公开结果进行对比和分析。所有的实验都是基于CPU为Intel Core i5-4590,3.3GH主频和12GB内存的台式机上进行的,测试开发平台为MATLAB 2016b。在所有的100个测试序列上运行的平均帧率为13.78 frame/s,与本文基准算法CSR-DCF[10]基本持平,在可接受范围内。

4.1 定性分析

图 2. 本文算法(绿色框)与fDSST算法(蓝色框)、CSR-DCF算法(红色框)的定性跟踪结果对比。(a) Soccer序列;(b) Basketball序列;(c) Shaking序列;(d) Human5序列;(e) Girl2序列

Fig. 2. Qualitative tracking results comparison for proposed method (green), fDSST method (blue) and CSR-DCF method (red). (a) Sequence soccer; (b) sequence basketball; (c) sequence shaking; (d) sequence human5; (e) sequence girl2

从OTB的100个测试序列中[21-22]选取了几组典型的图像序列,与本文互补算法中的两种基准算法进行对比分析,如

4.2 定量分析

为了更加客观精确地分析本文算法的准确性和稳健性,选用近年来较为流行和权威的曲线评价方法OPE(One-Pass Evaluation)。OTB测试集[21-22]为此提供了客观性指标:1) 精确度指标图,给定的阈值精度距离之内的帧数占总帧数的百分比,表征跟踪算法的准确性;2)成功率指标图,度量不同边框重叠率阈值下的跟踪成功率,表征跟踪算法的稳健性。选取近年来表现优秀的SRDCF[9]、Staple[11]、SRDCFdecon[18],fDSST[6]、CSR-DCF[10]算法与本文算法进行分析比较。

4.2.1 OTB2013

OTB2013标准测试集中包括50组经过标定的跟踪序列,在该测试集上进行测试后分别与SRDCF[9]、SRDCFdecon[18]、Staple[11]、fDSST[6]、CSR-DCF[10]算法的公开结果进行对比,得到如

图 3. OTB2013测试集上,不同算法的精确度和成功率对比。(a)精确度;(b)成功率

Fig. 3. Comparison of precision and success rate of different methods on OTB2013 test set. (a) Precision; (b) success rate

本文算法相比基准算法fDSST与CSR-DC在跟踪精度上分别提升了14.8% 和9.0%,在跟踪成功率上分别提升了11.1%和7.2%;与次优的SRDCFdecon跟踪算法相比,本文算法的跟踪精度高出3.4%,跟踪成功率高出1.2%。因此在测试集上的对比结果表明,本文算法相比于其他5种算法,在跟踪精度和稳健性上都具有一定的优势。

4.2.2 OTB2015

OTB2015在OTB2013的基础上将跟踪序列拓展到100组,更加具有权威性和说服力。由标准测试集进行评价的结果可以看出,同样本文算法在两个指标上均优于其他5种算法,如

图 4. OTB2015测试集上,不同算法的精确度和成功率对比。(a) 精确度;(b) 成功率

Fig. 4. Comparison of precision and success rate of different methods on OTB2015 test set. (a) Precision; (b) success rate

5 结论

在充分分析传统相关滤波跟踪模板与基于空间可靠性的跟踪模板的互补性的基础上,提出了一种稳健的基于方向可靠性的互补跟踪算法。引入了方向可靠性的概念,提出了最优判别方法,实现了两个模板在

[1] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[2] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥European Conference on Computer Vision, 2012: 702- 715.

[4] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[C]∥European Conference on Computer Vision, 2014: 254- 265.

[5] DanelljanM, HägerG, Khan FS, et al. Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Conference, 2014.

[6] Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[7] Galoogahi HK, SimT, LuceyS. Correlation filters with limited boundaries[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2015: 4630- 4638.

[8] PosseggerH, MauthnerT, BischofH. In defense of color-based model-free tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2015: 2113- 2120.

[9] DanelljanM, HägerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥IEEE International Conference on Computer Vision, 2015: 4310- 4318.

[10] Lukeži cˇ A , VojírT, Zajc LC, et al. Discriminative correlation filter with channel and spatial reliability[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017, 4847- 4856.

[11] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: Complementary learners for real-time tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401- 1409.

[12] 赵高鹏, 沈玉鹏, 王建宇. 基于核循环结构的自适应特征融合目标跟踪[J]. 光学学报, 2017, 37(8): 0815001.

[13] Wang MM, LiuY, Huang ZY. Large margin object tracking with circulant feature maps[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4800- 4808.

[15] He SF, Yang QX, Lau R W H, et al. Visual tracking via locality sensitive histograms[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2427- 2434.

[16] JiaX, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1822- 1829.

[18] DanelljanM, HägerG, Khan FS, et al. Adaptive decontamination of the training set: a unified formulation for discriminative visual tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1430- 1438.

[19] 金泽芬芬, 侯志强, 余旺盛, 等. 基于协方差矩阵的多特征融合跟踪算法[J]. 光学学报, 2017, 37(9): 0915005.

[20] 杨福才, 杨德东, 毛宁, 等. 基于稀疏编码直方图的稳健红外目标跟踪[J]. 光学学报, 2017, 37(11): 1115002.

[21] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411- 2418.

[22] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[23] KristanM, MatasJ, LeonardisA, et al. The visual object tracking VOT2015 challenge results[C]∥IEEE International Conference on Computer Vision Workshop, 2016: 564- 586.

Article Outline

宋日成, 何小海, 王正勇. 基于方向可靠性的互补跟踪算法[J]. 光学学报, 2018, 38(10): 1015001. Richeng Song, Xiaohai He, Zhengyong Wang. Complementary Object Tracking Based on Directional Reliability[J]. Acta Optica Sinica, 2018, 38(10): 1015001.