基于显著矩阵与神经网络的红外与可见光图像融合  下载: 876次

下载: 876次

1 引言

图像融合是将多源传感器所采集的关于同一目标场景或者单一传感器所采集的关于不同场景的多幅图像中的信息进行整合,得到空间分辨率和光谱分辨率均有所提升的高质量图像[1]。可见光图像的空间分辨率较高且蕴含丰富的细节信息,但成像易受外界环境影响;红外图像虽然对比度较低、细节信息丢失严重,但是红外传感器成像非常稳定。红外与可见光图像具有互补性,二者融合后图像具有较好的视觉效果。红外与可见光图像融合现已应用于**、计算机视觉、社会安全等多个领域[2-3]。

多尺度几何变换以其独特的多尺度分析特性被广泛应用于红外与可见光图像融合。由于传统的小波变换无法获取图像的边缘和方向信息,因此研究者提出了新的多尺度分析工具以用于图像融合,如曲波变换[4]、轮廓波变换[5]、剪切波变换[6]、离散小波变换[7]等。近年来,Jin等[8]采用非下采样轮廓波变换法对源图像进行分解,并通过区域能量自适应准则对其中的低频子带进行融合处理,同时通过绝对值取大法与自适应高斯区域标准差准则对高频子带进行融合处理,融合图像中目标更为突出。冯鑫[9]采用联合稀疏表示对Tetrolet分解后的低频子带进行精确拟合,并根据改进神经网络的神经元点火次数对高频子带进行选择,融合图像有效保留了源图像的边缘信息与细节特征。非下采样剪切波变换(NSST)[10]以剪切波变换(ST)[11]为基础,具备较好的平移不变性,能够有效克服图像融合中的Gibbs失真。江泽涛等[12] 采用显著性、清晰度和标准差联合权重矩阵对经NSST分解后的低频子带进行加权融合,并采用双通道脉冲发放皮层模型对高频子带进行融合处理,解决了背景信息缺失与图像边缘保留不充分的问题。吴一全等[13]采用引导滤波并结合二维Tsallis熵、显著性特征提取对经NSST分解的低频子带进行增强融合,同时采用信息和取最大对高频子带进行融合处理,解决了图像融合中目标不够突出、细节不够丰富的问题。

目前,红外与可见光图像的融合仍然存在以下问题:首先,源图像来自不同的传感器,相关性较小,存在空间校正误差;其次,一般的多尺度变换运算较为复杂且对分解方向数目有一定的限制,无法对图像进行进一步的稀疏表示,这限制了融合效果的提升;最后,现有的融合方法对图像细节保留不够充分且融合图像的对比度较低,视觉效果并非最佳。

针对上述问题,本文以NSST为基础,并结合视觉显著性和脉冲耦合神经网络(PCNN),提出了一个图像融合算法。NSST作为多尺度变换模型的一种,可以对图像的配准误差进行一定程度上的修正,减小了融合误差;此外,NSST对剪切后的方向数没有限制且逆变换不需要合成方向滤波器,能更好地对图像进行稀疏表示并且降低运算的复杂度,提升运算效率。另外,低频子带的融合以视觉显著性为基础,可以突出图像的显著性区域特征,契合人眼视觉的观察效果;高频子带的融合借助脉冲耦合神经网络对图像整体细节的提取能力,通过结合改进的拉普拉斯能量和,根据输出的点火矩阵设定融合规则,实现图像边缘细节信息的保留。

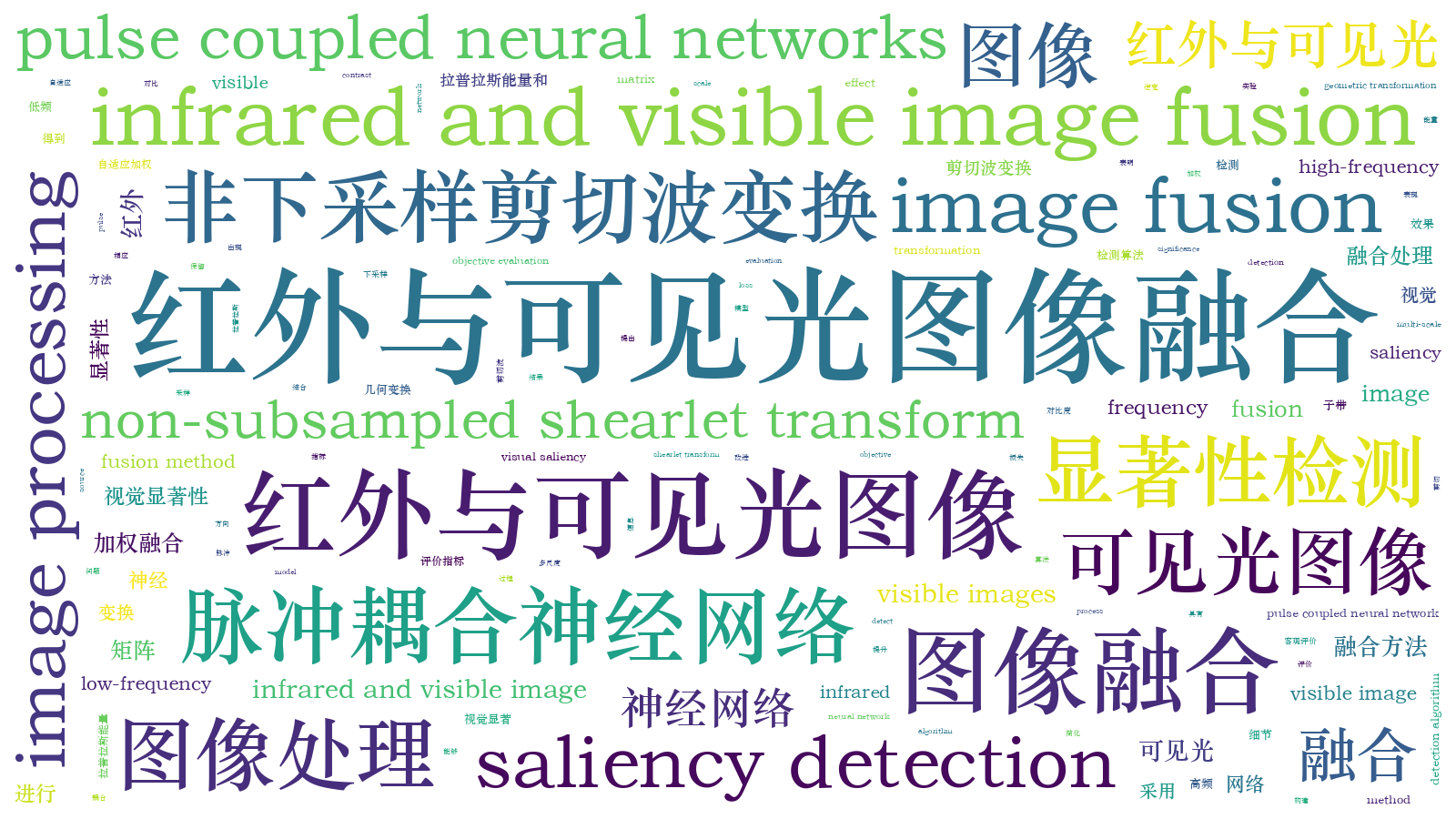

2 NSST分解模型

NSST对图像的分解过程分为多尺度分解和方向局部化两部分,多尺度分解的对象为源图像,通过非下采样塔式滤波器组(NSP)实现,每次分解可得到1个低频子带和1个高频子带。若源图像经过v级分解,则共可得到(v+1)个尺寸与源图像一致的子带。方向局部化的对象为多尺度分解后的低频子带,通过改进的剪切波滤波器(SF)实现,即先将标准剪切波滤波器从非极化坐标系映射到笛卡儿坐标系,再通过快速傅里叶逆变换计算二维卷积,从而得到改进后的剪切波滤波器,避免了下采样的操作,使NSST具有平移不变性,改善了Gibbs失真现象。此外,在方向局部化的过程中,可以根据需求选择长宽比可变的Meyer窗来自定义分解方向的数量,这打破了多尺度变换在分解方向上的局限性。若对某子带进行z个方向分解,则可以得到(2z+2)个与原子带大小相同的方向子带。以图像zoneplate为例,进行NSST分解,分解过程如

3 图像融合

本文提出的基于显著矩阵与脉冲耦合神经网络的图像融合算法如下:1)用快速引导滤波替换调谐(FT)图像显著性检测算法中的高斯滤波,并分别提取红外图像IR、可见光图像VIS的显著性特征,以构建二者的显著性矩阵;2)分别对IR、VIS进行l级的非下采样剪切波变换,并将变换结果分解为低频子带与高频子带的组合形式;3)针对低频子带,通过显著性矩阵,自适应地计算显著性加权系数并进行加权融合处理,得到融合后的低频系数;4)将IR、VIS的高频子带作为简化PCNN的输入,取IR、VIS的高频子带在点火矩阵中所有位置处的点火次数的差的绝对值,对差值绝对值与预设阈值进行比较:若差值绝对值处于阈值区间内,则采用多方向拉普拉斯能量和对对应位置处的高频子带系数进行自适应加权融合,若差值绝对值超出阈值区间,则根据点火次数选择高频子带系数,从而得到融合后的高频子带;5)对融合后的低频子带和高频子带进行多尺度逆变换,得到显著性特征明显且边缘细节信息丰富的融合图像。算法的整体流程如

3.1 低频子带融合

3.1.1 引导滤波

He等[15]提出引导滤波的概念,通过引导图像完成滤波过程。引导图像可以是待滤波图像本身,也可以是其他单独的图像。在引导图像的作用下,能够实现与双边滤波类似的保边平滑效果,不仅能够滤除图像噪声,还能够平滑边缘、保证梯度特性。

设输入图像为p,引导图像为G,引导滤波输出为O,则在以k为中心的局部窗口wk中,O与G之间的关系可以表示为

式中:Oc和Gc分别为图像O与G在位置c处的像素值;ak、bk为线性函数的系数;c为像素点索引。系数ak与bk通过线性回归求出:

式中:pc为输入图像p在c处的像素值;

3.1.2 融合规则

人类视觉系统在观察场景时会自动搜索并定位感兴趣的目标及区域,此种能力在计算机视觉领域中的应用即为视觉显著性检测,感兴趣区域称为显著性区域。FT[16]显著性检测算法通过对图像进行频率域分析,不仅能够捕捉显著性目标、突出显著性区域,还能够忽略噪声,并输出全分辨率显著图,当FT显著性检测算法指导低频子带的融合时,图像的显著性特征得到较好的体现。

设输入图像为I,其显著性计算公式为

式中:(x,y)为像素位置坐标;Iμ为输入图像的像素均值;Iwhc(x,y)为高斯差分滤波后的像素值;‖·‖为L2范数。

FT算法计算特征图时使用的非线性高斯函数会使算法的效率降低,本文利用快速引导滤波对其进行改进。快速引导滤波在滤波前后分别增加了imresize操作,降低了运算量,提高了运算效率,且不会出现明显的失真现象。改进后的显著性计算公式为

式中:IFGF(x,y)为经快速引导滤波后(x,y)处的像素值。以红外图像为例,常见的显著性检测算法与本文改进算法的检测结果对比如

图 3. 显著性检测结果。(a)红外图像;(b) AC算法;(c) HC算法;(d)改进算法

Fig. 3. Saliency detection results. (a) Infrared image; (b) AC algorithm; (c) HC algorithm; (d) improved algorithm

根据(4)式可以分别得到红外与可见光图像对应的显著性系数SIR(x,y)和SVIS(x,y),然后通过显著性系数矩阵对低频子带DIR(x,y)和DVIS(x,y)进行加权融合:

式中:DF(x,y)为融合后的低频子带;w1与w2为权重系数,计算公式为

3.2 高频子带融合

3.2.1 脉冲耦合神经网络

脉冲耦合神经网络[17]作为一种反馈型网络,具有全局耦合、空间邻近以及同步激发等多种特性,可提取图像的细节特征。脉冲耦合神经网络的基本组成单位为神经元。当神经元受到外部激励时,接收域接收外部激励

式中:

式中:

3.2.2 融合规则

PCNN进行子带融合时,通常借助点火次数设定融合规则。为了尽可能多地保留图像特征,本文在点火矩阵的基础上,通过结合多方向拉普拉斯能量和(Sum Modified Laplacian,SML)[18],设定了融合规则。SML通过计算水平和垂直方向的能量和来获取图像的清晰度和边缘特征,并通过计算对角线方向的能量和来减少信息丢失。改进的多方向SML计算公式为

式中:(

式中:Hl(i,j)为第l级图像的高频子带在(i,j)处的取值。

利用点火次数与多方向拉普拉斯能量和,对红外与可见光图像的高频子带

若

若

式中:

式中:SSML,VIS(i,j)和SSML,IR(i,j)分别为可见光和红外图像高频子带在(i,j)处的拉普拉斯能量和。

根据融合规则可知,当同一神经元的点火次数相差较大时,说明单一图像的特征较为明显,直接选择点火次数较大者作为融合后的子带系数;当点火次数较为接近时,说明两者均具有明显特征,此时采用SML自适应加权融合得到高频子带系数。

4 实验评估

4.1 实验设置

为验证本文算法的可行性与有效性,从TNO Image Fusion Dataset中选取四组经过配准的红外与可见光图像进行融合实验。实验的仿真平台配置为Intel酷睿i7-5500U CPU,运行内存为8GB,并搭载64位Win 7系统的PC机,编程环境为Matlab 2016a。由于本文算法是基于变换域,特选用拉普拉斯金字塔变换(LP)、轮廓波变换(Contourlet)、非下采样轮廓波变换(NSCT)、曲波变换(Curvelet)和双树复小波变换(DTCWT)等变换域算法以及交叉双边滤波 (CBF) 算法[19]、卷积稀疏表示 (CSR) 算法[20]、联合稀疏表示 (JSR) 算法[21]、联合稀疏表示与显著性检测 (JSRSD) 混合算法[22]等进行对比。对于五种变换域算法,Curvelet采用5层分解,LP、Contourlet、NSCT与DTCWT均采用4层分解;Contourlet的滤波器参数为“pkva”,NSCT的滤波器参数为“pyrexc”、“vk”, DTCWT滤波器参数为“legall”、“qshift_06”。经LP方法分解后的系数采用加权平均法并结合一致性检验的取大法进行融合;经Contourlet方法分解后的低频系数采用阈值选择法进行融合,高频系数则采用方差叠加法进行融合;经NSCT、Curvelet 及DTCWT方法分解后的低频系数均采用均值加权法进行融合,高频系数均采用绝对值取大法进行融合;CBF、CSR、JSR、JSRSD等四种算法的参数设置与原文献相同。本文算法的NSST采用4层分解,滤波器参数为“maxflat”,引导滤波的局部窗口大小为3 pixel×3 pixel。简化PCNN的参数设置具体如下:内部活动项、动态阈值、输出脉冲及点火映射矩阵均依据PCNN原始模型的设定,其初始值均为0,即

图 4. 点火次数。(a)红外图像;(b)可见光图像;(c)差值统计

Fig. 4. Number of ignition. (a) Infrared image; (b) visible image; (c) difference statistics

4.2 实验结果分析

对实验结果的评价分为主观评价和客观评价两部分。主观评价是通过人眼视觉对图像的融合效果进行评判,能够较为直观地判断融合结果的优劣。

第一组图像“Street”的融合结果如

图 5. 第一组图像。(a)红外图像;(b)可见光图像;(c) LP;(d) Contourlet;(e) NSCT;(f) Curvelet;(g) DTCWT;(h) CBF;(i) CSR;(j) JSR;(k) JSRSD;(l)所提方法

Fig. 5. First group of images. (a) Infrared image; (b) visible image; (c) LP; (d) Contourlet; (e) NSCT; (f) Curvelet; (g) DTCWT; (h) CBF; (i) CSR; (j) JSR; (k) JSRSD; (l) proposed method

第二组图像“Lake”的融合结果如

图 6. 第二组图像。(a)红外图像;(b)可见光图像;(c) LP;(d) Contourlet;(e) NSCT;(f) Curvelet;(g) DTCWT;(h) CBF;(i) CSR;(j) JSR;(k) JSRSD;(l)所提方法

Fig. 6. Second group of images. (a) Infrared image; (b) visible image; (c) LP; (d) Contourlet; (e) NSCT; (f) Curvelet; (g) DTCWT; (h) CBF; (i) CSR; (j) JSR; (k) JSRSD; (l) proposed method

第三组图像“Camp”的融合结果如

图 7. 第三组图像。(a)红外图像;(b)可见光图像;(c) LP;(d) Contourlet;(e) NSCT;(f) Curvelet;(g) DTCWT;(h) CBF;(i) CSR;(j) JSR;(k) JSRSD;(l)所提方法

Fig. 7. Third group of images. (a) Infrared image; (b) visible image; (c) LP; (d) Contourlet; (e) NSCT; (f) Curvelet; (g) DTCWT; (h) CBF; (i) CSR; (j) JSR; (k) JSRSD; (l) proposed method

第四组图像的融合结果如

图 8. 第四组图像。(a)红外图像;(b)可见光图像;(c) LP;(d) Contourlet;(e) NSCT;(f) Curvelet;(g) DTCWT;(h) CBF;(i) CSR;(j) JSR;(k) JSRSD;(l)所提方法

Fig. 8. Fourth group of images. (a) Infrared image; (b) visible Image; (c) LP; (d) Contourlet; (e)NSCT; (f) Curvelet; (g) DTCWT; (h) CBF; (i) CSR; (j) JSR; (k) JSRSD; (l) proposed method

主观评价虽然能够较为直接地判定融合结果的优劣,但是主观性较强,且个体的视觉敏感度存在差异,评判结果具有一定的片面性,因此需要借助客观评价指标对融合图像进行综合评判。本文采用信息熵(IE)、空间频率(SF)、像素标准差(SD)、峰值信噪比(PSNR)和相关系数(CC)对融合图像进行评价。IE用于衡量融合图像中所包含的信息量,SF用于衡量融合图像的灰度变化率,SD用于衡量融合图像像素灰度值的离散程度,PSNR用于衡量融合图像在融合过程中的失真程度,CC用于衡量融合图像与源图像的线性相关程度。以上5个评价指标均为正向指标,其值越大越好。四组融合图像的评价指标如

表 1. 第一组图像的评价指标

Table 1. Evaluation indicators for first group of images

|

表 2. 第二组图像的评价指标

Table 2. Evaluation indicators for second group of images

|

表 3. 第三组图像的评价指标

Table 3. Evaluation indicators for third group of images

|

表 4. 第四组图像的评价指标

Table 4. Evaluation indicators for fourth group of images

|

由

5 结论

提出一种基于多尺度几何变换的红外与可见光图像融合算法,采用视觉显著性自适应的方法融合低频子带,能够有效突出图像的显著性特征并提升融合图像的整体视觉效果;采用PCNN与SML融合高频子带,能够有效提取并保留全局的细节信息。实验结果表明,所提方法在IE、SF及SD等多个客观指标上均有一定的优势,并且在视觉效果上符合人眼视觉系统对实际场景的观测,从整体上提升了场景辨识度和环境释义能力,进一步加深了观察者对场景的理解。

[1] Jin X, Jiang Q, Yao S W, et al. A survey of infrared and visual image fusion methods[J]. Infrared Physics & Technology, 2017, 85: 478-501.

[2] Ma J Y, Ma Y, Li C. Infrared and visible image fusion methods and applications: a survey[J]. Information Fusion, 2019, 45: 153-178.

[3] Li S T, Kang X D, Fang L Y, et al. Pixel-level image fusion: a survey of the state of the art[J]. Information Fusion, 2017, 33: 100-112.

[4] 郭全民, 王言, 李翰山. 改进IHS-Curvelet变换融合可见光与红外图像抗晕光方法[J]. 红外与激光工程, 2018, 47(11): 440-448.

Guo Q M, Wang Y, Li H S. Anti-halation method of visible and infrared image fusion based on improved IHS-Curvelet transform[J]. Infrared and Laser Engineering, 2018, 47(11): 440-448.

[5] Yang S Y, Wang M, Jiao L C, et al. Image fusion based on a new contourlet packet[J]. Information Fusion, 2010, 11(2): 78-84.

[6] 王峰, 程咏梅. 基于Shearlet变换域改进的IR与灰度VIS图像融合算法[J]. 控制与决策, 2017, 32(4): 703-708.

Wang F, Cheng Y M. Improved infrared and gray visible light image fusion algorithm based on Shearlet transform[J]. Control and Decision, 2017, 32(4): 703-708.

[7] Zhang Q, Maldague X. An adaptive fusion approach for infrared and visible images based on NSCT and compressed sensing[J]. Infrared Physics & Technology, 2016, 74: 11-20.

[8] Jin X, Jiang Q, Yao S W, et al. Infrared and visual image fusion method based on discrete cosine transform and local spatial frequency in discrete stationary wavelet transform domain[J]. Infrared Physics & Technology, 2018, 88: 1-12.

[9] 冯鑫. Tetrolet框架下红外与可见光图像融合[J]. 光子学报, 2019, 48(2): 0210001.

[11] Easley GR, LabateD, Lim WQ. Optimally sparse image representations using shearlets[C]∥2006 Fortieth Asilomar Conference on Signals, Systems and Computers, October 29-November 1, 2006, Pacific Grove, CA, USA. New York: IEEE, 2006: 974- 978.

[12] 江泽涛, 吴辉, 周哓玲. 基于改进引导滤波和双通道脉冲发放皮层模型的红外与可见光图像融合算法[J]. 光学学报, 2018, 38(2): 0210002.

[13] 吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001.

[14] 孔韦韦, 王炳和, 李斌兵. 图像融合技术[M]. 西安: 西安电子科技大学出版社, 2015: 238- 241.

Kong WW, Wang BH, Li BB. Image fusion multiresolution non-subsampled[M]. Xi'an: Xidian University Press, 2015: 238- 241.

[16] AchantaR, HemamiS, EstradaF, et al. Frequency-tuned salient region detection[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25,2009, Miami, FL, USA. New York: IEEE, 2009: 1597- 1604.

[17] 王彦龙. 基于NSST的医学图像融合算法研究[D]. 西安: 西安电子科技大学, 2018.

Wang YL. Research on the medical image fusion algorithm based on NSST[D]. Xi'an:Xidian University, 2018.

[19] Shreyamsha Kumar B K. Image fusion based on pixel significance using cross bilateral filter[J]. Signal, Image and Video Processing, 2015, 9(5): 1193-1204.

[20] Liu Y, Chen X, Ward R K, et al. Image fusion with convolutional sparse representation[J]. IEEE Signal Processing Letters, 2016, 23(12): 1882-1886.

[21] Zhang Q H, Fu Y L, Li H F, et al. Dictionary learning method for joint sparse representation-based image fusion[J]. Optical Engineering, 2013, 52(5): 057006.

[22] Liu C H, Qi Y, Ding W R. Infrared and visible image fusion method based on saliency detection in sparse domain[J]. Infrared Physics & Technology, 2017, 83: 94-102.

沈瑜, 陈小朋, 苑玉彬, 王霖, 张泓国. 基于显著矩阵与神经网络的红外与可见光图像融合[J]. 激光与光电子学进展, 2020, 57(20): 201007. Yu Shen, Xiaopeng Chen, Yubin Yuan, Lin Wang, Hongguo Zhang. Infrared and Visible Image Fusion Based on Significant Matrix and Neural Network[J]. Laser & Optoelectronics Progress, 2020, 57(20): 201007.

![NSST分解过程 [14]](/richHtml/lop/2020/57/20/201007/img_1.jpg)