融合FHOG和LBP特征的尺度自适应相关滤波跟踪算法  下载: 994次

下载: 994次

1 引言

目前,随着计算机视觉在人工智能领域的火热,更多的研究是使用计算机代替人的眼睛和大脑去处理相关视频[1]。视觉目标跟踪是计算机视觉中一个重要的研究课题,它是在某视频序列初始帧目标的大小和位置给定的前提下,估计该视频后续帧中目标的大小和位置[2]。

近年来,相关滤波算法速度快、准确度高,被广泛应用在目标识别、目标跟踪等领域,并取得了较好的效果。Bolme等[3]第一次将相关滤波算法应用到目标跟踪任务中,提出了最小均方误差(MOSSE)跟踪算法,但是该算法使用的是单通道的灰度特征,导致跟踪精度不高。Henriques等[4]在相关滤波算法的框架中加入了核函数,使用多通道的HOG(Histogram of Oriented Gridients)特征替换单通道的灰度特征,提出了核相关滤波器(KCF)跟踪算法,但是该算法并不能很好地解决目标跟踪过程中出现的遮挡等问题[2];后来,CN(Color Names)[5]、SAMF(Scale Adaptive Multiple Feature)[6]和DSST(Discriminative Scale Space Tracking)[7]算法相继被提出,均取得了较好的跟踪效果。

针对KCF跟踪算法存在以上问题,本文提出一种多特征融合的尺度估计相关滤波跟踪算法。将快速方向梯度直方图 (FHOG)特征和局部二值模式(LBP)特征进行自适应加权融合,实现对目标更精确的定位。再利用尺度金字塔来估计目标的尺度大小,使算法有较高的跟踪准确性。

2 改进跟踪算法

2.1 KCF跟踪算法

KCF跟踪算法是一种鉴别式追踪方法,其基本思想是通过训练一个分类器来区分目标和背景以实现目标的跟踪[8]。首先,在第1帧给定跟踪的目标框,并构建跟踪区域;其次,利用循环矩阵将该区域进行循环移位,利用核函数计算目标的相似程度和目标出现的位置区域;选取最大的输出响应值作为最新的目标,通过傅里叶变换训练目标检测分类器,完成目标检测,最终实现目标的持续跟踪[9]。

2.2 特征融合

KCF跟踪算法提取图像特征时采用多通道, 因此可以采用更强大的特征代替单一的特征来进行算法改进。原KCF跟踪算法采用的是单一的HOG特征,当遇到目标背景复杂的情况时,该特征会造成目标丢失[10]。由于FHOG特征对运动模糊、光照变化等描述效果较好,而LBP特征具有较好的局部纹理表达能力和单调灰度不变性等显著优点,所以本文提出将FHOG与LBP特征进行自适应加权融合,实现对目标的定位。

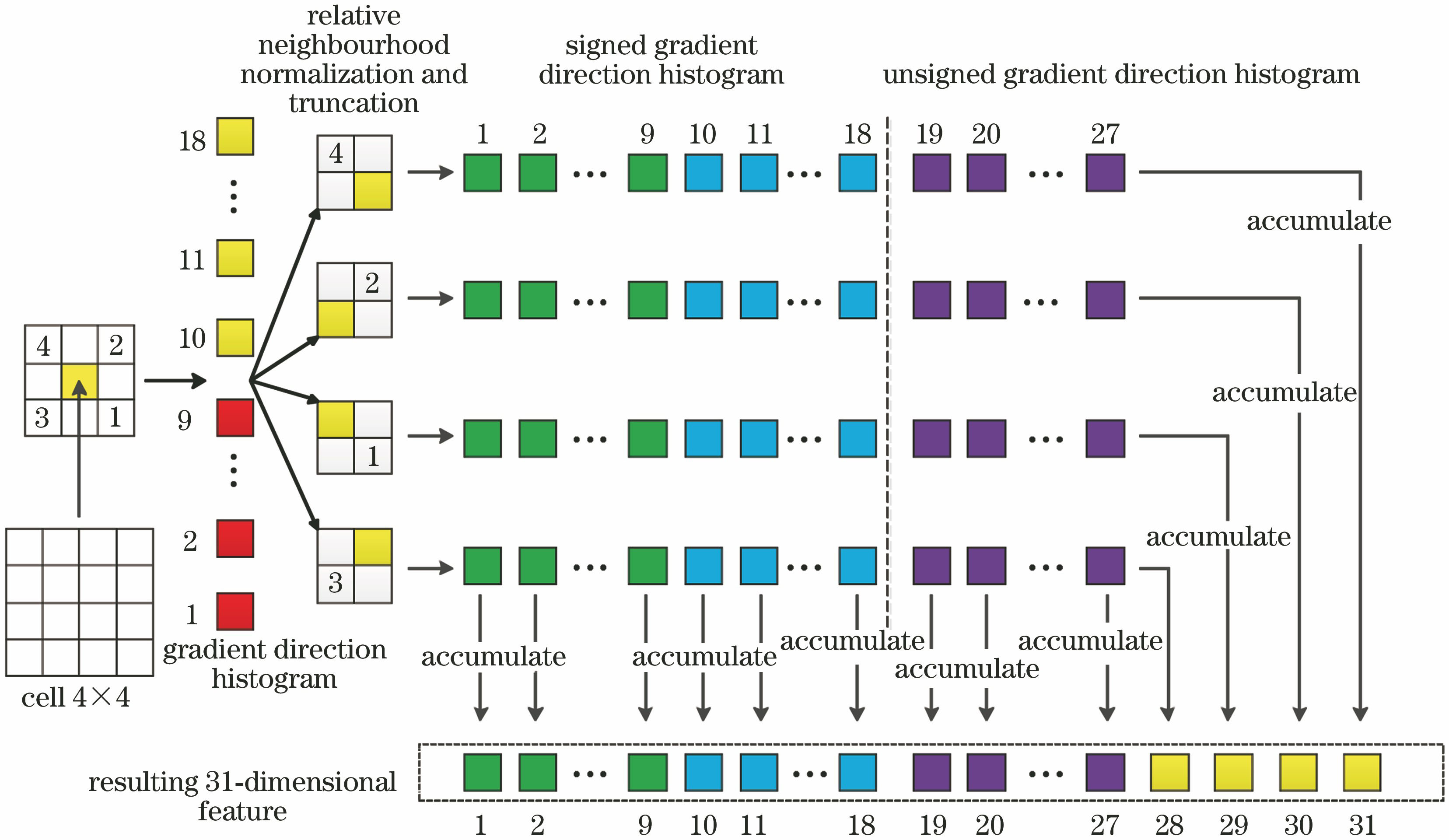

1) FHOG特征

FHOG是通过在HOG上进行了一些改进得到的,由Felzenszwalb等[11]提出,FHOG基于梯度信息能很好地反映图像目标的边缘信息并根据局部梯度的大小将图像的局部外观和形状特征化[12]。该特征能够很好地表征目标的局部形状信息,并且对光照和目标形状变化都具有很好的不变性[12]。

2) LBP纹理特征

LBP特征[13]是一种用来描述图像局部纹理特征的算子,具有灰度不变性和旋转不变性等显著的优点[14]。

本文基于决策级融合的思想对FHOG和LBP特征进行融合。在跟踪的过程中,通过对目标区域进行密集采样得到大量的循环移位样本,再在相关滤波框架下构建基于FHOG和LBP特征的目标表观模型。基于岭回归思想,采用最小化分类误差来训练表观模型,即

式中:ω为权重系数;[f(xi)-yi]2为损失函数;λ为控制过拟合的正则化参数;xm,n表示中心位置是(m,n)的图像块所对应的特征向量;ym,n为点(m,n)的期望响应。

式中:F、F-1分别为离散傅里叶变换和离散傅里叶逆变换;kxx表示基础样本对应特征向量的核自相关, kxx_i为其中元素;α为表观模型,对应元素为αi。

经训练分别得到基于FHOG和LBP特征的表观模型αFHOG,αLBP,为确定下一帧中目标可能出现的位置,对这两个特征的表观模型与下一帧图像中候选区域图像块对应特征向量的相关响应值进行计算。计算式分别为

式中:fFHOG(z)、fLBP(z)分别为这两个特征的表观模型与候选区域图像块产生的特征响应图;☉表示点积;kxz表示基础样本对应的特征向量x与候选区域图像块对应的特征向量z的核相关。

将两个特征响应图进行加权融合,可得到

式中:λFHOG、λLBP分别表示两个特征的融合系数,可通过各自输出响应图的置信度求出。本文采用平均峰值相关能量(APCE)[17]对输出响应图的置信度进行描述,即

式中:Qmax、Qmin、Qw,h分别表示相关响应最高值、最低值以及(w,h)位置处的相关响应。APCE反映响应图的波动程度和检测目标的置信水平。经过加权融合得到f(z),再利用其峰值对新一帧图像中的目标进行定位。根据FHOG和BLP特征对不同场景的处理能力,按照特征响应图的置信度对两种特征进行自适应加权融合,充分利用这两种特征在不同场景的适应能力,提高表观模型的鲁棒性和判别力。

2.3 目标尺度估计

为估计出目标的尺度大小,本文引入尺度金字塔模型来适应目标的尺度变化[18],如

式中:g'为尺度空间的输出响应值最大的位置。

第t帧的目标被估计出尺度后,以Pt为中心位置,选取图像块Zt,其尺度大小为bAt×bBt(b为扩展函数),其相应模型更新方案为[20]

图 3. 当前帧的目标跟踪与尺度估计示意图

Fig. 3. Schematic of target tracking and scale estimation for the current frame

式中:η为学习率;

3 实验与结果分析

为了检验本文改进算法的性能,实验以MATLAB 2014a为开发平台,在Windows 7系统/处理器为Intel(R) Core(TM) i7-6700 CPU@3.40 GHz的计算机上进行测试。选择OTB-50数据集中存在遮挡、尺度变化、快速运动等问题的6组图像序列,并将本文算法与5种目标跟踪算法进行实验对比,5种跟踪算法分别为LCT(Long-Term Correlation Tracking)[21]、Staple[22]、Struck[23]、CSK(circulant structure kernel)[24]、KCF[4]。序列信息如

3.1 参数设置

本文改进算法的参数设置如

表 2. 本文算法的主要参数设置

Table 2. Main parameters of the algorithm in this paper

|

表 1. 选用的图像序列的信息描述

Table 1. Information description of the selected image sequence

|

3.2 评价指标

为验证本文算法的有效性,采用OTB数据集中的三种评价指标来对跟踪结果进行评估:平均中心误差(CLE)、距离精度(DP)和重叠精度(OP)。

1) CLE为整个跟踪过程中所有图像序列中的目标中心位置

2) DP为 CLE小于某一阈值的帧数占总帧数的比值,可表示为

式中:n'表示CLE小于一定阈值的视频帧数;n为跟踪视频的总帧数,本文选取的阈值为20 pixel。

3) OP为计算目标预测位置及大小与实际位置及大小的重叠率大于一定阈值的视频帧数占总帧数的百分比,该阈值一般选取PASCAL的评价标准来进行计算。

本文算法和5种目标跟踪算法的CLE如

表 3. 6种算法在6组测试图像序列上的CLE

Table 3. CLE of six algorithms on six sets of test image sequences

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||

表 4. 不同算法的DP数据对比

Table 4. Comparison of DP data of different algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

3.3 综合性能评估

在6组具有复杂属性的视频序列上,采用一次性评估(OPE)方法,即6种跟踪算法在每段视频序列上均运行一次,得到这6种跟踪算法的精确率和成功率曲线,如

从

表 5. 不同算法的OP数据对比

Table 5. Comparison of OP data of different algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

算法跟踪序列的部分跟踪效果图如

1) Bird1序列中,目标出现快速运动、超出视野等问题。其他5种跟踪算法受到相似物体干扰或者在跟踪目标丢失时发生漂移,最终都导致跟踪失败。而本文算法能够持续跟踪,跟踪效果较好。

2) Box序列中,目标出现尺度变化、遮挡、运动模糊等问题。在跟踪过程中,目标周围出现相似物的遮挡并且逐渐发生跟踪漂移现象时,除LCT外的4种跟踪算法发生错误跟踪。目标出现尺度变化、相似物体干扰的问题时,本文改进算法仍能够有效地对目标进行跟踪,并且,相比于LCT算法,其CLE的数值更低。

3) Skating2序列中,目标出现局部遮挡、旋转等问题。目标首次旋转时,Staple算法在跟踪时就开始出现漂移现象,在目标第二次旋转时,跟踪失败。Struck和CSK算法相比于其他算法虽然跟踪精度较高,但目标尺度发生变化和受到背景干扰时,发生了目标丢失。由于测试序列中背景信息的干扰,KCF和LCT算法跟踪失败。本文改进算法能准确跟踪到目标。

4) Basketball序列中,目标出现遮挡、快速运动等问题。由于目标出现快速运动,KCF算法跟踪发生错误。Struck和CSK算法虽然能够正确跟踪到目标,跟踪精度较高,但是当目标周围有相似物体干扰时,会出现跟踪错误。出现相似物体的干扰时,LCT算法很容易出现跟踪错误。本文改进的算法具有较好的跟踪鲁棒性。

5) Soccer序列中,目标出现尺度变化、遮挡、运动模糊、背景杂波等问题。由于背景复杂,KCF、Struck和CSK算法出现漂移现象,跟踪失败。由于有相似背景和物体的干扰,Staple和LCT算法跟踪错误。本文改进算法在出现上述问题时,依然呈现出较好的跟踪效果。

6) CarScale序列中,目标出现尺度变化、局部遮挡、快速运动等问题。KCF、Struck和CSK算法在目标有遮挡时,出现错误跟踪。在目标突然快速运动时,Staple算法跟踪失败。LCT和本文改进算法在该序列中的跟踪效果较好。

从三个评价指标和部分跟踪效果图可看出,本文算法相比于其他5种跟踪算法,CLE较低,跟踪的准确率较高,DP和OP值较高。从精确率对比图和成功率对比图中也可看出,本文算法对于这些视频跟踪中常见的问题均具有较好的鲁棒性,且均达到了较好的跟踪效果,具有稳定的跟踪性能。

4 结论

在复杂场景下,针对单一图像特征、尺度估计导致跟踪精度低的问题,提出一种融合FHOG和LBP特征的尺度自适应相关滤波跟踪算法。对于不同特征,按照特征响应图的可信度来对FHOG特征和LBP特征进行自适应加权融合,以实现对目标的定位;并且这两种特征在不同场景下的适应能力,使得目标表观模型的鲁棒性和判别力得到了有效提升;再利用尺度金字塔来估计目标的尺度大小,使算法对发生尺度变化的目标有很好的适应能力。在OTB-50数据集上进行对比实验,结果表明本文算法较其他跟踪算法在精确率和成功率上均有所提升,具有较好的鲁棒性、跟踪效果以及稳定的跟踪性能。

[1] 徐海洋. 基于图片序列的三维重建技术研究[D]. 武汉: 华中科技大学, 2015.

Xu HY. Image sequences based 3D reconstruction[D]. Wuhan: Huazhong University of Sciense & Technology, 2015.

[2] 杨德东, 蔡玉柱, 毛宁, 等. 采用核相关滤波器的长期目标跟踪[J]. 光学精密工程, 2016, 24(8): 2037-2049.

[3] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[4] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[5] DanelljanM, Shahbaz KhanF, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, Ohio. New York: IEEE, 2014: 1090- 1097.

[6] LiY, ZhuJ. A scale adaptive kernel correlation filter tracker with feature integration[M] ∥Agapito L, Bronstein M, Rother C. Computer Vision-ECCV 2014 Workshops. Lecture Notes in Computer Science. Cham: Springer, 2014, 8926: 254- 265.

[7] DanelljanM, HägerG, KhanF, et al.Accurate scale estimation for robust visual tracking[C]∥British Machine Vision Conference, September 1-5, 2014, Nottingham.UK: BMVA Press, 2014.

[8] 赵倩. 基于视频分析的公交客流统计技术研究与实现[D]. 重庆: 重庆大学, 2016.

ZhaoQ. The technology research and implementation of bus passenger flow statistics based on video analysis[D]. Chongqing: Chongqing University, 2016.

[9] 田亚蕾, 马杰, 杨楠. 结合核相关滤波和Kalman预测的运动目标跟踪[J]. 小型微型计算机系统, 2018, 39(10): 2330-2334.

Tian Y L, Ma J, Yang N. Moving target tracking based on kernelized correlation filter and Kalman predicting[J]. Journal of Chinese Computer Systems, 2018, 39(10): 2330-2334.

[10] 杨剑锋, 张建鹏. 基于核相关滤波的长时间目标跟踪[J]. 激光与光电子学进展, 2019, 56(2): 021502.

[11] Felzenszwalb F, Girshick B. McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[12] 周涛, 狄晓妮, 李岩琪. 多特征融合与尺度估计相结合的目标跟踪算法[J]. 红外技术, 2019, 41(5): 469-476.

[13] Ojala T, Pietikäinen M, Mäenpää T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(7): 971-987.

[14] 徐绕山, 王爽, 孙正兴. 视觉相似性计算的艺术图像自组织方法[J]. 计算机工程与应用, 2017, 53(18): 163-169, 242.

Xu R S, Wang S, Sun Z X. Self-organization method for artistic images based on visual similarity computation[J]. Computer Engineering and Applications, 2017, 53(18): 163-169, 242.

[15] 望少建. 基于相关滤波的视觉目标跟踪[D]. 西安: 西安电子科技大学, 2018.

Wang SJ. Visual object tracking based on correlation filters[D]. Xi’an: Xidian University, 2018.

[16] 刘洪普, 郑梦敬, 侯向丹, 等. 基于局部二进制模式方差的分数阶微分医学图像增强算法[J]. 激光与光电子学进展, 2019, 56(9): 091006.

[17] Wang MM, LiuY, Huang ZY. Large margin object tracking with circulant feature maps[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 4800- 4808.

[18] 徐玉龙, 王家宝, 李阳, 等. 融合颜色特征的尺度自适应相关跟踪[J]. 计算机应用研究, 2017, 34(3): 945-948.

Xu Y L, Wang J B, Li Y, et al. Scale adaptive correlation tracking combined with color features[J]. Application Research of Computers, 2017, 34(3): 945-948.

[19] 谢柳, 尚振宏, 刘辉. 基于相关滤波融合多特征的运动目标跟踪方法[J]. 数据采集与处理, 2019, 34(1): 122-134.

Xie L, Shang Z H, Liu H. Object tracking combining multiple features based on correlation filter[J]. Journal of Data Acquisition and Processing, 2019, 34(1): 122-134.

[20] 何雪东, 周盛宗. 快速尺度自适应核相关滤波目标跟踪算法[J]. 激光与光电子学进展, 2018, 55(12): 121501.

[21] MaC, Yang XK, Zhang CY, et al. Long-term correlation tracking[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 5388- 5396.

[22] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[23] Hare S, Golodetz S, Saffari A, et al. Struck: structured output tracking with kernels[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10): 2096-2109.

[24] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer Vision-ECCV 2012. Lecture Notes in Computer Science. Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

[25] 刘万军, 张壮, 姜文涛, 等. 遮挡判别下的多尺度相关滤波跟踪算法[J]. 中国图象图形学报, 2018, 23(12): 1789-1800.

Liu W J, Zhang Z, Jiang W T, et al. Multi-scale correlation filter tracking algorithm based on occlusion discrimination[J]. Journal of Image and Graphics, 2018, 23(12): 1789-1800.

刘晓悦, 王云明, 马伟宁. 融合FHOG和LBP特征的尺度自适应相关滤波跟踪算法[J]. 激光与光电子学进展, 2020, 57(4): 041512. Xiaoyue Liu, Yunming Wang, Weining Ma. Scale-Adaptive Correlation Filter Tracking Algorithm Based on FHOG and LBP Features[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041512.