基于非对称卷积神经网络的图像去噪  下载: 670次

下载: 670次

1 引言

图像去噪是计算机视觉领域中非常经典的问题之一,其是从包含噪声的图像中还原潜在的且相对干净的图像。虽然传感器的电和热特性已有显著改善[1],但目前每个像素的尺寸越来越小。数字图像传感器输出的信号对光子噪声的敏感性越来越强,因此光子噪声是数字图像传感器中噪声的主要来源[2]。图像中多余噪声的去除可以带来更佳的视觉效果,提高图像质量,处理后的图像会影响后续图像的分类、分割和识别等[3]。

图像去噪的方法分为基于传统算法的图像去噪和基于深度学习的图像去噪两类。基于传统算法的图像去噪的处理方法:一类是专注于噪声图像的局部平滑,在去噪的基础上尽可能地保留图像边缘细节,使用的滤波方法有双边滤波[4]和高斯滤波[5]等;另一类是利用图像先验模型对图像进行去噪,使用的算法有非局部算法[6]和BM3D(Block-Matching and 3D filtering)算法[7]等。其中BM3D算法是传统算法中经典的去噪算法之一,采用该算法将图像分为一定大小的块,将具有相似特征的块合并成三维数组,采用联合滤波的方法对其进行处理,之后通过逆变换获得去噪后的图像。基于深度学习的图像去噪方法主要分为基于多层感知器(MLP)[8]和全卷积网络(FCN)[9]。基于MLP的图像去噪方法的处理过程:首先将原始图像拆分为大小相同的图像块,然后对每个图像块进行去噪,最后对去噪后的图像块进行拼接,对重叠部分的图像块进行聚合,从而得到去噪后的图像[8]。采用该方法处理图像耗时较长且容易造成网络模型的过拟合。基于FCN的去噪方法有去噪卷积神经网络(DnCNN)[10]和卷积盲去噪网络(CBDNet)[11]。DnCNN为FCN[10],其噪声类型为加性高斯白噪声,而数据集中的噪声具有单一性,则训练的模型对于数字成像传感器产生的噪声,去噪效果较差。CBDNet模型[11]分为噪声评估模型和去噪模型两部分,其训练数据集使用泊松高斯(Poissonian-Gaussian)模型[2]的模拟数据集和真实噪声数据集,该模型对相机内部噪声的去噪效果较好。

FCN去噪的成功依赖于训练数据集与真实噪声之间是否匹配,因此本文采用Poissonian-Gaussian模型模拟真实噪声的形成过程,同时使用公共数据集RENOIR[12]作为模型的训练数据集,此外为了提高模型的泛化能力,将模型分为噪声评估网络模型和U型去噪网络模型两部分。

2 所提方法

2.1 图像噪声模型

实验使用的训练数据集可分为模拟数据集和公共数据集RENOIR[12]两部分。其中模拟数据集是使用Poissonian-Gaussian模型[2]来模拟图像噪声以及光子传感器产生的噪声,剩余的稳态扰动使用高斯模型来模拟,噪声模拟的具体方法如下。

与信号相关的噪声模型可以表示为

式中:

假设

由分布函数可以得到

式中:

泊松高斯模型服从异方差高斯分布,可以表示为

图像信号传感器输出的信号经过图像处理器(ISP)处理后,使得噪声在空间与色彩上相关,因此对噪声模型进行改进,可以表示为

式中:

2.2 网络模型

实验将UNet++[15]中的跳跃连接应用到CBDNet[11]的U型去噪子网中,加入的跳跃连接旨在减少编码器和解码器中子网特征映射之间的语义差距。当特征映射在语义上相似时,优化任务将更容易被处理[15]。

CBDNet[11]模型如

对

UNet++[15]模型如

式中:

将UNet++模型中重新设计的跳跃连接应用到CBDNet的去噪子网中,即可得到实验使用的模型,如

2.3 损失函数

损失函数采用CBDNet[11]模型中的损失函数,其中损失函数分为噪声评估模型损失函数和去噪模型损失函数两部分。噪声评估模型损失函数可以表示为

L1=

式中:α表示参数,此时

式中:

去噪模型的损失函数可以表示为

式中:

总的损失函数可表示为

式中:

3 实验结果与分析

3.1 数据集和评价指标

3.1.1 数据集

在经典的RENOIR数据集[12]和VOC数据集中,使用Poissonian-Gaussian模型生成的数据作为训练数据集,将公共数据集PloyU[16]作为测试数据集,实验从测试集中任选10张图像进行测试。

3.1.2 评价标准

评价标准有客观评价和主观评价。客观评价标准是采用峰值信噪比(PSNR)[17]和结构相似性(SSIM)[17]作为定量的评价标准,表达式为

式中:

主观评价标准是在人的主观视觉中,根据自然图像的先验知识,将图像与已有先验知识的场景进行对比。

3.2 实验环境与参数选择

网络的训练和测试都是在Pytorch工具上进行的。实验硬件设备为Intel 2.20GHz CPU,NVIDIA GeForce GTX 1080 Ti。采用Adam梯度下降算法对回归目标进行优化训练,初始化学习率为0.0001,训练201次迭代后终止训练。

3.3 结果分析

为了验证网络模型的有效性,对网络模型进行实验对比。首先从公共数据集PloyU中选取10张图像,将改进的CBDNet与标准CBDNet得到的结果进行对比,PSNR和SSIM的结果如

表 1. 10张图像的PSNR

Table 1. PSNR of 10 images

|

表 2. 10张图像的结构相似度

Table 2. SSIM of 10 images

|

表 3. PSNR与SSIM的均值

Table 3. Mean of PSNR and SSIM

|

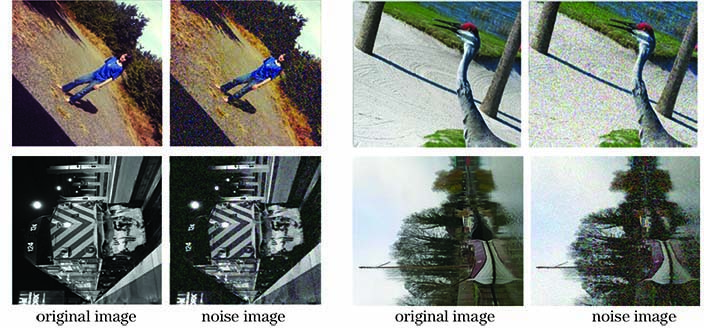

从PolyU数据集[16]中随机选取三张样本图像,去噪结果如

图 6. 图像 1的去噪结果。(a)原始图像;(b)噪声图像;(c) CBDNet;(d)改进的CBDNet

Fig. 6. Denoising results of image 1. (a) Original image; (b) noise image; (c) CBDNet; (d) improved CBDNet

图 7. 图像 2的去噪结果。(a)原始图像;(b)噪声图像; (c) CBDNet;(d)改进的CBDNet

Fig. 7. Denoising results of image 2. (a) Original image; (b) noise image; (c) CBDNet; (d) improved CBDNet

图 8. 图像 3的去噪结果。(a)原始图像;(b)噪声图像;(c) CBDNet;(d)改进的CBDNet

Fig. 8. Denoising results of image 3. (a) Original image; (b) noise image; (c) CBDNet; (d) improved CBDNet

4 结论

基于CBDNet架构[11]对其去噪部分的U型网络架构进行改进,将UNet++[15]中的跳跃连接应用到CBDNet中,旨在减少编码器和解码器中子网特征映射之间的语义差距;去噪后的图像可以解决边缘细节的损失、边界伪影和清晰度变差的问题。实验结果表明,对CBDNet模型的改进能够提高PNSR和SSIM,这为后续的目标检测、识别和跟踪等应用提供很好的图像样本数据集,并具有很好的实用性。

[1] RhodesH, AgranovG, HongC, et al. CMOS imager technology shrinks and image performance[C]//2004 IEEE Workshop on Microelectronics and Electron Devices, April 16-16, 2004, Boise, ID, USA. New York: IEEE, 2004: 7- 18.

[3] 陈曦. 基于深度卷积神经网络的图像去噪[D]. 合肥: 合肥工业大学, 2019.

ChenX. Image denoising based on deep convolutional neural networks[D]. Hefei: Hefei University of Technology, 2019.

[4] Zhang B Y, Allebach J P. Adaptive bilateral filter for sharpness enhancement and noise removal[J]. IEEE Transactions on Image Processing, 2008, 17(5): 664-678.

[5] Weiss B. Fast median and bilateral filtering[J]. ACM Transactions on Graphics, 2006, 25(3): 519-526.

[6] Buades A, Coll B, Morel J M. A review of image denoising algorithms, with a new one[J]. Multiscale Modeling & Simulation, 2005, 4(2): 490-530.

[7] Dabov K, Foi A, Katkovnik V, et al. Image denoising by sparse 3-D transform-domain collaborative filtering[J]. IEEE Transactions on Image Processing, 2007, 16(8): 2080-2095.

[9] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[11] GuoS, Yan ZF, ZhangK, et al. Toward convolutional blind denoising of real photographs[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 1712- 1722.

[12] Anaya J, Barbu A. RENOIR - A dataset for real low-light image noise reduction[J]. Journal of Visual Communication and Image Representation, 2018, 51: 144-154.

[13] Grossberg M D, Nayar S K. Modeling the space of camera response functions[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(10): 1272-1282.

[14] Malvar HS, He LW, CutlerR. High-quality linear interpolation for demosaicing of Bayer-patterned color images[C]//2004 IEEE International Conference on Acoustics, Speech, and Signal Processing, May 17-21, 2004, Montreal, Que., Canada. New York: IEEE, 2004: 8038960.

[15] Zhou ZW, Rahman Siddiquee M M, Tajbakhsh N, et al. UNet++: a nested U-Net architecture for medical image segmentation[M] //Stoyanov D, Taylor Z, Carneiro G, et al. Deep learning in medical image analysis and multimodal learning for clinical decision support. Lecture notes in computer science. Cham: Springer, 2018, 11045: 3- 11.

[16] XuJ, LiH, Liang ZT, et al. ( 2018-04-07)[2020-04-01]. org/abs/1804. 02603. https://arxiv.

[17] 佟雨兵, 张其善, 祁云平. 基于PSNR与SSIM联合的图像质量评价模型[J]. 中国图象图形学报, 2006, 11(12): 1758-1763.

Tong Y B, Zhang Q S, Qi Y P. Image quality assessing by combining PSNR with SSIM[J]. Journal of Image and Graphics, 2006, 11(12): 1758-1763.

甘建旺, 沙芸, 张国英. 基于非对称卷积神经网络的图像去噪[J]. 激光与光电子学进展, 2020, 57(22): 221018. Jianwang Gan, Yun Sha, Guoying Zhang. Image Denoising Based on Asymmetric Convolutional Neural Networks[J]. Laser & Optoelectronics Progress, 2020, 57(22): 221018.