基于特征融合的长时目标跟踪算法  下载: 1151次

下载: 1151次

ing at the problems of object tracking failure caused by occlusion and out of view in long-term tracking, we propose a long-term object tracking algorithm based on feature fusion to improve the speed and robustness of object tracking. First, the features of histogram of oriented gradient, color space and local sensitive histogram are fused to enhance the robustness of the algorithm in complex cases, and the fusion feature dimension reduction is carried out to improve the object tracking speed. Then, an additional one-dimensional scale correlation filter is used to obtain the optimal scale estimation of the object, and the computational complexity is reduced by quadrature rectangle-factorization. Finally, the object detection threshold is adaptively determined. When the object occlusion or out-of-view causes the failure of object tracking, the object region proposals can be extracted by EdgeBoxes, and object position is re-directed by using structured support vector machine to complete the long-term tracking of object. Experiments are conducted on standard tracking datasets OTB2015 and UAV123. Experimental results show that the average accuracy of the proposed algorithm is 5.0% higher than that of other optimal algorithms, the average success rate is increased by 2.6%, and the average object tracking speed is 28.2 frame/s, which meets the real-time requirements for tracking. In the case of object occlusion and out of view, the proposed algorithm can track the object continuously and accurately.

1 引言

随着计算机视觉技术的发展,视觉目标跟踪技术在视频监控、目标检测、视觉导航等领域的应用越来越广泛。但由于目标跟踪中存在目标形变、目标尺度变化、环境背景干扰、目标被遮挡等跟踪难点因素,目标跟踪容易发生漂移,导致不能对目标进行长时间跟踪。

相关滤波目标跟踪算法由于具有超高的跟踪速度和较高的跟踪稳健性,近几年得到了广泛的研究和应用。Henriques等[1]提出核相关滤波目标跟踪算法,基于循环矩阵性质将相关滤波模板训练阶段的采样问题等价于特征矩阵循环移位操作,来完成训练样本密集采样,大大减少了训练过程的样本采样次数,提高了跟踪速度。Li等[2]提出多尺度核相关滤波跟踪方法,通过构造目标不同尺度特征池,估计目标特征变化,一定程度上解决了目标尺度变化估计问题,但受制于跟踪速度,对尺度的数目设置有限,因此对目标的尺度变化不敏感。Danelljan等[3]提出空间判别尺度估计目标跟踪算法,通过额外的一维尺度相关滤波器,在目标位置确定后估计尺度变化,该方法可设置大量特征尺度池,对目标尺度变化估计精准快速。在目标受到遮挡情况下,以上方法容易发生失跟现象。利用卷积神经网络低层的目标细节表征和高层目标语义信息表征对目标进行特征提取[4-7],可获得目标较为全面的表征,结合相关滤波目标跟踪方法可以较好地解决目标旋转与目标遮挡等问题,但卷积特征提取计算量较大,导致目标跟踪速度达不到实时性要求。基于检测的目标跟踪方法在目标长时跟踪问题上具有较好的跟踪效果。Zhu等[8]利用EdgeBoxes方法提取候选目标区域,然后确定目标位置。该方法可对目标进行全局搜索,对不规则运动目标和大位移情况跟踪效果较好,但目标跟踪精度不高。Ma等[9]在相关滤波目标跟踪基础上,对跟踪过程中的目标遮挡进行判断,当目标发生遮挡时,引入基于支持向量机(SVM)的目标检测算法来重新确定目标位置,但跟踪速度慢。

上述算法对相关滤波目标跟踪算法进行了改进,但还存在以下问题:1)目标跟踪的精度和稳健性有待提升;2)目标跟踪速度有待优化;3)在长时目标跟踪中对目标被遮挡、目标出视野等问题处理不好,容易导致目标跟踪失败。

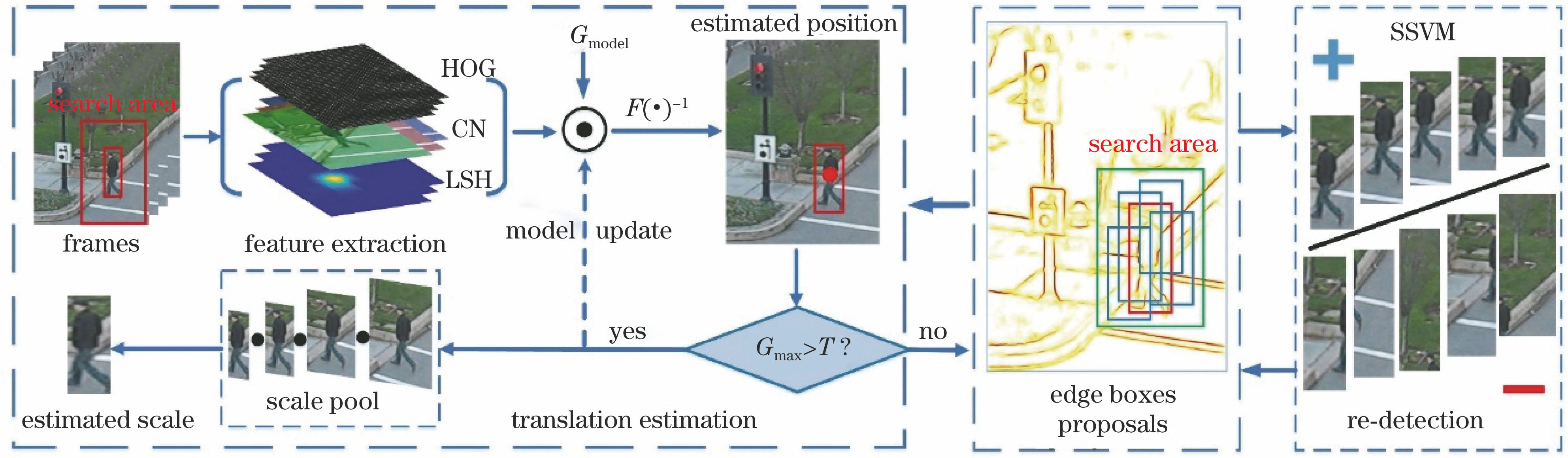

针对以上问题,本文提出基于特征融合的长时目标跟踪算法。首先,针对目标单一特征判别力不强的问题,融合目标方向梯度直方图特征、颜色空间特征和局部敏感直方图特征来提高复杂情况下的跟踪稳健性,并采用特征降维方法在最大化保留目标信息的同时加快跟踪速度;然后,在确定跟踪目标的位置后,通过额外的一维尺度相关滤波器来估计目标的最优尺度,同时采用正交三角(QR)分解无损降低特征维数,进一步加速目标尺度估计过程;最后,通过自适应策略确定目标检测的阈值,在目标出现遮挡或出视野等情况时,通过EdgeBoxes方法提取目标候选区域来避免暴力搜索目标,加快搜索速度,并利用结构化支持向量机(SSVM)来重新检测目标位置以达到目标长时跟踪的目的。在OTB100和UAV123标准跟踪数据集上进行实验,验证本文算法的有效性。

2 背景感知相关滤波

相关滤波目标跟踪算法通过目标特征与模板矩阵相关来构造目标函数,使得目标响应与目标函数风险最小化来训练目标跟踪滤波器模板[10],达到目标跟踪的目的。

式中:

滤波器模板训练时将(1)式时域的卷积运算转换到频域中的点积来降低算法复杂度,但时域的循环卷积导致相关滤波目标跟踪存在边界效应问题。通常,通过对目标特征加窗可减小边界效应,但会导致计算量增加,同时搜索区域受到限制。过大的搜索区域由于引入过多背景因素,导致训练的滤波器分辨力不够;但不足的搜索区域会导致训练的滤波器对目标的运动适应性不强,同时滤波器模板训练不足。背景感知相关滤波器(BACF)算法[11]在相关滤波算法的基础上对目标特征

式中:

将(2)式变换到频域,得:

式中:

要求解(3)~(4)式,通过构造增广拉格朗日函数可得:

式中

由于(5)式无封闭解,通过交替方向乘子法(ADMM)[12]优化求解可得两个优化子问题:

通过求解(6)~(7)式优化问题可得:

式中

式中

更新拉格朗日系数:

通过训练滤波器模板,在目标跟踪阶段求取搜索区域特征与模板的目标响应,响应最大值处即为目标预测位置。通过下式更新模型:

式中

BACF利用裁切矩阵实现高稳健性的模板训练,避免了相关滤波的边界效应问题,但仍存在以下问题:1)算法仅采用方向梯度直方图(HOG)作为目标提取特征,在目标模糊等纹理信息判别力不强时易导致跟踪失败;2)目标模板采用固定更新率更新,在目标受到遮挡或出视野等情况下模板易受到背景污染,无法满足目标长时跟踪要求;3)目标尺度估计采用构造金字塔方式,由于跟踪速度要求尺度池设置有限,对目标尺度估计不敏感。

3 本文算法

本文算法以BACF作为基准目标跟踪算法,基于特征融合方法来提高目标跟踪的稳健性;当发生由目标被遮挡等因素导致的失跟时,结合目标检测算法重新定位目标位置,同时通过额外的一维尺度滤波器获得目标更为精准的尺度估计。算法框架如

3.1 特征提取

BACF采用HOG特征作为目标判别特征。HOG特征通过计算和统计图像归一化的局部区域梯度方向直方图来构成特征

文献[

14]将局部敏感直方图特征(LSH)应用到目标跟踪中,LSH对图像中一个像素周围的区域进行统计,计算每个点的直方图,然后将每个像素点的直方图的所有区间值经过加权计算作为相应位置的像素值,如

式中:

式中

局部敏感度直方图特征考虑了周围像素对中心像素的影响,并且对光照变化和姿态变化等问题具有较好的适应性,在目标跟踪中具有较强的判别力与背景感知力。

颜色空间特征(CN)[15]将图像RGB颜色特征映射为11维颜色概率图,用概率分布来代替原始的像素值,对光照变化具有较好的适应性。

式中

CN颜色特征将RGB图像的3维颜色特征映射为黑、蓝、棕、灰、绿、橙、粉、紫、红、白和黄的11维颜色空间特征,如

图 2. 目标特征可视化。(a)原始图像;(b) HOG;(c) LSH;(d)~(f) CN

Fig. 2. Object feature visualization. (a) Image; (b) HOG; (c) LSH; (d)-(f) CN

本文通过融合目标HOG、LSH和CN特征来获得目标更全面的特征表征,以此增强目标复杂情况下的特征辨别力,但融合的高维特征将增加算法的计算复杂度,特别是快速傅里叶变换增加了操作时间耗费。因此,在融合三种目标特征的基础上,为加快目标跟踪的速度,通过对融合特征进行降维来实现快速稳健的目标跟踪。为保证最大化保留目标特征的有用信息,同时实现融合特征的降维,通过最小化特征重建损失来获取降维矩阵

式中

由(17)式可得降维压缩后的目标特征为

由于傅里叶变换的线性性质,可以得到压缩后的特征模型训练过程为

目标跟踪滤波器模板更新过程为

目标滤波器响应为

由(19)~(22)式可得到特征融合降维后的滤波模板训练与目标响应,完成目标跟踪过程。

3.2 尺度估计

背景感知相关滤波目标跟踪在确定目标位置时,通过提取不同尺度目标特征,根据目标响应值同时确定目标位置和尺度,但尺度设置受到跟踪速度限制,因此对目标尺度变化不敏感。

文献[ 3]提出在位置相关滤波器的基础上额外增加一个尺度相关滤波器来估计目标尺度变化。由于目标跟踪过程中位置变化通常大于目标尺度变化,因此在确定目标位置后,通过额外一维尺度相关滤波器构建目标尺度池可以对目标尺度进行较为准确的估计,并且计算量较小,跟踪速度快。尺度池设置如下:

式中:

通过上述方法构造一维尺度相关滤波器,通过提取目标HOG特征确定尺度变化,但通常目标特征维数

对于训练样本

为实现较为精准的尺度估计,进一步提高目标跟踪的速度,通过设置尺度池为

3.3 目标检测

3.3.1 目标检测

相关滤波目标跟踪算法是一种基于模板类的跟踪方法,在一定搜索范围内,通过训练滤波器模板与提取的目标特征的相关性来预测目标位置。为适应在跟踪过程中目标的变化特性,采用一定更新率实时更新模板策略,但当目标受到遮挡或出视野等因素影响时,滤波器模板由于学习到背景信息而导致模型漂移致使跟踪失败,在长时跟踪中不能满足对目标进行持续跟踪的任务。

通过对目标跟踪状态进行判断,在目标受到遮挡时结合目标检测方法重新确定目标位置是一种较好的解决目标跟踪过程中由于目标遮挡、出视野等因素造成目标失跟的方法。

支持向量机具有小样本、易训练且分类性能良好的特性。将目标跟踪作为分类任务,基于支持向量机进行跟踪已经取得了比较好的效果。传统支持向量机将目标跟踪作为二分类问题,在选择训练样本时仅利用二进制样本,而没有考虑空间结构信息,因此在跟踪过程中的样本不准确会降低分类器的准确度。文献[ 16]将结构化支持向量机运用到目标跟踪中,结构化输出向量机直接使用样本位置作为结构化标签,将目标位置信息引入训练过程,并通过预测函数来直接输出连续值确定目标,提高了SVM跟踪的准确性。

式中:

目标检测过程中,通常采用滑动窗方法暴力搜索目标,但基于滑动窗方式的计算量较大,降低了目标跟踪的实时性。文献[

17]提出通过EdgeBoxes提取候选区域方式实现目标跟踪的方法,通过图像边缘特性提取目标候选区域,然后确定真实目标。该方法可实现全局目标搜索,速度快,但对背景干扰判别力不强,跟踪精度不高。本文将背景感知相关滤波跟踪与EdgeBoxes提取候选框方法相结合,通过相关滤波跟踪方法精确预测目标位置,当目标被遮挡或因快速移动而丢失时进行判断,当目标丢失时,通过采用目标检测方法重新确定目标位置来完成长时目标跟踪任务。

3.3.2 自适应阈值

相关滤波目标跟踪算法通过目标响应来确定目标坐标位置,因此通过目标响应值可对目标跟踪中是否发生目标失跟等问题进行判断。文献[ 18]通过固定峰值旁瓣比阈值方法来判断是否发生目标遮挡、出视野等跟踪情况,但不同跟踪环境与跟踪目标对阈值设定的要求有差异,因此采用固定阈值方法判断目标跟踪效果的广适性受到限制。通过历史响应信息与当前帧响应信息来自适应判断目标遮挡、出视野等跟踪困难情况可提高阈值设定的广适性,目标阈值设置如下:

式中:

通过历史帧跟踪响应信息与当前帧目标响应信息即可判断是否发生目标遮挡、出视野等情况,采用目标检测机制来重新定位目标位置。

式中

当目标响应值小于一定的历史加权值则进行目标检测,由于目标跟踪在帧间目标位移变化具有连续性,因此通过最大化检测器输出与最小化空间位置变化来重新确定目标位置。

式中:

4 算法流程

本文提出基于特征融合的目标跟踪算法,其具体算法流程如

1) 输入目标跟踪图像序列。输入已知目标图像序列,获取目标在首帧的中心位置与尺度大小。

2) 训练滤波器模板。提取目标融合特征,将融合特征压缩为

3) 训练SSVM。根据目标图像位置、尺度大小训练结构化支持向量机。

4) 确定目标位置。根据步骤2)训练的目标滤波器模板,由(22)式计算目标响应,响应最大值处即为目标预测位置。

5) 目标位置重确定。判断步骤4)中目标响应最大值是否满足目标检测阈值条件

6) 目标尺度估计。在预测的目标位置处,提取目标尺度池HOG特征,利用一维尺度相关滤波器,按照(23)~(25)式获得目标17个尺度池特征,然后插值为33个尺度数进行尺度估计,精确确定目标尺度大小。

7) 更新检测。由于目标在图像序列中的变化在连续帧中较小,为提高目标跟踪的速度,降低滤波器模板训练的过拟合程度,本文采用隔3帧更新模板的方式,即当图像序列为3的整数倍时对滤波器模板进行更新,否则不更新。

8) 模型更新。在目标预测位置,以目标尺度估计大小提取目标融合特征,按照(21)式更新目标特征,按照(19)~(20)式方法训练目标滤波器模板。判断目标响应最大值是否大于分类器更新阈值

9) 阈值更新。按照(29)式更新置信度阈值。

10) 继续步骤4)~步骤9),直至目标跟踪结束。

5 实验

5.1 实验平台

实验算法均在戴尔工作站(Dell Precision 7810)计算机上进行,操作系统为64位Windows 7旗舰版,编程环境为Matlab 2017a和OpenCV3.1,处理器为 Intel Xeon E5-2620 v3,主频为2.40 GHz,内存为16 GB。

5.2 实验设置

实验参数设置:目标压缩维数

5.3 对比实验

除本文算法外,其他对比目标跟踪方法如下:核相关滤波跟踪(KCF)[1]、尺度空间判别跟踪(DSST)[3]、长时目标跟踪(LCT)[9]、BACF[10]、空间正则化相关滤波跟踪(SRDCF)[19]和多模版存储跟踪(MUSTER)[20]。对比算法均为近几年热门跟踪算法,且跟踪性能良好。

5.4 实验数据

为保证实验结果的客观性,对跟踪算法进行全面的评估,实验采用OTB100[21]和UAV123[22]标准跟踪数据集作为跟踪实验数据。OTB100包含100个跟踪目标图像序列,含有目标尺度变化、目标遮挡、目标出视野等11种跟踪难点因素,可对跟踪算法各种情况的跟踪效果作评价。UAV123包含123个无人机拍摄目标跟踪图像序列,目标形变更大,目标视野变化也更剧烈,同时包含目标跟踪的12种跟踪难点因素,利于评测算法针对各种情况下的性能。两个数据集均对目标背景框进行标注,便于实验算法跟踪结果的比较。实验在标准数据集上对所有跟踪图像序列进行目标跟踪,统计跟踪结果的平均值作为最终结果。

5.5 评估准则

为评估实验算法的跟踪性能,采用一次跟踪评估(OPE)中的跟踪成功率、跟踪精度和算法时间复杂度作为跟踪算法的评价指标。

1) 跟踪成功率。通过计算目标跟踪的结果、目标边界框与真实标注目标边界框的重叠率(IOU)来评估跟踪成功率。跟踪图像中大于一定阈值的重叠率的平均值作为每个视频的跟踪成功率,

式中:

2) 跟踪精度。通过计算算法跟踪结果目标的中心位置与真实标注目标的中心位置的欧氏距离来衡量目标跟踪的精度。跟踪精度的平均值作为算法跟踪的精度,

式中(

3) 算法时间复杂度。通过计算跟踪算法每秒处理的图像帧数(FPS)来评价。

式中

5.6 实验结果与分析

5.6.1 OTB100实验

本文算法及对比算法均在OTB100标准数据集上进行实验,通过对100个视频跟踪结果进行统计,得到总体跟踪结果曲线和分类因素结果曲线,说明算法针对各种因素的跟踪有效性。

设置为0.5~0.7区间时,目标跟踪的成功率相差最大为0.3%,且均保持较高的成功率,因此本文阈值自适应确定方法可以有效确定目标跟踪检测阈值,并且在一定范围内参数对目标跟踪效果的影响较小,该阈值确定方法广适性较强。

跟踪综合指标统计如

表 1. 目标跟踪成功率

Table 1. Success rate of object tracking

|

表 2. 实验图像序列特点

Table 2. Characteristics of image sequences in experiment

|

图 7. OTB100部分目标跟踪结果与重叠率。(a) Panda; (b) Lemming; (c) Blur Owl; (d) Human5; (e) Soccer; (f) Wake board1; (g) Jogging-2

Fig. 7. Partial object tracking results and overlap rates on OTB100. (a) Panda; (b) Lemming; (c) Blur Owl; (d) Human5; (e) Soccer; (f) Wake board1; (g) Jogging-2

如

如

如

如

如

如

如

5.6.2 UAV123实验

图 8. UAV123跟踪OPE评估曲线。(a)精度;(b)成功率

Fig. 8. OPE evaluation on UAV123. (a) Precision; (b) success rate

表 3. 目标跟踪成功率

Table 3. Success rate of object tracking

|

5.6.3 实际系统应用实验

图 9. 实际应用中的跟踪结果。(a)自行车;(b)行人小孩;(c)行人女孩

Fig. 9. Tracking results in practical applications. (a) Bicycle; (b) child; (c) girl

6 结论

对背景感知相关滤波目标跟踪算法进行研究,提出基于特征融合的长时目标跟踪算法,并通过实验验证本文方法提高了目标跟踪的精度和稳健性,可有效解决目标长时跟踪中的目标遮挡、出视野等跟踪失败问题。主要结论如下:1)本文提出特征融合方法,并推导给出基于特征融合与特征降维的目标滤波器模板训练更新方法,提高了目标跟踪的稳健性和精度,同时提高了目标跟踪的速度。2)通过额外的一维尺度相关滤波器对目标尺度变化进行估计,并通过QR分解与插值算法在对目标进行准确尺度估计的同时,提高目标跟踪的速度。3)通过自适应目标检测阈值策略,对目标遮挡、出视野问题进行有效判断,利用目标检测算法,结合候选区域提取策略,快速确定目标位置,有效解决目标遮挡和目标出视野等造成的目标失跟问题。4)利用特征降维策略、候选区域提取策略和模型更新策略有效提高了目标跟踪的速度,在OTB2015和UAV123数据集上的平均跟踪速度均满足实时性要求。

由于相关滤波是基于模板的目标跟踪算法,因此对于目标快速形变、旋转等因素的跟踪情况效果不好,将来可利用目标深度特征解决目标形变与旋转问题。

[2] LiY, ZhuJ. A scale adaptive kernel correlation filter tracker with feature integration[C]∥European Conference on Computer Vision, 2014: 254- 265.

[3] Danelljan M, Hager G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[5] DanelljanM, HagerG, Khan FS, et al. Convolutional features for correlation filter based visual tracking[C]∥Proceedings of the IEEE International Conference on Computer Vision Workshops, 2015: 621- 629.

[6] HeZ, FanY, ZhuangJ, et al. Correlation filters with weighted convolution responses[C]∥Proceedings of the IEEE Conference on Computer Vision Workshops, 2017: 1992- 2000.

[7] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[8] ZhuG, PorikliF, LiH. Beyond local search: Tracking objects everywhere with instance-specific proposals[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 943- 951.

[10] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[11] Galoogahi HK, FaggA, LuceyS. Learning background-aware correlation filters for visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision, 2017: 1144- 1152.

[13] Vondrick C, Khosla A, Pirsiavash H, et al. Visualizing object detection features[J]. International Journal of Computer Vision, 2016, 119(2): 145-158.

[14] He S F. Lau R W H, Yang Q X, et al. Robust object tracking via locality sensitive histograms[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(5): 1006-1017.

[15] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090- 1097.

[16] NingJ, YangJ, JiangS, et al. Object tracking via dual linear structured SVM and explicit feature map[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4266- 4274.

[17] HuaY, AlahariK, SchmidC. Online object tracking with proposal selection[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 3092- 3100.

[18] 刘威, 赵文杰, 李成. 时空上下文学习长时目标跟踪[J]. 光学学报, 2016, 36(1): 0115001.

[19] DanelljanM, HagerG, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 4310- 4318.

[20] Hong ZB, ChenZ, Wang CH, et al. Multi-store tracker (muster): a cognitive psychology inspired approach to object tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 749- 758.

[21] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[22] MuellerM, SmithN, GhanemB. A benchmark and simulator for UAV tracking[C]∥European Conference on Computer Vision, 2016: 445- 461.

Article Outline

葛宝义, 左宪章, 胡永江. 基于特征融合的长时目标跟踪算法[J]. 光学学报, 2018, 38(11): 1115002. Baoyi Ge, Xianzhang Zuo, Yongjiang Hu. Long-Term Object Tracking Based On Feature Fusion[J]. Acta Optica Sinica, 2018, 38(11): 1115002.