Calibration Method of Three-Dimensional Shape Measurement System Based on iGPS Positioning and Tracking

1 引言 在由工业机器人和形貌传感器组成的三维形貌机器人测量系统中,机器人既是运动载体,也是精度链中的重要环节。针对工业机器人绝对定位精度较低的问题,目前大多数研究以关节误差补偿为主[1 ] ,但在大尺寸复杂曲面的测量过程中,测量系统往往需要进行较大范围的运动,机器人各关节运动角度非常大,在测量域内的关节误差补偿往往无法达到测量系统所需的精度要求。

本文以“室内全局定位系统(iGPS)-工业机器人-形貌传感器”为核心,利用iGPS来实现全局定位跟踪,基于iGPS全局坐标系实现了形貌测量,提高了三维形貌机器人柔性测量系统的测量精度。系统不再以机器人基坐标系作为拼接坐标系,而是以iGPS世界坐标系作为拼接坐标系,因此传统“眼在手上”(Eye-in-hand)的手眼标定方式已不再适用。提出了一种融合特征点拟合的转换关系标定方法,通过对比实验,验证引入iGPS定位跟踪系统的测量系统标定算法的可靠性以及提高点云拼接精度的可行性。

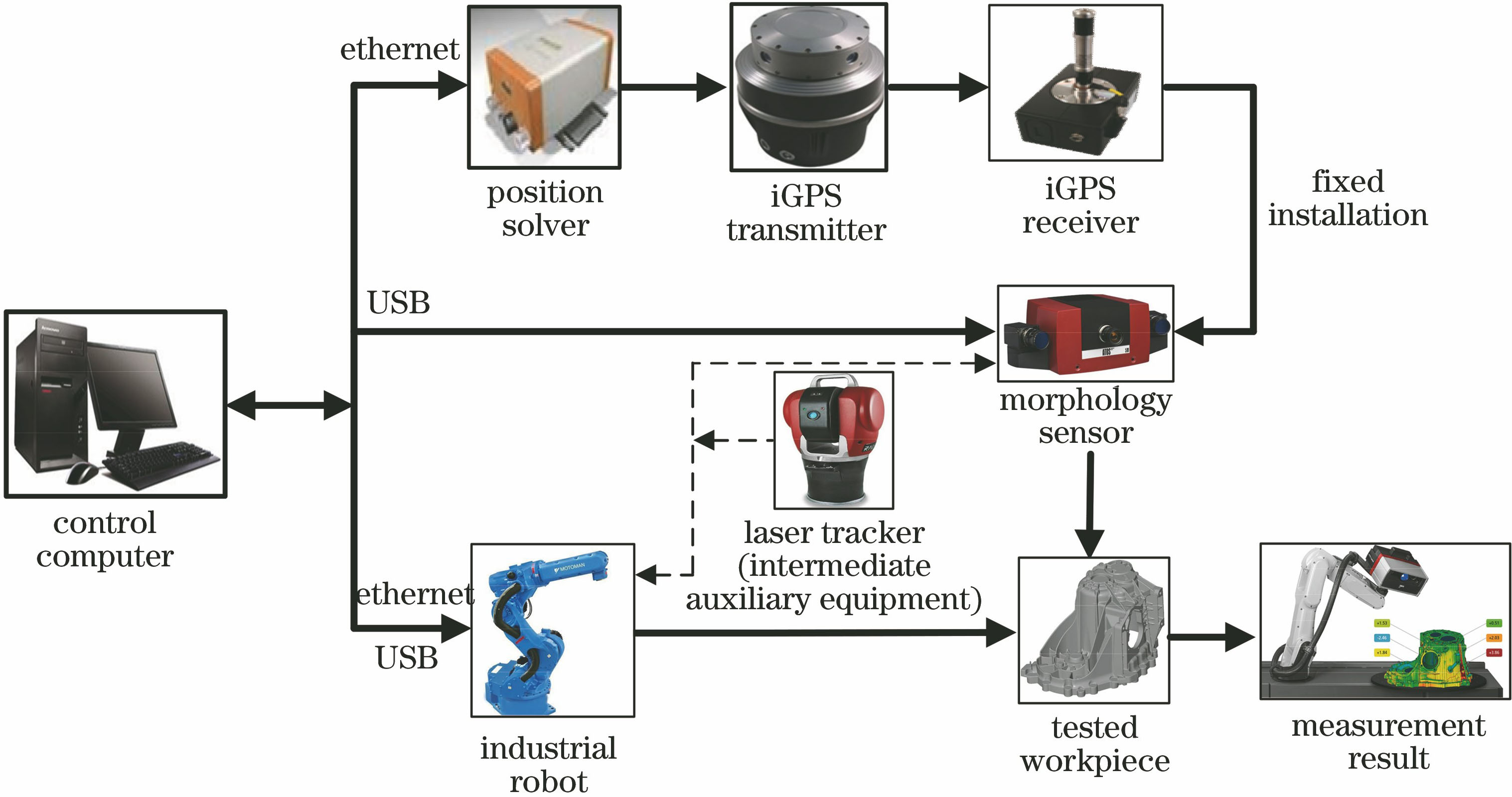

2 测量系统总体设计 测量系统以控制计算机为中心,由工业机器人、形貌测量传感器、iGPS定位跟踪测量系统、机器人控制系统等组成,如图1 所示,其中USB为通用串行总线。根据固定安装在三维形貌传感器上的iGPS接收器实时获取的点云数据进行基于iGPS测量坐标系的多视点云拼接,消除工业机器人定位精度对点云拼接的影响。

图 1. 系统方案组成框图Fig. 1. Block diagram of system plan compositions

3 测量系统数学模型 形貌测量系统坐标系由形貌传感器测量坐标系、iGPS接收传感器构成的Frame坐标系和作为世界坐标系的iGPS测量坐标系构成。系统各坐标系及关系示意图如图2 所示,各坐标系定义如下。

形貌传感器测量坐标系O s -X s Y s Z s :形貌传感器系统的Z s 轴与投影头轴线重合,且正向指向传感器,X s 轴与Y s 轴都在投影光平面上。

Frame坐标系O f -X f Y f Z f 由安装在形貌传感器顶端的4个iGPS接收传感器构成,是测量数据传递的中转站。Frame坐标系由iGPS测量系统创建,其创建规则如下。选择其中一个接收传感器作为原点,以4个传感器构成的平面作为X f Y f 平面,该平面的法线即为Z f 轴方向,以作为原点的接收传感器指向另一个接收传感器的方向为X f 轴,Y f 轴由右手定则确定。iGPS接收传感器固定安装在形貌传感器上,故坐标系O s -X s Y s Z s 与坐标系O f -X f Y f Z f 之间的转换关系

s f T 不随测量系统的运动而改变,其中上标f代表坐标系O f -X f Y f Z f ,下标s代表坐标系O s -X s Y s Z s 。

世界坐标系O w -X w Y w Z w 由iGPS定位跟踪系统确定,可使用任何一个激光发射器的坐标系作为世界坐标系。iGPS激光发射器在系统标定后不可以移动,而形貌传感器上的iGPS接收传感器会随着测量站位的改变而发生变化,故坐标系O f -X f Y f Z f 与坐标系O w -X w Y w Z w 之间的转换关系

f w T 是不断变化的,其中上标w代表坐标系O w -X w Y w Z w ,下标f代表坐标系O f -X f Y f Z f 。

设点P 为测量范围内任意一点,在工件坐标系下点P 的坐标为P p ,在世界坐标系O w -X w Y w Z w 下坐标为P w 。则两坐标系下点P 的坐标满足

P w = f w T · s f T · p s T · P p , (1)

式中

p s T 为工件坐标系向形貌传感器坐标系转化的关系。

工件坐标系下的被测点P p 在每次测量时都会先转换到形貌传感器坐标系O s -X s Y s Z s 下,故转换关系

p s T 的转换结果可由标定后的形貌传感器测量得到,只需将转换关系

f w T 、 s f T 在测量前进行标定,测量系统即可正常工作。

图 2. 系统坐标系示意图。(a)机器人系统相关坐标系; (b) iGPS坐标系Fig. 2. Schematic of coordinate system. (a) Coordinate system related to robot system; (b) iGPS coordinate system

图 3. 手眼标定示意图Fig. 3. Schematic of hand-eye calibration

4 测量系统转换关系标定 传统的工业机器人和形貌传感器结合的测量系统只需完成手眼标定,即建立起机器人末端法兰盘坐标系与形貌传感器坐标系之间的转换关系,便可对测量数据进行基于机器人基坐标系的点云拼接[2 ] 。但所提测量系统存在三个坐标系,需要标定两组坐标系之间的转换关系:坐标系O s -X s Y s Z s

与坐标系O f -X f Y f Z f 之间的转换关系

s f T ,坐标系O f -X f Y f Z f 与坐标系O w -X w Y w Z w 之间的转换关系

f w T 。

4.1 传统转换关系标定方法及参数求解 4.1.1 转换关系模型

传统机器人测量系统的标定方法控制机器人进行多次姿态变换,使传感器对固定不动的棋盘格进行拍摄,求得棋盘格相对于传感器的多个外部姿态参数,再结合机器人控制器显示的运动参数构建齐次方程,求得手眼变换矩阵[3 ] 。经典的手眼标定模型为Ai X=Bi X ,其中X 为所要求得的手眼矩阵[4 ] ,Ai 、Bi 分别为机器人末端法兰盘的运动量和与其对应的摄像机的运动量,Ai 由摄像机校准中的外部参数确定,Bi 可由机器人正向运动学关系和机器人关节读数确定,i 为变量的维数。图3 所示为传统手眼标定的示意图,其中O q -X q Y q Z q 为棋盘格坐标系,O b -X b Y b Z b 为机器人基坐标系。

将手眼矩阵X 用旋转矩阵R 和平移向量T 描述,即

X = R T 0 1 , (2)

求出旋转矩阵R 与平移向量T ,便可完成手眼矩阵的求解。

4.1.2 常用转换关系求解方法

手眼矩阵的求解实质是实现从笛卡儿空间一个坐标系到另一个坐标系的转换,应用最广泛的两种求解方法为四元数法和奇异值分解(SVD)法[5 ] 。

1) 四元数法

四元数法是一种利用四元矢量q 表示旋转矩阵R 的方法,q=q 0 +q 1 i+q 2 j+q 3 k= (q 0 ,q 1 ,q 2 ,q 3 ),其中q 0 、q 1 、q 2 、q 3 为任意实数,i、j、k为虚数单位,i2 =j2 =k2 =i×j×k=-1。旋转矩阵R 用单位四元数表示为

R = q 0 2 + q 1 2 - q 2 2 - q 3 2 2 ( q 1 q 2 - q 0 q 3 ) 2 ( q 1 q 3 + q 0 q 2 ) 2 ( q 1 q 2 + q 0 q 3 ) q 0 2 - q 1 2 + q 2 2 - q 3 2 2 ( q 2 q 3 - q 0 q 1 ) 2 ( q 1 q 3 - q 0 q 2 ) 2 ( q 2 q 3 + q 0 q 1 ) q 0 2 - q 1 2 - q 2 2 + q 3 2 , (3)

式中单位四元数满足

q 0 2 + q 1 2 + q 2 2 + q 3 2 = 1。

设Pi = (xi ,yi ,zi )为公共点Pi 在形貌传感器中的坐标,P'i = (x'i ,y'i ,z'i )为此公共点在机器人法兰盘坐标系下的坐标,s 为比例因子。则Pi = (xi ,yi ,zi )可用四元数表示为

x i y i z i = T + s q 0 2 + q 1 2 - q 2 2 - q 3 2 2 ( q 1 q 2 - q 0 q 3 ) 2 ( q 1 q 3 + q 0 q 2 ) 2 ( q 1 q 2 + q 0 q 3 ) q 0 2 - q 1 2 + q 2 2 - q 3 2 2 ( q 2 q 3 - q 0 q 1 ) 2 ( q 1 q 3 - q 0 q 2 ) 2 ( q 2 q 3 + q 0 q 1 ) q 0 2 - q 1 2 - q 2 2 + q 3 2 x' i y' i z' i 。 (4)

可用si 的算术平均值作为比例因子s 的最佳估计值,si 的表达式为

s i = x ' 2 ij + y ' 2 ij + z ' 2 ij x ij 2 + y ij 2 + z ij 2 , (5)

式中xij =xi -xj ,yij =yi -yj ,zij =zi -zj ;x'ij =x'i -x'j ,y'ij =y'i -y'j ,z'ij =z'i -z'j ;(xj ,yj ,zj )为某公共点Pj 在机器人法兰盘坐标系中的坐标,且j ≠i 。

设测量系统中的所有公共点的质心在机器人法兰盘坐标系中的坐标为

P - i = (

x - y - z - P - 'i = (

x - ' ,

y - ' ,

z - ' ),公共点的个数为n ,则由所有公共点的质心所列的转站方程组为

x - ' y - ' z - ' = T + sR x - y - z - 。 (6)

从而得到交叉共生矩阵为

U = 1 n ∑ i = 1 n ( P i - P - i ) ( P' i - P - ' i ) T , (7)

式中上标T代表求转置。

设反对称矩阵S=U-U T ,列矢量η= S 23 S 31 S 12 T M =trace(U ),其中trace为求迹运算,则可得矩阵Q 为

Q = M η T η U + U T - ME , (8)

式中E 为3阶单位矩阵。

解出矩阵Q 的最大特征值,其对应的特征向量即为四元矢量q =(q 0 ,q 1 ,q 2 ,q 3 ),代入(3)式可得旋转矩阵R 。将s 与R 的值代入(6)式可求解平移向量T 。

2) SVD法

SVD法是在求解目标函数最小化时应用的一种方程组求解算法[6 ] 。记Qi (x'i ,y'i ,z'i )为某公共点在形貌传感器坐标系中的坐标,则转站模型可表示为

P i = sR · Q i + T 。 (9)

设所有公共点的质心在形貌传感器坐标系中的坐标为(

x - 'i ,

y - 'i ,

z - 'i ),记为

Q - i Pi 、Qi 的质心坐标分别为

P - i = ∑ i = 1 n P i n , Q - i = ∑ i = 1 n Q i n 。 (10)

两组点Pi 、Qi 质心化后的坐标分别可表示为P'i =Pi - P - Q'i =Qi - Q -

Δ = ∑ i = 1 n ‖ P' i - sR · Q' i ‖ 2 。 (11)

当Δ 达到最小时,得到所求的旋转矩阵R 。要使Δ 最小等价于使

∑ i = 1 n P' i T R ·Q'i 最大,即

∑ i = 1 n P' i T · R · Q' i = trace ( R · H ) , (12)

式中矩阵H= ∑ i = 1 n Q'i ·P' i T H 进行SVD,得到H 的SVD矩阵U 和V 。当R=V ·U T 时,

∑ i = 1 n P' i T R ·Q'i 达到最大值,求解得到旋转矩阵R 。

可由(5)式中si 的算术平均值作为比例因子s 的最佳估计值,得到比例因子s 和旋转矩阵R ,再根据(9)式求出平移矩阵T ,进而完成手眼矩阵的求解。

4.2 融合特征点拟合的转换关系

s f T 标定

传统的手眼标定方法适用于以机器人基坐标进行点云拼接的测量系统,由于机器人的绝对定位精度较差,这种测量系统的点云拼接精度较低。以iGPS全局定位跟踪系统作为世界坐标系,机器人仅作为移动机构,不再是精度链中的环节;结合形貌传感器的坐标系无法直接测量的特点,提出了融合特征点拟合的转换关系标定方法,借助激光跟踪仪对形貌传感器坐标系O s -X s Y s Z s 与Frame坐标系O f -X f Y f Z f 之间的转换关系

s f T 进行标定。

1) 融合特征点拟合标定的数学模型

为提高测量坐标值的精确性,选择尺寸相同的激光跟踪仪靶球与形貌传感器半球形作为参考点,可得到由形貌传感器坐标系O s -X s Y s Z s 到激光跟踪仪坐标系O l -X l Y l Z l 的转换关系

s l T 。使用激光跟踪仪对形貌传感器上4个iGPS接收传感器进行测量,按照iGPS定位跟踪系统中的坐标系建立原则建立Frame坐标系,得到激光跟踪仪坐标系O l -X l Y l Z l 到Frame坐标系O f -X f Y f Z f 的转换关系

l f T ,转换关系标定的示意图如图4 所示。故形貌传感器坐标系到Frame坐标系的转换关系为

s f T = l f T · s l T 。 (13)

根据布尔-沙七参数转换模型[7 -8 ] ,对于空间中可测量范围内的特征点,假设点P 在形貌传感器坐标系下的坐标为(

X Y Z T ,点P 在激光跟踪仪坐标系下的坐标为(

x y z T ,则两坐标系的关系为

x y z = s R l X Y Z + T l , (14)

式中R l =R (εX )R (εY )R (εZ )为由形貌传感器坐标系到激光跟踪仪坐标系的旋转矩阵;T l =(

ΔX ΔY ΔZ T 为两坐标系之间的平移向量。则(13)式可以表示为

s f T = s R l T l 0 1 R s T s 0 1 = s R l R s s R l T s + T l 0 1 , (15)

式中R s 、T s 分别为激光跟踪仪坐标系到Frame坐标系的旋转矩阵和平移向量,可由激光跟踪仪直接对形貌传感器上安装的4个iGPS接收传感器进行测量获取。

图 4. 转换关系标定示意图Fig. 4. Schematic of calibration of conversion relationship

2) 转换关系参数求解

融合特征点拟合的标定方法在求解形貌传感器与激光跟踪仪转换关系时,首先需要建立形貌传感器坐标系O s -X s Y s Z s 和激光跟踪仪坐标系O l -X l Y l Z l 下的一组公共特征点。为计算方便,通常将特征点坐标转化为以重心为原点的重心化坐标。设特征点在两坐标系下的坐标分别为(

X i Y i Z i T 、(

x i y i z i T ,i= 1,2,…,n ,两个坐标系下的重心坐标分别为(

X g Y g Z g T 、(

x g y g z g T ,g 代表重心。则有

( X g Y g Z g ) T = 1 n ∑ i = 1 n ( X i Y i Z i ) T ( x g y g z g ) T = 1 n ∑ i = 1 n ( x i y i z i ) T 。 (16)

记经重心化后两坐标系下的特征点坐标分别为(

X - i Y - i Z - i T 、(

x - i y - i z - i T ,则有

( X - i Y - i Z - i ) T = ( X g Y g Z g ) T - ( X g Y g Z g ) T ( x - i y - i z - i ) T = ( x g y g z g ) T - ( x g y g z g ) T 。 (17)

将(16)、(17)式代入(14)式可得

x - i y - i z - i = s R l X - i Y - i Z - i 。 (18)

对(18)式两边取2-范数,由s> 0及旋转矩阵为正交矩阵的特性可得

‖ ( x - i y - i z - i ) T ‖ = λ ‖ ( X - i Y - i Z - i ) T ‖ , (19)

式中λ 为sR 1l 的二范数值。

对于n 个公共点,可得s 的最小均方估计为

s = ∑ i = 1 n ‖ x - i y - i z - i T · X - i Y - i Z - i T ‖ ∑ i = 1 n ‖ X - i Y - i Z - i T ‖ 2 。 (20)

形貌传感器坐标系与激光跟踪仪坐标系之间的转换通常为大角度空间坐标转换,在求解旋转矩阵R l 时,若采用基于泰勒级数展开的非线性方法求解,涉及到旋转参数初始值的选取问题,得不到准确结果[9 -10 ] ;而SVD法特殊性较强,不能保证得到旋转矩阵[11 ] 。这里采用基于罗德里格矩阵的最小二乘法进行求解,罗德里格矩阵由反对称矩阵和单位矩阵构建[12 -13 ] ,引入一个具有3个独立元素的反对称矩阵:

S = 0 - c - b c 0 - a b a 0 , (21)

式中a 、b 、c 为罗德里格参数,则R l = (E+S )(E-S )- 1 为正交矩阵。将R l 展开为

R l = 1 1 + a 2 + b 2 + c 2 1 + a 2 - b 2 - c 2 - 2 c - 2 ab - 2 b + 2 ac 2 c - 2 ab 1 - a 2 + b 2 - c 2 - 2 a - 2 bc 2 b + 2 ac 2 a - 2 bc 1 - a 2 - b 2 + c 2 。 (22)

在解算罗德里格参数a 、b 、c 时,可将两个公共点的坐标代入(18)式,求差可得

x - 2 - x - 1 y - 2 - y - 1 z - 2 - z - 1 = s R l X - 2 - X - 1 Y - 2 - Y - 1 Z - 2 - Z - 1 , (23)

(23)式两端同时左乘(E-S )得

( E - S ) x - 2 - x - 1 y - 2 - y - 1 z - 2 - z - 1 = s ( E - S ) R l X - 2 - X - 1 Y - 2 - Y - 1 Z - 2 - Z - 1 。 (24)

由R l =(E+S )(E-S )-1 知(E-S )R l =(E+S ),将其代入(24)式得

( E - S ) x - 2 - x - 1 y - 2 - y - 1 z - 2 - z - 1 = s ( E + S ) X - 2 - X - 1 Y - 2 - Y - 1 Z - 2 - Z - 1 。 (25)

代入E 和S 后,整理可得

x - 21 - s X - 21 y - 21 - s Y - 21 z - 21 - s Z - 21 = 0 - z - 21 + s Z - 21 - y - 21 + s Y - 21 - z - 21 + s Z - 21 0 x - 21 + s X - 21 - y - 21 + s Y - 21 x - 21 + λ X - 21 0 a b c , (26)

式中

x - 21 = x - 2 - x - 1 y - 21 = y - 2 - y - 1 z - 21 = z - 2 - z - 1 X - 21 = X - 2 - X - 1 Y - 21 = Y - 2 - Y - 1 Z - 21 = Z - 2 - Z - 1

(26)式为两公共点矩阵方程,对于n 个公共点(n ≥3),可根据(25)式引入间接平差模型,误差方程为

V = B 3 ( n - 1 ) × 3 · X 3 × 1 - l 3 ( n - 1 ) × 3 , (27)

式中

B 3 ( n - 1 ) × 3 = 0 - ( z - 21 + s Z - 21 ) - ( y - 21 + s Y - 21 ) - ( z - 21 + s X - 21 ) 0 x - 21 + s X - 21 - ( y - 21 + s Y - 21 ) x - 21 + s X - 21 0 ︙ ︙ ︙ 0 - ( z - n 1 + s Z - n 1 ) - ( y - n 1 + s Y - n 1 ) - ( z - n 1 + s Z - n 1 ) 0 x - n 1 + s X - n 1 - ( y - n 1 + s Y - n 1 ) x - n 1 + s X - n 1 0 , X 3 × 1 = a b c , l 3 ( n - 1 ) × 3 = x - 21 - s X - 21 y - 21 - s Y - 21 z - 21 - s Z - 21 ︙ x - 21 - s X - 21 y - 21 - s Y - 21 z - 21 - s Z - 21 。 (28)

根据最小二乘原理[13 ] ,可求得X 为

X = ( B T · B - 1 ) · B T · l 。 (29)

将(29)式求得的值代入(22)式即可求得R l ,平移向量T l 的计算公式为

T l = x y z - s R l X Y Z 。 (30)

综合激光跟踪仪建立机器人法兰盘坐标系与激光跟踪仪坐标系的转换关系

l f T ,根据(13)式即可完成转换关系的求解。

4.3 转换关系

f w T

Frame坐标系由4个iGPS接收传感器组成,4个iGPS接收传感器的相对位置关系始终保持不变,虽然Frame坐标系在测量过程中随测量站位的改变而变化,但是其坐标系各轴的方位是稳定不变的。iGPS跟踪定位系统可实时跟踪4个iGPS接收传感器的空间坐标,系统软件对每个测量站位的4个接收传感器坐标进行处理,则Frame坐标系O f -X f Y f Z f 到世界坐标系O w -X w Y w Z w 的转换关系为

P w = R f · P f + T f , (31)

式中R f =R (εX )R (εY )R (εZ )为包含X 轴、Y 轴、Z 轴旋转信息的旋转矩阵。

转换关系

f w T 可以将Frame坐标系O f -X f Y f Z f 下的测量数据传递给世界坐标系O w -X w Y w Z w ,其精度依赖于iGPS测量系统的测量精度。相较于传统手眼系统,将机器人法兰盘坐标系下的测量数据传递给机器人基坐标系的转换精度明显提升,且不会因为机器人在使用中积累的轴隙磨损导致机器人处在不同位姿的转换关系精度不同。

5 测量系统标定及测量实验

5.1 测量系统标定实验 所搭建的机器人形貌测量系统的iGPS跟踪定位系统采用4站式iGPS激光发射器,形貌传感器上安装4个iGPS接收传感器,形貌传感器与工业机器人末端法兰盘采用刚性连接件连接。按照融合特征点拟合的

s f T 转换关系标定方法进行标定,标定过程中借助激光跟踪仪。激光跟踪仪作为辅助测量仪器,在整个实验过程中位置始终保持不变,具体标定操作如下。

1) 形貌扫描仪刚性固结在机器人末端,调整工业机器人的位姿,在形貌扫描仪测量域内固定安装一组磁力靶座,该磁力靶座可与直径为3.81 cm的激光跟踪仪靶球和形貌扫描仪特制球形靶标配合。

2) 保持机器人位姿不变,将直径为3.81 cm的形貌扫描仪特制球形靶标放置在5个磁力座上,调整特制球形靶标至合适角度,使用形貌扫描仪识别靶标的坐标值,形貌扫描仪坐标系下靶标的坐标如表1 所示。

表 1. 形貌传感器坐标系下的球心坐标Table 1. Coordinates of the spherical center in the shape sensor coordinate systemNO. x /mmy /mmz /mmP 1 -629.501 -456.168 -709.990 P 2 -489.565 -327.139 -839.924 P 3 -287.453 -370.202 -824.983 P 4 -785.155 -211.489 -868.092 P 5 -479.621 -168.579 -1028.013

3) 保持机器人位姿不变,将直径为3.81 cm的激光跟踪仪靶球分别放置在磁力座上,利用激光跟踪仪进行坐标测量,测量过程中每个点位的坐标均测量三次,根据测量结果剔除偏差较大的坐标值,将三次测量结果拟合成一点的坐标值作为球心坐标,结果如表2 所示。

表 2. 激光跟踪仪坐标系下的球心坐标Table 2. Coordinates of the spherical center in laser tracker coordinate systemNO. x /mmy /mmz /mmP 1 1750.6562 -652.9866 -566.1360 P 2 1521.3690 -676.2413 -566.1982 P 3 1412.9291 -500.7903 -585.8113 P 4 1649.6295 -961.3801 -504.6604 P 5 1335.7658 -836.7170 -586.6102

4) 保持机器人和形貌扫描仪位姿不变,换用直径为1.27 cm的激光跟踪仪靶球测量形貌扫描仪上4个iGPS接收器的坐标,将测量结果进行偏移补偿,使坐标测量值为iGPS接收器的中心坐标,测量结果如表3 所示。

表3 其iGPS接收传感器的中心坐标

Table 3 iGPS receiving sensor center coordinates

NO. x /mmy /mmz /mmP 1 1515.3124 -112.0494 445.7442 P 2 1456.9414 -166.5095 371.5581 P 3 1418.1711 -2.8220 450.7450 P 4 1349.2972 -58.6704 362.3372

根据iGPS定位跟踪系统坐标系的建立原则,结合表1 ~3的数据建立Frame坐标系O f -X f Y f Z f 。对公共点坐标测量值进行平差优化后,根据4.2节的数学模型即可解算出转换关系

s f T 为

s f T = - 0.99998373 - 0.0009176 0.00562765 - 72.2559967 0.00559232 0.0347862 0.99937916 119.85600281 0.00111279 - 0.99939436 0.03478050 144.16200256 0 0 0 1 。 (32)

通过以上的步骤即完成了测量系统转换关系标定的实验,验证了所提算法的可靠性。

5.2 机器人测量系统形貌测量实验 完成测量系统的标定后,通过基于机器人基坐标系和iGPS世界坐标系的点云拼接对比实验,验证该标定方法可提高点云拼接精度。基于机器人基坐标系的点云拼接实验中使用传统Eye-in-hand的手眼标定方式;基于iGPS世界坐标系的点云拼接实验中机器人结合iGPS定位跟踪系统对标准球进行测量,使用与基于机器人基坐标系点云拼接实验相同的机器人测量轨迹,即让机器人携带形貌扫描仪在相同的测量站位对处在相同位置的标准球进行测量。测量得到的点云数据会自动拼接在iGPS世界坐标系下,从6个测量站位对测量域内固定位置的标准球进行测量。

将测量的点云预处理后拼接在机器人基坐标系下,将测量点云拼接成三角网格,如图5 所示,再与标准球的理论数模进行最佳拟合对齐,之后进行三维偏差分析,结果如图6 所示,右侧彩色偏差分布条形图(数值表示拼接精度,单位为mm,绿色代表在公差范围内,红色代表正偏差,蓝色代表负偏差)结果显示,点云拼接精度在±0.6625 mm以内,偏差分布较均匀,但拼接精度很低。将基于iGPS世界坐标系的点云拼接实验测量点云封装成三角网格,如图7 所示,将其与标准球理论数模进行三维偏差分析,结果如图8 所示,右侧彩色偏差分布条形图结果显示点云拼接精度在±0.0905 mm之间,拼接效果较好。

图 5. 机器人基坐标系点云拼接Fig. 5. Robot base coordinate system point cloud splicing

图 6. 机器人基坐标系拼接偏差Fig. 6. Robot base coordinate system splicing deviation

图 7. iGPS世界坐标系点云拼接Fig. 7. iGPS world coordinate system point cloud splicing

图 8. iGPS拼接偏差Fig. 8. iGPS splicing deviation

两次基于不同坐标系的点云拼接实验,使用了相同的设备、测量站位与测量顺序,故其拼接精度的差异基本源于机器人的定位误差。通过对比图6 和图8 可知,以机器人基坐标系作为拼接坐标系的点云拼接精度明显低于iGPS世界坐标系的,其原因主要是由机器人制造工艺导致的模型误差和由日常使用中连杆轴隙间磨损导致的定位误差。机器人工作时各轴角度变化较大,在不同角度定位误差不尽相同,即使采用机器人本体标定技术对机器人进行标定,仍然无法得到测量需求的系统拼接精度。而在iGPS跟踪定位系统中,机器人仅仅是一个执行机构,不作为精度链的组成环,不存在使用过程中由磨损等因素导致iGPS接收传感器精度降低的问题,故针对大型复杂曲面测量时利用iGPS进行点云拼接,其精度更高,拼接结果更为可靠。

6 结论 研究了基于iGPS定位跟踪系统的大型复杂曲面三维形貌机器人测量系统坐标转换关系的标定方法。测量系统主要由形貌传感器、工业机器人、iGPS定位跟踪系统构成,建立了测量系统的数学模型。对形貌传感器测量坐标系、Frame坐标系、世界坐标系的定义和构成进行了说明,对各个坐标系之间的转换关系进行了研究。提出了融合特征点拟合的标定方法来建立形貌传感器坐标系与Frame坐标系之间的转换关系,在此基础上利用罗德里格矩阵进行了转换关系的求解。对标定后的系统进行基于机器人基坐标系和iGPS世界坐标系的点云拼接对比实验,实验结果表明,融合特征点拟合的标定方法提高了点云拼接的精度。

马国庆, 刘丽, 于正林, 曹国华, 王强. 基于iGPS定位跟踪的三维形貌测量系统标定方法[J]. 中国激光, 2019, 46(1): 0104003. Ma Guoqing, Liu Li, Yu Zhenglin, Cao Guohua, Wang Qiang. Calibration Method of Three-Dimensional Shape Measurement System Based on iGPS Positioning and Tracking[J]. Chinese Journal of Lasers, 2019, 46(1): 0104003.

下载: 816次

下载: 816次