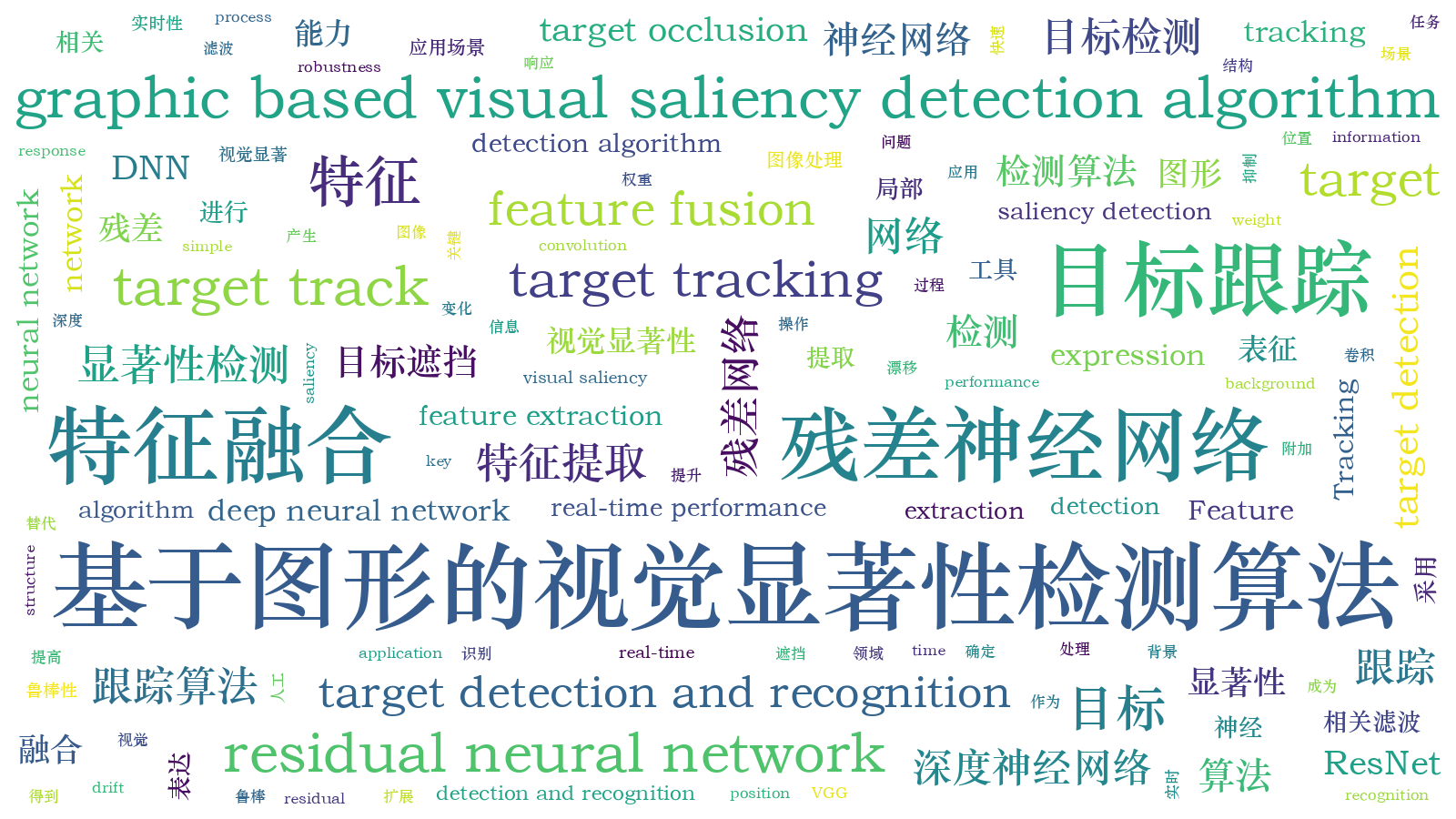

基于图形显著性检测的残差网络特征融合跟踪算法  下载: 819次

下载: 819次

1 引言

目标跟踪是计算机视觉领域的重要组成部分,广泛应用于**、安全监控、自动驾驶、医学等领域。但目标在快速运动或出现遮挡、模糊及姿态变化时,对跟踪算法提出了更高的要求。

Bolme等[1]将相关滤波应用到目标跟踪领域并提出了平方误差最小输出和(MOSSE)滤波器算法,该算法具有高效性、实时性,且鲁棒性更好,使基于相关滤波的目标跟踪算法得到了快速发展。其中,特征是目标跟踪中至关重要的一环[2]。从MOSSE滤波器算法中使用的一维灰度特征,到核滤波器(KCF)算法提出的多通道数据融合,使方向梯度直方图(HOG)等多维特征的使用成为可能。Danelljan等[3]提出基于颜色空间特征的Color Name跟踪算法,将RGB(Red, Green, Blue)颜色空间扩展到11个通道,对每个通道进行快速傅里叶变换及特征加权融合,提高了算法的跟踪精度,但也增加了计算量。Bertinetto等[4]将HOG特征和Color Name特征进行融合,改善了HOG特征在形变上的鲁棒性,达到了很好的跟踪效果。

深度学习具有强大的特征表达能力,因此,人们将深度学习特征应用到相关滤波的跟踪框架中[5-10]。Danelljan等[8]在空间正则化相关滤波(SRDCF)算法的基础上提出DeepSRDCF算法,通过实验分析了ImageNet-VGG-2048不同卷积层的效果,并将第一层提取的特征,经主成分分析(PCA)降维后输入SRDCF算法中。Ma等[9]提出了结合卷积神经网络(CNN)特征和相关滤波的层级卷积特征(CF2)算法,将CNN特征看作判别相关滤波器(DCF)框架里的多通道特征,然后训练分类器,特征提取网络为在ImageNet上预训练的VGG-Net conv3,4,5层。为了保持空间分辨率,去掉了池化层和全连接层。多线索相关滤波(MCCT)算法[10]将HOG,VGG-19的conv4-4,conv5-4三个特征进行排列组合,构建了七个专家系统同时进行跟踪,然后根据鲁棒分数和自评估分数自适应选择最好的跟踪专家。

相比人工特征,深度学习特征可以增强算法的精确性和鲁棒性,但深度特征提取工具仍然具有很大的提升空间。首先,在目标识别检测任务中,增加网络深度可以有效提升网络的识别率,如常用的深度特征提取工具VGG-19网络。其次,CNN提取的特征维度是普通特征的数百倍,特征之间存在大量的冗余信息,直接用这些高维特征表征目标大大增加了分类器训练和更新的计算量,降低了目标跟踪效率。最后,当局部感兴趣目标的信息量不完备时,提取的目标信息鲁棒性较差,可能会导致跟踪漂移。

针对上述问题,本文采用更深层数的残差神经网络(RNN),获得比VGG-19网络更丰富的特征信息,再结合浅层特征和深层语义特征选择合适的特征层组,从浅层特征的高分辨率、细节信息和深层特征的语义信息中获取更完整的目标表达。对提取的每一层特征都训练一个滤波器,然后结合不同特征层的响应图,实现从粗到精的目标定位跟踪。当跟踪信息不完备的局部目标时,用基于图形的视觉显著性(GBVS)检测算法[11]对候选框进行显著性检测,以提高特征的表征能力。

2 基本原理

2.1 基于残差网络的特征融合算法

2.2 基于显著性检测改进的跟踪算法

2.2.1 注意力机制

当场景从整个目标切换到目标上某个具有扩展特性的局部感兴趣目标时,上述算法中的特征融合策略效果较差。从目标本身来看,当局部扩展目标的信息量不够时,无法轻易提取出具有代表性的表征目标。从跟踪算法来看,层级融合策略中的高级语义信息对于局部目标的增益作用较小。

为了扩展算法的适用范围,采用显著性检测机制增强目标特征的表征能力。面对具有复杂场景的图像,人类通常能迅速找到自己感兴趣的区域,有效分析和处理图像,这种机制也被称为视觉显著性注意机制[14]。这种注意机制是大脑对复杂信息处理的权重选择,将这种机制引入图像分析中,可以优化计算资源的分配。

2.2.2 GBVS检测算法

GBVS算法提取候选框特征图的方法与文献[ 15]中的显著性算法相似,通过线性滤波和非线性滤波得到特征图M:[n]2→R,其中,[n]为{1,2,…,n},R为实数,然后通过马尔科夫链方法构建激活图Ga,将特征图M的像素点表示为图像的节点,节点与节点之间的权重w1可表示为

式中,F(a,b)为距离权重,两点的距离越远,距离权重越小,σ的值在距离的1/10到1/5范围内。d[(i,j)||(p,q)]为两个像素点之间的差异,M(i,j)、M(p,q)为像素点(i,j)、(p,q)的特征值。

将Ga边的权重归一化在[0,1]之间,并在Ga上定义一个马尔科夫链,边的权重定义为转移概率,节点定义为状态。用马尔科夫链的平衡状态表示停留在每个节点上的时间,若一个节点与其周围节点的相似性较小,则在这个节点上聚集的时间较长,停留时间可以反映该区域的显著性。特征图的显著情况由Ga的马尔科夫链稳定状态表示[16],再进行归一化操作就能得到显著性图像,如

图 2. 原始图像与GBVS图像。(a)原始图像;(b) GBVS图像

Fig. 2. Original image and GBVS image. (a) Original image; (b) GBVS image

2.2.3 基于GBVS改进的算法

将GBVS的显著性检测机制与特征融合相结合,GBVS图像能反映当前图像候选框内的显著区域,即将GBVS图像检测的结果和提取出的特征进行乘积操作,以权重的形式增强当前目标的表达,同时削弱背景对目标跟踪的影响。基于GBVS改进的算法流程如

3 实验验证

3.1 显著性检测对层级特征的增强

实验环境:CPU为2.90 GHz 12核i9-7920,内存为32 GB的台式机,编程环境为Matlab2018a,实验数据集为TColor128数据集[17],用平均中心误差作为最终评价指标。按照特征大小,将ResNet-50分成五个层组:conv1(尺寸为112×112),conv2(尺寸为56×56),conv3(尺寸为28×28),conv4(尺寸为14×14),conv5(尺寸为7×7)。

为分析GBVS算法对深度神经网络ResNet-50层级特征的有效性,设计了两组对比实验:第一组实验用ResNet-50中不同单层特征层提取的特征表征目标,然后用该特征层的结果和相关滤波器进行相关操作,得到响应图。第二组实验是用ResNet-50提取特征后,将GBVS算法的显著性检测结果和原始特征进行乘积,然后用带有显著性权重的特征层数进行跟踪。

图 4. 基于GBVS改进的算法平均中心误差

Fig. 4. Average center error of the improved algorithm based on GBVS

从

表 1. 基于GBVS改进的算法平均中心误差对比

Table 1. Comparison of average center error based on GBVS improved algorithm

|

图 5. 算法的跟踪效果。(a)改进前;(b)改进后

Fig. 5. Tracking effect of the algorithm. (a) Before improvement; (b) after improvement

表 2. 不同算法的中心误差平均值

Table 2. Average central error of different algorithms

|

3.2 在OTB50数据集上的对比实验

在目前主流的跟踪数据集OTB50上进行验证,采用一次通过评估(OPE)参数定量评价跟踪精度和尺度变化。为比较不同特征提取工具在相同相关滤波框架上的有效性,选取4种代表性的同框架不同特征的跟踪算法与本算法进行对比实验。将实验对照组分成两组:第一组为手工特征CSK(Gray)、Staple(HOG+Color)、STRCF(HOG+CN);第二组为神经网络特征CF2(VGG),括号内为采用的特征。CF2RES_old表示未经过GBVS改进的多层特征融合算法,CF2RES表示经过GBVS算法改进后的多层特征融合算法。

从

图 6. 不同算法在OTB50数据集上的跟踪精度。(a)总精度;(b)快速移动;(c)运动模糊;(d)低分辨率;(e)遮挡;(f)不同尺度

Fig. 6. Tracking accuracy of different algorithms on the OTB50 data set. (a) Total accuracy; (b) fast movement; (c) motion blur; (d) low resolution; (e) occlusion; (f) different scales

图 7. 不同算法在OTB数据集的跟踪结果

Fig. 7. Tracking results of different algorithms in the OTB dataset

4 结论

基于融合多层神经网络特征的相关滤波算法,提出了一种基于GBVS的残差神经网络特征融合跟踪算法。为了保证目标信息的鲁棒性,将残差神经网络的附加层和卷积层进行特征融合,并与显著性检测结果相乘得到最终目标特征组。将本算法和其他同类型算法在OTB50数据集进行测试和对比,实验结果表明,相比其他算法,本算法的精确度更高。但本算法在增加显著性检测的同时也增大了算法的复杂度,导致算法的实时性较差,从改进前的10 frame/s降低到0.5 frame/s。因此,还需进一步提高算法的实时性,以便更好地平衡目标跟踪的实时性和鲁棒性。

[1] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[2] Wang NY, Shi JP, YeungD, JiaJ. Understanding and diagnosing visual tracking systems[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 3101- 3109.

[3] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥IEEE Conference on Computer Vision & Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

[4] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1401- 1409.

[5] 杨大伟, 巩欣飞, 毛琳, 等. 重构特征联合的多域卷积神经网络跟踪算法[J]. 激光与光电子学进展, 2019, 56(19): 191501.

[6] 吴敏, 查宇飞, 张园强, 等. 基于分类-验证模型的视觉跟踪算法研究[J]. 光学学报, 2018, 38(5): 0515003.

[7] 唐聪, 凌永顺, 杨华, 等. 基于深度学习的红外与可见光决策级融合跟踪[J]. 激光与光电子学进展, 2019, 56(7): 071502.

[8] DanelljanM, HägerG, Khan FS, et al. Convolutional features for correlation filter based visual tracking[C]∥2015 IEEE International Conference on Computer Vision Workshop (ICCVW), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 621- 629.

[9] MaC, Huang JB, Yang XK, et al. Hierarchical convolutional features for visual tracking[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13,2015, Santiago, Chile. New York: IEEE, 2015: 3074- 3082.

[10] WangN, Zhou WG, TianQ, et al. Multi-cue correlation filters for robust visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 4844- 4853.

[11] HarelJ, KochC, PeronaP. Graph-based visual saliency[C]∥Advances in Neural Information Processing Systems 19: Proceedings of the 2006 Conference, December 4-7, 2006, Vancouver, BC, Canada. Cambridge: MIT, 2006: 545- 552.

[12] Jin H, Li X. Target tracking based on hierarchical feature fusion of residual neural network[J]. Proceedings of SPIE, 2019, 11321: 113211H.

[13] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3): 583-596.

[15] Itti L, Koch C, Niebur E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11): 1254-1259.

[16] 陈梦婷, 陈思喜. 基于GBVS改进的Object Bank场景分类方法[J]. 计算机与现代化, 2017, 7(1): 61-64.

Chen M T, Chen S X. Object Bank scene classification based on improved GBVS[J]. Computer and Modernization, 2017, 7(1): 61-64.

[17] Liang P P, Blasch E, Ling H B. Encoding color information for visual tracking: algorithms and benchmark[J]. IEEE Transactions on Image Processing, 2015, 24(12): 5630-5644.

[18] LiF, TianC, Zuo WM, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 4904- 4913.

[19] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer Vision-ECCV 2012. Lecture Notes in Computer Science. Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

Article Outline

金潓, 李新阳. 基于图形显著性检测的残差网络特征融合跟踪算法[J]. 激光与光电子学进展, 2020, 57(18): 181025. Hui Jin, Xinyang Li. Residual Network Feature Fusion Tracking Algorithm Based on Graph Salience Detection[J]. Laser & Optoelectronics Progress, 2020, 57(18): 181025.