融合卷积神经网络与主题模型的图像标注  下载: 842次

下载: 842次

1 引言

随着网络社交平台及APP的普及,互联网中无标签图像数据的规模日益增长。由于大数据技术的高速发展,网络中的无标签图像展现出巨大的商业价值,如何快速筛选并使用这些无标签图像数据成为一个极具研究价值的问题。图像检索[1]可以高效检索出需要的图像,而其在无标签图像数据的检索效果依赖于图像标注方法。由于图像的视觉特征与文本标签之间存在“语义鸿沟”[2],研究图像标注方法依旧是一份十分具有挑战性的工作。

当前图像标注方法主要分为4类:第1类是判别式图像标注[3-4],将图像自动标注问题看作是一个有监督的分类问题,通过计算视觉特征的相似性将一幅图分类为一个或多个语义类别;第2类是生成式图像标注模型[5-6],计算出视觉特征和语义文本之间的联合分布概率,然后使用分布模型估计新图像的语义标注文本概率;第3类是最邻近图像标注模型[7-8],依据图像特征找出与测试图像最相似的多张图像,并利用这些图像的标注词为测试图像进行标注;第4类是基于深度学习的图像标注模型。由于深度学习在多个领域取得了较好的成绩,特别是卷积神经网络[9](CNN)在计算机视觉领域(如图像分类[10]和目标识别[11]等)表现出优秀的图像处理能力,因此基于深度学习的图像标注效果一般优于其他模型。例如,基于线性回归的CNN-R(CNN-Regression)模型,该方法通过优化模型参数,提高了图像标注的性能[12];高耀东等[13]提出的CNN-MSE(CNN-Mean Squared Error)方法,通过将CNN的损失函数改进为均方差误差损失函数,极大地提高了图像的标注性能。虽然基于深度学习的图像标注性能较好,但忽略了图像集文本数据的稀疏分布及分布不平衡对图像标注的影响。为解决该问题,本文提出融合CNN和主题模型的图像标注方法。

本文充分利用狄利克雷(LDA)模型对图像文本信息处理和CNN对图像视觉特征提取的优势。利用LDA主题模型对图像训练集的文本数据建模,生成图像训练集的潜在文本主题分布和文本主题标注词分布,对图像训练集文本数据的处理弥补了CNN分类训练集中文本数据维度大、分布稀疏的问题;CNN提取图像的高层视觉特征弥补了传统图像特征提取复杂和传递图像视觉信息有限的问题。通过结合CNN和主题模型对图像视觉数据和文本数据的处理,改进CNN中的损失函数,使其可以计算图像对应多个文本主题分类学习的损失和提高低频文本主题分类的准确率,从而提高图像标注的性能。

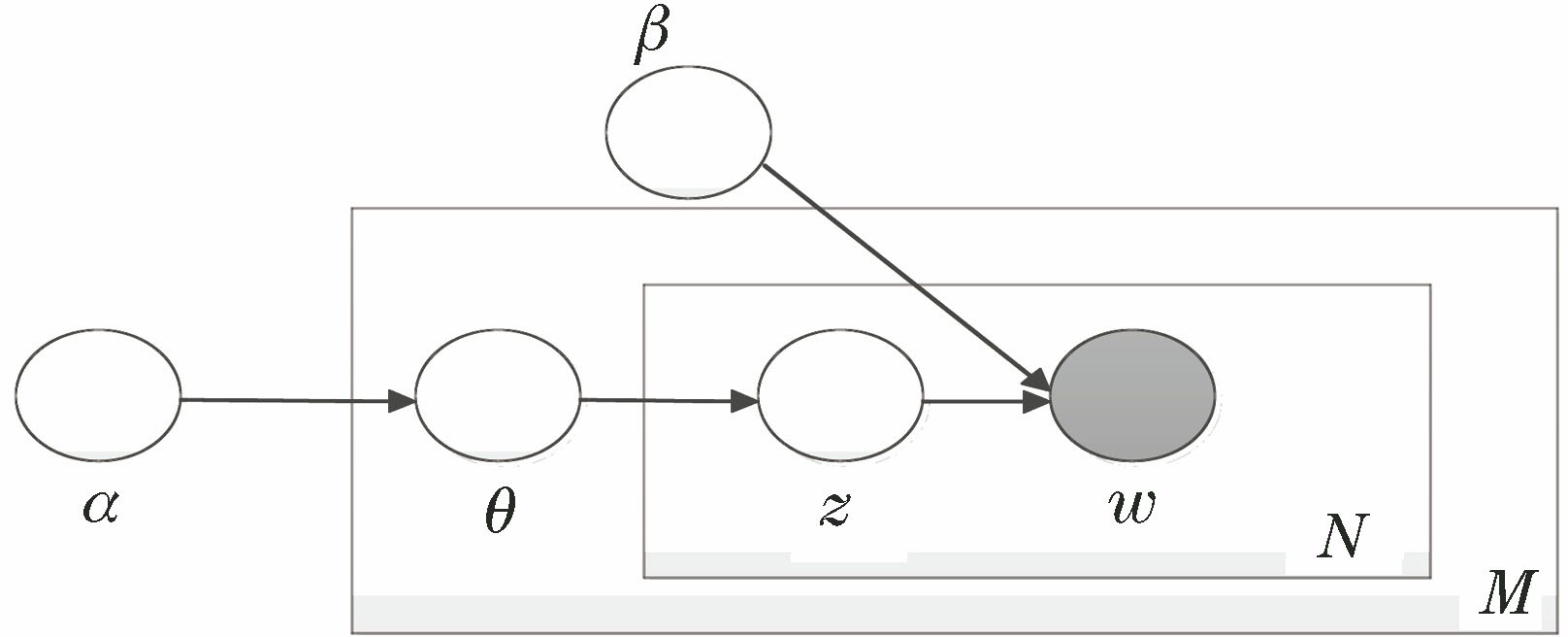

2 主题模型

LDA模型是一个生成式主题模型,其概率图模型如

在LDA模型下文档的具体生成过程为

1) 抽取一个主题比例

2) 对于文档

3) 抽取主题分派

4) 生成单词

潜变量和可观测变量的联合分布为

式中,

表 1. 符号及其意义

Table 1. Symbols and their meaning

|

利用LDA主题模型进行图像标注,需要得到测试集的图像主题分布

式中,

3 改进的卷积神经网络

3.1 基于迁移学习的卷积神经网络

用来进行图像特征学习和图像文本主题多标签分类学习的模型是AlexNet[14]模型,它曾是ImageNet[15]图像分类比赛中第一名。AlexNet模型的网络结构有 5个卷积层、3个池化层、3个全连接层,所有网络共计11层。CNN需要大量的图像数据进行训练以得到较好的模型参数,但是这种大规模数据训练对实验环境的要求高,耗费时间长,而采用小规模的数据集进行训练又易导致网络过拟合。因此采用迁移学习[16]的思想,即获得CNN在大规模数据集ImageNet上的模型参数,将其迁移到CNN上进行初始化,然后利用指定图像数据集对最后一层网络的模型参数进行微调,同时为适应对指定实验数据集的文本主题进行多标签分类的任务,需要修改网络输出层的损失函数。最后,使用完成微调的CNN模型提取图像数据集的高层特征同时进行图像文本主题多标签分类。基于迁移学习的CNN模型结构如

图像在输入CNN之前需要裁剪为指定大小227×227。在

表 2. CNN各层参数设置

Table 2. Parameters of different layers of CNN

|

3.2 基于多标签分类的损失函数

CNN中损失层的损失函数主要适用于单标签分类,但本文在CNN中需要进行图像文本主题多标签分类。因此需要将CNN的分类训练集由图像的高层视觉特征对应单个标签改为对应多个文本主题,并对原有的损失函数进行改进。CNN在进行单标签分类时,选用softmax交叉熵函数作为其损失函数,其公式为

为使CNN适应多标签分类,其损失函数需要计算训练集中图像的多个文本主题的全部损失,即对一张图像对应的多个潜在文本主题的损失进行累加。改进的损失函数为

式中:

图像的文本主题分布基于图像训练集文本标注词生成,因此图像训练集的文本标注词分布不平衡会影响图像生成的对应文本主题,使得该文本主题分布不平衡。由于图像训练集的文本主题分布不平衡,CNN在进行图像文本主题多标签分类学习时,低频文本主题分类学习的准确性要远低于高频文本主题。为提高分类学习中低频文本主题的准确率,在图像训练集中的高频标签中加入噪声进行平滑处理[17],在损失函数中加入频率系数,改进(5)式,表示为

式中:

对原有的文本主题

4 图像标注框架

在CNN和LDA主题模型的基础上,提出融合CNN和主题模型的图像标注方法。利用LDA主题模型对图像训练集的文本标注词进行建模,生成图像训练集的文本主题分布和文本主题的标注词分布。该处理充分利用主题模型的优势,降低图像文本数据的维度和稀疏性。考虑到判别式分类算法在图像稀疏标签分类中的优势,利用CNN的分类器进行图像文本主题多标签分类,可获取比生成式的主题模型中更加准确的潜在文本主题分布。由于传统特征的表达能力弱和提取过程复杂,这里采用CNN模型提取图像的高层视觉特征。在CNN完成图像特征学习后,改进CNN的分类器使其适应多标签分类,利用图像的高层特征及其对应的多个文本主题构造分类器,进行图像的文本主题多标签学习。图像标注的框架如

图 3. 融合CNN和主题模型的图像标注框架

Fig. 3. Framework of image annotation that combines CNN and topic model

由

1) 采用LDA主题模型为图像训练集的文本标注词建模,生成图像文本模态的主题分布

2) 利用完成微调的CNN提取图像的高层视觉特征,此特征表达的图像视觉信息比传统手工特征更加全面。由于图像训练集的文本主题分布稀疏且判别式分类处理图像标签的稀疏分布更具有优势,利用训练集中图像的高层语义特征及其文本主题构造分类器,其中每一类代表一个图像文本模态的主题。同时,每张训练图像可由一个图像的高层特征向量表示,其文本模态对应多个文本主题,将CNN模型的分类器改为多标签分类器,在此过程中也需注意改善训练集图像的文本主题分布不平衡的问题。

在图像标注阶段,即标注测试图像的过程可分为2步:

1) 利用完成微调的CNN提取测试图像的高层特征。然后利用完成训练的CNN的分类器对测试图像的高层特征进行分类,得到该测试图像的文本主题分布。

2) 将测试图像的文本主题分布和由主题模型生成的文本主题标注词分布按照主题模型的图像标注 (2) 式进行计算,以得到测试图像的文本标注词概率,选取概率最大的5个标注词作为测试图像的标注结果。

5 实验结果分析

5.1 实验设置

为验证本文标注方法的有效性,分别在两个图像标注数据集Corel5K与IAPR TC-12上进行实验。Corel5K图像数据集共有4999张彩色图像,图像大小为192×168,每张图像有1~5个标签。其中,4500张图像用于训练,剩余的499张用于测试。IAPR TC-12数据集共有19627张480×360大小的彩色图像,平均每张图像有5.7个标注。在此数据集中用于训练的图像个数为17665,用于测试的图像个数为1962。另外,验证图片包含于训练图像集。实验结果的评价指标是平均查准率(AP)、平均查全率(AR)和综合评价指标F1[18]。

5.2 实验参数设置

实验中的CNN是在Caffe深度学习框架的基础上运行的,并且CNN在运行过程中使用NVIDIA K620 GPU和cuDNN进行计算和加速[17]。在图像标注方法中,图像训练集中文本主题的个数

5.3 实验结果

为验证本文图像标注算法的有效性,在图像数据集上将本文图像标注方法与当前一些传统的图像标注方法进行比较,如MBRM[7]模型、JEC[8]模型、及改进的TagProp-ML方法[11]、2PKNN方法[12]。同时,与使用深度CNN的图像标注方法进行比较,如CNN-R模型[12]、CNN-MSE模型[13]。为验证图像高层视觉特征对图像标注的积极影响,在Corel5k数据集上,取不同图像视觉特征(传统特征和高层特征)的传统标注模型PLSA-WORDS[6]和HGMD[17]与本文图像标注方法进行对比。

表 3. 模型在Corel5K上的标注结果

Table 3. Annotation results of different models on Corel5K

|

通过

表 4. 通用数据集上所有图像标注方法的标注结果

Table 4. Annotation results of all image annotation models on common datasets

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

6 结论

为有效进行图像标注,提出融合卷积神经网络与主题模型的图像标注方法。对比其他标注方法,本文充分利用了主题模型在文本处理的优势,降低了图像文本数据的维度和稀疏性,运用卷积神经网络提取图像的高层视觉特征和进行图像文本主题多标签学习,获得更多的图像信息和更准确的文本主题分布。实验表明,本文方法显著提升了图像标注的性能。

[1] 彭晏飞, 宋晓男, 訾玲玲, 等. 基于卷积神经网络和改进模糊C均值的遥感图像检索[J]. 激光与光电子学进展, 2018, 55(9): 091008.

[4] Cusano C, Ciocca G, Schettini R. Image annotation using SVM[J]. Proceedings of SPIE, 2003, 5301: 330-338.

[5] Blei[\s]{1}DM,[\s]{1}Jordan[\s]{1}MI.[\s]{1}Modeling[\s]{1}annotated[\s]{1}data[C]∥Proceedings[\s]{1}of[\s]{1}the[\s]{1}26th[\s]{1}annual[\s]{1}international[\s]{1}ACM[\s]{1}SIGIR[\s]{1}conference[\s]{1}on[\s]{1}Research[\s]{1}and[\s]{1}development[\s]{1}in[\s]{1}information[\s]{1}retrieval,[\s]{1}July[\s]{1}28-August[\s]{1}1,[\s]{1}2003,[\s]{1}Toronto,[\s]{1}Canada.[\s]{1}New[\s]{1}York:[\s]{1}ACM,[\s]{1}2003:[\s]{1}127-[\s]{1}134.[\s]{1}

[7] GuillauminM,[\s]{1}MensinkT,[\s]{1}VerbeekJ,[\s]{1}et[\s]{1}al.[\s]{1}TagProp:[\s]{1}discriminative[\s]{1}metric[\s]{1}learning[\s]{1}in[\s]{1}nearest[\s]{1}neighbor[\s]{1}models[\s]{1}for[\s]{1}image[\s]{1}auto-annotation[C]∥2009[\s]{1}IEEE[\s]{1}12th[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision,[\s]{1}September[\s]{1}29-October[\s]{1}2,[\s]{1}2009,[\s]{1}Kyoto,[\s]{1}Japan.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2009:[\s]{1}309-[\s]{1}316.[\s]{1}

[9] 郭呈呈, 于凤芹, 陈莹. 基于卷积神经网络特征和改进超像素匹配的图像语义分割[J]. 激光与光电子学进展, 2018, 55(8): 081005.

[11] He[\s]{1}KM,[\s]{1}Zhang[\s]{1}XY,[\s]{1}Ren[\s]{1}SQ,[\s]{1}et[\s]{1}al.[\s]{1}Deep[\s]{1}residual[\s]{1}learning[\s]{1}for[\s]{1}image[\s]{1}recognition[C]∥2016[\s]{1}IEEE[\s]{1}Conference[\s]{1}on[\s]{1}Computer[\s]{1}Vision[\s]{1}and[\s]{1}Pattern[\s]{1}Recognition[\s]{1}(CVPR),[\s]{1}June[\s]{1}27-30,[\s]{1}2016,[\s]{1}Las[\s]{1}Vegas,[\s]{1}NV,[\s]{1}USA.[\s]{1}New[\s]{1}York:[\s]{1}IEEE,[\s]{1}2016:[\s]{1}770-[\s]{1}778.[\s]{1}

[12] Murthy[\s]{1}VN,[\s]{1}MajiS,[\s]{1}ManmathaR.[\s]{1}Automatic[\s]{1}image[\s]{1}annotation[\s]{1}using[\s]{1}deep[\s]{1}learning[\s]{1}representations[C]∥Proceedings[\s]{1}of[\s]{1}the[\s]{1}5th[\s]{1}ACM[\s]{1}on[\s]{1}International[\s]{1}Conference[\s]{1}on[\s]{1}Multimedia[\s]{1}Retrieval,[\s]{1}June[\s]{1}23-26,[\s]{1}2015,[\s]{1}Shanghai,[\s]{1}China.[\s]{1}New[\s]{1}York:[\s]{1}ACM,[\s]{1}2015:[\s]{1}603-[\s]{1}606.[\s]{1}

[13] 高耀东, 侯凌燕, 杨大利. 基于多标签学习的卷积神经网络的图像标注方法[J]. 计算机应用, 2017, 37(1): 228-232.

[14] 马永杰, 李雪燕, 宋晓凤. 基于改进深度卷积神经网络的交通标志识别[J]. 激光与光电子学进展, 2018, 55(12): 121009.

[16] 庄福振, 罗平, 何清, 等. 迁移学习研究进展[J]. 软件学报, 2015, 26(1): 26-29.

Zhuang F Z, Luo P, He Q, et al. Survey on transfer learning research[J]. Journal of Software, 2015, 26(1): 26-29.

[17] 李志欣, 郑永哲, 张灿龙, 等. 结合深度特征与多标记分类的图像语义标注[J]. 计算机辅助设计与图形学学报, 2018, 30(2): 318-326.

[18] 汪鹏, 张奥帆, 王利琴, 等. 基于迁移学习与多标签平滑策略的图像自动标注[J]. 计算机应用, 2018, 38(11): 3199-3203, 3210.

Article Outline

张蕾, 蔡明. 融合卷积神经网络与主题模型的图像标注[J]. 激光与光电子学进展, 2019, 56(20): 201004. Lei Zhang, Ming Cai. Image Annotation Based on Convolutional Neural Network and Topic Model[J]. Laser & Optoelectronics Progress, 2019, 56(20): 201004.