双注意力循环卷积显著性目标检测算法  下载: 1538次

下载: 1538次

1 引言

人类的视觉注意力机制能帮助人眼在复杂环境中快速定位最感兴趣的目标或区域。在机器视觉领域,常使用显著性目标检测算法模拟人类这一视觉特性:使用显著性目标检测算法对图像像素点进行显著度计算,突出图像前景区域像素,抑制背景区域像素,最终达到数据降维和减少背景干扰的目的。生成的显著图将有助于合理分配有限的计算资源,为后续复杂的视觉任务提供先验信息。显著性目标检测被广泛应用于图像检索[1]、图像/视频压缩[2]、图像质量评估[3]和虚拟视觉[4]等领域。

传统的显著性目标检测算法主要依靠人工提取的特征来计算区域显著性。Itti等[5]最先通过融合图像的颜色、方向、强度等浅层特征来度量图像显著区域;刘冬梅等[6]利用非下采样轮廓小波变换分解的高低频分量进行“由粗到精”的显著性检测;李德峰等[7]利用区域协方差理论融合多尺度空间特征,再结合全局核密度估计实现全局和局部特征融合估计目标显著性。上述算法在背景简单、对比度高的情况下能有效反映出目标的显著性,但由于未能利用深层语义的特征,检测结果的稳健性较差,显著区域突显不充分,算法泛化能力较弱。

近年来,卷积神经网络(CNN)被广泛应用于机器视觉领域,其具有自动提取图像特征的能力,通过堆叠卷积块,可以获得丰富的高层次特征。刘峰等[8]利用线性拟合将卷积网络全局预测模型和区域特征描述子优化模型的结果进行融合,生成高质量显著图;张松龙等[9]首先密集地融合尺度内卷积特征输出各尺度显著图,再融合多尺度显著图生成最终显著图;Hou等[10]在整体嵌套边缘检测(HED) 网络[11]基础上提出了一种特征“自顶向下”传播的全卷积神经网络架构。卷积神经网络能自动提取丰富的图像特征,包括浅层的结构特征和高层的语义特征,采用监督学习的方式对特征进行筛选、组合,增强了特征表示能力。特别是全卷积神经网络的使用,极大提高了显著性目标检测的性能。但仍存在特征利用效益不足,显著目标区域突出不均匀,背景错误检测和目标轮廓模糊等问题。

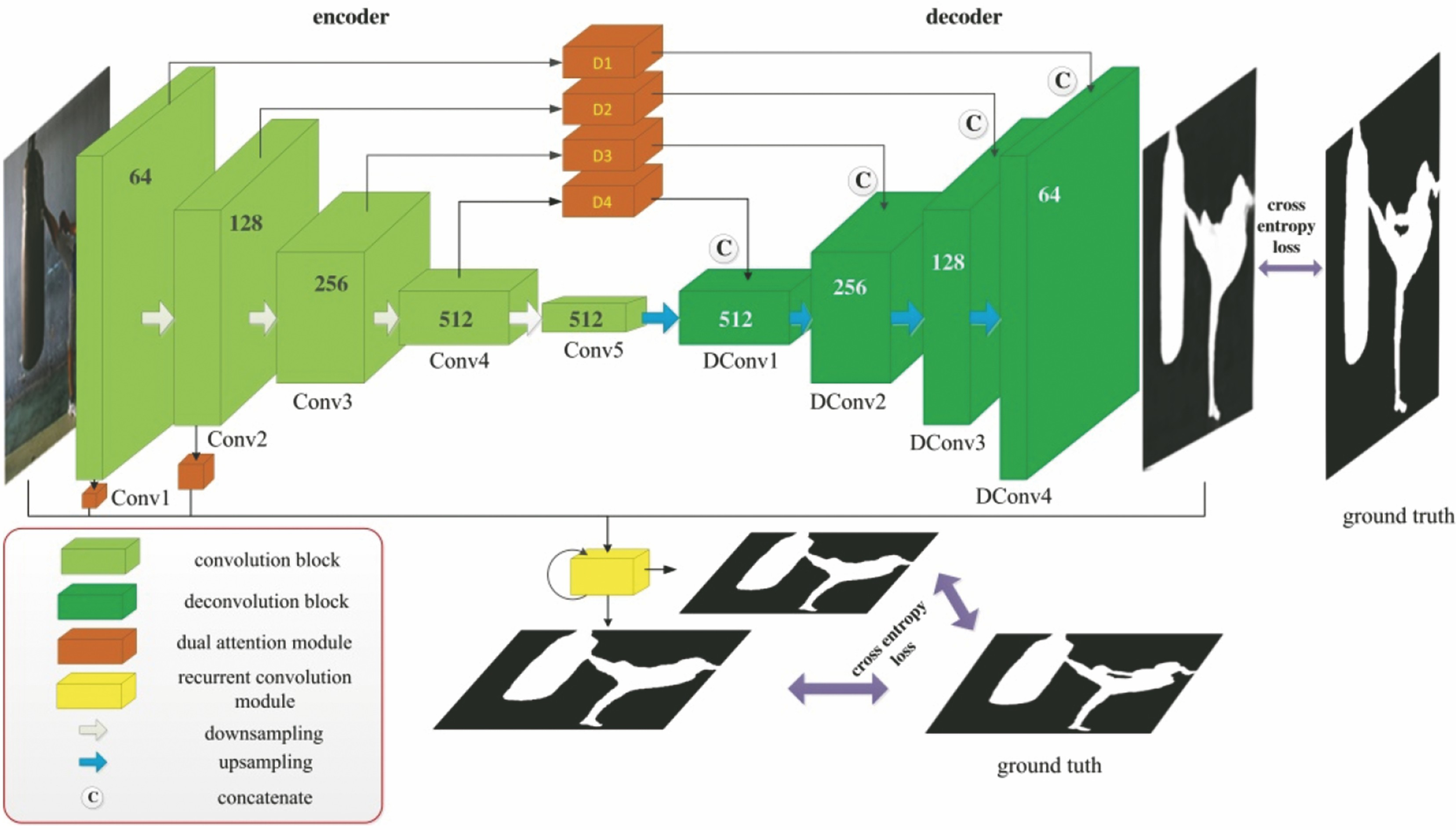

本文提出一种双注意力循环卷积网络显著性目标检测算法,选取U-Net[12]作为骨干网络,设计像素间-通道间双注意力模块(DAM),增强特征的利用效益,减弱噪声和背景像素干扰;设计一种循环卷积模块(RCM),通过循环迭代细化显著区域边缘轮廓;使用旁路输出策略对预测结果进行多阶段约束。

2 基本原理

所提检测算法模型主要包括全卷积骨干网络、双注意力模块和循环卷积模块。采用跨层连接策略融合深层语义特征和浅层结构特征。算法总体结构如

2.1 基于U-Net的全卷积骨干网络

文献[ 13]的实验结果表明只利用最后一层语义特征进行解码生成的图像具有严重“马赛克”现象,这是因为编码器中最大池化层会使图像信息损失,解码器不能完整还原细节信息。卷积神经网络中深层特征学习更多的语义信息,浅层特征描述图像局部结构特征,通过跨层连接将浅层细节特征与深层语义特征进行融合,能提高编码器预测图的细节表征能力。U-Net是图像分割领域的经典网络模型,其采用对称 “金字塔形”的编码器-解码器结构进行逐像素点预测,编码器与解码器之间采用跨层连接的方式进行多层级、多尺度特征融合,用于实现目标区域的准确分割。

本研究采用基于U-Net的改进全卷积神经网络作为特征提取骨干网络,用于实现显著性目标检测。编码器采用五层卷积块提取输入图像的高层语义特征,用于描述图像目标的显著性。其中卷积块由两个包含3×3卷积层、BN(batch normalization)层和ReLU激活层的子卷积模块组成。卷积块之间使用滑步为2的最大池化层进行下采样,增大深层特征感受野,确保特征描述具有一定的全局性。对每次下采样后的特征通道进行翻倍,最后的下采样通道不进行加倍。解码器采用反卷积块对高层语义特征进行上采样。反卷积块具有卷积块相同对卷积子模块,只是模块之间采用反卷积层进行上采样。上采样后通道数减半,并与对应的具有相同分辨率的编码器特征进行通道堆叠(channel concatenate)。

2.2 双注意力模块

前景区域和背景区域对显著性目标检测的影响不同,各特征通道对预测结果的贡献度存在差异。U-Net直接采用跨层连接将编码端特征与解码端特征进行concatenate融合,该操作会引入大量的杂波,干扰最后预测图生成。针对此问题,引入注意力机制对编码器特征进行预加权处理,过滤有害杂波干扰。以往的注意力机制只片面考虑通道间或像素间特征的影响,未能全面地对整个特征图中各像素点的重要度进行衡量。而显著性目标检测是通过逐像素点预测来对显著性目标区域进行分割,对各像素点的质量要求较高。基于此设计中的双注意力模块,在融合编码端特征与解码端特征之前,先将编码端特征接入设计的通道间-像素间双注意力模块,标定通道间响应权重,突出前景区域像素响应强度,增强任务相关特征表征能力,弱化背景和噪声影响。为避免由于多级注意力模块串联造成的特征信息弱化与损失,双注意力模块采用并联方式融合两类注意力。双注意力模块内部结构如

2.2.1 像素间注意力模块

显著性目标一般存在于图像某个区域,该区域像素点对目标显著值预测的影响大于其他像素点[14]。引入像素间注意力模块,为图像各像素点赋予权值,更多地关注前景区域像素,有助于生成有效的特征,减弱非显著区域的干扰。

文献[

15]使用多尺度卷积滤波器设计上下文重加权网络,对输入特征图进行像素间加权处理,增强地标建筑区域像素响应,提高了图像地理定位精度。文献[

16]利用感受野模块(RFB)模拟人类视觉感受野特性。聚合了多尺度特征信息,提升了目标检测准确率。本研究基于文献[

15],参考RFB设计思想,设计一种多尺度上下文重加权网络(MSCRN),作为像素间注意力模块来实现特征图像素间注意力预测,如

基于Inception-ResNet[17]结构设计一种多尺度上下文信息聚合模块,构建三路分支,分别为3×3卷积、3×3卷积加比率为3的3×3空洞卷积、3×3卷积加比率为3的5×5空洞卷积,实现3×3,9×9和15×15三个尺度特征信息的提取,并采用1×1卷积进行多通道特征融合。由于各级卷积特征分辨率存在差异,多尺度信息整合模块需自适应地进行调整。Conv1和Conv2的特征图分辨率较大,采用三支路提取多尺度特征;由于Conv3特征图经过两次下采样后分辨率较小,只采用3×3、9×9尺度特征提取分支;对于Conv4特征图则只取3×3尺度特征进行分支提取。各支路感受野如

输入特征图通过多尺度信息整合模块和激励函数,生成像素间注意力分布图。分布图分别与各通道特征图像素对应相乘,得到加权后的特征图。设输入特征图

式中:

2.2.2 通道间注意力模块

不同的特征通道往往具有不同的特征响应,不同的特征响应对于目标任务的影响存在差异。而卷积算子对输入特征图各通道的处理是等权重的,这与实际情况不相符。引入通道间注意力模块,实现通道间差异化处理,可以增大任务有利的特征通道权值,降低无用的特征通道权值,从而减弱无关信息干扰。本研究选用文献[

18]提出的挤压-激励(SE)模块作为通道间注意力模块,如

式中:

激励操作是采用全连接对全局信息描述符进行仿射变换,全面捕获通道依赖性,过程可表示为

式中:

最后,将得到的通道间权向量与各通道对应相乘,输出为

式中:

2.2.3 双注意力模块融合

由于两类注意力模块输出的权值均在0到1之间,直接采用串联方式将结果进行融合,会减小像素间灰度值差异,弱化特征响应,造成信息损失。为避免这个问题,本研究采用并联方式融合两类注意力模块。首先,让两类注意力模块分别对输入特征图进行处理,得到两类注意力加权特征图,然后采用concatenate操作对结果进行通道堆叠,最后用1×1卷积将两类结果进行整合,并使用L2 Normalize对输出层进行标准化。

2.3 循环卷积模块

对高层语义特征直接进行反卷积预测得到的显著图中会存在模糊现象。采取跨层连接,引入底层特征能明显改善显著图细节表示能力,但仍存在边界模糊现象。为进一步提升预测图质量,受人类“凝视”视觉机制启发,在模型后端引入循环卷积模块,以时间迭代来增强空间分辨能力,细化目标区域边缘。

文献[

19]首先提出循环卷积层(RCL),文献[

20-21]将其引入显著性目标检测,用于分层细化预测图,提升了显著性目标检测分割效果。基于RCL,设计多特征循环卷积模块(MFRCM),遵循Inception思想改造卷积循环单元,聚合多尺度感受野特征;同时添加外部循环机制,结合多卷积层特征,将解码器最后一层输出与编码器底层卷积特征作为输入,输出边缘效果更好的预测图。模块内部结构如

MFRCM将循环连接引至卷积层之间,以Inception卷积层为循环单位,逐步提取特征信息。随循环步骤

式中:

式中

式中:

在原RCL基础上,添加外部循环机制,将上一轮MFRCM的输出值作为下一轮外部循环的输入值。连接示意图如

3 实验与结果分析

3.1 数据集与评价准则

3.1.1 数据集介绍

在常用公开数据集ESSCD[22]、HKU-IS[23]和DUT-OMRON[24]上进行算法训练与验证。ESSCD数据集包含1000张语义结构复杂的图像。HKU-IS数据集包含4447张含有多个显著目标的图像。DUT-OMRON数据集包含对比度低、尺寸变化大的自然图像5168张,是一个十分具有挑战性的数据集。分别从ECSSD数据集、HKU-IS数据集和DUT-OMRON数据集随机抽取532张、2000张、2668张图像构成算法的训练集,共5200张。从剩余图像中抽取218张、1000张、1000张构成验证集,共2218张。其余图像用作测试集:ECSSD-250,HKU-IS-1447,DUT-OMRON-1500。

3.1.2 评价准则

选取PR(precision-recall)曲线、ROC(receiveroperating characteristic)曲线、

单独使用准确率或召回率不能判断算法的优劣,

式中

式中:

式中:

3.2 算法实现细节

采用深度学习框架pytorch-0.4进行神经网络搭建,实验环境为Windows 10,使用NVIDA TITAN X GPU进行神经网络训练与测试。采用二值交叉熵(BCE)损失函数作为预测值与目标之间误差的度量准则。设

网络训练时使用多阶段约束方案,约束输出值域范围,总损失函数

式中:

所提算法使用U-Net语义分割模型卷积层权重作为预训练参数进行训练,使用随机梯度下降优化器进行优化,其中初始学习率设置为0.001,动量设置为0.9,权重衰减设置为0.0001,学习率衰减采用基于轮次下降的策略,每200个轮次降为原来的0.1。循环卷积模块中LRN的超参数设置

3.3 实验结果比较与分析

将所提出的算法与6种流行的基于卷积神经网络的显著性目标检测算法进行对比实验:SRM[26],AMU[27],UCF[28],KSR[29],MDF[23],DSS[10]。对比算法的评测数据,均来自算法作者公布的显著结果图和相关的模型参数。

3.3.1 主观视觉对比

为比较所提出的算法与对比算法在不同情况下的目标检测效果,选择6组算法效果图作为主观视觉对比(见

3.3.2 客观量化对比

根据选择的客观评测准则对7种算法进行量化对比。

表 1. 客观量化指标对比

Table 1. Comparison of objective quantitative indicators

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 7. 不同算法在ECSSD-250测试集下的特征曲线。(a) PR曲线;(b) ROC曲线

Fig. 7. Characteristic curves of seven algorithms on ECSSD-250 testset. (a) PR curves; (b) ROC curves

图 8. 不同算法在HKU-IS-1447测试集下的特征曲线。(a) PR曲线;(b) ROC曲线

Fig. 8. Characteristic curves of seven algorithms on HKU-IS-1447 testset. (a) PR curves; (b) ROC curves

图 9. 7种算法在DUT-OMRON-1500测试集下的特征曲线。(a) PR曲线;(b) ROC曲线

Fig. 9. Characteristic curves of seven algorithms on DUT-OMRON-1500 testset. (a) PR curves; (b) ROC curves

3.3.3 算法运行时间及参数量对比

表 2. 各算法的运行时间

Table 2. Running time of different algorithms

|

表 3. 算法参数量统计

Table 3. Parameters statistics of different algorithms

|

4 结论

本研究提出一种双注意力循环卷积显著性目标检测算法。算法在U-Net骨干网络中引入像素间-通道间双注意力模块,对跨层连接的特征进行重加权处理,提高特征利用的有效性。其中使用空洞卷积设计像素间注意力模块,采用三路特征提取分支模拟感受野机制,有效整合多尺度上下文信息,实现像素间加权。采用多特征循环卷积层将U-Net解码端输出与编码端卷积特征进行结合处理,增强输出显著图边缘表示效果。实验表明,所提算法在多显著性目标检测和细节检测能力上表现良好,在三个测试集上的客观量化指标性能优于其他6类对比算法。但由于骨干网络的最大池化层会造成信息量丢失,影响预测图重构质量,下一步工作是改进编码器网络,提取适合显著性检测的特征,同时优化模型结构与参数,进一步改善运行速度。

[3] Guo CL, MaQ, Zhang LM. Spatio-temporal saliency detection using phase spectrum of quaternion Fourier transform[C]∥2008 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), June 23-28, 2008, Anchorage, AK, USA. New York: IEEE, 2008: 4587715.

[4] CourtyN, MarchandE. Visual perception based on salient features[C]∥Proceedings 2003 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2003), October 27-31, 2003, Las Vegas, Nevada, USA. New York: IEEE, 2003: 1024- 1029.

[6] 刘冬梅, 常发亮. 基于非下采样轮廓小波变换增强的从粗到精的显著性检测[J]. 光学学报, 2019, 39(1): 0115003.

[7] 李德峰, 刘松涛. 基于特征融合的图像目标显著性检测方法[J]. 半导体光电, 2018, 39(6): 898-902, 908.

[8] 刘峰, 沈同圣, 娄树理, 等. 全局模型和局部优化的深度网络显著性检测[J]. 光学学报, 2017, 37(12): 1215005.

[9] 张松龙, 谢林柏. 基于全部卷积特征融合的显著性检测[J]. 激光与光电子学进展, 2018, 55(10): 101502.

[10] Hou QB, Cheng MM, Hu XW, et al. Deeply supervised salient object detection with short connections[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI. New York: IEEE, 2017: 5300- 5309.

[11] Xie SN, Tu ZW. Holistically-nested edge detection[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1395- 1403.

[12] RonnebergerO, FischerP, BroxT. U-net: convolutional networks for biomedical image segmentation[M] ∥Navab N, Hornegger J, Wells W, et al. Medical image computing and computer-assisted intervention-MICCAI 2015. Lecture notes in computer science. Cham: Springer, 2015, 9351: 234- 241.

[13] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[14] Zhang XN, Wang TT, Qi JQ, et al. Progressive attention guided recurrent network for salient object detection[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT. New York: IEEE, 2018: 714- 722.

[15] Kim HJ, DunnE, Frahm JM. Learned contextual feature reweighting for image geo-localization[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI. New York: IEEE, 2017: 3251- 3260.

[16] Liu ST, HuangD, Wang YH. Receptive field block net for accurate and fast object detection[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11215: 404- 419.

[17] SzegedyC, IoffeS, VanhouckeV, et al.Inception-v4, inception-resnet and the impact of residual connections on learning[C]∥31st AAAI Conference on Artificial Intelligence, February 4-10, 2017, San Francisco.California: AAAI Press, 2017: 4278- 4284.

[18] HuJ, ShenL, SunG. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT. New York: IEEE, 2018: 7132- 7141.

[19] LiangM, Hu XL. Recurrent convolutional neural network for object recognition[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3367- 3375.

[20] LiuN, Han JW. DHSNet: deep hierarchical saliency network for salient object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 678- 686.

[21] Tang YB, Wu XQ, BuW. Deeply-supervised recurrent convolutional neural network for saliency detection[C]∥The 24th ACM International Conference on Multimedia, October 15-19, 2016, Amsterdam, Netherlands. USA: ACM, 2016: 397- 401.

[22] YanQ, XuL, Shi JP, et al. Hierarchical saliency detection[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 1155- 1162.

[23] Li GB, Yu YZ. Visual saliency based on multiscale deep features[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 5455- 5463.

[24] YangC, Zhang LH, Lu HC, et al. Saliency detection via graph-based manifold ranking[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3166- 3173.

[25] AchantaR, HemamiS, EstradaF, et al. Frequency-tuned salient region detection[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 1597- 1604.

[26] Wang TT, BorjiA, Zhang LH, et al. A stagewise refinement model for detecting salient objects in images[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice. New York: IEEE, 2017: 4019- 4028.

[27] Zhang PP, WangD, Lu HC, et al. Amulet: aggregating multi-level convolutional features for salient object detection[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice. New York: IEEE, 2017: 202- 211.

[28] Zhang PP, WangD, Lu HC, et al. Learning uncertain convolutional features for accurate saliency detection[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice. New York: IEEE, 2017: 212- 221.

[29] Wang TT, Zhang LH, Lu HC, et al. Kernelized subspace ranking for saliency detection[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9912: 450- 466.

Article Outline

谢学立, 李传祥, 杨小冈, 席建祥. 双注意力循环卷积显著性目标检测算法[J]. 光学学报, 2019, 39(9): 0915005. Xueli Xie, Chuanxiang Li, Xiaogang Yang, Jianxiang Xi. Salient Object Detection Algorithm Based on Dual-Attention Recurrent Convolution[J]. Acta Optica Sinica, 2019, 39(9): 0915005.