一种基于多尺度低秩分解的红外与可见光图像融合方法  下载: 1178次

下载: 1178次

1 引言

可见光、红外传感器技术在信息解译、目标探测等各领域发挥着重要作用,然而单一可见光、红外传感器仅从单方面获取信息,存在一定的片面性,如:红外传感器在复杂的环境下,能够识别热辐射信息,但对场景中的光照亮度不敏感,导致所成图像对比度较低,分辨率较差,细节纹理信息较少[1];而可见光传感器可以检测光谱反射特性,并且可以在正常光照条件下获得场景的细节纹理信息,图片清晰,信息量较丰富,但不能识别被遮挡和伪装的目标[2]。因此,对红外与可见光图像进行融合处理,可充分利用两者优势,融合得到同时具有可见光丰富的光谱、纹理信息以及红外图像热辐射信息的图像。

红外与可见光图像融合的关键在于如何从源图像中提取特征,并设计合理的融合规则进行融合处理。目前,已提出多种红外与可见光图像融合方法,主要包括多尺度分解的融合方法[3]、基于稀疏表示融合方法[4]、基于神经网络融合方法[5]、基于子空间融合方法[6]等。近年来基于深度学习的方法[7-8]得到了一定程度上的应用,但深度学习模型的训练对硬件要求较高,且需要耗费大量时间。当前,基于多尺度分解的融合方法应用最为广泛,其基本思想为:首先,对红外和可见光源图像分别进行分解,得到低频和高频信息;其次,根据相应的融合规则对低频和高频信息分别进行融合;最后,利用融合后的高、低频段进行相应的逆变换,得到最终的融合图像。传统基于多尺度分解方法主要有基于金字塔分解的融合方法[9],基于小波[10]、曲波分解[11]的融合方法,基于轮廓波分解[12]的融合方法等。近年来,在传统多尺度分解图像融合方法的基础上,国内外学者又对这些方法做了大量创新和改进,如引导滤波器[13]、四阶偏微分方程分解[6]等基于边缘保持滤波的融合方法。此外,吴一全等[14]提出了一种基于目标提取与引导滤波增强的红外与可见光图像融合方法,该方法在融合之前首先对红外目标进行目标提取,但融合结果中显著性目标的边缘不够自然。Bavirisetti等[15]提出了一种基于二尺度分解和显著性检测的融合方法,利用均值滤波和中值滤波提取基础层和细节层,并利用视觉显著性获得融合权重图,但该方法在图像分解时对特征提取不全面。

低秩分解于近几年被引入红外与可见光图像融合领域,现阶段使用的分解模型大多是基于Liu提出的低秩表示(LRR)理论[16],但是这种表示方法不能很好地保留区域结构信息。因此,2011年Liu又提出潜在低秩表示(LatLRR)理论[17],这种方法能够在一定程度上从原始数据中获取全局和局部的结构信息,Li在LatLRR分解理论的基础上提出了基于LatLRR理论的红外与可见光图像融合方法[18],提高了融合精度。

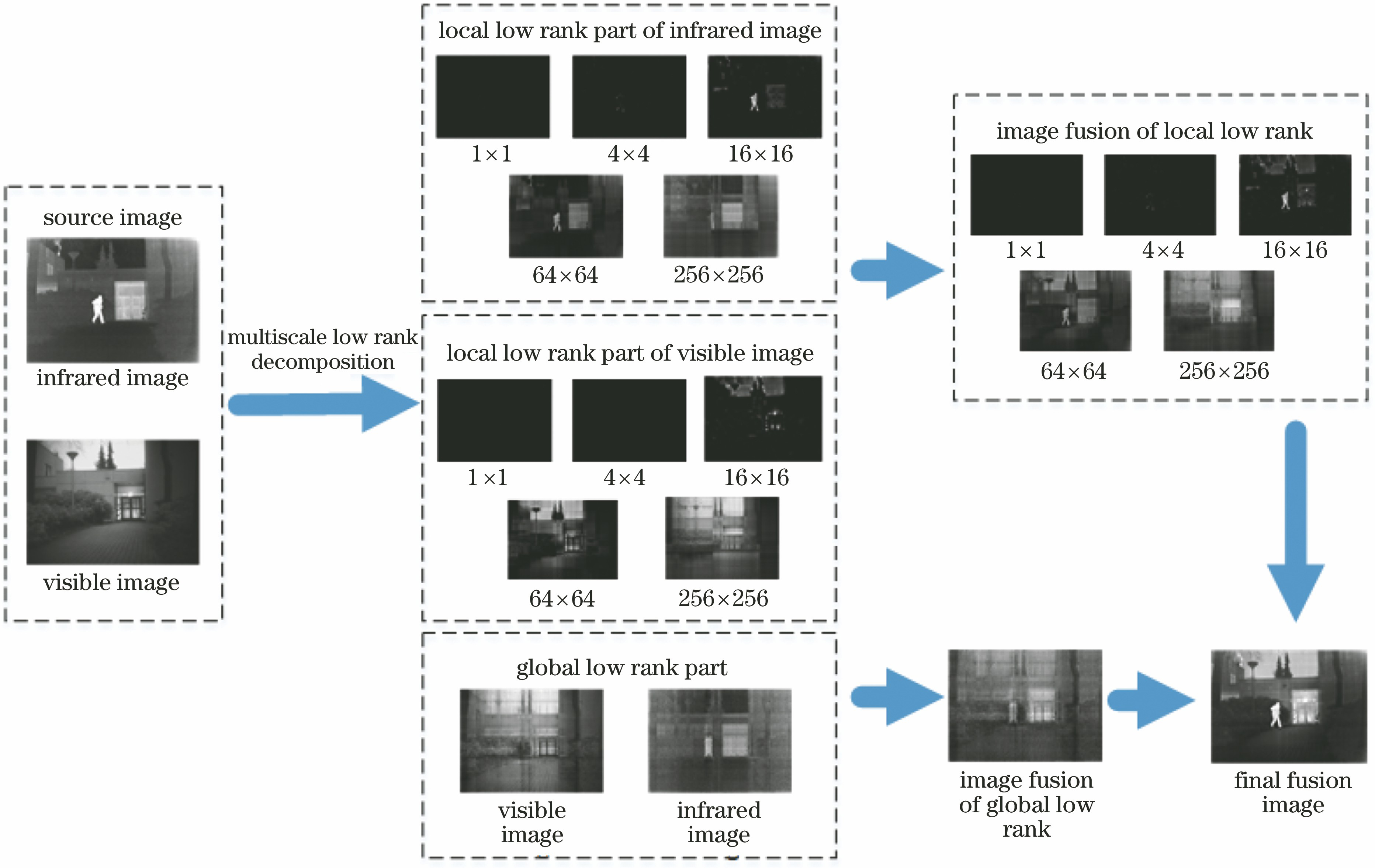

总体来说,上述基于多尺度分解的融合方法往往采用两层分解方式,即通过一种低通滤波器得到基础层低频信息,再通过与原图相减得到细节层。然而,由于上述两层分解方式对红外和可见光图像中的空间细节信息提取不充分,且图像中的显著性区域在分解图像中得不到完整体现,导致融合图像容易出现模糊、图像视觉信息大量丢失等。尽管LatLRR方法在一定程度上分解提取了源图像显著性区域和低秩区域,但分解得到的显著性图和低秩图存在分解不彻底且互相包含,导致融合结果往往存在对比度低、热红外目标不明显、细节与纹理不够清晰等问题。结合多尺度分解和低秩分解理论各自的优点,本文提出基于多尺度低秩分解的红外与可见光图像融合方法,对原始红外与可见光图像进行多尺度低秩分解,得到多层次局部低秩图和全局低秩图,并对不同尺度下的显著性图和低秩图有针对性地设计最优融合策略,从而更加全面地保留源图像的细节纹理信息和显著性信息,有效地提高融合结果的目视效果和定量精度。

2 融合方法的理论基础

本文提出了一种基于多尺度低秩分解的红外与可见光图像融合方法。其基本思想为:基于图像的局部相关性特点,采用多尺度低秩分解方法将红外、可见光图像分别分解为多层次低秩图,主要包括局部低秩图(显著图)和全局低秩图,对不同层次的显著图和全局低秩图,充分考虑各分解层图像的特点,有针对性地设计最优融合规则,最终重建得到具有高对比度、细节与纹理清晰的融合图像,其框架如

2.1 多尺度低秩分解方法

基于图像的局部相关性特点,采用多尺度低秩分解方法[19]对红外图像和可见光图像进行分解。为表示方便,以Y表示待分解图像,多尺度低秩分解模型示意图如

该模型将输入图像Y划分为由不同大小低秩块分解组成的图像矩阵T1,T2,…,TL,包括局部低秩图T1,T2,…,TL-1和全局低秩图TL,分解模型表示为

式中:Ti为采用不同大小低秩块分解得到的多尺度低秩分解图像;Ub,Sb,Vb是矩阵经奇异值分解(SVD)法分解的形式;

其中ceiling(·)代表向上取整。

图 3. Nato_camp场景红外图像分解示意图

Fig. 3. Schematic diagram of infrared image decomposition in Nato_camp

因此,通过多尺度低秩分解可更加充分地提取图像显著特征和纹理特征,并可针对各层次分解图像特点,有针对性地设计最优融合规则,这样不仅可减少融合结果可能存在的人工伪影和斑块,也可同时完整地保留红外和可见光图像的显著性特征和细节纹理信息。

2.2 融合策略

2.2.1 多层次局部低秩图(显著图)融合策略

图像分解得到的多层次局部低秩图为显著图,如

1) 对于较小低秩块分解得到的显著图,红外和可见光图像表现出较强的互补性,需要将他们完全保留,同时又不产生任何伪影和损失,因此本文基于求和融合策略来融合该部分图像(本文采用图像块大小为1×1、4×4、16×16分解得到的图像),表示为

式中:Fi(x,y)、Tr_i(x,y)、Tv_i(x,y)分别表示融合图像、红外显著图像、可见光显著图像对应位置的像素值。

为验证采用求和融合策略的合理性,基于Nato_camp场景图像,采用大小为16×16低秩块分解得到的红外和可见光图像(即Tv_3和Ti_3),如

图 4. 红外与可见光图像显著图示例(基于16×16低秩块分解得到)。(a)红外图像显著性部分Tv_3; (b)可见光图像显著性部分Tr_3; (c)红外和可见光图像同行位置灰度分布图

Fig. 4. Saliency images examples of infrared and visible images obtained by 16×16 low-rank block decomposition. (a) Saliency part of the infrared image Tv_3; (b) saliency part of the visible image Tr_3; (c) pixel distribution of infrared and visible images in the same line

使用求和融合策略,融合后的图像如

图 5. 基于16×16低秩块分解图像融合结果示意图。(a)融合结果F3;(b)融合图像灰度分布图

Fig. 5. Image fusion results based on 16×16 low rank block decomposition. (a) Fused image F3; (b) pixel distribution of the fused image

2) 由红外和可见光图像分解得到的不同尺度的显著图具有不同的特点。对于较大低秩块(3<i<L)分解得到的显著图像,如

式中:3<i<L;Wi(x,y)为最大绝对值方法权重系数;Tv_i(x,y),Tr_i(x,y)分别为可见光与红外图像的第i层多尺度低秩分解图像对应的像素值。为了减小噪声,使用高斯滤波器来平滑权重Wi,即

式中:Wd_i是Wi经过高斯滤波平滑后的结果;σs为高斯滤波的标准差,通常设σs=2。然后,通过最大绝对值准则,得到该部分分解图像的融合结果Fi为

综上可知,基于最大绝对值加权融合方式可以更好地保留大尺度显著部分的显著性信息和部分的纹理信息,能够更好地融合红外、可见光图像的互补特征。

2.2.2 全局低秩图融合策略

源图像的全局低秩部分包含了更多的全局结构信息和纹理信息。因此,为了避免复杂融合策略给个别融合图像带来人工伪影和斑块,在融合方法中,使用加权平均策略来获得融合后的低秩部分。融合策略的表达式为

式中:(x,y)表示像素位置;wr、wv分别代表对应红外图像和可见光图像相应的融合权重。为了更好地保留图像的全局结构信息和纹理信息,减少不必要的冗余信息以及复杂融合方法所带来的人工伪影,本文选取wr=0.5、wv=0.5。

2.2.3 重建

基于上述得到的不同层次局部低秩图融合结果和全局低秩图融合结果,重建最终融合图像,最终的融合图像可表示为

3 实验结果和分析

本研究所有实验都在2.8 GHz Intel(R) Core(TM) CPU 8 GB RAM下的MATLAB R2016a环境中进行。将通过主观和客观评价方法来评估本文的融合方法。

3.1 实验数据与参数设置

选取25幅不同场景的图像进行测试,其中测试图像大部分来自TNO红外/可见光图像数据库,少部分来自文献[ 6]。根据数据库中图像的大小设置多尺度低秩分解层数为6层,即L=6,每一个分解层低秩块的大小分别为1×1、4×4、16×16、64×64、256×256、M×N,其中M、N分别代表输入图像的高和宽。实验发现1000次左右的迭代对于多尺度分解应用来说已足够,实验次数超过1000次对分解结果没有产生明显的影响。因此,本文选择的实验迭代次数为1024次。

3.2 实验结果与分析

3.2.1 融合图像主观评价和分析

主观评价中,选取比较具有代表性的4个场景Nato_camp、Bunker 、Kaptein_1123、street的红外与可见光图像进行比较,所有的图像都已提前实现图像配准。同时选用近些年来提出的红外与可见光图像融合方法进行比较,分别是基于ResNet50[7]、CNN[20]、MISF[21]、GTF[22]、FPDE[6]的融合方法。

从实验结果可以看到,基于GTF的融合图像中,目标信息比较明显,但是可见光的细节和纹理信息保留得较差,红外图像中的融合结果类似,可见光图像信息保留得较少;基于ResNet50和FPDE的融合图像,普遍存在红外目标信息不突出的问题;基于CNN、MISF的融合图像在部分场景中存在明显的斑块现象,且显著性目标和纹理信息不能同时得到很好地保留。如:在Nato_camp场景的图像中,

图 6. Nato_camp场景融合结果。(a)可见光图像; (b)红外图像; (c) ResNet50方法; (d) CNN方法; (e) MISF方法; (f) GTF方法; (g) FPDE方法; (h)本文方法

Fig. 6. Fusion results in Nato_camp. (a) Visible image; (b) infrared image; (c) ResNet50 method; (d) CNN method; (e) MISF method; (f) GTF method; (g) FPDE method; (h) proposed method

图 7. Bunker场景融合结果。(a)可见光图像; (b)红外图像; (c) ResNet50方法; (d) CNN方法;(e) MISF方法;(f) GTF方法; (g) FPDE方法; (h)本文方法

Fig. 7. Fusion results in Bunker. (a) Visible image; (b) infrared image; (c) ResNet50 method; (d) CNN method; (e) MISF method; (f) GTF method; (g) FPDE method; (h) proposed method

图 8. Kaptein_1123场景融合结果。(a)可见光图像;(b)红外图像;(c) ResNet50方法;(d) CNN方法;(e) MISF方法;(f) GTF方法;(g) FPDE方法;(h)本文方法

Fig. 8. Fusion results in Kaptein_1123. (a) Visible image; (b) infrared image; (c) ResNet50 method; (d) CNN method; (e) MISF method; (f) GTF method; (g) FPDE method; (h) proposed method

图 9. Street场景融合结果。(a)可见光图像;(b)红外图像;(c) ResNet50方法;(d) CNN方法;(e) MISF方法;(f) GTF方法;(g) FPDE方法;(h)本文方法

Fig. 9. Fusion results in street. (a) Visible image; (b) infrared image; (c) ResNet50 method; (d) CNN method; (e) MISF method; (f) GTF method; (g) FPDE method; (h) proposed method

3.2.2 融合图像定量评价和分析

除了主观评价之外,为了对该方法与其他融合方法进行定量比较,还采用了5 种图像质量客观评价指标来评价和比较不同算法的融合效果,包括

表 1. 融合图像的客观评价结果

Table 1. Quantitative evaluation results of fused images

|

从实验结果可以看出,本文方法有更高的SSIM值,这表明该方法得到的融合图像和原图像相似程度高,图像更自然,包含的人工伪影等干扰信息更少。本文方法的融合图像在EN、SD和SF三个指标上也有较大的优势,虽然在部分场景的图像上基于ResNet50和MISF的融合方法在这三个指标上优于本文方法,但是从图像上可以看出,基于MISF方法的融合结果有较大的斑块和噪声,基于ResNet50的方法显然没有保留红外显著性信息,而本文方法的融合图像在保留显著区域的同时能够保留可见光的细节和纹理信息。与此同时,融合图像基本没有斑块和人工伪影,视觉效果更好,适合各种场景的信息,融合方法的鲁棒性高。QAB/F代表了图像的边缘信息的保留程度,本文方法的指标要低于基于MISF的融合方法,但在主观上评价上,本文的方法有更好的视觉效果,边缘保留完整、图像对比度较高,相比近年来的图像融合方法有一定程度的改善。通过25幅不同场景的图像实验结果表明,本文算法适用于各种场景的红外与可见光图像融合,其主观与客观质量评价结果都有一定程度的改善。

4 结论

针对传统红外与可见光图像融合方法往往存在场景对比度低、热红外目标不明显、细节与纹理不够清晰等问题,提出一种基于多尺度低秩分解的红外与可见光图像融合算法。基于多尺度低秩分解将源图像分解为多层次、多尺度显著性图和低秩图,并根据各分解层图像特点,有针对性地设计最优融合规则。基于公开的TNO数据库图像进行实验,并从定性和定量两方面进行综合评价。实验结果表明,本文算法不仅具有较好的视觉效果,同时融合精度较高,融合图像在不引入人工伪影和斑块的同时,能够保留源图像细节信息,增强显著目标区域,有利于后续目标识别、检测等应用的开展。

[1] Han J, Bhanu B. Fusion of color and infrared video for moving human detection[J]. Pattern Recognition, 2007, 40(6): 1771-1784.

[2] Ma J Y, Ma Y, Li C. Infrared and visible image fusion methods and applications: a survey[J]. Information Fusion, 2019, 45: 153-178.

[3] Dogra A, Goyal B, Agrawal S. From multi-scale decomposition to non-multi-scale decomposition methods: a comprehensive survey of image fusion techniques and its applications[J]. IEEE Access, 2017, 5: 16040-16067.

[4] Zhang Q, Liu Y, Blum R S, et al. Sparse representation based multi-sensor image fusion for multi-focus and multi-modality images: a review[J]. Information Fusion, 2018, 40: 57-75.

[5] 周哓玲, 江泽涛. 结合脉冲耦合神经网络与引导滤波的红外与可见光图像融合[J]. 光学学报, 2019, 39(11): 1110003.

[6] Bavirisetti DP, XiaoG, LiuG. Multi-sensor image fusion based on fourth order partial differential equations[C]∥2017 20th International Conference on Information Fusion (Fusion), July 10-13, 2017, Xi'an, China. New York: IEEE, 2017: 17102397.

[7] Li H, Wu X J, Durrani T S. Infrared andvisible image fusion with ResNet and zero-phase component analysis[J]. Infrared Physics & Technology, 2019, 102: 103039.

[8] 马旗, 朱斌, 张宏伟. 基于VGG网络的双波段图像融合方法[J]. 激光与红外, 2019, 49(11): 1374-1380.

Ma Q, Zhu B, Zhang H W. Dual-band image fusion method based on VGGNet[J]. Laser & Infrared, 2019, 49(11): 1374-1380.

[9] Matsopoulos G K, Marshall S. Application of morphological Pyramids: fusion of MR and CT phantoms[J]. Journal of Visual Communication and Image Representation, 1995, 6(2): 196-207.

[10] Qu G H, Zhang D L, Yan P F. Medical image fusion by wavelet transform modulus maxima[J]. Optics Express, 2001, 9(4): 184-190.

[11] Nencini F, Garzelli A, Baronti S, et al. Remote sensing image fusion using the curvelet transform[J]. Information Fusion, 2007, 8(2): 143-156.

[14] 吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001.

[15] Bavirisetti D P, Dhuli R. Two-scale image fusion of visible and infrared images using saliency detection[J]. Infrared Physics & Technology, 2016, 76: 52-64.

[16] LiuG, LinZ, YuY. Robust subspace segmentation by low-rank representation[C]∥The 27th International Conference on Machine Learning, June 21-24, 2010, Haifa, Israel. New York: ACM, 2010: 663- 670.

[17] Liu GC, Yan SC. Latent low-rank representation for subspace segmentation and feature extraction[C]∥2011 International Conference on Computer Vision, November 6-13, 2011. Barcelona, Spain. New York: IEEE, 2011: 1615- 1622.

[19] Ong F, Lustig M. Beyond low rank+sparse:multiscale low rank matrix decomposition[J]. IEEE Journal of Selected Topics in Signal Processing, 2016, 10(4): 672-687.

[20] Liu Y, Chen X, Peng H, et al. Multi-focus image fusion with a deep convolutional neural network[J]. Information Fusion, 2017, 36: 191-207.

[21] Zhan K, Kong L W, Liu B, et al. Multimodal image seamless fusion[J]. Journal of Electronic Imaging, 2019, 28(2): 023027.

[22] Ma J Y, Chen C, Li C, et al. Infrared and visible image fusion via gradient transfer and total variation minimization[J]. Information Fusion, 2016, 31: 100-109.

[23] Xydeas C S, Petrovic V. Objective image fusion performance measure[J]. Electronics Letters, 2000, 36(4): 308-309.

陈潮起, 孟祥超, 邵枫, 符冉迪. 一种基于多尺度低秩分解的红外与可见光图像融合方法[J]. 光学学报, 2020, 40(11): 1110001. Chaoqi Chen, Xiangchao Meng, Feng Shao, Randi Fu. Infrared and Visible Image Fusion Method Based on Multiscale Low-Rank Decomposition[J]. Acta Optica Sinica, 2020, 40(11): 1110001.