基于双目视觉的深度图拼接  下载: 1350次

下载: 1350次

1 引言

双目立体视觉利用双摄像机模拟人眼成像[1],利用视差原理得到三维空间中物体的轮廓尺寸及位置。传统的双目深度传感器只能在重叠区域获得深度图,具有视场小的不足,通过深度图像拼接的方法可以得到大视场的深度图,可有效扩大双目深度传感器的视场角[2],具有很高的应用研究价值,可广泛应用于机器人、虚拟现实、机械制造、三维测量、生物医学、考古勘探等领域。

图像拼接一般通过图像获取、图像配准及图像融合来完成。其中图像配准最为关键,涉及特征提取与匹配[3]。常见的特征提取方法有Harris角点算法、加速稳健特征(SURF)算法、快速特征点提取/描述(ORB)算法和尺度不变特征变换(SIFT)算法等[4]。由于Harris角点对尺度的敏感性,基于Harris角点的特征提取方法稳定性不高。SURF特征提取方法的计算速度优于SIFT算法的,但是在进行丰富纹理图像拼接时效果稍逊于SIFT算法的。Rublee等[5]提出的ORB算法在保证尺度和旋转不变性的前提下,通过角点检测(FAST)使特征提取速度有了大幅度的提升,但是在丰富纹理的特征匹配时效果远不如SIFT算法的。Lowe[6]提出的SIFT特征提取方法具有尺度不变性和特征描述精准的优势,虽然耗时较长,但是在一些需要高精度而对实时性要求不高的场合仍有很大的应用空间。基于摄像机旋转的深度图像拼接方法[7]与传统的图像拼接方法原理基本一致,不适用于摄像机一般性运动后的拼接。

为了克服传统双目深度传感器视场小的缺点,提出了一种基于双目视觉的深度图像拼接方法。考虑到左目彩色图与深度图一一对应,在保证一定重叠区域的前提下自由移动双目深度传感器,采集移动前后的彩色图及深度图。以彩色图进行特征提取及匹配,并计算出单应性矩阵,以此单应性矩阵对深度图像进行拼接,并结合空间位置关系对深度图的深度值进行了矫正,最终得到了大视场的深度图拼接结果。

2 双目深度图的拼接算法原理

2.1 双目深度图的获取

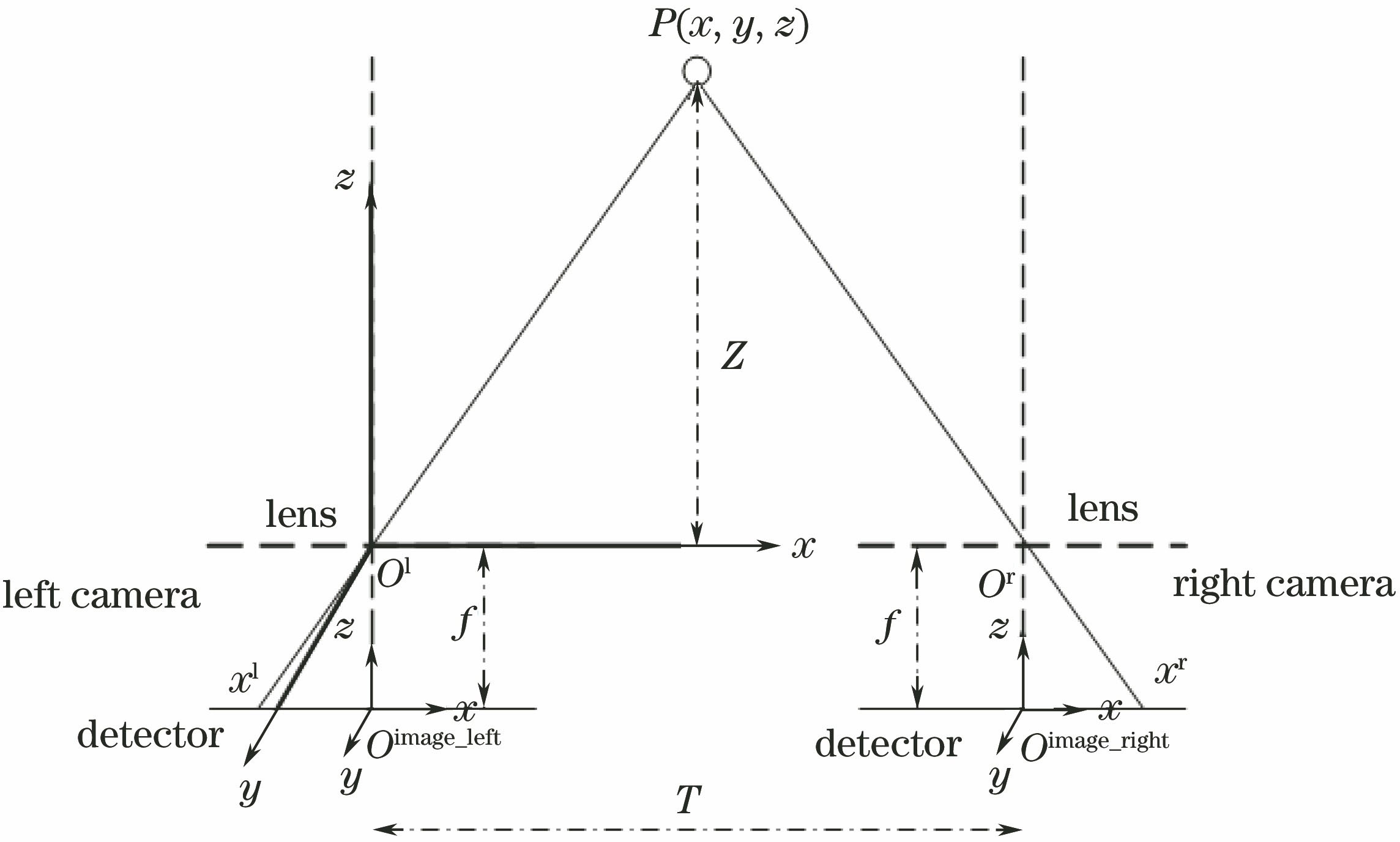

两个完全相同的摄像机平行放置,测距原理[8]如

经过数学计算可得

将(1)、(2)式代入

采用张正友标定法[9]对双目摄像机进行联合标定,并根据标定结果对左、右摄像机进行极线校正和畸变校正,使左右相机对应的像素点处于同一水平线。采用绝对误差和(SAD)算法进行立体匹配,计算公式为

式中

2.2 双目深度图的拼接

单应性变换原理[10]如

2.3 双目深度图的矫正

传统的图像拼接仅需将移动后的图像投影到移动前的图像像面就能得到最终的结果[12]。而深度图的像素值具有不同于一般彩色图的意义,深度图的灰度值代表物体的深度值,即空间物体到垂直于相机光轴的过镜头光心的平面的垂直距离。考虑到移动前后双目传感器的空间位置发生了变化,提出了一种基于单应性矩阵的深度图矫正方法。具体原理图如

式中

式中

将(6)式代入(5)式得到

故

式中Δ

根据几何关系可得

根据(9)式对

3 理论仿真与实验

3.1 理论仿真

用Matlab进行理论仿真,如

考虑到

仿真实验结果表明,通过图像拼接获得的单应性矩阵能够反映对应点空间位置间的关系,为深度矫正提供了理论基础。

3.2 双目摄像机的标定与畸变校正

以可变基线USB3.0双目视觉相机作为双目深度传感器,所用镜头为2.8 mm广角镜头,所用单目图像大小为640 pixel×480 pixel。采用张正友标定法对双目视觉模块进行标定,所用棋盘格标定板的方格尺寸为30 mm×30 mm。

图 6. 双目测距模块移动前后的实物图。(a)移动后;(b)移动前

Fig. 6. Real maps of binocular ranging module before and after moving. (a) After moving; (b) before moving

3.3 双目深度图的获取

对双目传感器采集到的图像进行畸变校正、极限矫正、立体匹配后得到深度图。双目传感器移动后与移动前的位置分别如

图 7. 移动前后的彩色图及深度图。(a)移动前左目彩色图;(b)移动后左目彩色图;(c)移动前深度图;(d)移动后深度图

Fig. 7. Color images and depth maps before and after moving. (a) Left-view color image before moving; (b) left-view color image after moving; (c) depth map before moving; (d) depth map after moving

3.4 双目深度图的拼接及深度矫正结果的评价

对彩色图像进行特征点提取与匹配,计算出单应性矩阵,根据此单应性矩阵对彩色图进行拼接,得到彩色图的拼接结果,并以此单应性矩阵对深度图进行拼接与深度矫正,结果如8所示。

图 8. 拼接结果。(a)彩色图;(b)深度图;(c)矫正后的深度图

Fig. 8. Stitching results. (a) Color image; (b) depth map; (c) depth map after correction

图 9. 不同像素高度下的深度矫正折线图。(a) 220;(b) 280;(c) 360;(d) 420

Fig. 9. Depth correction images under different pixel heights. (a) 220; (b) 280; (c) 360; (d) 420

拼缝在485 pixel处,可以发现

表 1. 矫正前后的fPSNR

Table 1. fPSNR before and after correction

|

4 结论

提出了一种基于双目视觉的深度图拼接方法,并进行了理论仿真与实验。所提方法具有普适性和实用价值,能有效地扩大双目深度传感器的视场,得到的拼接图像与单传感器图像基本相同。推导了投影变换前后深度值变换与单应性矩阵之间的关系,通过仿真和实验结果验证了所推导公式的正确性。

[1] 王珊, 徐晓. 基于双目单视面的三维重建[J]. 光学学报, 2017, 37(5): 0515004.

Wang S, Xu X. 3D reconstruction based on horopter[J]. Acta Optica Sinica, 2017, 37(5): 0515004.

[2] 李小妹. 基于深度图像的拼接技术研究与实现[D]. 成都: 电子科技大学, 2013.

Li XM. Research and implementation of mosaic technology based on depth images[D]. Chengdu: University of Electronic Science and Technology of China, 2013.

[3] 张鑫, 靳雁霞, 薛丹. SICA-SIFT和粒子群优化的图像匹配算法[J]. 激光与光电子学进展, 2017, 54(9): 091002.

[4] 刘丽, 匡纲要. 图像纹理特征提取方法综述[J]. 中国图象图形学报, 2009, 14(4): 622-635.

[7] Cho S I, Kim J C, Ban K J, et al. 3D panorama generation using depth-map stitching[J]. Journal of Information & Communication Convergence Engineering, 2011, 9(6): 780-784.

[8] 姜雨彤. 双目测距系统及标定方法研究[D]. 长春: 长春理工大学, 2013.

Jiang Y T. Binocular ranging system and calibration method[D]. Changchun: Changchun University of Science and Technology, 2013.

[10] 邹朋朋, 张滋黎, 王平, 等. 基于共线向量与平面单应性的双目相机标定方法[J]. 光学学报, 2017, 37(11): 1115006.

[12] 张春萍, 王庆. 光场相机成像模型及参数标定方法综述[J]. 中国激光, 2016, 43(6): 0609004.

[13] StockmanG, Shapiro LG. Computer vision[M]. Upper Saddle River: Prentice Hall, 2001.

Article Outline

袁瑞峰, 刘明, 惠梅, 赵跃进, 董立泉. 基于双目视觉的深度图拼接[J]. 激光与光电子学进展, 2018, 55(12): 121013. Ruifeng Yuan, Ming Liu, Mei Hui, Yuejin Zhao, Liquan Dong. Depth Map Stitching Based on Binocular Vision[J]. Laser & Optoelectronics Progress, 2018, 55(12): 121013.