结合脉冲耦合神经网络与引导滤波的红外与可见光图像融合  下载: 1063次

下载: 1063次

1 引言

红外与可见光图像融合的目的是提取二者的优势信息,得到具有良好细节信息和目标显著性的融合图像。图像融合算法可分为两大类:基于变换域的融合和基于空间域的融合[1]。基于变换域的融合方法,近年来其研究热点在于改善传统多尺度变换方法[如Laplacian Pyramid (LP)、Principal Component Analysis (PCA)、Wavelet Transform (WT)及Contourlet变换等]中存在的特征提取效率不高、信息冗余等问题,主要有Nonsubsampled Contourlet Transform (NSCT)变换[2]、Nonsubsampled Shearlet Transform (NSST)变换[3]、Nonsubsampled Shearlet Contrast Transform (NSSCT)变换[4]、非下采样双树复轮廓波变换[5-6]等。因多尺度、多方向的分解及逆变换比较耗时,变换域的融合策略普遍存在融合效率不高的问题,基于空间域的融合策略由于直接在像素上进行操作,其执行效率具有一定的优势。基于空间域的融合方法,其中一个研究热点为基于区域的图像融合,融合的关键在于区域划分方法的选取及融合规则的制定[7-8]。考虑到红外和可见光图像目标区域与背景区域具有显著不同的特性,Zhang等[3]基于超像素显著度将原图像划分为目标区域和背景区域,其中目标区域取红外图像灰度值,背景区域经NSST变换,通过对比梯度信息进行系数加权融合;Lu等[9]根据区域统计特性对原图像进行区域划分,在目标区域保留红外图像信息,在背景区域采用核奇异值分解进行融合。上述基于区域的融合方法,将原图划分为背景和目标区域,分别采用不同的融合规则实现图像融合,更好地保留了红外目标区域信息及可见光背景细节。但是,由于其仅仅进行二值区域分割,容易丢失部分细节信息,且直接基于区域划分图进行融合,容易出现伪影,而这个问题也正是基于区域的融合方法普遍存在的。针对这个问题,本文将提出一种基于多区域分割的图像融合方法,并结合引导滤波改善伪影问题。

图像经脉冲耦合神经网络(PCNN)处理得到的点火时间矩阵,可视为从空间纹理分布以及亮度分布上对图像的多区域划分,满足红外与可见光图像融合过程中充分保留红外目标亮度信息和可见光背景纹理特性的要求。本文提出一种结合PCNN与引导滤波的快速融合方法,解决了基于区域的图像融合方法所获得图像细节不够丰富、易出现伪影的问题。为提高算法执行效率,简化PCNN模型,并在脉冲产生单元加入抑制项,抑制已灭火像素的再次激活,同时采用信息熵判定准则及时停止迭代,在确保获得的点火时间矩阵

2 PCNN模型的改进

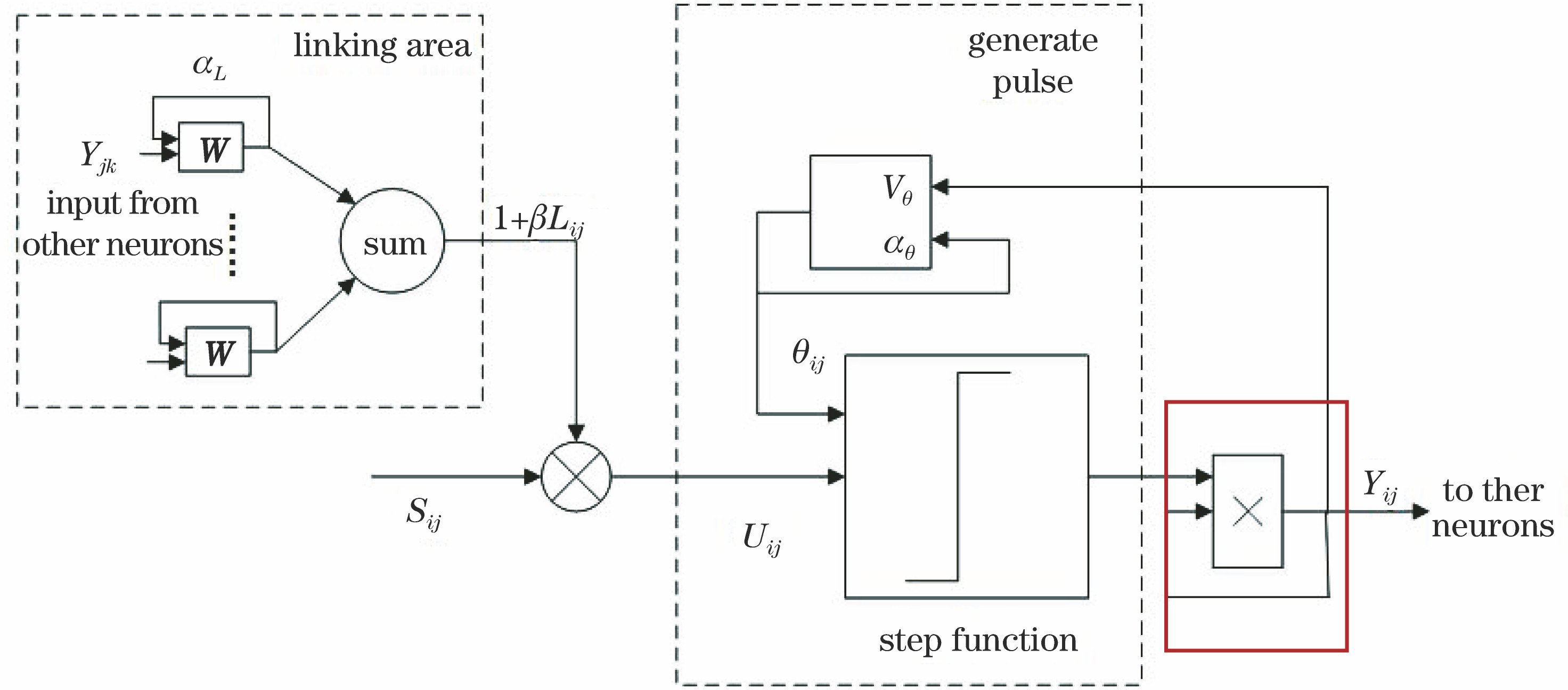

PCNN是由多个神经元以特定的结构互相连接的反馈型单层网络[10],具有三个功能单元:反馈输入域、连接输入域及脉冲产生域。该模型结构充分模拟了哺乳动物视觉系统对图像亮度响应的衰减特性以及脉冲同步发放特性。

在保证能够具备模拟哺乳动物视觉特性的基础上,可省去反馈域的耦合输入部分,同时,为了避免已灭火像素的再次激活干扰点火矩阵的区域划分效果,修正其脉冲产生过程,增加了抑制项:即将上一次脉冲状态与本次脉冲产生单元进行调制。

式中:

传统PCNN模型在step function模块获得的输出即为最终输出,随着模型迭代的进行,灭火的像素会周期地再次点火,且不同像素会存在点火周期混叠的情况,从而导致点火时间矩阵出现噪声和振荡。为了解决传统PCNN模型存在的上述问题,本研究在step function模块后面加入了点火抑制项(即

3 PCNN参数设置

3.1 耦合连接矩阵W的设置

从(7)式可以看出,中心位置权重为零,周围邻域的权值系数为该处位置与中心点位置的欧氏距离的倒数,距离越远其灰度值对中心像素点火状态的影响越小。

3.2 参数αL、VL、αθ、Vθ以及β的设置

PCNN不同于常规神经网络及深度学习网络,不需要根据大量样本进行训练,其模型参数可以直接设定,故参数设置可直接决定所获得的点火时间矩阵分割效果。虽然本文对模型进行了简化,但是仍涉及到5个关键参数的设置,且各参数之间存在较强的耦合关系。当前PCNN参数设置分为三大类:基于经验设置、采用优化算法寻优、基于机理建模分析。其中,优化算法寻优容易出现不收敛、过拟合等问题,稳健性不佳;基于机理建模分析尚不成熟,适用性不高;基于经验的设置方法基本可以满足需求,即通过多次实验调整参数设置。但是PCNN模型待设置的参数过多,不同参数之间存在耦合影响,使得基于经验设置过程比较麻烦。因此,本文根据模型点火过程分析,为基于经验设置增加约束,从而减少需要设定参数的数量,降低设置参数的复杂度。

参数

本文基于PCNN模型进行图像处理,是从像素点灭火角度出发考虑。因此,在设定模型初始条件时,假定图像最原始的状态是全部点火的,即脉冲输出矩阵

第1次迭代时,相关变量状态为

由(10)式和(11)式及像素灭火条件

图像经PCNN获得的脉冲输出矩阵序列,第一次迭代时灭火像素可看成是种子点,后续迭代可看作是基于种子点的灭火过程的扩散。由于本研究采用PCNN的目的是获得可反映纹理特性的点火时间矩阵输出,其脉冲发放过程不能过于粗糙。因此,第一次迭代时灭火像素不可过多,以保证点火时间矩阵后续迭代的有效性,即像素灰度值较暗的区域仍进行一定程度的纹理分割,本研究设定

(13)式即为本文所增加的约束。可充分考虑

4 融合框架

考虑PCNN输出的点火时间矩阵具有多区域分割效果,基于点火时间矩阵进行直接加权融合会带来严重伪影效应。因此,引入引导滤波对点火时间矩阵

引导滤波是一种具有保留边缘特性的滤波器,易于实现且执行速度快[13]。假定输入图像表示为

式中:

式中:

所提出的融合框架如

融合步骤如下所述:

1) 将已配准的红外图像(

2)

3) 基于

式中:·表示点乘运算。

5 实验结果及分析

5.1 实验相关设置

为了验证所提出模型和算法的有效性,本文方法在Intel Core i5-4300U CPU, 内存为 4 GB 的计算机上采用MATLAB 2016a编程实现,选取4组典型红外与可见光图像(

为了评价融合效果,本文将从主观视觉效果和客观评价指标两方面进行讨论。选用的客观评价指标为交叉熵(Cerf)、空间频率(SF)和信息熵(sh)。交叉熵越小,表明融合图像与原图像的差异越小,融合效果越好;空间频率越大,表明图像清晰度越高;信息熵越大,表明融合图像包含信息越丰富。

5.2 实验结果分析

4组红外与可见光图像的融合结果如

图 3. 4组原始红外与可见光图像。(a) Camp红外图像;(b) camp可见光图像;(c) dune红外图像;(d) dune可见光图像;(e) kayak红外图像;(f) kayak可见光图像;(g) road红外图像;(h) road可见光图像

Fig. 3. Four groups of the original infrared and visible images. (a) Camp infrared image; (b) camp visible image; (c) dune infrared image; (d) dune visible image; (e) kayak infrared image; (f) kayak visible image; (g) road infrared image; (h) road visible image

为了客观评价不同算法的融合结果,选取交叉熵、空间频率和信息熵三个指标进行对比分析,具体评价结果如

表 1. 不同算法融合结果的客观评价指标

Table 1. Objective evaluation indexes of different fusion methods

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 4. 不同算法融合结果对比。(a1)~(a4)引导滤波(GFF)的融合结果;(b1)~(b4)基于特征提取(FE)的融合结果;(c1)~(c4) NSCT_PCNN的融合结果;(d1)~(d4)本文PCNN_GFF的融合结果

Fig. 4. Fusion results of different fusion methods. (a1)-(a4) Fusion results of GFF; (b1)-(b4) fusion results of EF; (c1)-(c4) fusion results of NSCT_PCNN; (d1)-(d4) fusion results of the proposed PCNN_GFF

为了进一步验证本文算法的快速性,在同一硬件平台上运行上述融合算法,列出其所需的执行时间,如

表 2. 不同融合算法平均运行时间对比

Table 2. Average running time of different fusion methods

|

5 结论

针对红外与可见光图像融合过程中图像细节不够丰富,融合图像中目标边缘易出现模糊等问题,利用PCNN输出的点火时间矩阵具有多区域分割特性这一特点,提出了结合PCNN与引导滤波GFF的融合方法。通过引入GFF修正点火时间矩阵,进行红外与可见光图像的加权融合,可很好地将红外与可见光图像各自的优势信息保留到融合图像中,且不会出现由于区域分割而带来的伪影。同时,为了提高融合速度,简化了PCNN的模型结构,提出了一种带约束的参数设置方法,并基于信息熵最大原则确定迭代停止次数,在保证点火时间矩阵分割的区域可较好反映原图纹理特性的基础上,减少迭代次数,从而提高了算法的效率。多组实验结果表明,本文提出的算法具有较高的运行效率,同时融合图像具有较为丰富的细节纹理信息,主客观综合性能均优于其他几种对比融合方法。本研究采用简单加权的规则进行融合,未来可寻找更为合适的融合规则,突出目标信息,以便于后续基于融合图像的目标定位及识别应用。

[2] 陈震, 杨小平, 张聪炫, 等. 基于补偿机制的NSCT域红外与可见光图像融合[J]. 仪器仪表学报, 2016, 37(4): 860-870.

[4] 吴冬鹏, 毕笃彦, 何林远, 等. 基于NSSCT的红外与可见光图像融合[J]. 光学学报, 2017, 37(7): 0710003.

[6] 邓辉, 王长龙, 胡永江, 等. 基于非下采样双树复轮廓波与自适应分块的红外与可见光图像融合[J]. 光子学报, 2019, 48(7): 0710006.

[7] Meher B, Agrawal S, Panda R, et al. A survey on region based image fusion methods[J]. Information Fusion, 2019, 48: 119-132.

[8] 朱浩然, 刘云清, 张文颖. 基于迭代导向滤波与多视觉权重信息的红外与可见光图像融合[J]. 光子学报, 2019, 48(3): 0310002.

[10] LindbladT, Kinser JM. 脉冲耦合神经网络图像处理[M]. 马义德, 绽琨, 王兆滨, 等, 译. 北京: 高等教育出版社, 2008: 10- 20.

LindbladT, Kinser JM. Image processing using pulse-coupled neural networks[M]. Ma Y D, Zhan K, Wang Z B, et al., Transl. Beijing: Higher Education Press, 2008: 10- 20.

[11] 马义德, 戴若兰, 李廉. 一种基于脉冲耦合神经网络和图像熵的自动图像分割方法[J]. 通信学报, 2002, 23(1): 46-51.

[12] 邓翔宇, 马义德. PCNN参数自适应设定及其模型的改进[J]. 电子学报, 2012, 40(5): 955-964.

[13] 吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001.

[16] 陈木生. 结合NSCT和压缩感知的红外与可见光图像融合[J]. 中国图象图形学报, 2016, 21(1): 39-44.

Article Outline

周哓玲, 江泽涛. 结合脉冲耦合神经网络与引导滤波的红外与可见光图像融合[J]. 光学学报, 2019, 39(11): 1110003. XiaoLing Zhou, Zetao Jiang. Infrared and Visible Image Fusion Combining Pulse-Coupled Neural Network and Guided Filtering[J]. Acta Optica Sinica, 2019, 39(11): 1110003.