基于多尺度注意力机制的多分支行人重识别算法  下载: 1181次

下载: 1181次

1 引言

行人重识别旨在通过匹配行人图像,从部署在不同位置的互不交叉的监控摄像头来寻找特定行人,对于该问题的深入研究对公共安全和刑侦以及智能安防等有着非常重要的现实意义[1]。提取准确而有效的特征是实现行人重识别任务的关键,文献[ 2]提出了一种基于视角信息嵌入的模型,结合行人图像视角朝向的特点,对于行人重识别网络进行了优化。文献[ 3]提出了一种基于卷积神经网络(CNN)判别特征学习的模型,通过加强对样本监督信息的利用和提升对样本间距离关系的约束,提升了网络提取判别性特征的能力。

随着视角的变化,图像中行人的面部、手、脚等身体部位会变得不稳定,卷积神经网络往往会把焦点放在身体的主要部位,而其他具有描述性的身体部位则容易被忽视[4]。局部特征可以关注更多的细节,应对遮挡、姿态变化等问题时会有更好的表现。为了学习更加精细且有判别性的特征,许多工作提出将特征进行切分并分别计算损失的方法,如局部卷积基准网络(PCB)[5]、多粒度网络(MGN)[6]、多尺度卷积特征融合网络[7]等。但是简单的水平切分往往存在一定的限制,一些完整的特征(比如背包等)可能被强制切分,从而造成了有效信息的丢失。文献[ 8]提出一种结构化特征丢弃方法(DropBlock),通过对特征图中的邻近矩形区域进行随机丢弃,实现了对细节信息的关注。文献[ 4]提出批量特征丢弃(BDB)方法,该方法对于批量特征图,随机遮挡同样的矩形区域,强迫网络在保留的区域中学习一些细节的局部特征。然而,这些方法往往难以对保留区域中不同局部特征的有效性进行准确评判,故很难实现更加细致的加权强化。

另外,为了处理行人重识别任务中边界框检测不完善以及身体部分错位等问题,许多工作提出利用注意机制来聚焦特定区域的捕获特征。文献[ 9]提出一种注意力组成网络(AACN),利用注意力模块来提取行人图片的姿态信息和局部信息以去除背景的干扰。文献[ 10]提出了一种双重注意力匹配方法(DuATM)来学习上下文特征序列并同时实现细致的序列比较。文献[ 11]提出了一个协调注意力网络(HA-CNN),通过融合基于像素的软注意力与基于区域的硬注意力,优化了未对齐的行人图像。但这些注意力方法普遍只能提取固定尺度的特征,不能使网络根据输入信息自适应地调节感受野大小来实现更加合理的权重分配。

针对这些方法存在的问题,本文将多尺度特征融合方法(MSFF)与注意力机制相结合,设计了一个多尺度注意力(MSA)模块,使网络能够根据输入自适应地调整感受野大小,并实现了对于图像中不同尺度目标的加权关注。同时,将MSA模块与批量特征丢弃方法[2]相结合,设计了一个多尺度注意力特征丢弃(MSA-FD)模块,以实现对局部特征中不同位置的权重调整,进而使网络自适应地关注不同尺度的显著信息与次显著信息。另外,本文提出一种图像模糊切分策略,与MSA-FD模块相互补充以获取更加丰富的局部细节信息,最终得到一个基于多尺度注意力机制的多分支网络来统筹全局特征和局部特征,优化行人重识别任务中受遮挡的、未对齐的行人图像。

2 基本原理

2.1 网络框架

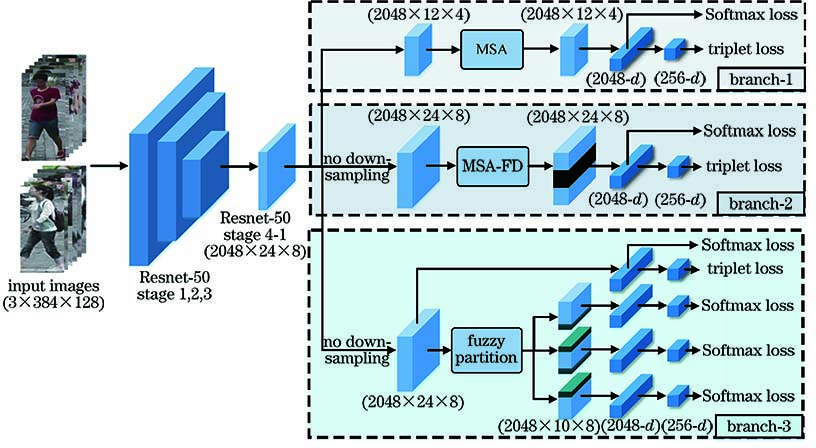

以Resnet-50为基础框架建立了一个多分支网络,分别从多角度提取更具判别性的特征完成行人重识别任务。其中第一个分支是基于多尺度注意机制的全局分支,该分支在没有区域划分的情况下学习全局特征表示。同时设计了一个MSA模块,使得网络能够根据输入信息自适应地调节感受野大小,实现对于全局特征的加权强化。第二个分支和第三个分支分别从两个角度来联合提取多元局部特征,获取更加丰富的细节信息。其中,为了保留更多的细节信息,第二、三分支取消了基础网络中的下采样操作。第二个分支是基于多尺度注意力机制的特征丢弃分支,该分支将MSA模块与批量特征丢弃方法[4]相结合,设计了一个MSA-FD模块,更好地实现了对保留区域中次显著信息的关注。第三个分支为图像模糊分块分支,在传统图像均匀切分的基础上进行了微调,采用一种模糊分块策略,使得中下三个切块中的一部分信息相互包含,减少了暴力切分带来的信息损失的问题。通过全局特征和局部特征的统一结合,网络能够提取更加丰富的信息和细节来表征输入图像的完整情况。

图 1. 基于多尺度注意力机制的多分支行人重识网络框架图

Fig. 1. Multi-branch person re-identification framework based on multi-scale attention mechanism

2.2 基于多尺度注意力机制的全局分支

传统注意力模块中,每一层人工神经元感受野的大小相同,忽略了不同尺度特征对于模型的贡献[12-13]。针对这一问题,本研究将MSFF与双重注意力模块[14]相结合,充分利用不同尺度信息,最终得到了一个MSA,使得网络能够根据输入自适应地调节感受野大小,以实现全局特征更加细致准确的加权强化。

首先对于MSFF模块,给定当前输入特征Xb1∈RC×H×W,其中C、H、W分别代表特征的通道数以及在特征高度和宽度上的元素数目。为了减少模型的参数量,首先利用一个卷积核为1×1的卷积操作将特征通道数目调整为原来的1/r,得到降维后的特征X'∈R(C/r)×H×W(在实验过程中,r设置为8)。将特征X'分别送入4个感受野为R(分别取3,5,7,9[12-13])的深度可分离卷积模块(DSC)[15]得到4组不同尺度的特征,从而使最终的特征能够从整个空间尺度范围捕获信息。分别将4组不同尺度的特征传入一个参数共享的压缩激励模块中[16]实现特征通道间信息交互,然后将4个尺度的特征按元素相加,自适应指导多个尺度特征的动态融合,得到一个包含多尺度信息的融合特征Xms∈R(C/r)×H×W。将特征Xms与通道降维后的输入特征X'按元素相加,最终得到多尺度融合特征Xo∈R(C/r)×H×W已备后续利用。

将第一个分支中经过Resnet-50网络第4阶段得到的特征Xb1∈RC×H×W分别送入3个MSFF模块,得到3个多尺度融合特征Q∈R(C/r)×H×W,K∈R(C/r)×H×W和V∈R(C/r)×H×W,利用三者之间的相互关联信息建立注意力模块,得到一个更具判别性的全局特征表达。首先,对特征Q和K进行双线性池化[17],完成全局信息的聚合。具体地来说,分别对Q和K进行尺寸调整,得到特征Qr∈R(C/r)×HW和Kr∈RHW×(C/r)。进一步地,对于特征Kr通过一个Softmax层得到一个权重特征Ks∈RHW×(C/r),然后将特征Qr与其进行矩阵相乘操作,得到一个包含二阶统计信息的特征G∈R(C/r)×(C/r),表达式为

最后用特征G来聚合整个空间的全局信息。

从输入的整个空间收集特征后,根据当前局部特征的需要,对聚合的全局特征进行自适应加权分布。利用这种方式可以实现通过一组紧凑的特征来捕获更复杂的全局关系。同样地,对于特征V∈R(C/r)×H×W,对其进行尺寸调整得到特征Vr∈RHW×(C/r),然后附加一个Softmax层得到一个指导全局特征分布的权重向量。权重向量中对应的每个位置都可以接收特定的全局信息,这是对现有局部特征的补充,有助于学习更复杂的关系。将该权重向量与聚合的全局特征G相乘,进行特征加权分配,最终得到空间层面更加完备的特征D∈R(C/r)×H×W,表达式为

最后通过一个卷积核为1×1的卷积层将特征D的通道数目调整为C,得到最终的多尺度加权特征O∈RC×H×W。

2.3 基于多尺度注意力机制的特征丢弃分支

联合全局特征和局部特征来进行物体识别已被证明是一种有效的策略,批量特征丢弃方法[4]以批量的方式随机丢弃所有输入特征图的相同区域,以增强局部区域更加精细化的特征学习,但该方法难以实现对于保留区域特征的加权关注。本研究将MSA模块与批量特征丢弃方法相结合,设计了一个多尺度注意力机制特征丢弃模块(MSA-FD),实现了对于保留局部区域的特征权重调整,增强了模型对于局部区域显著不同尺度特征的关注,减少了无关信息对于模型的影响。

MSA-FD模块与MSA模块结构大致相同,但对于第二个分支中经过MSFF模块得到的特征K2∈R(C/r)×H×W和V2∈R(C/r)×H×W,随机选择二者相同位置的连续矩形区域进行丢弃,强迫网络在保留区域里面学习一些细节的局部特征。其中此处C,H,W仅代表其自身含义,不代表具体数值,由于第二、三分支中取消了下采样操作,该模块中H和W的值均为全局分支中MSA模块的两倍。在后续注意力权重计算过程中,K2和V2两个特征分别起特征聚合和特征分布的作用。在对两个特征利用Softmax层产生权重向量之前,通过特征丢弃的方法随机选择特征图中的一个矩形区域进行丢弃。具体来说,首先产生一个二进制掩模m∈R1×H×W,其中随机选择(0.3H)×W的矩形区域元素置为1,其他位置则置0。接下来将其m乘以-¥并将其与K2和V2的各通道相加,使得两组特征被丢弃区域中的对应元素均变为-¥,其他位置则保持不变。这样做的目的是通过Softmax层产生权重向量时,利用exp(-¥)≈0的思想,将保留区域和被丢弃区域区分开来,即被丢弃区域中所有位置被分配0的权重,而保留区域中所有位置共享和为1的概率,该方式不仅可以保证重要特征得到更多关注,还可实现不同局部信息的差别关注。后续的工作与MSA模块一致,通过建立Q2、K2和V2三组多尺度特征的相互关系,最终得到一个实现区域加权分配的特征,进而提取更加丰富且有判别性的细节信息,进行更加准确有效地匹配。

图 3. 基于多尺度注意力机制的特征丢弃方法结构图

Fig. 3. Structure of multi-scale attention-aware feature DropBlock module

2.4 图像模糊分块分支

图像分块策略也是行人重识别任务中获取局部特征的另一有效手段,本研究将其作为第三分支与第二分支的MSA-FD模块联合应用,用于提取更加细节的有判别力的行人局部特征。本研究在传统均匀分块的基础上对切块策略进行了微调,采用一种模糊分块的方法,给定网络第三分支传递来的特征Xb3∈R2048×24×8,如

2.5 训练策略

本研究的训练策略沿用了MGN[6]方法中三元组损失以及分类损失联合训练的方法,有效地避免了损失权重失衡以及收敛困难的问题。如

3 实验结果及分析

3.1 数据集及评估协议

3.1.1 数据集介绍

本研究在3个主流的行人重识别数据集Market-1501[18]、DukeMTMCreID[19]和CUHK03[20]上进行了实验,并将实验结果与多种最新的行人重识别算法进行了对比。

Market-1501数据集包含来自6个不同摄像机的1501个行人的图像。整个数据集分为训练集和测试集两部分,训练集包含来自781个行人的12936张图像,测试集包含来自750个行人的3368张查询图像和16364张图库图像。查询图像中的行人检测矩形框是人工绘制的,而图库图像中的行人检测矩形框则是使用DPM检测器[21]检测得到的。

DukeMTMC-reID数据集是由8个高分辨率摄像机拍摄的来自1402个行人的36411张图像组成。训练集由从数据集中随机选取的702个行人的16522张图像组成。测试集包含剩余的702个行人的2228张查询图像和17661张图库图像。

CUHK03数据集包含由5对摄像机拍摄的1467个行人的14097张图像组成,同时分为手动标记行人边界框和DPM检测的行人边界框两部分。其测试协议分为两种。本实验采用最新的将数据分为包含767个行人的训练集和包含700个行人的测试集的分离策略。

3.1.2 评估协议

本实验中,为了验证所提行人重识别模型的有效性,采用了通用的累积匹配特性曲线(CMC)中的Rank-1以及平均精度均值(mAP)两个指标对实验结果进行评估。

CMC-k(也称为Rank-k匹配精度)表示正确匹配出现在排名前k的检索结果中的概率。Rank-k即表示按照相似度排序后的前k张图像中存在与查询图像属于同一身份信息(ID)的准确率。而大多数行人重识别工作中更在意的是,排名第一的检索结果匹配正确的概率,即Rank-1。

另一种广泛使用的度量标准为mAP,mAP是行人重识别等多标签图像分类任务中常用的评测指标。mAP是指将多分类任务中的平均精度(AP)求和再取平均后的结果。具体计算步骤如下:

1) 计算准确率。准确率的计算表达式为

式中:NTP为预测正确的正样本数,NFP为预测错误的正样本数。

2) 计算AP。 AP是指集合中某一类别所有准确率之和除以含有该类别目标的图像数量,表达式为

式中:Nc为第c个类别目标的图像数量;c=1,2,…,C',其中C'为总类别数。

3) 计算mAP。由于任务中有不止一个类别,因此需要对所有类别计算平均AP值,表达式为

3.2 实验设置

本实验基于PyTorch深度学习框架进行展开,并使用2个NVIDIA RTX 2080 GPU进行数据并行加速。其中,输入图像的尺寸统一调整为384 pixel×128 pixel,采用Adam优化器进行参数更新,权重衰减因子设置为0.0005,两个超参数β1,β2分别设置为0.9和0.999。另外,实验共进行400次迭代,初始学习率设置为0.0002,并分别在第200次迭代和第300次迭代时,学习率均减小90%。

3.3 实验结果分析

为了验证本文模型的有效性,分别在Market-1501和DukeMTMC-ReID数据集上对其各模块进行实验验证。其中baseline是以Resnet-50为基础设计的模型,仅存在一个全局分支。本研究通过在baseline基础上不断增加特定模块以及从完整模型中去除特定模块两个角度来验证各部分的有效性。

3.3.1 多尺度注意力模块对于实验结果的影响

多尺度注意力模块(MSA)通过将多尺度特征融合方法(MSFF)与双重注意力模块[14]相结合,使得网络能够有效地从整个空间访问多尺度特征,实现了对全局特征的加权强化。为了验证MSA模块的有效性,本研究在Market-1501以及DukeMTMC-ReID两个数据集上进行了实验。从

表 1. 多尺度注意力模块的影响

Table 1. Effects of multi-scale attention module unit: %

| |||||||||||||||||||||||||||||

3.3.2 多尺度注意力特征丢弃模块对于实验结果的影响

同样地,本研究对于多尺度注意力特征丢弃(MSA-FD)模块的有效性进行了验证。从

表 2. 多尺度注意力特征丢弃模块的影响

Table 2. Effects of multi-scale attention-aware feature DropBlock module unit: %

| ||||||||||||||||||||||||||||||||||

3.3.3 不同分块策略对于实验结果的影响

为了验证不同的图像分块策略对于模型表现的影响,本文分别研究均匀分块(UP)策略以及模糊切块 (FP)策略作为单独分支,与全局分支相结合进行实验, 同时验证了不同重叠尺寸的模糊切块策略对于实验结果的影响。实验结果如

表 3. 不同分块策略的影响

Table 3. Effects of different partition strategies unit: %

| ||||||||||||||||||||

3.3.4 联合多元局部特征策略对于实验结果的影响

本文所设计的网络是为了追求更加精细的局部特征,将特征丢弃方法与图像切分策略相结合,既减少了切分策略带来的信息丢失,同时也降低了特征丢弃方法所带来的随机性。这两部分特征与全局特征相结合之后,模型表现出了较好的效果。综上所述,本文所设计的各模块都可以起到提高模型表现的作用,同时各模块之间的组合也可以进一步提升精度。

表 4. 联合多元局部特征策略对于实验结果的影响

Table 4. Effect of joint multiple local feature strategy unit: %

| |||||||||||||||||||||||||||||

3.4 实验结果与主流方法的对比

为了验证本文算法的优越性,分别在三个数据集Market-1501、DukeMTMC-ReID以及CUHK03上与目前多种主流行人重识别算法进行对比,见

从实验结果可以看出,在Market-1501数据集上,本文方法的Rank-1和mAP分别达到了95.37%、88.02%,表现出了良好的性能。另外采用Re-ranking[26]方法对结果进行优化之后,Rank-1和mAP分别提升至96.35%及94.50%。而在DukeMTMC-ReID数据集上,Rank-1精度为90.57%,mAP为80.92%,使用Re-ranking方法后,Rank-1和mAP分别提升至93.00%、90.74%,超过了当前大多数方法。同样地,本文也针对CUHK03 (Labeled)以及CUHK03 (Detected)对于算法性能进行了测试,从

表 5. 在Market-1501数据集上的结果对比

Table 5. Comparison of results on Market-1501 unit: %

| |||||||||||||||||||||||||||||||||||

表 6. 在DukeMTMC-ReID数据集上的结果对比

Table 6. Comparison of results on DukeMTMC-ReID unit: %

| |||||||||||||||||||||||||||||||||||

表 7. 在CUHK03数据集上的结果对比

Table 7. Comparison of results on CUHK03 unit: %

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||

3.5 计算效率与主流方法的对比

本文方法与Mobilenet_v2[30]、HA-CNN[11]、MLFN[24]等主流方法进行了对比。为保证实验对比的公平性,本研究在相同硬件环境下测试了各方法训练运行一个批次(10张图像)所消耗的时间。从

表 8. 在Market-1501数据集上的计算速度对比

Table 8. Comparison of computation speed on Market-1501

|

4 结论

通过设计一个基于多尺度注意力机制的多分支行人重识别网络,分别实现对于显著信息与次显著信息的强化,通过更好地协调全局特征和多元局部特征来完成行人重识别任务。与其他方法相比,本文方法可以实现更加合理的权重分配,无论从全局特征还是局部特征层面,都可以最大限度地充分利用特征,减少无关因素对于模型造成的干扰。此外,对传统均匀分块方法进行微调,设计了一种模糊图像分块策略,减少了因暴力分割造成的信息丢失的问题。本研究在多个数据集上对于模型表现进行了验证,并进行了详细的分析,实验结果证明本文方法具有突出的表现。

[1] 刘可文, 房攀攀, 熊红霞, 等. 基于多层级特征的行人重识别[J]. 激光与光电子学进展, 2020, 57(8): 081503.

[2] 毕晓君, 汪灏. 基于视角信息嵌入的行人重识别[J]. 光学学报, 2019, 39(6): 0615007.

[3] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络判别特征学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720001.

[4] Dai ZZ, Chen MQ, Gu XD, et al.Batch DropBlock network for person re-identification and beyond[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South).New York: IEEE Press, 2019: 3691- 3701.

[5] Sun YF, ZhengL, YangY, et al.Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[M] ∥Computer Vision - ECCV 2018. Cham: Springer International Publishing, 2018: 501- 518.

[6] Wang GS, Yuan YF, ChenX, et al.Learning discriminative features with multiple granularities for person Re-identification[C]∥2018 ACM Multimedia Conference on Multimedia Conference - MM '18.New York: ACM Press, 2018: 274- 282.

[7] 徐龙壮, 彭力. 基于多尺度卷积特征融合的行人重识别[J]. 激光与光电子学进展, 2019, 56(14): 141504.

[8] GhiasiG, Lin TY, Le QV. DropBlock: a regularization method for convolutional networks[C]∥Advances in Neural Information Processing Systems.2018: 10727- 10737.

[9] XuJ, ZhaoR, ZhuF, et al.Attention-aware compositional network for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 2119- 2128.

[10] Si JL, Zhang HG, Li CG, et al.Dual attention matching network for context-aware feature sequence based person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 5363- 5372.

[11] LiW, Zhu XT, Gong SG. Harmonious attention network for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 2285- 2294.

[12] LiX, Wang WH, Hu XL, et al.Selective kernel networks[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA.New York: IEEE Press, 2019: 510- 519.

[13] Zhou KY, Yang YX, CavallaroA, et al.Omni-scale feature learning for person re-identification[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27- November 2, 2019, Seoul, Korea (South).New York: IEEE Press, 2019: 3701- 3711.

[14] Chen YP, KalantidisY, Li JS, et al. ( 2018-10-27)[2019-12-26]. https: ∥arxiv.org/abs/1810. 11579.

[15] CholletF. Xception: deep learning with depthwise separable convolutions[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 1800- 1807.

[16] HuJ, ShenL, SunG. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 7132- 7141.

[17] Lin TY, RoyChowdhury A, Maji S. Bilinear CNN models for fine-grained visual recognition[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile.New York: IEEE Press, 2015: 1449- 1457.

[18] Wang HX, Gong SG, Xiang T. Highly efficient regression for scalable person re-identification[EB/OL]. ( 2016-12-05)[2019-12-26]. https: ∥arxiv.org/abs/1612. 01341.

[19] Zheng ZD, ZhengL, YangY. Unlabeled samples generated by GAN improve the person re-identification baseline in vitro[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy.New York: IEEE Press, 2017: 3774- 3782.

[20] LiW, ZhaoR, XiaoT, et al.DeepReID: deep filter pairing neural network for person re-identification[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE Press, 2014: 152- 159.

[21] Felzenszwalb P F, Girshick R B. McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[22] Song CF, HuangY, Wanli OY, et al.Mask-guided contrastive attention model for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 1179- 1188.

[23] Li DW, Chen XT, ZhangZ, et al.Learning deep context-aware features over body and latent parts for person re-identification[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 7398- 7407.

[24] Chang XB, Hospedales TM, XiangT. Multi-level factorisation net for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 2109- 2118.

[25] Kalayeh MM, BasaranE, GökmenM, et al.Human semantic parsing for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA.New York: IEEE Press, 2018: 1062- 1071.

[26] ZhongZ, ZhengL, Cao DL, et al.Re-ranking person re-identification with k-reciprocal encoding[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA.New York: IEEE Press, 2017: 3652- 3661.

[27] LiW, Zhu XT, Gong S G. Person re-identification by deep joint learning of multi-loss classification[EB/OL]. ( 2017-05-12)[2019-12-26]. https: ∥arxiv.org/abs/1705. 04724.

[28] Sun YF, ZhengL, Deng WJ, et al.SVDNet for pedestrian retrieval[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy.New York: IEEE Press, 2017: 3820- 3828.

[29] Chen YB, Zhu XT, Gong SG. Person re-identification by deep learning multi-scale representations[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy.New York: IEEE Press, 2017: 2590- 2600.

[30] SandlerM, HowardA, Zhu ML, et al.MobileNetV2: inverted residuals and linear bottlenecks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE Press, 2018: 4510- 4520.

Article Outline

李聪, 蒋敏, 孔军. 基于多尺度注意力机制的多分支行人重识别算法[J]. 激光与光电子学进展, 2020, 57(20): 201001. Cong Li, Min Jiang, Jun Kong. Multi-Branch Person Re-Identification Based on Multi-Scale Attention[J]. Laser & Optoelectronics Progress, 2020, 57(20): 201001.