基于FCN的无人机可见光影像树种分类  下载: 1224次

下载: 1224次

1 引言

树种空间信息是林业管理的基础,它可以用于解决林业保护部门面临的各种应用问题,准确的树种分布图有利于林业资源管理和监测、碳储量估算、森林扰动评估等[1-5]。当前,人们对于树种组成与空间分布信息的需求日益增加[6-8],而遥感技术在获取空间信息方面有着明显的优势[9]。但高分辨率遥感卫星用于获取遥感影像时,时效性较差,价格高且易受外界环境因素的干扰,目前针对精确至树种层面的分类空间分辨率仍不够高。因此如何利用遥感技术获取精确的树种空间分布信息是当前林业遥感的重点与难点。

无人机遥感属于低空遥感技术,与各种高分辨率卫星相比,无人机在获取影像过程中受大气因素的干扰较小,在小区域遥感应用方面有着良好的前景[10]。利用无人机获取超高空间分辨率的影像为提取树种空间信息提供了新的手段,而准确快速提取树种分类信息的技术则是无人机影像在林业应用发挥作用的关键。现有的用于提高无人机影像树种分类精度的方法多是通过传统机器学习及添加手工特征变量的方式,不同的特征变量会导致获得的分类效果不同[11],手工添加特征变量往往依靠经验,具有一定的盲目性[1]。因此亟须一种可以挑选有效特征变量并能精细区分不同树种的方法。

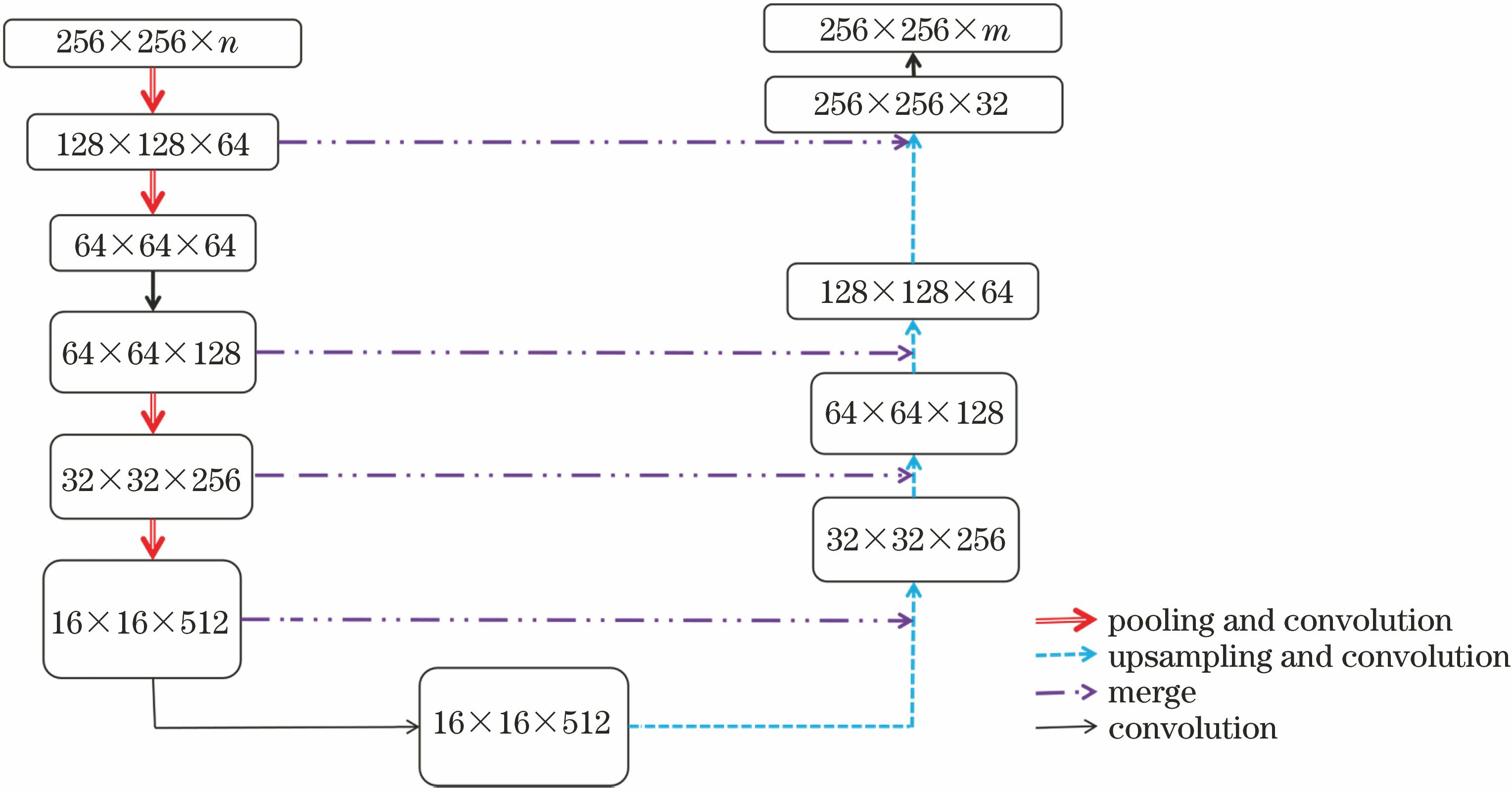

近十几年,深度学习在图像分类上逐渐显现其特有的优势[12]。全卷积神经网络(FCN)是一种多层神经网络,使用反向传播算法进行训练,通过融合不同层的信息来显著提高整个图像分类的准确性[13],这一点和传统图像分类识别方法相比是一个重要的优势。它是在卷积神经网络(CNN)的基础上进行改进的,即将CNN最后的全连接层换成卷积层,采用反卷积层对特征热图进行上采样,使特征热图恢复到与输入图像相同的尺寸,从而对图像按照像素级别进行分类,并保留了输入图像中的空间信息。Res-U-Net架构是对ResNet的修改和扩展,其以能够用非常少的训练样本但仍能获得精确的分类结果而著称。该模型最早被应用于医学图像的分类,由于医学图像的获取成本较高,因此图像样本往往数量有限,但该结构所需的训练样本非常少,并且网络速度快[14]。Xu等[15]和Wang[16]分别将Res-U-Net结构应用于无人机影像的建筑物提取以及高分辨率卫星影像中油类作物和椰子树的分辨,均取得了较高的精度。对于超高精度的无人机影像,上述方法往往被应用于单一树种或是人工建筑的提取,但对于树种层面的分类,鲜有成功案例,本文将对此进行尝试。

考虑到一些树种间的光谱信息具有相似性,且实验所使用的样本数量有限,因此本文将基于Res-U-Net模型的FCN应用于无人机可见光影像的树种分类中,FCN结构在pytorch开源库中实现,并结合面向对象的方法,实现了对森林树种高精度的识别与分类。

2 研究方法

2.1 数据获取

数据获取所用的无人机型号为精灵4PRO,其配备的相机型号为FC6310,相机像素数为2000万,相机焦距为24 mm,影像传感器为1 inch(1 inch=2.54 cm)的互补金属氧化物半导体(CMOS)。

影像拍摄地位于杭州市临安区潜川镇的一个林场,地理位置位于119.72°E、30.23°N。潜川镇自然生态条件优越,森林覆盖率达到76%,其中蕴藏着丰富的林业资源。拍摄时间为2018年12月15日,拍摄期间天气状况良好,拍摄高度约为280 m,属于低空飞行,受大气因素影响较小。拍摄期间无人机相机镜头保持垂直向下,且拍摄时保持悬浮不动。获取的无人机影像用于树种分类,尺寸为3648 pixel×5472 pixel。

2.2 图像分割

面向对象分割是图像分割的一种,其最小单元是由多个相邻像元组成的影像对象,而不再是单个像元。其更多地是应用对象的几何信息和对象间的光谱、拓扑、纹理等信息,而不仅仅是对象的光谱信息[17]。因此面向对象的方法不仅可以提高影像的分类精度,还可以去除椒盐现象,减弱边缘效应。多尺度分割是面向对象分割中常用的方法,对于不同分类目标,合适的分割尺度也不同。因此面向对象分割需要对无人机影像进行最优分割尺度的选择,实验中参考了全局最优判断方法[18-19]来筛选最佳尺度[16]。

2.3 特征变量提取

为了更多地利用影像信息,提高分类的精度,本文除了利用图像原始的红、绿、蓝三个波段外,还利用了光谱特征、纹理特征和位置特征。其中光谱特征包括每个波段中各对象所有像素值的平均值和标准差,以及由原始波段计算出来的可见光差异植被指数(VDVI)[20]和过绿减过红指数(ExG-ExR)[21]。VDVI是借鉴归一化植被指数(NDVI)构造的,适用于仅含可见光波段无人机遥感影像的绿色植被信息提取;ExG-ExR是一种改进的颜色指数,基于0阈值的ExG-ExR指数可以很好地对植被的冠层进行区分;纹理特征主要由灰度共生矩阵(GLCM)表征,包括它的均值、标准差和同质化程度,已被证明其在植被分类中可以发挥重要作用[22-23];位置特征包括各对象中心点坐标及X坐标到该点所属对象左边框的距离和Y坐标到该点所属对象上边框的距离。

2.4 随机森林方法

随机森林(RF)是一种集合了多棵分类与回归树的数据挖掘方法。在机器学习中,RF是一个包含多个决策树的分类器,并且其输出的类别是由单棵树输出类别的众数而定[24]。每棵决策树的创建过程都涉及两个步骤:第一步使用bootstrap随机选择约4/5的训练样本来构建每棵决策树,剩余的1/5样本为袋外数据(OOB),用于内部交叉验证以评估RF的分类准确性;第二步是确定决策树中每个节点的分列条件,随机选择特征变量的子集并根据基尼指数来分割每棵树,仅使用RF选择的特征变量子集的优点是使树之间的相关性较小且泛化能力较强。RF法可以通过评估观察结果与袋外预测数据之间的均方误差(InMSE)的增加量来确定每个特征变量的重要性,明确特征变量对分类准确性的贡献[25],即在分类的同时可对参与分类的变量根据贡献进行重要性排序。本研究利用这一特点对众多的特征变量进行有效筛选。

2.5 基于Res-U-Net模型的FCN法

FCN已经被广泛应用于图像分类中,本文将基于Res-U-Net模型的FCN应用于无人机影像的树种分类中。

Res-U-Net网络包括两个路径:收缩(

2.6 研究技术路线

对无人机影像进行最优尺度面向对象分割,并提取特征变量,随后应用RF算法对融合了特征变量的分割对象实施树种分类,同时,筛选出显著性最高且对分类准确性贡献最大的两个特征变量。分别对添加了由RF法筛选得到的特征变量影像和原始影像制作样本数据,并输入到基于Res-U-Net模型的FCN中进行训练,训练完成后对图像进行预测分类。由于FCN分类得到的结果存在基于像元分类的缺点,因此利用原始影像进行最优尺度分割后的结果对FCN分类结果图的边界进行约束,划分出具有空间临近性的同质区域,去除结果中的混杂像元(

3 研究结果与分析

3.1 面向对象分割结果

利用大津算法(OTSU)[27]剔除原始影像内的非植被。考虑树种图像的特点,在设置多尺度分割参数时,对于树种分类,光谱信息比形状信息更为重要,因此选择形状指数为0.1,光谱指数为0.9;紧致度和平滑度对于分割同样重要,因此均设置为0.5[28]。分割尺度越大,斑块也越大,但破碎程度较小。利用全局评分法,将植被图的尺度设置为30~200 pixel,并按照10 pixel的步长进行18次分割,计算各自的全局平均得分,选择得分最低的尺度(160 pixel)作为此图的最优分割尺度(

得到植被图面向对象的最优分割结果,如

图 4. 研究区植被影像与面向对象分割结果

Fig. 4. Vegetation image and object-oriented segmentation results in the study area

3.2 标签与样本数据

研究区域的树种类型有毛竹、杉木、马尾松、樟树和蕨类5种,其中樟树是幼龄林,蕨类基本为低矮的蕨类。基于无人机影像面向对象分割矢量结果,结合野外调查与目视判读,对部分斑块进行树种类型标记,剩余斑块和无法判断的区域另归为一类,将标记结果生成标签数据。之后,对无人机影像图和标签图进行对应切块,使用128 pixel×128 pixel滑动窗口,步长为128 pixel生成样本,统计每个窗口内被标记为五种类型的像元总数,若占窗口总像元数的80%以上,则为合格的样本,称为“采样数据集”[

图 5. 标签制作。(a)标签图;(b)样本和对应标签的旋转图

Fig. 5. Label making. (a) Label map; (b) rotation of the sample and corresponding label

3.3 特征变量筛选结果

RF法的应用与树的个数(ntree)和抽取的变量数(mtry)两个参数密切相关。OOB误差随着ntree的增大而减小,根据大数定律,当ntree大于某个阈值时,所有种类的OOB误差都会收敛,表明RF中决策树的数量已经足够。根据

实验中分别利用基于Res-U-Net的FCN方法和RF方法对无人机影像植被图进行树种分类。其中参与RF法分类的数据特征变量较多,分类过程中,RF法对特征变量进行了重要性排序,见

3.4 训练过程中损失率与精度变化

以训练样本数据集作为输入,进行深度神经网络的训练。记录训练过程中FCN的损失率与每轮训练后的参数变化,并计算检验样本分类结果的准确性与训练轮数之间的关系(

图 8. 训练过程中的损失率与精度变化。(a)损失率;(b)精度

Fig. 8. Loss and accuracy change during training. (a) Loss; (b) accuracy

将添加了特征变量的样本数据集记为A,将原始影像的样本数据集记为B。比较A和B的损失率可以发现它们的曲线基本吻合,但A的下降速度略快于B,能够更早地接近稳定并趋近于0,见

3.5 FCN及RF分类结果

参与FCN法分类的数据,根据参与分类变量不同,分为2组,一组只有RGB 3个变量,另外一组添加了VDVI与ExG-ExR,两组数据的分类结果分别见

图 9. 不同方法的分类结果。 (a)真实地物图;(b)原始RGB数据与VDVI、ExG-ExR数据融合的FCN法;(c)基于原始RGB数据FCN法; (d)基于33个特征变量RF法

Fig. 9. Classification results by different methods. (a) Groundtruth map; (b) FCN method with fused data including original RGB data, VDVI data and ExG-ExR data; (c) FCN method with original RGB data; (d) RF method with 33 feature variables

3.6 面向对象方法优化实验结果

为优化基于象元的分类结果,将面向对象分割结果对FCN分类结果进行修正,得到树种分类结果如

3.7 结果分析

通过观察

表 1. 对无人机影像进行分类的精度评价

Table 1. Accuracy evaluation of classification of UAV images

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 10. 面向对象分割对FCN分类结果修正。 (a)面向对象修正前 (b)面向对象修正后

Fig. 10. Correction of FCN classification results by object-oriented segmentation. (a) Before object-oriented amendments; (b) after object-oriented amendments

表 2. 面向对象分割对FCN分类结果修正精度评价

Table 2. Correction of FCN classification results by object-oriented segmentation

| ||||||||||||||||||||||||||||||

4 讨论

4.1 FCN与RF方法对分类结果的影响

从

4.2 不同树种图像相似性对分类结果的影响

对于FCN的分类结果,马尾松的生产者精度最低(仅79.2%),被误分成杉木的像元比例较高。出现此现象的可能原因如下:1)研究区包含的马尾松样本像元数量在所有树种的样本中最少,在总像元中的占比为3.39%;2)马尾松和杉木有着相似的树冠纹理及颜色特征,这很容易导致FCN对这两类树种误分。杉木与蕨类间也有一定程度的误分,原因可能是此地经过择伐,部分杉木被砍倒后混入蕨类中,从而增加了蕨类的空间变异程度,造成了部分杉木与蕨类被误分的情况。

4.3 特征变量对分类结果的影响

对比

4.4 面向对象方法与FCN结合对分类结果影响

通过比较

5 结论

将基于Res-U-Net模型的FCN应用于无人机影像的树种分类中,通过比较FCN对添加了VDVI和ExG-ExR的特征变量前后的影像和RF对添加了所有特征变量的影像分类效果,可以得到如下结论:

1) 基于Res-U-Net模型的FCN对添加了VDVI和ExG-ExR的无人机影像进行树种分类,能获得高精度的树种分类图,它相比于RF方法提高了分类精度,相比于FCN对原始影像的树种分类,既提高了分类精度,减弱了椒盐噪声的影响,也加快了损失率的下降速度,提高了分类效率。

2) FCN法对图像进行像素级别的分类会造成结果缺乏空间一致性,存在椒盐效应。但基于最优尺度的面向对象分割结果可以对其结果进行修正,虽仍有一些误分斑块,但基本消除了椒盐噪声,减弱了边缘效应,优化了像元分类结果,同时提高了树种分类精度。

[1] 滕文秀, 温小荣, 王妮, 等. 基于深度迁移学习的无人机高分影像树种分类与制图[J]. 激光与光电子学进展, 2019, 56(7): 072801.

[2] 李夏, 吴开华, 巩永芳, 等. 休宁县主要树种生物量及碳储量分析[J]. 安徽农业大学学报, 2012, 39(4): 502-506.

Li X, Wu K H, Gong Y F, et al. Forest biomass and forest carbon storage analysis for the main tree species in XiuningCounty[J]. Journal of Anhui Agricultural University, 2012, 39(4): 502-506.

[3] 余新晓, 鲁绍伟, 靳芳, 等. 中国森林生态系统服务功能价值评估[J]. 生态学报, 2005, 25(8): 2096-2102.

Yu X X, Lu S W, Jin F, et al. The assessment of the forest ecosystem services evaluation in China[J]. Acta Ecologica Sinica, 2005, 25(8): 2096-2102.

[4] Ørka H O, Dalponte M, Gobakken T, et al. Characterizing forest species composition using multiple remote sensing data sources and inventory approaches[J]. Scandinavian Journal of Forest Research, 2013, 28(7): 677-688.

[5] Fassnacht F E, Latifi H, Stereńczak K, et al. Review of studies on tree species classification from remotely sensed data[J]. Remote Sensing of Environment, 2016, 186: 64-87.

[6] Jensen R R, Hardin P J, Hardin A J. Classification of urban tree species using hyperspectral imagery[J]. Geocarto International, 2012, 27(5): 443-458.

[7] 陈婷婷, 徐辉, 杨青, 等. 武夷山常绿阔叶林空间结构参数分布特征[J]. 生态学报, 2018, 38(5): 1817-1825.

Chen T T, Xu H, Yang Q, et al. Spatial distribution characteristics of an evergreen broad-leaved forest in the Wuyi Mountains, Fujian Province, southeastern China[J]. Acta Ecologica Sinica, 2018, 38(5): 1817-1825.

[8] 张甍, 李婷婷, 张钦弟, 等. 太岳山主要树种空间分布格局及其维持机制研究[J]. 西北植物学报, 2017, 37(4): 782-789.

Zhang M, Li T T, Zhang Q D, et al. Study on the spatial distribution patterns and maintaining mechanisms of dominant trees in Taiyue mountain, Shanxi[J]. Acta Botanica Boreali-Occidentalia Sinica, 2017, 37(4): 782-789.

[9] 张立保, 王鹏飞. 高分辨率遥感影像感兴趣区域快速检测[J]. 中国激光, 2012, 39(7): 0714001.

[10] Shang X, Chisholm L A. Classification of Australian native forest species using hyperspectral remote sensing and machine-learning classification algorithms[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2014, 7(6): 2481-2489.

[11] 欧攀, 张正, 路奎, 等. 基于卷积神经网络的遥感图像目标检测[J]. 激光与光电子学进展, 2019, 56(5): 051002.

[12] 吴止锾, 高永明, 李磊, 等. 类别非均衡遥感图像语义分割的全卷积网络方法[J]. 光学学报, 2019, 39(4): 0428004.

[13] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651.

[14] Han Y, Ye J C. Framing U-net via deep convolutional framelets: application to sparse-view CT[J]. IEEE Transactions on Medical Imaging, 2018, 37(6): 1418-1429.

[15] Xu Y Y, Wu L, Xie Z, et al. Building extraction in very high resolution remote sensing imagery using deep learning and guided filters[J]. Remote Sensing, 2018, 10(1): 144.

[16] 王露. 面向对象的高分辨率遥感影像多尺度分割参数及分类研究[D]. 长沙: 中南大学, 2014.

WangL. Analysing classification and segmentation parameters selection in high resolution remote sensing image using based on object[D]. Changsha: Central South University, 2014.

[17] 张春晓, 侯伟, 刘翔, 等. 基于面向对象和影像认知的遥感影像分类方法: 以都江堰向峨乡区域为例[J]. 测绘通报, 2010( 4): 11- 14.

Zhang CX, HouW, LiuX, et al. Remotesensing image classification based on object-oriented and image cognition: a case study in xiang'e, Dujiangyan[J]. Bulletin of Surveying and Mapping, 2010( 4): 11- 14.

[18] 刘兆祎, 李鑫慧, 沈润平, 等. 高分辨率遥感图像分割的最优尺度选择[J]. 计算机工程与应用, 2014, 50(6): 144-147.

Liu Z Y, Li X H, Shen R P, et al. Selection of the best segmentation scale in high-resolution image segmentation[J]. Computer Engineering and Applications, 2014, 50(6): 144-147.

[19] Johnson B, Xie Z X. Unsupervised image segmentation evaluation and refinement using a multi-scale approach[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2011, 66(4): 473-483.

[20] 汪小钦, 王苗苗, 王绍强, 等. 基于可见光波段无人机遥感的植被信息提取[J]. 农业工程学报, 2015, 31(5): 152-159.

Wang X Q, Wang M M, Wang S Q, et al. Extraction of vegetation information from visible unmanned aerial vehicle images[J]. Transactions of the CSAE, 2015, 31(5): 152-159.

[21] 孙国祥, 汪小旵, 闫婷婷, 等. 基于机器视觉的植物群体生长参数反演方法[J]. 农业工程学报, 2014, 30(20): 187-195.

Sun G X, Wang X C, Yan T T, et al. Inversion method of flora growth parameters based on machine vision[J]. Transactions of the CSAE, 2014, 30(20): 187-195.

[22] 任国贞, 江涛. 基于灰度共生矩阵的纹理提取方法研究[J]. 计算机应用与软件, 2014, 31(11): 190-192, 325.

Ren G Z, Jiang T. Study on glcm-based texture extraction methods[J]. Computer Applications and Software, 2014, 31(11): 190-192, 325.

[23] Han N, Du H Q, Zhou G M, et al. Exploring the synergistic use of multi-scale image object metrics for land-use/land-cover mapping using an object-based approach[J]. International Journal of Remote Sensing, 2015, 36(13): 3544-3562.

[24] 顾星博, 温琪, 史晓雯, 等. 随机森林的并行运算方法及适用条件[J]. 实用预防医学, 2016, 23(2): 129-132.

Gu X B, Wen Q, Shi X W, et al. Parallel random forest method and its applicable condition[J]. Practical Preventive Medicine, 2016, 23(2): 129-132.

[25] Breiman L, Breiman L, Cutler R. Random forests machine learning[J]. Journal of Clinical Microbiology, 2001, 2: 199-228.

[26] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[27] Otsu N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1979, 9(1): 62-66.

[28] 穆亚南, 丁丽霞, 李楠, 等. 基于面向对象和随机森林模型的杭州湾滨海湿地植被信息提取[J]. 浙江农林大学学报, 2018, 35(6): 1088-1097.

Mu Y N, Ding L X, Li N, et al. Classification of coastal wetland vegetation in Hangzhou Bay with an object-oriented, random forest model[J]. Journal of Zhejiang A&F University, 2018, 35(6): 1088-1097.

[29] Hu Y F, Zhang Q L, Zhang Y Z, et al. A deep convolution neural network method for land cover mapping: a case study of Qinhuangdao, China[J]. Remote Sensing, 2018, 10(12): 2053.

[30] Rodriguez-Galiano V F, Ghimire B, Rogan J, et al. An assessment of the effectiveness of a random forest classifier for land-cover classification[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2012, 67: 93-104.

Article Outline

戴鹏钦, 丁丽霞, 刘丽娟, 董落凡, 黄依婷. 基于FCN的无人机可见光影像树种分类[J]. 激光与光电子学进展, 2020, 57(10): 101001. Pengqin Dai, Lixia Ding, Lijuan Liu, Luofan Dong, Yiting Huang. Tree Species Identification Based on FCN Using the Visible Images Obtained from an Unmanned Aerial Vehicle[J]. Laser & Optoelectronics Progress, 2020, 57(10): 101001.