基于前景移除的合成孔径成像算法  下载: 742次

下载: 742次

1 引言

遮挡处理对目标识别与跟踪等计算机视觉应用构成了巨大挑战,这是由于单视角成像的机理限制,使得它只能在探测器平面记录光强信息,缺失了光线的方向信息。因此,当目标被遮挡时,单视角成像不能有效地获取遮挡背后目标的信息。多视角合成孔径成像技术可以同时记录空间中光线的位置信息和方向信息[1],并将记录的不同方向光线的各视角图像有效地合成为具有极浅景深的图像。当探测目标发生遮挡时,它可有效地虚化前景遮挡,实现“透视”探测[2]。但是,由于传统的合成孔径成像算法在物面重聚焦成像前未移除前景遮挡像素,致使重建图像的质量不高,目标细节仍存在遮挡的情况[3-5]。

近年来,国内外学者对传统的合成孔径成像算法对目标重建质量不高等问题开展了相关研究,并取得了一定成果。Wilburn等[6]提出了在一段时间间隔内用摄像机阵列对场景目标进行连续成像的算法,若遮挡物静止而目标在移动,则对一段时间内的多帧图像进行方差计算,并将方差值较小的区域识别为遮挡物。但该算法仅适用于目标移动而遮挡物处于静止状态的场景。Vaish等[7]提出了使用颜色中值、熵、合成聚焦和立体匹配等4种代价函数重建被遮挡平面的算法,但当遮挡物在每个视角中覆盖了较大区域时,该算法可能会失败。Zhou等[8-9]提出了基于方向相关性的遮挡物去除算法,假设前景遮挡物为理想的朗伯体,首先将合成孔径成像对焦到遮挡物上,计算合成图像上每个像素方向采样的方差,然后采用设立阈值去除方差较小像素的算法来优化重建结果。但是,该算法不适合用于遮挡物为非朗伯体或复杂场景成像的情况。Zhao等[10-11]提出了在合成孔径成像前通过使用背景减法来去除动态遮挡的算法。由于这种算法建立在静态背景图像序列减法之上,因此无法处理遮挡物和背景同时静止的场景,并且该算法对复杂背景环境十分敏感。针对这个问题,Zhao等[12]又提出了适用场景更加广泛的算法--通过能量最小化使用像素来标记的合成孔径成像,但由于该算法基于颜色方差对图像进行分割,因此导致其对各视角图像中因场景光照造成的颜色差异非常敏感,不适合用于室外的复杂场景。另外,该标记方法也不适用于多重前景相互遮挡的情况。Yang等[13-14]将最大色差法作为能量最小化的数值项对前景像素进行标记。Yang等[15]提出了基于最优相机选择的被遮挡目标成像算法。然而,Zhao和Yang等的研究利用的是三角仿射变换原理对目标进行合成孔径成像,并未结合光场成像机理重建目标,这也影响了对未知场景目标探测的准确性以及时效性。

针对上述算法存在的问题,本文提出了将(极平面图)EPI中的边缘视差进行分层并指定前景深度进行扩散的像素标记算法,并对移除遮挡后的多视角图像进行合成孔径成像,该算法可以准确地识别和移除前景像素。将所提算法与其他算法的重建结果进行对比后可以看出:所提算法可以准确地识别前景遮挡物,并能在重建时移除遮挡像素,有效地提升目标重建图像的质量。

2 基于前景移除的合成孔径成像算法

2.1 前景标记方法

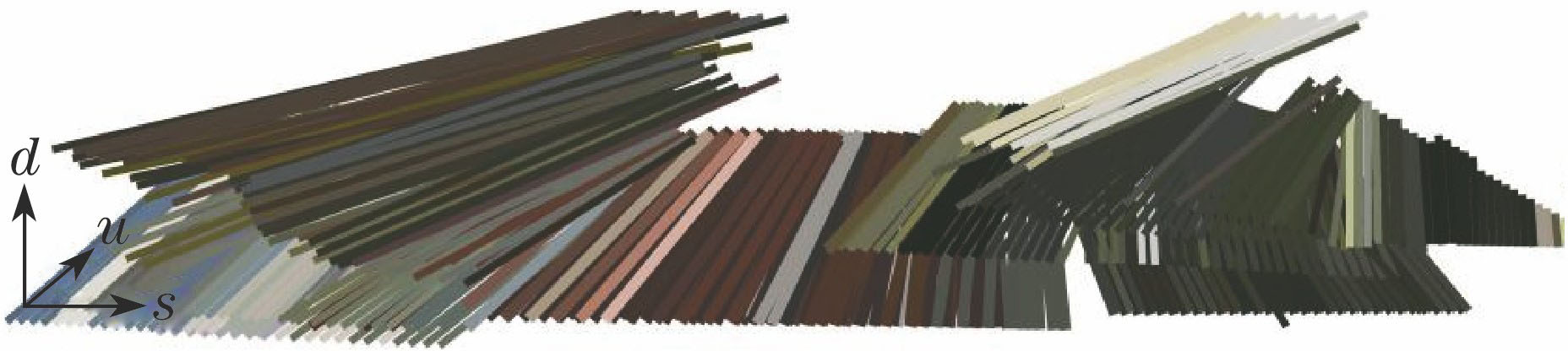

根据Bolles等[16]提出的EPI概念及构建EPI的方法可知,EPI中边缘斜率和视差之间的关系为

式中:

图 1. 根据视差大小对全部EPI中的边缘视差进行分层表示

Fig. 1. Layered expression for edge disparity in all EPIs according disparity

在所提算法实施过程中,首先通过一条穿过丰富场景信息区域的扫描线来获得一个边缘信息较多的EPI,计算该EPI中所有边缘线段的视差,以此预估该场景中物点大概的视差范围;然后在每个EPI中进行边缘置信度计算以获取边缘信息[17],在上述视差范围内精确计算这些边缘的视差,并将它们从小到大排列起来构成集合

式中:

2.2 前景射线筛除

通过Inocc

2.3 指定深度上的目标进行聚焦成像

在光场成像中,可以通过线性移动式相机或线性排布的相机阵列对光场信息进行探测,假设相机阵列由

式中:[

式中:

本课题组提出利用EPI提取光场数据,通过四维EPI的剪切变换对剔除前景遮挡像素的四维光场数据进行合成孔径成像。

如

更为一般地,当

由文献[

4]中采用的双平面法参数化表征光场四维信息可知,空间中同一物点在任意子视角

同理可得

根据(6)式可得

同理可得

式中:Δ

将(10)式和(11)式代入(4)式可得

若Δ

(12)式表示通过对四维EPI数据的剪切变换可以将光场四维数据映射到指定视差上。其中,

通过(12)式可以获得剔除前景遮挡像素的各视角图像Inocc

图 6. 移除遮挡像素后在指定深度上的相机视角图像

Fig. 6. Camera view images on the specific depth plane after removing occlusion

利用Inoccsynthetic(

式中:Δ

3 算法主要流程概述

基于前景标记的合成孔径算法(算法流程图见

1) 确定场景深度范围:将四维光场数据重排成四维EPI,通过EPI中的边缘视差信息估计场景深度范围。

2) 前景标记:通过对EPI中的边缘视差进行分层处理,定位前景遮挡物所在视差范围后,仅在该范围内进行深度扩散,以获取前景遮挡物像素的深度信息,并进行二值化标记,不在此范围内的像素不参与计算。

3) 前景射线筛除:根据各视角图像前景标记结果,移除各视角图像被标记位置上的像素。

4) 通过四维 EPI的剪切变换进行合成孔径成像:根据目标所在深度指定视差,沿EPI边缘方向进行剪切变换,对目标进行聚焦成像。

4 实验结果与分析

实验环境为:Core i7-6700k @4.00 GHz四核,32 G内存,MATLAB 2015b编程环境。采用Disney实验室提供的线性移动式相机拍摄室外环境的数据集,采用Stanford大学提供的相机阵列拍摄室内场景数据集对算法进行测试,验证其可行性和适用性。

实验1选用Disney实验室的数据集,该数据由1台安装在线性移动平台上配备50 mm镜头的Canon EOS 5D Mark II拍摄获取。该户外场景中包括了一座被树枝和栏杆遮挡的居民楼。本课题组选取了该数据集中的51个视角,呈1行51列排布,单个视角图像分辨率为901 pixel×1086 pixel。在此场景中,栏杆和树枝作为前景覆盖在一个较宽的深度范围,并且在各相机视角下,它们都对楼房部分细节存在遮挡。所提算法可以在各子视角图像中准确地标记前景像素信息,并在合成孔径成像前有效地移除这些前景遮挡像素,从而获得较清晰的楼房墙面和窗户等细节信息,如

相比于传统的合成孔径成像算法,所提算法可以显著提升遮挡背后目标重建图像的质量,较好地保留了目标的细节信息,并且能够较好地适用于室外复杂环境中遮挡目标的识别。

实验2选用Stanford大学相机阵列拍摄的室内场景数据集,它是一个由被植物部分遮挡的2个CD盒和1张海报组成的场景。这组数据集有105个视角,呈5行21列分布,单个视角图像分辨率为515 pixel×650 pixel。在各单一子视角图像中,目标被部分遮挡,很难获取到遮挡背后的目标的全部信息。首先,通过本研究所提算法对该数据集场景进行前景标记,前景视差范围约为[11.77,12.89],如

实验中,3种算法对焦在左侧CD盒的视差约为7.19,右侧CD盒的视差约为7.41。由

![传统合成孔径成像算法与所提算法对户外场景遮挡目标的重建结果。(a) Disney数据集中相机视角图像;(b)相机视角图像的前景标记图像,前景视差范围约为[10.5,13.2];(c)传统合成孔径成像算法的重建结果,分别对焦到指定红框区域;(d)所提算法的重建结果,分别对焦到红框区域,从左到右对焦视差分别约为6.17、6.08、5.82;(e)传统合成孔径成像,分别对焦到红框区域,蓝框内为该区域的细节;(f)所提算法的重建结果,分别对焦到红框区域,蓝框内为该区域的细节,从左到右对焦视差分别约为5.99、5.82、5.73](/richHtml/gxxb/2018/38/6/0611002/img_8.jpg)

图 8. 传统合成孔径成像算法与所提算法对户外场景遮挡目标的重建结果。(a) Disney数据集中相机视角图像;(b)相机视角图像的前景标记图像,前景视差范围约为[10.5,13.2];(c)传统合成孔径成像算法的重建结果,分别对焦到指定红框区域;(d)所提算法的重建结果,分别对焦到红框区域,从左到右对焦视差分别约为6.17、6.08、5.82;(e)传统合成孔径成像,分别对焦到红框区域,蓝框内为该区域的细节;(f)所提算法的重建结果,分别对焦到红框区域,蓝框内为该区域的细节,从左到右对焦视差分别约为5.99、5.82、5.73

Fig. 8. Reconstructed results of outdoor occluded objects with the traditional synthetic aperture imaging and our algorithm. (a) Image of camera view in the Disney dataset; (b) an foreground labeled image of camera view, the foreground disparity range is about [10.5,13.2]; (c) reconstructed images with the traditional synthetic aperture imaging, focusing on the red frame areas, respectively; (d) reconstructed images with our algorithm, focusing on the same red frame areas, respectively, and the disparit

图 9. (a)相机视角前景深度扩散图像;(b)相机视角前景标记图像

Fig. 9. (a) Foreground depth propagation image of camera view; (b) foreground labeled image of camera view

最后,参考

![不同算法对植物背后CD盒重建结果的细节对比。(a1)传统合成孔径成像算法,对焦到左侧CD盒;(a2)传统合成孔径成像算法,对焦到右侧CD盒;(b1)所提算法,对焦到左侧CD盒;(b2)所提算法,对焦到右侧CD盒;(c1)文献[12]中的算法,对焦到左侧CD盒;(c2)文献[12]中的算法,对焦到右侧CD盒](/richHtml/gxxb/2018/38/6/0611002/img_11.jpg)

图 11. 不同算法对植物背后CD盒重建结果的细节对比。(a1)传统合成孔径成像算法,对焦到左侧CD盒;(a2)传统合成孔径成像算法,对焦到右侧CD盒;(b1)所提算法,对焦到左侧CD盒;(b2)所提算法,对焦到右侧CD盒;(c1)文献[ 12]中的算法,对焦到左侧CD盒;(c2)文献[ 12]中的算法,对焦到右侧CD盒

Fig. 11. Details of reconstructed CD cases behind the plant with different algorithms. (a1) The traditional synthetic aperture imaging, focusing on the left CD case; (a2) the traditional synthetic aperture imaging, focusing on the right CD case; (b1) our algorithm, focusing on the left CD case; (b2) our algorithm, focusing on the right CD case; (c1) the algorithm in ref.[12], focusing on the left CD case; (c2) the algorithm in ref.[12], focusing on the right CD case

图 12. 各种算法重建CD盒图像的峰值信噪比

Fig. 12. PSNR of reconstructed CD cases images with different algorithms

5 结论

针对传统合成孔径成像算法重建目标质量不高的问题,利用对EPI边缘视差进行分层,并在前景边缘视差范围内局部深度扩散的思想,提出了一种基于前景遮挡移除的合成孔径算法。实验结果表明:所提算法在室外环境和室内环境测试集上均表现出了良好的适用性;相比于其他算法,所提算法的重建效果具有更好的图像辨识度以及更高的PSNR。在Stanford大学数据集实验中,所提算法重建目标的PSNR分别为25.08 dB和25.25 dB,优于传统合成孔径成像算法和文献[ 12]所提算法重建目标的PSNR。但是,由于合成的虚拟孔径景深极浅,在对具有一定深度范围的被遮挡目标或不同深度上被遮挡的多个目标进行重建时,会导致不在景深范围内的目标部分失焦。因此,课题组将在后续工作中利用对边缘视差进行分层的思想,重建出不同深度上的目标并融合,以形成目标所在深度范围上的全景深图像。

[1] LevoyM, HanrahanP. Light field rendering[C]∥Proceedings of the Conference on Computer Graphics and Interactive Techniques.New York: ACM Press, 1996: 31- 42.

LevoyM, HanrahanP. Light field rendering[C]∥Proceedings of the Conference on Computer Graphics and Interactive Techniques.New York: ACM Press, 1996: 31- 42.

[2] IsaksenA, McMillan L, Gortler S J. Dynamically reparameterized light fields[C]∥Proceedings of the 27th Annual Conference on Computer graphics and Interactive Techniques.New York: ACM Press, 2000: 297- 306.

IsaksenA, McMillan L, Gortler S J. Dynamically reparameterized light fields[C]∥Proceedings of the 27th Annual Conference on Computer graphics and Interactive Techniques.New York: ACM Press, 2000: 297- 306.

[3] JoshiN, AvidanS, MatusikW, et al. Synthetic aperture tracking: tracking through occlusions[C]. Proceedings of IEEE 11 th International Conference on Computer Vision, 2007: 9849062.

JoshiN, AvidanS, MatusikW, et al. Synthetic aperture tracking: tracking through occlusions[C]. Proceedings of IEEE 11 th International Conference on Computer Vision, 2007: 9849062.

[4] VaishV, WilburnB, JoshiN, et al. Using plane+parallax for calibrating dense camera arrays[C]. Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004: 8161383.

VaishV, WilburnB, JoshiN, et al. Using plane+parallax for calibrating dense camera arrays[C]. Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004: 8161383.

[5] VaishV, GargG, TalvalaE, et al. Synthetic aperture focusing using a shear-warp factorization of the viewing transform[C]. Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2005: 537.

VaishV, GargG, TalvalaE, et al. Synthetic aperture focusing using a shear-warp factorization of the viewing transform[C]. Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2005: 537.

[6] Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[J]. ACM Transactions on Graphics, 2005, 24(3): 765-776.

Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[J]. ACM Transactions on Graphics, 2005, 24(3): 765-776.

[7] VaishV, LevoyM, SzeliskiR, et al. Reconstructing occluded surfaces using synthetic apertures: stereo, focus and robust measures[C]. Proceedings of IEEE Computer Socity Conference on Computer Vision and Patter Recognition, 2006, 2: 2331- 2338.

VaishV, LevoyM, SzeliskiR, et al. Reconstructing occluded surfaces using synthetic apertures: stereo, focus and robust measures[C]. Proceedings of IEEE Computer Socity Conference on Computer Vision and Patter Recognition, 2006, 2: 2331- 2338.

[9] 周志良. 光场成像技术研究[D]. 合肥: 中国科学技术大学, 2012.

周志良. 光场成像技术研究[D]. 合肥: 中国科学技术大学, 2012.

Zhou ZL. Research on light field imaging technology[D]. Hefei: University of Science and Technology of China, 2012.

Zhou ZL. Research on light field imaging technology[D]. Hefei: University of Science and Technology of China, 2012.

[10] PeiZ, ZhangY, YangT, et al. A novel method for detecting occluded object by multiple camera arrays[C]∥International Conference on Fuzzy Systems and Knowledge Discovery. Washington: IEEE, 2012: 1673- 1677.

PeiZ, ZhangY, YangT, et al. A novel method for detecting occluded object by multiple camera arrays[C]∥International Conference on Fuzzy Systems and Knowledge Discovery. Washington: IEEE, 2012: 1673- 1677.

[13] YangT, ZhangY, YuJ, et al.All-in-focus synthetic aperture imaging[C]∥Proceedings of European Condeference on Computer Vision-ECCV 2014. [S.l.]: Springer International Publishing, 2014: 1- 15.

YangT, ZhangY, YuJ, et al.All-in-focus synthetic aperture imaging[C]∥Proceedings of European Condeference on Computer Vision-ECCV 2014. [S.l.]: Springer International Publishing, 2014: 1- 15.

[17] Sorkine-HornungA, KimC, ZimmerH, et al. Scene reconstruction from high spatio-angular resolution light fields: US20140327674[P]. 2013-07-17.

Sorkine-HornungA, KimC, ZimmerH, et al. Scene reconstruction from high spatio-angular resolution light fields: US20140327674[P]. 2013-07-17.

刘严羊硕, 刘宾, 潘晋孝. 基于前景移除的合成孔径成像算法[J]. 光学学报, 2018, 38(6): 0611002. Yanyangshuo Liu, Bin Liu, Jinxiao Pan. Synthetic Aperture Imaging Algorithm Via Foreground Removing[J]. Acta Optica Sinica, 2018, 38(6): 0611002.