基于改进卷积神经网络的视网膜血管图像分割  下载: 1715次

下载: 1715次

1 引言

视网膜血管是人体唯一可以通过无创伤手段观察到的清晰血管,目前医学研究表明[1],视网膜血管异常与高血压、冠心病、糖尿病等心血管疾病严重程度有很大关系,视网膜血管的病变可能发生在发病之前,因此彩色眼底图像的视网膜血管检测对于预测、诊断和治疗心血管疾病有重要的应用价值。然而,视网膜上血管分布错综复杂且往往有病变干扰,但是由于眼底照相机的照明与成像方式的局限性[2],彩色眼底图像中血管末梢与背景的对比度低,且往往存在噪声、光照不均匀的问题,视网膜血管难以完全分割,人工标注耗时耗力,且存有较大的主观性。因此,视网膜血管自动分割技术一直是眼底图像分析领域的热点和难点。

多年来,国内外专家学者提出了大量方法并取得了一定的成果,这些方法可分为5类[3]:基于血管跟踪的方法、基于匹配滤波的方法、基于形态学处理的方法、基于形变模型的方法和基于机器学习的方法,其中基于机器学习的方法分割血管的精度最高。通过其他方法进行特征提取,用机器学习方法进行特征训练和分割为目前最常用的方法。文献[ 4]提出基于组合移位滤波响应的特征提取方法,并将提取的特征输入AdaBoost分类器以对视网膜血管进行检测。文献[ 5]提出一种具有自适应连接值的脉冲耦合神经网络与高斯匹配滤波器相结合的视网膜血管分割方法实现眼底图像中血管区域的自动生长。文献[ 6]提出基于全连接条件随机场的方法进行血管分割,条件随机场的参数则用结构化输出支持向量机进行学习。

近年来,随着深度学习的发展,卷积神经网络(CNN)作为深度学习的重要分支,通过局部感受野和权值共享减少了所需要训练的参数,使卷积神经网络能快速处理高维图像,并具有平移不变性,其强大的自动学习特征能力也使其能捕捉目标的高层语义信息,因此在图像识别、语义分割、目标检测等领域有极大的优势,其应用也更加广泛[7-8]。在彩色眼底图像视网膜血管分割方面,有别于传统的先手动提取特征、再选择合适的分类器来分割眼底图像中血管的方法,CNN将特征提取和分类器设计融于一个深层模型中,通过大量样本的训练来自动学习各种场景下的血管特征,具有更好的泛化能力和稳健性。文献[ 9]提出一种CNN方法,将血管分割视为一个是否为血管的二分类任务,用CNN进行逐像素分类,并结合结构化预测方法,同时对多个像素点进行分类,其结果优于许多传统算法,对细小血管的检测也有很好的效果,但其网络拥有千万级的参数量。文献[ 10]提出一种多级卷积神经网络,拥有多级输入,同时将源图像和经过最大池化处理的图像输入该网络,并在网络中加入dropout层与spatial-dropout层,这种网络具有应用于其他类型图像分类的潜力,但多级输入意味着多个平行网络支路,从而增加了网络的计算量。

针对眼底图像中细小血管难以提取的问题,本文提出一种改进的基于编码器-解码器结构的全卷积神经网络,其网络主要有两个特点:首先,将残差学习[11]和DenseNet[12]结构相结合的残差密集连接结构引入网络,通过残差学习使网络更容易优化,更充分地利用每一层的特征图信息,缩短了低层特征图到高层特征图之间的路径,强化了特征的传播能力,从而增强网络的性能;其次,将空洞卷积与编解码器结构相结合,编解码结构网络具有强大的提取感兴趣区域的能力,但在编码阶段丢失的细节信息无法在解码阶段很好地复原,空洞卷积以不增加网络参数数量的形式增大了网络的感受野,从而能获取更多的细节结构信息,本文将两者相结合,在准确地提取血管特征的同时,能保留更多的细小血管。

2 网络结构

2.1 残差密集连接模块

残差学习的基本思想是,假设网络的输入为

DenseNet的密集连接模块(DB)将前层结果与本层结果合并作为下一层的输入,设网络第

式中

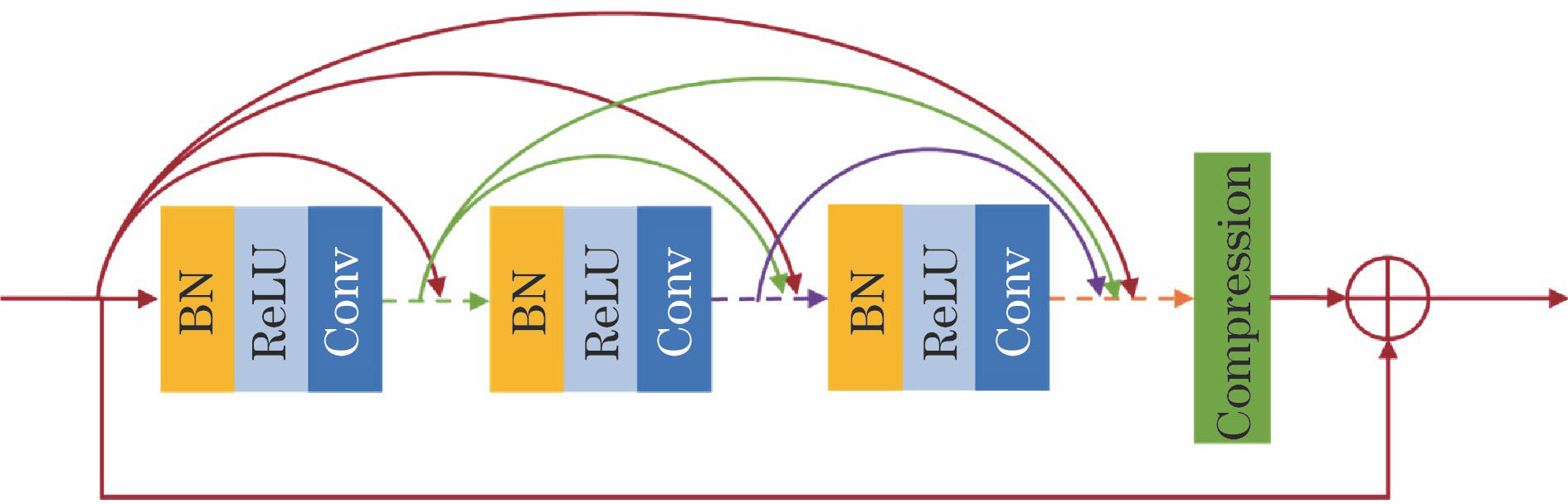

DenseNet结构能充分利用所有输出特征图的信息,而在密集连接层中加入残差学习可以进一步强化特征传播,提升网络性能[13]。因此,将残差学习与DenseNet结构相结合,设计了残差密集连接模块(RDB),其结构如

2.2 空洞卷积

CNN应用于图像语义分割的一个问题是使用池化层、增加步长减小特征图尺寸会导致图像细节结构丢失,从而导致分割结果不够精细[14]。为应对这个问题,部分研究者们提出了基于编码器-解码器结构的全卷积神经网络[14]并不断改进,如U-Net[15]、SegNet[16],通过编码器结构逐步减小特征图从而学习图像抽象特征,通过解码器结构将图像恢复到原始大小,但解码器不能很好地恢复丢失的图像细节结构,因此部分研究者[17]提出去掉池化层,并使用空洞卷积以不增加参数数量的方式增大感受野,从而保留更多的图像细节结构。但网络越深,特征图数量越多,保持特征图尺寸与原图一致则会带来更大的计算量。因此,本文在基于编、解码器的全卷积神经网络的结构上将一般卷积替换为空洞卷积,从而提取出更多的细小血管。

空洞卷积可以看成带孔的卷积,其基本原理是在普通卷积核的每个像素之间插入孔(即像素值为0的像素),以不增加网络参数数量的形式增大了感受野,如

图 2. 不同扩张率下的空洞卷积示意图。(a) r=1; (b) r=2; (c) r=3

Fig. 2. Schematic of dilated convolutions under different dilation rates. (a) r=1; (b) r=2; (c) r=3

2.3 视网膜血管分割网络模型

针对视网膜图像特征的复杂性(如光照、病变等因素干扰),设计了基于编码器-解码器结构的网络模型,引入RDB改善深层网络优化困难的问题,进一步提升网络性能,并使得每一层所得的血管特征得以反复利用,同时大幅减少网络参数数量,使得视网膜血管图像的训练不容易过拟合;将普通卷积替换成空洞卷积增大了网络的感受野,从而使网络保留图像细节结构,提取出更多细小血管。

本文算法的网络结构如

3 实验结果分析

进行实验仿真的计算机硬件配置为Intel Core i7-6850K 与Nvidia GeForce GTX1080Ti,使用以TensorFlow作为后端的Keras开源库训练和测试网络模型。

3.1 数据集与预处理

本文在DRIVE[18]公共数据集上进行实验,DRIVE数据集是从荷兰的糖尿病视网膜病变筛查项目中获得。其图像是从25~90岁之间的400名糖尿病受试者拍摄的眼底图像中随机抽取的40张图像,其中20张作为训练集,20张作为测试集。每幅图像均被裁剪为584×565大小,并对应有专家手动分割的结果和掩模图像。

由于眼底图像中存在光照不均、血管与背景对比度低等因素影响,为了更好地分割出视网膜血管,本文对DRIVE数据集中的每一幅图像进行如下处理:首先将其转化为灰度图像,然后采用对比度受限制的自适应直方图均衡化(CLAHE)算法改善视网膜图像光照不均匀的问题并增强图像的对比度[19],接着采用尺寸为64×64、步长为16的滑动窗口将图像分为局部重叠的图像块。

3.2 训练

由于DRIVE数据集本身较小,为防止网络过拟合,本文对训练数据集进行数据增强。将经过预处理的训练图像分别旋转0°、90°、180°、270°之后,分别对其进行水平和垂直翻转,扩充至原来训练集的12倍。在输入网络之前,随机对训练集中的图像进行Gamma矫正(

网络参数的权重初始化采用He正态分布方法[20],采用交叉熵函数作为损失函数,其计算公式为

式中

3.3 性能评价指标

为了定量分析检验网络性能和分割结果,本文采用准确率、灵敏度和特异性这三个通用指标来客观评价视网膜血管的分割效果。这三个指标的计算公式为

式中

受试者工作特性(ROC)曲线也是衡量视网膜血管分割标准的重要曲线,其以假阳性率(即1-特异性)为横坐标,以真阳性率(即灵敏度)为纵坐标,反映了设定不同阈值时的灵敏度和特异性变化的情况,曲线下的面积(AUC)为ROC曲线下方的面积,AUC越接近1,说明算法性能越好,分割效果越好。本文采用AUC作为其中一个评价指标,采用Python开源库中的scikit-learn库绘制ROC曲线并计算AUC。

3.4 实验结果

本文在DRIVE数据集的测试集上进行实验。

![本文算法与文献[9]算法的分割效果。(a)源图像;(b)金标准图像;(c)文献[9]结果;(d)本文算法结果](/richHtml/gxxb/2018/38/11/1111004/img_4.jpg)

图 4. 本文算法与文献[ 9]算法的分割效果。(a)源图像;(b)金标准图像;(c)文献[ 9]结果;(d)本文算法结果

Fig. 4. Segmentation results by proposed method and method in Ref. [9]. (a) Original images; (b) ground truth; (c) results in Ref. [9]; (d) results by proposed method

![本文算法与文献[9]算法的分割结果ROC曲线。(a) ROC曲线;(b)图(a)中红框区域内曲线](/richHtml/gxxb/2018/38/11/1111004/img_5.jpg)

图 5. 本文算法与文献[ 9]算法的分割结果ROC曲线。(a) ROC曲线;(b)图(a)中红框区域内曲线

Fig. 5. ROC curves of segmentation results by proposed method and method in Ref. [9]. (a) ROC curves; (b) curves in red box of Fig. (a)

表 1. 不同算法在DRIVE数据集上视网膜血管分割性能对比

Table 1. Retinal vessel segmentation performance comparison among different algorithms on DRIVE datasets

| |||||||||||||||||||||||||||||||||||||||||||

文献[ 9]方法和本文深度学习算法的网络参数数量分别为48 M和4.4 k,文献[ 10]未给出具体的网络参数,无法计算参数数量。可以看出,本文算法网络具有更少的参数,计算效率大幅度提升。

3.5 网络结构的影响

对网络分别进行以下调整:1)删去了RDB结构中的短连接,即去掉残差学习,转为普通的密集连接模块结构,该网络记为Network_1;2)不使用空洞卷积,即扩张率

表 2. Retinal vessel segmentation performance comparison among different network structures on DRIVE datasets

Table 2.

|

视网膜血管分割性能对比

表 2. Retinal vessel segmentation performance comparison among different network structures on DRIVE datasets

Table 2.

|

4 结论

针对彩色眼底图像视网膜血管手工分割难度大、细小血管难以分割的问题,提出了一种改进的卷积神经网络方法。首先,将残差密集连接结构引入网络,密集连接结构强化了特征图的传播并大幅减少了网络参数数量,而残差学习使网络更容易优化,两者结合更进一步提升了网络的性能。其次,将空洞卷积引入编、解码器结构网络中,在准确提取血管图像的同时保留了更多的细小血管。与其他传统方法和深度学习方法相比,本文算法准确率和灵敏度更高;与现有准确度较高的深度学习算法相比,本文算法在大幅减少网络参数、提高计算效率的同时,细小血管的保留更加完整,分割性能更好。

[2] 王晓恒, 薛庆生. 大视场手持式免散瞳眼底照相机光学设计[J]. 光学学报, 2017, 37(9): 0922001.

[3] 朱承璋, 邹北骥, 向遥, 等. 彩色眼底图像视网膜血管分割方法研究进展[J]. 计算机辅助设计与图形学学报, 2015, 27(11): 2046-2057.

[4] 黄文博, 王珂, 燕杨. 彩色视网膜眼底图像血管自动检测方法[J]. 光学精密工程, 2017, 25(5): 1378-1386.

[5] 徐光柱, 张柳, 邹耀斌, 等. 自适应脉冲耦合神经网络与匹配滤波器相结合的视网膜血管分割[J]. 光学精密工程, 2017, 25(3): 756-764.

[7] 高琳, 王俊峰, 范勇, 等. 基于卷积神经网络与一致性预测器的稳健视觉跟踪[J]. 光学学报, 2017, 37(8): 0815003.

[8] 李素梅, 雷国庆, 范如. 基于卷积神经网络的深度图超分辨率重建[J]. 光学学报, 2017, 37(12): 1210002.

[11] HeK, ZhangX, RenS, et al. Deep residual learning for image recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770- 778.

[12] HuangG, LiuZ, MaatenL, et al. Densely connected convolutional networks[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2261- 2269.

[13] ZhangY, TianY, KongY, et al. Residual dense network for image super-resolution[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2018.

[15] RonnebergerO, FischerP, BroxT. U-Net: convolutional networks for biomedical image segmentation[C]∥International Conference on Medical Image Computing and Computer-Assisted Intervention. Springer, Cham, 2015: 234- 241.

[19] 陈萌梦, 熊兴良, 张琰, 等. 1种视网膜眼底图像增强的新方法[J]. 重庆医科大学学报, 2014, 39(8): 1087-1090.

[20] HeK, ZhangX, RenS, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]∥IEEE International Conference on Computer Vision (ICCV), 2015: 1026- 1034.

[21] Kingma DP, BaJ. Adam: a method for stochastic optimization[C]∥The 3rd International Conference on Learning Representations, 2015: 1- 15.

[22] 王晓红, 赵于前, 廖苗, 等. 基于多尺度2D Gabor小波的视网膜血管自动分割[J]. 自动化学报, 2015, 41(5): 970-980.

Article Outline

吴晨玥, 易本顺, 章云港, 黄松, 冯雨. 基于改进卷积神经网络的视网膜血管图像分割[J]. 光学学报, 2018, 38(11): 1111004. Chenyue Wu, Benshun Yi, Yungang Zhang, Song Huang, Yu Feng. Retinal Vessel Image Segmentation Based on Improved Convolutional Neural Network[J]. Acta Optica Sinica, 2018, 38(11): 1111004.