基于深度信息的大豆株高计算方法  下载: 1543次

下载: 1543次

1 引言

大豆作物在生长过程中所体现出的形态特征对选育大豆优良品种具有重要作用[1]。株高的动态变化不同程度地影响大豆产量,研究该表型特征不仅有助于基因-环境相互作用的定量分析,而且对提升大豆品质至关重要[2]。

传统株高测量方法是利用直尺、手持式激光测距仪等设备手动测量冠层最高点到植株根部的垂直长度,这种方法不仅费时费力,而且结果易受测量者主观因素的影响。为了弥补传统测量技术的不足,信息化的测量技术被广泛地应用到农作物表型特征的研究中。

目前植物表型参数测量研究大多局限于实验室环境或是基于虚拟植株三维重建,无法反映田间植株真实的生长情况[3-4]。基于田间的高通量表型参数测量手段是制约植物基因组研究和作物改良的主要因素[5]。目前农作物冠层信息获取技术主要包括手持式传感器、基于双目相机的立体视觉技术、手持式激光扫描技术和三维激光扫描及雷达技术等[6-7]。手持式传感器采用的是接触式测量方法,会导致农作物发生形变。基于双目相机的立体视觉技术[8],可对作物冠层图像进行非接触式无损采集,且不破坏作物生长形态,但采集的图像质量受光照影响较大,进而降低了表型参数计算的准确性。手持式激光扫描技术(如FastSCAN型激光扫描仪和Artec EVA型激光扫描仪)虽然能够高精度地重构作物冠层的三维结构形态,但其采集速度较慢[9]。近年来,在地物表型参数分析的基础上,研究人员提出了空间上高通量的测量方法,如网络相机远程表型测量[10],这种方法虽然实现了农作物表型特征的快速采集,但其测量结果误差波动范围较大。三维激光扫描及雷达技术[11-12](如FARO Focus3D 120型地物激光扫描)能快速精确地获取植物冠层点云信息,但获取的点云信息中存在大量的冗余背景信息,需要进行点云筛选等操作才能精确构建冠层三维结构形态,且昂贵的价格进一步限制了该设备的广泛应用[13-15]。上述技术手段已经在大田作物(如玉米和水稻)和树木等的表型参数计算中取得了较多的研究成果,但针对大豆的表型研究相对较少。

本文提出了一种价格相对低廉且精确度相对较高的农作物冠层信息获取方法。Kinect传感器具有较精确和快速获取空间信息的优势,已经被广泛用于农产品检测、农作物实时监控和植物表型参数获取等研究中[16-18]。在此构建了基于Kinect 2.0传感器的大豆冠层图像采集平台,以快速高效地获取自然环境下大豆冠层彩色及距离点云数据,并以此开展大豆株高的计算方法研究。该研究成果为田间农作物高通量表型技术的研究提供了一种有力的获取手段,为大豆优良品种的选育提供了精确的数据支持[19-20]。

2 材料与方法

2.1 实验材料

大豆种植及其冠层信息的采集工作是在黑龙江八一农垦大学农学院卓越农业人才创新创业训练园开展的。在自然光强为0~1200 μmol·m-2·s-1、温度为20~34 ℃的室外条件下,选取抗线9号、抗线13号和富豆6号这3个品种的大豆作为研究对象,其中抗线9号和抗线13号大豆的抗线虫能力较强,富豆6号富含丰富的油脂。将种子经过精选后进行消毒、催芽,播种于花盆中。具体操作为:首先将中等土块铺平于直径为0.3 m、高为0.18 m的聚氯乙烯(PVC)材料的盆底,装入筛选好的非盐碱细土,直至盆重为 4.5 kg,均匀平铺复合肥后继续在盆中放入细土至7.5 kg。在2018年5月21日种植第一批上述三个大豆品种,分别在9 d后和18 d后种植第二批和第三批大豆。每个品种的大豆各15盆,三批大豆共计45盆。

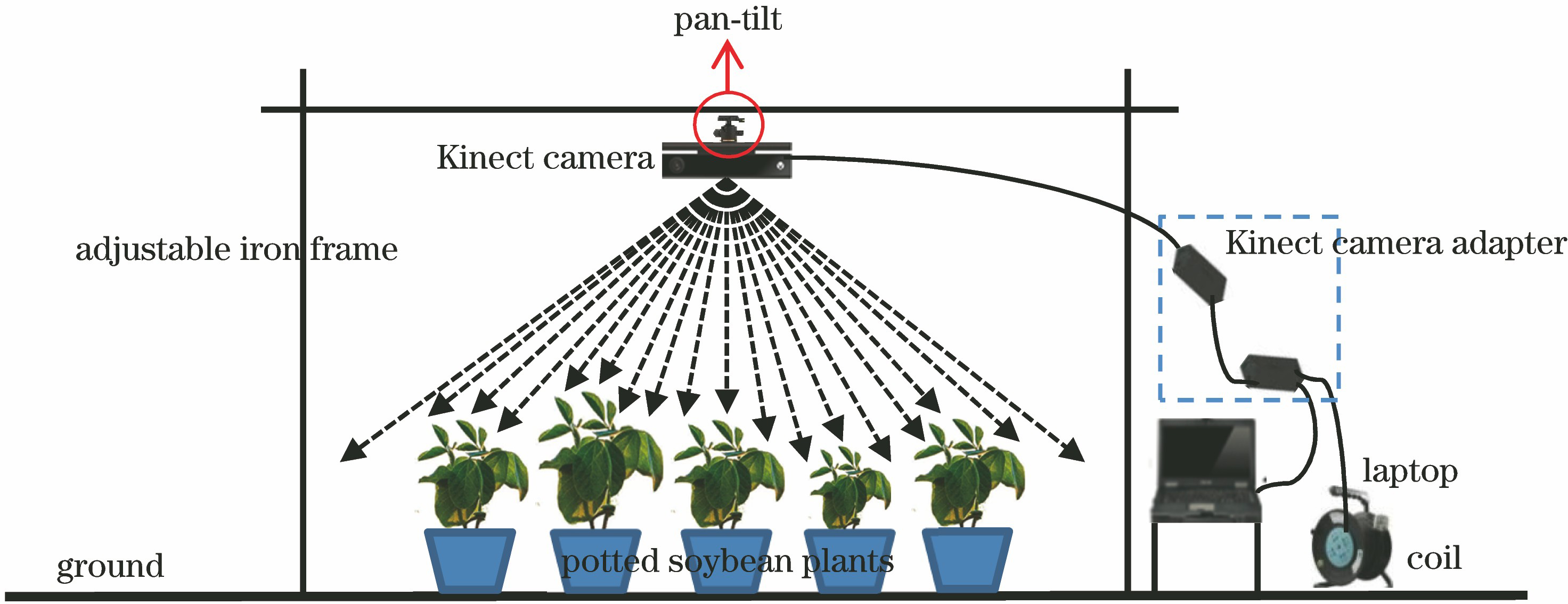

2.2 图像同步采集系统构建

构建基于Kinect 2.0的大豆冠层三维数据同步采集系统,动态采集大豆冠层彩色图像和深度信息的多源数据。该系统由Kinect 2.0相机、笔记本电脑、线圈和可上下左右调节的铁架组成。通过云台把Kinect 2.0相机安装在可调拍摄架的固定位置处,通过USB 3.0接口连接Kinect 2.0相机和笔记本电脑。Kinect 2.0由彩色摄像头(RGB Camera)、深度(红外)摄像头和红外发射器组成[21-22]。其中彩色摄像头用于拍摄彩色图像,其分辨率为1920 pixel×1080 pixel。深度(红外)摄像头用于获取红外光谱并创建可视范围内的物体深度图像,其分辨率为512 pixel×424 pixel,帧速为30 frame/s。深度数据获取范围为0.5~4.5 m,水平角度为70°,垂直角度为60°。为保证大豆正常生长,数据采集工作均在室外自然光照下进行。

2.3 采集方法

为减少光照对大豆冠层图像的影响,并保证所采集的实验图像的清晰度,选择垂直方式获取大豆冠层图像信息,并基于深度信息开展大豆株高计算方法研究。数据采集周期为7~10 d。为保证深度信息的有效性,将Kinect 2.0相机置于可调铁架中央,通过调节铁架高度寻找最佳拍摄高度。大豆株高人工测量时间在设备采集的前一天或后一天进行,测量工具为直尺,单位为cm,将所获取的测量值与计算值进行对比。

3 大豆三维点云快速重建

为构建具有颜色信息的单盆及群体大豆冠层三维结构形态,利用搭建的同步采集系统,以顶视法采集富豆9号、抗线9号和13号大豆冠层的彩色图像及其深度图像,获取的图像分别包括红、绿、蓝(R、G、B)通道的颜色分量值及

以单株抗线9号大豆为例,具有颜色信息的大豆冠层三维重建流程如

图 2. 具有颜色信息的大豆冠层三维(3D)重建流程图。(a)图像同步采集系统;(b) 深度图像;(c) 彩色图像;(d)原始三维点云;(e) 彩色图像灰度直方图;(f) 原始点云距离图;(g) 具有颜色信息的原始点云距离图;(h) 分割后大豆冠层距离图;(i) 分割后具有颜色信息的大豆冠层距离图

Fig. 2. Flow chart of three dimensional (3D) reconstruction of soybean canopy with color information. (a) Synchronous acquisition system; (b) depth image; (c) color image; (d) raw 3D point cloud; (e) gray histogram of color image; (f) distance image of raw data; (g) distance image of raw data with color information; (h) distance image of canopy after segmentation; (i) distance image of canopy with color information after segmentation

3.1 Kinect相机标定

空间物体上任意一点(

为精确标定彩色相机和深度相机,首先,分别获取Kinect 相机视场下的12组不同位置的棋盘格彩色图像和红外图像,由于红外图像与深度图像具有统一的视角和分辨率,因此可用红外图像代替深度图像作为彩色图像标定的对象。利用 MATLAB标定工具箱,分别对两个相机进行标定[25]。标定得到的棋盘格与相机的相对位置关系如

图 4. 棋盘格与相机的相对位置关系。(a) 彩色相机拍摄的棋盘格角点检测;(b) 深度相机拍摄的棋盘格角点检测

Fig. 4. Relative position relationship between checkerboard and camera. (a) Corner detection of checkerboard by color camera; (b) corner detection of checkerboard by depth camera

世界坐标系中的坐标点经过旋转平移后,可转化到相机坐标系

式中:

式中:0T=(0,0,0)。 通过上述求解运算,可得

3.2 具有颜色信息的三维点云重建

利用上述标定关系,将彩色相机坐标系转换到深度相机坐标系下,即可得到深度图像中距离值与彩色图像中颜色值的对应关系。利用MATLAB的scatter3函数实现大豆冠层三维点云的重建,重建后的三维模型仅包括形态结构信息[27]。为了重建具有完整颜色信息的大豆三维模型,对采集的点云颜色数据进行了均值融合处理。最后,根据相机间的标定关系,将点云数据的RGB颜色信息赋值到对应的深度图像中,最终重建了具有颜色信息的大豆冠层三维结构形态。

3.3 具有颜色信息的大豆冠层点云提取方法

为提高后续大豆株高计算的速度及准确性,需要对第3.2节重建后的三维点云进行分割,即将大豆冠层点云从复杂的背景点云中提取出来。在此采用最大类间方差阈值分割法确定分割阈值

上述

式中:

假设

式中:

大豆冠层像素均值为

式中:

式中:

最终求得两类间的方差

当

此时

利用求解的

图 5. 具有颜色信息的大豆冠层三维重建。(a)原始三维点云;(b)具有颜色信息的原始三维点云;(c)分割后大豆冠层三维点云距离正视图;(d)分割后大豆冠层三维点云距离侧视图;(e)具有颜色信息的大豆冠层三维点云正视图;(f)具有颜色信息的大豆冠层三维点云俯视图

Fig. 5. 3D reconstruction of soybean canopy with color information. (a) Raw 3D point cloud; (b) raw 3D point cloud with color information; (c) 3D point cloud distance image of soybean canopy after segmentation under front view; (d) 3D point cloud distance image of soybean canopy after segmentation under side view; (e) 3D reconstruction of soybean canopy with color information under front view; (f) 3D reconstruction of soybean canopy with color information under top view

4 基于深度信息的株高计算方法研究

4.1 单盆大豆株高计算

假设地面相对平坦,即地面三维点云在

式中:(

式中:

对单盆株高的计算总共进行了90次,求解平均值并将其作为最终株高值。

4.2 群体大豆株高计算

为实现高通量大豆株高计算,开展了群体的大豆株高计算方法研究。群体数据采集实验场景如

群体大豆株高的计算方法如

根据三角模型距离计算原理计算得到相机距离大豆冠层的距离为

其中:

从而得到群体图像中每盆大豆植株的株高为

5 大豆株高计算方法有效性验证

5.1 大豆冠层三维重建效果

在标定彩色图像和红外图像的基础上,遍历深度图像的所有三维点云,根据求解得到的旋转矩阵和平移矢量,将彩色图像坐标系转换到深度图像坐标系,即将颜色信息赋值于对应的点云,构建具有颜色信息的大豆冠层三维结构形态。

为清晰观察到大豆植株三维重建效果,在此以2018年7月19日获取的15盆大豆(三个品种)的冠层彩色和点云数据为例,构建其三维结构形态,三维重建效果如

图 9. 2018年7月19日获得的大豆冠层三维重建效果。(a)单盆重建;(b)群体重建

Fig. 9. 3D reconstruction effect of soybean canopy on July 19, 2018. (a) 3D reconstruction of individual soybean plant; (b) 3D reconstruction of grouped soybean plants

重建采集的所有单盆大豆冠层图像,三维重建的大豆冠层能够反映生殖生长期的大豆冠层生长状态的动态变化,且重建后的冠层点云包含颜色信息,通过提供连续的数据记录能较为真实地还原植株形态和生长状态[29]。以大豆9-5号为例,其2018年6月19日(0619)—2018年9月5日(0905)生殖生长期的冠层重建效果如

图 10. 大豆9-5号的2018年6月19日(0619)—2018年9月5日(0905)生殖生长期的冠层3D重建效果

Fig. 10. 3D reconstruction of 9-5 soybean canopy in reproductive period from June 19, 2018 (0619) to September 5, 2018 (0905)

5.2 大豆株高计算值比较结果

以重建大豆冠层点云为研究目的,对大豆株高进行计算。分别对2018年6月6日—2018年7月19日的三个品种大豆植株冠层采用了单盆大豆株高测量方法,计算值与实测值的平均误差为0.14 cm(

每种样本总数为60盆。在群体采集方式下,分别针对抗线9号、抗线13号和富豆6号三个品种进行株高计算,计算值与实测值的相关系数

图 11. 三个品种大豆株高的测量值与计算值的比较。(a)抗线9号的对比结果;(b)抗线13号的对比结果;(c)富豆6号的对比结果

Fig. 11. Comparison of manual measurement values and sensor measurement values of plant height for three soybean varieties. (a) Comparison result of Kangxian-9; (b) comparison result of Kangxian-13; (c) comparison result of Fudou-6

在大豆生长末期,大豆株高的实测值与计算值均约为50 cm。基于时间序列的三个品种大豆株高的动态变化如

图 12. 基于时间序列的三个品种大豆株高动态变化图

Fig. 12. Dynamic change of mean value of plant height for three soybean varieties based on time sequence

由

6 结论

在自然环境下,利用所设计的大豆冠层图像同步采集系统,采集了抗线9号、抗线13号以及富豆6号三个寒地大豆品种的生殖时期冠层彩色图像和深度图像数据,标定了彩色相机和深度相机,重建了以大豆生长时间为序列的发芽期、出枝期、开花期、结痂期和鼓粒期5个阶段的具有颜色信息的大豆冠层三维结构形态。在此三维重建的基础上,计算得到的单盆和群体大豆株高平均误差分别为0.14 cm和0.54 cm。抗线9号、抗线13号和富豆6号的株高计算值与人工测量值的决定系数分别为0.9717,0.9730,0.9697。该研究成果为高通量计算农作物的其他表型参数提供了一种现实可行的数据获取手段。在未来工作中,将继续利用该采集平台及技术探索大豆植株其他重要的表型特征(如茎粗、冠幅和分枝角度等)的计算方法,为进一步实现大豆植株表型参数的高通量计算提供前期技术基础。

[4] 宋祺鹏, 唐晶磊, 辛菁. 基于生长模型的苗期大豆植株三维重建[J]. 计算机工程, 2017, 43(5): 275-280.

[7] PalanichamyD, Cobb JN. Agronomic field trait phenomics[M]. New York: Springer, 2015: 83- 99.

[8] 李辉. 基于虚拟双目视觉的玉米叶片三维重建方法[J]. 科技通报, 2016, 32(5): 96-101.

[9] 李抒昊, 关海鸥, 于崧, 等. 基于FastSCAN玉米整株三维重构及参数计算方法[J]. 农机化研究, 2018, 40(4): 162-166.

[10] 蒋普, 耿楠. 基于网络摄像机的株高远程无损测量系统[J]. 农机化研究, 2015, 37(4): 68-72.

[11] 李泉, 程效军, 田芮, 等. 多站地面三维激光扫描强度数据纠正与归一化[J]. 激光与光电子学进展, 2017, 54(12): 122802.

[12] 肖杨, 胡少兴, 肖深, 等. 从三维激光点云中快速统计树木信息的方法[J]. 中国激光, 2018, 45(5): 0510007.

[13] 马晓丹, 郭彩玲, 张雪, 等. 基于三维点云颜色特征的苹果树冠层光照分布计算方法[J]. 农业机械学报, 2015, 46(6): 263-268.

[14] 马晓丹, 郭彩玲, 张雪, 等. 苹果树冠层不同光照区域叶绿素荧光性状计算方法[J]. 光谱学与光谱分析, 2016, 36(12): 3986-3990.

[17] SkerikF, VolfJ, LindaM, et al. Methods for detection of objects in agriculture, Prague[C]∥Conference Proceeding-5th International Conference, TAE 2013: Trends in Agricultural Engineering, September 3-6, 2013. Czech University of Life Sciences Prague, 2013, 599- 601.

[18] YamamotoS, HayashiS, SaitoS, et al. Measurement of growth information of a strawberry plantusing a natural interaction device[C]∥2012 Dallas, Texas, July 29-August 1, 2012. American Society of Agricultural and Biological Engineers, 2012: 121341108.

[19] 沈跃, 朱嘉慧, 刘慧, 等. 基于深度和彩色双信息特征源的Kinect植物图像拼接[J]. 农业工程学报, 2018, 34(5): 176-182.

[20] 刘明, 卜伟召, 杨文钰, 等. 山东间作大豆产量与主要农艺性状关联分析[J]. 中国油料作物学报, 2018, 40(3): 344-351.

[21] 刘刚, 张雪, 宗泽, 等. 基于深度信息的草莓三维重建技术[J]. 农业机械学报, 2017, 48(4): 160-165, 172.

[22] 余秀丽, 王丹丹, 牛磊磊, 等. Kinect 在现代农业信息领域中的应用与研究进展[J]. 农机化研究, 2015, 37(11): 216-221.

[23] 郭连朋, 陈向宁, 刘彬. Kinect传感器的彩色和深度相机标定[J]. 中国图象图形学报, 2014, 19(11): 1584-1590.

[24] 李雅娜. Kinect深度相机标定算法研究[D]. 西安: 西安电子科技大学, 2014.

Li YN. Research on calibration algorithm of Kinect depth camera[D]. Xi'an:Xidian University, 2014.

[25] 王珊, 徐晓. 基于双目单视面的三维重建[J]. 光学学报, 2017, 37(5): 0515004.

Wang S, Xu X. 3D reconstruction based on horopter[J]. Acta Optica Sinica, 2017, 37(5): 0515004.

[26] 周薇, 马晓丹, 张丽娇, 等. 基于多源信息融合的果树冠层三维点云拼接方法研究[J]. 光学学报, 2014, 34(12): 1215003.

[27] 王孟博. 基于点云的作物植株三维重建技术研究[J]. 鄂州大学学报, 2018, 25(1): 104-106, 109.

[28] . Matlab 的图像阈值分割算法研究[J]. 软件导刊, 2014, 13(12): 76-78.

[29] Guan H O, Liu M, Ma X D, et al. Three-dimensional reconstruction of soybean canopies using multisource imaging for phenotyping analysis[J]. Remote Sensing, 2018, 10(8): 1206.

[30] 朱冰琳, 刘扶桑, 朱晋宇, 等. 基于机器视觉的大田植株生长动态三维定量化研究[J]. 农业机械学报, 2018, 49(5): 256-262.

[31] CarloneL, DongJ, FenuS, et al. Towards 4D crop analysis in precision agriculture: estimating plant height and crown radius over time via expectation-maximization[C]∥IEEE ICRA Workshop on Robotics in Agriculture, May 26-30, 2015 Seattle, WA, USA, 2015.

Article Outline

冯佳睿, 马晓丹, 关海鸥, 朱可心, 于菘. 基于深度信息的大豆株高计算方法[J]. 光学学报, 2019, 39(5): 0515003. Jiarui Feng, Xiaodan Ma, Haiou Guan, Kexin Zhu, Song Yu. Calculation Method of Soybean Plant Height Based on Depth Information[J]. Acta Optica Sinica, 2019, 39(5): 0515003.