基于Lucas-Kanade算法的最大Gabor相似度大姿态人脸识别  下载: 1035次

下载: 1035次

1 引言

人脸识别技术是当代人工智能、模式识别和计算机视觉领域中热门的研究课题之一。在实际生活和科学应用中,通过人脸识别检测,得出大角度姿态是影响人脸识别结果的主要因素的结论。当输入的人脸图像是一张水平旋转角度较大的侧脸图像时,即使是同一个人的两幅图像,不同姿态反映的图像也会有很大的差异,这种差异可能会比相同姿态而不同身份的人的差异还要大[1]。这使得很多常规人脸识别算法的性能大幅下降,进而导致识别率也明显降低。

针对大角度人脸姿态的主流研究方法主要集中在三维人脸模板和二维平面技术。在三维人脸模板方面,Tang等[2]利用二维人脸重构三维虚拟人脸,然后将三维人脸进行二维投影,构建二维多姿态人脸库,将多姿态人脸识别问题转化为某一角度下两幅相同姿态照片的对比问题[3]。这种采用二维人脸重构三维虚拟人脸的思路,在一定程度上改善了姿态变化对人脸识别的影响,但三维人脸重建运算较复杂,计算量较大,难以实现实时性的要求。

在二维平面技术方面,Chai等[4]提出了局部线性回归算法(LLR),该算法假设人脸侧脸与正脸呈局部线性关系,用侧脸图像与其对应的正脸图像进行训练,得到侧脸到正脸之间的线性映射关系,进而由侧脸估计出其对应的正脸图像。为解决侧脸到正脸的非线性问题,LLR算法把人脸分成了很多个小区域,并对每个小区域分别进行线性映射,这必然会导致非线性信息的丢失。Ashraf等[5]基于LK(Lucas-Kanade)算法提出了人脸区域的流堆栈(StackFlow)算法,该算法首先将人脸划分为若干块,用仿射变换进行侧脸到正脸的校正;训练过程中使用LK算法,经仿射变化后的侧脸与正脸的误差最小;作者提出采用流堆栈算法来获得每块人脸的全局最优,即某一块的全局最优应该是使所有训练图像的对应块和正面人脸的对应块差值和最小的仿射变换参数,但是这种方法是根据像素寻找全局最优参数,所以对人脸区域的划分准确度要求较高,同时由于姿态、光照和表情等因素不完全相同,合成的正面人脸比较模糊,导致识别率较低。类似地,Ho等[6]提出了一种通过马尔可夫随机场(Markov Random Fields,MRF)寻找仿射变换参数的方法,该方法的目标函数与流堆栈算法相同,但是其每块人脸全局最优参数的确定是通过马尔可夫随机场实现的。通过构建代价函数,实现代价函数的最小化来选择最优参数,并运用BP(Belief Propagation)算法求出最优参数。但是在确定每一块最优参数时,运行BP算法非常耗时,同时确定最优参数是在某一张人脸上运行的,因此不可避免地会带上该人脸的特性信息。Li等[7]提出了基于神经网络的深度多视角特征学习(MVRL)方法,通过不同的深度学习模型来得到不同特征,进而融合为一个整体特征作为此人脸特征的表示。Yim等[8]提出多任务的深度神经网络(CPF)方法来实现人脸校正,主任务用于从输入人脸图像构建任意姿态的人脸图像,副任务用于从得到的人脸图像再反过来构造输入图像,以实现整个神经网络的反馈。Peng等[9]提出了基于深度神经网络学习的姿态校正(Multi-Source Multi-Task,MSMT)方法,首先通过正面的二维人脸生成一个三维模板,然后投影生成不同姿态的二维人脸,再在训练识别模型时将身份信息与非身份信息(如姿态和特征点)放在一起训练,得到一个包含姿态、特征点和身份的多特征,最后把侧脸的姿态特征和正面人脸的身份特征拼接在一起重新构建,以保证不同姿态的人脸得到的特征是相似的。但是基于神经网络的算法需要的训练集大,同时需要手工标定特征点,在训练阶段比较耗时。

本文主要研究人脸姿态的二维平面校正方法,采用基于加权的LK算法得到每块人脸的最优仿射变换参数,提出每一块的最优仿射变换参数应使所有训练集中这一块校正的人脸块与对应正脸块Gabor [10]相似度最大,并以每一人脸块最优参数得到的平均Gabor相似度作为这一块人脸的权重进行识别。最后,在FERET人脸数据库中进行了每块最优参数的评估和侧脸姿态的校正实验,同时进行了识别率实验,证明了所提方法的有效性。

2 基于最大Gabor相似度的人脸姿态校正

2.1 用加权LK算法求每块人脸的仿射变换参数

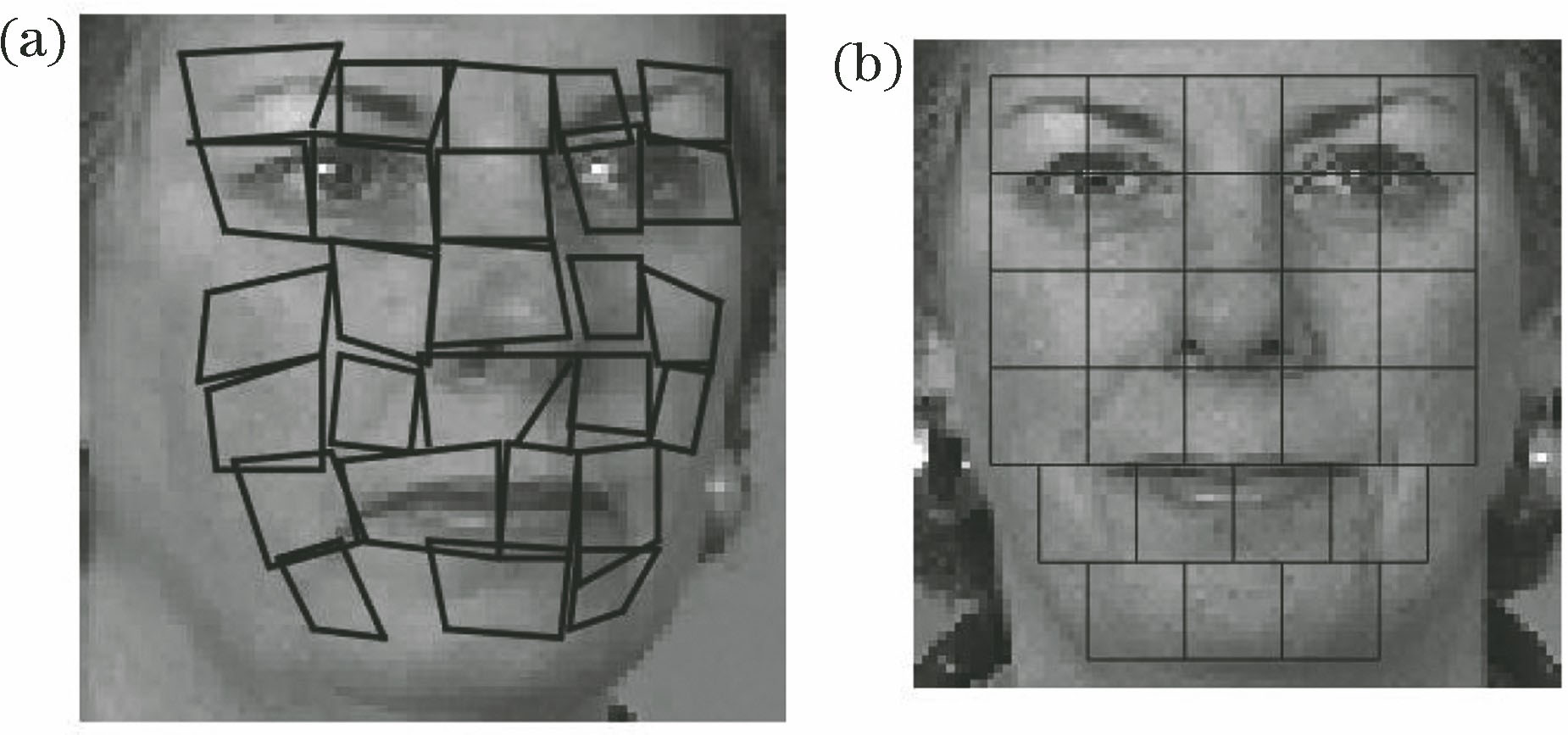

LK算法[11]是一种有效的、实现图片对齐的算法。但是在侧脸角度情况下,人脸各个区域变化的形态不同,如果对整个人脸都运用LK算法,则各个人脸区域的对齐效果较差,所以首先要对某一个特定角度的侧面和对应的正面人脸进行分块。通过Gabor滤波器的尺度和方向对图像进行滤波,将其结果作为纹理特征来选择全局最优参数。该过程基于提取到的人脸局部空间信息而不是每个点的像素差值信息,因此用于校正的侧脸和正脸分块并不需要精确的点对点对应,而是大致的局部区域对应即可。侧面和正面人脸的分块示意图如

用

仿射变换参数

使目标函数最小时对应的

式中:

假设有

式中:*代表卷积。将(4)式变换到傅里叶频域,即

式中:

(6)式中将

式中:

2.2 基于最大Gabor相似度寻找每块全局最优的仿射变换参数

如果基于像素值寻找全局最优参数,由于人脸块划分不标准、光照条件和姿态误差等因素的影响,很难保证校正参数的准确性,最终造成人脸合成效果不理想。因此,利用Gabor特征提高光照和姿态的稳健性,通过使Gabor特征向量余弦相似度最大,来寻找一个全局最优参数。

假设共有

求库中第

求库中对应第

对于第

则第

基于上述提出的Gabor相似度求取的全局最优姿态校正参数对光照变化有良好的适应性。此外,全局最优参数的选择是基于Gabor变换提取的局部空间特征,而不是利用每个点的像素信息,所以人脸校正过程中侧脸的划分不需要很精确,只需进行粗略的侧脸区域划分即可通过全局最优参数得到清晰的正面人脸。

2.3 基于加权的分块Gabor向量人脸识别

考虑到姿态校正过程中采用的是基于人脸分区域的Gabor特征校正方法,所以加权的局部Gabor二值模式直方图序列(LGBPHS)算法[13]更适用于上述姿态校正后进一步的人脸识别。由于本方法基于局部分块,而每个局部块在识别整个人脸中所起的作用大小不一,且根据最优校正参数拟合的局部块也有相对的优劣之分,因此提出为每块人脸设定一个权重值,以提高最终的识别率。

按照上述人脸分块,将不同尺度、不同方向的Gabor滤波器分别与侧脸校正的图片块和库中正脸对应块进行卷积,取其幅值部分组成Gabor幅值图谱(GMM),对每个人脸区域的GMM应用局部二值模式(LBP)算法得到局部Gabor二值模式图谱并计算直方图,将所有区域直方图串接为一个直方图序列,并将其作为这一块人脸图像的描述符。

假设两个直方图是

式中:

采用加权的局部Gabor二值模式直方图序列算法进行人脸识别,即对上述每块人脸添加权重系数。假设灰度区间为[0,

式中:

最终每个人脸的直方图可表示为

式中:

式中:

设定第

最后,找到使

3 实验结果与分析

本实验采用FERET人脸数据库[14]进行实验。该数据库包含约200人,共14051张灰度人脸图像,同一个人包含不同的表情、光照和姿态图片。在训练过程中,每一种角度都采用前60个人(身份ID从1到60)的

提取Gabor特征时,Gabor内核定义为

根据每一块得到的最优参数进行了三部分实验,分别是关于最优参数的评估、侧脸的姿态校正和侧脸识别实验。本实验使用MATLAB语言,在Intel(R) i5-3230M处理器上运行。

3.1 评估得到的每块最优参数

本实验测试了同一角度下(40°)60个人(身份ID从61到120)的侧脸区域经过最优参数校正后的侧脸块与正脸块Gabor余弦相似度,其中实验的第1,7,9,15块(根据

图 2. 基于最优参数的Gabor相似度表现。(a)第1块;(b)第7块;(c)第9块;(d)第15块

Fig. 2. Performance of Gabor similarity based on optimal parameter. (a) 1st patch; (b) 7th patch; (c) 9th patch; (d) 15th patch

3.2 通过每块最优参数校正人脸

本部分实验不仅使用FERET人脸数据库,还选取了CMU_PIE人脸数据库[15]的图片进行测试。CMU_PIE数据库规模不大,仅有68个人,共41368张人脸图片,但含有更多丰富光照变化的图片。实验对人脸库中标定为±40°的侧脸进行校正,此外还实际拍摄了侧脸图片进行实验。效果如

图 3. 基于Gabor最优参数和像素差最优参数校正后的人脸对比

Fig. 3. Synthesizing frontal face comparison based on Gabor optimal parameters and pixel difference optimal parameters

从上述结果可以看出,在光照不均匀的条件下,根据Gabor特征得到的最优变换参数依然适用,所以得到的全局最优参数对光照有一定的稳健性。另外,虽然数据库中标定的角度有误差(前后相差10°左右),但是恢复出来的正面人脸基本是清晰的。从这一点可以看出,全局最优参数对姿态也具有一定的稳健性。同样情况下(人脸分块也是粗略划分的),如果是根据像素差最小得到的最优参数对侧脸进行校正,得到的效果图非常模糊,这是因为依据像素差值最小寻得的最优参数对人脸分块的准确性有很大的依赖。

3.3 侧脸的识别率

侧脸识别实验在FERET人脸数据库中进行,测试了身份ID从61到190共130个人的对应角度的侧脸图片,即每个角度测试数据为130张图片,并与其他方法进行了对比。实验对比方法主要选择与本文分块提取相似度思想相似的3种经典方法,即文献[

4-6]中的方法,同时对比了近年来较热门的基于深度学习的方法,即文献[

7-9]中的方法。实验结果如

表 1. 若干方法在FERET人脸数据库中的识别率对比

Table 1. Comparison of recognition rates of different approaches on FERET database

| ||||||||||||||||||||||||||||||||||||||||||||

从

对于基于深度学习的几种方法,整体识别率都较高,但这些方法对硬件设备和训练数据规模的要求均较高。对于CPF方法(训练集用了14000张图片),虽然整个神经网络有反馈,可以得到任意姿态的人脸图像,但是图片的校正过程需要对图像另外添加一些编码信息,而且提取的各个角度特征的区分度并不太好。MVRL方法(训练集用了30000张图片)通过不同深度学习模型提取的特征有些冗余,并且只利用了纹理特征而没有对形状特征进行区分,因而需要的训练图像数量要求规模更大。而最新的基于深度神经网络学习的MSMT方法,训练集用了106402张图片,计算量极大。相比而言,所提方法操作简单,对硬件设备要求不高,在数据规模小的情况下具有高效率和高精度的优势。

4 结论

大姿态已成为限制人脸识别率提高的主要因素。采用基于加权的LK人脸分块算法分析可知,每一人脸块的全局最优参数是使得Gabor特征的余弦相似度最大的参数,同时将根据最优参数得到的平均Gabor相似度作为姿态识别中的权重可以提高识别率。所提方法的优点在于数据规模小的情况下具有独特优势,以少量训练样本和较短训练时间即可得到理想的结果,并且无需进行任何标定点的检测,对人脸的分块进行粗略划分即可。下一步的研究应将深度神经网络学习与本文方法所提取的Gabor参数相结合,以便更加高效地得到清晰的正脸图片和更高的识别精度。

[2] Tang H, Yin B, Sun Y. et al. Pose-invariant face recognition based on a single view[J]. Journal of Information and Computer Science, 2010, 7(12): 2369-2379.

[3] 童莹, 魏以民, 沈越泓. 基于全局约束的监督稀疏保持投影降维方法研究[J]. 光学学报, 2018, 38(9): 0910001.

[4] Chai XJ, Shan SG, Chen XL, et al. Local linear regression (LLR) for pose invariant face recognition[C]∥7th International Conference on Automatic Face and Gesture Recognition (FGR06), April 10-12, 2006, Southampton, UK. New York: IEEE, 2006: 631- 636.

[5] Ashraf AB, LuceyS, ChenT. Learning patch correspondences for improved viewpoint invariant face recognition[C]∥2008 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2008, Anchorage, AK, USA. New York: IEEE, 2008: 4587754.

[7] LiJ, ZhaoJ, ZhaoF, et al. Robust face recognition with deep multi-view representation learning[C]∥Proceedings of the 24th ACM International Conference on Multimedia, October 15-19, 2016, Amsterdam, Netherlands. New York: ACM, 2016: 1068- 1072.

[8] YimJ, JungH, YooB, et al. Rotating your face using multi-task deep neural network[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 676- 684.

[9] PengX, YuX, SohnK, et al. Reconstruction-based disentanglement for pose-invariant face recognition[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1632- 1641.

[11] Lucas BD, KanadeT. An iterative image registration technique with an application to stereo vision[C]∥Proceedings of 7th International Joint Conference on Artificial Intelligence, August 24-28, 1981, Vancouver, British Columbia. San Francisco: Margan Kaufmann Publishers Inc., 1981: 674- 679.

[12] Ashraf AB, LuceyS, ChenT. Fast image alignment in the Fourier domain[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2480- 2487.

[13] Zhang WC, Shan SG, GaoW, et al. Local Gabor binary pattern histogram sequence (LGBPHS): a novel non-statistical model for face representation and recognition[C]∥Tenth IEEE International Conference on Computer Vision (ICCV'05) Volume 1, October 17-21, 2005, Beijing, China. New York: IEEE, 2005: 786- 791.

Article Outline

程超, 达飞鹏, 王辰星, 姜昌金. 基于Lucas-Kanade算法的最大Gabor相似度大姿态人脸识别[J]. 光学学报, 2019, 39(7): 0715005. Chao Cheng, Feipeng Da, Chenxing Wang, Changjin Jiang. Pose Invariant Face Recognition Using Maximum Gabor Similarity Based on Lucas-Kanade Algorithm[J]. Acta Optica Sinica, 2019, 39(7): 0715005.