一种基于IGA的融合点云和影像的建筑物提取方法

1 引言

随着高分遥感影像的普及和光学遥感技术的成熟,利用遥感影像的光谱特性已可以对建筑物进行较为精准的二维提取。卢麒[1]等提出了一种多层次感知网络,利用空间金字塔模块提取不同尺度下的浅层和深层建筑特征,高精度提取多源影像中的建筑物。冯凡[2]等提出了一种高效的尺度自适应全卷积网络,融合多特征、跨尺度特征,优化初始聚合特征集合,提升了网络对不同类型遥感影像建筑物的提取效果。然而,但由于高程数据的缺失和“异物同谱,同物异谱”的现象存在,单独依靠影像进行变化检测的技术仍有很大的改进空间[3]。

LiDAR(Light Detection and Ranging,LiDAR)技术是一种主动的遥感技术,可得到目标物精准的空间位置信息,包含高程,强度和回波等。已有很多研究实现了基于点云的三维建筑物提取。Zhao[4]等使用动态调参和改进的随机样本一致性方法提取大、小面积屋顶,显著提高了屋顶面提取的准确性。Du[5]等提出了一种结合点和网格特征从LiDAR点云数据中提取建筑物的方法,该方法对大尺寸LiDAR数据也有较好的提取效果。Hujebri[6]等通过正射影像的光谱信息区分植被和建筑物,并用均值漂移算法检测建筑物,该方法在地表复杂的密集城市区显示出良好的性能。蔡湛[7]等采用最小二乘法对屋顶面边缘点进行拟合外扩,提取交点作为建筑物顶面的边缘点,提高了屋顶轮廓线的提取精度。然而,有限的点云密度、随机的点云分布和复杂的建筑物环境,会造成点云数据质量不佳,特征提取失效,最终导致建筑物点云提取失败。

随着遥感数据多样化,多源数据的融合成为必然趋势[8]。点云数据可以反映地物的空间结构特征,但其离散性可能导致部分特征的缺失;遥感影像可以提供丰富的颜色信息,连续的几何特征,能很好地反映地物样貌,补充建筑物特征。狄玮琪[9]结合影像和点云生成的nDSM,使用注意力机制对深度学习的网络性能进行改进,实现建筑物高精度提取。王朝莹[10]等融合遥感影像与LiDAR点云多尺度深度特征,利用特征连接结合卷积、反卷积的方式,实现特征融合与交互,引入基于加权交叉熵的损失函数,提高了实验精度。Chen[11]等利用图几何矩(GGM)卷积编码点集的局部几何结构,提出一种配备GGM卷积的分层架构,用于训练和识别建筑物点。因此,基于融合数据的建筑物提取可以综合多种数据的优势,精确提取建筑物。但现阶段基于深度学习的方法需要大量训练样本和训练时间,过程繁琐;且使用的数据大多非原始点云与影像,一定程度上降低了准确性与可靠性。直接提取原始点云和影像的多维数据特征,并基于分类器提取建筑物,可以最大程度保证数据的真实性,减少大量样本标注工作,提高结果精度和效率。

特征维度过高会导致时间复杂度的增加,相关性高的不同特征之间存在冗余。因此需要降低特征维数,简化特征矩阵,提高建筑物提取效率。特征选择的本质是组合优化问题,通常通过群体智能算法解决。常用算法有:遗传算法(Genetic Algorithm,GA)[12]、粒子群(Particle Swarm Optimization,PSO)[13]、萤火虫算法(Firefly Algorithm,FA)[14]、樽海鞘群算法(Slap Swarm Algorithm,BSSA)[15]等。GA算法具有快速随机搜索能力和计算时间少、鲁棒性高等优点,但复杂特征和较高的维数会导致效率降低。为使训练能够快速稳定收敛到最优解,本文通过改进GA算法来获取建筑物提取的最优特征子集。综上,本文基于密度、高程、回波次数等提取不同邻域的点云特征,融合航空影像的纹理特征后,采用遗传算法进行特征优化,得到特征子集。依据这些优化特征,高效、准确地实现建筑物的提取。

1 算法原理及步骤

1.1 算法流程

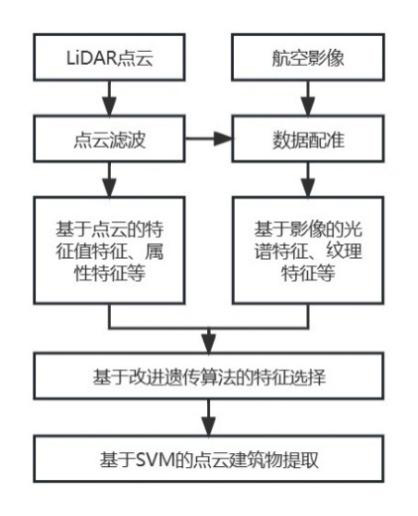

本文首先对原始点云进行预处理,实现点云与影像的配准。再提取点云的局部特征,结合遥感影像的彩色纹理特征,得到多维特征集合。随后采取改进的遗传算法对特征进行筛选,去除部分相关性大的特征,减少特征维数。再利用优化后的特征高效训练随机森林模型,对点云进行监督分类,实现建筑物提取。流程如

1.2 特征提取

1.2.1 点云特征

点云数据是指三维坐标系统中的一组向量的集合,反映了目标物精确的空间位置。点云与其邻域内的点的空间位置关系反映了点云的局部空间结构特征,通过这些特征可以有效地区分不同地物类型。同时,不同大小和类型的邻域,展现出来的特征也各不相同。点云的局部特征可以通过点云邻域协方差矩阵获得,相比协方差矩阵的特征向量,协方差矩阵的特征值(λ1,λ2,λ3)具有旋转不变性[16],可以更好的提取点云特征。组合计算中心点的三个特征值λ1,λ2,λ3,可产生一系列描述该点局部分布情况的特征描述子,作为点云分类的判断依据。原始的点云数据还包括强度,高程,回波等信息。本文使用的点云特征主要包括:基于特征值的特征、基于点云密度的特征和基于高程的特征。计算中使用点云特征的具体含义和公式如

表 1. 点云邻域特征

Table 1. Neighborhood features of points

|

λ1、λ2和λ3是中心点的特征值,通过计算其邻域点集的协方差矩阵来获得。通过特征值间的运算得到点云的一系列结构特征,包括特征值和(SU)、总方差(TV)、特征值熵(EI)、各向异性(AN)、平面度(PL)、线性度(LI)、表面粗糙度(SR)和球形度(SP)。AN表示邻域内点沿三个垂直轴分布的均匀性,有利于区分建筑物与植被。PL是指点云平面度,较高的PL值的点集平面结构更加明显,例如建筑物的屋顶。LI代表点云的线性度,显示邻域内点的线性程度,线性度高的对象如电力线。SR反映了邻域内所有点空间分布的不规则性。通常,由于植被点云分布杂乱离散,其粗糙度较高,然而,建筑物屋顶等平面物体的粗糙度较低。

点云数据还包含密度,强度,高程,回波等信息。密度特征反映了点云的空间分布特点,可以精确描述点云几何特征。强度特征反映了地物的反射属性,平均强度AI代表了邻域所有点强度的平均值。基于高度的特征包括HA(向上高差)、HB(向下高差)和NHV(邻域高程方差)。HA代表当前点与邻域中最高点间的高度差。HB代表当前点与最低点之间的高度差。NHV代表当前点与邻域中所有点高程均值间的高度差。对于高程发生突变的物体,可通过较高的NHV值清晰的区分出来,如建筑物立面[17]。

上述基于特征值、高程和密度的特征,结合不同类型和半径的邻域,可以扩展得到具有相当维度的特征向量,用于点云的特征描述。与单尺度特征相比,可以更有效地提取建筑物点云[18]。

1.2.2 影像特征

点云和影像精确配准后,利用其二维坐标与影像像素位置的对应关系,可得到每个点对应的影像特征作为补充特征,包括基于RGB的特征和基于纹理的特征。

受图像数据波段算法的启发,本文利用三个波段的组合设计红色度,绿色度,蓝色度三项指标作为点云的RGB特征。以绿色度为例,计算方法为绿色波段反射值与其余两波段反射值之和的比。植被与建筑物相比,在绿色波段具有反射峰,因此绿色度可以有效地区分植被和建筑物。

受灰度共生矩阵的彩色图像纹理特征提取方法的启发(color GLCM,CGLCM)[19],本文使用CGLCM方法提取影像的彩色纹理特征。参考陈美龙等[20]实验得出角二阶矩、同质性、相关性、逆差距等14个纹理特征值间存在部分冗余的结论,本文取互不相关且具有良好分辨能力的角二阶矩、熵、对比度和相关性4个纹理特征,作为影像的纹理特征。

本文使用的遥感影像包含RGB三个波段,由GLCM的计算公式得,CGLCM 的计算公式为:

式中:

因此,当

式中 FE(z)为矩阵z的纹理特征值。最后对向量FV的9个分量求均值

综上,本文中影像特征的种类、含义和公式如

表 2. 影像特征

Table 2. Images features

|

提取影像彩色纹理特征的具体步骤如下:

1)选择5×5的滑动窗口[19];

2)选择步距δ,本文选择 δ=1,即对中心像素进行运算,并与直接相邻的像素进行比较;

3)选择θ为 0°、45°、90°、135°四个方向。本文取四个方向特征结果

4)计算小窗图像的CGLCM,计算相关特征分配给中心像素。然后将窗口移动到下一个像素,得到新的小窗口图像,重复计算过程,直到整个图像计算完成。

1.3 特征融合

在提取点云空间特征和影像纹理特征后,需要将纹理特征分配给点云,以扩展点云的特征维度。由于点云和图像在预处理中已经实现了高精度配准,因此点云和图像在XY平面上具有精确的空间位置对应关系。因此,在XY方向上投影点云,每个点都会落在某个像素内。根据1.1.2,基于GLCM对每个像素点进行计算得到一系列纹理特征图像,将像素内的所有纹理特征分配给落在像素点内的点,实现点云特征矩阵的维数扩展,相关原理如

在图中,Pti代表某个像素内的点,总共有n个,ai到ki代表该点的所有点云空间特征,Ai到Li代表该像素的所有基于GLCM的纹理特征。因此,点云的特征空间从{ai,bi,…,ki}扩展到{ai,bi,…,ki,Ai,Bi,…,Li}。

1.4 特征选择与优化

特征选择的本质是从融合后的特征集中选择最具代表性和最优的特征子集。对于本文实验,最优子集是指经训练得到最优分类模型的特征子集。需要进行特征选择的原因主要有以下三点:a)存在对分类有不利影响的特征,某些特征在本实验中可能不利于分类器的训练,甚至会降低分类的准确率,需要剔除;b)一些特征间存在较大相关性,由于半径和邻域类型的不同,同类型特征会产生多个特征向量,可能包含大量冗余信息;c)通过选择进行特征优化。在分类器的训练中,不同特征对训练有不同程度的正向影响。选取对分类器训练效果更优的特征,是提高结果精度的关键。

特征选择的流程图如

1.4.1 特征选择算法

本文采用改进的遗传算法(Improved Genetic Algorithm,IGA)进行特征选择与降维。具体为:改变染色体的编码方式,使之适用于特征选择;在传统遗传操作(选择、交叉和变异)的基础上,增加重复过滤器(REfilter),提高特征选择效率。

染色体由二进制字符串组成,代表了不同特征组合形成的各个子集,每个特征可视为其上的一个基因。如果选择了某一特征,则该特征对应的位置基因为1,否则为0。由此得到的不同染色体对应不同的特征组合,通过训练后生成的特征分类模型也具有不同的分类效果。在达到遗传算方法的迭代循环次数后,可以得到满足需要的染色体,其01编码对应最优特征子集。编码原理图如

为提高实验效率,本文设计了重复特征过滤器(REfilter)。该过滤器位于传统的遗传操作之后,用于筛选出连续十次编码均为0或1的特征,并将其永久剔除或保留。

1.4.2 目标函数

本实验中,使用支持向量机(SVM)二分类模型实现建筑物点云的提取。为了提高分类的准确率,减少分类器的训练时间,选择的特征子集需要尽可能具有代表性,并且维度尽可能低。所以在设计适应度函数时,函数值的大小需要由特征维度和分类精度两项指标决定。分类精度越高,特征维数越小,适应度值就应越高,表示分类更高效准确。因此,本文设计了一种适应度函数的计算方法。首先,根据SVM训练的分类器对测试集进行分类,将预测结果与真实标签进行比较并计数,得到分类混淆矩阵,计算TP(True Positive)、FP(False Positive)、TN(True Negative)、FN(False Negative)四项指标,并得出P(Precision)和R(Recall)。最后使用F1值来评价分类精度,如

然而特征集合的维度越高,SVM分类器分类速度越慢。因此,应添加基于训练特征子集维度的惩罚措施。本文设计的最终适应度函数如

2 实验分析

2.1 实验数据

本文选择ISPRS的公开数据集对方法进行精度测试,之后使用实际生产数据验证方法的稳定性。实验环境为拯救者R9000P笔记本,AMD Ryzen™ 7 5 800 H,3.2 GHz CPU,32.0 GB内存,Windows11 64位操作系统。

ISPRS的公开数据集Vaihingen采集自德国的Vaihingen地区,包含三个area1、area2和area3三个实验区,并提供每个区域的正射影像、点云和DSM等数据。正射影像分辨率为0.09 m,点云平均密度为4pts/m2。

实际生产数据1正射影像分辨率为0.2 m,点云平均密度为30 pts/m2;实际生产数据2正射影像分辨率为0.5 m,点云平均密度为30 pts/m2。

实验首先采用

为验证实验的先进性和普适性,采用

2.2 实验结果及分析

本文基于与影像融合后的地物点云,提取1.1中描述的点云特征和影像特征。其中,基于点云提取球形邻域和圆柱形领域时,根据经验将邻域半径设置为1m和2m,提取的点云特征和影像特征共计82维。实验对数据集Vaihingen进行分层抽样,在每一次迭代中,随机选取20%的数据点训练分类器,余下80%的点作为精度验证数据。设置算法的选择率(代沟率)0.6,交叉率0.9,变异率0.1,初始种群数量为20,为以更少的迭代次数获得收敛结果。

2.2.1 Vaihingen数据集结果

Vaihingen的三个实验区特征集合经过特征优化后,特征数量从82维降低至12维,大大降低了训练所需特征维数,减少了特征冗余。保留的特征为:特征熵(k=5),平面度(k=5),表面粗糙度(k=5),各向异性(k=5),特征熵(r=1 m),平面度(r=1 m),表面粗糙度(r=1 m),平均强度(r=2 m),向下高差(r=2 m),绿色度(r=1),对比度和熵,包含光谱纹理特征和点云特征,证明点云和影像均存在可提高结果精度的特征。

实验采用ISPRS官方提供的参考数据进行定量评价。采用的指标包括基于面积(per-area)、目标(per-object)、面积大于50 m2的目标(per-object>50 m2)的完整率(%),正确率(%)以及质量(%)(见文献[21])。基于目标的指标中,提取结果与参考数据之间的重叠率不小于50%即记为无误。三个实验区提取精度如

表 3. Vaihingen实验结果(%)

Table 3. Experiments results of Vaihingen (%)

|

表 4. 与其它方法精度对比(%)

Table 4. Comparison with other methods (%)

|

通过

2.2.2 实际生产数据结果

用于实际生产的两个实验区特征集合经过特征优化后,特征数量从82维降低至10维。保留的特征为:特征熵(k=5),平面度(k=5),各向异性(k=5),表面粗糙度(r=1 m),平均强度(r=2 m),向下高差(r=2 m),绿色度(r=1),相关性,对比度和熵,包含光谱纹理特征和点云特征,证明某些特征对建筑物提取具有显著效果。实验采用3.2.1中的评定标准对实验结果进行定量评价。实验精度如

表 5. 实际生产数据实验结果(%)

Table 5. Experiments results of production data (%)

|

从

3 结论

本文基于改进的遗传算法,提出了融合LiDAR点云和航空影像的建筑物点云提取方法,通过提取点云特征和影像彩色纹理信息特征,借助SVM分类器和改进的遗传算法对特征进行优化降维。本文的实验方法将两组实验区的特征维数从82维分别降低至12维和10维,在保证特征具有代表性的基础上,提高了分类器训练的效率。优化后的特征组合训练的分类器在ISPRS公开数据集Vaihingen上获得了最优的完整率(96.7%,94.3%),优于网站上其它建筑物提取算法,同时获得了较高的正确率(98.0%,98.3%);在实际生产数据集上也获得了极高的完整率和正确率,提高了建筑物点云的提取精度,且证明了实践方法的普适性。观察两组优化选择后的特征,影像特征在建筑物提取中均起到了显著的作用,进而说明了本文方法的正确性和优越性。获得高精度的建筑物点云后,拟合建筑物边缘并规则化是下一步的研究方向。

[1] 卢麒, 秦军, 姚雪东, 等. 基于多层次感知网络的GF-2遥感影像建筑物提取[J]. 国土资源遥感, 2021, 33(02): 75-84.

Lu Qi, Qin Jun, Yao Xue-Dong, et al. Buildings extraction of GF-2 remote sensing image based on multi-layer perception network[J]. Remote Sensing for Natural Resources, 2021, 33(02): 75-84.

[2] 冯凡, 王双亭, 张津, 等. 基于尺度自适应全卷积网络的遥感影像建筑物提取[J]. 激光与光电子学进展, 2021, 58(24): 459-470.

Feng Fan, Wang Shuang-Ting, Zhang Jin, et al. Building Extraction from Remote Sensing Imagery Basedon Scale-Adaptive Fully Convolutional Network[J]. Laser & Optoelectronics Progress, 2021, 58(24): 459-470.

[3] Reba M, Seto K C. A systematic review and assessment of algorithms to detect, characterize, and monitor urban land change[J]. Remote Sensing of Environment, 2020, 242(1): 111739.

[4] Zhao R, Pang M, Wei M. Accurate extraction of building roofs from airborne light detection and ranging point clouds using a coarse-to-fine approach[J]. Journal of Applied Remote Sensing, 2018, 12(2): 1.

[5] Du S, Zhang Y, Zou Z, et al. Automatic building extraction from LiDAR data fusion of point and grid-based features[J]. Isprs Journal of Photogrammetry & Remote Sensing, 2017, 130: 294-307.

[6] Hujebri B, Ebrahimikia M, Enayati H. Automatic Building Extraction from LIDAR Point Cloud Data in the Fusion of Orthoimage[J]. Copernicus GmbH, 2019.

[7] 蔡湛, 李如仁, 李新科, 等. 一种基于激光点云数据的房屋轮廓线提取方法[J]. 地理与地理信息科学, 2021(2013-5): 17-21.

CAI Zhan, LI Ru-Ren, LI Xin-Ke, et al. Building Roof Boundary Extraction from LiDAR Point Cloud[J]. Geography and Geo-Information Science, 2021(2013-5): 17-21.

[8] Reba M, Seto K C. A systematic review and assessment of algorithms to detect, characterize, and monitor urban land change[J]. Remote Sensing of Environment, 2020, 242(1): 111739.

[9] 狄玮琪. 基于深度学习的点云与影像联合建筑物提取方法[D]. 桂林理工大学. 2021.

DIWei-Qi. Building Extraction Using the Fusion of Point Cloud and Image Base on Deep learning Method[D]. Guilin :Guilin University of Technology. 2021.

[10] 王朝莹, 邢帅, 戴莫凡. 遥感影像与LiDAR点云多尺度深度特征融合的地物分类方法[J]. 测绘科学技术学报, 2021, 38(6): 8.

WANG Zhao-Ying, XING Shuai, DAI Mo-Fan. A Method of Ground Object Classification Based on Multi-scale Deep Feature Fusion of Remote Sensing Image and LiDAR Point Cloud[J]. Journal of Geomatics Science and Technology, 2021, 38(6): 8.

[11] Chen S, Shi W, Zhou M, et al. Automatic Building Extraction via Adaptive Iterative Segmentation with LiDAR Data and High Spatial Resolution Imagery Fusion[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020(99): 1-1.

[12] Babatunde O H, Armstrong L, Leng J, et al. A genetic algorithm-based feature selection[J]. British Journal of Mathematics & Computer Science, 2014, 5(4): 889-905.

[13] KennedyJ, EberhartR C. A discrete binary version of the particle swarm algorithm[C]. 1997 IEEE International conference on systems, man, and cybernetics. Computational cybernetics and simulation, Orlando, FL, USA: IEEE, 1997, 5: 4104-4108.

[14] MazaS, ZouacheD. Binary Firefly Algorithm for Feature Selection in Classification[C]//2019 International Conference on Theoretical and Applicative Aspects of Computer Science (ICTAACS), Skikda, Algeria: IEEE, 2019: 1-6.

[15] Tubishat M, Idris N, Shuib L, et al. Improved salp swarm algorithm based on opposition based learning and novel local search algorithm for feature selection[J]. Expert Systems with Applications, 2020, 145: 113-122.

[16] Meng F, Wang X, Shao F, et al. Energy-Efficient Gabor Kernels in Neural Networks with Genetic Algorithm Training Method[J]. Electronics, 2019, 8(1).

[17] Lei H, Jiang G, Quan L. Fast Descriptors and Correspondence Propagation for Robust Global Point Cloud Registration[J]. IEEE Transactions on Image Processing, 2017, 26(8): 3614-3623.

[18] FuY.; ChiangH. D. Toward Optimal Multiperiod Network Reconfiguration for Increasing the Hosting Capacity of Distribution Networks. IEEE Trans. Power Deliv. 2018, 33, 2294–2304.

[19] 侯群群, 王飞, 严丽. 基于灰度共生矩阵的彩色遥感图像纹理特征提取[J]. 国土资源遥感, 2013(4): 7.

HOU Qun-Qun, WANG Fei, YAN Li. Extraction of color image texture feature based on gray-level cp-occurrence matrix[J]. Remote Sensing for Natural Resources, 2013(4): 7.

[20] 苑丽红, 付丽, 杨勇, 等. 灰度共生矩阵提取纹理特征的实验结果分析[J]. 计算机应用, 2009, 29(4): 1018-1018.

Yuan Li-Hong, Fu Li, Yang Yong, et al. Analysis of texture feature extracted by gray level co-occurrence matrix[J]. Journal of Computer Applications, 2009, 29(4): 1018-1018.

[21] ROTTENSTEINER F, SOHN G, GERKE M, aal et. Results of the ISPRS Benchmark on Urban Object Detection and 3D Building Reconstruction[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 93: 256-271.

Article Outline

赖旭东, 骈蔚然, 薄立明, 何丽华. 一种基于IGA的融合点云和影像的建筑物提取方法[J]. 红外与毫米波学报, 2024, 43(1): 116. Xu-Dong LAI, Wei-Ran PIAN, Li-Ming BO, Li-Hua He. A building extraction method based on IGA that fuses point cloud and image data[J]. Journal of Infrared and Millimeter Waves, 2024, 43(1): 116.