基于特征融合与子空间学习的行人重识别算法  下载: 1149次

下载: 1149次

ing at the problem that the existing person re-identification algorithm cannot be adapted well to the variances of illumination, attitude and occlusion, a novel person re-identification algorithm based on feature fusion and subspace learning is proposed, in which the Histogram of Oriented Gradient (HOG) feature and the Hue-Saturation-Value (HSV) histogram feature are first extracted from the entire pedestrian image as the overall feature and then the Color Naming (CN) feature and the two-scale Scale Invariant Local Ternary Pattern (SILTP) feature are extracted in a sliding window. In addition, in order to make this algorithm have better scale invariance, the original images are first down-sampled twice and then the above features are extracted from the sampled images. After the features are extracted, a kernel function is used to transform the original feature space into a nonlinear space, in which a subspace is learned. Simultaneously, in this subspace, a similarity function is learned. The experiments on three public datasets are conducted and the results show that the proposed algorithm can be used to improve the re-identification rate relatively well.

1 引言

行人重识别被普遍认为是一个图像检索的子问题,主要解决的问题是从其他摄像头所拍摄的图像中集中检索是否存在当前摄像头中感兴趣的目标人物。然而,如果摄像机的分辨率较低,所处的位置不同,会导致所拍摄到的图像在光照、姿态、视角、遮挡等方面产生很大差异,这些问题给重识别带来了很大的挑战。

行人图像的特征表达和相似性度量是行人重识别的两个关键问题。在特征表达方面,Farenzena等[1]通过分割法将图片中的背景剔除,再对行人图像进行对称和不对称部件分割,对分割后的不同区域分别提取重复度高的结构区域、极大稳定颜色区域和带权重的颜色直方

近年来,深度学习[9]也被应用于行人重识别算法的研究中,并在大数据集上取得了不错的识别效果。Zheng等[10]将校验模型和识别模型相结合,并采用交互熵损失函数得到一个更具判别性的行人特征描述子。陈兵等[11]采用卷积神经网络,通过改善样本之间距离关系的约束和增强样本监督信息的使用来达到提高识别率的目的。但是,由于深度学习需要的数据集较大(在小数据集上会导致过拟合),对于不同问题所需要的模型不相同,在理论方面还缺乏一定的指导,因此具有较大的主观性。

为了解决目前行人重识别中存在的问题,本文在现有算法的基础上提出一种新的算法。在特征提取前,对图像进行预处理以增强图像的可处理性。预处理后,对行人图像分别提取局部特征和整体特征,再利用核函数将所提取的特征转换到非线性空间,在非线性空间学习一个子空间,最后在子特征空间学习一个测度矩阵进行相似度度量。选取HOG直方图作为整体特征,在局部部件上选取要提取的特征为颜色命名(CN)特征和两个尺度的尺度不变局部三元模式(SILBP)特征。核函数主要选取效果较好的RFB-

2 特征选择与提取

2.1 图像预处理

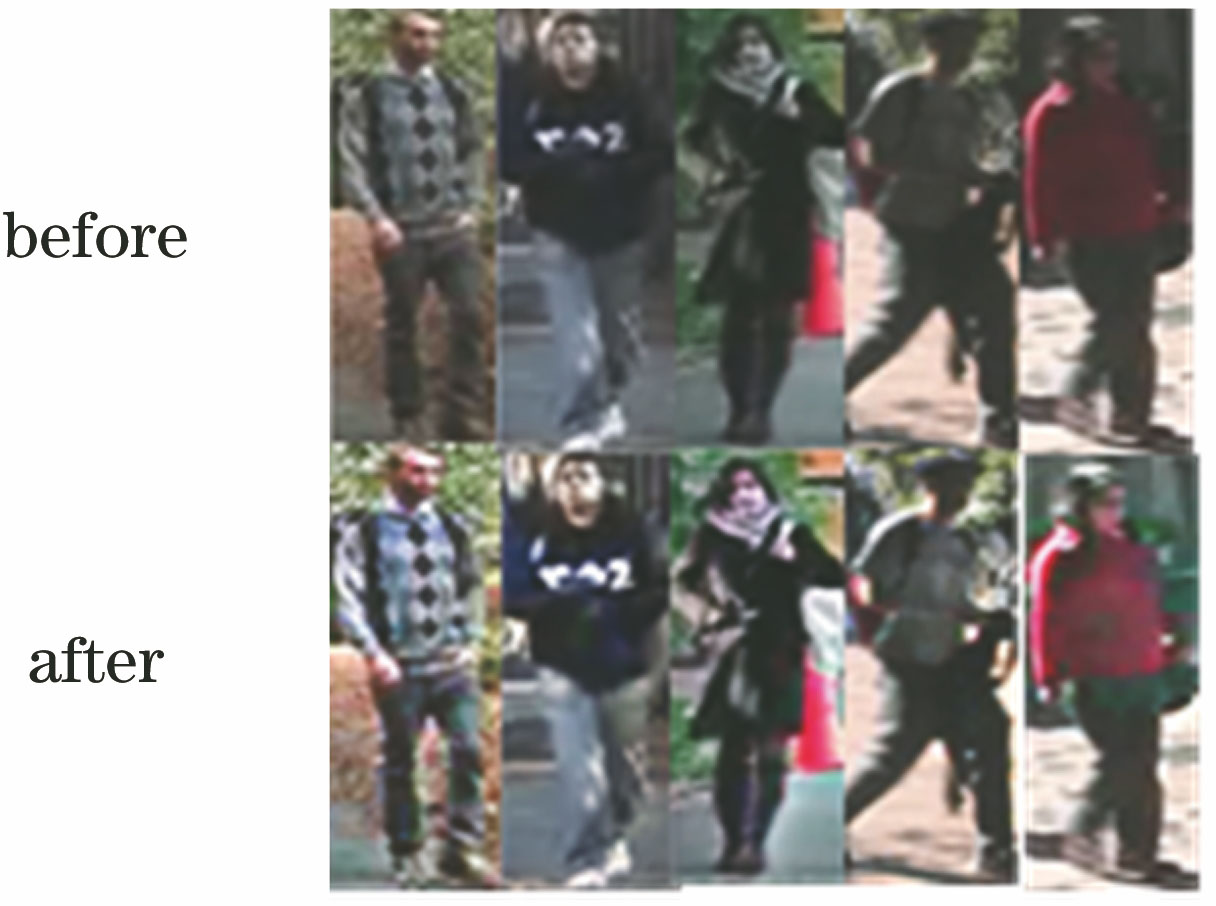

为了获得更好的颜色特征和视觉效果,在对图像进行特征提取之前采用带颜色恢复的多尺度Retinex(MSRCR)[12]算法对行人图像进行预处理。MSRCR最早是由Edwin于1971年提出的一种基于色彩恒常理论得到的图像增强方法,该算法与传统的图像增强算法只能增强图像中的某一种特征相比,但MSRCR算法可以在边缘增强、动态范围压缩和颜色恒常3个方面达到平衡,并且可以对各种不同类型的图像进行自适应增强。在尺度选择方面,这里选择了大小为5和20的两种尺度。MSRCR变换前后的图像如

图 1. MSRCR变换前后的图像(VIPeR数据集)

Fig. 1. Images before and after MSRCR transformation (VIPeR dataset)

2.2 整体与局部特征选取

首先对图像提取整体特征,采用HOG和HSV颜色特征作为行人图像的整体特征。由于HOG是在行人图像的局部单元格上提取特征,因此对图像的光学和几何形变都具有一定的稳健性,然而,上述两种形变只有在更大的空间上才会出现。除此之外,HOG还具有较强的局部光学归一化性能。而HSV颜色空间的亮度和拍摄图像的彩色信息无关,饱和度和色调与人感受颜色的方式具有相似度关系,因此能够较好地反映人类对颜色的感知能力。HSV颜色直方图描述的是不同颜色在整幅图像中所占的比例,实现简单,效果较好,因此选择HSV颜色直方图作为整体的颜色特征。

局部特征选取SILTP特征和CN特征。SILTP特征是基于经典算法LBP(Local Binary Pattern)的改进算法,对光照具有较好的稳健性。事实上,LBP特征仅在灰度变换下具有很好的稳健性,但是对噪声比较敏感,SILTP通过引入尺度不变局部比较容差改善LBP,以此实现对图片噪声的稳健性。CN特征是指人们使用一定的方法和准则对生活中出现的颜色以一种语义给予标签,目前在目标分类领域具有一定的应用。由于在不同的光照下颜色的名称不会改变,因此CN特征不仅对形变、遮挡具有一定的稳健性,对光照也具有一定的稳健性。

2.3 整体与局部特征提取

为了精确地识别出目标行人,采用整体特征和局部特征相结合的办法。整体特征是对整幅图像提取的特征,因此不仅可以对行人进行快速识别,而且还考虑到了整幅行人图像各部件之间的联系。由于不同位置的摄像头拍摄到同一个行人时,受到遮挡、视角、几何形变的影响较大,因此这种情况下采用整体特征的匹配率较低,而采用局部特征可以很好地解决这个问题。在特征提取完成后,将整体特征和局部特征融合组成最终的特征描述子。

整体特征提取:对行人图像提取HOG特征时,第1步,对原始图像进行灰度化处理;第2步,采用Gamma校正法对图像颜色空间进行归一化处理,这样不仅可以调节图像的对比度,还可以减少噪声;第3步,计算图像每个像素点的梯度值;第4步,将图像分成

为了使特征描述子对尺度变化具有稳健性,对图像进行两次下采样,得到1/2原图大小和1/4原图大小的两个图像,同时在上述第4步中,HOG中的小格子也按图像的尺度缩小同样的倍数。初始图像大小为128×48,两次下采样后图像的大小分别为64×24和32×12。初始的

局部特征提取:目前很多文献给出了相关局部特征提取的方法,Zheng等[13]提出将行人图像在竖直方向平均分成6个水平条带。谭飞刚等[14]将4个数据集里的图像叠加,找到了适合的分割比例,但是对图像进行部件分割会使图像丢失一部分信息。

这里选择在滑动窗口中提取局部特征。滑动窗口的大小选择为16×16,以8个像素点为重叠步伐,在大小为128×48的图像上滑过。在每个窗口内提取两个尺度的SILTP(SILT

3 多特征融合与相似性度量

3.1 相似性度量函数

假设行人

式中:

式中:

其中,

(6)式中的常数项不影响相似性函数,因此对(6)式进行简化可以得到相似性度量函数的最终表达式

再令

由于特征向量在原始特征空间的维度较大,而低维度的特征向量对分类更有利,目前一些算法采用主成份分析(PCA)[16]等方法降维,但是该方法在降维过程中没有考虑到距离度量问题,因此不是最好的。根据文献[

15],在交叉数据集中学习一个子空间[

式中:

由于

式中:s.t.表示约束条件。但是,文献[

15]只是在原始特征空间中训练得到相似性度量矩阵,由于原始空间线性不可分,因此获得的识别效果不理想。这里,先将原始特征空间通过核函数转换到非线性空间,再学习相似性测度矩阵。核函数转换的作用就是将原始特征空间转换到易于区分的非线性空间。将行人特征

3.2 多特征融合的度量学习

单一特征无法很好地适应遮挡、光照、姿态等的变换,而多特征可以很好地适应多种变换,因此这里将整体特征和局部特征进行融合。假设提取的整体特征中的HOG特征用

4 实验测试与结果

4.1 实验数据和算法评价标准

实验中所有数据集中的图片大小都统一为128×48。实验的数据随机从3个数据集中选取

4.2 不同数据集上的算法比较

实验主要选择在VIPeR[17]、iLIDS[18]、3DPeS[19]3个数据集上进行。这3个数据集在姿态、遮挡、光照方面都有很大的变化,而这也正是在实际应用中所存在的问题。因此将所提出的方法在这3个数据集上进行测试具有实际的意义,同时也具有很大的挑战性。

VIPeR数据集中的行人图片来自两个摄像头,行人的姿态、光照变化都比较大,VIPeR数据集主要由632个人的1264张图片组成。随机从VIPeR数据集中选取

表 1. 不同算法在VIPeR数据集上的性能比较

Table 1. Performance comparison of different algorithms on VIPeR dataset

| |||||||||||||||||||||||||||||||||||

iLIDS数据集一共有119个行人的476张图片,每个人的图片有2~8张不等,由于这个数据集是在机场采集的,因此行人图像受到遮挡比较严重。随机选取

表 2. 不同算法在iLIDS数据集上的性能比较

Table 2. Performance comparison of different algorithms on iLIDS dataset

| |||||||||||||||||||||||||||||||

3DPeS数据集主要由192个人的1011张图像组成的,视角变换较大,每个人的图片有2~26张不等。不同算法在3DPeS数据集上的性能如

表 3. 不同算法在3DPeS数据集上的性能比较

Table 3. Performance comparison of different algorithms on 3DPeS data sets

| |||||||||||||||||||||||||||||||

除了与现有算法进行比较外,还在VIPeR数据集上进行了只有局部特征和只有整体特征的实验比较。识别率比较CMC曲线图如

图 2. 识别率比较CMC曲线图。(a)特征比较;(b)核函数比较

Fig. 2. CMC curves for recognition rate comparison. (a) Feature comparison; (b) kernel function comparison

最后进行了有无使用核函数的实验验证。由

5 结论

目前大部分的特征算法均采用局部特征融合或直接采用整体特征融合,很少采用整体和局部相结合的办法,而所提出的算法充分考虑了这些问题,将整体特征和局部特征相结合。在相似性度量方面,大部分算法采用在原始线性空间下进行度量,而本算法将原始特征向量通过核函数转换到非线性空间后,在非线性空间下同时学习一个子空间和一个距离度量函数。采用学习子空间的方法可以降低特征向量的维度,同时也避免了PCA等降维方法的缺点。从实验结果可以看出,所提算法超过了大部分算法的第一识别率,但是识别率还不是很高,不能满足实际应用需要,因此下一步将继续优化算法,提高识别率。

[1] FarenzenaM, BazzaniL, PerinaA, et al. Person re-identification by symmetry-driven accumulation of local features[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco. New York: IEEE, 2010: 2360- 2367.

[2] 黄新宇, 许娇龙, 郭纲, 等. 基于增强聚合通道特征的实时行人重识别[J]. 激光与光电子学进展, 2017, 54(9): 091001.

[3] ZhaoR, Ouyang WL, Wang XG. Learning mid-level filters for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus. New York: IEEE, 2014: 144- 151.

[4] Liu CX, Gong SG, Loy CC, et al. Person reidentification: what features are important?[C]∥Proceedings of the 12th European Conference on Computer Vision, October 7-13, 2012, Florence. Berlin: Springer, 2012: 391- 401.

[5] 范彩霞, 朱虹, 蔺广逢, 等. 多特征融合的人体目标再识别[J]. 中国图象图形学报, 2013, 18(6): 711-717.

[6] 袁立, 田子茹. 基于融合特征的行人再识别方法[J]. 模式识别与人工智能, 2017, 30(3): 269-278.

[8] 齐美彬, 檀胜顺, 王运侠, 等. 基于多特征子空间与核学习的行人再识别[J]. 自动化学报, 2016, 42(2): 299-308.

[9] 许路, 赵海涛, 孙韶媛. 基于深层卷积神经网络的单目红外图像深度估计[J]. 光学学报, 2016, 36(7): 0715002.

[11] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络全批量学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720002.

Cheng B, Zha Y F, Li Y Q, et al. Robust Convolutional Neural Networks Feature Learning for Person Re-identification[J]. Acta Optica Sinica, 2018, 38(7): 0720002.

[13] Zheng WS, GongS, XiangT. Person re-identification by probabilistic relative distance comparison[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2011. Colorado Springs, CO, USA. New York: IEEE, 2011: 649- 656.

[14] 谭飞刚, 黄玲, 翟聪, 等. 一种用于大型交通枢纽的跨摄像机行人再识别算法研究[J]. 铁道学报, 2017, 39(1): 76-82.

[15] Liao SC, HuY, Zhu XY, et al. Person re-identification by local maximal occurrence representation and metric learning[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston. New York: IEEE, 2015: 2197- 2206.

[16] KoestingerM, HirzerM, WohlhartP, et al. Large scale metric learning from equivalence constraints[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence. New York: IEEE, 2012: 2288- 2295.

[17] GrayD, TaoH. Viewpoint invariant pedestrian recognition with an ensemble of localized features[C]∥Proceedings of the 10th European Conference on Computer Vision, October 12-18, 2008, Marseille. Berlin: Springer, 2008, 5302: 262- 275.

[18] Zheng WS, Gong SG, XiangT. Associating groups of people[C]∥Proceedings of the 20th British Machine Vision Conference, September 7-10, 2009, London. New York: IEEE, 2009: 1- 11.

[19] BaltieriD, VezzaniR, CucchiaraR. 3DPeS: 3D people dataset for surveillance and forensics[C]∥Proceedings of the 2011 Joint ACM Workshop on Human Gesture and Behavior Understanding, December 01, 2011, Scottsdale. New York: ACM, 2011: 59- 64.

[20] 丁宗元, 王洪元, 陈付华, 等. 基于距离中心化与投影向量学习的行人重识别[J]. 计算机研究与发展, 2017, 54(8): 1785-1794.

[21] MignonA, JurieF. Pcca: A new approach for distance learning from sparse pairwise constraints[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence. New York: IEEE, 2012: 2666- 2672.

[22] PedagadiS, OrwellJ, VelastinS, et al. Local fisher discriminant analysis for pedestrian reidentification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 25-27, 2013, Portland. New York: IEEE, 2013: 3318- 3325.

[23] LiZ, Chang SY, LiangF, et al. Learning locally-adaptive decision functions for person verification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland. New York: IEEE, 2013: 3610- 3617.

Article Outline

朱小波, 车进. 基于特征融合与子空间学习的行人重识别算法[J]. 激光与光电子学进展, 2019, 56(2): 021503. Xiaobo Zhu, Jin Che. Person Re-Identification Algorithm Based on Feature Fusion and Subspace Learning[J]. Laser & Optoelectronics Progress, 2019, 56(2): 021503.