基于背景连续性先验知识的显著性检测  下载: 892次

下载: 892次

1 引言

显著性检测的目的是高效准确地区分图像中的背景和前景区域,帮助计算机快速注意到图像的重要部分,并利于计算资源在图像分析和处理过程中进行优先分配。最终提取出的显著性图像可以广泛应用于计算机视觉领域,包括图像分割[1]、目标识别[2],以及图像检索[3]等。

为了解决显著性检测问题,通常需要借助一些基于前景和背景的属性或位置特点的先验知识。在之前的研究中常使用一种对图像中心区域给予更高显著性的中心先验知识,该中心先验知识对于前景物体的大小和所处位置有着严格的限制。其常被计算用作结合其他显著性线索使用的权值[4-5]或是一些基于学习方法的特征[6]。另一种对比度先验知识则假设图像中的目标物体与其周围的背景区域具备较高的特征对比度,并被几乎所有的显著性检测方法所采用[4-9]。最近的研究工作中提出了一种将图像边界区域视作背景的边界先验知识 [6-7,9],在文献[ 6]中,图像内区域与边界的对比度被作为算法学习的一种特征。在文献[ 7]中,图像局部区域的显著性被定义为其到图像边界的最短测地距离,因为在边界先验知识的假设下,图像的背景区域到达图像边界的最短测地距离要远小于前景区域。但若图像中的前景物体与图像的边界相接触,这些前景物体就会被误认为背景,为此Zhu等[9]考虑物体与图像边界的接触程度,提出了边界连通性的计算,若物体仅仅只有小部分与边界接触,则不认为其为背景区域。

本文提出了一种新的先验知识——图像背景连续性先验知识,该先验知识假设图像中的前景物体被相同颜色和纹理的背景区域所环绕,同时基于此假设给出一种新的显著性检测方法。背景连续性先验知识体现的是图像中前景物体和背景区域的空间联系,并基于两者在图像中的分布关系给出关于前景和背景的定义。本文先对图像进行超像素分割,寻找超像素间的长度最短路径,并基于背景连续的假设计算路径中超像素的前景权重,然后根据超像素间的色彩差异修正极少部分错误的前景权重,最后结合基于边界先验知识的背景权重得到了最终的显著性图。

2 基于背景连续性先验知识的显著性检测

2.1 基于背景连续性的图像分析

在自然图像中,物体和背景不仅各自有着独特的属性特点,而且两者之间也存在着特殊的空间分布关系。这种特殊关系简单来说就是图像中的物体常“嵌入”于背景中,使得物体周围被相同颜色和纹理的背景区域环绕。从整体图像来看,背景与物体如同溪流与裸露在水面的石头,石头阻碍了溪流的流动,而物体“阻碍”了背景在图像中的空间连续性,这也是本文将这一物体和背景的关系称为背景连续性的原因。

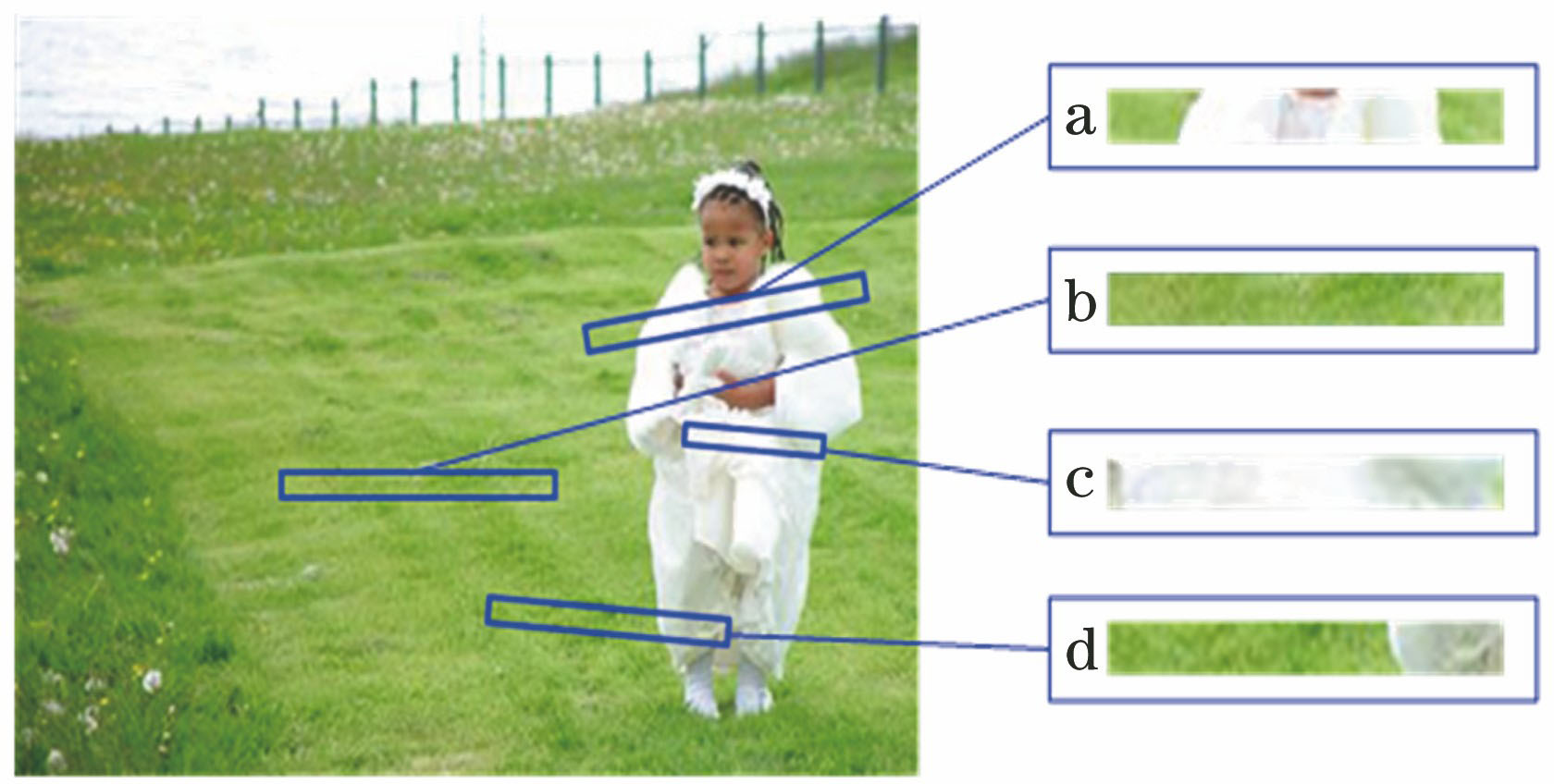

一幅只有背景没有前景的图像,其任意局部区域应该都表现为连续分布的背景区域,如

2.2 基于背景连续性的前景权重计算

先对整幅图像作SLIC(Simple Linear Iterative Clustering)超像素分割[10],以超像素作为计算单元。SLIC对图像进行局部的聚类,在一定程度上弱化了图像的纹理细节,在模糊图像的同时,又能保留重要边缘。

对图像分割得到超像素集合,可表示为

在寻找

找到任意一组超像素间长度为

式中:

在实验中发现,利用(2)式计算得到的前景权重来体现图像中物体的显著性在大多数情况下并不能取得良好的效果。这是由于图像中的许多物体因弯曲或者自身的形状特点,会形成沟状区域,如

式中:

其中,

图 3. 基于背景连续性计算图像中超像素前景权重的各个阶段。(a)原图像;(b) SLIC分割;(c)修正前的前景权重;(d)修正后的前景权重

Fig. 3. Each stage for calculating foreground weight of each super-pixel of image based on background continuity. (a) Original image; (b) SLIC segmentation; (c) foreground weight before correction; (d) foreground weight after correction

3 结合边界先验知识的显著性优化

结合背景连续性先验知识与边界先验知识,以期望得到更好的显著性效果。以超像素作为基本单位,计算图像中任意超像素

式中:

结合基于背景连续性计算得到的前景权重,令新的权重表示为

用归一化新权重得到的显著性图像相比用(2)式权重得到的显著性图像,显著性区域更加集中,周围过高的背景显著性值得到了有效抑制。但由于(6)式中权重相乘的缘故,得到的

式中:

因为本节使用的边界先验知识方法会把所有与边界接壤的区域都认为是背景区域,一旦图像中前景物体与边界接壤,该方法就会失效,导致优化后的显著性效果反而不如优化之前。

4 实验仿真

使用3个标准图片数据集做对比实验,其分别为ASD[11]、ECSSD[4]和PASCAL-S[12]数据集。这3个数据集中的图片都带有人工标注的显著性区域(GT),其中ASD[11]是一个常用图片集,里面的图片一般只包含相对简单的背景区域。相比之下,ECSSD[4]和PASCAL-S[12]中图片的背景更加复杂,而且物体相对背景的颜色和纹理差异不大,对于显著性检测而言更具挑战性。针对显著性效果,本研究把基于背景连续性的显著性检测同一些常用的显著性算法:GS (geodesic saliency)算法[7]、SF (saliency filters)算法[13]、MR (manifold ranking)算法[8]和SO (saliency optimization)算法[9]在每个数据集上都做了评估对比,部分显著性效果的对比如

图 4. 各种方法在ASD数据集上的部分显著性检测效果对比

Fig. 4. Partial saliency detection results of each method on ASD dataset

评估显著性效果采用以下3种指标:准确性、召回率和

首先采用文献[

11]中的自适应阈值方法对测试算法在数据集上得到的显著性图像进行二值分割并计算准确性、召回率和

式中:

准确率-召回率(PR)曲线:算法的准确率可以通过降低召回率得到提升,反之亦然,所以需要把两者结合起来,采用准确率-召回率曲线的方式考察算法的性能。为了获取准确率-召回率曲线,首先设定一个阈值

平均绝对误差(MAE):无论是准确率还是召回率都不能直接体现算法结果与人工标注显著区域的差异大小。为了得到显著性算法间更加全面的比较结果,使用算法所得显著图和人工标注显著图来计算平均绝对误差。对于任意一幅显著性图像

式中:

文献[

9,13-17]采用图像中超像素间的全局或局部颜色对比度作为整体算法中的显著性线索或能量函数的前景权重。本文基于背景连续性计算得到的前景权重相较于全局或者局部对比度,能够作为一种更好的显著性线索或者前景权重来服务于整体的显著性算法,如

图 5. 在3个数据集上的PR曲线和平均绝对误差的对比图。(a)(b) ASD;(c)(d) PASCAL-S;(e)(f) ECSSD

Fig. 5. PR curves and MAEs on three datasets. (a)(b) ASD; (c)(d) PASCAL-S; (e)(f) ECSSD

图 6. 在3个数据集上各方法的对比。(a) ASD;(b) PASCAL-S;(c) ECSSD

Fig. 6. Comparison of different methods on three datasets. (a) ASD; (b) PASCAL-S; (c) ECSSD

图 7. 3种方法对图像处理后的显著性效果对比。(a)原图像;(b)基于全局对比度;(c)基于局部对比度;(d)基于背景连续性

Fig. 7. Comparison of saliency results for image processed by three methods. (a) Original image; (b) based on global contrast; (c) based on local contrast; (d) based on background continuity

在本文算法的运算中,由于结合寻找最短路径的前景权重计算优化不够,消耗了大量的运算时间,即几乎90%的时间都被用来计算前景权重,而仅有剩下不到10%的时间被用于再分配权值和显著性优化。

表 1. 3种方法在ASD数据集上得到的各指标数值对比

Table 1. Comparison of all index values obtained by three methods on ASD dataset

|

表 2. 各种算法的运算时间对比

Table 2. Comparison of running time for different methods

|

5 结论

基于背景连续性先验知识,提出一种新的显著性检测方法。通过超像素分割并寻找超像素间的长度最短路径来近似图像中的局部区域,选取图像中的特定局部区域并计算其中超像素块的前景权重。最后经过基于色彩差异的前景权重修正和结合边界先验知识的显著性优化得到最终的显著性检测结果。

但本文方法也存在着局限性,因为其是在基于前景区域被相似属性背景区域环绕的假设上而成立的,所以一旦图像中的背景环境复杂,存在不同属性特点的背景区域环绕前景物体,则本文方法的实现效果就会被削弱。在极端情况下,即不存在相似属性的背景区域环绕前景物体,则该方法会完全失效。

同时由于本文算法把超像素作为基本计算单元,所以得到的超像素的形状是否规整,排列是否紧密都会影响最终的算法效果。本文采用测地距离替代欧氏距离进行像素间的聚类,达到了提升SLIC的分割效果。在未来的研究中,可以考虑结合超像素的颜色和纹理特征来计算前景权重,以期获得更好的实验效果。

[2] RutishauserU, WaltherD, KochC, et al. Is bottom-up attention useful for object recognition?[C]∥Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004, June 27-July 2, 2004, Washington, DC, USA. New York: IEEE, 2004: 37- 44.

[4] YanQ, XuL, Shi JP, et al. Hierarchical saliency detection[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 1155- 1162.

[5] Cheng MM, WarrellJ, Lin WY, et al. Efficient salient region detection with soft image abstraction[C]∥2013 IEEE International Conference on Computer Vision, December 1-8, 2013, Sydney, NSW, Australia. New York: IEEE, 2013: 1529- 1536.

[6] Jiang HZ, Wang JD, Yuan ZJ, et al. Salient object detection: a discriminative regional feature integration approach[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2083- 2090.

[7] Wei YC, WenF, Zhu WJ, et al. Geodesic saliency using background priors[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer Vision-ECCV 2012. Berlin, Heidelberg: Springer, 2012: 29- 42.

[8] YangC, Zhang LH, Lu HC, et al. Saliency detection via graph-based manifold ranking[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3166- 3173.

[9] Zhu WJ, LiangS, Wei YC, et al. Saliency optimization from robust background detection[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 2814- 2821.

[11] AchantaR, HemamiS, EstradaF, et al. Frequency-tuned salient region detection[C]∥2019 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, Florida, USA. New York: IEEE, 2009: 1597- 1604.

[12] LiY, Hou XD, KochC, et al. The secrets of salient object segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 280- 287.

[13] PerazziF, KrähenbühlP, PritchY, et al. Saliency filters: contrast based filtering for salient region detection[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 733- 740.

[14] You TT, TangY. Visual saliency detection based on adaptive fusion of color and texture features[C]∥2017 3rd IEEE International Conference on Computer and Communications (ICCC), December 13-16, 2017, Chengdu, China. New York: IEEE, 2017: 2034- 2039.

[15] 闫琦, 李慧, 荆林海, 等. 一种超像素区域相似性度量的遥感信息提取算法[J]. 激光与光电子学进展, 2017, 54(8): 081004.

[16] 李庆武, 周亚琴, 马云鹏, 等. 基于双目视觉的显著性目标检测方法[J]. 光学学报, 2018, 38(3): 0315002.

[17] 张松龙, 谢林柏. 基于全部卷积特征融合的显著性检测[J]. 激光与光电子学进展, 2018, 55(10): 101502.

金一康, 于凤芹. 基于背景连续性先验知识的显著性检测[J]. 激光与光电子学进展, 2019, 56(12): 121006. Yikang Jin, Fengqin Yu. Saliency Detection Based on Background Continuity Priori Knowledge[J]. Laser & Optoelectronics Progress, 2019, 56(12): 121006.