基于残差网络的光学遥感图像场景分类算法  下载: 1004次

下载: 1004次

1 引言

随着遥感技术的飞速发展,光学遥感图像的采集方法不断地更新进步,遥感图像场景的分类问题引起了人们广泛关注。遥感图像场景的识别和分类能够广泛应用于城市规划、土地利用、全球环境污染和监测以及**领域的目标检测等方面,这些都是关系到国计民生的重要领域。所以,遥感图像的场景分类研究具有重要的理论意义和实际价值。

传统的遥感图像场景分类方法,例如BP神经网络、模糊神经网络、自组织特征映射网络等都存在收敛速度慢、限于局部收敛等缺点,严重依赖于低级特征描述,并且不能完全捕获场景中包含的高级语义信息。近些年,以卷积神经网络(CNN)为代表的深度学习方法在图像识别与分类领域取得了重大突破。例如,朱明明等[1]利用深度学习对机场进行识别检测。姜晓佳等[2]基于卷积神经网络搭建Hair-Net模型,对毛发显微图像进行了自动分类。马俊成等[3]利用深度卷积神经网络(DCNN)进行飞机目标分类,解决了分类精度低的问题。王燕妮等[4]利用卷积神经网络算法对多光谱图像进行处理,实现了对古壁画颜料的分类。Castelluccio等[5]将GoogleNet用于遥感图像场景分类,结果表明预训练的CNN模型大大优于传统的基于特征的手工方法。Cheng等[6]使用BoVW模型编码单个卷积层。Chaib等[7]将CNN模型的最后两个全连接层融合在一起来表示图像信息。Li等[8]提出了一种多尺度改进的Fisher核编码方法,并将不同层次的特征图进行了组合。这些研究均取得了比较好的实验效果。

但是卷积神经网络也存在一些缺点,CNN模型在提取图像特征时,这些特征信息会因层而异,其中浅层网络提取图像的局部低层特征,深层网络提取图像的全局高层语义特征。以往的研究中往往利用传输到最后全连接层的信息来代表输入图像,这样做会忽略各层之间的互补信息。其次,在一些常见的公共遥感数据集中存在不同类别相似性较大和同一类别差异性较大的问题,而这些问题也是影响分类准确率的重要因素[9]。

为了解决以上问题,本文提出了一种基于残差网络(ResNet)的遥感图像场景分类方法。本文的方法不同于仅仅更改全连接层的常规传输方法,为了独立捕获中间层特征,在ResNet网络模型中嵌入了跳跃连接和协方差池化两个模块,以连接多分辨率特征映射和融合不同层次的多分辨率特征信息。

2 基本原理

2.1 相关工作

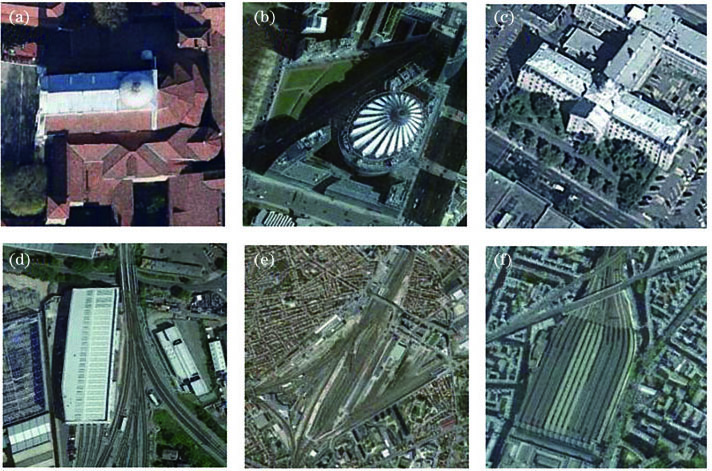

在使用卷积神经网络来提取图像特征时,这些特征信息会因层而异,较浅的层反映比较具体的信息,较深的层反映比较抽象的信息,这些信息再通过全连接层进行整合,而在这个过程中可能会丢失各层的互补信息,从而导致分类精度降低。同时,在实际应用或者一些经典的公共数据集中,必不可少地会存在不同类别的图像具有很大的相似性或者同一类别的图像具有很大的差异性的问题,以在遥感图像领域极具挑战性的NWPU-RESISC45数据集为例,如

图 1. 同一类的差异性。(a)(b)(c)教堂类别;(d)(e)(f)火车站类别

Fig. 1. In-class diversity. (a) (b) (c) Church category; (d) (e) (f) railway station category

图 2. 不同类的相似性。(a)(b)高速公路与跑道类别;(c)(d)工业区与火车站类别;(e)(f)体育馆与火车站类别

Fig. 2. Between-class similarity. (a) (b) freeway versus runway; (c) (d) industrial area versus railway station; (e) (f) stadium versus train station

随着卷积层深度的增加,生成的特征信息更加抽象化和多样化,这使得网络具有更强的学习能力。因此,CNN在计算机视觉方面取得了重大突破。然而与单目标图像相比,卷积神经网络在复杂的空间关系中包含了多个目标,图像底层的细节特征被削弱,这使得CNN在进行场景分类时不再具有区分性,从而无法得到令人满意的场景分类结果。因此,充分利用网络层的特征数据进行场景图像分类是非常必要的。所以,为了解决这一问题,本研究使用预先训练的ResNet网络,利用其中有快捷连接的残差块从网络中的不同层提取特征映射,通过融合不同残差块提取的特征信息,达到显著增加深度而不过度拟合的效果,从而获得更高的分类精度。为了充分利用ResNet的优良性能,提出一种新的基于ResNet的结构,该结构可以将预先训练好的模型中的参数进行传递,其有别于只改变全连接层的传统方法,在ResNet网络模型中嵌入一个跳跃连接模块,以连接多分辨率特征映射进行分类。此外,还利用协方差池化方法对不同层次的多分辨率特征映射进行融合。与仅使用一阶统计量来集成特征映射的传统池化策略相比,协方差池化是一种使用二阶统计量信息来池化特征映射的方法。因此,这种方法可以提取更具代表性的特征,从而提高了ResNet在场景图像分类上的准确性。

ResNet网络,又名残差网络,由He等[10]提出,在2015年ImageNet比赛中排名第一。它主要设计了一种带有快捷连接的残差块,相当于在网络中增加了一条直连通道,使网络具有更强的恒等映射能力,从而在不过度拟合的情况下拓展了的网络深度,提高了网络性能。其中,残差块的结构如

2.2 实验原理与方法

本文提出的用于遥感图像场景分类的网络结构如

2.2.1 预训练网络提取残差块之间的特征

预先训练的18层ResNet包含8个残差块,从相邻残差块提取的特征信息具有很大的相似性,且从每个块中提取特征会增加网络的复杂度和计算时间,因此,本文在残差块之间提取特征,并且只执行5次特征提取。随着网络深度的增加,特征图的维数也随之增加。如果依次对特征映射进行卷积和合并,则维数会不断增加,故本研究利用全局平均池化操作(GAP)来降低特征映射的维数。在GAP之前,特征映射通过批处理规范化(BN)[11]和激活函数(Relu)进行预处理。对于具有d维X=(x(1),x(2),…,x(d)),每个维度通过

其中,Var(·)代表样本方差,则输出的y(x)写为

校正线性单位(ReLU)为

将其作为激活函数,为神经网络增加非线性。

从残差块提取到的特征通过跳跃连接操作融合在一起。所得到的多分辨率特征映射用X表示,并将X的体积沿特征映射的通道维数重塑为矩阵。然后,利用协方差池化层对得到的多分辨率特征映射进行聚合。下面将详细介绍新添加的模块,即跳跃连接和协方差池。

2.2.2 跳跃连接

不同残差块可以提取到具有不同空间分辨率的图像特征映射,这些特征映射通过平均池化操作降低维数,得到3组空间分辨率相同的特征映射,即X1∈

其中,[;;;]表示沿第三维度的连接操作。

另外,为了连接具有不同空间分辨率的特征映射,采用平均池化操作来减少每一组特征映射的通道数,从而得到空间分辨率相同的特征映射,然后利用跳跃连接操作将它们连接起来。

平均池化的数学定义如下。给定一个三维特征映射张量y=

结果得到输出特征映射张量Z=[Z1,Z2,…,ZL/k]∈RH×W×(L/k)。在实际中,本文选择可以整除L的k值。

2.2.3 协方差池化

协方差池化的具体作用为融合多分辨率特征映射。经过跳跃连接,可以得到以矩阵形式表示的多层特征映射,利用协方差池化操作对矩阵进行奇异值分解得到对称矩阵,然后进行矢量化得到特征向量。

给定特征矩阵X∈RD×N(如

式中:XaC代表将协方差矩阵X转换成对称矩阵C;

其中CaF代表将协方差矩阵C转换成对称矩阵F,C=UΣUT,U和Σ表示C的特征向量矩阵和特征值矩阵。在

3 实验结果分析

3.1 实验数据集

为了评估该方法的性能,在3个经典的遥感场景图像数据集上进行实验。

UC Merced Land Use数据集(如

图 6. UC Merced Land Use遥感图像数据集。(a)海滩类别;(b)棒球场类别;(c)立交桥类别

Fig. 6. UC Merced Land Use remote sensing image dataset. (a) Beach; (b) baseball field; (c) overpass

Google of SIRI-WHU数据集(如

图 7. Google of SIRI-WHU遥感图像数据集。(a)河流类别;(b)池塘类别;(c)港口类别

Fig. 7. Google of SIRI-WHU sensing image dataset. (a) River; (b) pond; (c) harbor

NWPU-RESISC45数据集[15](如

图 8. NWPU-RESISC45遥感图像数据集。(a)森林类别;(b)圆形农田类别;(c)河流类别

Fig. 8. NWPU-RESISC45 sensing image dataset. (a) Forest; (b) circular farmland; (c) river

3.2 环境与参数设置

表 1. 实验环境介绍

Table 1. Introduction of experimental environment

|

3.3 实验结果

本文分别以未经改进的ResNet网络和经过本文方法改进后的网络在上述3个公开的经典遥感数据集(UC Merced Land Use 数据集、Google of SIRI-WHU数据集和NWPU-RESISC45数据集)中进行实验,得到的实验结果如下。

3.3.1 类别的准确率对比

图 9. UC Merced Land Use 数据集的分类结果

Fig. 9. UC Merced Land Use data set classification results

图 10. Google of SIRI-WHU 数据集的分类结果

Fig. 10. Google of SIRI-WHU data set classification results

从

3.3.2 类别间的错分率对比

在不同的数据集中不同类别间可能会出现错分,这是因为他们之间有着非常相似的特征信息。例如在UC Merced Land Use 数据集中的公园类别和稠密住宅区类别、NWPU-RESISC45数据集中的商业区类别和稠密住宅区类别、Google of SIRI-WHU数据集中的住宅区类别和商业区类别等,它们都是描述居住区的,唯一的区别是建筑的密度。在UC Merced Land Use 数据集中的农田类别和高尔夫球场类别、Google of SIRI-WHU数据集中的池塘类别和港口类别等,这些都是描述比较空旷地区的,类间的相似性非常大。因此,在未经改进的网络中不同类别间很容易错分。根据实验结果,可知本文方法可以改善由类间相似性导致的错误分类,从而降低了类间的错分率。

3.3.3 与现有方法的对比

为了更好地突出本文方法的优势,

表 2. 不同模型在UC Merced Land Use数据集的分类结果

Table 2. Comparison of the classification results obtained for the UC Merced Land Use dataset unit: %

|

表 3. 不同模型在Google of SIRI-WHU数据集的分类精度

Table 3. Comparison of the classification results obtained for the Google of SIRI-WHU dataset unit: %

|

表 4. 不同模型在NWPU-RESISC45数据集的分类精度

Table 4. Comparison of the classification results obtained for the NWPU-RESISC45 dataset unit: %

|

从

4 结论

本文提出了一种新的用于光学遥感图像场景分类的网络模型。新的网络在ResNet网络中引入跳跃连接和协方差池化两个新的模块,不仅可以将ResNet模型中不同层次的多分辨率特征信息融合在一起,而且可以利用高阶信息来实现更具代表性的特征学习。本文在3个公开的遥感图像数据集上进行了综合实验,并与现有的方法进行比较,验证了新方法的有效性。

本文方法虽然在一定程度上提高了分类准确率,但是对于某些类别的分类效果还并不十分完美。所以,在后继的研究中,本人将利用高光谱遥感图像,通过提取更多的光谱信息进行分析,从而实现对目标更加准确的识别与分类

[1] 朱明明, 许悦雷, 马时平, 等. 改进区域卷积神经网络的机场检测方法[J]. 光学学报, 2018, 38(7): 0728001.

[2] 姜晓佳, 高树辉. 基于改进卷积神经网络的毛发显微图像自动分类[J]. 激光与光电子学进展, 2019, 56(23): 231002.

[3] 马俊成, 赵红东, 杨东旭, 等. 飞机目标分类的深度卷积神经网络设计优化[J]. 激光与光电子学进展, 2019, 56(23): 231006.

[4] 王燕妮, 朱丹娜, 王慧琴, 等. 基于卷积神经网络的壁画颜料多光谱图像分类[J]. 激光与光电子学进展, 2019, 56(22): 221001.

[7] Chaib S, Liu H, Gu Y F, et al. Deep feature fusion for VHR remote sensing scene classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(8): 4775-4784.

[9] Cheng G, Yang C Y, Yao X W, et al. When deep learning meets metric learning: remote sensing image scene classification via learning discriminative CNNs[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(5): 2811-2821.

[10] He KM, Zhang XY, Ren SQ, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA.New York: IEEE Press, 2016: 770- 778.

[11] IoffeS, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[EB/OL]. ( 2015-02-11)[2020-06-16]. https: ∥arxiv.org/abs/1502. 03167.

[12] Song W W, Li S T, Fang L Y, et al. Hyperspectral image classification with deep feature fusion network[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(6): 3173-3184.

[13] Hu F, Xia G S, Hu J W, et al. Transferring deep convolutional neural networks for the scene classification of high-resolution remote sensing imagery[J]. Remote Sensing, 2015, 7(11): 14680-14707.

[15] Cheng G, Han J W, Lu X Q. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865-1883.

[16] He N J, Fang L Y, Li S T, et al. Skip-connected covariance network for remote sensing scene classification[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(5): 1461-1474.

[17] Liu YF, Zhong YF, FeiF, et al.Scene semantic classification based on random-scale stretched convolutional neural network for high-spatial resolution remote sensing imagery[C]∥2016 IEEE International Geoscience and Remote Sensing Symposium (IGARSS), July 10-15, 2016, Beijing, China.New York: IEEE Press, 2016: 763- 766.

[18] 张康, 黑保琴, 李盛阳, 等. 基于CNN模型的遥感图像复杂场景分类[J]. 国土资源遥感, 2018, 30(4): 49-55.

Zhang K, Hei B Q, Li S Y, et al. Complex scene classification of remote sensing images based on CNN[J]. Remote Sensing for Land & Resources, 2018, 30(4): 49-55.

汪鹏, 刘瑞, 辛雪静, 刘沛东. 基于残差网络的光学遥感图像场景分类算法[J]. 激光与光电子学进展, 2021, 58(2): 0210001. Peng Wang, Rui Liu, Xuejing Xin, Peidong Liu. Scene Classification of Optical Remote Sensing Images Based on Residual Networks[J]. Laser & Optoelectronics Progress, 2021, 58(2): 0210001.