基于多尺度生成对抗网络的SAR图像样本增广  下载: 1166次

下载: 1166次

1 引言

深度学习是近年来备受关注的话题,但其需要大量的样本数据才能发挥优势[1],而合成孔径雷达(SAR)图像由于设备限制导致数据来源不够丰富。随着我国海洋事业发展的需求和海上威胁的不断增加,增强海洋监测技术在军用和民用方面都具有重大意义。考虑到军用无人飞行器拍摄的海上舰船SAR图像较少的问题,从已有SAR图像进行样本增广,以获得大量有效的SAR图像,对提高海上舰船检测、识别能力十分必要[2]。

基于计算机绘图的SAR仿真系统,如Balz等[3]采用一种在图形处理器(GPU)上栅格化的方法进行快速仿真;Hammer等[4]提出了一种基于射线跟踪方法的模拟器,可模拟高分辨率的小场景,但这两种模拟器的精度都容易受到几何精度和电磁计算简化的影响。在目标分类领域,常见的数据增广方法,如剪裁、旋转、平移,都无法取得期望的效果,一方面是因为目标分类对图像平移、旋转不敏感[5],另一方面是目标分类方法通常将图像整体进行变换,忽略了图像内的场景和目标变动。

生成对抗网络(GAN)是近年来深度学习的热门话题之一,其在自然语言处理、计算机视觉等方面均有应用,且不断往其他领域扩展。受博弈论中的零和博弈启发,GAN将生成问题当作生成器(generator)和判别器(discriminator)两个网络之间的对抗问题[6],即给定生成器噪声,将生成器生成的数据作为输出,并用判别器判别生成数据的真假。在博弈过程中,不断改进生成器,以生成更逼真的数据;判别器不断提高自身分辨数据真假的能力。但GAN存在训练困难、梯度消失、模型崩溃等问题[7]。可通过改变GAN的结构提升网络的性能,如条件生成对抗网络(CGAN)[8]可生成指定标签的数据;InfoGAN[9]在CGAN的基础上将生成器输入的噪声进行分解,使数据的生成过程可控,并对生成结果有一定的解释性;Pix2Pix[10]也是CGAN的一种变体结构,将图像映射到另一张图像上,成功将GAN应用到图像翻译领域;而循环一致性生成对抗网络(CycleGAN)[11]、StarGAN[12]解决了图像翻译的配对问题,将图像到图像的一对一映射转换为多领域之间的转换。此外,GAN在超分辨率、音频生成等领域也取得了巨大的进展。其次,可通过改变目标函数提升网络的性能。如Wasserstein生成对抗网络(WGAN)[13]利用Wasserstein-1距离代替原始GAN中的JS(Jensen-Shannon)散度,从而改进生成器和判别器的目标函数;带梯度惩罚的WGAN(WGAN-GP)[14]使用正则化形式对判别器进行约束,解决了模型崩溃、梯度消失的问题,使GAN能更稳定的进行学习。

已有研究中,GAN的多种结构变体通常对应特定的任务,且需要一定数量的同类型数据集进行学习。如文献[ 15]中用WGAN-GP生成特定方位角SAR图像的新样本,需要多张样本图像作为训练集。本文参考文献[ 16]中的方法,针对SAR图像信息少且纹理简单的特点,提出了一种通过学习单张图像信息,生成有效SAR图像的方法。

2 网络结构

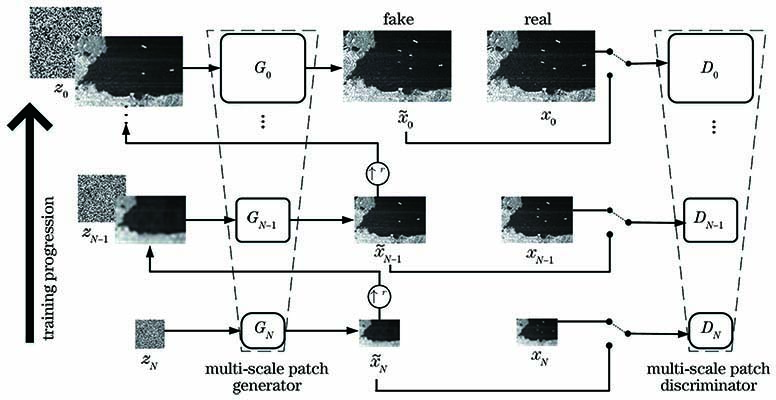

2.1 金字塔式多尺度GAN

采用一种金字塔式多尺度结构GAN作为整体框架捕捉图像内部的统计信息,每一层金字塔都有一个简单的GAN负责该尺度下图像样本的生成和判别,具体网络结构如

通过噪声zN生成样本

式中,

将第n个尺度下输入的噪声zn和图像

式中,fn为从生成图像

2.1.1 Inception模块

生成器将输入的图像用尺寸为3×3的卷积核卷积后,其输出通道数变为192,将

Inception模块中有三条分支对输入进行卷积运算(卷积核尺寸为1×1),对于单像素点,1×1的卷积运算(Conv)相当于该像素点在所有特征上进行了一次全连接运算,即全连接形式,如

为缩短本模型学习单张图像的时间、降低计算成本,使用1×1卷积,减少提取的特征数后,Inception模块还将5×5卷积分解为两个3×3卷积,以提升模型的运算速度。

图 4. 线性卷积层与1×1卷积层。(a)线性卷积层;(b) 1×1卷积层

Fig. 4. Linear convolutional layer and 1×1 convolutional layer. (a) Linear convolution layer; (b) 1×1 convolution layer

2.1.2 残差密集模块

Inception模块提取不同尺度的特征得到的输出经下采样后,进入残差密集模块。实验采用的残差密集模块[18]可以充分利用Inception模块获取的不同尺度舰船特征,提高生成器生成图像的质量。残差密集模块由五个卷积层密集连接,每个卷积层可以向所有后续层传递信息。文献[

19]已经证明去除BN层可以减少计算复杂度并提高网络性能,因此,生成器在残差密集模块中去除所有BN层,如

2.2 生成器的结构

为提取SAR图像中更多的特征,在原有生成器中的5个全卷积网络中加入密集残差模块和Inception模块,如

生成器的具体配置如

表 1. 生成器的参数

Table 1. Parameters of the generator

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

2.3 判别器的结构

判别器采用文献[

16]中的结构,采用马尔科夫判别器(patch-GAN)思想,由5个全卷积层构成,用下采样方法捕捉当前尺度下的图像分布,如

3 损失函数

模型训练从最粗的尺度开始,按

式中,α为重建损失在训练损失中所占的权重,实验中取10。

对抗损失:在每个尺度下生成器都有一个马尔科夫判别器,以判别该尺度下生成图像的真假[10]。实验采用WGAN-GP损失[14],用Wasserstein-1距离代替原始GAN的JS散度,并将判别器的Lipschitz-1约束正则化作为目标函数的惩罚项,解决了损失函数梯度消失问题,提高了模型的稳定性。马尔科夫判别器判别图谱的平均值可表示为

式中,adv为取平均值函数,xn为原始图像的下采样结果,

重建损失:为了生成原始图像x的特定噪声图谱,令{

当n=N时,重建损失可表示为

可用

4 实验分析

4.1 实验数据和平台

实验数据:使用SSDD公开数据集,数据来源主要有TerraSAR-X、RadarSat-2和Sentinel-1传感器,有HH、HV、VV和VH四种极化方式,分辨率为1~15 m,使用LabelImg进行标注,共1160张图像,包含2456艘舰船[22]。

实验平台:系统为Ubuntu18.04,CPU为Intel Core i7-9750H,主频为2.60 GHz,GPU为GeForce RTX2060,内存为16 GB。开发框架为PyTorch,语言为Python。

4.2 模型训练

模型训练采用Adam自适应算法,设置学习率为0.0005,一阶动量为0.5,二阶动量为0.999,每个尺度的训练次数为2000次,当学习次数达到1600次时将学习率调整到0.00005。

4.3 实验结果

图 7. 由单一图像生成的图像。(a)小尺寸舰船的图像1;(b)小尺寸舰船的图像2;(c)背景带噪声的图像;(d)大尺寸舰船的图像

Fig. 7. Image generated from single image. (a) Image1 of small ship; (b) image2 of small ship; (c) image with noise in background; (d) image of large ship

本方法改进的重点在于得到更多尺度特征的同时更好地利用图像特征,改进前后生成的图像如

图 8. 不同网络生成的图像。(a)用于训练的图像;(b)原网络生成的图像;(c)改进后网络生成的图像

Fig. 8. Images generated by different networks. (a) Images used for training; (b) images generated by the original network; (c) images generated by the improved network

4.4 结果验证

采用本方法(记为method1)和传统方法(记为method2)对样本进行增广,传统增广方法主要对图像进行裁剪、平移、改变亮度、加噪声、旋转、镜像、在图像上添加黑色区域,本方法采用LabelImg图像标注软件对生成的样本图像进行人工标注。由于SSDD数据集中的数据类别只有舰船一种,因此标注时也只标注舰船,实验共制备了五个数据集。

1) SSDD_method1_20:从SSDD数据集的1160张图像中选取58张进行训练,主要涉及简单背景下的大、小尺寸舰船和复杂背景下的大、小尺寸舰船。每张图像通过method1训练生成20张图像,共得到1160张图像。

2) SSDD_method1_40:从SSDD数据集的1160张图像中选取29张图像,每张图像通过method1训练生成40张图像,共1160张图像。

3) SSDD_method2_20:用相同的58张图像,每张图像用method2中的任意一种方式进行20次增广,共得到1160张图像。

4) SSDD_method2_40:用相同的29张图像,每张图像用method2中的任意一种方式进行40次增广,共得到1160张图像。

5) SSDD_method2_1160:用SSDD数据集中的1160张图像,每张图像采用method2中的任意一种方式进行1次增广,共得到1160张图像。

本方法生成的样本主要用于SAR图像的目标检测,因此用目标检测算法判定生成的SAR图像是否有效。SSD和Tiny-YOLO训练均采用Adam自适应算法,batch size为16,初始学习率为0.00004,epoch为10000,训练集和测试集中的图像数量比为7∶3。由于SSDD数据集和标注的生成样本数据集只有一个类别,因此采用平均精度(AP)衡量目标检测算法的训练效果,将Bounding box和Ground truth的重叠阈值设为0.5,得到的结果如

表 2. 不同方法生成图像的AP

Table 2. AP of different methods to generate images

| ||||||||||||||||||||||||||

当样本增广的原始图像只有58张时,分别用method1和method2将数据集增广至1160张图像,然后与SSDD数据集结合得到新的数据集SSDD+ SSDD_method1_20和SSDD+ SSDD_method2_20,用这两个新数据集训练目标检测算法SSD和Tiny-YOLO。从

相比原始SSDD数据,用本方法增广的数据集,训练得到的模型在目标检测时对虚警、漏检、错检现象都有所改进,如

图 9. 不同数据集训练的错检情况。(a)正确检测结果;(b) SSDD数据集;(c) SSDD数据集+生成的样本数据集

Fig. 9. Error detection of training on different data sets. (a) Correct test results; (b) SSDD data set; (c) SSDD data set + generated sample data set

图 10. 不同数据集训练的虚警情况。(a)正确检测结果;(b) SSDD数据集;(c) SSDD数据集+生成的样本数据集

Fig. 10. False alarms of training on different data sets. (a) Correct test results; (b) SSDD data set; (c) SSDD data set + generated sample data set

图 11. 不同数据集训练的漏检情况。(a)正确检测结果;(b) SSDD数据集;(c) SSDD数据集+生成的样本数据集

Fig. 11. Missed detection of training on different data sets. (a) Correct test results; (b) SSDD data set; (c) SSDD data set + generated sample data set

图 12. 加入生成数据集后未检测出的结果。(a)正确检测结果;(b) SSDD数据集;(c) SSDD数据集+生成的样本数据集

Fig. 12. Undetected result after adding the generated data set. (a) Correct test results; (b) SSDD data set; (c) SSDD data set + generated sample data set

5 结论

针对深度学习需要大量样本数据支撑,而SAR图像获取较为困难的问题,基于GAN提出了一种学习单张图像内部分布的样本增广方法。相比常见的样本增广方法,本方法进行样本数据增广时可以改变图像中目标的数量、相对位置以及背景环境,使生成的样本具有多样性。使用金字塔式的多尺度GAN对单张图像进行学习,在生成器前端采用Inception模块获取更多尺度的特征,结合残差密集模块充分利用图像特征。将生成的图像标注后作为数据集训练目标检测算法,用训练的模型测试同一测试集,得到的结果较好,证明了本方法生成SAR图像的有效性。但本方法每次只能训练一张图像,再次处理另一张图像需要重新训练,增加了训练时间和训练成本。因此,之后的研究中还需考虑能否通过导入具有普适性的预训练模型对具体的图像进行微调,从而达到快速训练的目的。

[1] Wang ZW, SheQ, Ward TE. Generative adversarial networks: a survey and taxonomy[EB/OL]. [2020-01-31].https:∥arxiv.org/abs/1701. 04862.

[2] 易维, 曾湧, 原征. 基于NSCT变换的高分三号SAR与光学图像融合[J]. 光学学报, 2018, 38(11): 1110002.

[4] Hammer H, Schulz K. Coherent simulation of SAR images[J]. Proceedings of SPIE, 2009, 7477: 74771G.

[5] Cubuk ED, ZophB, ManéD, et al. AutoAugment: learning augmentation strategies from data[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 113- 123.

[6] Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al. Generative adversarial nets[EB/OL]. [2020-01-27].https:∥arxiv.org/abs/1406. 2661.

[7] ArjovskyM, BottouL. Towards principled methods for training generative adversarial networks[EB/OL]. [2020-02-05].https:∥arxiv.org/abs/1701. 04862.

[8] MirzaM, OsinderoS. Conditional generative adversarial nets[EB/OL]. [2020-01-30].https:∥arxiv.org/abs/1411. 1784.

[9] ChenX, DuanY, HouthooftR, et al. InfoGAN: interpretable representation learning by information maximizing generative adversarial nets[EB/OL]. [2020-02-03].https:∥arxiv.org/abs/1606. 03657.

[10] IsolaP, Zhu JY, Zhou TH, et al. Image-to-image translation with conditional adversarial networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 5967- 5976.

[11] Zhu JY, ParkT, IsolaP, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2242- 2251.

[12] ChoiY, ChoiM, KimM, et al. StarGAN: unified generative adversarial networks for multi-domain image-to-image translation[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 8789- 8797.

[13] AjocskyM, ChintalaS, BottouL. Wasserstein GAN[EB/OL]. [2020-02-04].https:∥arxiv.org/abs/1701. 07875.

[14] GulrajaniI I, Ahmed F, Arjovsky M, et al. Improved training of Wasserstein GAN[EB/OL].[2020-01-27]. https:∥arxiv.org/abs/1704. 00028.

[15] Cui Z Y, Zhang M R, Cao Z J, et al. Image data augmentation for SAR sensor via generative adversarial nets[J]. IEEE Access, 2019, 7: 42255-42268.

[16] Shaham TR, DekelT, MichaeliT. SinGAN: learning a generative model from a single natural image[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South). New York: IEEE, 2019: 4569- 4579.

[17] SzegedyC, VanhouckeV, IoffeS, et al. Rethinking the inception architecture for computer vision[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 2818- 2826.

[18] Wang XT, YuK, Wu SX, et al. ESRGAN: enhanced super-resolution generative adversarial networks[M] ∥ Leal-Taixé L, Roth S, et al. Computer Vision -ECCV 2018. Lecture Notes in Computer Science. Cham: Springer, 2018, 11133: 63- 79.

[19] HuangG, Liu Z, van der Maaten L, et al. Densely connected convolutional networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 2261- 2269.

[20] LimB, SonS, KimH, et al. Enhanced deep residual networks for single image super-resolution[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1132- 1140.

[21] SzegedyC, IoffeS, VanhouckeV, et al. Inception-v4, inception-ResNet and the impact of residual connections on learning[EB/OL]. [2020-01-30].https:∥arxiv.org/abs/1602. 07261.

[22] 李健伟, 曲长文, 彭书娟, 等. 基于生成对抗网络和线上难例挖掘的SAR图像舰船目标检测[J]. 电子与信息学报, 2019, 41(1): 143-149.

Li J W, Qu C W, Peng S J, et al. Ship detection in SAR images based on generative adversarial network and online hard examples mining[J]. Journal of Electronics & Information Technology, 2019, 41(1): 143-149.

Article Outline

李诗怡, 付光远, 崔忠马, 杨小婷, 汪洪桥, 陈雨魁. 基于多尺度生成对抗网络的SAR图像样本增广[J]. 激光与光电子学进展, 2020, 57(20): 201018. Shiyi Li, Guangyuan Fu, Zhongma Cui, Xiaoting Yang, Hongqiao Wang, Yukui Chen. Data Augmentation in SAR Images Based on Multi-Scale Generative Adversarial Networks[J]. Laser & Optoelectronics Progress, 2020, 57(20): 201018.