基于多尺度特征提取和全连接条件随机场的图像语义分割方法  下载: 1298次

下载: 1298次

ing at the problems of insufficient usage of context information and unclear image edge segmentation in image semantic segmentation, a network model based on multi-scale feature extraction and fully connected conditional random fields is proposed. RGB and depth images are input into the network in a multi-scale form, and their features are extracted by a Convolutional neural network. Depth information is added to supplement the RGB feature map and obtain a rough semantic segmentation, which is optimized by the fully connected conditional random fields. Finally, fine semantic segmentation results are obtained. This proposed method improves the precision of semantic segmentation and optimizes the image edge segmentation, which has a practical application.

1 引言

图像语义分割是像素级的密集分类问题,目标是对图像中的每个像素进行语义信息标注,从而从整体上理解图像。其在目标检测、场景理解和三维重建等计算机视觉任务中已广泛应用[1-2],具有重要的理论研究意义和实际应用价值。图像语义分割的难点主要来源于物体层次、类别层次和背景层次[3-4]三个方面。

在深度学习出现之前,传统的图像语义分割方法主要包括像素级别阈值法、基于像素聚类的分割方法以及基于图论划分的分割方法[5]。基于卷积神经网络(CNN)的方法不需要人工参与,能够直接从大量样本图像数据集中自动学习与语义相关的有用特征,并获得精确的结果,较传统语义分割方法具有明显的优势。Long等[6]提出的全卷积网络(FCN)是语义分割模型的开山之作,DeepLab[7]、SegNet[8]等网络模型结构与FCN相同;与基于FCN的方法相比,Noh等[9]提出的反卷积网络克服了物体尺度带来的高识别错误问题;为了充分利用物体—图像和物体—物体之间存在的上下文关系,提高语义分割的精度,文献[ 10-11]使用扩张卷积聚合多尺度的上下文信息;Zhao等[12]提出的PSPNet通过空间池化模块和空间场景解析网络,利用不同区域的上下文信息聚合全局上下文信息;Lin等[13]将多尺度图像作为输入,产生了不同尺度的特征图,提高了语义分割的精度;熊志勇等[14]将缩放得到的三个不同尺度图像作为网络输入,通过多尺度融合算法生成输出图;蒋应锋等[15]提出多尺度交替迭代训练,对每个像素进行类别标定,并应用超像素描绘分割图的轮廓;刘丹等[16]以超像素为中心,提取不同尺度的图像块作为网络的输入,将多尺度CNN模型结构用于图像语义分割;Zheng等[17]提出的CRFasRNN模型和Lin等[18]提出的结合CNN和条件随机场(CRF)的模型利用CNN的特征提取和CRF概率图形建模的优势,提高了不同图像区域之间的语义相关性。

为了解决普通CNN方法无法处理的边缘分割不清等问题,通常采用条件CRF[19]、全连接条件随机场(FullCRF)[20]、马尔科夫随机场(MRF)或高斯条件随机场(G-CRF)[21]优化网络输出,从而得到更加精确的分割结果。

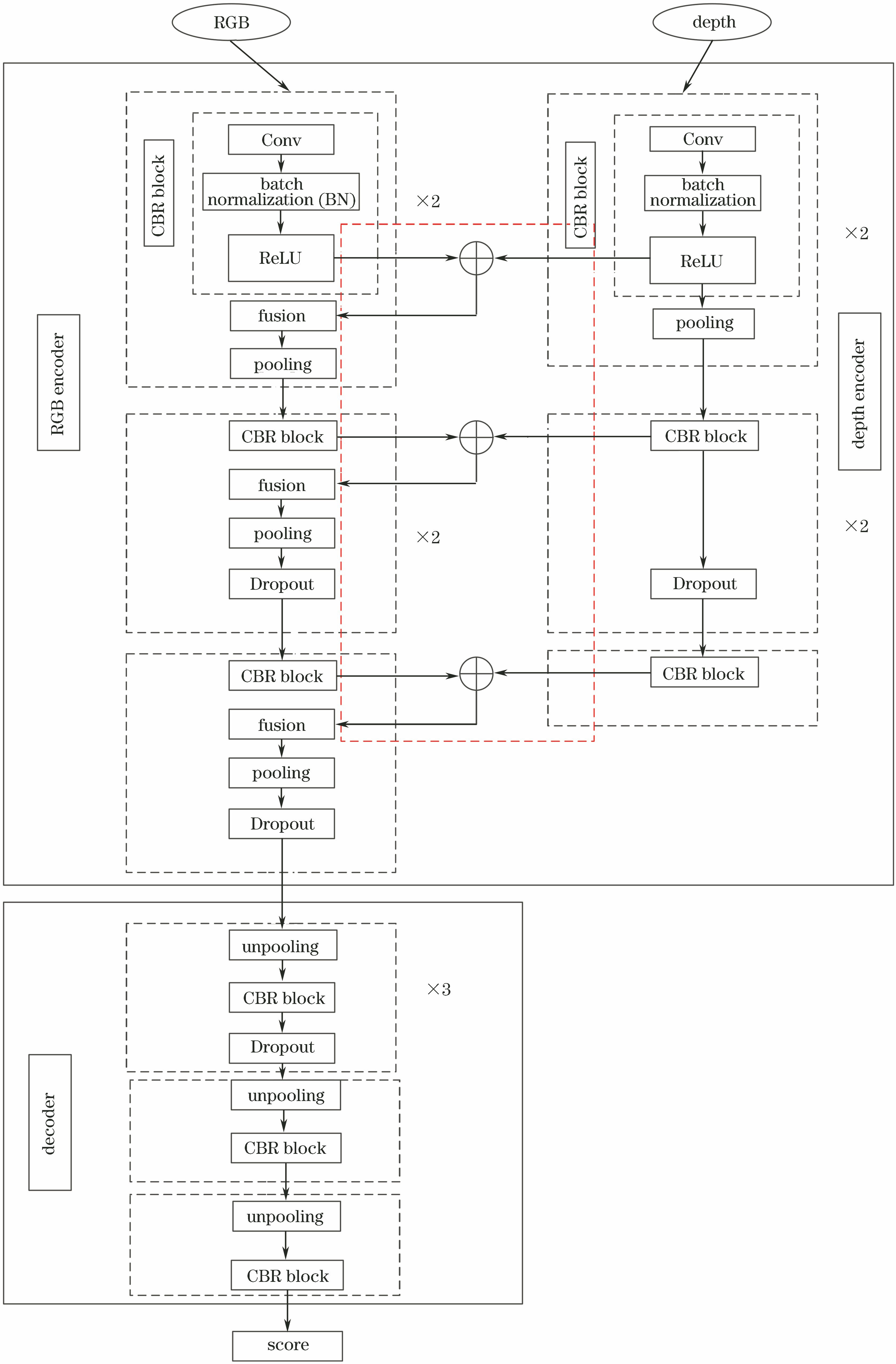

为充分利用物体的上下文信息,并清晰描绘图像的边缘轮廓,本文在FuseNet[22]的基础上,设计了一种多尺度的CNN模型——多尺度特征提取和全连接条件随机场相结合的图像语义分割方法(MSF-CRF)。该方法采用语义粗分割网络(MSF-Net)得出语义粗分割结果,再利用FullCRF优化,得到语义精细分割结果。MSF-CRF模型分别以多尺度形式将RGB图像和深度图像输入到对应的尺度分支,并将RGB图像的深度信息以元素求和的方式添加到RGB特征图,而后采用多尺度特征融合的方式将三个尺度分支的信息进行融合,进一步改善语义分割的性能,最后采用FullCRF优化图像的边界。对所提方法进行了详细研究,并在NYUv2数据集上进行了实验验证。

2 MSF-CRF语义分割模型

2.1 多尺度输入

为了利用图像的多尺度信息,提取不同尺度下的不变特征,更好地感知图像中过大或者过小的物体,避免损失过多的图像信息,提高语义分类的精度。采用双线性插值的方式将RGB图像和深度图像分别转化为三种不同的尺度,然后输入到网络中。以320 pixel×240 pixel的图像为基准,分别以基准图像的0.6、0.8和1倍进行处理,得到128 pixel×96 pixel、192 pixel×144 pixel和320 pixel×240 pixel三种不同的尺度。三个尺度的图像共用同一个网络模型,采用共享权重的方式训练网络。另外,采用最邻近插值方式将真实标签图处理成大小为320 pixel×240 pixel的图像。

2.2 语义粗分割网络—MSF-Net

MSF-Net为编码-解码式网络,其将输入图像同时输入到三个尺度分支中,生成不同尺度的特征图,每个尺度的图像经过网络后,会得到三个得分图,进行多尺度特征融合后,即可得到语义粗分割结果。

RGB图像特征提取分支的第一部分由CBR块、融合层和池化层组成,该部分执行两次,其中CBR块由卷积层(Conv)、批归一化层(BN)和激活函数(ReLU)组成;第二部分由CBR块、融合层、池化层和Dropout层组成,加入Dropout层可以防止网络出现过拟合现象;第三部分同样由CBR块、融合层、池化层和Dropout层组成,该部分执行一次。

深度图像特征提取分支的第一部分由CBR块和池化层组成,该部分执行两次;第二部分由CBR块、池化层和Dropout层组成,该部分执行两次;第三部分为CBR块。

2.2.1 MSF-Net网络结构定义

将类别标签定义为集合

式中:

利用Softmax函数将得分映射为输入图像中所含像素类别的概率分布,该过程称为Softmax的回归过程,定义为

式中:

为了得到最优参数

式中:

2.2.2 RGB图像与深度图像融合

深度图像包含图像的场景结构信息,将其与RGB图像进行融合,可以使网络学到更多的特征,从而更好地预测。RGB图像与深度图像融合通常有两种方法:一种方法是将RGB图像和深度图像堆叠成4个通道,然后输入到网络中进行训练;另一种方法是将RGB图像和深度图像分为两个同步的网络分支,分别提取特征,在每一步池化操作之前,通过元素求和的方式将深度信息融合进RGB特征图,如

2.2.3 多尺度得分图融合

多尺度得分图融合过程如

表 1. 特征融合前单个分支编码器部分的参数设置表

Table 1. Parameter setting table of single branch encoder before feature fusion

| ||||||||||||||||||

2.3 基于FullCRF的语义精细分割-MSF-CRF

3 实验结果及分析

采用NYUv2[23]室内场景数据集验证本文所提方法的有效性和可靠性。该数据集由1449个成对RGB-D图像组成,包括3个城市26个场景类别下464个不同的场景。同时,该数据集中包括35064个不同的对象,跨越3894个不同的类。根据Gupta等[24]的分类标准,将NYUv2数据集分为795张训练集和654张测试集。同时,参考该文献中的映射标准,将原始标签映射为40类(0代表无效)。为了评价图像语义分割结果的精度,以像素精度(PA)、平均类别精度(MA)和平均IoU(MIoU)三个指标作为评价标准,分别利用

3.1 MSF-CRF与其他方法对比

为验证所提方法的可行性,将MSF-CRF分别与多个图像语义分割方法进行比较,如FCN[6]、FuseNet[22]等。

表 2. 不同网络在NYUv2数据集上的结果

Table 2. Results of different networks on NYUv2 dataset

|

3.2 分割性能对比

为验证所提方法的有效性,采用所提方法与FuseNet分别对数据集中的40个类别进行实验所得到的类别精度和IoU分数如

将RGB图像和深度图像作为FuseNet和MSF-CRF的输入进行实验,所得结果如

表 3. 40个类别的类别精度对比表

Table 3. Comparison of classification accuracy of 40 categories

|

表 4. 40个类别的IoU对比表

Table 4. Comparison of IoU of 40 categories

|

4 结论

结合多尺度特征提取与全连接条件随机场,提出了一种利用不同尺度图像作为网络输入的CNN模型,融合图像的彩色信息与深度信息训练网络,利用FullCRF描绘图像的边界。在NYUv2数据集上的实验结果表明,多尺度的图像特征对图像语义分割结果具有重要影响,多尺度CNN模型对图像语义分割具有更好的表现力。该模型不仅更大程度地结合了物体的上下文信息,还优化了图像语义分割的边缘,使得网络在语义分割类别和边界方面都得到了更好的效果,提高了语义分割的准确性。

[2] 郭呈呈, 于凤芹, 陈莹. 基于卷积神经网络特征和改进超像素匹配的图像语义分割[J]. 激光与光电子学进展, 2018, 55(8): 081005.

[3] 魏云超, 赵耀. 基于DCNN的图像语义分割综述[J]. 北京交通大学学报, 2016, 40(4): 82-91.

[4] 张新明, 祝晓斌, 蔡强, 等. 图像语义分割深度学习模型综述[J]. 高技术通讯, 2017, 27(9): 808-815.

[6] LongJ, ShelhamerE, DarrellT. Fully Convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3431- 3440.

[7] Chen LC, PapandreouG, KokkinosI, et al. Semantic image segmentation with deep Convolutional nets and fully connectedCRFs[EB/OL]. ( 2016-06-07)[2018-10-25]. https:∥arxiv.org/abs/1412. 7062.

[9] NohH, HongS, HanB. Learning deConvolution network for semantic segmentation[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1520- 1528.

[10] YuF, Koltun V. Multi-scale context aggregation by dilated Convolutions[EB/OL]. ( 2016-04-30)[2018-10-25]. https:∥arxiv.org/abs/1511. 07122.

[12] Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 6230- 6239.

[13] Lin GS, Shen C H, van den Hengel A, et al. Efficient piecewise training of deep structured models for semantic segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 3194- 3203.

[14] 熊志勇, 张国丰, 王江晴. 基于多尺度特征提取的图像语义分割[J]. 中南民族大学学报(自然科学版), 2017, 36(3): 118-124.

[15] 蒋应锋, 张桦, 薛彦兵, 等. 一种新的多尺度深度学习图像语义理解方法研究[J]. 光电子·激光, 2016, 27(2): 224-230.

[16] 刘丹, 刘学军, 王美珍. 一种多尺度CNN的图像语义分割算法[J]. 遥感信息, 2017, 32(1): 57-64.

[17] ZhengS, JayasumanaS, Romera-ParedesB, et al. Conditional random fields as recurrent neural networks[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1529- 1537.

[18] Lin G S. Shen C H, van den Hengel A, et al. Exploring context with deep structured models for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(6): 1352-1366.

[19] Lafferty JD, McCallum A, Pereira F C N. Conditional random fields: probabilistic models for segmenting and labeling sequence data[C]∥Proceedings of the Eighteenth International Conference on Machine Learning, June 28-July 01, 2001. San Francisco: Morgan Kaufmann Publishers Inc., 2001: 282- 289.

[20] KrähenbühlP, KoltunV. Efficient inference in fully connected CRFs with Gaussian edge potentials[C]∥Proceedings of the 24th International Conference on Neural Information Processing Systems, December 12-15, 2011, Granada, Spain. USA: Curran Associates Inc., 2011: 109- 117.

[21] VemulapalliR, TuzelO, Liu MY, et al. Gaussian conditional random field network for semantic segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA, 2016: 3224- 3233.

[22] HazirbasC, Ma LN, DomokosC, et al. FuseNet: incorporating depth into semantic segmentation via fusion-based CNN architecture[M] ∥Lai S H, Lepetit V, Nishino K, et al.Computer vision-ACCV 2016. Lecture notes in computer science. Cham: Springer, 2017, 10111: 213- 228.

[23] SilbermanN, HoiemD, KohliP, et al. Indoor segmentation and support inference from RGBD images[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7576: 746- 760.

[24] GuptaS, ArbeláezP, MalikJ. Perceptual organization and recognition of indoor scenes from RGB-D images[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 564- 571.

[25] GuptaS, GirshickR, ArbeláezP, et al. Learning rich features from RGB-D images for object detection and segmentation[M] ∥ Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8695: 345- 360.

[26] DengZ, TodorovicS, Latecki LJ. Semantic segmentation of RGBD images with mutex constraints[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1733- 1741.

Article Outline

董永峰, 杨雨訢, 王利琴. 基于多尺度特征提取和全连接条件随机场的图像语义分割方法[J]. 激光与光电子学进展, 2019, 56(13): 131007. Yongfeng Dong, Yuxin Yang, Liqin Wang. Image Semantic Segmentation Based on Multi-Scale Feature Extraction and Fully Connected Conditional Random Fields[J]. Laser & Optoelectronics Progress, 2019, 56(13): 131007.