基于级联残差生成对抗网络的低照度图像增强  下载: 970次

下载: 970次

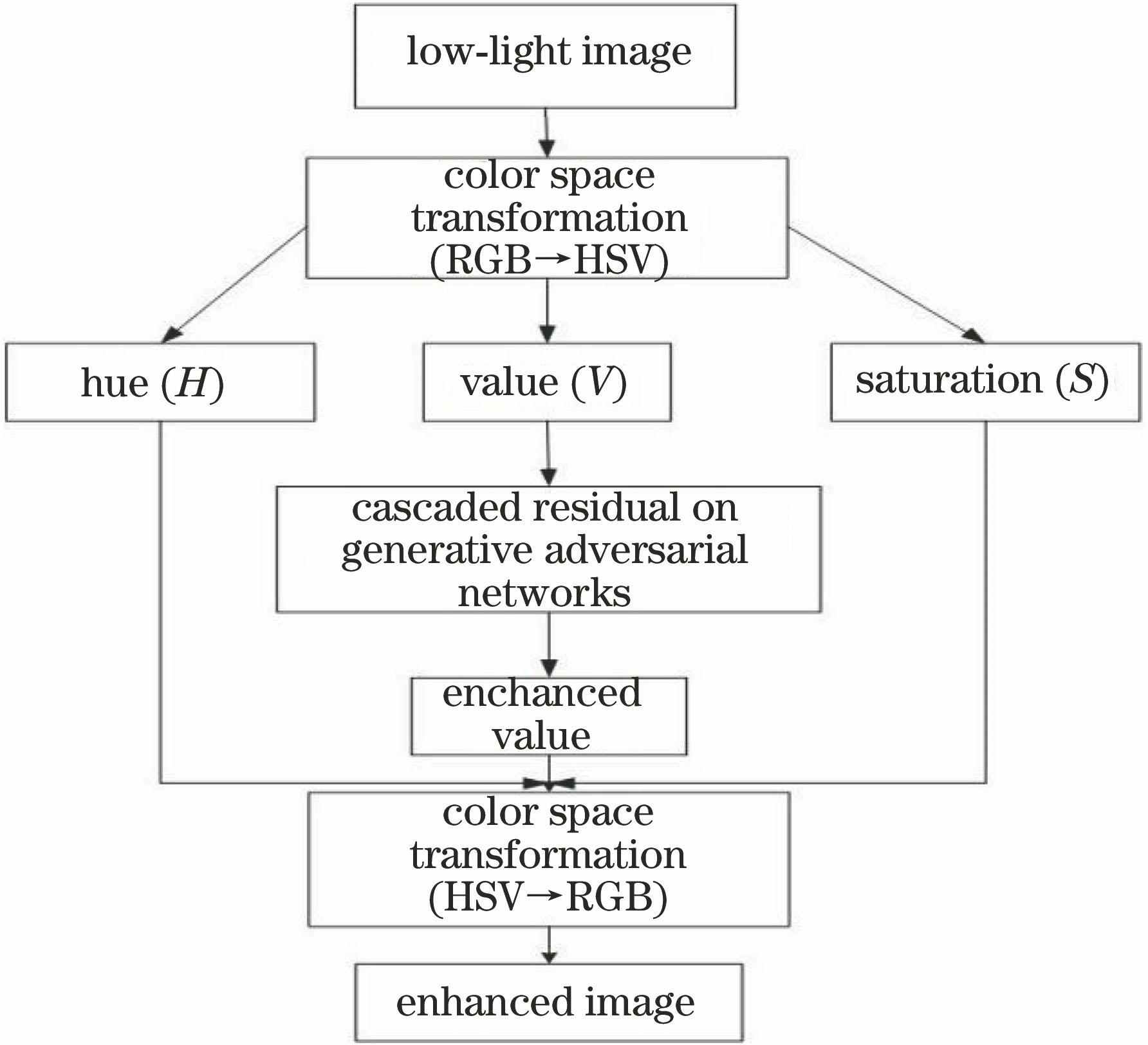

ing at the problem of poor visual effect and low image quality of existing low-light images, a low-light image enhancement algorithm based on cascaded residual generative adversarial network is proposed. The algorithm uses constructed cascaded residual convolutional neural network as generator network and improved PatchGAN as discriminator network. First, training samples are synthesized through normal-light image on the basis of Retinex theory. Then, low-light images are converted from red-green-blue space to hue-saturation-value color space. Meanwhile, keeping hue and saturation unchanged, the value component is enhanced through the cascaded residual generator network. Besides, low-light image is enhanced through the way of discriminator network supervising generator network. They struggle against each other to promote the capability of generator network to enhance the low-light image. Experimental results show that the proposed enhancement algorithm obtains better visual effects and contrast in terms of synthetic low-light images and natural low-light images. Especially, for the synthetic low-light images, the proposed algorithm is obviously superior to other comparison algorithms in terms of peak signal-to-noise ratio and structural similarity.

1 引言

在低照度环境或者设备补光能力不足时,采集到的是亮度低、视觉上不清晰、对比度低的图像,这些缺点严重影响了图像在后续计算机视觉任务中的处理,因此,图像的预处理过程要求增强低照度图像的视觉效果。早期,国内外的低照度图像增强的第一类主流算法是Pizer等[1]通过直方图均衡化(HE)的方法增强低照度图像,以及Reza等[2]提出在直方图均衡化上改进的限制对比度自适应直方图(CLAHE)的方法,尽管这些方法在增强低照度图像上有一定的效果,但是经增强后的图像容易出现色彩失真的现象。第二类低照度图像增强算法是建立在Land[3]提出的Retinex理论上,Jobson等[4-5]先后提出了单尺度Retinex(SSR)方法和多尺度Retinex(MSRCR)方法对低照度图像进行增强。Fu等[6]提出了一种基于融合的低照度图像增强算法,Guo等[7]提出通过Retinex理论估计低照度图像的照度图,从而实现对低照度图像增强的算法。Ying等[8]提出利用相机模型对低照度图像增强算法,以及Ren等[9]提出了一种结合图像去噪的低照度图像增强算法,这些方法虽然在视觉上相对于低照度图像有一定的提高,但是增强后的图像容易出现颜色失真、边缘伪影等问题。

随着深度学习在目标检测、超分辨率重建等方面的发展,诸多学者也将深度学习用于低照度图像增强领域。Lore等[10]第一次提出用深度学习中的自动编码器实现低照度图像增强;Li等[11]提出的LightenNet,直接通过四层卷积层估计照度图,并结合Retinex理论得到最终的增强图像;马红强等[12]将RGB图像转换到HSI颜色空间,直接通过深度的卷积神经网络对亮度通道进行训练,最终得到增强的正常照度图像。而在Goodfellow等[19]提出生成对抗网络(GAN)后,一些学者将生成对抗网络应用到图像处理领域。Isola等[13]通过条件生成对抗网络实现图像到图像的转换任务,唐贤伦等[14]实现了用深度卷积的条件生成对抗网络对图像进行识别。

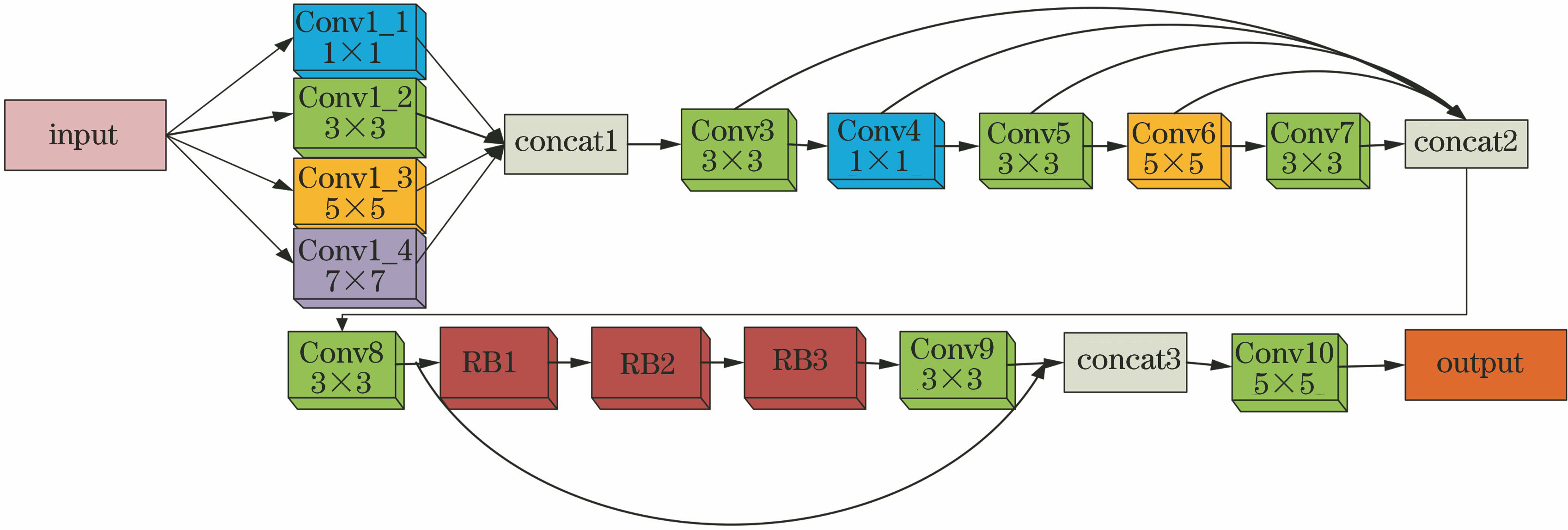

本文提出了一种基于级联残差生成对抗网络的低照度图像增强算法,避免了直接使用自动编码器网络,以及近年来经典的全卷积神经网络。所提的级联残差卷积神经网络作为生成器网络,其优势是通过多尺度卷积和残差模块提取图像的特征信息。该生成对抗网络结构主要包括生成器网络中的多尺度特征提取、特征融合以及级联残差学习,不断获得丰富的低照度图像的特征,并提高特征信息的利用率,加快网络收敛速度,以及使用改进的PatchGAN作为判别器网络来监督生成器网络,提高生成器网络生成接近正常照度图像的能力。

2 相关理论

2.1 Retinex理论模型

Retinex理论是由Land[3]提出来的一种颜色恒常知觉的计算理论模型,该模型认为物体的颜色是由物体对光线的反射能力决定,而不是由反射光强度决定。物体的色彩不受光照非均匀性的影响,具有一致性。该模型可以表示为

式中:S表示观察到的低照度图像;R表示物体本质的反射图;I表示外界光照环境的照度图;°表示逐像素乘法。

2.2 HSV颜色空间模型

现阶段常用的彩色图像模型主要有两种,一种是面向硬件设备的RGB颜色空间模型,另一种是面向视觉感知的HSV颜色空间模型。相比于RGB颜色空间,HSV颜色空间更接近于人类视觉经验和对色彩的认识。HSV颜色空间模型是通过色调、饱和度和亮度三个属性来描述彩色图像。其中,色调又称色彩,是描述颜色的一种属性;饱和度是指色彩的纯度;亮度是指色彩的明暗程度和亮度的高低,亮度越低,图像越接近灰色或黑色,亮度越高,图像越接近白色。对于HSV颜色空间,仅改变亮度分量,不会改变图像颜色细节信息。彩色图像的每个像素表示一个RGB值,这些像素形成了一幅彩色图像。不同的颜色空间模型都能表示同一种颜色,因此它们之间是可以相互转换的。RGB颜色空间中R、G、B进行归一化后,这三个分量都在[0,1]之间,而对应的HSV颜色空间中的H、S、V分量分别可以由R、G、B来表示:

2.3 生成对抗网络以及PatchGAN理论

生成对抗网络是受博弈论中的二人零和博弈(即二人的利益之和为零,一方的所得正是另一方的所失)的启发,由生成网络和判别网络组成。 生成网络捕捉真实数据样本的潜在分布,并生成新的数据样本,判别网络区分真实样本与生成的数据样本。生成网络不断训练更新网络参数,使得判别网络无法判别出生成的样本数据的真假。判别网络也不断更新网络,获得更准确的鉴别能力,它们相互博弈,最终训练的网络达到平衡,就得到最好的结果。

在生成对抗网络中,常用的判别器网络是一个二分类器,判别输入数据是真实数据还是生成数据。然而PatchGAN替换生成对抗网络原始的判别器网络,将其判别器网络变成了全卷积网络。原始GAN判别器网络需要输出一个真或假的矢量,但是PatchGAN输出的是一个N×N的矩阵A,Aij的值代表每个Patch为真样本的概率,A其实就是卷积层输出的特征图。

3 低照度图像增强算法

本文所提的级联残差生成对抗网络避免了直接将低照度的RGB图像输入到网络进行训练,而是结合与人类视觉感知非常接近的HSV颜色模型,将低照度的RGB图像转换到HSV颜色空间。经统计实验发现,低照度图像的照度主要分布在HSV空间的亮度分量,因此本文通过级联残差卷积神经网络学习低照度图像中低照度的特征,最终得到正常照度的清晰图像。并使用PatchGAN判别器来提高图像增强的质量,加快网络收敛速度。

3.1 生成器网络结构

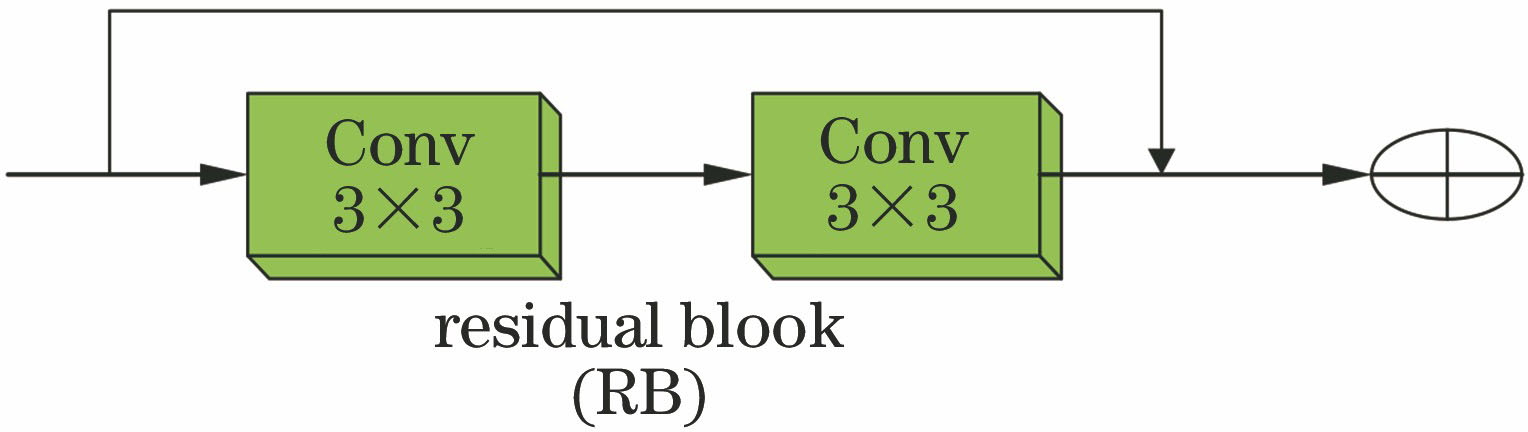

级联残差卷积神经网络作为生成器网络,建立了低照度图像与正常照度图像之间亮度通道的映射关系,并通过反向传播算法训练生成器网络中的权重,使得生成器网络具有更好的生成正常照度图像的能力。本文的生成器网络主要由多尺度特征提取、特征融合、级联残差学习、重建这四部分组成。多尺度特征提取是由4个不同尺度的卷积层和1个连接操作构成,特征融合是通过5个卷积层和1个连接操作将特征联合。而在级联残差学习阶段,依次采用1个卷积层、3个相同的残差模块以及1个卷积层来学习图像的特征,并将级联残差学习阶段的浅层与深层的特征图进行级联,其中每个残差模块由2个卷积层和1个快捷连接操作构成。最后利用1个卷积层来重建,获得增强的图像。其网络结构和该网络中的残差模块如

1) 多尺度特征提取。采用多尺度卷积对输入图像的亮度分量进行提取,不仅能够获得丰富的低照度图像的相关特征,保留图片更多的细节信息,也能在不同尺度下,提高所捕获的图像信息的鲁棒性和有效性。本文分别采用1×1,3×3,5×5和7×7四种不同尺度的卷积核从输入图像中提取特征,每种卷积核个数为16,同时将不同尺度提取的特征图进行连接,作为低照度图像的多尺度特征。多尺度卷积特征提取的计算公式为

式中:Wmi(i=1,2,3,4)表示第m层的第i组卷积核;Gmi表示第m层输出的第i组特征图;X表示输入图像;*表示卷积操作。本文除最后一层卷积层外,其余每一层卷积后都使用修正线性单元(Relu)作为激活函数,卷积层最终的输出表示为

式中:Bm表示第m层的偏置。

2) 特征融合。采用5层卷积层进行特征提取,再将每个卷积层提取的特征图进行融合。分别使用3×3,1×1,3×3,5×5和3×3大小的卷积核,每层卷积核个数均为32,来捕获图像特征信息。使用了3个3×3的卷积核,通过小尺寸卷积核的堆叠来使所获得的感受野与用一个大尺寸的卷积核所获得的感受野大小一致,起到了隐式正则化的作用。间隔先使用1×1的卷积核,可以达到降维的目的,减少网络参数,再间隔使用5×5的卷积核,可以在浅层网络中增大感受野。并通过连接操作,将5层的特征图联合,使得多个卷积提取的特征进行融合。不仅保留了每层特征图的细节信息,也加快网络训练速度。

3) 级联残差学习。为防止在网络层数加深时,出现网络退化现象,依次采用1个3×3×32的卷积层、3个相同的残差模块、1个3×3×32的卷积层和1个级联操作,其中每个残差模块分别使用3×3×64、3×3×32卷积核和1个快捷连接操作。通过使用残差模块,可以控制网络的参数数量,而且保证了特征图的输出表达能力,提高了传播效率。最后,将浅层的卷积操作得到的特征图与残差模块学习后通过卷积提取的特征图进行级联,有利于加快网络训练速度和梯度的保持。残差学习的映射函数为

式中:Hm为第m层残差块的输入;Hm+1为第m+1层残差块的输出;F(Hm)表示学习的残差。

4) 重建。设计了1个卷积层产生最后的正常照度图像,实现了低照度图像增强后的重建。使用大小为3×3×1的卷积核,参数较少,加快了网络的训练速度,从而得到最佳的正常照度图像。该卷积层用函数表示为

式中:Gni表示最后一层(第n层)第i组特征图;Wni表示最后一层(第n层)第i组的卷积核;Bn表示最后一层(第n层)的偏置。

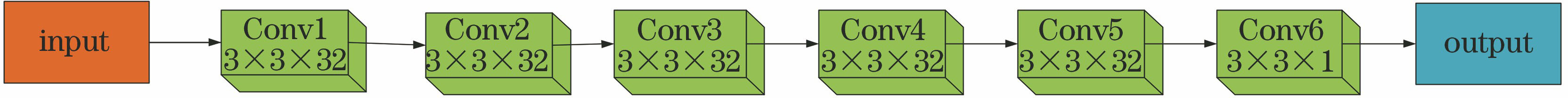

3.2 判别器网络结构

判别器的作用就是区分出参考图像与生成器生成的图像,而判别器网络结构一般比较简单。本文的判别器受Isola等[13]提出的PatchGAN判别器的启发,设计了6层全卷积层的卷积神经网络,除最后一层卷积层外,每层卷积后使用Relu激活函数。不同于原始的GAN判别器作为真假二分类器,该判别器输出的是N×N的矩阵,它对小尺寸的图像块进行计算,减少了参数量和计算量,加快了收敛速度。其结构如

3.3 损失函数

生成器网络和判别器网络训练过程中均使用均方误差(MSE)损失函数。对于生成器网络,使用MSE损失函数计算增强后的图像与正常照度图像之间的误差。对于判别器网络,使用MSE损失函数计算判别器网络处理后的图像与正常照度图像之间的损失,其损失值越小,说明生成器生成的图像越接近真实图像,判别器起到监督的作用。生成器和判别器的损失函数计算公式分别为

式中:N表示样本训练数目;Yi表示第i组真实的正常照度图像值;Pi表示生成器生成的第i组的输出值;Qi表示判别器第i组输出值;Lgen表示生成器网络的损失值;Ldis表示判别器网络的损失值。

4 实验与结果分析

本节描述了实验数据集的获取、实验设置以及实验步骤。为了评估本文模型的性能,将本文算法的增强结果与经典对比算法的结果进行比较,选取的经典对比算法有:基于融合的文献[ 6]算法、文献[ 7]算法、基于相机模型的文献[ 8]算法、文献[ 9]算法、文献[ 10]算法、文献[ 11]算法以及文献[ 12]算法,分别在合成的低照度图像数据集与真实的低照度图像数据上进行对比分析。为了说明本文模型设计的有效性,还对生成器网络与生成对抗网络进行对比实验。

4.1 实验数据及实验设置

实验数据:由于拍摄低照度图像与其同一时刻同一场景的正常照度图像是非常困难的,本文从公开数据集Berkeley Segmentation Dataset[15]中选取60幅正常照度的图像,并基于Retinex理论模型,合成240张低照度图像,其光照分量I可在(0,1)随机取值。将合成的200幅低照度图像作为训练样本,40幅作为测试样本。

实验设置:本文使用caffe深度学习开源框架实现网络训练,并用软件Matlab R2016a进行测试。在网络训练中,每层卷积核初始化为高斯分布,采用固定的学习率,设置为0.0001,动量参数设为0.9,迭代次数为105。该模型训练采用小批量训练方式,batch-size为2,并采用Adam算法优化网络参数。实验所用的计算机的GPU配置为Nvidia GTX 1060。

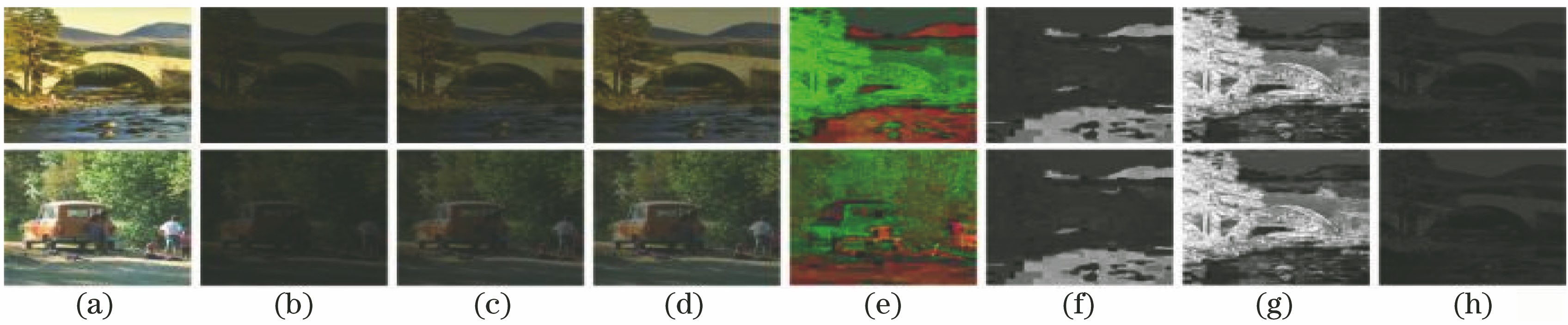

图 4. 不同图像。(a)正常照度的River和Car;(b)照度为0.2的图像;(c)照度为0.35的图像;(d)照度为0.5的图像;(e)照度为0.2时HSV颜色空间图像;(f) H分量;(g) S分量;(h) V分量

Fig. 4. Different images. (a) River and car of normal-light images; (b) images with illuminance of 0.2; (c) images with illuminance of 0.35; (d) images with illuminance of 0.5; (e) HSV color space images with illuminance of 0.2; (f) H component; (g) S component; (h) V component

实验步骤:1)采用数据集Berkeley Segmentation Dataset通过Retinex理论模型获取低照度图像数据集;2)将低照度图像RGB图像数据集与正常照度的RGB图像数据集转化为HSV颜色空间各分量的图像;3)对低照度图像与正常照度的亮度(V)分量图像通过级联残差生成对抗网络模型进行训练与测试;4)将HSV颜色空间中亮度(V)分量增强后的图像与其余两个分量的图像转换到预测的正常照度的RGB图像;5)分析基于合成的低照度图像数据集的增强结果;6)分析基于真实的低照度图像数据集的增强结果;7)分析模型对比实验的增强结果。

所提算法流程图如

![不同算法对低照度图像Starfish的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[6]算法;(d)文献[7]算法;(e)文献[8]算法;(f)文献[9]算法;(g)文献[10]算法;(h)文献[11]算法;(i)文献[12](/richHtml/lop/2020/57/14/141024/img_6.jpg)

图 6. 不同算法对低照度图像Starfish的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[

6]算法;(d)文献[

7]算法;(e)文献[

8]算法;(f)文献[

9]算法;(g)文献[

10]算法;(h)文献[

11]算法;(i)文献[

12

Fig. 6. Enhanced results of low-light image Starfish by different algorithms. (a) Low-light image; (b) normal-light image; (c) Ref. [6] algorithm; (d) Ref. [7] algorithm; (e) Ref. [8] algorithm; (f) Ref. [9] algorithm; (g) Ref. [10] algorithm; (h) Ref. [11] algorithm; (i) Ref. [12] algorithm; (j) proposed algorithm

4.2 基于合成低照度图像数据集上的实验结果分析

为了验证本文算法在低照度图像增强上的效果,在合成数据集上将本文算法与其他算法进行对比。从合成数据集中选取3幅低照度图像,不同算法增强的效果如

对于

![不同算法对低照度图像Man的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[6]算法;(d)文献[7]算法;(e)文献[8]算法;(f)文献[9]算法;(g)文献[10]算法;(h)文献[11]算法;(i)文献[12</xre](/richHtml/lop/2020/57/14/141024/img_7.jpg)

图 7. 不同算法对低照度图像Man的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[

6]算法;(d)文献[

7]算法;(e)文献[

8]算法;(f)文献[

9]算法;(g)文献[

10]算法;(h)文献[

11]算法;(i)文献[

12Fig. 7. Enhanced results of low-light image Man by different algorithms. (a) Low-light image; (b) normal-light image; (c) Ref. [6] algorithm; (d) Ref. [7] algorithm; (e) Ref. [8] algorithm; (f) Ref. [9] algorithm; (g) Ref. [10] algorithm; (h) Ref. [11] algorithm; (i) Ref. [12] algorithm; (j) proposed algorithm

Fig. 7. Enhanced results of low-light image Man by different algorithms. (a) Low-light image; (b) normal-light image; (c) Ref. [6] algorithm; (d) Ref. [7] algorithm; (e) Ref. [8] algorithm; (f) Ref. [9] algorithm; (g) Ref. [10] algorithm; (h) Ref. [11] algorithm; (i) Ref. [12] algorithm; (j) proposed algorithm

![不同算法对低照度图像Street的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[6]算法;(d)文献[7]算法;(e)文献[8]算法;(f)文献[9]算法;(g)文献[10]算法;(h)文献[11]算法;(i)文献[12</](/richHtml/lop/2020/57/14/141024/img_8.jpg)

图 8. 不同算法对低照度图像Street的增强结果。(a)低照度图像;(b)正常照度图像;(c)文献[

6]算法;(d)文献[

7]算法;(e)文献[

8]算法;(f)文献[

9]算法;(g)文献[

10]算法;(h)文献[

11]算法;(i)文献[

12Fig. 8. Enhanced results of low-light image Street by different algorithms. (a) Low-light image; (b) normal-light image; (c) Ref. [6] algorithm; (d) Ref. [7] algorithm; (e) Ref. [8] algorithm; (f) Ref. [9] algorithm; (g) Ref. [10] algorithm; (h) Ref. [11] algorithm; (i) Ref. [12] algorithm; (j) proposed algorithm

Fig. 8. Enhanced results of low-light image Street by different algorithms. (a) Low-light image; (b) normal-light image; (c) Ref. [6] algorithm; (d) Ref. [7] algorithm; (e) Ref. [8] algorithm; (f) Ref. [9] algorithm; (g) Ref. [10] algorithm; (h) Ref. [11] algorithm; (i) Ref. [12] algorithm; (j) proposed algorithm

为了定量地评价这些算法,本文从合成的数据集中随机抽取了5幅低照度图像,使用峰值信噪比(PSNR)[16]和结构相似度(SSIM)[17]两项常用的客观评价指标进行评价。

PSNR是评价图像质量最广泛使用的客观评价标准之一,是一种全参考的图像质量评价指标。它反映了图像结构信息的完整性,其值越高,图像受噪声的影响越小,失真也越小,这意味着其值越高,低照度图像增强的效果就越好。其计算公式为

式中:x为增强的图像;y为参考的正常照度图像。

SSIM也是一种常用的图像质量评价指标,反映了两幅图像结构信息的相似性。其值越大,两幅图像越接近,图像的失真就越小,其计算公式为

式中:x、y分别为增强的图像和参考的正常照度的清晰图像;μx为x的平均值;μy为y的平均值;

基于合成的低照度图像的不同算法的客观评价指标对比结果如

表 1. 不同算法的PSNR和SSIM

Table 1. PSNR and SSIM of different algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

4.3 基于真实的低照度图像数据集上的实验结果分析

本文算法在合成的低照度图像上进行训练,并在合成测试集上取的不错的增强效果。为了进一步说明本文算法的优势,

从

![不同算法对真实的低照度图像Pocky的增强结果。(a)真实的低照度图像;(b)文献[6]算法;(c)文献[7]算法;(d)文献[8]算法;(e)文献[9]算法;(f)文献[10]算法;(g)文献[11]算法;(h)文献[12](/richHtml/lop/2020/57/14/141024/img_9.jpg)

图 9. 不同算法对真实的低照度图像Pocky的增强结果。(a)真实的低照度图像;(b)文献[ 6]算法;(c)文献[ 7]算法;(d)文献[ 8]算法;(e)文献[ 9]算法;(f)文献[ 10]算法;(g)文献[ 11]算法;(h)文献[ 12

Fig. 9. Enhancement results of real low-light image Pocky by different algorithms. (a) Real low-light image; (b) Ref. [6] algorithm; (c) Ref. [7] algorithm; (d) Ref. [8] algorithm; (e) Ref. [9] algorithm; (f) Ref. [10] algorithm; (g) Ref. [11] algorithm; (h) Ref. [12] algorithm; (i) proposed algorithm

![不同算法对真实低照度图像Palace的增强效果。(a)真实的低照度图像;(b)文献[6]算法;(c)文献[7]算法;(d)文献[8]算法;(e)文献[9]算法;(f)文献[10]算法;(g)文献[11]算法;(h)文献[12](/richHtml/lop/2020/57/14/141024/img_10.jpg)

图 10. 不同算法对真实低照度图像Palace的增强效果。(a)真实的低照度图像;(b)文献[ 6]算法;(c)文献[ 7]算法;(d)文献[ 8]算法;(e)文献[ 9]算法;(f)文献[ 10]算法;(g)文献[ 11]算法;(h)文献[ 12

Fig. 10. Enhancement results of real low-light image Palace by different algorithms. (a) Real low-light image; (b) Ref. [6] algorithm; (c) Ref. [7] algorithm; (d) Ref. [8] algorithm; (e) Ref. [9] algorithm; (f) Ref. [10] algorithm; (g) Ref. [11] algorithm; (h) Ref. [12] algorithm; (i) proposed algorithm

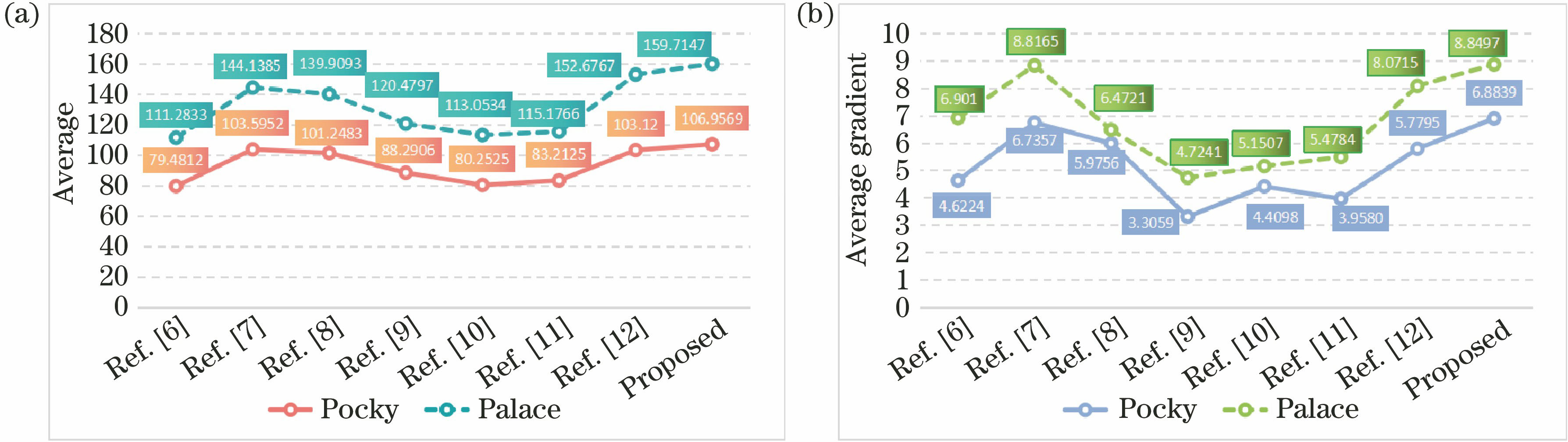

为了客观地评价真实的低照度图像,由于真实的低照度图像没有同一时刻、同一场景的正常照度图像作为其参考图像,因此本文从无参考图像评价指标中的图像均值、平均梯度两方面进行评价。图像均值反映了图像的平均明暗程度,即图像亮度,均值越大,图像亮度就越大。平均梯度反映了图像的清晰度和纹理变化,平均梯度越大,图像越清晰。不同算法对于真实低照度图像的图像均值和平均梯度变化曲线如

从

图 11. 不同算法对比结果。(a)均值;(b)平均梯度

Fig. 11. Comparison results of different algorithms. (a) Average; (b) average gradient

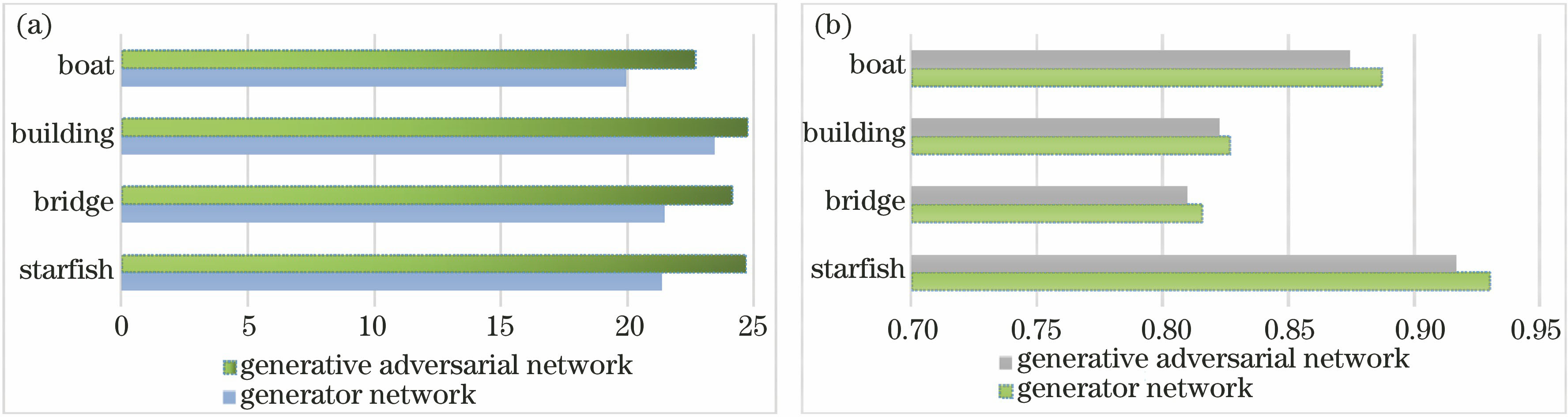

4.4 模型对比实验结果分析

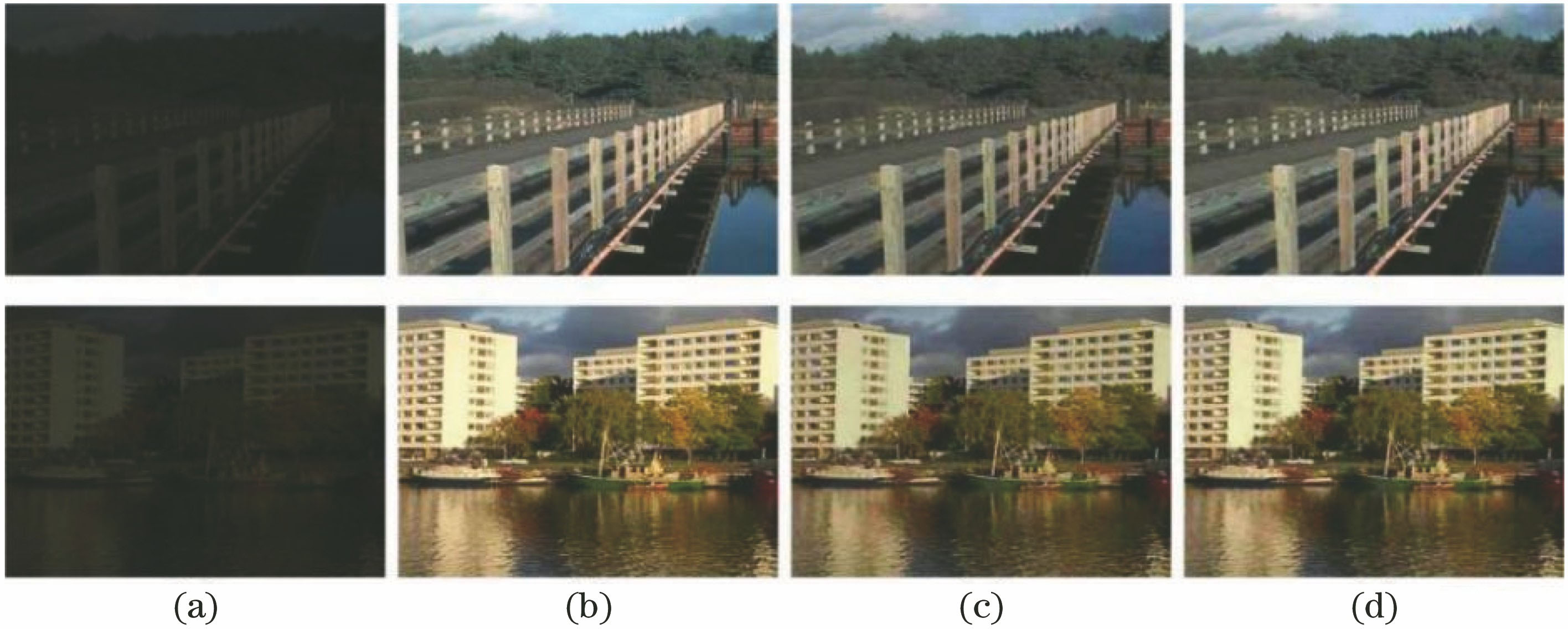

为验证本文模型设计的合理性和有效性,本节将生成器网络模型与生成对抗网络模型在合成数据集上进行实验对比。两个模型除了自身的网络结构不同,其他实验条件都相同,并将训练的合成数据集中的图像进行测试,选取2幅图像展示,如

图 12. 生成器网络与生成对抗网络模型对低照度图像增强结果的主观对比。(a)低照度图像;(b)正常照度图像;(c)生成器网络;(d)生成对抗网络

Fig. 12. Subjective comparison of low-light image enhancement results by generator network and generative adversarial network. (a) Low-light image; (b) normal-light image; (c) results of generator network; (d) results of generative adversarial network

由

图 13. 生成器网络和生成对抗网络在不同图像的结果对比。(a) PSNR;(b) SSIM

Fig. 13. Comparison results of generator network and generative adversarial network of different images. (a) PSNR; (b) SSIM

5 结论

本文提出的基于级联残差生成对抗网络的低照度图像增强算法,是将级联残差卷积神经网络作为生成器网络,对低照度图像在HSV颜色空间中亮度分量增强,改进了传统方法以及全卷积神经网络直接对低照度RGB图像的增强。将多尺度卷积与残差学习结合,与仅使用残差模块网络相比,提高了网络的利用率,并且,使用个数较少的残差模块,可以减少网络参数。同时,本文使用改进的PatchGAN作为判别器,替换了生成对抗网络中一般使用的二分类的判别器,使得生成器网络获得更佳的增强低照度图像的能力,进一步加速网络的训练。实验结果表明,与其他对比算法相比,本文算法具有更佳的低照度图像增强能力。随后的研究内容将结合低照度图像照度不均匀的特征,对网络结构进一步优化,获得更好的增强效果。

[1] Pizer S M, Amburn E P, Austin J D, et al. Adaptive histogram equalization and its variations[J]. Computer Vision, Graphics, and Image Processing, 1987, 39(3): 355-368.

[2] Reza A M. Realization of the contrast limited adaptive histogram equalization (CLAHE) for real-time image enhancement[J]. The Journal of VLSI Signal Processing-Systems for Signal, Image, and Video Technology, 2004, 38(1): 35-44.

[3] Land E H. The retinex theory of color vision[J]. Scientific American, 1977, 237(6): 108-128.

[4] Jobson D J, Rahman Z, Woodell G A. Properties and performance of a center/surround Retinex[J]. IEEE Transactions on Image Processing, 1997, 6(3): 451-462.

[5] Jobson D J, Rahman Z, Woodell G A. A multiscale retinex for bridging the gap between color images and the human observation of scenes[J]. IEEE Transactions on Image Processing, 1997, 6(7): 965-976.

[6] Fu X Y, Zeng D L, Huang Y, et al. A fusion-based enhancing method for weakly illuminated images[J]. Signal Processing, 2016, 129: 82-96.

[7] Guo X J, Li Y, Ling H B. LIME: low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2017, 26(2): 982-993.

[8] Ying ZQ, LiG, Ren YR, et al. A new low-light image enhancement algorithm using camera response model[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017. Venice. IEEE, 2017.

[9] Ren XT, Li MD, Cheng WH, et al. Joint enhancement and denoising method via sequential decomposition[C]∥2018 IEEE International Symposium on Circuits and Systems (ISCAS), May 27-30, 2018. Florence. IEEE, 2018: 1- 5.

[10] Lore K G, Akintayo A, Sarkar S. LLNet: a deep autoencoder approach to natural low-light image enhancement[J]. Pattern Recognition, 2017, 61: 650-662.

[11] Li C Y, Guo J C, Porikli F, et al. LightenNet: a convolutional neural network for weakly illuminated image enhancement[J]. Pattern Recognition Letters, 2018, 104: 15-22.

[12] 马红强, 马时平, 许悦雷, 等. 基于深度卷积神经网络的低照度图像增强[J]. 光学学报, 2019, 39(2): 0210004.

[13] IsolaP, Zhu JY, Zhou TH, et al. Image-to-image translation with conditional adversarial networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017. Honolulu, HI. IEEE, 2017: 1125- 1134.

[14] 唐贤伦, 杜一铭, 刘雨微, 等. 基于条件深度卷积生成对抗网络的图像识别方法[J]. 自动化学报, 2018, 44(5): 855-864.

Tang X L, Du Y M, Liu Y W, et al. Image recognition with conditional deep convolutional generative adversarial networks[J]. Acta Automatica Sinica, 2018, 44(5): 855-864.

[15] Chen XY, Wang SA. Superpixel segmentation based on delaunay triangulation[C]∥2016 23rd International Conference on Mechatronics and Machine Vision in Practice (M2VIP), November 28-30, 2016. Nanjing, China. IEEE, 2016: 1- 6.

[16] Mannos J, Sakrison D. The effects of a visual fidelity criterion of the encoding of images[J]. IEEE Transactions on Information Theory, 1974, 20(4): 525-536.

[17] Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[18] Ma K D, Zeng K, Wang Z. Perceptual quality assessment for multi-exposure image fusion[J]. IEEE Transactions on Image Processing, 2015, 24(11): 3345-3356.

[19] GoodfellowI, Pouget-AbadieJ, MirzaM, et al. Generative adversarial nets[C]∥Advances in Neural Information Processing Systems, 2014: 2672- 2680.

Article Outline

陈清江, 屈梅. 基于级联残差生成对抗网络的低照度图像增强[J]. 激光与光电子学进展, 2020, 57(14): 141024. Qingjiang Chen, Mei Qu. Low-Light Image Enhancement Based on Cascaded Residual Generative Adversarial Network[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141024.