基于改进的Mask R-CNN的乳腺肿瘤目标检测研究  下载: 1300次

下载: 1300次

1 引言

乳腺癌是全球女性死亡率最高的恶性肿瘤之一。目前,乳腺癌已成为一个关乎我国乃至全球女性健康的重大问题。2018年公布的统计结果显示,乳腺癌是发病率最高的癌症,约占新增病例总数的11.6%,占死亡病例总数的6.6%[1]。《中国肿瘤登记年报》显示乳腺癌是中国女性癌症患者中最常见的癌症[2]。近10年来,中国女性的乳腺癌发病率和死亡率迅速上升,是全世界平均发病率和死亡率的两倍[3]。目前,乳腺X线摄影技术[4]是诊断乳腺癌最可靠的方法,主要原因是乳腺X线图像分辨率高。然而,乳腺X线图像自身也存在一些缺陷,例如,病灶区域对比度不明显,而且小的肿块或钙化点受乳腺周围组织的影响可能会使医生出现视觉上的混乱,导致医生在读取乳腺X线图像过程中耗时耗力,诊断效率不高[5],甚至可能出现漏诊误诊。

近年来,随着人工智能医疗技术的快速发展,利用计算机辅助诊断(CAD)技术检测疾病已成为时代的大趋势[6]。很多研究人员利用CAD技术对乳腺图像进行了研究,并取得了相应的研究成果[7-9]。然而,这些对乳腺病灶区域的研究均是基于传统的机器学习方法进行的,虽然取得了一定效果,但其检测精度与提取的特征密切相关,而特征的提取过程需要根据人群的特异性进行调整,因此很难推广。此外,以上针对乳腺病理图像进行分类的算法大都是在小型数据集上进行研究的,模型的泛化能力无法得到保证,不适用于对大型数据集进行图像识别。

基于深度学习的方法已被成功应用于医学成像中[10-14],极大地提升了图像识别的准确率。文献[ 11]提出了Mask R-CNN网络,该网络使用预先训练好的卷积神经网络来抽取特征,有效地提升了识别精度。文献[ 12]提出了基于DenseNet和反卷积的DD-Net( DenseNet and deconvolution-based network)神经网络。DD-Net结合了DenseNet和反褶积的优点,采用快捷连接的方式将DenseNet和反褶积串联起来,加快了网络的训练速度。然而,Mask R-CNN网络的基准网络是残差网络,在提取特征时,精度不够高。针对这一问题,本文提出了一种新的网络——Mask R-CNN-II网络,并在MaskR-CNN-II网络中应用迁移学习算法,从病变图像中检测和分割乳腺肿瘤,以提高对肿瘤的检测精度,这对于辅助医生诊断具有积极意义。本文主要以乳腺癌的研究现状为背景,围绕乳腺X线图像预处理和深度学习算法,对乳腺癌的病灶区域进行了良恶性分类与检测研究。

2 乳腺图像的处理

2.1 乳腺图像预处理

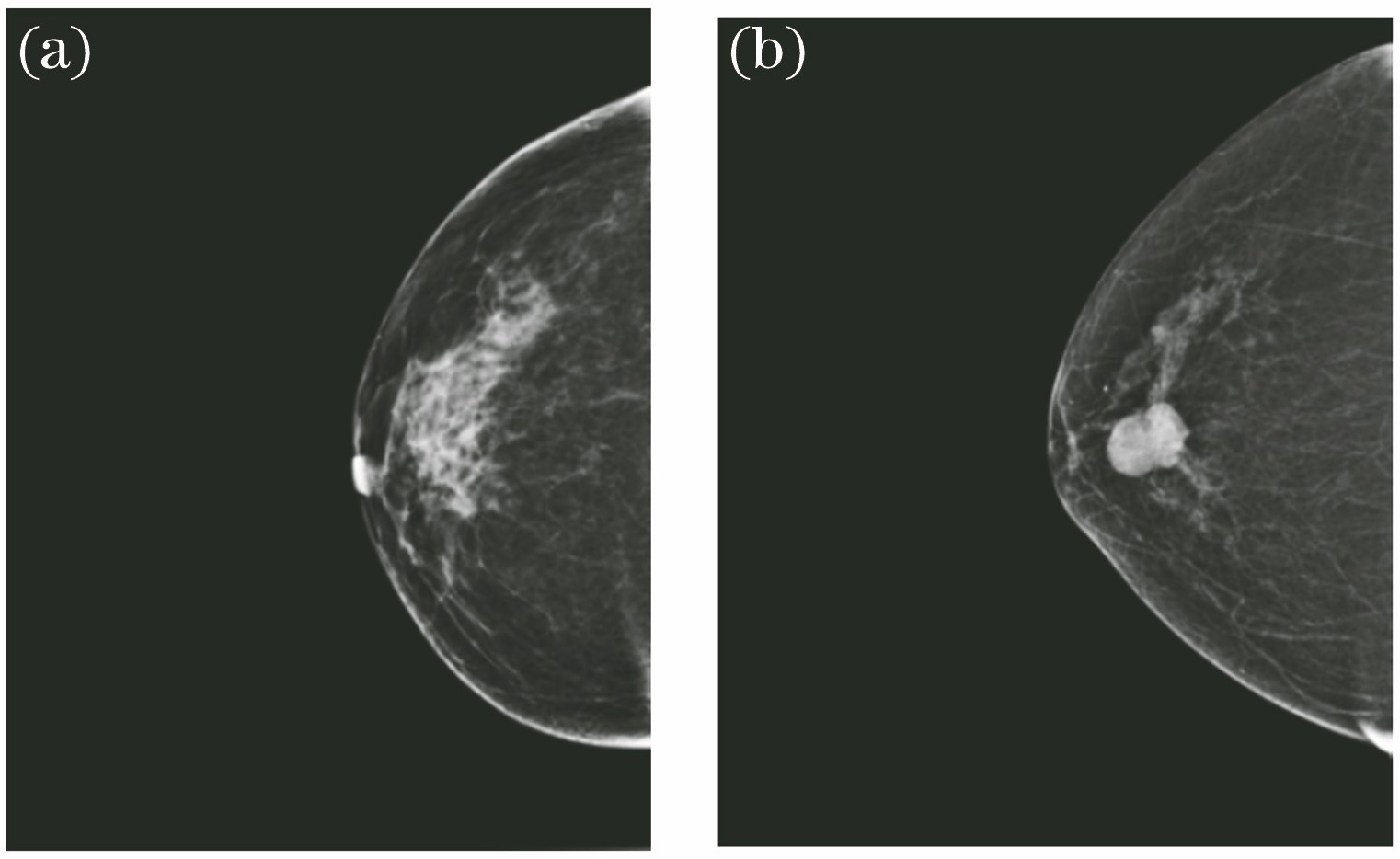

本文采用的图像均取自山西医科大学第一医院,乳腺图像共计2048张,其中患病乳腺图像为1072张,正常乳腺图像为976张。数据库中所有的乳腺图像都已由专家进行了相应的标记,并将肿瘤划分为6个等级。

图 1. 正常乳腺图像以及患病乳腺图像。(a)正常乳腺图像; (b)患病乳腺图像

Fig. 1. Normal and diseased breast images. (a) Normal breast image; (b) diseased breast image

全数字化乳腺X线摄影机拍摄的图像具有较高的分辨率,且该摄影机的诊断工作台采用的是全分辨率模式,可以把图像的细节非常清晰地呈现出来。在检查过程中,可以获得左乳腺头(LCC)、左乳腺侧(LMLO)、右乳腺头(RCC)和右乳腺侧(RMLO)[15]4种类型的乳腺X线图像,如

图 2. 4种类型的乳腺图像。(a) LCC;(b) LMLO;(c) RCC;(d) RMLO

Fig. 2. Images of four types of breast. (a) LCC; (b) LMLO; (c) RCC; (d) RMLO

2.2 乳腺图像去背景

图 3. 原始图像与去背景图像。(a)原始图像;(b)去背景图像

Fig. 3. Original image and image with background elimination. (a) Original image; (b) image with background elimination

2.3 病变区域数据集及图像融合

乳腺肿瘤的种类一共有6种,病变等级分别为2、3、4a、4b、4c、5,等级越高患有恶性肿瘤的可能性越大。6种病变等级如

每一张乳腺图片都可能出现多处不同等级的病变区域,医生在诊断过程中根据病变等级最高的进行判断。在本文所使用的原始数据集的标定中,出现等级4c或5就被认定为恶性肿瘤。

为了更好地实现网络的迁移学习,本文先使用6种等级的肿瘤图片对网络进行预训练,之后再训练原始数据集。医生已在病变图像中标记出病变区域以及分类,所有图像中一共有1932处病灶区域,各等级病变区域的数量及其占病变总区域数量的比例如

图 4. 病变等级。(a)等级2;(b)等级3;(c)等级4a;(d)等级4b;(e)等级4c;(f)等级5

Fig. 4. Lesion grade. (a) Lesion grade 2; (b) lesion grade 3; (c) lesion grade 4a; (d) lesion grade 4b; (e) lesion grade 4c; (f) lesion grade 5

表 1. 各等级病变区域的数量及其占病变总区域数量的比例

Table 1. Number of lesion areas of each grade and their corresponding proportions to the total number of lesion areas

|

在训练模型时,数据集不足会导致模型产生过拟合现象,降低模型的准确率。为了避免此现象的发生,本文使用图像融合[17]的方法来扩大数据集。对于每一张病变图像,将病变区域数据与相应的健康区域进行融合,以获得大样本数据集。

图 5. 病变区域、健康区域的图像以及二者的融合图像。(a)病变区域的图像;(b)健康区域的图像;(c)融合图像

Fig. 5. Images of diseased and healthy areas and their fusion image. (a) Image of diseased area; (b) image of healthy area; (c) fusion image

3 网络改进

本文选取Mask R-CNN[11]网络作为乳腺肿瘤检测的基本网络。Mask R-CNN是一种当前较为先进的目标检测网络,它包含两个分支,能够同时实现分类、回归及分割三项任务。该网络通过引入分割任务,有效提高了模型的检测性能;此外,该模型通过使用ROI Align层替代传统的ROI pooling层,有效克服了定位偏移的问题。下面分别介绍Mask R-CNN网络及其具体的改进方式。

3.1 Mask R-CNN网络

在医学图像识别中,选取正确的网络模型非常重要,对模型的要求是不仅要快还要准。因此,本文选取了不仅精度高而且速度快的Mask R-CNN网络,其具体结构如

图中CNN表示基准网络,RPN代表生成建议窗口网络,ROI Align代表使用双线性插值得到与原图中ROI对应的特征图中的区域(保留坐标的对应关系),Mask branch代表分支网络。从网络结构中可以看出,Mask R-CNN网络最终通过两个分支输出结果,第一个分支输出背景和物体的分割结果,第二个分支输出分类和坐标结果。但是由于Mask R-CNN网络的基准网络是残差网络,在提取特征时,精度达不到要求,因此对Mask R-CNN的基准网络进行改进是非常有必要的。

3.2 改进Mask R-CNN网络

DenseNet神经网络模型不同于其他的卷积神经网络,其主要的特点是:1)采用了一种新的密集连接机制,即该模型当前的输入,不仅与前一层的输出有关联,还与之前所有的输出有关联。该模型将之前所有层的输出通过一定的方式组合在一起,然后输入到该层,这样做的目的主要是提高特征图的利用率,强化特征传播。2)由于每一层的特征图都得到了重复利用,所以每一层都利用了少量的卷积核进行特征提取,大幅减少了模型产生的参数量。

DenseNet网络是Mask R-CNN网络的基准网络,但是DenseNet网络的卷积方式会造成很大浪费。而本文实验是在三块GPU(graphics processing unit)上运行的,使用的是分组卷积方式,在分组卷积中很难实现组与组之间的信息交流。所以本文使用Channel Shuffle卷积方式,目的是在减少DenseNet网络参数量的同时解决分组卷积方式中难以实现组与组之间信息交流的问题。Channel Shuffle卷积中的卷积方式与DenseNet网络的卷积方式并不相同。在DenseNet网络的卷积中,一组卷积核负责一组特征图,而在Channel Shuffle卷积中,则是一个卷积核负责一个特征图,这样就可以大大减少参数量。但这样会造成同一组数据之间信息的丢失,因此可以通过Shuffle操作来解决分组卷积中组内信息不交流以及组与组之间信息不交流的问题。

图 9. Channel Shuffle示意图。 (a)分组卷积; (b)应用Shuffle的过程; (c)应用Shuffle后的效果

Fig. 9. Schematic of Channel Shuffle. (a) Grouped convolution; (b) Shuffle process; (c) effect after applying Shuffle

4 实验仿真及结果分析

4.1 实验设置及评价指标

本文采用Pytorch框架进行实验,训练过程中使用Adam优化器,学习率设置为0.01。将图像数据集按照6∶2∶2的比例划分为训练集、测试集以及验证集,输入到网络中的乳腺X线图像的尺寸为224 pixel×224 pixel,batch size设为192,激活函数选择RELU函数。训练600个epoch,每组分组卷积核的大小为64,初始学习率设置为0.01,训练600个epoch,每隔100个epoch改变一次学习率。

本文选用mAP(mean average precision)[18]作为评价标准对网络结果进行分析评价。mAP是平均精度均值,即k个类别的精确率的均值,计算公式为

式中:p代表每个类别的平均精确率,用来评价每个类别的检测结果。mAP是目标检测算法中应用得最广泛的评价指标,其值越高,模型的分类性能就越好,其取值在0~1之间。以上的概念都可以从混淆矩阵的概念中引出。分类结果的混淆矩阵表如

Precision(P)和recall(R)分别指的是模型的准确率(也叫查准率)和召回率(也叫查全率),它们的表达式分别为

4.2 实验仿真及对比分析

4.2.1 图像去背景对模型性能的影响

为了验证去背景的意义,本文将原始图像以及去背景后的图像分为正常区域图像和病变区域图像两类。在这里,本文利用D-ShuffleNet网络进行迁移学习,并按照4.1节中的设置对模型进行训练。通过实验得到的准确率和损失函数分别如

图 10. 原始数据集与去背景数据集的准确率曲线

Fig. 10. Accuracy curves of original data set and data set with background elimination

图 11. 原始数据集与去背景数据集的损失函数曲线

Fig. 11. Loss curves of original data set and data set with background elimination

在

4.2.2 网络模型对比分析

为了证明所提模型能够有效实现乳腺肿瘤的检测,本文将其与另外4种较为流行的网络模型进行了对比。本文按照4.1节中的设置进行了5组实验,并使用Xavier initialization对模型的参数进行初始化。第1组实验使用本文提出的Mask R-CNN-II网络进行训练,第2组实验使用原始的Mask R-CNN网络进行训练,第3组实现使用You Only Look Once(YOLO)-V3[19]网络进行训练,第4组实验使用Single Shot MultiBox Detector(SSD)网络[20]进行训练,第4组使用Faster R-CNN网络进行训练。

表 3. 不同模型的训练结果

Table 3. Training results of each model

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||

4.2.3 迁移学习对模型性能的影响

在模型训练中,迁移学习[21]算法指的是利用神经网络模型训练一个其他的数据集,然后保留训练之后的网络参数,继续训练目标数据集。该算法具有加快训练速度和提高精度的作用。本文首先使用迁移学习的方式训练D-ShuffleNet网络。在模型训练收敛之后,保留模型参数,将训练之后的D-ShuffleNet网络作为Mask R-CNN-II网络的基准网络。本文按照4.1节中的设置对模型进行训练。实验过程使用了三块GPU,也就是分组卷积分为了三组。网络在预训练过程中的准确率和损失函数曲线如

此外,为了验证预训练对网络性能的影响,本文设置了另外两组对比实验。其中一组是使用原始的未经任何预处理的1160张病变区域数据集对模型进行预训练的模型,另一组是使用Xavier initialization进行参数初始化后的模型。之后本文按照4.1节的设置,使用经过预处理的病变区域图像对上述两组经过预训练的模型和一组没有经过预训练的模型进行实验。

表 4. 经过预训练和未经预训练模型的实验结果

Table 4. Experimental results of models with and without pretraining

| ||||||||||||||||||||||||||||||||||||||

4.3 模型性能的评估

关于模型评估的标准,除了最常用的几种之外,受试者工作特征曲线(ROC曲线)也是用来评价模型分类器性能的重要标准,它主要表示的是模型分类器的真阳率(灵敏性)和假阳率之间的关系。ROC曲线经过(0,0)点,曲线下方的面积用AUC表示。AUC的数值越大,表示模型对乳腺X线图像良恶性分类的性能越好。理想模型的AUC值为1,表示模型的准确率达到了100%。ROC曲线能很好地反映模型的泛化性能,其下方的面积为AUC,AUC值越大说明模型的泛化能力越好。

从

5 结论

本文通过结合DenseNet网络以及Channel Shuffle卷积方式,提出了一种新网络——D-ShuffleNet网络,进而提出了新的目标检测网络Mask R-CNN-II,并在Mask R-CNN-II网络中应用迁移学习算法对乳腺肿瘤目标进行检测研究。通过7组对比实验证明了本文所提Mask R-CNN-II网络相比其他网络的检测精度更高,同时通过实验验证了本文所使用的融合图像的思想以及迁移学习算法是有效的,最终提高了模型的准确率和识别率。然而,从实验结果中发现,虽然本文网络对6种等级乳腺肿瘤的识别准确率都有所提高,但是对于4a和4c这两种病变等级区域的识别率要明显低于对其他4种病变等级区域的识别准确率。所以,本文下一步将从各方面对网络进行研究,以提高网络的表达性能,同时提高模型对4a和4c病变等级区域的识别准确率。

[1] 马丹丹, 刘坤, 齐晓伟. 2018年全球癌症统计: 乳腺癌发病和死亡人数统计[J]. 中华乳腺病杂志(电子版), 2018, 12(6): 375.

Ma D D, Liu K, Qi X W. Global cancer statistics in 2018: statistics on morbidity and mortality of breast cancer[J]. Chinese Journal of Breast Disease (Electronic Edition), 2018, 12(6): 375.

[2] 何明艳. 乳腺癌流行趋势分析与术后放疗效应研究[D]. 衡阳: 南华大学, 2019: 20- 38.

He MY. Analysis of epidemic trend with breast cancer and research on the effect of postoperative radiotherapy[D]. Hengyang: University of South China, 2019: 20- 38.

[3] 周星彤, 沈松杰, 孙强. 中国乳腺癌筛查现状及进展[J]. 中国医学前沿杂志(电子版), 2020, 12(3): 6-11.

[4] Machida Y, Saita A, Namba H, et al. Automated volumetric breast density estimation out of digital breast tomosynthesis data: feasibility study of a new software version[J]. Springerplus, 2016, 5(1): 780-787.

[5] Rouhi R, Jafari M. Classification of benign and malignant breast tumors based on hybrid level set segmentation[J]. Expert Systems With Applications, 2016, 46: 45-59.

[6] Li C X, Shen C B, Xue K, et al. Artificial intelligence in dermatology: past, present, and future[J]. Chinese Medical Journal, 2019, 132(17): 2017-2020.

[8] 鲁逸峰, 金琴花, 荆晶, 等. 基于机器学习的可降解支架检测与分割算法[J]. 光学学报, 2018, 38(2): 0215005.

[10] RenR, HeK, GirshickR, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]∥ Proceedings of the 28th International Conference on Neural Information Processing Systems. [S.l.:s.n.], 2015: 91- 99.

[11] He K M, Gkioxari G, Dollár P, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 386-397.

[12] Zhang Z, Liang X, Dong X, et al. A sparse-view CT reconstruction method based on combination of DenseNet and deconvolution[J]. IEEE Transactions on Medical Imaging, 2018, 37(6): 1407-1417.

[13] 黄鸿, 彭超, 吴若愚, 等. 基于部分注释CT图像的自监督迁移学习肺结节分类[J]. 光学学报, 2020, 40(18): 1810003.

[14] 杨其利, 周炳红, 郑伟, 等. 基于全卷积递归网络的弱小目标检测方法[J]. 光学学报, 2020, 40(13): 1310002.

[16] 文婵娟. 数字乳腺断层摄影(DBT)对乳腺病变诊断价值的初步研究[D]. 广州: 南方医科大学, 2014: 20- 30.

Wen CJ. The diagnostic performance of digital breast tomosynthesis for breast lesions: a preliminary study[D]. Guangzhou: Southern Medical University, 2014: 20- 30.

[17] Ma J Y, Ma Y, Li C. Infrared and visible image fusion methods and applications: a survey[J]. Information Fusion, 2019, 45: 153-178.

[19] Shafiee MJ, ChywlB, LiF, et al. Fast YOLO: a fast You Only Look Once system for real-time embedded object detection in video[EB/OL]. [2020-07-13].https:∥arxiv.org/abs/1709. 05943.

[20] LiuW, AnguelovD, ErhanD, et al.SSD: single shot MultiBox detector[C]∥European Conference on Computer Vision. [S.l.]: Springer International Publishing, 2016: 21- 37.

[21] 张景祥, 王士同, 邓赵红, 等. 融合异构特征的子空间迁移学习算法[J]. 自动化学报, 2014, 40(2): 236-246.

Article Outline

孙跃军, 屈赵燕, 李毅红. 基于改进的Mask R-CNN的乳腺肿瘤目标检测研究[J]. 光学学报, 2021, 41(2): 0212004. Yuejun Sun, Zhaoyan Qu, Yihong Li. Study on Target Detection of Breast Tumor Based on Improved Mask R-CNN[J]. Acta Optica Sinica, 2021, 41(2): 0212004.