对象随型粗糙面近红外单目视觉测量与基准图像自愈

1 引言

基于计算机单目视觉的位姿测量系统具有结构简单、非接触测量、精度高、稳定性好的特点[1],已广泛应用于工业现场机器人系统自动控制、物体三维重构、飞机导航和助降等领域[2-4]。其中,采用近红外作为单目视觉测量光源,穿透性强,特别适合户外受环境光干扰场合使用。

在大多数单目视觉位姿测量系统中,最常用的方法是PnP问题(Perspective n-Points Problem)求解[5-8],即采用由空间几何元素和其视觉图像上的对应点计算相机外参数,也称为3D-2D特征点匹配方法[9,10]。文献[7]基于误差传播理论提出了一种PnP问题误差分步分析新方法,以P4P问题研究为例,推导得到了单目视觉测量中相关参数和变量的误差函数解析式,揭示了影响姿态测量精度的误差规律。在采用PnP解算的系统中,合作目标的图形和尺寸等经过精心设计,标志的三维位置信息可事先完成高精度测量标定,从而解算准确的位姿信息。文献[9]中归纳了单目视觉高精度位姿测量中合作目标形状和图案设计的基本原则,分析了在透视投影情况下合作目标特征点的提取精度,并针对光阴影干扰测量精度的问题,提出了误差修正算法和合作目标几何尺寸设计方法。

PnP问题的解法又分为非迭代算法及迭代算法两类。非迭代算法采用解析数学模型直接计算,速度快、实时性好,适合于动态测量与控制应用场合。代表性算法有直接线性计算方法DLT[10]、高效的EPnP方法[11]、强鲁棒性的RPnP方法[12]、快速、全局最优的OPnP方法[13]等。迭代算法可减少合作目标的制作误差影响,测量精度更高,但多次迭代会带来实时性下降。代表性算法有局部优化能力很强的比例正交投影迭代变化POSIT算法[14]、对初始值适应性更强的正交迭代OI[15]算法。第二类算法适合于静态高精度测量场合。

尽管采用PnP方法在解算合作目标位姿参数方面具有显著的优势,但当在实际运行中出现单目视觉测量系统偏离预置合作目标对象特殊情况后,因失去合作目标特征点图像信息,也将无法完成位姿测量,影响测量系统的正常运行。

因此,本文以被测物体合作目标周边的随型粗糙防滑涂层表面为研究对象,针对随型粗糙面图像缺少专门设计的特征点信息,难以使用PnP算法进行精确位姿测量的问题,研究提出一种以随型粗糙面为测量对象的单目视觉测量法,以及随型粗糙面污染受损后基准图像自愈方法。该方法可作为以合作目标位测量对象的单目视觉测量系统的补充,提高测量系统在复杂运行环境中的鲁棒性和稳定性。

1 随型粗糙面测量中需解决的问题

在单目视觉相对空间位姿测量场合,通常选用精心设计特征点的合作目标为测量对象。

合作目标上的点、线及标识符精度受控,用于单目视觉位姿测量的精度高。特别是测量对象上安装的合作目标十分明显,若被污染或损坏,维护人员很容易观察到并及时清理和更换,不影响测量工作。合作目标的尺寸和在测量视场中的占比越大,精度越高。同时,在动态测量中,既要确保合作目标始终处于视场内,又要留出测量装置与合作目标相对位置的允许偏差余量,便于单目视觉位姿测量系统在动态运行环境中的使用。

但在实际使用中,仍会因人为操作动作过大或突发情况,出现测量装置偏离合作目标,不能获得完整合作目标图像而无法完成测量。此时,如果充分利用合作目标附近的对象背景测量,获得满足一定使用精度要求的姿态测量结果,将大幅度提高测量装置对各种突发状况的适应能力。

测量对象合作目标附近的背景,具有与背景表面形状随型的特征。特别是在合作目标背景表面涂覆防滑层的应用场合,其成像效果表现为充满画幅的非规则图像。若将这类非规则图像用于位姿解算,需要解决以下两个方面的问题:

(1)随型粗糙表面是非精确加工自然形成的,具有随机性,无法事先获得图像上特征点本身的参数,需要通过与基准图像匹配才能完成位姿测量。而且,理论上精度相对合作目标会有所下降,必须选择合适的算法确保测量精度满足使用最基本要求。

(2)与合作目标相比,背景随型粗糙面的变化不易观察,一旦被污染或损坏,将影响位姿正常解算,必须采取应对措施,对被污染或损坏区域的基准图像进行动态更新。通常,随型粗糙面的污染或损坏是一个逐渐累积变化和扩大的过程,必须逐次隔离历史图像变化,在动态自愈中实现位姿测量。

2 随型粗糙面特征点提取与匹配算法

2.1 建立基于RANSAC单应变换匹配的基准图像

采用PnP的n点算法,需要特征点在世界坐标系下的位置数据,而随型粗糙面是随机形成的,要逐个获得大量特征点的位置参数不具备工程可行性。因此,宜采用图像特征点与基准图像匹配的方法,即:通过光学测量设备捕获实时随型粗糙表面图像,计算采集图像的特征点,得到刻画其特征的数据结构——描述子,与事先存储的基准图像特征点及描述子进行特征匹配,并使用RANSAC(随机抽样一致算法)选取大部分特征匹配点对遵循的图像间单应变换,从而获得相对位姿测量结果。

首先,构建匹配计算的基准图像。在首次实时测量之前,将单目视觉测量装置在超出被测对象合作目标一定范围内的区域运动,通过将相机坐标系与随型粗糙面坐标系的倾斜角、俯仰角及方位角调整到零位,采集获得随型粗糙面基准图像。

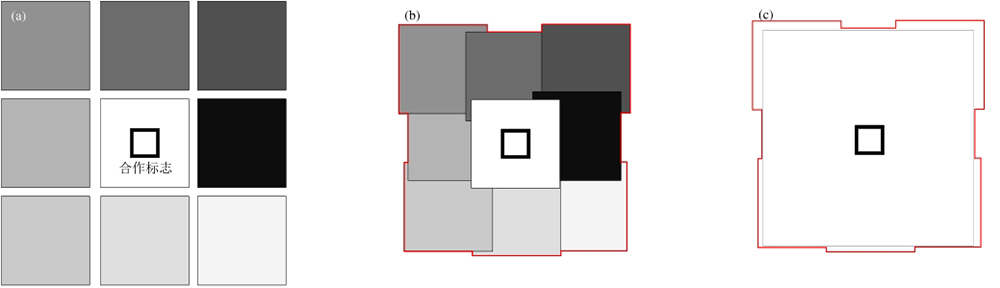

考虑到工程实际使用需求,在被测对象合作目标及其周围八个方向连续拍摄9幅图片,并确保一定的图像重叠率。将拍摄的9幅图像进行图像畸变校正和拼接后导入单目视觉测量装置。

图 1. 原始基准图像拼接制作示意(a)原始图,(b)拼接图,(c)基准图

Fig. 1. Schematic diagram of reference image mosaic(a)Original image,(b)Splicing image,(c)Reference image

在形成的最终基准图像上提取特征点/描述子数据,连同随型粗糙面坐标系至基准相机坐标系的坐标转换矩阵,打包写入xml文件。

2.2 坐标转换、特征点提取及匹配计算

定义随型粗糙面坐标系为Ot-XtYtZt,实时测量的相机坐标系为Oc-XcYcZc,采集基准图时的相机坐标系为Oc'-Xc'Yc'Zc'。从随型粗糙面坐标系至实时相机坐标系的旋转矩阵定义为

坐标旋转矩阵的计算关系为:

令c及c′坐标系下的同一特征点的图像坐标分别为p1,p2,则转换关系为:

单应矩阵H表示为:

其中,

采用RANSAC算法,根据公式求解旋转矩阵及位移矩阵。在获取四组解后,按照本文的实验背景,对姿态角及位移向量进行滤波,得到满足要求的唯一正确解。

目前比较成熟的基于斑点检测的特征提取算子有SIFT[15]、SURF[16]、KAZE[17]、AKAZE[18]、ORB[19]等。其中SIFT算法具有自适应尺度、透视变形、光照变化等优良特性,是图像特征检测领域中具有里程碑意义的算法;SURF算法为加速SIFT算法;KAZE算法利用非线性尺度分解解决边界模糊及细节丢失;AKAZE算法为加速KAZE算法;ORB算法混合使用了机器学习和手工特征子算法。

经过测量比较,选用匹配精度最高的SIFT算子,采用BF策略进行特征点提取及描述子计算。

特征点提取具体方法为:使用高斯函数实现尺度空间上不同图像的卷积,具体采用DOG(Difference of Gaussian)金字塔方式,以寻找极值点。根据疑似像素点周围八个区域点及其近邻尺度相应点比较,若得到相应极值,则作为疑似SIFT特征点。然后再剔除不适合作为特征点的低对比度点及边缘点。

描述子计算具体方法:以提取出的特征点为中心,4×4像点为结构体,统计其梯度方向的分布及梯度幅值在各方向区域内的叠加值。方向空间按照8区间划分,每区间45度,每个结构体使用8维向量描述,形成32维向量,即为该SIFT特征点的描述子。

特征点匹配具体方法:使用暴力(Brute-Force)匹配器进行两幅图像特征描述子之间的匹配,遍历第一幅图像的描述子,搜索在第二幅图像的描述子,返回距离最小的匹配。使用的距离度量采用2范数计算。

3 随型粗糙面污染或损坏后的自愈

3.1 图像自愈的基本原理

基准图像至实时图像的特征匹配点,经过RANSAC计算后可剔除不符合单应模型的一些误匹配点对。但当随型粗糙表面局部被污染或损坏后,相比污染和损坏前的匹配点数量减少,匹配解算精度将会受到影响。此时,若采用最近一次测量图像去修正原始基准图像,完成基准图像自愈修复更新,可避免出现使用累积形成大面积污染和损坏的随型粗糙面图像与原始基准图像匹配解算的情况,进一步提高测量系统的工作可靠性。

图像自愈的基本原理可以概括为,在最新的包含因污染或损坏导致部分区域出现固定改变的、但能基本满足精度要求的随型粗糙面图像上,将特征点提取时未能与基准图像匹配的污染或损坏区域稳定的新特征点,在测量完成后替换基准图像中相应区域原特征点,用于下一次同一区域的测量匹配。

图像自愈的过程实质上就是基准图像持续更新迭代的过程。

图 2. 随型粗糙表面被污染后的图像匹配示意(a)自愈前匹配图像,(b)自愈后匹配图像

Fig. 2. Schematic diagram of image matching after contaminated random rough surface(a)Matching image before self-healing,(b)Matching image after self-healing

3.2 自愈精度与适用范围

自愈是在粗糙面被污染或破坏时自动激活的算法,应首先研究特征点数量与方位角和水平姿态角精度之间的关系,以量化评估未损坏粗糙面上特征点对于已损坏粗糙面特征点校正的效果。

图 3. 特征点个数影响测量测量精度实验曲线

Fig. 3. Experimental curve of influence of number of characteristic points on measurement accuracy

从图中可以看出,随着特征点个数从4开始增加,测量精度迅速提高,当特征点数目达到约60个时,测量精度趋于稳定。

显然,在该项实验中,当有效匹配特征点数量不低于60个时,启动自愈算法能够基本满足测量精度要求。因此,必须根据具体情况,设置自愈适用范围,判别污染或损坏的程度启动或终止自愈算法,避免频繁启动自愈或自愈后精度不满足使用要求。

为此,引入自愈系数概念,在将实时图像与基准图像匹配时,采用RANSAC方法选取概率最大单应模型计算匹配特征点对,根据匹配特征点密度情况计算自愈系数。若随型粗糙面污染或破坏超过范围,则计算当前图像的特征点及描述子,并更新基准数据。

设Mk0、Mk1为污染或破坏前后,第k次实时测量图像区域内与基准图像内正确匹配特征点对数。定义自愈系数λ如下:

λ反映了图像的污染或破坏程度。根据实际使用需要,设置自愈启动和终止区间

需要指出的是,视场内粗糙面出现少量污染或损坏时,可以启动自愈后将其纳入基准图像特征点。若粗糙面的污染区域较大,但未达到终止自愈条件时,以剩余特征点的数量进行单应变换的精度下降,而且随着自愈次数的增加,误差逐渐累积,最终出现自愈算法性能衰退的情况。

为消除因累积误差导致自愈失效的情况,在测量流程设计时,充分利用正常运行中基于合作目标测量时机,进行随型粗糙面基准图像的自愈。启动自愈的时机包括以下两种情况:

(1)当能检测到完整的合作目标,且自愈系数超过

(2)当检测不到合作目标或检测到不完整的合作目标时,且根据污染和损坏情况计算的自愈系数处于区间

另外,实际运用环境中,还存在随型粗糙表面常常会受到外来物的短时干扰或者入侵情况,此时如果启动自愈,将会造成实时测量图像与基准图像产生较大差异,大幅降低测量精度。此时,应在测量流程设计时增加判据,消除外来物的短时干扰或者入侵的影响。

3.3 基于图像自愈的位姿测量流程

基于随型粗糙面图像自愈的位姿测量算法实现过程为:

(1)实时采集随型粗糙面图像数据,进行图像畸变校正,计算实时图像关键点位置及描述子数据。

(2)与存储的基准图像关键点及描述子进行特征匹配,解算随型粗糙面坐标系至相机坐标系的单应转换矩阵。

(3)按照存储的基准转换矩阵及测量结果,计算出随型粗糙面坐标系至相机坐标系转换矩阵。反解高精度方位角及水平姿态角,完成参数测量。

(4)测量完毕,判断视场内是否能够检测到完整的合作目标。当能够完成基于合作目标的测量时,且自愈系数超过

(5)当视场内未能检测到合作目标或只能检测到不完整的合作目标时,统计特征点有效匹配点数,计算自愈系数,若自愈系数处于区间

(6)当检测不到合作目标或检测到不完整的合作目标,且自愈系数超过

随型粗糙面位姿测量流程图见

图 4. 随型粗糙面位姿测量流程图

Fig. 4. Flow chart of pose measurement of profile following rough surface

需要注意的是,启动自愈后,应将自愈图像上的特征点观察视点转化至以基准图像为中心,进行投影校正。

4 测量实验与结果

4.1 基于随型粗糙面与合作目标的测量仿真结果对比

比较随型粗糙面与精密加工的合作目标位姿测量性能,相机焦距8mm,高度为500mm,图像分辨率为1920像素×1080像素。合作目标为方形合作目标[9],加工精度为0.1mm。选用直线拟合相交算法进行亚像素提取,获取合作目标上4个标志点高精度位置。提取随型粗糙面上的特征点输入测量系统进行实验。以合作目标的高精度结果作为测量真值比较随型粗糙面算法精度。

控制三维转台运动,通过光学手段解算方位角ψ及两个姿态角θ、γ,计算测量精度,结果见

图 5. 随型粗糙面上不同测量算法结果对比

Fig. 5. Comparison of different measurement algorithms on random rough surfaces

在实时性方面,考虑实际工程应用,选取120个特征点匹配对实施测量,获得的结果更加稳定。比较各种算法耗时,基于120个特征点处理的本文算法运算时间与P4P算法相比约增加5倍,与其他算法相比运算时间处于中等水平,见

4.2 粗糙面污染和损坏后的自愈实测实验

搭建仿真环境,进行基于随型粗糙面测量实验以验证测量算法和自愈算法。随型粗糙面上特征点通过算法自动提取,相机参数与位置关系不变。提供三种场景测量,第一种为正常粗糙面上测量;第二种为人为局部破坏粗糙面,测量装置内部基准数据未更新条件下测量;第三种为粗糙面被破坏后,测量装置自动启动自愈算法,更新基准数据并测量。

为验证算法,设置不同污染共进行6次实验。下面,以其中一组实验结果为例进行说明。

示例实验:在三种场景下各任意提取一组匹配图像对,如

图 7. 自愈匹配对比图(a)破坏前匹配图像,(b)破坏后匹配图像,(c)自愈后匹配图像

Fig. 7. Self healing matching comparison diagram (a) Matching image before destruction,(b) Matching image after destruction,(c) Matching image after self-healing

图(a)为未污染的图像匹配对;图(b)为粗糙面被污染后的图像匹配对,能够匹配的特征点大幅减少;图(c)为在更新基准图像后,污染后粗糙面图像能匹配的特征点显著增加。

在三维转台上转动相机,并记录实时测量曲线,结果见

图 8. 自愈前、后对比实验(a)破坏前方位角测量曲线,(b)破坏后方位角测量曲线,(c)自愈后方位角测量曲线,(d)破坏前俯仰角测量曲线,(e)破坏后俯仰角测量曲线,(f)自愈后俯仰角测量曲线:(g)破坏前倾斜角测量曲线;(h)破坏后倾斜角测量曲线;(i)自愈后倾斜角测量曲线

Fig. 8. Self healing contrast experiment (a) Measurement curve before destruction of azimuth, (b) Measurement curve after destruction of azimuth, (c) Measurement curve after self-healing of azimuth, (d) Measurement curve before destruction of pitch, (e) Measurement curve after destruction of pitch, (f) Measurement curve after self-healing of pitch, (g) Measurement curve before destruction of roll, (h) Measurement curve after destruction of roll, (i) Measurement curve after self-healing of roll

该次实验中,当污染程度即自愈系数为70%时,自愈后与自愈前的方位角误差比值约为28%,自愈后的方位测量误差减少了72%。证明在更新基准图像后,被破坏区域的特征点信息能够用于匹配解算并保持一定的精度。

表 1. 自愈实验测量结果

Table 1. Measurement results of self-healing experiment

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

从表中可以看出,当污染程度即自愈系数为60%时,自愈能力不显著,方位角的误差比值仅为98.7%。但随着自愈系数的增加,即粗糙面被破坏或污染程度的增加,自愈算法的自愈能力越来越强,表现为方位角的误差比值越来越小。当污染程度即自愈系数超过70%后,自愈效果显著。

5 结论

本文提出对象随型粗糙面的单目视觉测量与自愈方法,解决凹凸不平粗糙面位姿测量及其受损后的自愈问题。

描述了随型粗糙面测量中需解决的问题,详细阐述了随型粗糙面特征点提取与匹配算法和随型粗糙面污染或损坏后的自愈。设计实验室实验对提出的算法进行验证。结果表明:提出的测量和自愈算法可作为基于合作目标算法的有效补充,在粗糙面被破坏或污染后自动激活自愈处理流程。当随型粗糙面图像污染或受损达到70%时,采用自愈处理与未做自愈处理相比,方位角测量误差减少72%以上,验证了基准图像自愈方法的有效性。

实际应用中还必须解决如何有效区分随型粗糙面污染、受损与外来物入侵,以及户外光照、阴影变化的情况,避免误判而频繁错误更新基准图像的问题,探讨运用人工智能技术提高算法对环境的适应性。

[1] 冯肖维, 谢安安, 肖健梅, 等. 非合作纹理目标单目位姿计算[J]. 光学精密工程, 2020, 28(8): 1775-1784.

[2] 熊芝, 许航, 张刘港, 等. 基于加权加速正交迭代算法的相机位姿估计[J]. 红外与激光工程, 2022, 51(10): 20220030.

[3] 尚洋, 孙晓亮, 张跃强, 等. 三维目标位姿跟踪与模型修正[J]. 测绘学报, 2018, 47(6): 799-808.

SHANG Yang, SUN Xiao-Liang, ZHANG Yue-Qiang, et al. Research on 3D Target Pose Tracking and Modeling[J]. Acta Geodaetica et Cartographics Sinica, 2018, 47(6): 799-808.

[4] 邹瑜, 梁斌, 王学谦, 等. 基于旋转投影二进制描述符的空间目标位姿估计[J]. 光学精密工程, 2017, 25(11): 2958-2967.

[5] Hamel T, Samson C. Riccati Observers for the Nonstationary PnP Problem[J]. IEEE Transactions on Automatic Control, 2018, 63(3): 726-741.

[6] 王天宇, 董文博, 王震宇. 基于单目视觉和固定靶标的位姿测量系统[J]. 红外与激光工程, 2017, 46(4): 427001-427003.

[7] 屈也频, 侯旺. 基于误差传播理论的PnP问题姿态精度分析[J]. 光学精密工程, 2019, 27(2): 479-487.

[8] 王鹏, 周权通, 孙长库. 多特征点拓扑确定位姿测量算法研究[J]. 红外与激光工程, 2017, 46(5): 517001.

[9] 屈也频, 刘坚强, 侯旺. 单目视觉高精度测量中的合作目标图形设计[J]. 光学学报, 2020, 40(13): 1315001.

[10] I Y., et al. Direct Linear Transformation from Comparator Coordinates into Object Space Coordinates in Close-Range Photogrammetry[J]. Photogrammetric Engineering & Remote Sensing Journal of the American Society of Photogrammetry, 2015.

[11] 张慧娟, 熊芝, 劳达宝, 等. 基于EPNP算法的单目视觉测量系统研究[J]. 红外与激光工程, 2019, 48(5): 517001-517005.

[12] Xu C, Xie M. A Robust O(n) Solution to the Perspective-n-Point Problem[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7): 1444-1450.

[13] 劳达宝, 张慧娟, 熊芝, 等. 基于单目视觉的姿态自动测量方法[J]. 光子学报, 2019, 48(3): 315001.

[14] 李鑫, 张跃强, 刘进博, 等. 基于直线段对应的相机位姿估计直接最小二乘法[J]. 光学学报, 2015, 35(6): 615001-615003.

[15] Lowe D. Distinctive image features from scale-invariant key points[J]. International Journal of Computer Vision, 2003, 20: 91-110.

[16] BayH, TuytelaarsT, GoolL V. SURF: Speeded up robust features[C]// Proceedings of the 9th European conference on Computer Vision - Volume Part I. Springer-Verlag, 2006.

[17] AlcantarillaP F, BartoliA, DavisonA J. KAZE Features[C]// European Conference on Computer Vision (ECCV). 2012.

[18] AlcantarillaP F. Fast Explicit Diffusion for Accelerated Features in Nonlinear Scale Spaces[C]// British Machine Vision Conference (BMVC). 2013.

[19] RubleeE, RabaudV, KonoligeK, et al. ORB: an efficient alternative to SIFT or SURF[C]// IEEE International Conference on Computer Vision, ICCV2011, Barcelona, Spain, November 6-13, 2011. IEEE, 2011.

[20] LeuteneggerS, ChliM, SiegwartR Y. BRISK: Binary Robust invariant scalable keypoints[C]// International Conference on Computer Vision. IEEE, 2011.

[21] Rosten E, Porter R, Drummond T. FASTER and better: A Machine Learning Approach to Corner Detection[J]. IEEE Transactions on Software Engineering, 2010, 32(1): 105-119.

Article Outline

侯旺, 屈也频, 刘坚强, 吕余海. 对象随型粗糙面近红外单目视觉测量与基准图像自愈[J]. 红外与毫米波学报, 2024, 43(1): 134. Wang HOU, Ye-Pin QU, Jian-Qiang LIU, Yu-Hai LYU. Near-infrared monocular vision measurement and reference image self-healing of object random rough surface[J]. Journal of Infrared and Millimeter Waves, 2024, 43(1): 134.